Résumé de la publication

Grâce à cet article vous allez comprendre comment Docker et Kubernetes vous aident à exécuter, faire évoluer, surveiller et mettre à jour vos applications sur site et dans le cloud. L’article montre des techniques pour rendre vos applications hautement disponibles, élastiques, sécurisées et résistantes aux pannes

Objectifs de la publication

- Empaquetez et exécutez des applications monolithiques existantes ou de nouvelles applications basées sur des microservices dans des conteneurs

- Créez et expédiez vos propres images de conteneurs

- Utilisez Kubernetes pour orchestrer des applications multi-conteneurs complexes sur site ou dans le cloud

- Exécuter, mettre à l’échelle, surveiller et mettre à jour les services d’application

- Provisionner, faire évoluer et mettre à jour des clusters Kubernetes entièrement hébergés sur Microsoft Azure

- Sécurisez vos applications conteneurisées à l’aide des bonnes pratiques Docker et Kubernetes

Introduction

Préambule

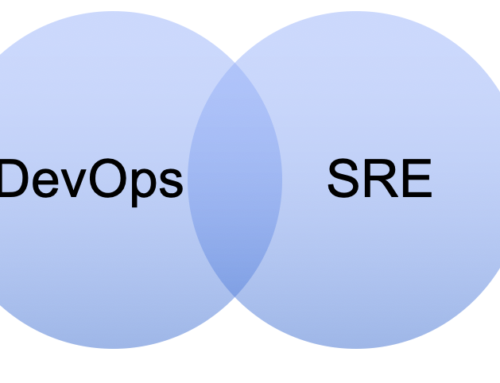

La conteneurisation est considérée comme le meilleur moyen d’implémenter DevOps et l’objectif principal de cet article est de fournir des solutions de déploiement de bout en bout pour votre environnement Azure.

Cet article commencera par la mise en œuvre du déploiement et de la gestion des conteneurs ainsi que par la mise en route avec Docker et Kubernetes. Ensuite, cet article expliquera les opérations de gestion et d’orchestration des conteneurs dans Docker à l’aide des solutions cloud d’Azure. Vous apprendrez également à déployer et à gérer des applications hautement évolutives ainsi qu’à configurer un cluster Kubernetes prêt pour la production sur Azure dans un environnement intact. Enfin, l’article vous aidera également à tirer parti des outils Docker et Kubernetes de Microsoft pour créer des applications pouvant être rapidement déployées sur Azure.

À la fin de l’article, vous découvrirez des sujets plus avancés pour approfondir vos connaissances sur Docker et Kubernetes.

Contenu de cet article

- Chapitre 1, Que sont les conteneurs et pourquoi devrais-je les utiliser ? ce chapitre se concentre sur la chaîne d’approvisionnement des logiciels et les frictions qu’elle comporte. Il présente ensuite les conteneurs comme un moyen de réduire ce frottement et d’ajouter une sécurité de niveau entreprise par-dessus. Dans ce chapitre, nous examinons également comment les conteneurs et l’écosystème qui les entoure sont assemblés. Nous soulignons spécifiquement la distinction entre les composants OSS en amont (Moby) qui forment les blocs de construction des produits en aval de Docker et d’autres fournisseurs.

- Le chapitre 2, Configuration d’un environnement de travail, dans ce chapitre, explique en détail comment configurer un environnement idéal pour les développeurs, les DevOps et les opérateurs qui peut être utilisé lorsque vous travaillez avec des conteneurs Docker.

- Chapitre 3, Utilisation des conteneurs, ce chapitre explique comment démarrer, arrêter et supprimer des conteneurs. Le chapitre explique également comment inspecter des conteneurs pour en extraire des métadonnées supplémentaires. En outre, il explique comment exécuter des processus supplémentaires ou comment les attacher au processus principal dans un conteneur déjà en cours d’exécution. Il montre également comment récupérer des informations de journalisation à partir d’un conteneur qui sont produites par les processus en cours d’exécution à l’intérieur. Enfin, le chapitre présente le fonctionnement interne d’un conteneur, notamment des espaces de noms Linux et des groupes de contrôle.

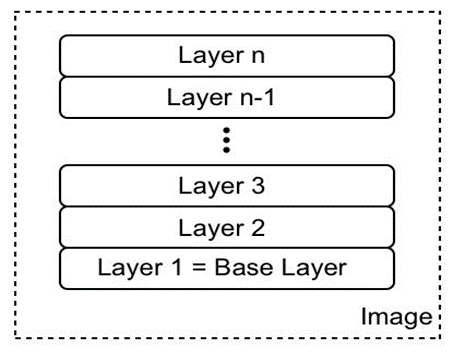

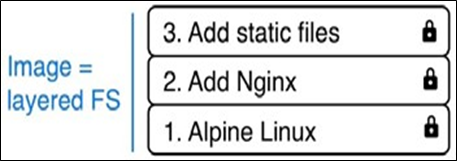

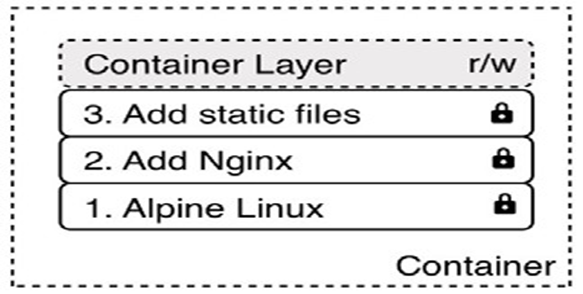

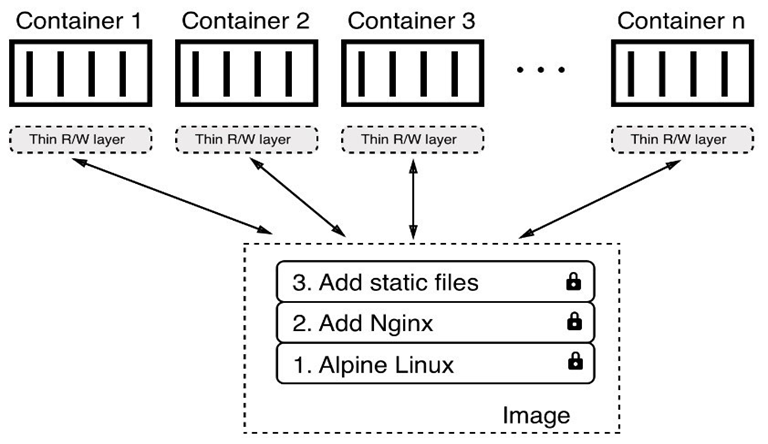

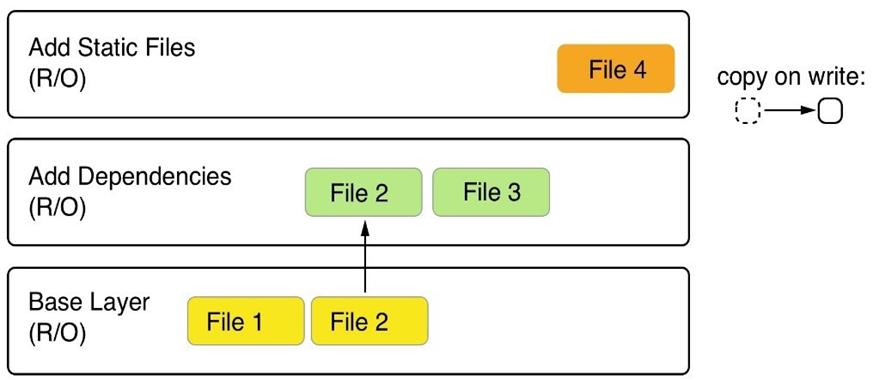

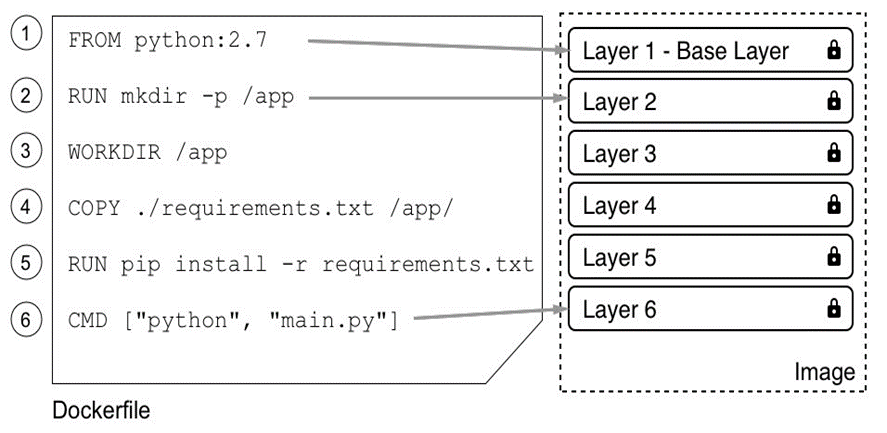

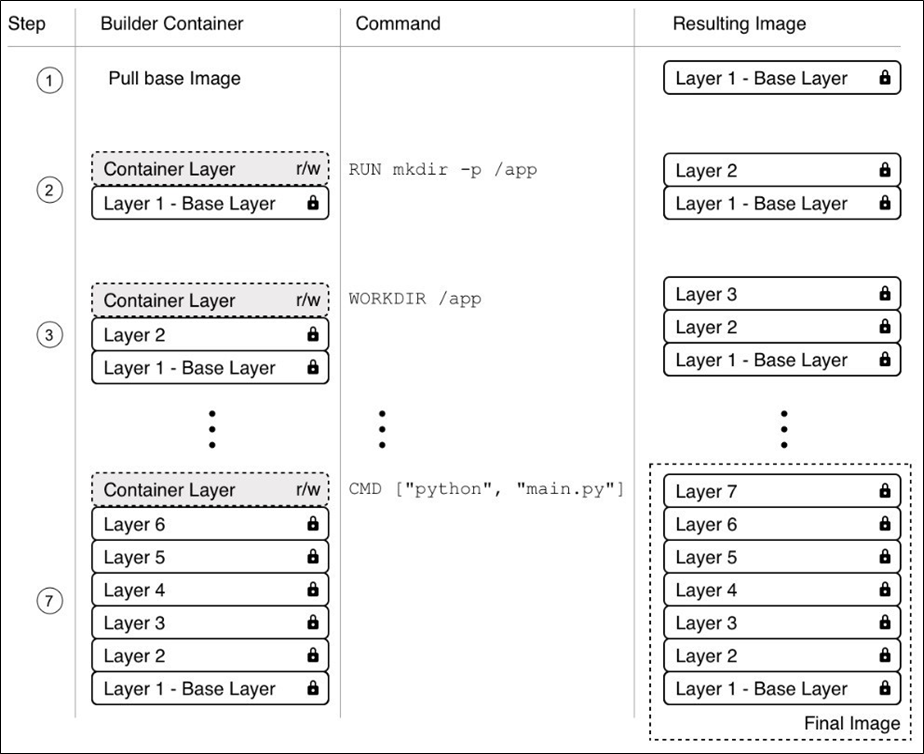

- Chapitre 4, Création et gestion d’images de conteneurs, ce chapitre présente les différentes façons de créer des images de conteneurs qui servent de modèles pour les conteneurs. Il présente la structure interne d’une image et comment elle est construite.

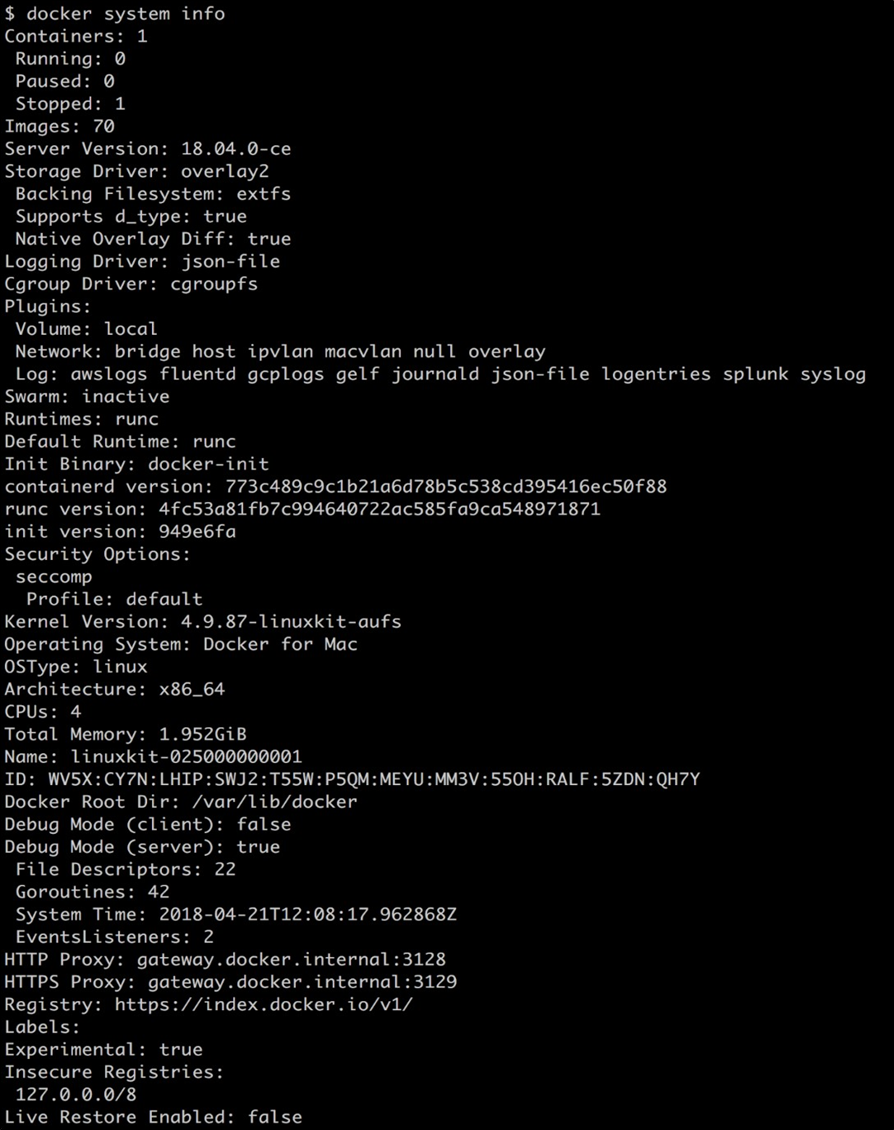

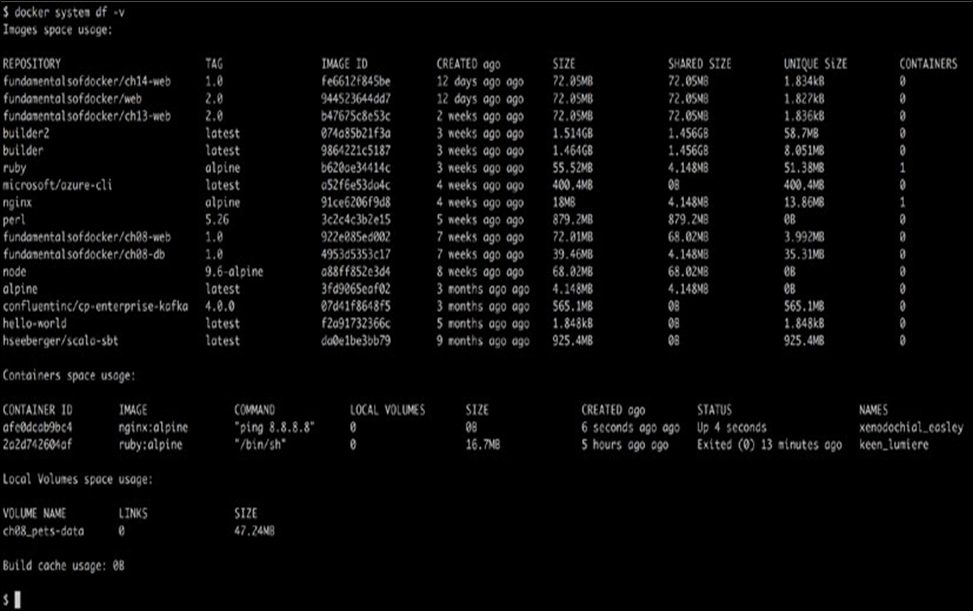

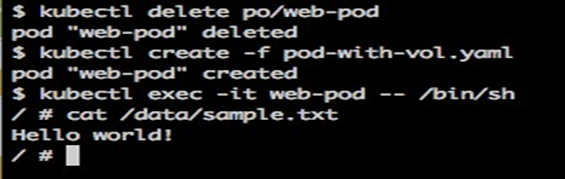

- Chapitre 5, Volumes de données et gestion du système, ce chapitre présente les volumes de données qui peuvent être utilisés par des composants avec état s’exécutant dans des conteneurs. Le chapitre présente également les commandes de niveau système qui sont utilisées pour recueillir des informations sur Docker et le système d’exploitation sous-jacent, ainsi que des commandes pour nettoyer le système des ressources orphelines. Enfin, il présente les événements système générés par le moteur Docker.

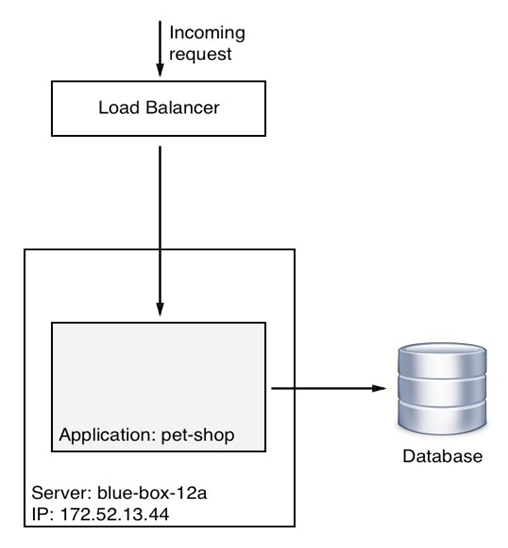

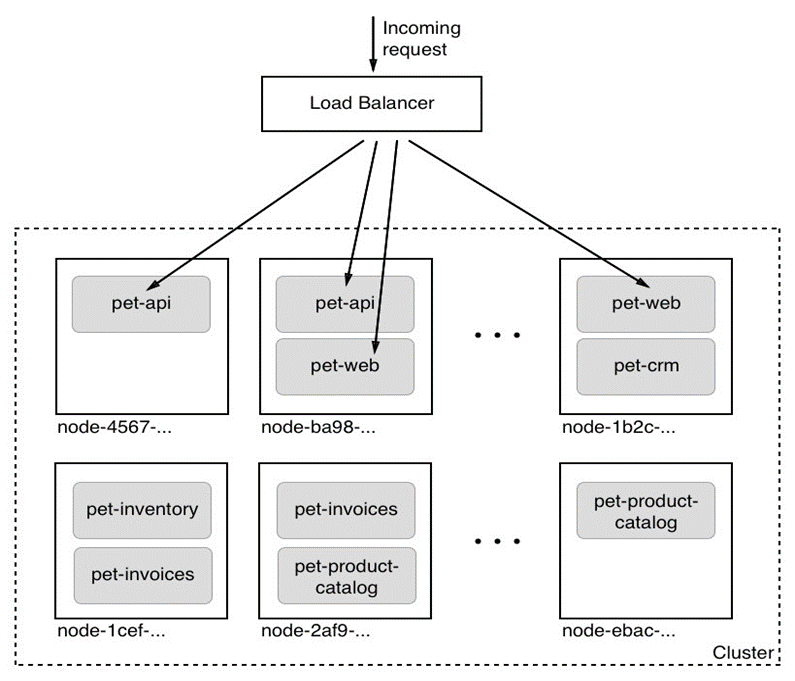

- Chapitre 6, Architecture d’application distribuée, ce chapitre présente le concept d’une architecture d’application distribuée et présente les différents modèles et meilleures pratiques nécessaires pour exécuter une application distribuée avec succès. Enfin, il examine les exigences supplémentaires qui doivent être remplies pour exécuter une telle application en production.

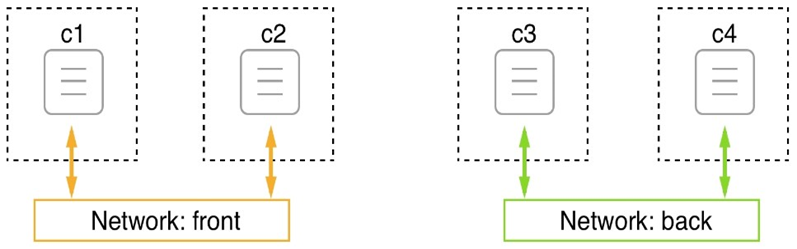

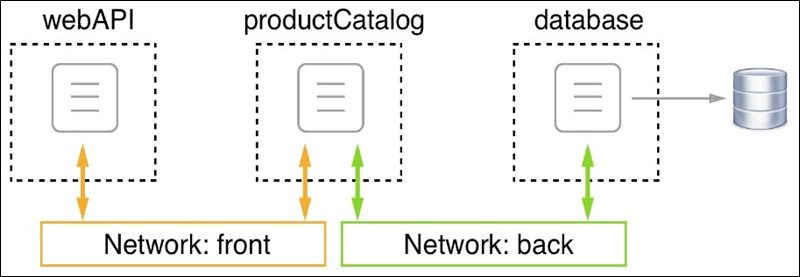

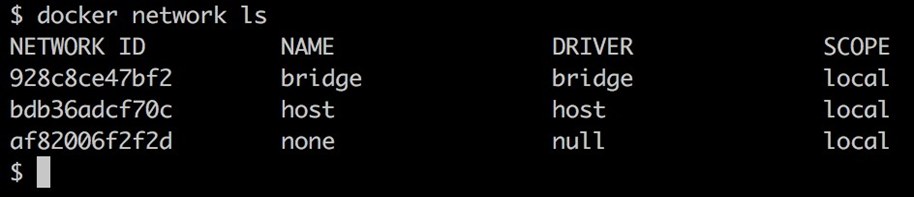

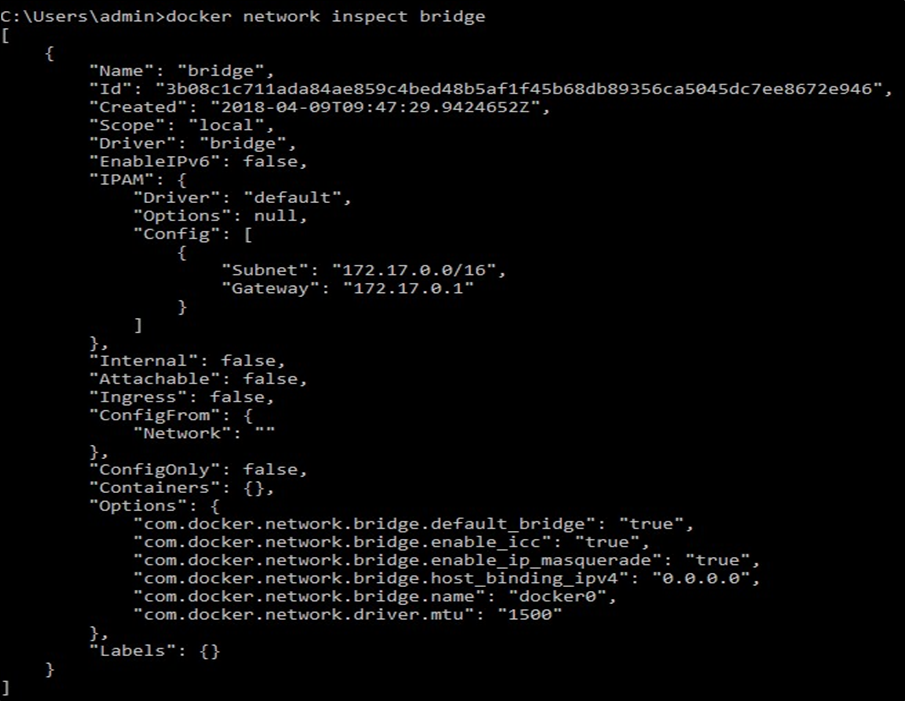

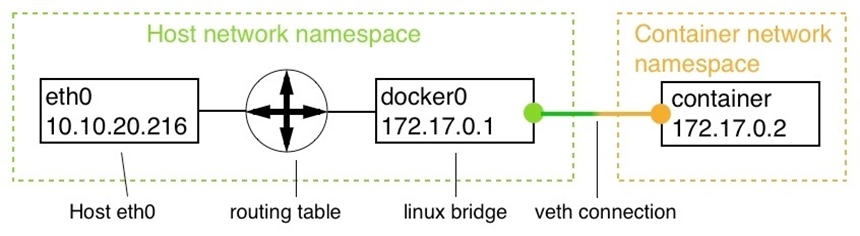

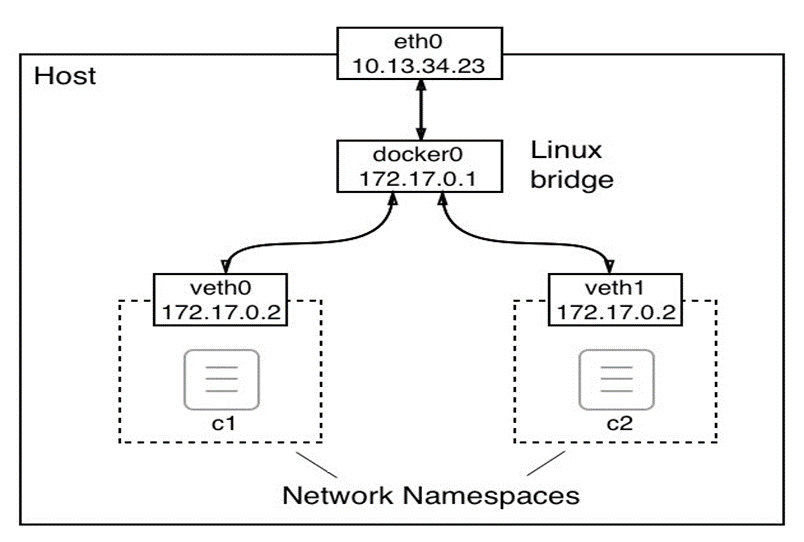

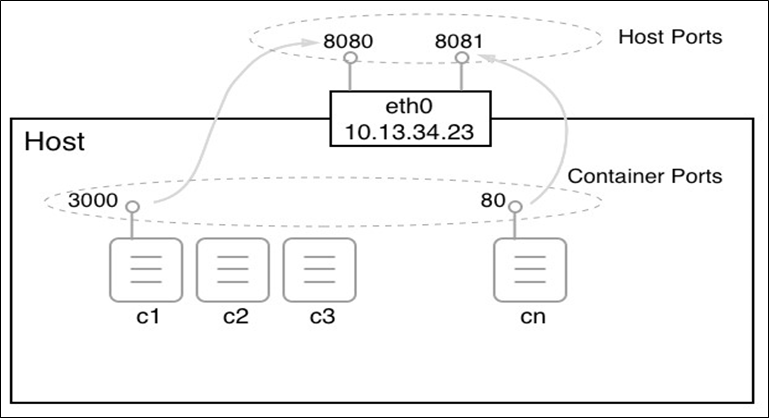

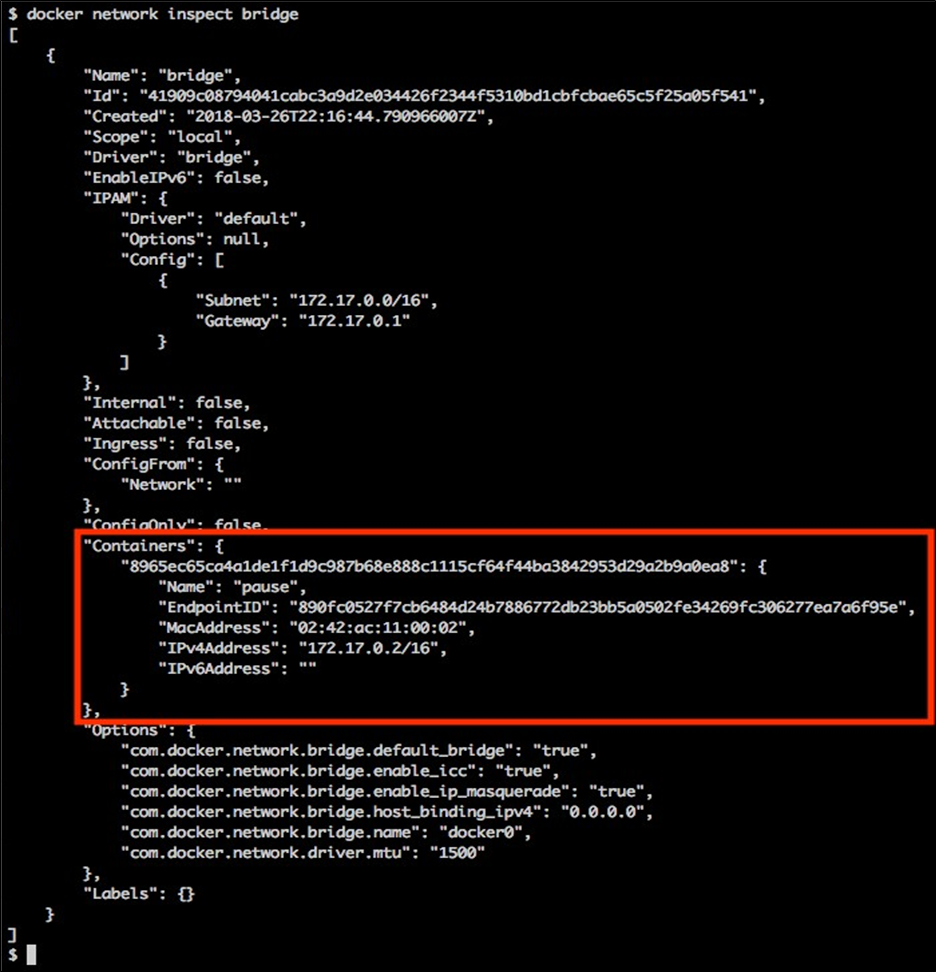

- Chapitre 7, Mise en réseau à hôte unique, ce chapitre présente le modèle de mise en réseau de conteneurs Docker et son implémentation à hôte unique sous la forme d’un réseau en pont. Le chapitre présente le concept de réseaux définis par logiciel et comment ils sont utilisés pour sécuriser les applications conteneurisées. Enfin, il présente comment les ports à conteneurs peuvent être ouverts au public et rendre ainsi les composants conteneurisés accessibles depuis le monde extérieur.

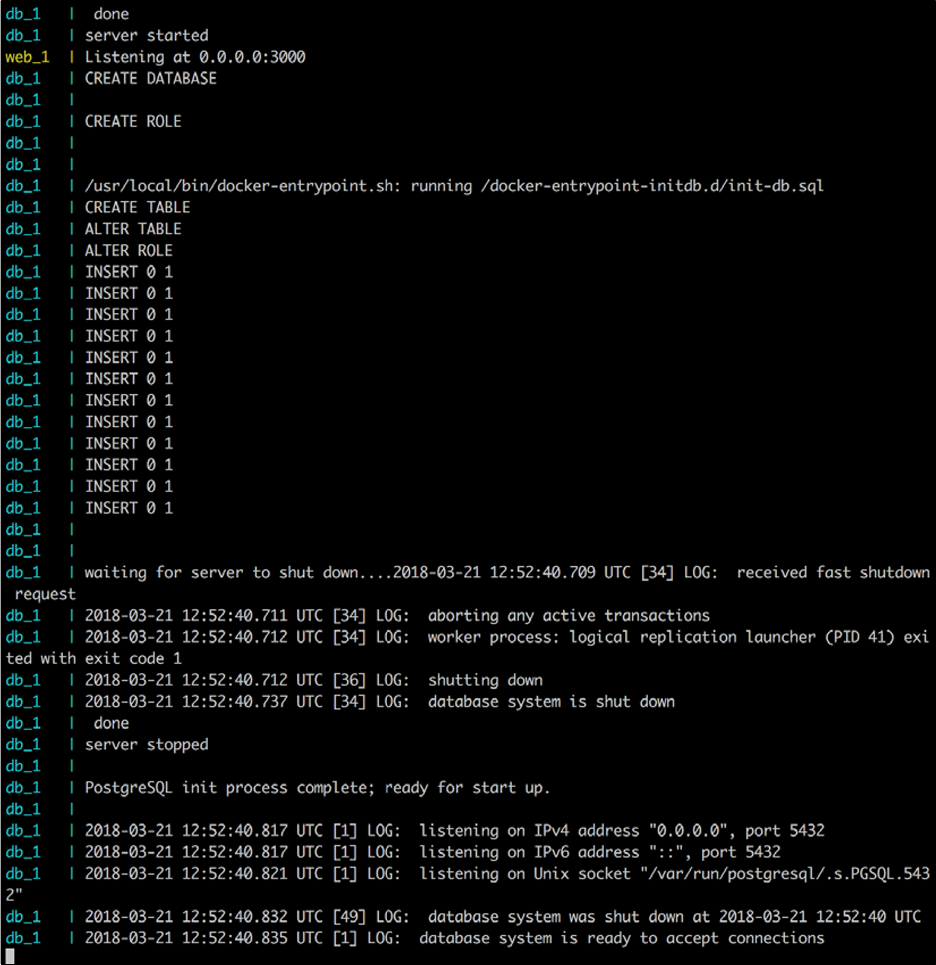

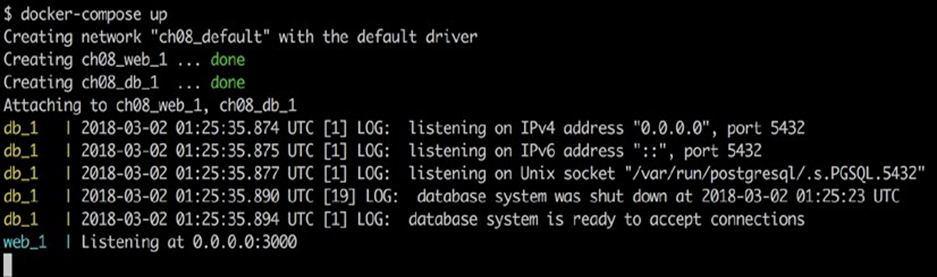

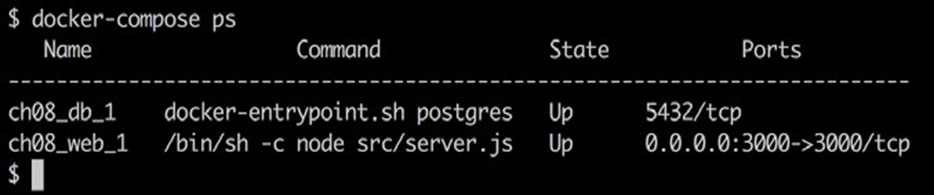

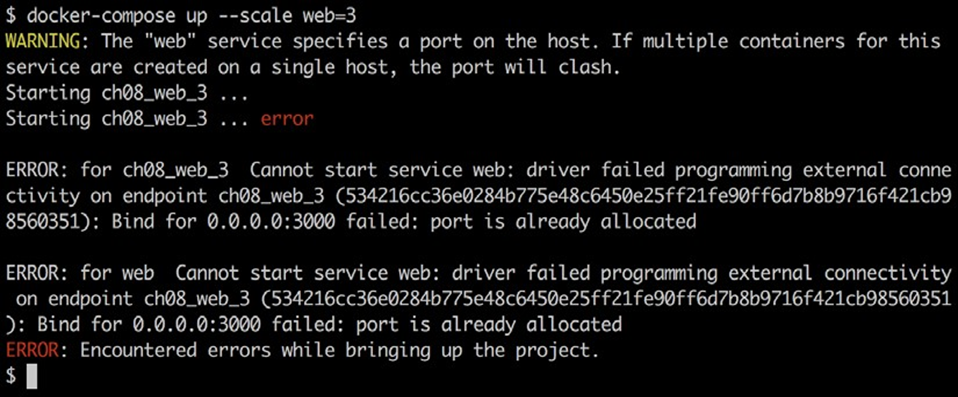

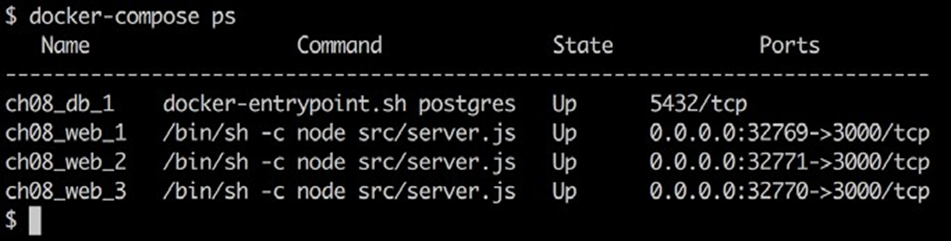

- Chapitre 8, Docker Compose, ce chapitre présente le concept d’une application composée de plusieurs services s’exécutant chacun dans un conteneur et comment Docker Compose nous permet de créer, d’exécuter et de mettre à l’échelle facilement une telle application en utilisant une approche déclarative.

- Chapitre 9, Orchestrateurs, ce chapitre présente le concept d’orchestrateurs. Il explique pourquoi les orchestrateurs sont nécessaires et comment ils fonctionnent conceptuellement. Le chapitre fournira également un aperçu des orchestrateurs les plus populaires et nommera quelques-uns de leurs avantages et inconvénients.

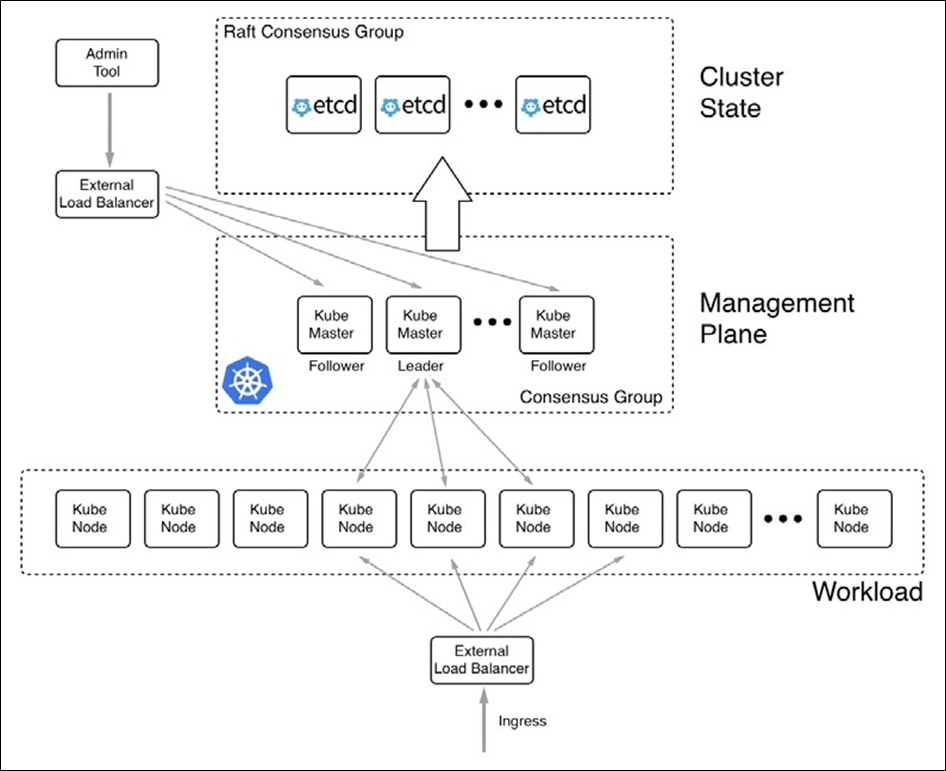

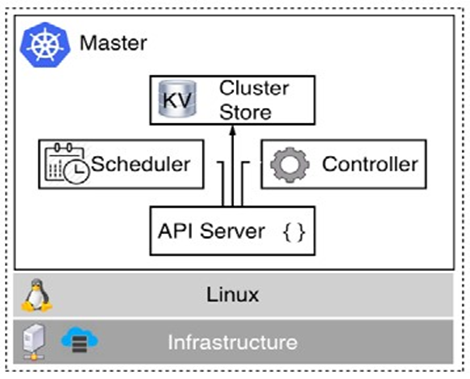

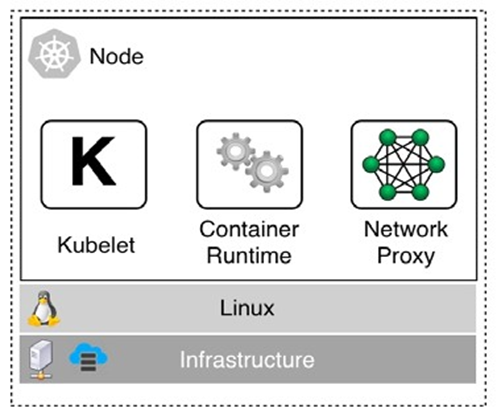

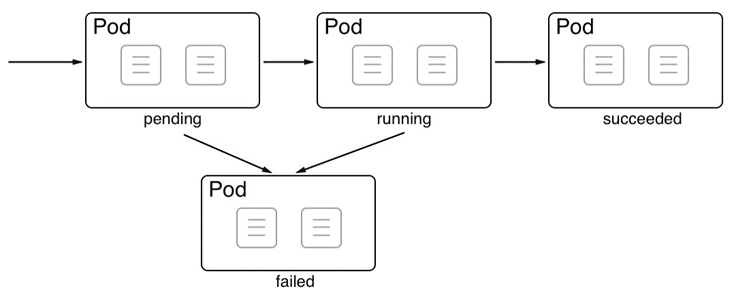

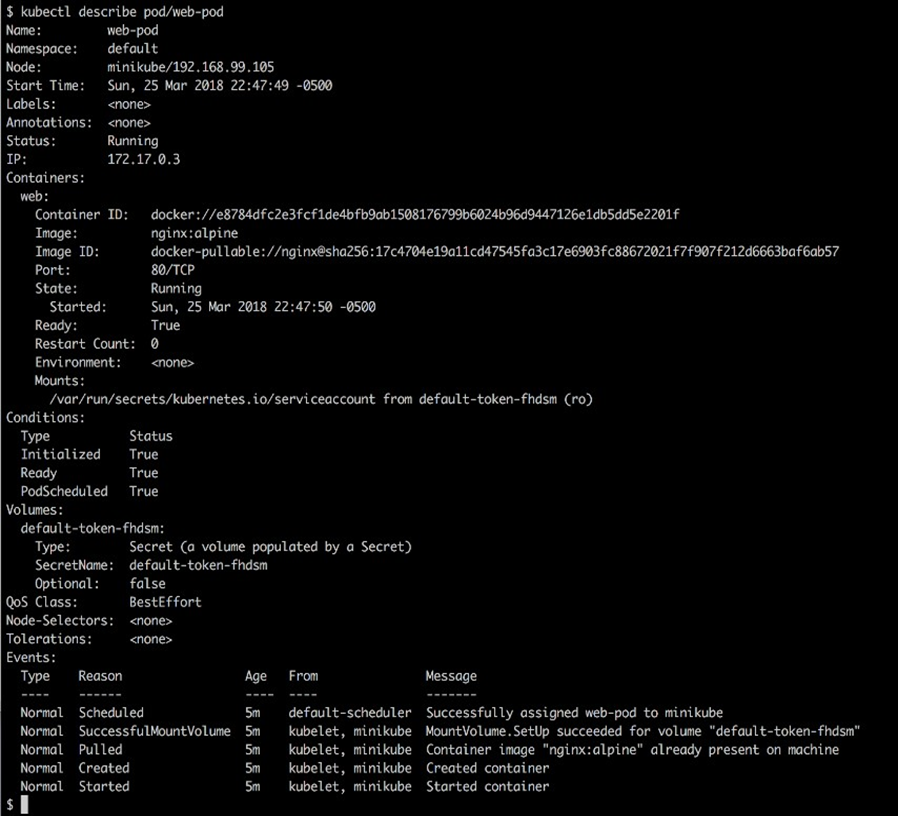

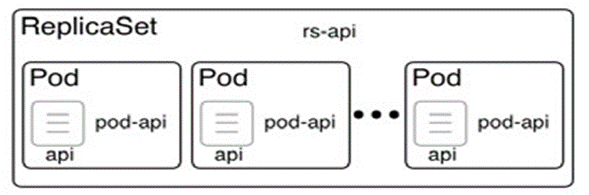

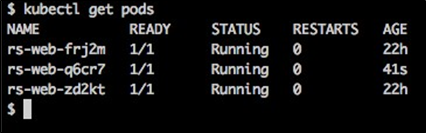

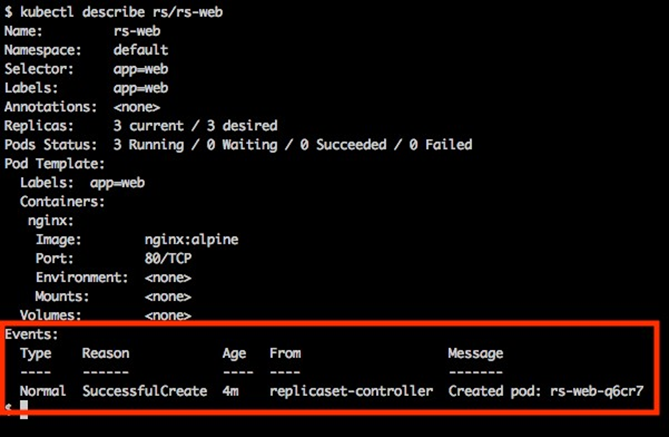

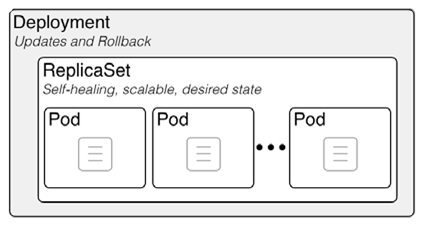

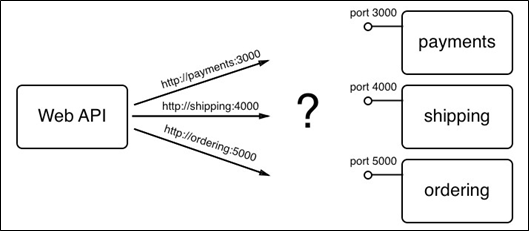

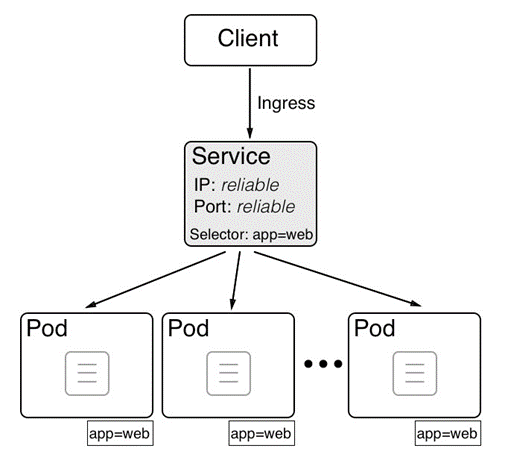

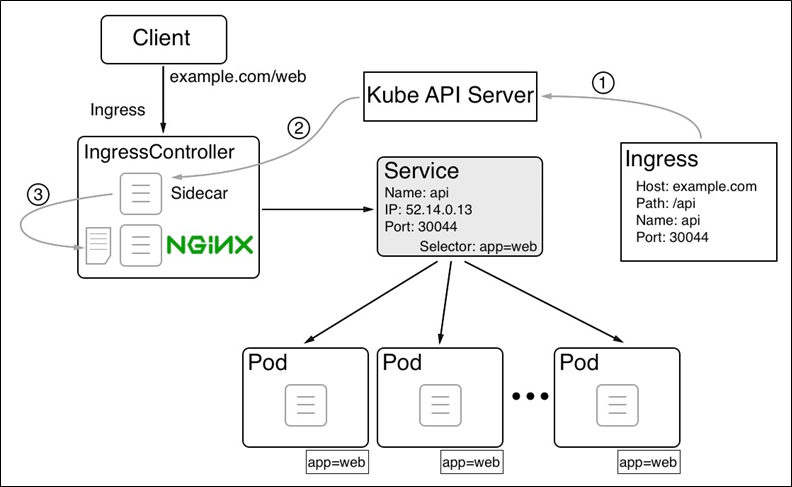

- Chapitre 10, Orchestration des applications conteneurisées avec Kubernetes , ce chapitre présente Kubernetes. Kubernetes est actuellement le leader incontesté de l’espace d’orchestration de conteneurs. Il commence par une présentation de haut niveau de l’architecture d’un cluster Kubernetes, puis examine les principaux objets utilisés dans Kubernetes pour définir et exécuter des applications conteneurisées.

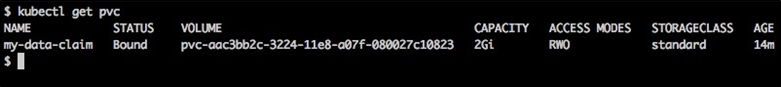

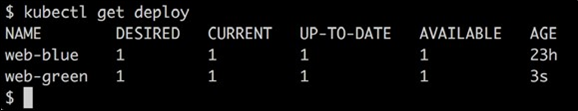

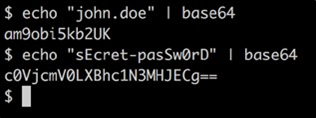

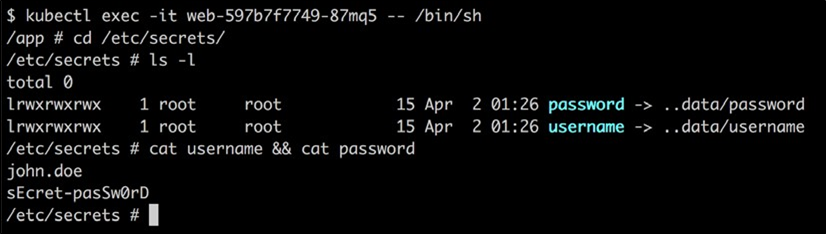

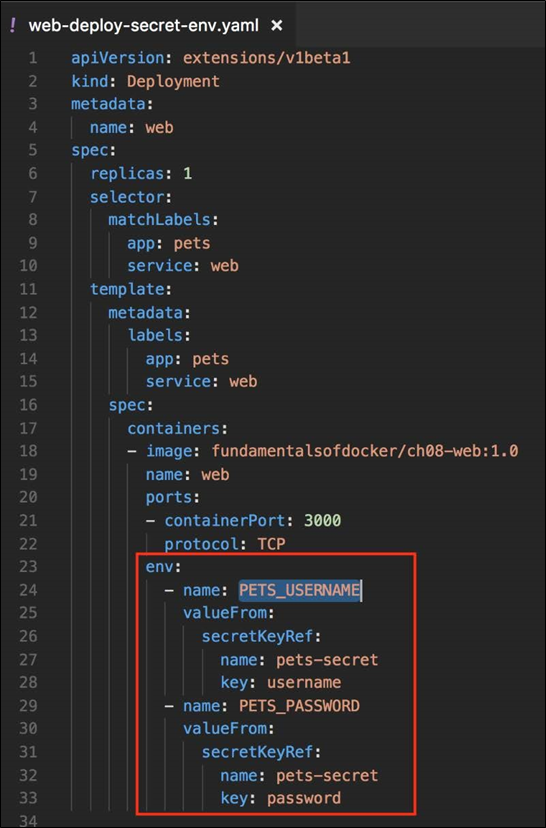

- Chapitre 11, Déploiement, mise à jour et sécurisation d’une application avec Kubernetes , ce chapitre explique comment déployer, mettre à jour et faire évoluer des applications dans un cluster Kubernetes. Il explique également comment les déploiements sans temps d’arrêt sont atteints pour permettre des mises à jour et des annulations sans interruption des applications critiques. Ce chapitre présente également les secrets de Kubernetes comme moyen de configurer les services avec et de protéger les données sensibles.

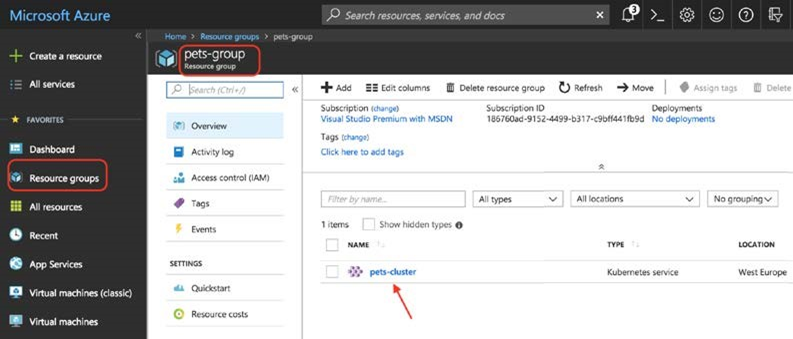

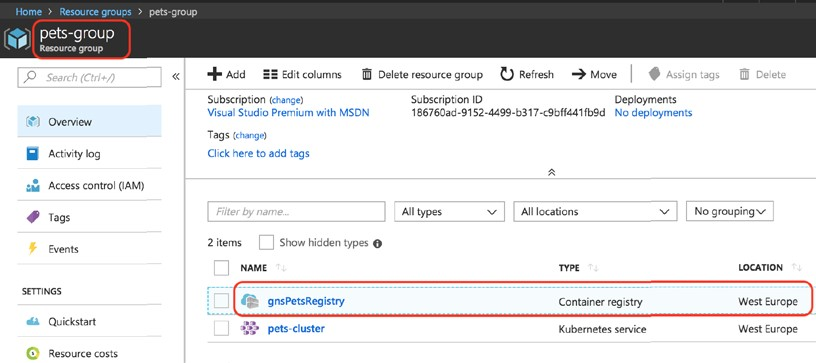

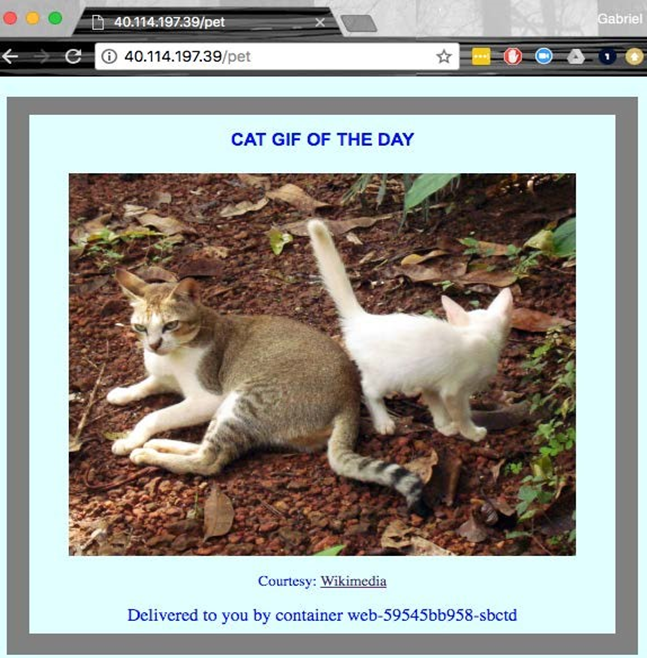

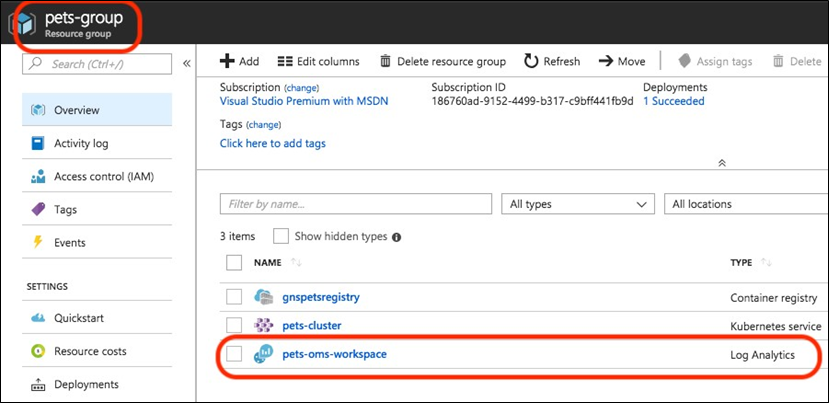

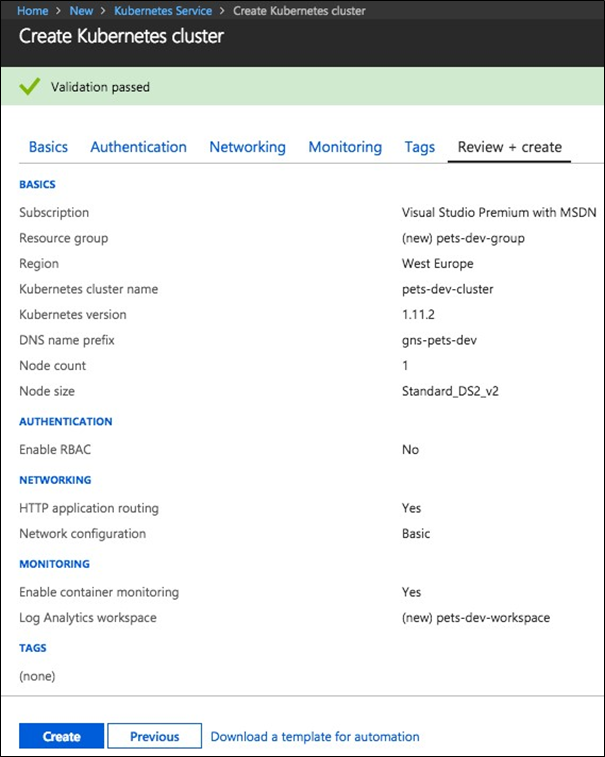

- Chapitre 12, Exécution d’une application conteneurisée dans le cloud, ce chapitre montre comment déployer une application conteneurisée complexe dans un cluster Kubernetes hébergé sur Microsoft Azure à l’aide de l’offre Azure Kubernetes Service (AKS). Premièrement, il explique comment approvisionner un cluster Kubernetes, deuxièmement, il montre comment héberger les images Docker dans Azure Container Registry et enfin, il montre comment déployer, exécuter, surveiller, mettre à l’échelle et mettre à niveau l’application. Le chapitre montre également comment mettre à niveau la version de Kubernetes dans le cluster sans provoquer de temps d’arrêt.

Que sont les conteneurs et pourquoi devrais-je les utiliser?

Le premier chapitre de cet article vous fera découvrir le monde des conteneurs et leur orchestration. Cet article suppose que vous n’avez aucune connaissance préalable dans le domaine des conteneurs et vous donnera une introduction très pratique sur le sujet.

Dans ce chapitre, nous nous concentrons sur la chaîne d’approvisionnement des logiciels et les frictions à l’intérieur. Nous présentons ensuite les conteneurs comme un moyen de réduire ce frottement et d’ajouter une sécurité de niveau entreprise par-dessus. Dans ce chapitre, nous examinons également comment les conteneurs et l’écosystème qui les entoure sont assemblés. Nous soulignons en particulier la distinction entre les composants OSS (Operations Support System) en amont, réunis sous le nom de code Moby, qui forment les blocs de construction des produits en aval de Docker et d’autres fournisseurs.

Le chapitre couvre les sujets suivants :

- Que sont les conteneurs ?

- Pourquoi les conteneurs sont-ils importants ?

- Quel est l’avantage pour moi ou pour mon entreprise ?

- Le projet Moby

- Produits Docker

- L’écosystème des conteneurs

- Architecture de conteneur

Après avoir terminé ce module, vous pourrez :

- Expliquez en quelques phrases simples à un profane intéressé ce que sont les conteneurs, en utilisant une analogie comme les conteneurs physiques

- Justifiez à un profane intéressé pourquoi les conteneurs sont si importants, en utilisant une analogie telle que les conteneurs physiques par rapport à l’expédition traditionnelle, ou les maisons d’appartements par rapport aux maisons unifamiliales, etc.

- Nommez au moins quatre composants open source en amont utilisés par les produits Docker, tels que Docker pour Mac / Windows

- Identifier au moins trois produits Docker

Exigences techniques

Ce chapitre est une introduction théorique au sujet. Par conséquent, il n’y a pas d’exigences techniques particulières pour ce chapitre.

Que sont les conteneurs ?

Un conteneur de logiciel est une chose assez abstraite et cela pourrait donc aider si nous commençons par une analogie qui devrait être assez familière à la plupart des lecteurs. L’analogie est un conteneur d’expédition dans l’industrie du transport.

Nous transportons d’énormes quantités de marchandises dans des trains, des navires et des camions. Nous les déchargeons à des emplacements cibles, ce qui peut être un autre moyen de transport. Les marchandises sont souvent diverses et complexes à manipuler. Avant l’invention des conteneurs d’expédition, ce déchargement d’un moyen de transport et son chargement dans un autre était un processus vraiment complexe et fastidieux. Prenons, par exemple, un agriculteur apportant une charrette pleine de pommes à une gare centrale où les pommes sont ensuite chargées dans un train, avec toutes les pommes de nombreux autres agriculteurs. Ou pensez à un vigneron apportant ses tonneaux de vin avec un camion au port où ils sont déchargés, puis transférés sur un navire qui transportera les tonneaux à l’étranger. Chaque type de produit était conditionné à sa manière et devait donc être traité à sa manière. Toute marchandise en vrac risquait d’être volée ou endommagée au cours du processus. Puis vint le conteneur qui révolutionna totalement l’industrie du transport.

Le conteneur est juste une boîte métallique aux dimensions standardisées. La longueur, la largeur et la hauteur de chaque conteneur sont identiques. C’est un point très important. Sans l’accord du monde sur une taille standard, les conteneurs d’expédition n’auraient pas connu un tel succès. De nos jours, les entreprises qui souhaitent faire transporter leurs marchandises de A à B emballent ces marchandises dans ces conteneurs standardisés. Ensuite, ils appellent un expéditeur qui vient avec un moyen de transport standardisé. Il peut s’agir d’un camion conçu pour charger un conteneur ou d’un train dont les wagons peuvent chacun transporter un ou plusieurs conteneurs. Enfin, nous avons des navires spécialisés dans le transport d’énormes quantités de conteneurs. Les expéditeurs n’ont jamais besoin de déballer et de reconditionner les marchandises. Pour un expéditeur, un conteneur est simplement une boîte noire ; ils ne sont pas intéressés par ce qu’il contient et ne devraient pas s’en soucier dans la plupart des cas. Ce n’est qu’une grosse boîte en fer aux dimensions standard. L’emballage des marchandises dans des conteneurs est désormais entièrement délégué aux parties qui souhaitent que leurs marchandises soient expédiées, et elles devraient savoir comment les manipuler et les emballer. Étant donné que tous les conteneurs ont la même forme et les mêmes dimensions normalisées, les expéditeurs peuvent utiliser des outils standardisés pour manipuler les conteneurs, c’est-à-dire des grues qui déchargent des conteneurs, par exemple d’un train ou d’un camion, et les chargent sur un navire ou vice versa. Un seul type de grue suffit pour gérer tous les conteneurs qui se présentent avec le temps. De plus, les moyens de transport peuvent être normalisés, comme les porte-conteneurs, les camions et les trains. En raison de toute cette standardisation, tous les processus dans et autour de l’expédition des marchandises ont pu être standardisés, et ainsi rendus beaucoup plus efficaces qu’ils ne l’étaient avant l’ère des conteneurs.

Je pense que vous devriez maintenant bien comprendre pourquoi les conteneurs d’expédition sont si importants et pourquoi ils ont révolutionné toute l’industrie du transport. J’ai choisi cette analogie parce que les conteneurs logiciels que nous allons examiner ici remplissent exactement le même rôle dans la chaîne d’approvisionnement des logiciels que les conteneurs d’expédition dans la chaîne d’approvisionnement des biens physiques.

Voyons ce que les développeurs faisaient avant de développer une nouvelle application. Une fois une application terminée aux yeux des développeurs, ils remettraient cette application aux ingénieurs d’exploitation qui devaient ensuite l’installer sur les serveurs de production et la faire fonctionner. Si les ingénieurs d’exploitation ont eu de la chance, ils ont même obtenu un document précis avec des instructions d’installation des développeurs. Jusqu’ici tout va bien, et la vie était facile. Mais les choses sont devenues un peu incontrôlables quand il y avait de nombreuses équipes de développeurs dans une entreprise qui créaient des types d’applications très différents, mais tous devaient être installés sur les mêmes serveurs de production et continuer à y fonctionner. Habituellement, chaque application a des dépendances externes telles que le framework sur lequel elle a été construite ou les bibliothèques qu’elle utilise, etc.

Parfois, deux applications utilisent le même framework mais dans des versions différentes qui peuvent être compatibles ou non entre elles. La vie de notre ingénieur d’exploitation est devenue beaucoup plus difficile au fil du temps. Ils devaient être vraiment créatifs avec la façon dont ils pouvaient charger leurs serveurs, ou leur « vaisseau », avec différentes applications sans casser quelque chose. L’installation d’une nouvelle version d’une certaine application était un projet complexe en soi et nécessitait souvent des mois de planification et de test. En d’autres termes, il y avait beaucoup de friction dans la chaîne d’approvisionnement des logiciels. Mais de nos jours, les entreprises s’appuient de plus en plus sur les logiciels et les cycles de sortie deviennent de plus en plus courts. Nous ne pouvons plus nous permettre d’avoir une nouvelle version peut-être deux fois par an. Les applications doivent être mises à jour en quelques semaines ou jours, voire parfois plusieurs fois par jour. Les entreprises qui ne se conforment pas risquent de fermer leurs portes en raison du manque d’agilité. Alors, quelle est la solution ?

Une première approche a été d’utiliser des machines virtuelles (VM). Au lieu d’exécuter plusieurs applications sur le même serveur, les entreprises emballent et exécutent une seule application par machine virtuelle. Avec lui, les problèmes de compatibilité avaient disparu et la vie semblait à nouveau bonne. Malheureusement, le bonheur n’a pas duré longtemps. Les machines virtuelles sont des bêtes assez lourdes en soi, car elles contiennent toutes un système d’exploitation complet tel que Linux ou Windows Server et tout cela pour une seule application. C’est comme si, dans l’industrie des transports, vous utilisiez un gigantesque navire uniquement pour transporter un camion chargé de bananes. Quel gâchis. Cela ne peut jamais être rentable. La solution ultime au problème était de fournir quelque chose de beaucoup plus léger que les machines virtuelles, mais également capable d’encapsuler parfaitement les marchandises dont il avait besoin pour transporter. Ici, les produits sont l’application réelle écrite par nos développeurs plus (et c’est important) toutes les dépendances externes de l’application, telles que le framework, les bibliothèques, les configurations, etc. Ce Saint Graal d’un mécanisme d’emballage logiciel était le conteneur Docker.

Les développeurs utilisent des conteneurs Docker pour empaqueter leurs applications, leurs frameworks et leurs bibliothèques, puis ils expédient ces conteneurs aux testeurs ou aux ingénieurs d’exploitation. Pour les testeurs et les ingénieurs d’exploitation, le conteneur n’est qu’une boîte noire. Surtout, il s’agit d’une boîte noire normalisée. Tous les conteneurs, quelle que soit l’application exécutée à l’intérieur, peuvent être traités de la même manière. Les ingénieurs savent que si un conteneur s’exécute sur leurs serveurs, tous les autres conteneurs doivent également fonctionner. Et cela est vrai, à part quelques cas marginaux qui existent toujours. Ainsi, les conteneurs Docker sont un moyen de conditionner les applications et leurs dépendances de manière standardisée. Docker a ensuite inventé l’expression « Construire, expédier et exécuter n’importe où ».

Pourquoi les conteneurs sont-ils importants ?

De nos jours, le temps entre les nouvelles versions d’une application devient de plus en plus court, mais le logiciel lui-même ne devient pas plus simple. Au contraire, les projets logiciels augmentent en complexité. Ainsi, nous avons besoin d’un moyen d’apprivoiser la bête et de simplifier la chaîne logistique des logiciels.

Amélioration de la sécurité

Nous entendons également chaque jour combien de cybercrimes sont en augmentation. De nombreuses entreprises bien connues sont affectées par des failles de sécurité. Les données clients très sensibles sont volées, telles que les numéros de sécurité sociale, les informations de carte de crédit, etc. Mais non seulement les données clients sont compromises, mais des secrets d’entreprise sensibles sont également volés.

Les conteneurs peuvent aider de plusieurs façons. Tout d’abord, Gartner a découvert dans un récent rapport que les applications s’exécutant dans un conteneur sont plus sécurisées que leurs homologues ne s’exécutant pas dans un conteneur. Les conteneurs utilisent des primitives de sécurité Linux telles que les espaces de noms du noyau Linux pour mettre en sandbox différentes applications s’exécutant sur les mêmes ordinateurs et groupes de contrôle (cgroups), pour éviter le problème de voisin bruyant lorsqu’une mauvaise application utilise toutes les ressources disponibles d’un serveur et affame toutes les autres applications.

Étant donné que les images de conteneurs sont immuables, il est facile de les analyser pour détecter les vulnérabilités et les expositions connues et, ce faisant, augmenter la sécurité globale de nos applications.

Une autre façon de sécuriser davantage notre chaîne logistique de logiciels lors de l’utilisation de conteneurs est d’utiliser la confiance dans le contenu. La confiance dans le contenu garantit essentiellement que l’auteur d’une image de conteneur est bien celui qu’il prétend être et que le consommateur de l’image de conteneur à la garantie que l’image n’a pas été falsifiée en transit. Ce dernier est connu comme une attaque d’homme au milieu (MITM).

Tout ce que je viens de dire est bien sûr techniquement également possible sans utiliser de conteneurs, mais comme les conteneurs introduisent une norme mondialement acceptée, il est tellement plus facile de mettre en œuvre ces meilleures pratiques et de les appliquer.

D’accord, mais la sécurité n’est pas la seule raison pour laquelle les conteneurs sont importants. Il existe d’autres raisons, comme expliqué dans les deux sections suivantes.

Simuler des environnements de type production

L’un d’eux est le fait que les conteneurs permettent de simuler facilement un environnement de production, même sur l’ordinateur portable d’un développeur. Si nous pouvons conteneuriser n’importe quelle application, nous pouvons également conteneuriser, disons, une base de données telle qu’Oracle ou MS SQL Server. Désormais, tous ceux qui ont déjà dû installer une base de données Oracle sur un ordinateur savent que ce n’est pas la chose la plus simple à faire et que cela prend beaucoup de place sur votre ordinateur. Vous ne voudriez pas faire cela à votre ordinateur portable de développement juste pour tester si l’application que vous avez développée fonctionne vraiment de bout en bout. Avec les conteneurs à portée de main, je peux exécuter une base de données relationnelle complète dans un conteneur aussi facilement que dire 1, 2, 3. Et lorsque j’ai terminé les tests, je peux simplement arrêter et supprimer le conteneur et la base de données disparaît sans laissant une trace sur mon ordinateur.

Étant donné que les conteneurs sont très légers par rapport aux machines virtuelles, il n’est pas rare que de nombreux conteneurs s’exécutent en même temps sur l’ordinateur portable d’un développeur sans surcharger l’ordinateur portable.

Normaliser l’infrastructure

Une troisième raison pour laquelle les conteneurs sont importants est que les opérateurs peuvent enfin se concentrer sur ce qu’ils font vraiment bien, approvisionner l’infrastructure, et exécuter et surveiller les applications en production. Lorsque les applications qu’ils doivent exécuter sur un système de production sont toutes conteneurisées, les opérateurs peuvent commencer à standardiser leur infrastructure. Chaque serveur devient juste un autre hôte Docker. Aucune bibliothèque spéciale de frameworks ne doit être installée sur ces serveurs, juste un OS et un runtime de conteneur tel que Docker.

De plus, les opérateurs ne doivent plus avoir de connaissances intimes sur les composants internes des applications, car ces applications fonctionnent de manière autonome dans des conteneurs qui devraient ressembler à des boîtes noires pour les ingénieurs d’exploitation, de la même manière que les conteneurs d’expédition ressemblent au personnel dans l’industrie du transport.

Quel est l’avantage pour moi ou pour mon entreprise ?

Quelqu’un a dit qu’aujourd’hui, chaque entreprise d’une certaine taille doit reconnaître qu’elle doit être une entreprise de logiciels. Le logiciel gère toutes les entreprises, point final. Comme chaque entreprise devient une entreprise de logiciels, il est nécessaire d’établir une chaîne d’approvisionnement de logiciels. Pour que l’entreprise reste compétitive, sa chaîne d’approvisionnement de logiciels doit être sécurisée et efficace. L’efficacité peut être obtenue grâce à une automatisation et une normalisation approfondie. Mais dans les trois domaines, la sécurité, l’automatisation et la normalisation, les conteneurs ont prouvé leur supériorité.

De grandes entreprises bien connues ont signalé que lors de la conteneurisation des applications existantes (beaucoup les appellent des applications traditionnelles) et de l’établissement d’une chaîne d’approvisionnement de logiciels entièrement automatisée basée sur les conteneurs, elles peuvent réduire d’un facteur le coût utilisé pour la maintenance de ces applications critiques. de 50 à 60% et ils peuvent réduire le temps entre les nouvelles versions de ces applications traditionnelles jusqu’à 90%.

Cela dit, l’adoption de la technologie des conteneurs permet à ces entreprises d’économiser beaucoup d’argent, tout en accélérant le processus de développement et en réduisant les délais de commercialisation.

Le projet Moby

À l’origine, lorsque la société Docker a introduit les conteneurs Docker, tout était open source. Docker n’avait pas de produits commerciaux pour le moment. Le moteur Docker que la société a développé était un logiciel monolithique. Il contenait de nombreuses parties logiques, telles que l’exécution du conteneur, une bibliothèque réseau, une API RESTful, une interface de ligne de commande et bien plus encore.

D’autres fournisseurs ou projets tels que Red Hat ou Kubernetes utilisaient le moteur Docker dans leurs propres produits, mais la plupart du temps, ils n’utilisaient qu’une partie de ses fonctionnalités. Par exemple, Kubernetes n’a pas utilisé la bibliothèque réseau Docker du moteur Docker mais a fourni sa propre façon de mettre en réseau. Red Hat à son tour n’a pas mis à jour le moteur Docker fréquemment et a préféré appliquer des correctifs non officiels aux anciennes versions du moteur Docker, mais ils l’appelaient toujours le moteur Docker.

De toutes ces raisons et bien d’autres, l’idée est apparue que Docker devait faire quelque chose pour séparer clairement la partie open source Docker de la partie commerciale Docker. En outre, la société voulait empêcher les concurrents d’utiliser et d’abuser du nom Docker pour leurs propres gains. C’est la raison principale de la naissance du projet Moby. Il sert de cadre à la plupart des composants open source que Docker a développés et continue de développer. Ces projets open source ne portent plus le nom Docker.

Le projet Moby comprend des composants pour la gestion des images, la gestion des secrets, la gestion de la configuration, la mise en réseau et l’approvisionnement, pour n’en nommer que quelques-uns. En outre, une partie du projet Moby comprend des outils Moby spéciaux qui sont, par exemple, utilisés pour assembler des composants en artefacts exécutables.

Certains des composants qui appartiendraient techniquement au projet Moby ont été donnés par Docker à la Cloud Native Computing Foundation (CNCF) et n’apparaissent donc plus dans la liste des composants. Les plus importants sont containerd et runc qui forment ensemble le runtime du conteneur.

Produits Docker

Docker sépare actuellement ses gammes de produits en deux segments. Il y a la Community Edition (CE) qui est une source fermée mais entièrement gratuite, et puis il y a la Enterprise Edition (EE) qui est également une source fermée et doit être sous licence sur une base annuelle. Les produits d’entreprise sont pris en charge par le support 24 x 7 et sont pris en charge avec des corrections de bogues beaucoup plus longtemps que leurs homologues CE.

Docker CE

L’édition de la communauté Docker comprend des produits tels que la boîte à outils Docker, Docker pour Mac et Docker pour Windows. Ces trois produits visent principalement les développeurs.

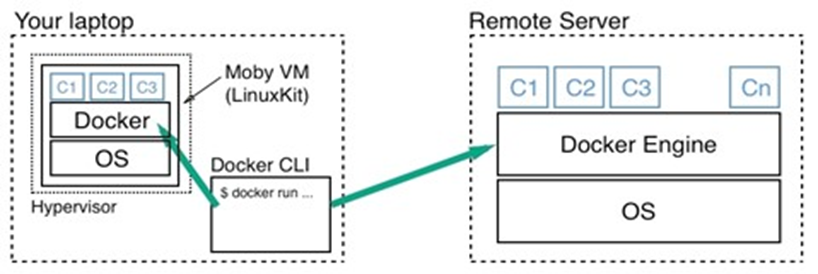

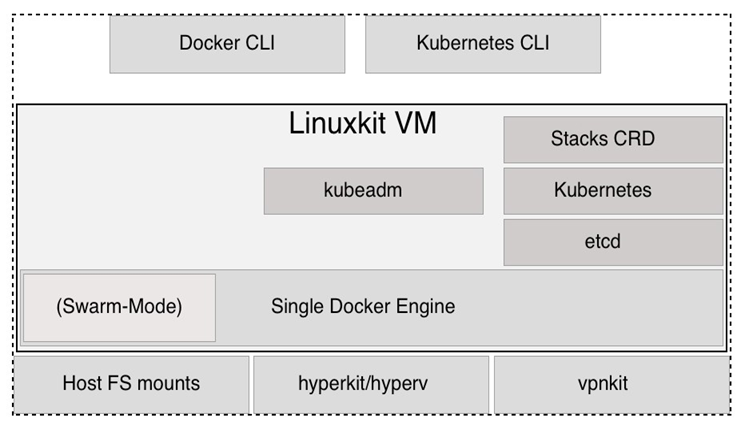

Docker pour Mac et Docker pour Windows sont des applications de bureau faciles à installer qui peuvent être utilisées pour créer, déboguer et tester des applications ou des services Dockerized sur un Mac ou sur Windows. Docker pour Mac et Docker pour Windows sont des environnements de développement complets qui s’intègrent profondément avec leur infrastructure d’hyperviseur, leur réseau et leur système de fichiers respectifs. Ces outils sont le moyen le plus rapide et le plus fiable d’exécuter Docker sur un Mac ou Windows.

Sous l’égide de la CE, il existe également deux produits plus destinés aux ingénieurs d’exploitation. Ces produits sont Docker pour Azure et Docker pour AWS.

Par exemple, avec Docker pour Azure, qui est une application Azure native, vous pouvez configurer Docker en quelques clics, optimisé et intégré aux services Azure Infrastructure as a Service ( IaaS ) sous-jacents . Il aide les ingénieurs d’exploitation à accélérer le temps nécessaire pour créer et exécuter des applications Docker dans Azure.

Docker pour AWS fonctionne de manière très similaire, mais pour le cloud d’Amazon.

Docker EE

Le Docker EE se compose des deux produits Universal Control Plane (UCP) et Docker Trusted Registry (DTR) qui s’exécutent tous les deux sur Docker Swarm. Les deux sont Applications en essaim. Docker EE s’appuie sur les composants en amont du Moby projette et ajoute des fonctionnalités de niveau entreprise telles que le contrôle d’accès basé sur les rôles (RBAC), la multi-location, les clusters mixtes de Docker Swarm et Kubernetes, l’interface utilisateur Web et la confiance du contenu, ainsi que la numérisation d’images par-dessus.

L’écosystème des conteneurs

Il n’y a jamais eu une nouvelle technologie introduite dans l’informatique qui a pénétré le paysage aussi rapidement et complètement que les conteneurs. Toute entreprise qui ne veut pas être laissée pour compte ne peut ignorer les conteneurs. Cet énorme intérêt pour les conteneurs de tous les secteurs de l’industrie a déclenché de nombreuses innovations dans ce secteur. De nombreuses entreprises se sont spécialisées dans les conteneurs et proposent soit des produits qui s’appuient sur cette technologie, soit des outils qui la prennent en charge.

Initialement, Docker n’avait pas de solution pour l’orchestration de conteneurs, donc d’autres entreprises ou projets, open source ou non, ont tenté de combler cet écart. Le plus important est Kubernetes qui a été lancé par Google et ensuite donné à la CNCF. Les autres produits d’orchestration de conteneurs sont Apache Mesos, Rancher, Open Shift de Red Hat, Swarm de Docker, etc.

Plus récemment, la tendance s’oriente vers un maillage de services. C’est le nouveau mot à la mode. Au fur et à mesure que nous conteneurisons de plus en plus d’applications et que nous transformons ces applications en applications davantage orientées microservices, nous rencontrons des problèmes qu’un logiciel d’orchestration simple ne peut plus résoudre de manière fiable et évolutive. Les sujets dans ce domaine sont la découverte de services, la surveillance, le traçage et l’agrégation de journaux. De nombreux nouveaux projets ont vu le jour dans ce domaine, le plus populaire en ce moment étant Istio, qui fait également partie de la CNCF.

Beaucoup disent que la prochaine étape dans l’évolution du logiciel est les fonctions, ou plus précisément, les fonctions en tant que service (FaaS). Il existe des projets qui fournissent exactement ce type de service et sont construits sur des conteneurs. Un exemple frappant est OpenFaaS.

Nous n’avons fait qu’effleurer la surface de l’écosystème des conteneurs. Toutes les grandes sociétés informatiques telles que Google, Microsoft, Intel, Red Hat, IBM et bien d’autres travaillent fiévreusement sur les conteneurs et les technologies connexes. La CNCF qui porte principalement sur les conteneurs et les technologies associées, a tellement de projets enregistrés, qu’ils ne tiennent plus tous sur une affiche. C’est une période passionnante pour travailler dans ce domaine. Et à mon humble avis, ce n’est que le début.

Architecture des conteneurs

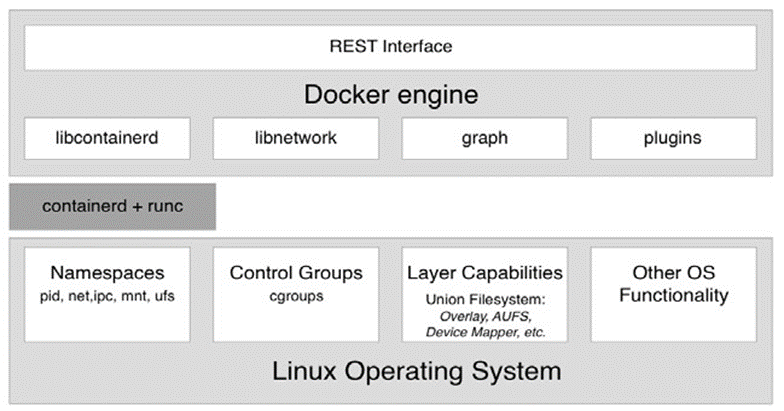

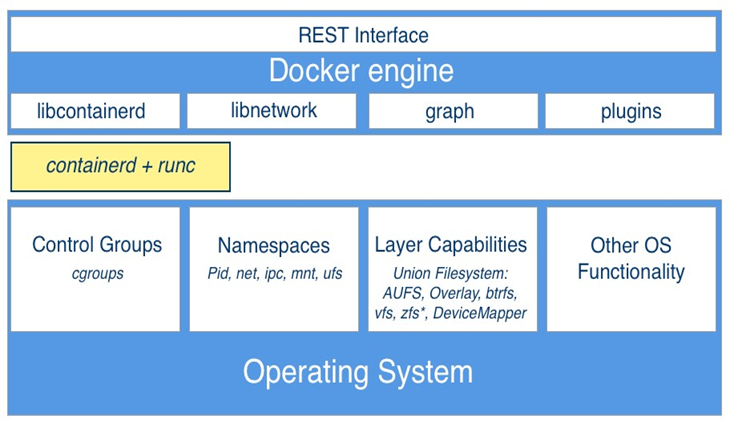

Maintenant, discutons à un niveau élevé de la conception d’un système capable d’exécuter des conteneurs Docker. Le diagramme suivant illustre à quoi ressemble un ordinateur sur lequel Docker a été installé. Soit dit en passant, un ordinateur sur lequel Docker est installé est souvent appelé hôte Docker, car il peut exécuter ou héberger des conteneurs Docker :

Schéma d’architecture de haut niveau du moteur Docker

Dans le schéma précédent, nous voyons trois parties essentielles :

- En bas, nous avons le système d’exploitation Linux

- Au milieu gris foncé, nous avons le runtime du conteneur

- En haut, nous avons le moteur Docker

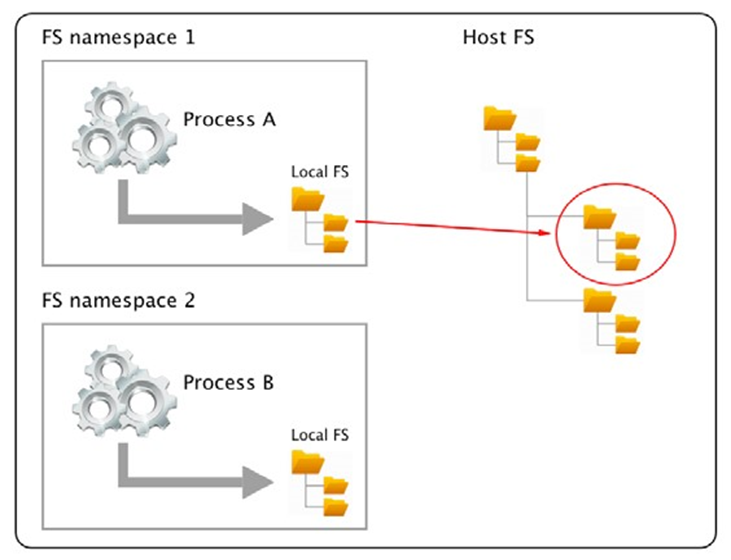

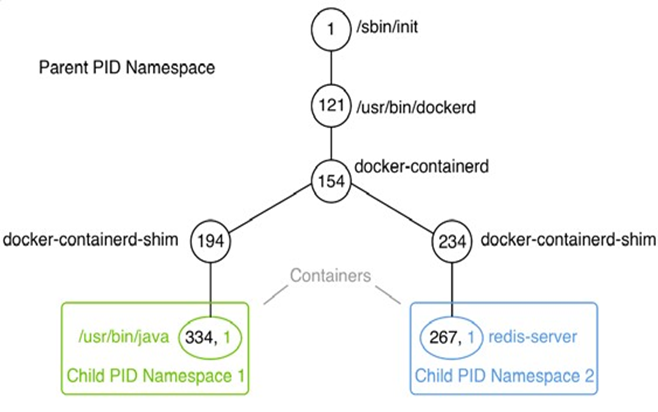

Les conteneurs ne sont possibles qu’en raison du fait que le système d’exploitation Linux fournit certaines primitives, telles que les espaces de noms, les groupes de contrôle, les capacités de couche, etc., qui sont exploitées de manière très spécifique par l’exécution du conteneur et le moteur Docker. Les espaces de noms du noyau Linux tels que les espaces de noms Process ID (pid) ou les espaces de noms réseau (net) permettent à Docker d’encapsuler ou de sandboxer les processus qui s’exécutent à l’intérieur du conteneur. Les groupes de contrôle s’assurent que les conteneurs ne peuvent pas souffrir du syndrome du voisin bruyant, où une seule application s’exécutant dans un conteneur peut consommer la plupart ou la totalité des ressources disponibles de l’hôte Docker entier. Les groupes de contrôle permettent à Docker de limiter les ressources, telles que le temps CPU ou la quantité de RAM que chaque conteneur obtient allouée de façon maximale.

Le runtime du conteneur sur un hôte Docker se compose de containerd et runc. runc est la fonctionnalité de bas niveau du conteneur runtime et containerd , qui est basé sur runc , fournit la fonctionnalité de niveau supérieur. Les deux sont open source et ont été donnés par Docker à la CNCF.

Le runtime du conteneur est responsable de l’ensemble du cycle de vie d’un conteneur. Il extrait une image de conteneur (qui est le modèle d’un conteneur) d’un registre si nécessaire, crée un conteneur à partir de cette image, initialise et exécute le conteneur, et finalement arrête et supprime le conteneur du système lorsque cela lui est demandé.

Le moteur Docker fournit des fonctionnalités supplémentaires en plus de l’exécution du conteneur, telles que les bibliothèques réseau ou la prise en charge des plugins. Il fournit également une interface REST sur laquelle toutes les opérations de conteneur peuvent être automatisées. L’interface de ligne de commande Docker que nous utiliserons fréquemment dans cet article est l’un des consommateurs de cette interface REST.

Résumé

Dans ce chapitre, nous avons examiné comment les conteneurs peuvent réduire massivement le frottement dans la chaîne d’approvisionnement du logiciel et en plus, rendre la chaîne d’approvisionnement beaucoup plus sûre.

Dans le prochain chapitre, nous nous familiariserons avec les conteneurs. Nous apprendrons comment exécuter, arrêter et supprimer des conteneurs et les manipuler autrement. Nous aurons également un assez bon aperçu de l’anatomie des conteneurs. Pour la première fois, nous allons vraiment nous salir les mains et jouer avec ces conteneurs, alors restez à l’écoute.

Questions

Veuillez résoudre les questions suivantes pour évaluer vos progrès d’apprentissage :

- Quelles affirmations sont correctes (plusieurs réponses sont possibles) ?

- Un conteneur est une sorte de machine virtuelle légère

- Un conteneur ne fonctionne que sur un hôte Linux

- Un conteneur ne peut exécuter qu’un seul processus

- Le processus principal dans un conteneur a toujours PID 1

- Un conteneur est un ou plusieurs processus encapsulés par des espaces de noms Linux et restreints par des cgroups

- Expliquez à un profane intéressé dans vos propres mots, peut-être en utilisant des analogies, ce qu’est un conteneur.

- Pourquoi les conteneurs changent-ils la donne en informatique ? Nommez trois à quatre raisons.

- Qu’est-ce que cela signifie lorsque nous affirmons : si un conteneur fonctionne sur une plate-forme donnée, il s’exécute n’importe où … ? Nommez deux ou trois raisons pour lesquelles cela est vrai.

- Vrai ou faux : les conteneurs Docker ne sont vraiment utiles que pour les applications greenfield modernes basées sur des microservices. Veuillez justifier votre réponse.

- Combien une entreprise typique économise-t-elle en conteneurisant ses applications héritées ?

- 20%

- 33%

- 50%

- 75%

- Sur quels deux concepts de base de Linux les conteneurs sont-ils basés?

Mise en place d’un environnement de travail

Dans le dernier chapitre, nous avons appris ce que sont les conteneurs Docker et pourquoi ils sont importants. Nous avons appris quels types de conteneurs de problèmes résolvent dans une chaîne d’approvisionnement de logiciels moderne.

Dans ce chapitre, nous allons préparer notre environnement personnel ou professionnel pour travailler efficacement avec Docker. Nous discuterons en détail de la façon de configurer un environnement idéal pour les développeurs, les DevOps et les opérateurs qui peuvent être utilisés lorsque vous travaillez avec des conteneurs Docker.

Ce chapitre couvre les sujets suivants :

- Le shell de commande Linux

- PowerShell pour Windows

- Utilisation d’un gestionnaire de packages

- Choisir un éditeur de code

- Boîte à outils Docker

- Docker pour macOS et Docker pour Windows

- Minikube

- Clonage du référentiel de code source

Après avoir terminé ce chapitre, vous pourrez effectuer les opérations suivantes :

- Utilisez un éditeur sur votre ordinateur portable capable de modifier des fichiers simples tels qu’un Dockerfile ou un fichier docker- compose.yml

- Utilisez un shell tel que Bash sur macOS et PowerShell sur Windows pour exécuter les commandes Docker et d’autres opérations simples, telles que la navigation dans la structure des dossiers ou la création d’un nouveau dossier

- Installez Docker pour macOS ou Docker pour Windows sur votre ordinateur

- Exécuter des commandes Docker simples telles que la version Docker ou le conteneur Docker exécuté sur votre Docker pour macOS ou Docker pour Windows

- Installez Docker Toolbox avec succès sur votre ordinateur

- Utilisez docker-machine pour créer un hôte Docker sur VirtualBox

- Configurer votre CLI Docker locale pour accéder à distance à un hôte Docker exécuté dans VirtualBox

Exigences techniques

Pour ce chapitre, vous aurez besoin d’installer macOS ou Windows, de préférence Windows 10 Professionnel. Vous devez également avoir un accès gratuit à Internet pour télécharger des applications et la permission d’installer ces applications sur votre ordinateur portable.

Le shell de commande Linux

Les conteneurs Docker ont d’abord été développés sur Linux pour Linux. Il est donc naturel que le principal outil de ligne de commande utilisé pour travailler avec Docker, également appelé shell, soit un shell Unix ; rappelez-vous, Linux dérive d’Unix. La plupart des développeurs utilisent le shell Bash. Sur certaines distributions Linux légères, comme Alpine, Bash n’est pas installé et, par conséquent, il faut utiliser le shell Bourne plus simple, juste appelé sh. Chaque fois que nous travaillons dans un environnement Linux, comme à l’intérieur d’un conteneur ou sur une machine virtuelle Linux, nous utiliserons /bin/bash ou /bin/sh, selon leur disponibilité.

Bien que macOS X ne soit pas un système d’exploitation Linux, Linux et OS X sont tous deux des versions d’Unix et prennent donc en charge les mêmes types d’outils. Parmi ces outils, il y a les coquilles. Ainsi, lorsque vous travaillez sur un macOS, vous utiliserez probablement le shell Bash.

Dans cet article, nous attendons des lecteurs une familiarité avec les commandes de script les plus élémentaires de Bash et PowerShell si vous travaillez sous Windows. Si vous êtes un débutant absolu, nous vous recommandons fortement de vous familiariser avec les feuilles de triche suivantes :

- Aide-mémoire sur la ligne de commande Linux de Dave Child sur http://bit.ly/2mTQr8l

- Aide-mémoire de base PowerShell sur http://bit.ly/2EPHxze

PowerShell pour Windows

Sur un ordinateur, un ordinateur portable ou un serveur Windows, nous avons plusieurs outils de ligne de commande disponibles. Le plus familier est le shell de commande. Il est disponible sur n’importe quel ordinateur Windows depuis des décennies. C’est une coquille très simple. Pour des scripts plus avancés, Microsoft a développé PowerShell. PowerShell est très puissant et très populaire parmi les ingénieurs travaillant sur Windows. Sur Windows 10, enfin, nous avons le soi-disant sous-système Windows pour Linux, qui nous permet d’utiliser n’importe quel outil Linux, comme les shells Bash ou Bourne. En dehors de cela, il existe également d’autres outils qui installent un shell Bash sur Windows, par exemple, le shell Git Bash. Dans cet article, toutes les commandes utiliseront la syntaxe Bash. La plupart des commandes s’exécutent également dans PowerShell.

Nous vous recommandons donc d’utiliser PowerShell ou tout autre outil Bash pour travailler avec Docker sous Windows.

Utilisation d’un gestionnaire de packages

La façon la plus simple d’installer un logiciel sur un ordinateur portable macOS ou Windows est d’utiliser un bon gestionnaire de paquets. Sur macOS, la plupart des gens utilisent Homebrew et sur Windows, Chocolatey est un bon choix.

Installer Homebrew sur un macOS

Installer Homebrew sur un macOS est facile ; suivez simplement les instructions sur https://brew.sh/

Voici la commande pour installer Homebrew :

/usr/bin/ruby -e “$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)”

Une fois l’installation terminée, testez si Homebrew fonctionne en entrant brew –version dans le Terminal. Vous devriez voir quelque chose comme ceci :

$ brew –version

Homebrew 1.4.3

Homebrew/homebrew-core (git revision f4e35; last commit 2018-01-11)

Maintenant, nous sommes prêts à utiliser Homebrew pour installer des outils et des utilitaires. Si nous voulons, par exemple, installer l’éditeur de texte Vi, nous pouvons le faire comme ceci:

$ brew install vim

Cela va ensuite télécharger et installer l’éditeur pour vous.

Installer Chocolatey sur Windows

Pour installer le gestionnaire de packages Chocolatey sous Windows, veuillez suivre les instructions sur https://chocolatey.org/ ou simplement exécuter la commande suivante dans un terminal PowerShell que vous avez exécuté en tant qu’administrateur :

PS> Set-ExecutionPolicy Bypass -Scope Process -Force; iex ((New-Object System.Net.WebClient).DownloadString(‘https://chocolatey.org/install. ps1’))

Une fois Chocolatey installé, testez-le avec la commande choco sans paramètres supplémentaires. Vous devriez voir une sortie similaire à la suivante :

PS> choco

Chocolatey v0.10.3

Pour installer une application telle que l’éditeur Vi, utilisez la commande suivante :

PS> choco install -y vim

Le paramètre -y garantit que l’installation se déroule sans demander de reconfirmation. Veuillez noter qu’une fois que Chocolatey a installé une application, vous devez ouvrir une nouvelle fenêtre PowerShell pour l’utiliser.

Choisir un éditeur de code

L’utilisation d’un bon éditeur de code est essentielle pour travailler de manière productive avec Docker. Bien sûr, quel éditeur est le meilleur est très controversé et dépend de vos préférences personnelles. Beaucoup de gens utilisent Vim, ou d’autres tels que Emacs, Atom, Sublime ou Visual Studio (VS) Code, pour n’en nommer que quelques-uns. Si vous n’avez pas encore décidé quel éditeur vous convient le mieux, alors je vous recommande fortement d’essayer VS Code. Il s’agit d’un éditeur gratuit et léger, mais il est très puissant et est disponible pour macOS, Windows et Linux. Essaie. Vous pouvez télécharger VS Code à partir de https://code.visualstudio.com/download.

Mais si vous avez déjà un éditeur de code préféré, continuez à l’utiliser. Tant que vous pouvez modifier des fichiers texte, vous êtes prêt à partir. Si votre éditeur prend en charge la coloration syntaxique pour les fichiers Dockerfiles et JSON et YAML, c’est encore mieux.

Docker Toolbox

Docker Toolbox est disponible pour les développeurs depuis quelques années. Il précède les nouveaux outils tels que Docker pour macOS et Docker pour Windows. La boîte à outils permet à un utilisateur de travailler de manière très élégante avec des conteneurs sur n’importe quel ordinateur macOS ou Windows. Les conteneurs doivent s’exécuter sur un hôte Linux. Ni Windows ni macOS ne peuvent exécuter les conteneurs en mode natif. Ainsi, nous devons exécuter une machine virtuelle Linux sur notre ordinateur portable, où nous pouvons ensuite exécuter nos conteneurs. Docker Toolbox installe VirtualBox sur notre ordinateur portable, qui est utilisé pour exécuter les machines virtuelles Linux dont nous avons besoin.

En tant qu’utilisateur Windows, vous savez peut-être déjà qu’il existe des soi-disant conteneurs Windows qui s’exécutent nativement sur Windows. Et tu as raison. Récemment, Microsoft a porté le moteur Docker vers Windows et il est désormais possible d’exécuter des conteneurs Windows directement sur Windows Server 2016 sans avoir besoin d’une machine virtuelle. Nous avons donc maintenant deux versions de conteneurs, les conteneurs Linux et les conteneurs Windows. Les premiers ne fonctionnent que sur l’hôte Linux et les seconds ne fonctionnent que sur un serveur Windows. Dans cet article, nous discutons exclusivement des conteneurs Linux, mais la plupart des choses que nous apprenons s’appliquent également aux conteneurs Windows.

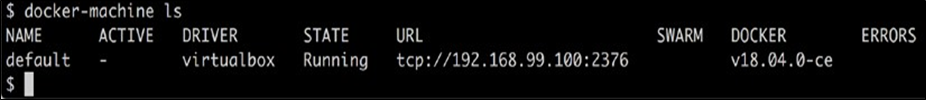

Utilisons docker-machine pour configurer notre environnement. Premièrement, nous listons toutes les VM Dockerready que nous avons actuellement définies sur notre système. Si vous venez d’installer Docker Toolbox, vous devriez voir la sortie suivante :

Liste de toutes les machines virtuelles compatibles Docker

L’adresse IP utilisée peut-être différente dans votre cas, mais elle sera certainement dans la plage 192.168.0.0/24. Nous pouvons également voir que la VM a Docker version 18.04.0-ce installé.

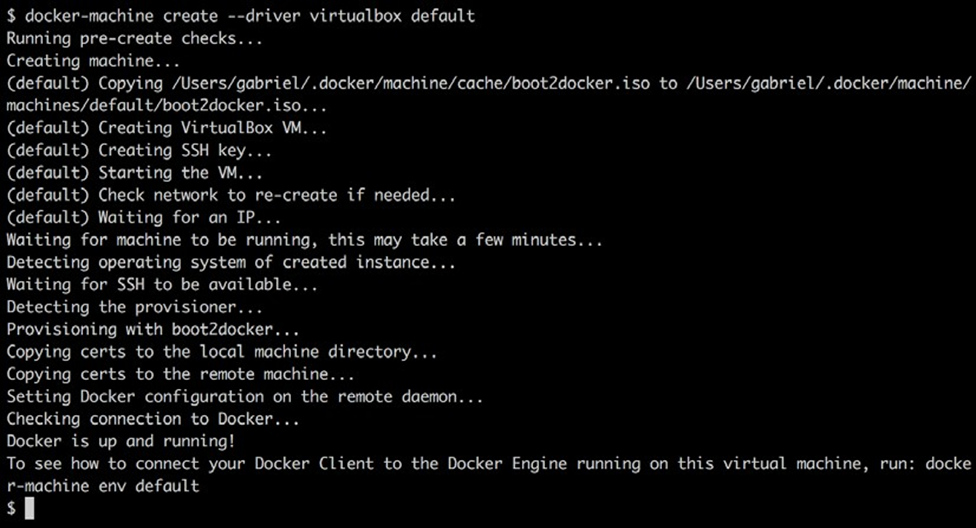

Si, pour une raison quelconque, vous n’avez pas de machine virtuelle par défaut ou si vous l’avez accidentellement supprimée, vous pouvez la créer à l’aide de la commande suivante :

$ docker-machine create –driver virtualbox default

La sortie que vous devriez voir se présente comme suit :

Création de la VM appelée par défaut dans VirtualBox

Pour voir comment connecter votre client Docker au moteur Docker exécuté sur cette machine virtuelle, exécutez la commande suivante :

$ docker-machine env default

Une fois que notre machine virtuelle appelée par défaut est prête, nous pouvons essayer de la connecter en SSH :

$ docker-machine ssh default

Lors de l’exécution de la commande précédente, nous sommes accueillis par un message de bienvenue boot2docker.

Tapez docker –version dans l’invite de commandes comme suit :

docker@default:~$ docker –version

Docker version 18.06.1-ce, build e68fc7a

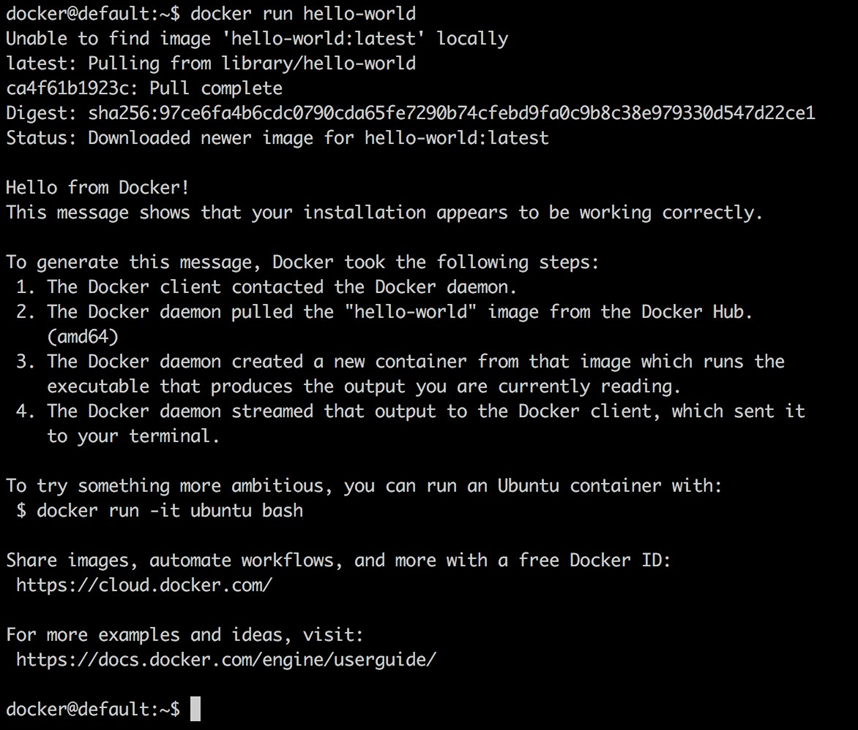

Maintenant, essayons d’exécuter un conteneur :

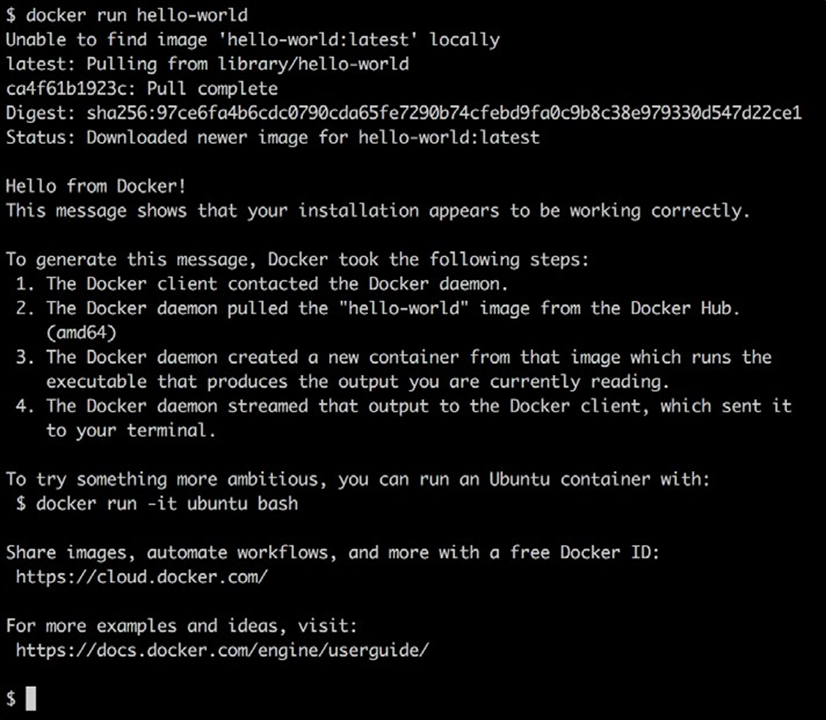

docker@default:~$ docker run hello-world

Exécution du conteneur Docker Hello World

Docker pour macOS et Docker pour Windows

Si vous utilisez un macOS ou que Windows 10 Professionnel est installé sur votre ordinateur portable, nous vous recommandons fortement d’installer Docker pour macOS ou Docker pour Windows. Ces outils vous offrent la meilleure expérience lorsque vous travaillez avec des conteneurs. Remarque : les anciennes versions de Windows ou de Windows 10 Home Edition ne peuvent pas exécuter Docker pour Windows. Docker pour Windows utilise Hyper-V pour exécuter des conteneurs de manière transparente dans une machine virtuelle, mais Hyper-V n’est pas disponible sur les anciennes versions de Windows ni dans l’édition familiale.

Installation de Docker pour macOS

Accédez au lien suivant pour télécharger Docker pour macOS sur https://docs.docker.com/docker-for-mac/install/.

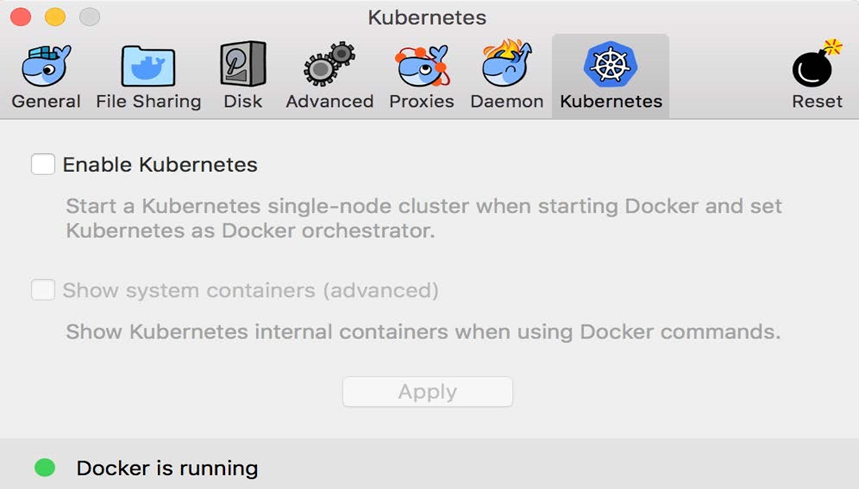

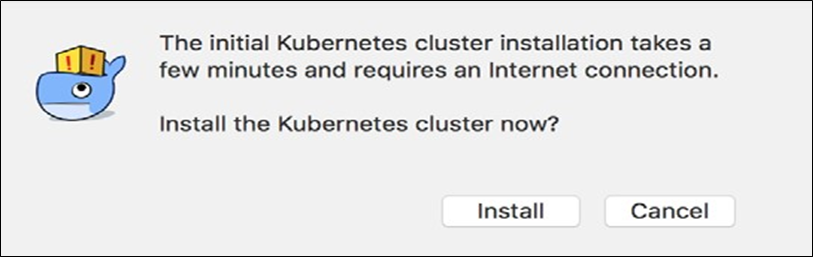

Il existe une version stable et une version dite de bord de l’outil disponibles. Dans cet article, nous allons utiliser des fonctionnalités plus récentes et Kubernetes, qui, au moment de la rédaction, ne sont disponibles que dans la version Edge. Veuillez donc sélectionner cette version.

Pour démarrer l’installation :

1. Cliquez sur le bouton Get Docker for Mac (Edge) et suivez les instructions.

2. Une fois que vous avez correctement installé Docker pour macOS, ouvrez un terminal. Appuyez sur commande + barre d’espace pour ouvrir Spotlight et tapez terminal, puis appuyez sur entrée. Le terminal d’Apple sera ouvert comme suit :

Apple Terminal window

3. Tapez docker –version dans l’invite de commande et appuyez sur Entrée. Si Docker pour macOS est correctement installé, vous devriez obtenir une sortie similaire à la suivante :

$ docker –version

Docker version 18.02.0-ce-rc2, build f968a2c

4. Pour voir si vous pouvez exécuter des conteneurs, entrez la commande suivante dans le terminal et appuyez sur Entrée :

$ docker run hello-world

Si tout se passe bien, votre sortie devrait ressembler à ceci :

Exécution du conteneur Hello World sur Docker pour macOS

Félicitations, vous êtes maintenant prêt à travailler avec les conteneurs Docker.

Installation de Docker pour Windows

Remarque, vous ne pouvez installer Docker pour Windows que sur Windows 10 Professionnel ou Windows Server 2016 car il nécessite Hyper-V, qui n’est pas disponible sur les ancienness Versions Windows ou sur l’édition Home de Windows 10. Si vous utilisez Windows 10 Home ou une ancienne version de Windows, vous devrez vous en tenir à Docker Toolbox.

1. Accédez au lien suivant pour télécharger Docker pour Windows à l’adresse https://docs.docker.com/docker-for-windows/install/.

Il existe une version stable et une version dite de bord de l’outil disponibles. Dans cet article, nous allons utiliser des fonctionnalités plus récentes et Kubernetes, qui, au moment de la rédaction, ne sont disponibles que dans la version Edge. Veuillez donc sélectionner cette version.

2. Pour démarrer l’installation, cliquez sur le bouton Get Docker for Windows (Edge) et suivez les instructions. Avec Docker pour Windows, vous pouvez développer, exécuter et tester des conteneurs Linux et des conteneurs Windows. Dans cet article, cependant, nous ne discutons que des conteneurs Linux.

3. Une fois que vous avez correctement installé Docker pour Windows. Ouvrez une fenêtre PowerShell et tapez docker –version dans l’invite de commandes. Vous devriez voir quelque chose comme ceci :

PS> docker –version

Docker version 18.04.0-ce, build 3d479c0

Utilisation de docker-machine sous Windows avec Hyper-V

Si Docker pour Windows est installé sur votre ordinateur portable Windows, Hyper-V est également activé. Dans ce cas, vous ne pouvez pas utiliser Docker Toolbox car il utilise VirtualBox, et Hyper-V et VirtualBox ne peuvent pas coexister et s’exécuter en même temps. Dans ce cas, vous pouvez utiliser docker-machine avec le pilote Hyper-V.

1. Ouvrez une console PowerShell en tant qu’administrateur. Installez docker-machine à l’aide de Chocolatey comme suit:

PS> choco install -y docker-machine

2. À l’aide du gestionnaire Hyper-V de Windows, créez un nouveau commutateur interne appelé DM Internal Switch, où DM signifie docker-machine.

3. Créez une machine virtuelle appelée par défaut dans Hyper-V avec la commande suivante :

PS> docker-machine create –driver hyperv –hyperv-virtual- switch “DM Internal Switch” default

Vous devez exécuter la commande précédente en mode administrateur, sinon elle échouera.

Vous devriez voir la sortie suivante générée par la commande précédente :

Running pre-create checks…

(boot2docker) Image cache directory does not exist, creating it at C:\Users\Docker\.docker\machine\cache… (boot2docker) No default Boot2Docker ISO found locally, downloading the latest release…

(boot2docker) Latest release for github.com/boot2docker/

boot2docker is v18.06.1-ce ….

….

Checking connection to Docker…

Docker is up and running!

To see how to connect your Docker Client to the Docker Engine running on this virtual machine, run: C:\Program Files\Doc ker\Docker\Resources\bin\docker-machine.exe env default

4. Pour voir comment connecter votre client Docker au moteur Docker exécuté sur cette machine virtuelle, exécutez ce qui suit :

C:\Program Files\Docker\Docker\Resources\bin\docker-machine.exe env default

5. La liste de toutes les machines virtuelles générées par docker-machine nous donne la sortie suivante :

PS C:\WINDOWS\system32> docker-machine ls

NAME ACTIVE DRIVER STATE URL SWARM DOCKER ERRORS

default . – hyperv Running tcp://[…]:2376 v18.06.1-ce

6. Maintenant, passons à SSH dans notre VM boot2docker :

PS> docker-machine ssh default

Vous devriez être accueilli par l’écran d’accueil.

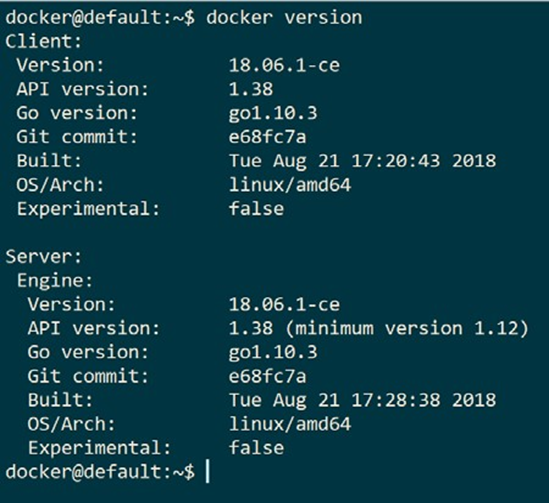

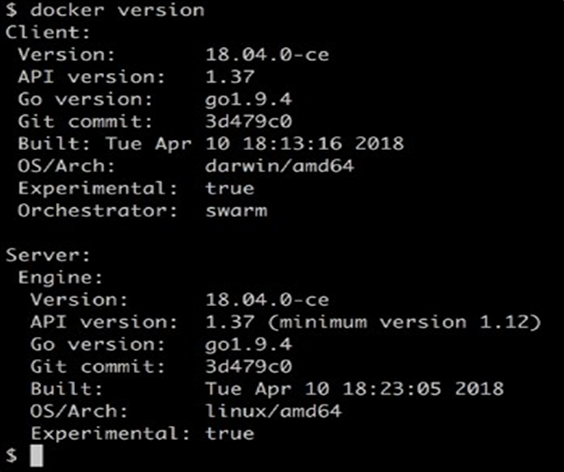

Nous pouvons tester la machine virtuelle en exécutant notre commande docker version , qui est illustrée comme suit:

Version du client Docker (CLI) et du serveur

Il s’agit certainement d’une machine virtuelle Linux, comme nous pouvons le voir sur l’entrée OS / Arch, et Docker 18.06.1-c’est installé.

Minikube

Si vous ne pouvez pas utiliser Docker pour macOS ou Windows ou, pour une raison quelconque, vous n’avez accès qu’à une ancienne version de l’outil qui ne prend pas encore en charge Kubernetes, alors c’est une bonne idée d’installer Minikube. Minikube fournit un cluster Kubernetes à nœud unique sur votre poste de travail et est accessible via kubectl , qui est l’outil de ligne de commande utilisé pour travailler avec Kubernetes.

Installation de Minikube sur macOS et Windows

Pour installer Minikube pour macOS ou Windows, accédez au lien suivant à https://kubernetes.io/docs/tasks/tools/install-minikube/.

Suivez attentivement les instructions. Si Docker Toolbox est installé, vous disposez déjà d’un hyperviseur sur votre système, car le programme d’installation de Docker Toolbox a également installé VirtualBox. Sinon, je vous recommande d’installer d’abord VirtualBox.

Si Docker pour macOS ou Windows est installé, vous avez déjà installé kubectl , vous pouvez donc ignorer cette étape également. Sinon, suivez les instructions sur le site.

Enfin, sélectionnez le dernier binaire pour Minikube pour macOS ou Windows et installez-le. Pour macOS, le dernier binaire s’appelle minikube-darwin-amd64 et pour Windows, il est minikube-windows-amd64.

Test de Minikube et kubectl

Une fois Minikube installé avec succès sur votre poste de travail, ouvrez un terminal et testez l’installation.

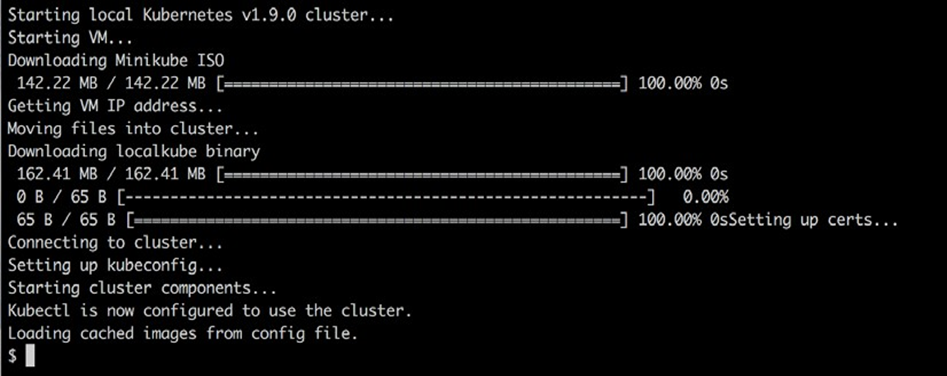

1. Tout d’abord, nous devons démarrer Minikube . Entrez minikube start sur la ligne de commande. La sortie doit ressembler à ceci :

Starting Minikube

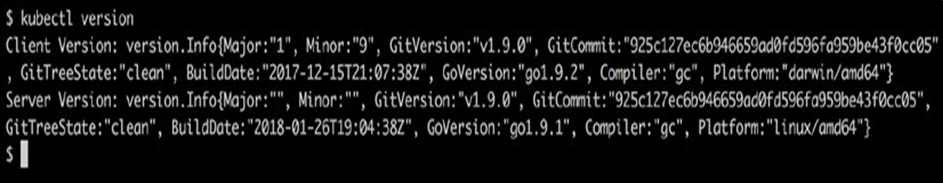

2. Maintenant, entrez la version de kubectl et appuyez sur Entrée pour voir quelque chose comme la capture d’écran suivante :

Déterminer la version du client et du serveur Kubernetes

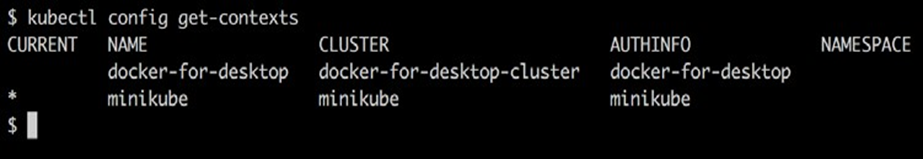

Si la commande précédente échoue, par exemple, en expirant, il se peut que votre kubectl ne soit pas configuré pour le bon contexte. kubectl peut être utilisé pour fonctionner avec de nombreux clusters Kubernetes différents. Chaque cluster est appelé un contexte.

3. Pour savoir pour quel contexte kubectl est actuellement configuré, utilisez la commande suivante :

$ kubectl config current-context minikube

La réponse doit être minikube , comme indiqué dans la sortie précédente.

4. Si ce n’est pas le cas, utilisez kubectl config get-contexts pour répertorier tous les contextes définis sur votre système, puis définissez le contexte actuel sur minikube comme suit :

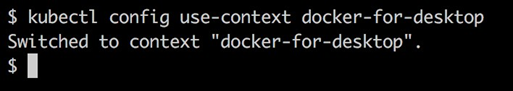

$ kubectl config use-context minikube

La configuration de kubectl , où il stocke les contextes, se trouve normalement dans ~ /. kube / config , mais cela peut être remplacé en définissant une variable d’environnement appelée KUBECONFIG . Vous devrez peut-être désactiver cette variable si elle est définie sur votre ordinateur.

Pour plus d’informations sur la configuration et l’utilisation des contextes Kubernetes, consultez le lien à https://kubernetes.io/docs/concepts/ configuration / organise-cluster- access – kubeconfig / .

En supposant que Minikube et kubectl fonctionnent comme prévu, nous pouvons maintenant utiliser kubectl pour obtenir des informations sur le cluster Kubernetes.

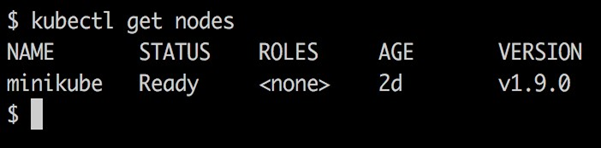

5. Entrez la commande suivante :

$ kubectl get nodes

NAME STATUS ROLES AGE VERSION

minikube Ready <none> 47d v1.9.0

Évidemment, nous avons un cluster d’un nœud, sur lequel Kubernetes v1.9.0 est installé.

Clonage du référentiel de code source

Cet article est accompagné du code source accessible au public. Clonez ce référentiel sur votre ordinateur local.

Tout d’abord créer un nouveau dossier par exemple, dans votre dossier maison, comme apps- withdocker -et- Kubernetes et parcourir l’itinéraire :

$ mkdir -p ~/apps-with-docker-and-kubernetes \ cd apps-with-docker-and-kubernetes

Et puis clonez le référentiel avec la commande suivante :

$ git clone https://github.com/appswithdockerandkubernetes/labs. git

Résumé

Dans ce chapitre, nous avons installé et configuré notre environnement personnel ou professionnel afin de pouvoir travailler de manière productive avec les conteneurs Docker. Cela s’applique également aux développeurs, aux DevOps et aux ingénieurs d’exploitation. Dans ce contexte, nous nous sommes assurés que nous utilisons un bon éditeur, que Docker pour macOS ou Windows est installé et que nous pouvons également utiliser docker-machine pour créer des machines virtuelles dans VirtualBox ou Hyper-V que nous pouvons utiliser pour exécuter et tester des conteneurs.

Dans le chapitre suivant, nous allons apprendre tous les faits importants sur les conteneurs. Par exemple, nous explorerons comment exécuter, arrêter, répertorier et supprimer des conteneurs, mais plus que cela, nous plongerons également profondément dans l’anatomie des conteneurs.

Questions

Sur la base de votre lecture de ce chapitre, veuillez répondre aux questions suivantes :

1. À quoi sert la machine docker ? Nommez trois à quatre scénarios.

2. Vrai ou faux ? Avec Docker pour Windows, on peut développer et exécuter des conteneurs Linux.

3. Pourquoi de bonnes compétences en script (comme Bash ou PowerShell) sont-elles essentielles pour une utilisation productive des conteneurs ?

4. Nommez trois à quatre distributions Linux sur lesquelles Docker est certifié pour fonctionner.

5. Nommez toutes les versions de Windows sur lesquelles vous pouvez exécuter des conteneurs Windows.

Travailler avec des conteneurs

Dans le chapitre précédent, vous avez appris à préparer de manière optimale votre environnement de travail pour une utilisation productive et sans friction de Docker. Dans ce chapitre, nous allons nous salir les mains et apprendre tout ce qui est important pour travailler avec des conteneurs. Voici les sujets que nous allons couvrir dans ce chapitre :

- Exécution du premier conteneur

- Démarrage, arrêt et retrait des conteneurs

- Inspection des conteneurs

- Exec dans un conteneur en cours d’exécution

- Fixation à un conteneur en cours d’exécution

- Récupération des journaux des conteneurs

- Anatomie des conteneurs

Après avoir terminé ce chapitre, vous pourrez effectuer les opérations suivantes :

- Exécuter, arrêter et supprimer un conteneur basé sur une image existante, telle que NGINX, busybox ou alpine

- Liste de tous les conteneurs du système

- Inspectez les métadonnées d’un conteneur en cours d’exécution ou arrêté

- Récupérer les journaux produits par une application s’exécutant à l’intérieur d’un conteneur

- Exécutez un processus tel que / bin / sh dans un conteneur déjà en cours d’exécution.

- Attacher un terminal à un conteneur déjà en cours d’exécution

- Expliquez dans vos propres mots à un profane intéressé les fondements d’un conteneur

Exigences techniques

Pour ce chapitre, vous devez avoir installé Docker pour Mac ou Docker pour Windows. Si vous utilisez une ancienne version de Windows ou utilisez Windows 10 Home Edition, Docker Toolbox doit être installé et prêt à l’emploi. Sous macOS, utilisez l’application Terminal et sous Windows, une console PowerShell pour essayer les commandes que vous apprendrez.

Exécution du premier conteneur

Avant de commencer, nous voulons nous assurer que Docker est correctement installé sur votre système et prêt à accepter vos commandes. Ouvrez une nouvelle fenêtre de terminal et saisissez la commande suivante :

$ docker -v

Si tout fonctionne correctement, vous devriez voir la version de Docker installée sur la sortie de votre ordinateur portable dans le terminal. Au moment de la rédaction, cela ressemble à ceci :

Docker version 17.12.0-ce-rc2, build f9cde63

Si cela ne fonctionne pas, alors quelque chose avec votre installation ne va pas. Veuillez-vous assurer d’avoir suivi les instructions du chapitre précédent sur la façon d’installer Docker pour Mac ou Docker pour Windows sur votre système.

Vous êtes donc prêt à voir une action. Veuillez saisir la commande suivante dans votre fenêtre de terminal et appuyez sur retour :

$ docker container run alpine echo “Hello World”

Lorsque vous exécutez la commande précédente la première fois, vous devriez voir une sortie dans votre fenêtre Terminal similaire à ceci :

Unable to find image ‘alpine:latest’ locally latest: Pulling from library/alpine 2fdfe1cd78c2: Pull complete Digest: sha256:ccba511b…

Status: Downloaded newer image for alpine:latest

Hello World

C’était facile ! Essayons d’exécuter à nouveau la même commande :

$ docker container run alpine echo “Hello World”

La deuxième, troisième ou nième fois que vous exécutez la commande précédente, vous ne devriez voir que cette sortie dans votre terminal :

Hello World

Essayez de comprendre pourquoi la première fois que vous exécutez une commande, vous voyez une sortie différente de toutes les fois suivantes. Ne vous inquiétez pas si vous ne pouvez pas le comprendre, nous expliquerons les raisons en détail dans les sections suivantes du chapitre.

Démarrage, arrêt et retrait des conteneurs

Vous avez réussi à exécuter un conteneur dans la section précédente. Maintenant, nous voulons enquêter en détail sur ce qui s’est exactement passé et pourquoi. Regardons à nouveau la commande que nous avons utilisée :

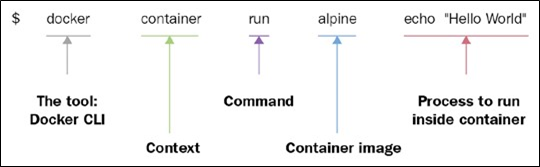

$ docker container run alpine echo “Hello World”

Cette commande contient plusieurs parties. D’abord et avant tout, nous avons le mot docker. Il s’agit du nom de l’interface de ligne de commande (CLI) Docker, que nous utilisons pour interagir avec le moteur Docker responsable de l’exécution des conteneurs. Ensuite, nous avons le mot conteneur, qui indique le contexte avec lequel nous travaillons. Comme nous voulons exécuter un conteneur, notre contexte est le mot conteneur. Vient ensuite la commande réelle que nous voulons exécuter dans le contexte donné, qui est exécutée.

Permettez – moi de récapituler- à ce jour, nous avons l’exécution de conteneurs docker, ce qui signifie, Hey Docker, nous voulons lancer un récipient ….

Maintenant, nous devons également indiquer à Docker quel conteneur exécuter. Dans ce cas, il s’agit du soi – disant conteneur alpin. Enfin, nous devons définir quel type de processus ou de tâche doit être exécuté à l’intérieur du conteneur lorsqu’il est en cours d’exécution. Dans notre cas, il s’agit de la dernière partie de la commande, echo “Hello World”.

La figure suivante peut vous aider à obtenir une meilleure approche de l’ensemble :

Anatomie de l’expression d’exécution du conteneur Docker

Maintenant que nous avons compris les différentes parties d’une commande pour exécuter un conteneur, essayons d’exécuter un autre conteneur avec un processus différent en cours d’exécution. Tapez la commande suivante dans votre terminal :

$ docker container run centos ping -c 5 127.0.0.1

Vous devriez voir une sortie dans votre fenêtre Terminal similaire à la suivante :

Unable to find image ‘centos:latest’ locally latest: Pulling from library/centos 85432449fd0f: Pull complete Digest: sha256:3b1a65e9a05…

Status: Downloaded newer image for centos:latest PING 127.0.0.1 (127.0.0.1) 56(84) bytes of data.

64 bytes from 127.0.0.1: icmp_seq=1 ttl=64 time=0.022 ms

64 bytes from 127.0.0.1: icmp_seq=2 ttl=64 time=0.019 ms

64 bytes from 127.0.0.1: icmp_seq=3 ttl=64 time=0.029 ms

64 bytes from 127.0.0.1: icmp_seq=4 ttl=64 time=0.030 ms

64 bytes from 127.0.0.1: icmp_seq=5 ttl=64 time=0.029 ms

— 127.0.0.1 ping statistics —

5 packets transmitted, 5 received, 0% packet loss, time 4103ms rtt min/avg/max/mdev = 0.021/0.027/0.029/0.003 ms

Ce qui a changé, c’est que cette fois, l’image du conteneur que nous utilisons est centos et le processus que nous exécutons à l’intérieur du conteneur centos est ping -c 5 127.0.0.1, qui envoie cinq fois l’adresse de bouclage à un ping jusqu’à ce qu’elle s’arrête.

Analysons la sortie en détail :

- La première ligne est la suivante :

Unable to find image ‘centos:latest’ locally

Cela nous indique que Docker n’a pas trouvé d’image nommée centos: dernier dans le cache local du système. Ainsi, Docker sait qu’il doit extraire l’image d’un registre dans lequel les images de conteneur sont stockées. Par défaut, votre environnement Docker est configuré de telle sorte que les images soient extraites du Docker Hub sur docker.io. Ceci est exprimé par la deuxième ligne, comme suit :

latest: Pulling from library/centos

- Les trois lignes de sortie suivantes sont les suivantes :

85432449fd0f: Pull complete

Digest: sha256:3b1a65e9a05…

Status: Downloaded newer image for centos:latest

Cela nous indique que Docker a réussi à extraire les centos d’image : les plus récents du Docker Hub.

Toutes les lignes suivantes de la sortie sont générées par le processus que nous avons exécuté à l’intérieur du conteneur, qui est l’outil ping dans ce cas. Si vous avez été attentif jusqu’à présent, vous avez peut-être remarqué que le mot-clé le plus récent s’est produit plusieurs fois. Chaque image a une version (également appelée balise), et si nous ne spécifions pas explicitement de version, Docker l’assume automatiquement comme la plus récente.

Si nous exécutons à nouveau le conteneur précédent sur notre système, les cinq premières lignes de la sortie seront manquantes car, cette fois, Docker trouvera l’image du conteneur mise en cache localement et n’aura donc pas à la télécharger en premier. Pour le vérifier, essayez-le.

Exécution d’un conteneur de devis aléatoires

Pour les sections suivantes de ce chapitre, nous avons besoin d’un conteneur qui s’exécute en continu en arrière-plan et produit une sortie intéressante. C’est pourquoi nous avons choisi un algorithme qui produit des citations aléatoires. L’API qui produit ces citations aléatoires gratuites peut être trouvée sur https://talaikis.com/random_quotes_api/.

Maintenant, l’objectif est d’avoir un processus en cours d’exécution à l’intérieur d’un conteneur qui produit un nouveau devis aléatoire toutes les cinq secondes et renvoie le devis à STDOUT. Le script suivant fera exactement cela :

while :

do

wget -qO- https://talaikis.com/api/quotes/random

printf ‘n’

sleep 5 done

Essayez-le dans une fenêtre de terminal. Arrêtez le script en appuyant sur Ctrl + C. La sortie devrait ressembler à ceci :

{“quote”:”Martha Stewart is extremely talented. Her designs are picture perfect. Our philosophy is life is messy, and rather than being afraid of those messes we design products that work the way we

live.”,”author”:”Kathy Ireland”,”cat”:”design”}

{“quote”:”We can reach our potential, but to do so, we must reach within ourselves. We must summon the strength, the will, and the faith to move forward – to be bold – to invest in our future.”,”author”:”John Hoeven”,”cat”:”faith”}

Chaque réponse est une chaîne au format JSON avec la citation, son auteur et sa catégorie.

Maintenant, exécutons cela dans un conteneur alpin en tant que démon en arrière-plan. Pour cela, nous devons compacter le script précédent en une seule ligne et l’exécuter en utilisant la syntaxe / bin / sh -c “…”. Notre expression Docker se présente comme suit :

$ docker container run -d –name quotes alpine \

/bin/sh -c “while :; do wget -qO- https://talaikis.com/api/quotes/ random; printf ‘\n’; sleep 5; done”

Dans l’expression précédente, nous avons utilisé deux nouveaux paramètres de ligne de commande, -d et –name . Le -d indique à Docker d’exécuter le processus en cours d’exécution dans le conteneur en tant que démon Linux. Le paramètre –name à son tour peut être utilisé pour donner au conteneur un nom explicite. Dans l’exemple précédent, le nom que nous avons choisi est des guillemets.

Si nous ne spécifions pas de nom de conteneur explicite lorsque nous exécutons un conteneur, Docker attribue automatiquement au conteneur un nom aléatoire mais unique. Ce nom sera composé du nom d’un célèbre scientifique et et adjectif. Ces noms peuvent être boring_borg ou angry_goldberg . Assez humoristique nos ingénieurs Docker, n’est-ce pas ?

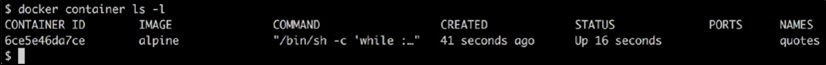

Un point important à retenir est que le nom du conteneur doit être unique sur le système. Assurons-nous que le conteneur de devis est opérationnel :

$ docker container ls -l

Cela devrait nous donner quelque chose comme ceci :

Liste du dernier conteneur d’exécution

La partie importante de la sortie précédente est la colonne STATUS, qui dans ce cas est Up 16 secondes. Autrement dit, le conteneur est opérationnel depuis 16 secondes maintenant.

Ne vous inquiétez pas si la dernière commande Docker ne vous est pas encore familière, nous y reviendrons dans la section suivante.

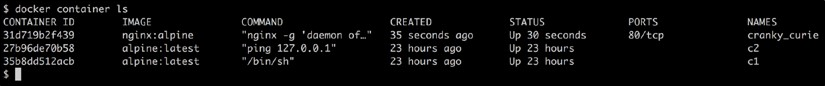

Liste des conteneurs

Comme nous continuons à gérer des conteneurs au fil du temps, nous en obtenons beaucoup dans notre système. Pour découvrir ce qui est actuellement en cours d’exécution sur notre hôte, nous pouvons utiliser la commande list de conteneurs comme suit:

$ docker container ls

Cela répertoriera tous les conteneurs en cours d’exécution. Une telle liste pourrait ressembler à ceci:

Liste de tous les conteneurs en cours d’exécution sur le système

Par défaut, Docker génère sept colonnes avec les significations suivantes :

| Column | Description |

| Container ID | The unique ID of the container. It is a SHA-256. |

| Image | The name of the container image from which this container is instantiated. |

| Command | The command that is used to run the main process in the container. |

| Created | The date and time when the container was created. |

| Status | The status of the container (created, restarting, running, removing, paused, exited, or dead). |

| Ports | The list of container ports that have been mapped to the host. |

| Names | The name assigned to this container (multiple names are possible). |

Si nous voulons répertorier non seulement les conteneurs en cours d’exécution, mais tous les conteneurs définis sur notre système, nous pouvons utiliser le paramètre de ligne de commande -a ou –all comme suit :

$ docker container ls -a

Cela répertoriera les conteneurs dans n’importe quel état, tels que créés, en cours d’exécution ou fermés.

Parfois, nous voulons simplement répertorier les ID de tous les conteneurs. Pour cela, nous avons le paramètre -q :

$ docker container ls -q

Vous vous demandez peut-être où cela est utile. La commande suivante montre où cela peut être très utile :

$ docker container rm -f $ (docker container ls -a -q)

Penchez-vous en arrière et respirez profondément. Ensuite, essayez de découvrir ce que fait la commande précédente. Ne lisez pas plus loin jusqu’à ce que vous trouviez la réponse ou abandonniez.

La commande précédente supprime tous les conteneurs actuellement définis sur le système, y compris ceux qui sont arrêtés. La commande rm signifie supprimer, et elle sera expliquée plus loin.

Dans la section précédente, nous avons utilisé le paramètre -l dans la commande list. Essayez d’utiliser l’aide de Docker pour savoir ce que signifie le paramètre -l. Vous pouvez appeler l’aide de la commande list comme suit :

$ docker container ls -h

Arrêt et démarrage des conteneurs

Parfois, nous voulons arrêter (temporairement) un conteneur en cours d’exécution. Essayons cela avec le conteneur de citations que nous avons utilisé précédemment. Exécutez à nouveau le conteneur avec cette commande :

$ docker container run -d –name quotes alpine \

/bin/sh -c “while :; do wget -qO- https://talaikis.com/api/quotes/ random; printf ‘\n’; sleep 5; done”

Maintenant, si nous voulons arrêter ce conteneur, nous pouvons le faire en émettant cette commande :

$ docker container stop quotes

Lorsque vous essayez d’arrêter le conteneur de guillemets, vous remarquerez probablement qu’il faut un certain temps pour que cette commande soit exécutée. Pour être précis, cela prend environ 10 secondes. Pourquoi est-ce le cas ?

Docker envoie un signal Linux SIGTERM au processus principal exécuté à l’intérieur du conteneur. Si le processus ne réagit pas à ce signal et ne se termine pas lui-même, Docker attend 10 secondes, puis envoie SIGKILL, qui tuera le processus avec force et terminera le conteneur.

Dans la commande précédente, nous avons utilisé le nom du conteneur pour spécifier le conteneur que nous voulons arrêter. Mais nous aurions également pu utiliser l’ID de conteneur à la place.

Comment obtient-on l’ID d’un conteneur ? Il y a plusieurs façons de le faire. L’approche manuelle consiste à répertorier tous les conteneurs en cours d’exécution et à trouver celui que nous recherchons dans la liste. De là, nous copions son ID. Un moyen plus automatisé consiste à utiliser des scripts shell et des variables d’environnement. Si, par exemple, nous voulons obtenir l’ID du conteneur de guillemets, nous pouvons utiliser cette expression :

$ export CONTAINER_ID=$(docker container ls | grep quotes | awk ‘{print $1}’)

Maintenant, au lieu d’utiliser le nom du conteneur, nous pouvons utiliser la variable $ CONTAINER_ID dans notre expression :

$ docker container stop $CONTAINER_ID

Une fois que nous avons arrêté le conteneur, son statut passe à Exited.

Si un conteneur est arrêté, il peut être redémarré à l’aide de la commande docker container start. Faisons-le avec notre conteneur de devis. Il est bon de le relancer, car nous en aurons besoin dans les sections suivantes de ce chapitre :

$ docker container start quotes

Retrait des conteneurs

Lorsque nous exécutons la commande docker container ls -a , nous pouvons voir un bon nombre de conteneurs qui ont le statut Exited . Si nous n’avons plus besoin de ces conteneurs, alors c’est une bonne chose de les supprimer de la mémoire, sinon ils occupent inutilement de précieuses ressources. La commande pour supprimer un conteneur est :

$ docker container rm <container ID>

Une autre commande pour supprimer un conteneur est :

$ docker container rm <container name>

Essayez de supprimer l’un de vos conteneurs sortis à l’aide de son ID.

Parfois, la suppression d’un conteneur ne fonctionnera pas car il est toujours en cours d’exécution. Si nous voulons forcer une suppression, quelle que soit la condition actuelle du conteneur, nous pouvons utiliser le paramètre de ligne de commande -f ou –force.

Inspection des conteneurs

Les conteneurs sont des instances d’exécution d’une image et ont beaucoup de données associées qui caractérisent leur comportement. Pour obtenir plus d’informations sur un conteneur spécifique, nous pouvons utiliser la commande inspect. Comme d’habitude, nous devons fournir l’ID ou le nom du conteneur pour identifier le conteneur dont nous voulons obtenir les données. Alors, inspectons notre conteneur d’échantillons :

$ docker container inspect quotes

La réponse est un gros objet JSON plein de détails. Cela ressemble à ceci:

[

{

“Id”: “c5c1c68c87…”,

“Created”: “2017-12-30T11:55:51.223271182Z”,

“Path”: “/bin/sh”,

“Args”: [

“-c”,

“while :; do wget -qO- https://talaikis.com/api/ quotes/random; printf ‘\n’; sleep 5; done”

],

“State”: {

“Status”: “running”,

“Running”: true, …

},

“Image”: “sha256:e21c333399e0…”, …

“Mounts”: [],

“Config”: {

“Hostname”: “c5c1c68c87dd”,

“Domainname”: “”, …

},

“NetworkSettings”: {

“Bridge”: “”,

“SandboxID”: “2fd6c43b6fe5…”, …

}

}

]

La sortie a été raccourcie pour plus de lisibilité.

Veuillez prendre un moment pour analyser ce que vous avez obtenu. Vous devriez voir des informations telles que :

- L’ID du conteneur

- La date et l’heure de création du conteneur

- À partir de quelle image le conteneur est construit et ainsi de suite

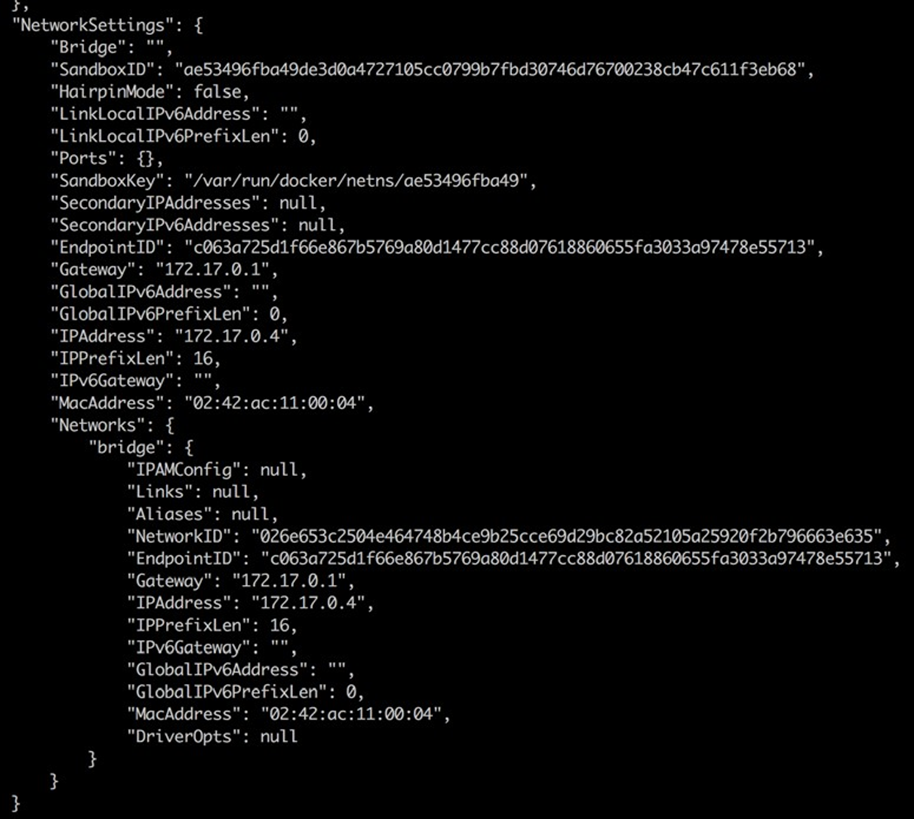

De nombreuses sections de la sortie, telles que Mounts ou NetworkSettings, n’ont pas beaucoup de sens pour le moment, mais nous en discuterons certainement dans les prochains chapitres de l’article. Les données que vous voyez ici sont également nommées les métadonnées d’un conteneur. Nous utiliserons la commande inspect assez souvent dans le reste de l’article comme source d’information.

Parfois, nous n’avons besoin que d’une infime partie des informations globales, et pour y parvenir, nous pouvons utiliser l’outil grep ou un filter. La première méthode n’aboutit pas toujours à la réponse attendue, alors examinons la dernière approche :

$ docker container inspect -f “{{json .State}}” quotes | jq

Le paramètre -f ou –filter est utilisé pour définir le filtre. L’expression de filtre elle-même utilise la syntaxe du modèle Go. Dans cet exemple, nous voulons uniquement voir la partie état de la sortie entière au format JSON.

Pour bien formater la sortie, nous redirigeons le résultat dans l’outil jq :

{

“Status”: “running”,

“Running”: true,

“Paused”: false,

“Restarting”: false,

“OOMKilled”: false,

“Dead”: false,

“Pid”: 6759,

“ExitCode”: 0,

“Error”: “”,

“StartedAt”: “2017-12-31T10:31:51.893299997Z”,

“FinishedAt”: “0001-01-01T00:00:00Z”

}

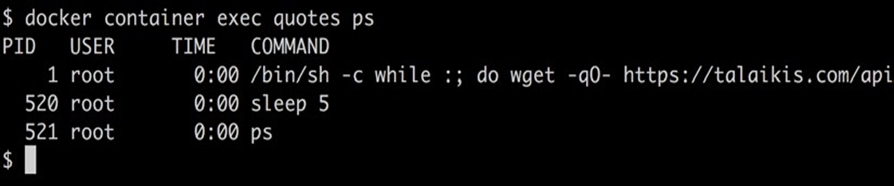

Exec dans un conteneur en cours d’exécution

Parfois, nous voulons exécuter un autre processus à l’intérieur d’un conteneur déjà en cours d’exécution. Une raison typique pourrait être d’essayer de déboguer un conteneur qui se comporte mal. Comment peut-on le faire ? Tout d’abord, nous devons connaître l’ID ou le nom du conteneur, puis nous pouvons définir quel processus nous voulons exécuter et comment nous voulons qu’il s’exécute. Encore une fois, nous utilisons notre conteneur de devis en cours d’exécution et nous exécutons un shell de manière interactive à l’intérieur avec la commande suivante :

$ docker container exec -i -t quotes /bin/sh

L’indicateur – i signifie que nous voulons exécuter le processus supplémentaire de manière interactive, et -t indique à Docker que nous voulons qu’il nous fournisse un TTY (un émulateur de terminal) pour la commande. Enfin, le processus que nous exécutons est / bin / sh.