Résumé de la publication

Cet article vous propose de découvrir le framework Spark (ou Apache Spark2). Spark est un framework open source de calcul distribué. Il s’agit d’un ensemble d’outils et de composants logiciels structurés selon une architecture définie. Développé à l’université de Californie à Berkeley par AMPLab, Spark est aujourd’hui un projet de la fondation Apache. Ce produit est un cadre applicatif de traitements big data pour effectuer des analyses complexes à grande échelle. Depuis son installation à son exploitation l’article vise à expliquer son fonctionnement.

Objectifs de la publication

- Présentation de l’architecture Spark

- Installer, configurer et optimiser Apache Spark

- Création de DataFrame et Dataset

- Flux d’exécution des applications

- Gestion de SQL

- Streaming, Machine Learning et Graph Analysis

Chapitre 1. Introduction à Apache Spark

Apache Spark est un framework open source pour le traitement efficace et rapide de grands ensembles de données stockés dans des magasins de données hétérogènes.Des algorithmes analytiques sophistiqués peuvent être facilement exécutés sur ces grands ensembles de données. Spark peut exécuter un programme distribué 100 fois plus rapidement que MapReduce. Comme Spark est l’un des projets à croissance rapide dans la communauté open source, il fournit un grand nombre de bibliothèques à ses utilisateurs.

Nous aborderons les sujets suivants dans ce chapitre :

- Une brève introduction à Spark

- Architecture Spark et les différents langages pouvant être utilisés pour coder les applications Spark

- Composants Spark et comment ces composants peuvent être utilisés ensemble pour résoudre une variété de cas d’utilisation

- Une comparaison entre Spark et Hadoop

Qu’est-ce que Spark ?

Apache Spark est un cadre informatique distribué qui rend le traitement des mégadonnées assez facile, rapide et évolutif. Vous devez vous demander ce qui rend Spark si populaire dans l’industrie et en quoi est-il vraiment différent des outils existants disponibles pour le traitement des mégadonnées ? La raison en est qu’il fournit une pile unifiée pour le traitement de toutes sortes de mégadonnées, qu’il s’agisse de données par lots, en continu, d’apprentissage automatique ou de graphiques.

Spark a été développé à l’ AMPLab d’ UC Berkeley en 2009 et est ensuite tombé sous le parapluie Apache en 2010. Le cadre est principalement écrit en Scala et Java.

Spark fournit une interface avec de nombreux magasins de données distribués et non distribués différents, tels que Hadoop Distributed File System (HDFS), Cassandra, Openstack Swift, Amazon S3 et Kudu. Il fournit également une grande variété d’API linguistiques pour effectuer des analyses sur les données stockées dans ces magasins de données. Ces API incluent Scala, Java, Python et R.

L’entité de base de Spark est Resilient Distributed Dataset (RDD), qui est une collection de données partitionnée en lecture seule. Le RDD peut être créé en utilisant des données stockées dans différents magasins de données ou en utilisant un RDD existant. Nous en discuterons plus en détail au chapitre 3, Spark RDD.

Spark a besoin d’un gestionnaire de ressources pour distribuer et exécuter ses tâches. Par défaut, Spark propose son propre planificateur autonome, mais il s’intègre facilement avec Apache Mesos et Yet Another Resource Negotiator (YARN) pour la gestion des ressources du cluster et l’exécution des tâches.

L’une des principales caractéristiques de Spark est de conserver une grande quantité de données en mémoire pour une exécution plus rapide. Il possède également un composant qui génère un graphique acyclique dirigé (DAG) des opérations basées sur le programme utilisateur. Nous en discuterons plus en détail dans les prochains chapitres.

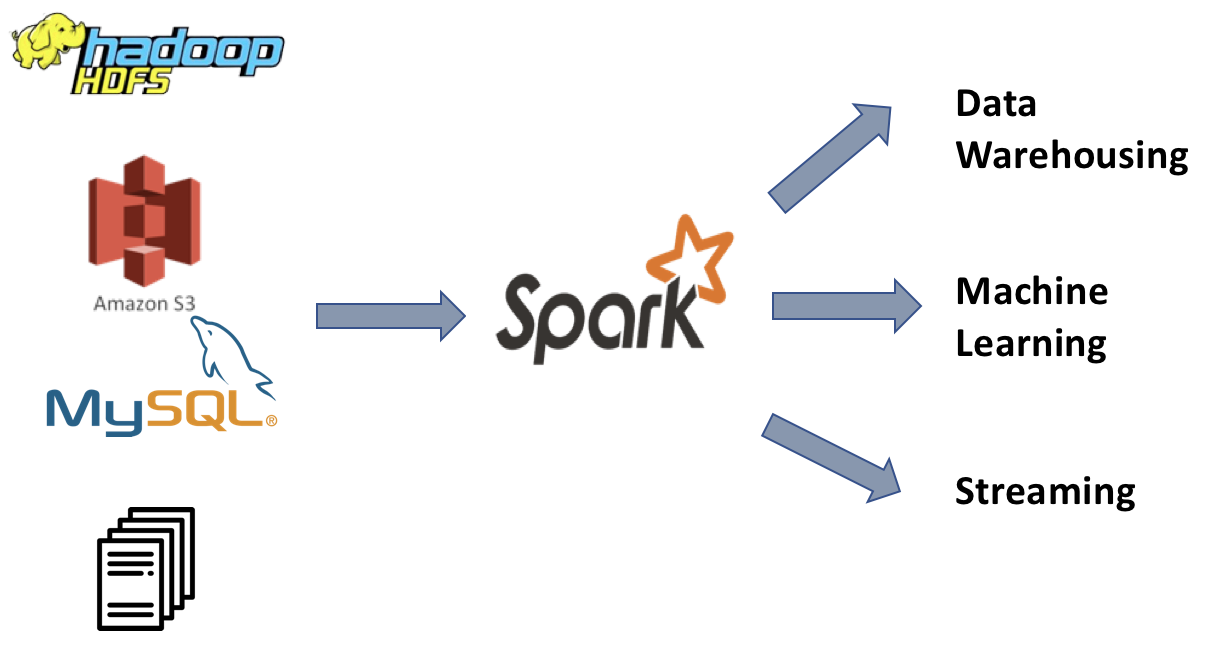

Le diagramme suivant montre certains des magasins de données populaires auxquels Spark peut se connecter :

Magasins de données

Remarque

Spark est un moteur informatique et ne doit pas être considéré comme un système de stockage également. Spark n’est pas non plus conçu pour la gestion des clusters. À cette fin, des cadres tels que Mesos et YARN sont utilisés.

Présentation de l’architecture Spark

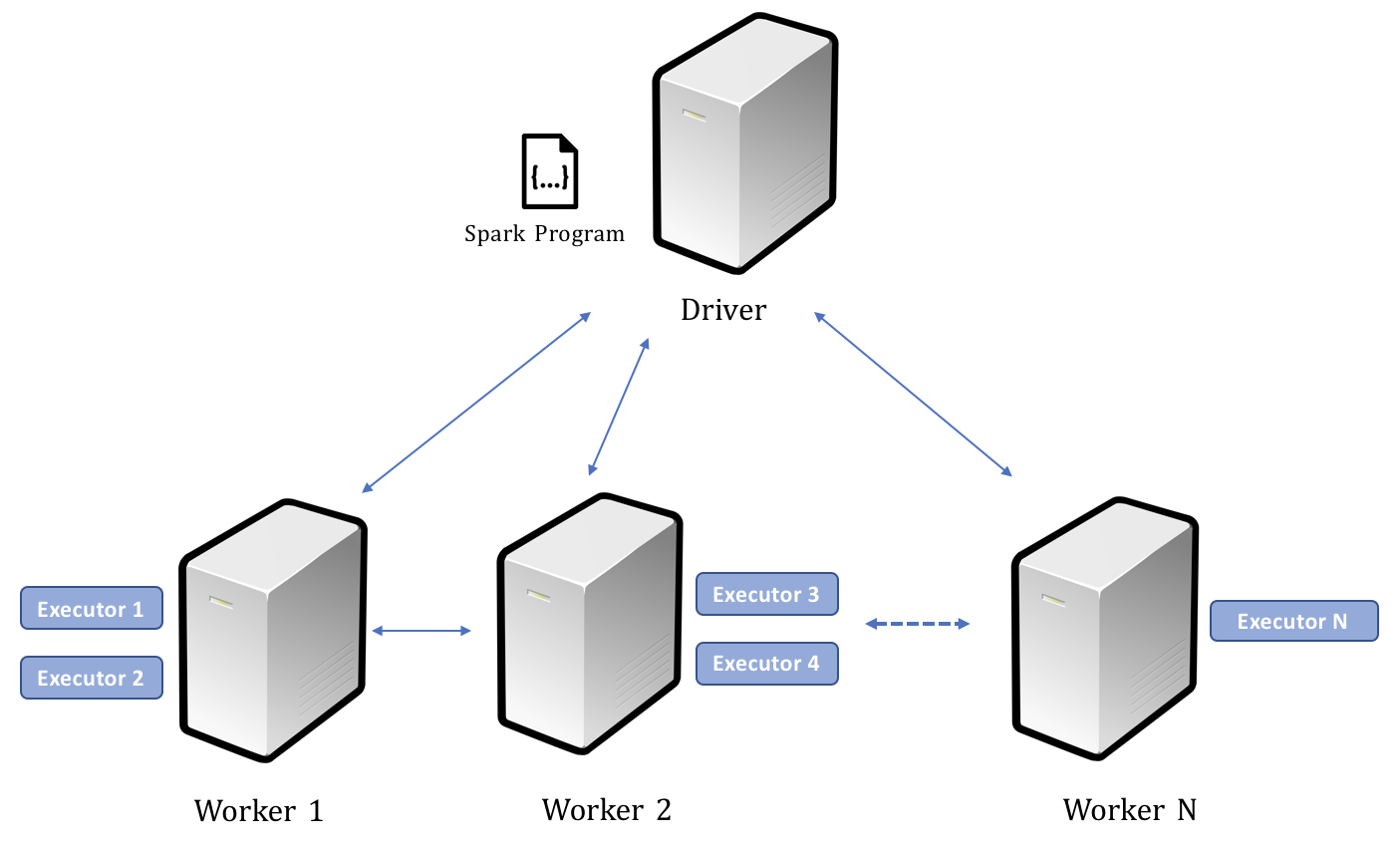

Spark suit une architecture maître-esclave, car elle lui permet d’évoluer à la demande. L’ architecture de Spark comprend deux composants principaux :

Driver Program : un programme de pilote est l’endroit où un utilisateur écrit du code Spark à l’aide des API Scala, Java, Python ou R. Il est responsable du lancement de diverses opérations parallèles du cluster.

Executor : Executor est la machine virtuelle Java (JVM) qui s’exécute sur un nœud de travail du cluster. Executor fournit des ressources matérielles pour exécuter les tâches lancées par le programme du pilote.

Dès qu’un travail Spark est soumis, le programme pilote lance diverses opérations sur chaque exécuteur. Le pilote et les exécuteurs exécutent ensemble une application.

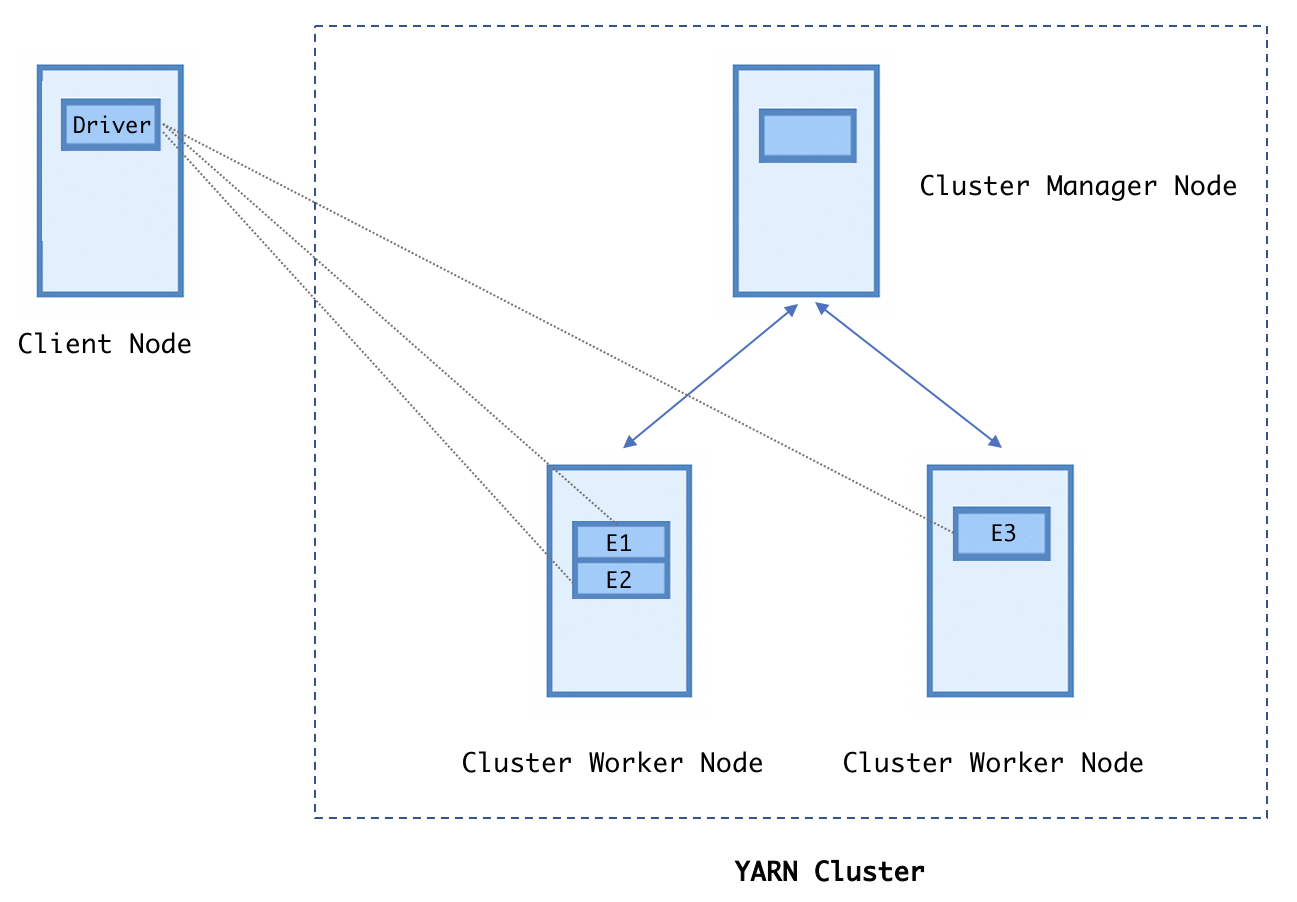

Le diagramme suivant illustre les relations entre le pilote, les travailleurs et les exécuteurs. Comme première étape, un processus de pilote analyse le code utilisateur (Spark programme) et crée plusieurs exécuteurs sur chaque nœud de travail. Le processus du pilote non seulement bifurque les exécuteurs sur les machines de travail, mais envoie également des tâches à ces exécuteurs pour exécuter l’ensemble de l’application en parallèle.

Une fois le calcul terminé, la sortie est envoyée au programme du pilote ou enregistrée dans le système de fichiers :

Driver, Workers, and Executors

API de langage Spark

Spark est intégré à une variété de langages de programmation tels que Scala, Java, Python et R. Les développeurs peuvent écrire leur programme Spark dans l’un de ces langages. Cette liberté de langage est également l’une des raisons pour lesquelles Spark est populaire parmi les développeurs. Si vous comparez cela à Hadoop MapReduce, dans MapReduce, les développeurs n’avaient qu’un seul choix: Java, ce qui rendait difficile pour les développeurs d’un autre langage de programmation de travailler sur MapReduce.

Scala

Scala est la langue principale de Spark. Plus de 70% du code de Spark est écrit en langage évolutif (Scala). Scala est une langue assez nouvelle. Il a été développé par Martin Odersky en 2001 et a été lancé publiquement pour la première fois en 2004. Comme Java, Scala génère également un bytecode qui fonctionne sur JVM. Scala apporte les avantages des mondes orientés objet et fonctionnels. Il fournit une programmation dynamique sans compromettre la sécurité des types. Comme Spark est principalement écrit en Scala, vous pouvez trouver presque toutes les nouvelles bibliothèques dans Scala API.

Java

La plupart d’entre nous connaissent Java. Java est un puissant langage de programmation orienté objet. La majorité des cadres de Big Data sont écrits en Java, qui fournit des bibliothèques riches pour connecter et traiter les données avec ces cadres.

Python

Python est un langage de programmation fonctionnel. Il a été développé par Guido van Rossum et a été publié pour la première fois en 1991. Pendant un certain temps, Python n’était pas populaire parmi les développeurs, mais plus tard, vers 2006-07, il a introduit certaines bibliothèques telles que Numerical Python ( NumPy ) et Pandas , qui sont devenues les pierres angulaires et a rendu Python populaire parmi tous les types de programmeurs. Dans Spark, lorsque le pilote lance des exécuteurs sur les nœuds de travail, il démarre également un interpréteur Python pour chaque exécuteur. Dans le cas de RDD, les données sont d’abord expédiées dans les machines virtuelles Java, puis transférées vers Python, ce qui ralentit le travail lorsque vous travaillez avec des RDD.

R

R est un langage de programmation statistique. Il fournit une bibliothèque riche pour analyser et manipuler les données, c’est pourquoi il est très populaire parmi les analystes de données, les statisticiens et les scientifiques des données. L’intégration de Spark R est un moyen de fournir aux scientifiques des données la flexibilité requise pour travailler sur les mégadonnées. Comme Python, SparkR crée également un processus R pour chaque exécuteur afin de travailler sur les données transférées depuis la JVM.

SQL

Structured Query Language (SQL) est l’une des langues les plus populaires et les plus puissants pour travailler avec des tables stockées dans la base de données. SQL permet également aux non-programmeurs de travailler avec des mégadonnées. Spark fournit Spark SQL, qui est un moteur de requête SQL distribué. Nous en apprendrons plus en détail au chapitre 6 , Spark SQL

Composants Spark

Comme expliqué précédemment dans ce chapitre, la philosophie principale de Spark est de fournir un moteur unifié pour créer différents types d’applications de Big Data. Spark fournit une variété de bibliothèques pour travailler avec l’analyse par lots, le streaming, l’apprentissage automatique et l’analyse graphique.

Ce n’est pas comme si ces types de traitement n’avaient jamais été effectués avant Spark, mais pour chaque nouveau problème de Big Data, il y avait un nouvel outil sur le marché; par exemple, pour l’analyse par lots, nous avions MapReduce, Hive et Pig. Pour le streaming , nous avions Apache Storm, pour l’apprentissage automatique, nous avions Mahout. Bien que ces outils résolvent les problèmes pour lesquels ils sont conçus, chacun d’eux nécessite une courbe d’apprentissage. C’est là que Spark apporte des avantages. Spark fournit une pile unifiée pour résoudre tous ces problèmes. Il comprend des composants conçus pour traiter toutes sortes de mégadonnées. Il fournit également de nombreuses bibliothèques pour lire ou écrire différents types de données telles que JSON, CSV et Parquet.

Voici un exemple de pile Spark :

Spark Stack

Avoir une pile unifiée apporte de nombreux avantages. Examinons certains des avantages :

- Le premier est le partage de code et la réutilisabilité. Les composants développés par l’équipe d’ingénierie des données peuvent facilement être intégrés par l’équipe de science des données pour éviter la redondance du code.

- En second lieu, il y a toujours un nouvel outil sur le marché pour résoudre un cas d’utilisation différent du big data. La plupart des développeurs ont du mal à apprendre de nouveaux outils et à acquérir une expertise afin de les utiliser efficacement. Avec Spark, les développeurs n’ont qu’à apprendre les concepts de base qui permettent aux développeurs de travailler sur différents cas d’utilisation du Big Data.

- Troisièmement, sa pile unifiée donne aux développeurs un grand pouvoir pour explorer de nouvelles idées sans installer de nouveaux outils.

Le diagramme suivant fournit un aperçu de haut niveau des différentes applications de Big Data alimentées par Spark :

Cas d’utilisation de Spark

Spark Core

Spark Core est le composant principal de Spark. Spark Core définit les éléments suivants :

- Les composants de base, tels que RDD et DataFrames

- Les API disponibles pour effectuer des opérations sur ces abstractions de base

- Variables partagées ou distribuées, telles que les variables de diffusion et les accumulateurs

Nous les examinerons plus en détail dans les prochains chapitres.

Spark Core définit également toutes les fonctionnalités de base, telles que la gestion des tâches, la gestion de la mémoire, les fonctionnalités d’E / S de base, etc. C’est une bonne idée de jeter un œil au code Spark sur GitHub (https://github.com/apache/spark).

Spark SQL

Spark SQL est l’endroit où les développeurs peuvent travailler avec des données structurées et semi-structurées telles que les tables Hive, les tables MySQL, les fichiers Parquet, les fichiers AVRO, les fichiers JSON, les fichiers CSV, etc. Une autre alternative pour traiter les données structurées est d’utiliser Hive. Hive traite les données structurées stockées sur HDFS à l’aide de Hive Query Language (HQL). Il utilise en interne MapReduce pour son traitement, et nous verrons comment Spark peut fournir de meilleures performances que MapReduce. Dans la version initiale de Spark, les données structurées étaient définies comme RDD de schéma (un autre type de RDD). Lorsqu’il existe des données avec le schéma, SQL devient le premier choix de traitement de ces données. Spark SQL est le composant Spark qui permet aux développeurs de traiter les données avec langage Structured Query Language (SQL).

En utilisant Spark SQL, la logique métier peut être facilement écrite en SQL et HQL. Cela permet aux ingénieurs d’entrepôt de données ayant une bonne connaissance de SQL d’utiliser Spark pour leur traitement d’extraction, de transformation et de chargement (ETL). Les projets Hive peuvent facilement être migrés sur Spark à l’aide de Spark SQL, sans modifier les scripts Hive.

Spark SQL est également le premier choix pour l’analyse et l’entreposage de données. Spark SQL permet aux analystes de données d’écrire des requêtes ad hoc pour leur analyse exploratoire. Spark fournit un shell SQL Spark, où vous pouvez exécuter les requêtes de type SQL et elles sont exécutées sur Spark. Spark convertit en interne le code en une chaîne de calculs RDD, tandis que Hive convertit le travail HQL en une série de travaux MapReduce. En utilisant Spark SQL, les développeurs peuvent également utiliser la mise en cache (une fonctionnalité Spark qui permet de conserver les données en mémoire), ce qui peut augmenter considérablement les performances de leurs requêtes.

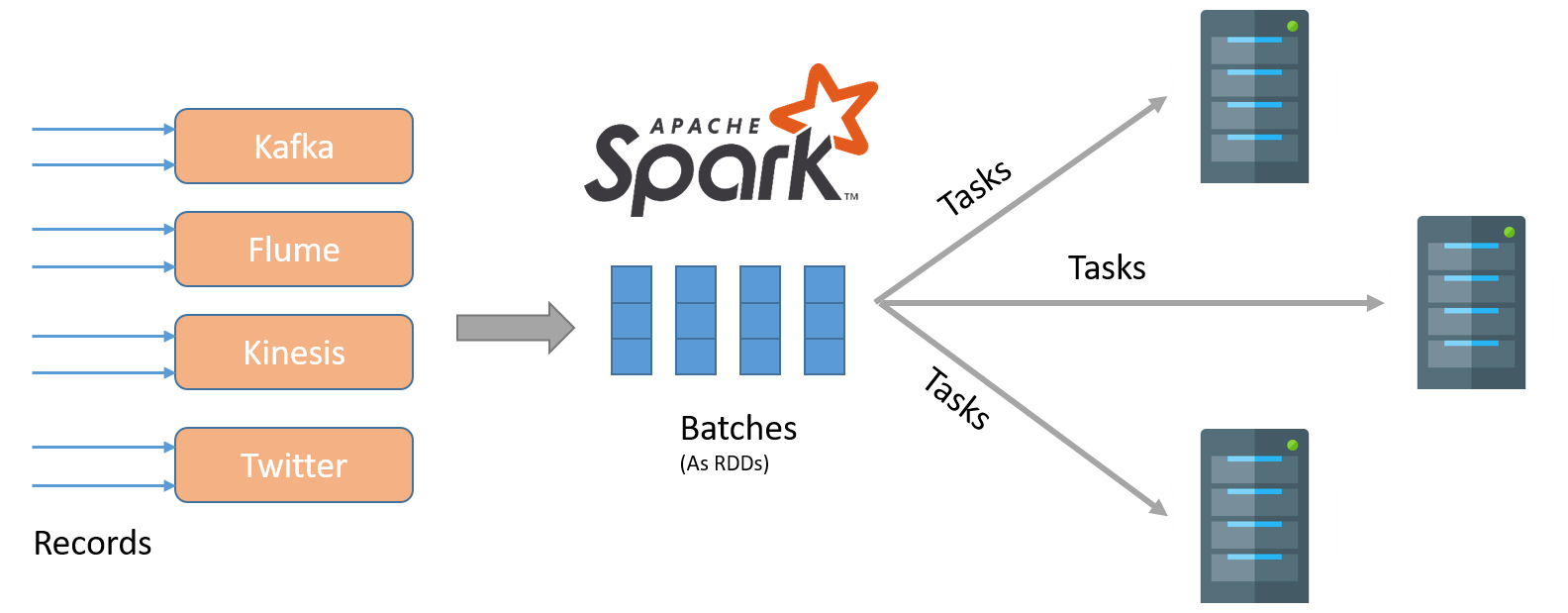

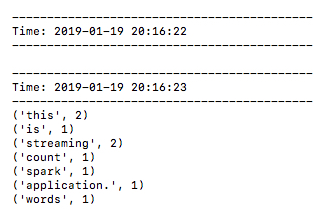

Spark Streaming

Spark Streaming est un package utilisé pour traiter un flux de données en temps réel. Il peut exister de nombreux types différents de flux de données en temps réel ; par exemple, un site Web de commerce électronique enregistrant des visites de page en temps réel, des transactions par carte de crédit, une application de fournisseur de taxi envoyant des informations sur les trajets et des informations de localisation des conducteurs et des passagers, etc. En bref, toutes ces applications sont hébergées sur plusieurs serveurs Web qui génèrent des journaux d’événements en temps réel.

Spark Streaming utilise RDD et définit d’autres API pour traiter le flux de données en temps réel. Comme Spark Streaming utilise RDD et ses API, il est facile pour les développeurs d’apprendre et d’exécuter les cas d’utilisation sans apprendre une toute nouvelle pile technologique.

Spark 2.x a introduit le streaming structuré, qui utilise des DataFrames plutôt que des RDD pour traiter le flux de données. L’utilisation de DataFrames comme abstraction de calcul apporte tous les avantages de l’API DataFrame au traitement en continu. Nous discuterons des avantages des DataFrames sur RDD dans les prochains chapitres.

Spark Streaming a une excellente intégration avec certaines des files d’attente de messagerie de données les plus populaires, comme Apache Flume et Kafka. Il peut être facilement connecté à ces files d’attente pour gérer une quantité massive de flux de données.

Apprentissage automatique Spark

Il est difficile d’exécuter un algorithme d’apprentissage automatique lorsque vos données sont réparties sur plusieurs machines. Il peut y avoir un cas où le calcul dépend d’un autre point qui est stocké ou traité sur un exécuteur différent. Les données peuvent être mélangées entre les exécuteurs ou les employés, mais le mélange entraîne un coût élevé. Spark fournit un moyen d’éviter de mélanger les données. Oui, c’est la mise en cache. La capacité de Spark à conserver une grande quantité de données en mémoire facilite l’écriture d’algorithmes d’apprentissage automatique.

Spark MLlib et ML sont les packages de Spark pour travailler avec des algorithmes d’apprentissage automatique. Ils fournissent les éléments suivants:

- Algorithmes d’apprentissage automatique intégrés tels que la classification, la régression, le clustering, etc.

- Des fonctionnalités telles que le pipelining, la création de vecteurs, etc.

Les algorithmes et fonctionnalités précédents sont optimisés pour la réorganisation des données et pour évoluer à travers le cluster.

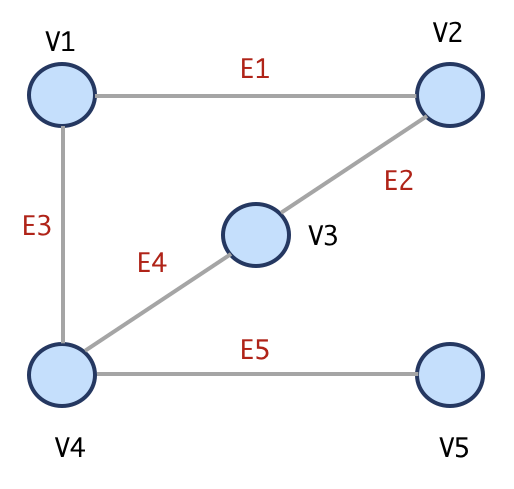

Traitement de graphique Spark

Spark a également un composant pour traiter les données du graphique. Un graphique se compose de sommets et d’arêtes. Les arêtes définissent la relation entre les sommets. Quelques exemples de données graphiques sont les évaluations de produits des clients , les réseaux sociaux, les pages Wikipedia et leurs liens, les vols d’aéroport, etc.

Spark fournit GraphX pour traiter ces données. GraphX utilise RDD pour son calcul et permet aux utilisateurs de créer des sommets et des arêtes avec certaines propriétés. À l’aide de GraphX , vous pouvez définir et manipuler un graphique ou obtenir des informations à partir du graphique.

GraphFrames est un package externe qui utilise des DataFrames au lieu de RDD, et définit la relation sommet-bord à l’aide d’un DataFrame .

Gestionnaire de cluster

Spark fournit un mode local pour l’exécution du travail, où le pilote et les exécuteurs s’exécutent au sein d’une seule machine virtuelle Java sur la machine client. Cela permet aux développeurs de démarrer rapidement avec Spark sans créer de cluster. Nous utiliserons principalement ce mode d’exécution de travail tout au long de cet article pour nos exemples de code, et expliquerons les défis possibles avec un mode cluster autant que possible. Spark fonctionne également avec une variété d’horaires. Ayons un bref aperçu d’eux ici.

Planificateur autonome

Spark est livré avec son propre ordonnanceur, appelé ordonnanceur autonome . Si vous exécutez vos programmes Spark sur un cluster qui n’a pas d’installation Hadoop, il est possible que vous utilisiez le planificateur autonome par défaut de Spark.

YARN

YARN est le planificateur par défaut de Hadoop. Il est optimisé pour les travaux par lots tels que MapReduce, Hive et Pig. La plupart des organisations ont déjà installé Hadoop sur leurs clusters; par conséquent, Spark offre la possibilité de le configurer avec YARN pour la planification des travaux.

Mesos

Spark s’intègre également bien avec Apache Mesos qui est construit en utilisant les mêmes principes que le noyau Linux. Contrairement à YARN, Apache Mesos est un gestionnaire de cluster à usage général qui ne se lie pas à l’écosystème Hadoop. Une autre différence entre YARN et Mesos est que YARN est optimisé pour les charges de travail par lots de longue durée, tandis que Mesos, la capacité à fournir une allocation fine et dynamique des ressources, le rend plus optimisé pour les travaux de streaming.

Kubernetes

Kubernetes est un cadre d’orchestration à usage général pour exécuter des applications conteneurisées. Kubernetes fournit plusieurs fonctionnalités telles que l’hébergement multiclient (exécution de différentes versions de Spark sur un cluster physique) et le partage de l’espace de noms. Au moment de la rédaction de cet article, le planificateur Kubernetes est encore au stade expérimental. Pour plus de détails sur l’exécution d’une application Spark sur Kubernetes, veuillez consulter la documentation de Spark.

Tirer le meilleur parti de Hadoop et Spark

Les gens se confondent généralement entre Hadoop et Spark et comment ils sont liés. L’intention de cette section est de discuter des différences entre Hadoop et Spark, ainsi que de la façon dont elles peuvent être utilisées ensemble.

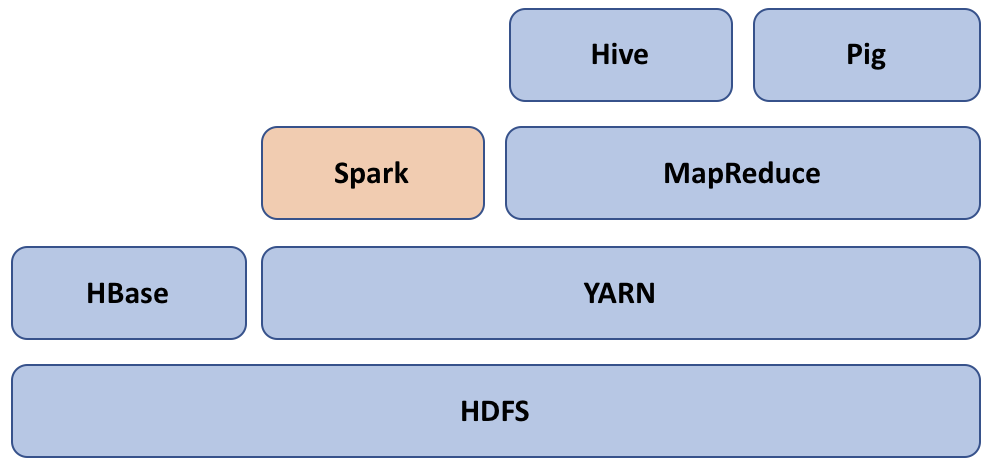

Hadoop est principalement une combinaison des composants suivants :

- Hive and Pig

- MapReduce

- FIL

- HDFS

HDFS est la couche de stockage où les données sous-jacentes peuvent être stockées. HDFS fournit des fonctionnalités telles que la réplication des données, la tolérance aux pannes, la haute disponibilité, etc. Hadoop est un schéma en lecture; par exemple, vous n’avez pas besoin de spécifier le schéma lors de l’écriture des données dans Hadoop, vous pouvez plutôt utiliser différents schémas lors de la lecture des données. HDFS fournit également différents types de formats de fichiers, tels que TextInputFormat , SequenceFile , NLInputFormat , etc. Si vous voulez en savoir plus sur ces formats de fichiers, je vous recommande de lire Hadoop: The Definitive Guide de Tom White.

MapReduce de Hadoop est un modèle de programmation utilisé pour traiter les données disponibles sur HDFS. Il se compose de quatre phases principales: mapper, trier, mélanger et réduire. L’une des principales différences entre Hadoop et Spark est que le modèle MapReduce de Hadoop est étroitement lié aux formats de fichier des données. D’autre part, Spark fournit une abstraction pour traiter les données à l’aide de RDD. RDD est comme un conteneur à usage général de données distribuées. C’est pourquoi Spark peut s’intégrer à une variété de magasins de données.

Une autre différence principale entre Hadoop et Spark est que Spark fait bon usage de la mémoire. Il peut mettre en cache les données en mémoire pour éviter les E / S disque. En revanche, les travaux MapReduce d’Hadoop impliquent généralement plusieurs E / S de disques. En règle générale, un travail Hadoop se compose de plusieurs travaux de mappage et de réduction. Ceci est connu sous le nom de chaînage MapReduce. Une chaîne MapReduce peut ressembler à ceci : Map -> Reduce -> Map -> Map -> Reduce.

Toutes les tâches réduites écrivent leur sortie sur HDFS pour plus de fiabilité ; par conséquent, chaque tâche de carte à côté devra la lire depuis HDFS. Cela implique plusieurs opérations d’E / S disque et rend le traitement global plus lent. Il y a eu plusieurs initiatives telles que Tez dans Hadoop pour optimiser le traitement MapReduce. Comme indiqué précédemment, Spark crée un DAG d’opérations et optimise automatiquement les lectures de disque.

Hormis les différences précédentes, Spark complète Hadoop en fournissant une autre façon de traiter les données. Comme indiqué précédemment dans ce chapitre, il s’intègre bien avec les composants Hadoop tels que Hive, YARN et HDFS. Le diagramme suivant montre un écosystème typique de Spark et Hadoop. Spark utilise YARN pour planifier et exécuter sa tâche dans le cluster :

Spark et Hadoop

Résumé

Dans ce chapitre, nous avons présenté Apache Spark et son architecture. Nous avons discuté du concept de programme de pilote et d’exécuteurs, qui sont les principaux composants de Spark.

Nous avons ensuite brièvement discuté des différentes API de programmation pour Spark et de ses principaux composants, notamment Spark Core, Spark SQL, Spark Streaming et Spark GraphX.

Enfin, nous avons discuté de certaines différences majeures entre Spark et Hadoop et comment elles se complètent. Dans le chapitre suivant, nous allons installer Spark sur une instance AWS EC2 et passer par différents clients pour interagir avec Spark.

Chapitre 2. Installation d’Apache Spark

Dans le chapitre 1, Introduction à Apache Spark, nous avons découvert ce qu’est Spark, son architecture et les différents composants fournis par Spark. Dans ce chapitre, nous allons configurer Spark dans différents modes et examiner les différentes API que nous pouvons utiliser pour accéder aux clusters Spark ou soumettre une application Spark. Ce chapitre se couvrir les suivants sujets :

- Création d’un nœud unique (instance EC2 Linux) sur le cloud AWS

- Installation de Java sur une instance

- Installer Python sur une instance

- Installer Scala sur une instance

- Installation de Spark sur une instance

- Comment accéder à différents clients de composants Spark sur une instance

AWS elastic compute cloud (EC2)

Amazon Web Service (AWS) est une plate-forme cloud populaire qui fournit diverses offres pour l’infrastructure en tant que service (IAAS), la plate-forme en tant que service (PAAS) et les logiciels en tant que service (SAAS). AWS fournit des instances EC2 évolutives en tant que nœuds (machines) avec des ressources configurables (RAM et cœurs). Il fournit également un service de stockage simple (S3) en tant que stockage évolutif et à faible coût.

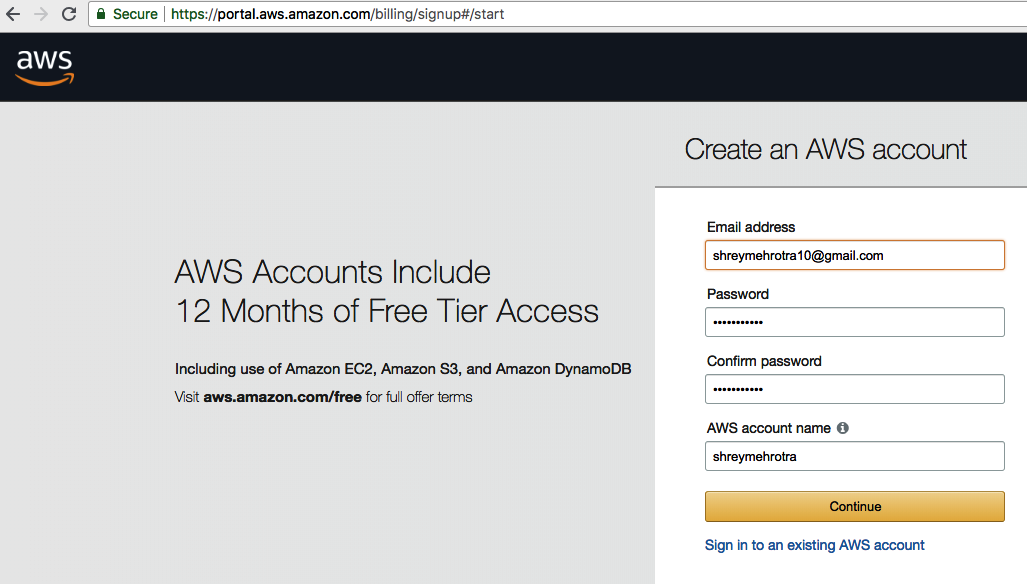

Créer un compte gratuit sur AWS

AWS vous fournit un compte gratuit afin que vous puissiez explorer différents services. Pour plus de détails sur ces services gratuits, veuillez visiter https://aws.amazon.com/free. Vous verrez l’écran suivant :

Suivez ces étapes pour obtenir votre nœud EC2 gratuit pour l’installation de Spark :

- Ouvrez un compte AWS avec votre Email address et votre Password, comme indiqué dans la capture d’écran suivante :

- Vous vous retrouverez dans la AWS Management Console, comme suit :

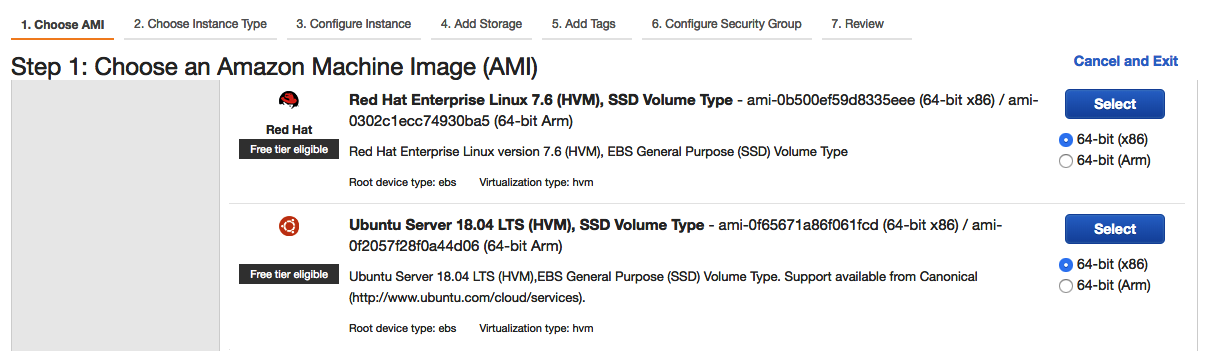

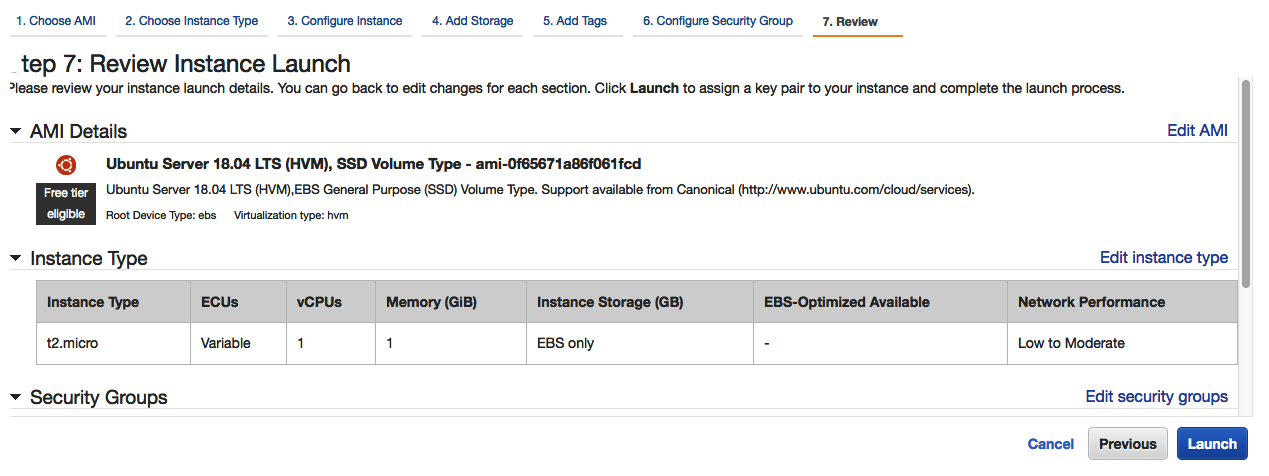

- Sélectionnez l’image de la machine Amazon (AMI) souhaitée. Nous avons choisi Ubuntu Server 18.04 ici :

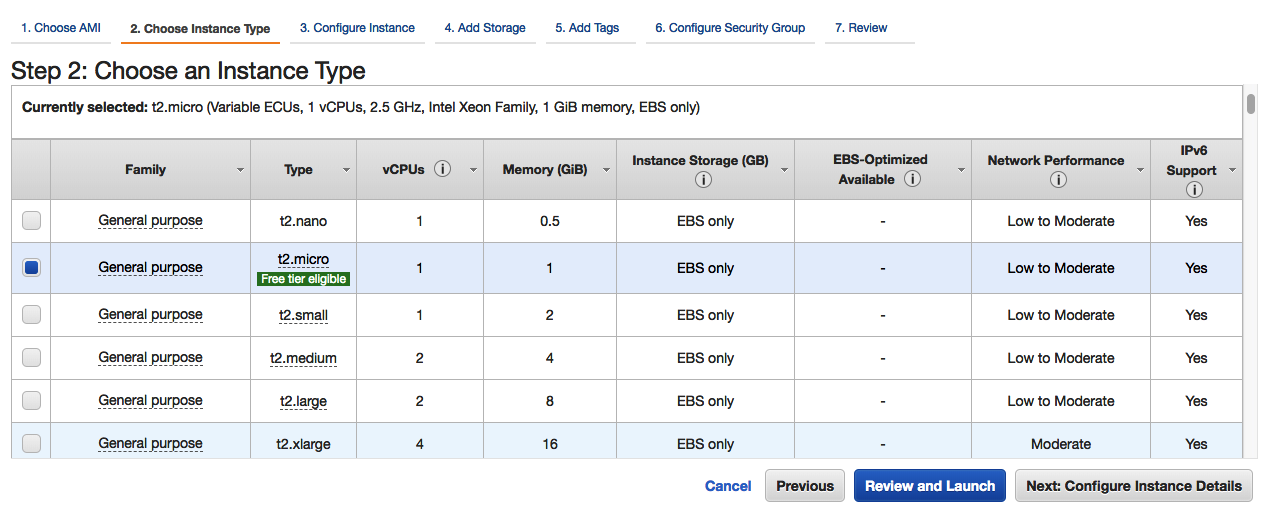

- Sélectionnez le Free tier eligible, t2.micro, comme suit:

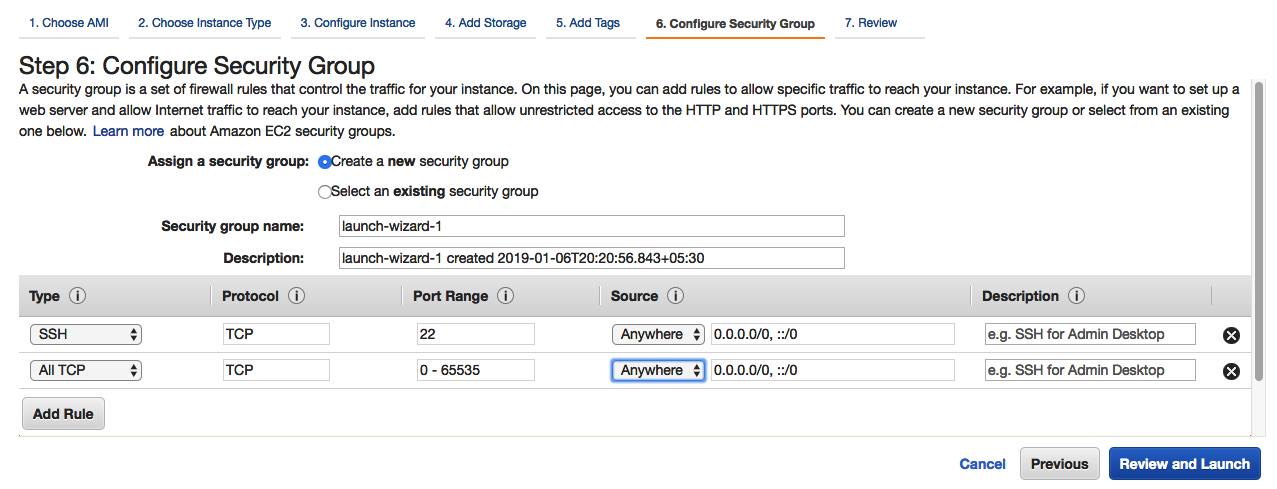

- Sélectionnez Configure Security Group pour permettre à toutes les machines de se connecter à l’instance que vous avez créée, comme suit :

- Vérifiez votre instance de lancement, comme suit :

- En cliquant sur Lancer, vous verrez une fenêtre contextuelle, qui vous permettra de générer une nouvelle paire clé-valeur pour votre instance:

- Cela générera une clé publique et des clés privées pour votre instance. La clé publique est stockée dans une instance Amazon, tandis que vous devez télécharger la clé privée.

- Cliquez sur Download Key Pair. Cela téléchargera un fichier .pem sur votre machine. Conservez-le dans un endroit sûr sur votre machine.

- Après avoir téléchargé le fichier .pem, cliquez sur Launch. Cela prendra un certain temps et affichera la page suivante :

- Vous pouvez parcourir quelques ressources utiles au bas de cette page. Une fois votre instance démarrée, vous pouvez consulter le tableau de bord EC2 :

Connexion à votre instance Linux

Reportez-vous aux liens suivants pour vous connecter à votre instance à partir de différentes plateformes:

Une fois que vous avez téléchargé le fichier .pem, appliquez les paramètres d’autorisation suivants pour obtenir des informations sur votre machine:

- Définissez l’autorisation du fichier .pem sur 400 et fournissez un chemin d’accès complet dans la commande ssh

- Le nom d’utilisateur par défaut pour Ubuntu AMI est ubuntu

- ec2-18-219-82-165.us-east-2.compute.amazonaws.com est le nom d’hôte de l’instance. Vous pouvez obtenir le nom d’hôte (DNS public (IPv4)) et d’autres détails sur la machine depuis le tableau de bord de l’instance EC2:

Pour l’instance que nous avons créée, nous pouvons nous connecter à la machine avec les commandes suivantes :

chmod 400 shrey.pem

ssh -i “shrey.pem” ubuntu@ec2-18-219-82-165.us-east-2.compute.amazonaws.com

Vous verrez l’écran suivant lors de l’exécution des commandes précédentes:

Une fois que vous vous connectez à votre instance Amazon, votre machine sera prête à installer les frameworks requis.

Configuration de Spark

Apache Spark peut être configuré dans les modes suivants :

- Mode autonome

- Mode distribué ou cluster

Conditions préalables

Les conditions suivantes sont requises pour configurer Spark dans l’un des modes:

- Linux OS : Spark est le plus compatible avec toutes les versions du système d’exploitation Linux. Vous pouvez utiliser n’importe quel ordinateur de bureau, machine virtuelle, serveur ou machine à l’échelle du cloud pour installer Spark. Bien que vous puissiez l’installer sur votre machine Windows, nous utilisons la machine Ubuntu AWS pour configurer Spark.

- Scala / Python / Java : Spark prend en charge les API dans plusieurs langues, y compris Scala, Python et Java. Toutes les API d’actions et de transformations Spark sont disponibles dans ces différents langages.

Installer Java

Vous pouvez utiliser les commandes suivantes pour installer Java sur votre système :

sudo add-apt-repository ppa:webupd8team/java -y

sudo apt install java-common oracle-java8-installer oracle-java8-set-default

Installation de Scala

Si vous avez le fichier Scala .tar (par exemple, scala-2.12.6.tgz), copiez-le dans une instance Linux AWS EC2 à n’importe quel emplacement (par exemple, / opt ):

- Vous pouvez également télécharger le dernier fichier binaire .tar.gz depuis http://www.scala-lang.org/download/all.html

- Vous pouvez télécharger 2.12.6 à partir de l’emplacement suivant : https://downloads.lightbend.com/scala/2.12.6/scala-2.12.6.tgz

Remarque

Le fichier / opt est un dossier vide à la racine dans la plupart des dossiers d’exploitation basés sur Linux. Ici, nous pouvons utiliser ce dossier pour copier et installer des logiciels. Par défaut, ce dossier appartient à root. Exécutez la commande suivante si vous rencontrez des problèmes d’autorisation lors de l’accès à ce dossier :

sudo chmod -R 777 / opt

Suivez ces étapes pour installer Scala 2.12.6 sur votre machine virtuelle Linux :

- Accédez à l’emplacement où vous avez copié le package logiciel Scala et décompressez- le :

cd / opt

tar – xzvf scala-2.12.6.tgz

- Définissez la variable d’environnement dans. bash_profile, comme suit:

nano ~ /. bash_profile

- Ajoutez les lignes suivantes à la fin du du fichier:

export SCALA_HOME = / opt / scala-2.12.6

export PATH = $ PATH: $ SCALA_HOME / bin

- Exécutez la commande suivante pour mettre à jour les variables d’environnement dans la courant session :

source ~ /. bash_profile

- Recherchez une installation Scala en exécutant la commande suivante:

scala -version

Installer Python

Python sous Linux peut être facilement installé avec les commandes suivantes :

sudo apt-get update

sudo apt-get install python3.6

Installation de Spark

Suivez ces étapes pour installer Spark 2.3.1, compilé avec Hadoop 2.7:

- Si vous avez une distribution tar Spark 2.0 (par exemple, spark-2.3.1-bin-hadoop2.7.tgz), copiez-la dans votre machine virtuelle Linux à n’importe quel emplacement (par exemple, / opt ) à l’ aide de n’importe quel fichier Windows sur Linux logiciel de transfert (FileZilla ou WinSCP). Vous pouvez également télécharger le dernier fichier binaire .tar.gz à partir du lien Apache Spark suivant: http://spark.apache.org/downloads.html.

Remarque

Le fichier / opt est un dossier vide à la racine dans la plupart des dossiers d’exploitation basés sur Linux. Ici, nous utiliserions ce dossier pour copier et installer des logiciels. Par défaut, ce dossier appartient à Root. Par conséquent, exécutez la commande suivante si vous rencontrez des problèmes d’autorisation lors de l’accès à ce dossier. sudo chmod -R 777 / opt .

- Accédez à l’emplacement où vous avez copié le package logiciel Spark et décompressez- le :

cd /opt

tar -xzvf spark-2.3.1-bin-hadoop2.7.tgz

- Définissez la variable d’environnement dans bash_profile, comme suit :

nano ~ /. bash_profile

- Ajoutez les lignes suivantes à la fin du fichier :

export SPARK_HOME=/opt/spark-2.3.1-bin-hadoop2.7

export PATH=$PATH:$SPARK_HOME/sbin

export PATH=$PATH:$SPARK_HOME/bin

- Exécutez la commande suivante pour mettre à jour les variables d’environnement dans la courant session :

source ~/.bash_profile

Utilisation de composants Spark

Spark fournit une interface de ligne de commande différente, c’est -à-dire une boucle de lecture-évaluation-impression (REPL) pour différents langages de programmation. Vous pouvez choisir le type de REPL parmi les options suivantes, en fonction de la langue de votre choix :

- Shell Spark pour Scala : Si vous souhaitez utiliser Scala pour accéder aux API Spark, vous pouvez démarrer le shell Spark Scala avec la commande suivante :

spark-shell

L’écran suivant s’affiche après l’exécution de la commande précédente :

Une fois le pilote (l’un des composants de Spark) démarré, vous pouvez accéder à toutes les API Scala et Java dans le shell :

- Shell Spark pour Python : Si votre choix de codage préféré est Python, vous pouvez démarrer le shell Python de Spark avec une commande :

- Ajoutez Python à Spark Path.

- Ouvrez le .bash_profile et ajoutez les lignes suivantes:

nano ~/.bash_profile

export PYSPARK_PYTHON=python3

export PYTHONPATH=$SPARK_HOME/python:$PYTHONPATH

- Enregistrez-le ~/.bash_profile :

pyspark

Une fois le shell chargé, vous pouvez commencer à utiliser les commandes Python pour accéder aux API Spark, comme indiqué dans la sortie suivante :

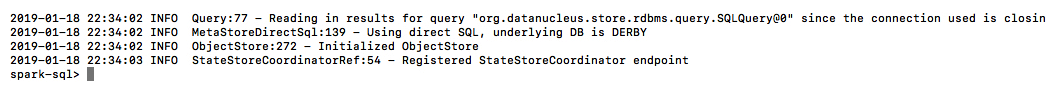

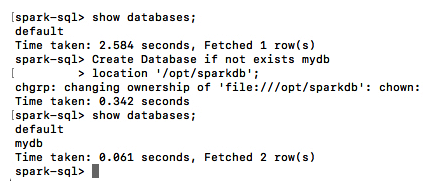

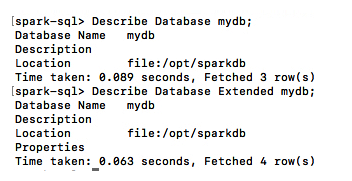

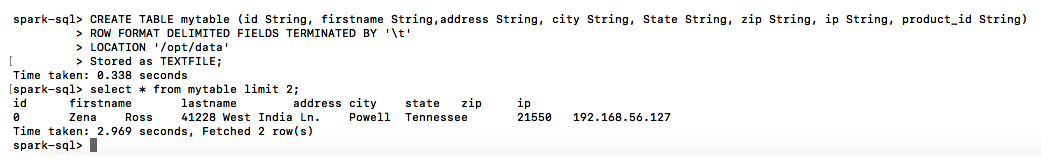

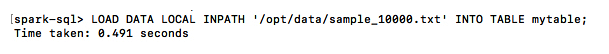

- Spark SQL : si vous avez travaillé sur un système de gestion de base de données relationnelle (SGBDR) comme Oracle, MySQL ou Teradata et que vous souhaitez appliquer vos compétences en programmation SQL à Spark, vous pouvez utiliser le module Spark SQL pour écrire des requêtes pour différents jeux de données structurés. Pour démarrer le shell Spark SQL, il vous suffit de taper la commande suivante dans le terminal de votre machine :

spark- sql

La capture d’écran suivante montre l’ensemble des exécutions qui se produiraient lorsque vous ouvririez spark-sql. Comme vous pouvez le voir, spark-sql utilise la base de données sous-jacente, qui est DERBY par défaut. Dans le chapitre 6, Spark SQL, vous découvrirez comment nous pouvons connecter spark-sql au métastore Hive :

Vous auriez un shell spark-sql connecté par défaut magasin de données Derby:

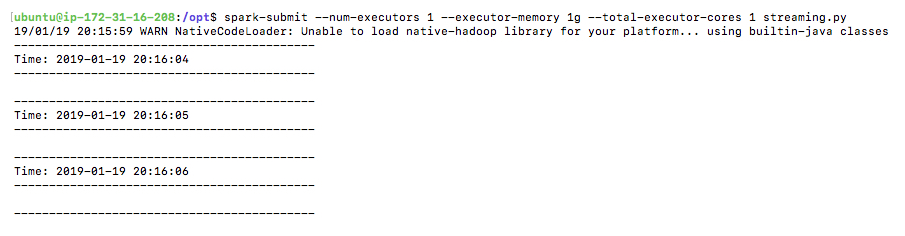

- Soumission Spark : La fonctionnalité multilingue de Spark vous permet également d’utiliser Java pour accéder aux API Spark. Étant donné que Java (jusqu’à la version 8) ne fournit pas la fonctionnalité REPL, les API Spark sont accessibles et exécutées à l’aide de la commande suivante :

spark-submit

La syntaxe suivante explique comment nous pouvons spécifier jar avec logique, le nombre d’exécuteurs, la spécification des ressources de l’exécuteur et le mode d’exécution pour l’application (autonome ou YARN) :

./bin/spark-submit \

–class <main-class> \

–master <master-url> \

–deploy-mode <deploy-mode> \

–executor-memory 20G \

–total-executor-cores 100

–conf <key>=<value> \

<application-jar> \

[application-arguments]

Ici, nous pouvons décrire les différentes logiques comme suit :

- –class : il s’agit de la classe contenant la méthode main et c’est le point d’entrée de l’application (par exemple, org.apache.spark.examples.SparkPi).

- –master : Il s’agit de la propriété clé pour définir le master de votre application. En fonction du mode autonome ou en mode cluster, le master peut être local, YARN, ou spark://host:port (par exemple, spark://192.168.56.101:7077). Plus d’options sont disponibles sur https://spark.apache.org/docs/latest/submitting-applications.html#master-urls.

- –deploy-mode : il est utilisé pour démarrer le pilote sur l’un des nœuds de travail du cluster ou localement où la commande est exécutée (client) (par défaut : client).

- –conf : Spark configurations que vous souhaitez remplacer pour votre application au format key=value.

- application-jar : il s’agit du chemin de votre application jar. Si elle est présente dans HDFS, alors vous devez spécifier le chemin de HDFS comme hdfs:// path ou si elle est un chemin de fichier, alors il devrait être un chemin valide sur un nœud de pilote, file://path.

- application-arguments : Ce sont les arguments que vous devez spécifier pour la classe principale de votre application.

Différents modes d’exécution

L’application Spark peut s’exécuter dans différents modes, qui sont classés par où et comment nous voulons configurer le maître et quelles sont les besoins en ressources de l’exécuteur.

Le maître peut s’exécuter sur la même machine locale, avec des exécuteurs ; il peut également s’exécuter sur une machine spécifique avec l’hôte et le port fournis. Si nous configurons YARN en tant que gestionnaire de ressources Spark, le maître peut être géré par YARN:

# Exécuter l’application localement sur 8 cœurs

./bin/spark-submit \

–class org.apache.spark.examples.SparkPi \

–master local[8] \

/path/to/examples.jar \

100

# Exécuter sur un cluster autonome Spark en mode de déploiement client

./bin/spark-submit \

–class org.apache.spark.examples.SparkPi \

–master spark://host-ip:7077 \

–executor-memory 20G \

–total-executor-cores 100 \

/path/to/examples.jar \

1000

# Exécuter sur un cluster YARN

export HADOOP_CONF_DIR=XXX

./bin/spark-submit \

–class org.apache.spark.examples.SparkPi \

–master yarn \

–deploy-mode cluster \ # can be client for client mode

–executor-memory 20G \

–num-executors 50 \

/path/to/examples.jar \

1000

Source : https://spark.apache.org/docs/latest/submitting-applications.html.

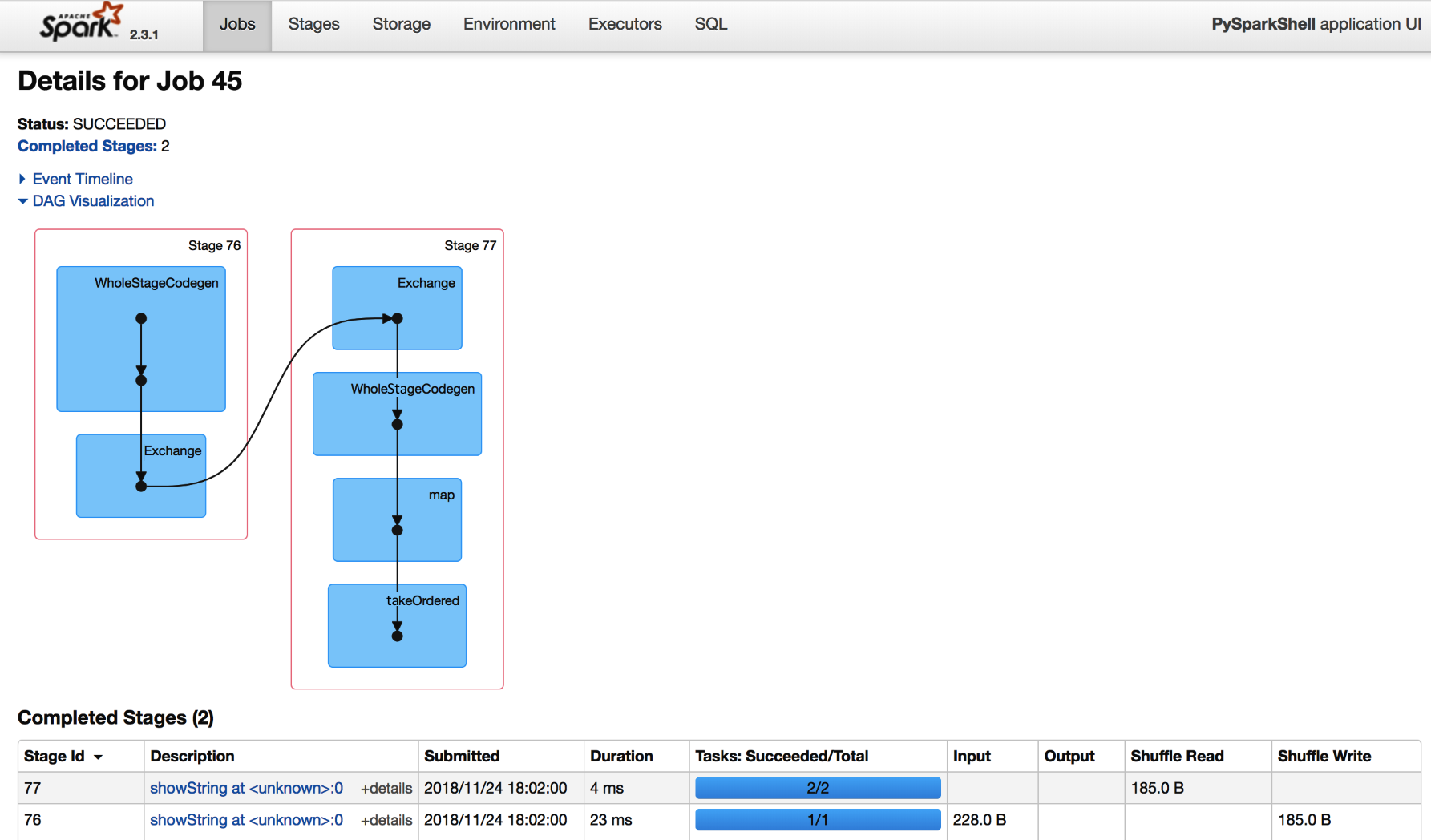

Interface utilisateur Spark : Spark fournit une interface Web pour l’exécution des applications, accessible par défaut sur le port 4040: http://localhost:4040/jobs/ :

Spark sandbox

Pour démarrer rapidement le développement, vous pouvez également télécharger et configurer le bac à sable fourni par Hortonworks ou Cloudera. Voici les liens :

- Hortonworks : https://hortonworks.com/tutorial/hands-on-tour-of-apache-spark-in-5-minutes/

- Cloudera : https://www.cloudera.com/documentation/enterprise/5-6-x/topics/quickstart.html

Résumé

Ce chapitre vous a aidé à installer Java, Scala et Spark sur une machine Linux obtenue à partir d’une instance AWS EC2. Vous pouvez maintenant utiliser la même configuration pour exécuter les requêtes / exemples fournis dans d’autres chapitres de cet article.

Dans le chapitre suivant, vous découvrirez l’unité de base de Spark, qui est RDD. RDD fait référence à un ensemble de données distribué résilient immuable, sur lequel nous pouvons appliquer d’autres actions et transformations.

Chapitre 3. Spark RDD

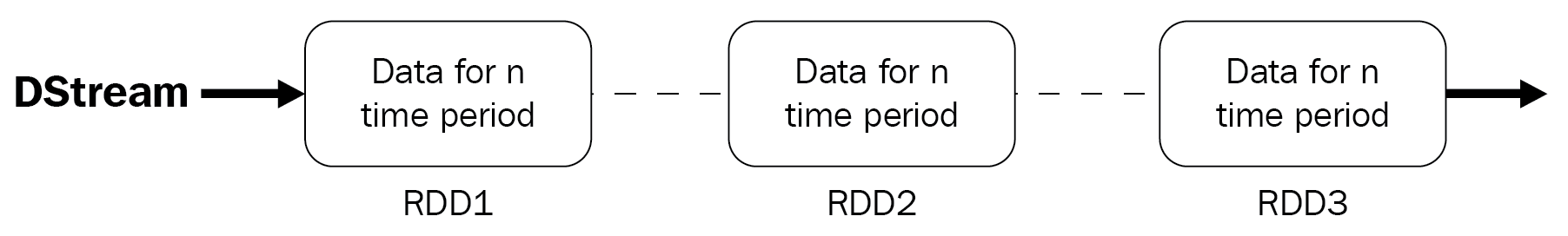

Les jeux de données distribués résilients (RDD) sont le bloc de construction de base d’une application Spark. Un RDD représente une collection en lecture seule d’objets distribués sur plusieurs machines. Spark peut distribuer une collection d’enregistrements à l’aide d’un RDD et les traiter en parallèle sur différentes machines.

Dans ce chapitre, nous apprendrons ce qui suit :

-

- Qu’est – ce qu’un RDD ?

- Comment créez-vous des RDD ?

- Différentes opérations disponibles pour travailler sur les RDD

- Types importants de RDD

- Mise en cache d’un RDD

- Partitions d’un RDD

- Inconvénients de l’utilisation de RDD

Les exemples de code de ce chapitre sont écrits en Python et Scala uniquement. Si vous souhaitez passer par les API Java et R, vous pouvez visiter la page de documentation Spark sur https://spark.apache.org/.

Qu’est-ce qu’un RDD?

RDD est au cœur de chaque application Spark. Comprenons plus en détail la signification de chaque mot:

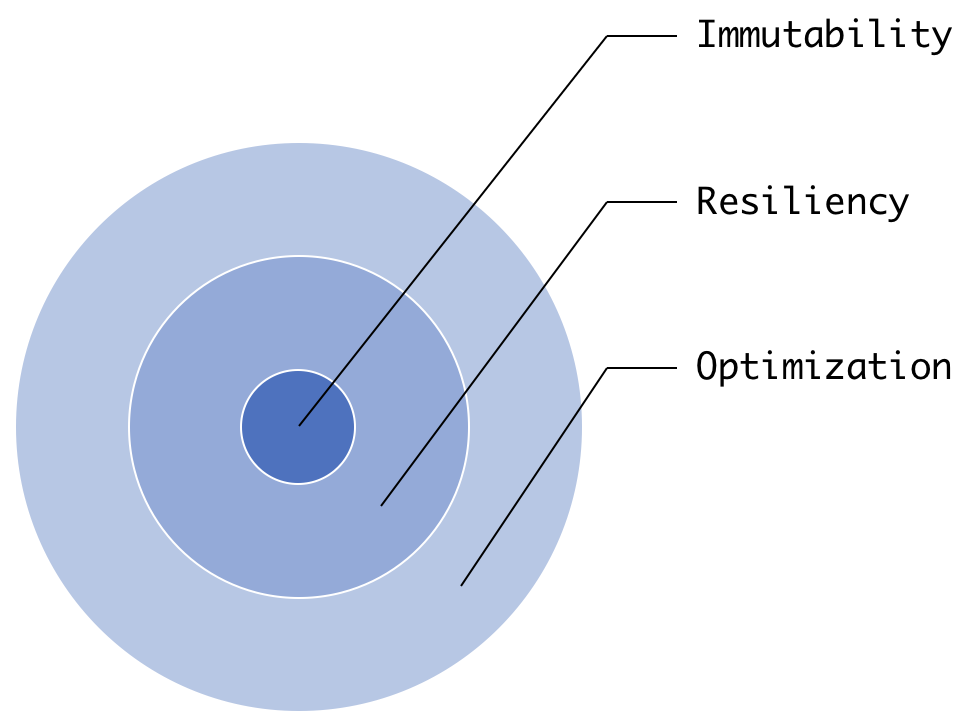

- Résilient : si nous regardons la signification de résilient dans le dictionnaire, nous pouvons voir que cela signifie être : capable de récupérer rapidement de conditions difficiles. Spark RDD a la capacité de se recréer en cas de problème. Vous devez vous demander, pourquoi a-t-il besoin de se recréer ? Vous vous souvenez comment HDFS et d’autres magasins de données parviennent à la tolérance aux pannes ? Oui, ces systèmes conservent une réplique des données sur plusieurs machines à récupérer en cas de panne. Mais, comme expliqué au chapitre 1, Introduction à Apache Spark, Spark n’est pas un magasin de données ; Spark est un moteur d’exécution. Il lit les données des systèmes source, les transforme et les charge dans le système cible. Si quelque chose ne va pas lors de l’exécution de l’une des étapes précédentes, nous perdrons les données. Pour fournir la tolérance aux pannes lors du traitement, un RDD est rendu résilient : il peut se recalculer. Chaque RDD conserve des informations sur son RDD parent et comment il a été créé à partir de son parent. Cela nous introduit au concept de Lineage. Les informations sur la maintenance du parent et de l’opération sont appelées lignées. La lignée ne peut être atteinte que si vos données sont immutables. Qu’est-ce que je veux dire par là ? Si vous perdez l’état actuel d’un objet et que vous êtes sûr que l’état précédent ne changera jamais, vous pouvez toujours revenir en arrière et utiliser son état passé avec les mêmes opérations, et vous récupérerez toujours l’état actuel de l’objet. C’est exactement ce qui se passe dans le cas des RDD. Si vous trouvez cela difficile, ne vous inquiétez pas ! Cela deviendra clair lorsque nous verrons comment les RDD sont créés. L’immuabilité apporte également un autre avantage : optimization. Si vous savez que quelque chose ne changera pas, vous avez toujours la possibilité de l’optimiser. Si vous y prêtez attention, tous ces concepts sont connectés, comme l’illustre le schéma suivant :

RDD

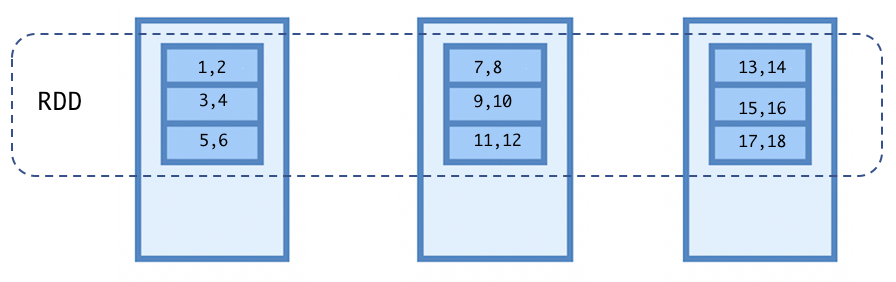

- Distribué : comme mentionné au point suivant, un ensemble de données n’est rien d’autre qu’une collection d’objets. Un RDD peut distribuer son ensemble de données sur un ensemble de machines, et chacune de ces machines sera responsable du traitement de sa partition de données. Si vous venez d’un arrière-plan Hadoop MapReduce, vous pouvez imaginer des partitions comme les divisions d’entrée pour la phase de carte.

- Jeu de données : un jeu de données n’est qu’une collection d’objets. Ces objets peuvent être un objet complexe Scala, Java ou Python ; Nombres ; cordes ; lignes d’une base de données; et plus.

Chaque programme Spark se résume à un RDD. Un programme Spark écrit en Spark SQL, DataFrame ou ensemble de données est converti en RDD au moment de l’exécution.

Le diagramme suivant illustre un RDD de nombres (1 à 18) ayant neuf partitions sur un cluster de trois nœuds :

RDD

Métadonnées résilientes

Comme nous l’avons vu, outre les partitions, un RDD stocke également certaines métadonnées à l’intérieur. Ces métadonnées aident Spark à recalculer une partition RDD en cas d’échec et fournissent également des optimisations lors de l’exécution des opérations.

Les métadonnées comprennent les éléments suivants :

- Une liste des dépendances RDD parent

- Une fonction pour calculer une partition à partir de la liste des RDD parents

- L’emplacement préféré pour les partitions

- Les informations de partitionnement, en cas de pair de RDD

Bon, assez de théorie ! Créons un programme simple et comprenons les concepts plus en détail dans la section suivante.

Programmation à l’aide de RDD

Un RDD peut être créé de quatre manières :

- Paralléliser une collection : c’est l’un des moyens les plus simples de créer un RDD. Vous pouvez utiliser la collection existante de vos programmes, tels que List, Array ou Set, ainsi que d’autres, et demander à Spark de distribuer cette collection sur le cluster pour la traiter en parallèle. Une collection peut être distribuée à l’aide de parallelize (), comme illustré ici :

#Python

numberRDD = spark.sparkContext.parallelize(range(1,10))

numberRDD.collect()

Out[4]: [1, 2, 3, 4, 5, 6, 7, 8, 9]

Le code suivant effectue la même opération dans Scala :

//scala

val numberRDD = spark.sparkContext.parallelize(1 to 10)

numberRDD.collect()

res4: Array[Int] = Array(1, 2, 3, 4, 5, 6, 7, 8, 9, 10)

- À partir d’un jeu de données externe : bien que la parallélisation d’une collection soit le moyen le plus simple de créer un RDD, ce n’est pas le moyen recommandé pour les grands jeux de données. Les grands ensembles de données sont généralement stockés sur des systèmes de fichiers tels que HDFS, et nous savons que Spark est conçu pour traiter les mégadonnées. Par conséquent, Spark fournit un certain nombre d’API pour lire les données des jeux de données externes. L’une des méthodes de lecture des données externes est le textFile ( ) . Cette méthode accepte un nom de fichier et crée un RDD, où chaque élément du RDD est la ligne du fichier d’entrée.

Dans l’exemple suivant, nous initialisons d’abord une variable avec le chemin d’accès au fichier, puis utilisons la variable filePath comme argument de la méthode textFile ( ) :

//Scala

val filePath = “/FileStore/tables/sampleFile.log”

val logRDD = spark.sparkContext.textFile(filePath)

logRDD.collect()

res6: Array[String] = Array(2018-03-19 17:10:26 – myApp – DEBUG – debug message 1, 2018-03-19 17:10:27 – myApp – INFO – info message 1, 2018-03-19 17:10:28 – myApp – WARNING – warn message 1, 2018-03-19 17:10:29 – myApp – ERROR – error message 1, 2018-03-19 17:10:32 – myApp – CRITICAL – critical message with some error 1, 2018-03-19 17:10:33 – myApp – INFO – info message 2, 2018-03-19 17:10:37 – myApp – WARNING – warn message, 2018-03-19 17:10:41 – myApp – ERROR – error message 2, 2018-03-19 17:10:41 – myApp – ERROR – error message 3)

Si vos données sont présentes dans plusieurs fichiers, vous pouvez utiliser wholeTextFiles () au lieu d’utiliser la méthode textFile (). L’argument de wholeTextFiles () est le nom du répertoire qui contient tous les fichiers. Chaque élément sera représenté comme une paire de valeurs clés, où la clé sera le nom du fichier et la valeur sera le contenu entier de ce fichier. Ceci est utile dans les scénarios où vous avez beaucoup de petits fichiers et souhaitez traiter chaque fichier séparément.

Remarque

Les fichiers JSON et XML sont des entrées courantes de wholeTextFiles() car vous pouvez analyser chaque fichier séparément à l’aide d’une bibliothèque d’analyseur.

- À partir d’un autre RDD : Comme indiqué dans la première section, les RDD sont immuables par nature. Ils ne peuvent pas être modifiés, mais nous pouvons transformer un RDD en un autre RDD à l’aide des méthodes fournies par Spark. Nous allons discuter de ces méthodes plus en détail dans ce chapitre. L’exemple suivant utilise filter() pour transformer notre numberRDD en evenNumberRDD en Python. De même, il utilise également filter() pour créer oddNumberRDD dans Scala:

#Python

evenNumberRDD = numberRDD.filter(lambda num : num%2 == 0 )

evenNumberRDD.collect()

Out[10]: [2, 4, 6, 8]

Le code suivant effectue la même opération dans Scala :

//Scala

val oddNumberRDD = numberRDD.filter( num => num%2 != 0 )

oddNumberRDD.collect()

res8: Array[Int] = Array(1, 3, 5, 7, 9)

- À partir d’un DataFrame ou d’un ensemble de données : Vous devez penser, pourquoi créerions- nous jamais un RDD à partir d’un DataFrame ? Après tout, un DataFrame est une abstraction au-dessus d’un RDD. Tu as raison! Pour cette raison, il est conseillé d’utiliser des DataFrames ou un ensemble de données sur un RDD, car un DataFrame apporte des avantages en termes de performances.

Vous devrez peut-être convertir un RDD à partir d’un DataFrame dans certains scénarios où les éléments suivants s’appliquent :

- Les données sont très non structurées

- Les données sont réduites à une taille gérable après des calculs lourds, tels que des jointures ou des agrégations, et vous souhaitez plus de contrôle sur la distribution physique des données à l’aide d’un partitionnement personnalisé

- Vous avez du code écrit dans un langage de programmation différent ou un code RDD hérité

Créons un DataFrame et convertissons-le en RDD :

#Python

rangeDf = spark.range(1,5)

rangeRDD = rangeDf.rdd

rangeRDD.collect()

Out[15]: [Row(id=1), Row(id=2), Row(id=3), Row(id=4)]

Dans le code précédent, nous avons d’abord créé un rangeDf DataFrame avec une colonne id (le nom de colonne par défaut) à l’aide de la méthode range() de Spark , qui a créé 4 lignes, de 1 à 4 . Nous utilisons ensuite la rdd méthode pour convertir en rangeRDD.

Remarque

La méthode range (N) crée des valeurs de 0 à N-1 .

Comme nous avons maintenant une compréhension de base de la façon de créer des RDD, écrivons un programme simple qui lit un fichier journal et renvoie uniquement le nombre de messages avec des niveaux de journal d’ERRoR et d’INFO :

$ cat sampleFile.log

2018-03-19 17:10:26 – myApp – DEBUG – debug message 1

2018-03-19 17:10:27 – myApp – INFO – info message 1

2018-03-19 17:10:28 – myApp – WARNING – warn message 1

2018-03-19 17:10:29 – myApp – ERROR – error message 1

2018-03-19 17:10:32 – myApp – CRITICAL – critical message with some error 1

2018-03-19 17:10:33 – myApp – INFO – info message 2

2018-03-19 17:10:37 – myApp – WARNING – warn message

2018-03-19 17:10:41 – myApp – ERROR – error message 2

2018-03-19 17:10:41 – myApp – ERROR – error message 3

Le code précédent montre le contenu des fichiers sampleFile.log. Chaque ligne dans sampleFile.log représente un journal avec son niveau de journal.

Les extraits de code suivants calculent le nombre de messages ERROR et INFO dans le fichier journal à l’aide de l’API Python :

#Python

filePath = “/FileStore/tables/sampleFile.log”

logRDD = spark.sparkContext.textFile(filePath)

resultRDD = logRDD.filter(lambda line : line.split(” – “)[2] in [‘INFO’,’ERROR’])\

.map(lambda line : (line.split(” – “)[2], 1))\

.reduceByKey(lambda x, y : x + y)

resultRDD.collect()

Out[27]: [(‘INFO’, 2), (‘ERROR’, 3)]

Le code suivant effectue la même opération dans Scala:

//Scala

val filePath = “/FileStore/table/sampleFile.log”

val logRDD = spark.sparkContext.textFile(filePath)

val resultRDD = logRDD.filter(line => Array(“INFO”,”ERROR”).contains(line.split(” -“)(2)))

.map(line => (line.split(” – “)(2), 1))

.reduceByKey( _ + _ )

resultRDD.collect()

res12: Array[(String, Int)] = Array((ERROR,3), (INFO,2))

Dans les deux exemples précédents, nous avons d’abord créé une variable filePath qui contenait le chemin d’accès à notre fichier journal. Nous avons ensuite utilisé la méthode textFile () pour créer notre RDD de base, c’est-à-dire logRDD . Sous le capot, Spark ajoute cette opération à son DAG. Au moment de l’exécution, Spark lira notre sampleFile.log et le distribuera à plusieurs exécuteurs. Dans la ligne suivante, nous utilisons filter () pour obtenir uniquement les lignes qui ont “INFO” et “ERROR” comme niveau de journal. La méthode filter () accepte une fonction en entrée et renvoie un booléen. Nous avons également conduit la sortie du filter à un objet map (), et maintenant le problème est réduit au problème du mot-comte. À ce stade, map () ne recevra que les lignes filtrées et affectera 1 à chaque enregistrement. Nous agrégons les enregistrements en fonction du niveau de journal à l’aide de ReduceByKey (), qui ajoute toutes les valeurs pour chaque niveau de journal. Nous collectons enfin notre résultat en utilisant la méthode collect (). C’est le point où Spark commence réellement à exécuter le DAG.

Transformations et actions

Nous avons discuté de quelques opérations de base pour créer et manipuler des RDD. Il est maintenant temps de les classer en deux catégories principales:

- Transformations

- Actions

Transformation

Comme son nom l’indique, les transformations nous aident à transformer les RDD existants. En sortie, ils créent toujours un nouveau RDD qui est calculé paresseusement. Dans les exemples précédents, nous avons discuté de nombreuses transformations, telles que map() , filter() et ReduceByKey() .

Les transformations sont de deux types :

- Transformations étroites

- Transformations larges

Transformations étroites

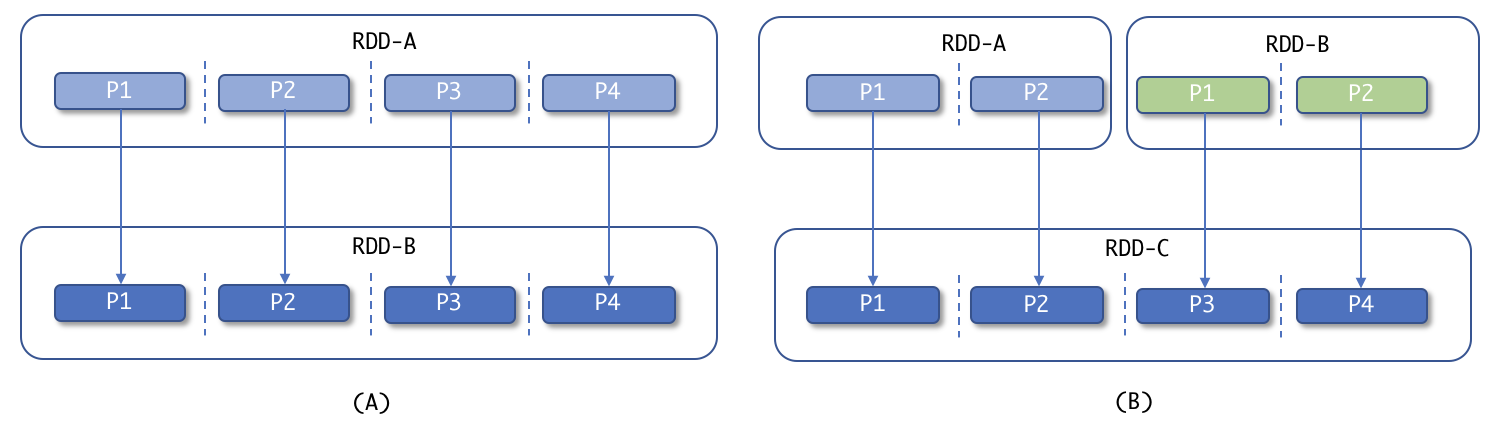

Des transformations étroites transforment les données sans mélange. Ces transformations transforment les données par partition ; c’est-à-dire que chaque élément du RDD de sortie peut être calculé sans impliquer d’éléments de différentes partitions. Cela conduit à un point important : le nouveau RDD aura toujours le même nombre de partitions que ses RDD parents, et c’est pourquoi ils sont faciles à recalculer en cas d’échec. Comprenons cela avec l’exemple suivant :

Transformations étroites

Donc, nous avons un RDD-A et nous effectuons une transformation étroite, comme map() ou filter() , et nous obtenons un nouveau RDD-B avec le même nombre de partitions que RDD-A . Dans la partie (B), nous en avons deux, RDD-A et RDD-B, et nous effectuons un autre type de transformation étroite comme union(), et nous obtenons un nouveau RDD-C avec le nombre de partitions égal à la somme de partitions de ses RDD parents ( A et B ). Regardons quelques exemples de transformations étroites.

map ( )

Cela applique une fonction donnée à chaque élément d’un RDD et renvoie un nouveau RDD avec le même nombre d’éléments. Par exemple, dans le code suivant, les nombres de 1 à 10 sont multipliés par le nombre 2 :

#Python

spark.sparkContext.parallelize(range(1,11)).map(lambda x : x * 2).collect()

Le code suivant effectue la même opération dans Scala :

//Scala

spark.sparkContext.parallelize(1 to 10).map(_ * 2).collect()

flatMap ( )

Cela applique une fonction donnée qui renvoie un itérateur à chaque élément d’un RDD et renvoie un nouveau RDD avec plus d’éléments. Dans certains cas, vous pourriez avoir besoin de plusieurs éléments à partir d’un seul élément. Par exemple, dans le code suivant, un RDD contenant des lignes est converti en un autre RDD contenant des mots :

#Python

spark.sparkContext.parallelize([“It’s fun to learn Spark”,”This is a flatMap example using Python”]).flatMap(lambda x : x.split(” “)).collect()

Le code suivant effectue la même opération dans Scala :

//Scala

spark.sparkContext.parallelize(Array(“It’s fun to learn Spark”,”This is a flatMap example using Python”)).flatMap(x => x.split(” “)).collect()

filtre ( )

La transformation filter( ) applique une fonction qui filtre les éléments qui ne répondent pas aux critères de condition, comme indiqué dans le code suivant. Par exemple, si nous avons besoin de nombres supérieurs à 5, nous pouvons passer cette condition à la transformation filter( ) . Créons un RDD de nombres 1 à 10 et filtrons les nombres supérieurs à 5 :

#Python

spark.sparkContext.parallelize(range(1,11)).filter(lambda x : x > 5).collect()

Le code suivant effectue la même opération dans Scala :

//Scala

spark.sparkContext.parallelize(1 to 10).filter(_ > 5).collect()

Toute fonction qui renvoie une valeur booléenne peut être utilisée pour filtrer les éléments.

union ( )

La transformation union() prend un autre RDD en entrée et produit un nouveau RDD contenant des éléments à partir des deux RDD, comme indiqué dans le code suivant. Créons deux RDD : l’un avec les numéros 1 à 5 et l’autre avec les numéros 5 à 10 , puis les concaténons ensemble pour obtenir un nouveau RDD avec les numéros 1 à 10 :

#Python

firstRDD = spark.sparkContext.parallelize(range(1,6))

secordRDD = spark.sparkContext.parallelize(range(5,11))

firstRDD.union(secordRDD).collect()

Le code suivant effectue la même opération dans Scala :

//scala

val firstRDD = spark.sparkContext.parallelize(1 to 5)

val secordRDD = spark.sparkContext.parallelize(5 to 10)

firstRDD.union(secordRDD).collect()

Remarque

La transformation union() ne supprime pas les doublons. Si vous venez d’un arrière-plan SQL, union() effectue la même opération que Union All dans SQL.

mapPartitions ( )

La transformation mapPartitions() est similaire à map() . Il permet également aux utilisateurs de manipuler les éléments d’un RDD, mais il offre plus de contrôle par partition. Il applique une fonction qui accepte un itérateur comme argument et renvoie un itérateur comme sortie. Si vous avez effectué des scripts shell et que vous connaissez la programmation AWK , vous pouvez corréler cela avec la transformation mapPartitions pour mieux la comprendre. Un exemple AWK typique ressemble à BEGIN { # Begin block } {#middle block} END {#end Block }. Le bloc Begin ne s’exécute qu’une seule fois avant de lire le contenu du fichier, le bloc du middle s’exécute pour chaque ligne du fichier d’entrée et le bloc end ne s’exécute également qu’une seule fois à la fin du fichier. De même, si vous souhaitez que certaines opérations soient effectuées au début ou à la fin du traitement de tous les éléments un par un, vous pouvez utiliser la transformation mapPartitions() . Dans le code suivant, nous multiplions chaque élément par 2, mais cette fois avec mapPartitions() :

#Python

spark.sparkContext.parallelize(range(1,11), 2).mapPartitions(lambda iterOfElements : [e*2 for e in iterOfElements]).collect()

Le code suivant effectue la même opération dans Scala :

//scala

spark.sparkContext.parallelize(1 to 10, 2).mapPartitions(iterOfElements => for (e <- iterOfElements) yield e*2 ).collect()

Un exemple où vous pourriez utiliser mapPartitions() est lorsque vous devez ouvrir une connexion de base de données au début de chaque partition.

Remarque

Si vous souhaitez créer un objet une seule fois et que cet objet doit être utilisé lors du calcul dans chaque partition, vous pouvez utiliser des variables de broadscast.

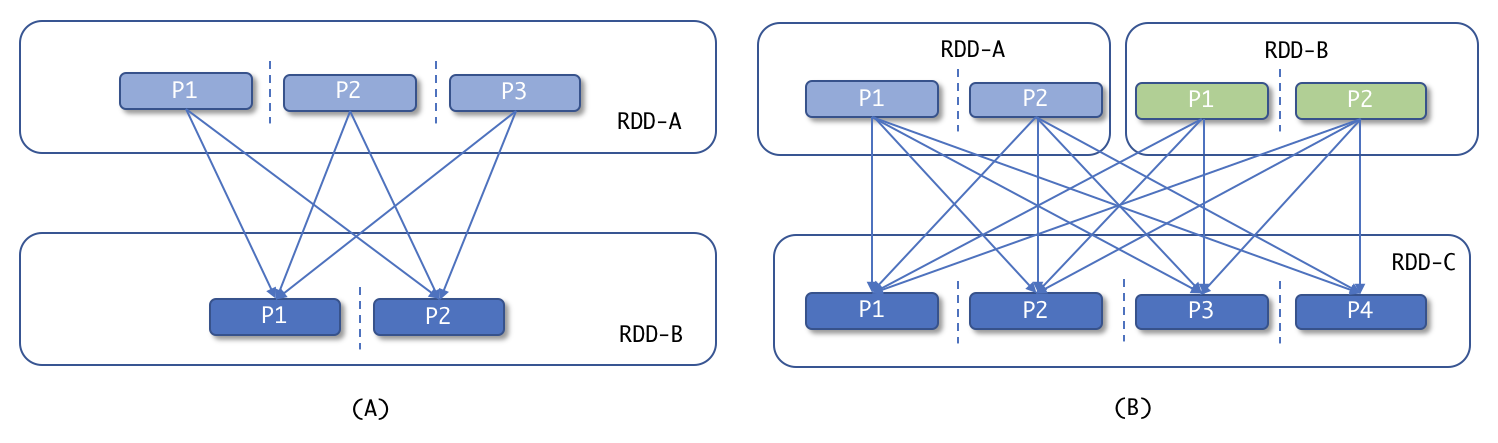

Transformations larges

Les transformations larges impliquent un brassage des données entre les partitions. Les groupByKey() , ReduceByKey() , join() , distinct() et intersect() sont quelques exemples de transformations larges. Dans le cas de ces transformations, le résultat sera calculé à l’aide des données de plusieurs partitions et nécessite donc un shuffle. Les transformations larges sont similaires à la phase de shuffle-and-sort de MapReduce. Comprenons le concept à l’aide de l’exemple suivant :

Transformations larges

Nous avons un RDD-A et nous effectuons une large transformation telle que groupByKey() et nous obtenons un nouveau RDD-B avec moins de partitions. RDD-B aura des données regroupées par chaque clé de l’ensemble de données. Dans la partie (B) , nous avons deux RDD : RDD-A et RDD-B et nous effectuons un autre type de transformation large comme join() ou intersection() et obtenons un nouveau RDD-C . Voici quelques exemples de transformations étendues.

distinct ( )

La transformation distinct() supprime les éléments en double et renvoie un nouveau RDD avec des éléments uniques comme indiqué. Créons un RDD avec des éléments dupliquées (1,2,3,4) et utilisons distinct() pour obtenir un RDD avec des nombres uniques:

#Python

spark.sparkContext.parallelize([1,1,2,2,3,3,4,4]).distinct().collect()

Le code suivant effectue la même opération dans Scala:

//scala

spark.sparkContext.parallelize(Array(1,1,2,2,3,3,4,4)).distinct().collect()

sortBy ( )

Nous pouvons trier un RDD à l’aide de la transformation sortBy() . Il accepte une fonction qui peut être utilisée pour trier les éléments RDD. Dans l’exemple suivant, nous trions notre RDD dans l’ordre décroissant à l’aide du deuxième élément du tuple :

#Python

spark.sparkContext.parallelize([(‘Rahul’, 4),(‘Aman’, 2),(‘Shrey’, 6),(‘Akash’, 1)]).sortBy(lambda x : -x[1]).collect()

Le code suivant effectue la même opération dans Scala :

//scala

spark.sparkContext.parallelize(Array((“Rahul”, 4),(“Aman”, 2),(“Shrey”, 6),(“Akash”, 1))).sortBy( _._2 * -1 ).collect()

Le code précédent entraînera ceci :

[(‘Shrey’, 6), (‘Rahul’, 4), (‘Aman’, 2), (‘Akash’, 1)]

intersection ( )

La transformation intersection() nous permet de trouver des éléments communs entre deux RDD. Comme la transformation union(), intersection() est également une opération d’ensemble entre deux RDD, mais implique un shuffle. Les exemples suivants montrent comment trouver des éléments communs entre deux RDD à l’aide d’intersection() :

#Python

firstRDD = spark.sparkContext.parallelize(range(1,6))

secordRDD = spark.sparkContext.parallelize(range(5,11))

firstRDD.intersection(secordRDD).collect()

Le code suivant effectue la même opération dans Scala :

//Scala

val firstRDD = spark.sparkContext.parallelize(1 to 5)

val secordRDD = spark.sparkContext.parallelize(5 to 10)

firstRDD.intersection(secordRDD).collect()

Le code précédent donne un résultat de 5.

substract ( )

Vous pouvez utiliser la transformation subtract() pour supprimer le contenu d’un RDD à l’aide d’un autre RDD. Créons deux RDD : le premier a des nombres de 1 à 10 et le second a des éléments de 6 à 10. Si nous utilisons subtract() , nous obtenons un nouveau RDD avec les nombres 1 à 5 :

#Python

firstRDD = spark.sparkContext.parallelize(range(1,11))

secordRDD = spark.sparkContext.parallelize(range(6,11))

firstRDD.subtract(secordRDD).collect()

Le code suivant effectue la même opération dans Scala:

//scala

val firstRDD = spark.sparkContext.parallelize(1 to 10)

val secordRDD = spark.sparkContext.parallelize(6 to 10)

firstRDD.subtract(secordRDD).collect()

Dans l’exemple précédent, nous avons deux RDD: firstRDD contient des éléments de 1 à 10 et secondRDD contient des éléments 6 à 10 . Après avoir appliqué la transformation subtract() , nous obtenons un nouveau RDD contenant des éléments de 1 à 5 .

cartesian()

La transformation cartesian() peut joindre des éléments d’un RDD à tous les éléments d’un autre RDD et donne le produit cartésien de deux. Dans les exemples suivants, firstRDD a des éléments [0,1,2] et secondRDD a des éléments [‘A’,’B’,’C’] . Nous utilisons cartesian() pour obtenir le produit cartésien de deux RDD :

#Python

firstRDD = spark.sparkContext.parallelize(range(3))

secordRDD = spark.sparkContext.parallelize([‘A’,’B’,’C’])

firstRDD.cartesian(secordRDD).collect()

Le code suivant effectue la même opération dans Scala :

//scala

val firstRDD = spark.sparkContext.parallelize(0 to 2)

val secordRDD = spark.sparkContext.parallelize(Array(“A”,”B”,”C”))

firstRDD.cartesian(secordRDD).collect()

Voici la sortie de l’exemple précédent :

//Scala

Array[(Int, String)] = Array((0,A), (0,B), (0,C), (1,A), (1,B), (1,C), (2,A), (2,B), (2,C))

N’oubliez pas que ces opérations impliquent un shuffle et nécessitent donc de nombreuses ressources informatiques telles que la mémoire, le disque et la bande passante du réseau.

Remarque

textFile() et wholeTextFiles() sont également considérés comme des transformations, car ils créent un nouveau RDD à partir de données externes.

Action

Vous auriez remarqué que dans chaque exemple que nous avons utilisé, la méthode collect() pour obtenir la sortie. Pour obtenir le résultat final pour le pilote, Spark fournit un autre type d’opération appelé actions. Au moment des transformations, Spark enchaîne ces opérations et construit un DAG, mais rien n’est exécuté. Une fois qu’une action est effectuée sur un RDD, elle force l’évaluation de toutes les transformations nécessaires pour calculer ce RDD.

Les actions ne créent pas de nouveau RDD. Ils sont utilisés pour :

- Retour des résultats finaux au pilote

- Écriture du résultat final sur un stockage externe

- Exécution d’une opération sur chaque élément de ce RDD (par exemple, foreach())

Discutons de certaines des actions de base.

collect ( )

L’action collect() renvoie tous les éléments d’un RDD au programme pilote. Vous ne devez utiliser collect() que si vous êtes sûr de la taille de votre sortie finale. Si la taille de la sortie finale est énorme, votre programme de pilote peut se bloquer lors de la réception des données des exécuteurs. L’utilisation de collect() n’est pas conseillée en production. L’exemple suivant collecte tous les éléments d’un RDD contenant des nombres de 0 à 9 :

#Python

spark.sparkContext.parallelize(range(10)).collect()

Out[26]: [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

count ( )

Utilisez count() pour compter le nombre d’éléments dans le RDD. Le code Scala suivant compte le nombre d’un RDD et renvoie 10 en sortie :

//scala

spark.sparkContext.parallelize(1 to 10).count()

res17: Long = 10

take ( )

L’action take() renvoie N nombre d’éléments d’un RDD. Le code suivant renvoie les deux premiers éléments d’un RDD contenant les nombres 0 à 9 :

#Python

spark.sparkContext.parallelize(range(10)).take(2)

Out[27]: [0, 1]

top ( )

L’action top() renvoie les N éléments supérieurs du RDD. Le code suivant renvoie les 2 premiers éléments d’un RDD :

#Python

spark.sparkContext.parallelize(range(10)).top(2)

Out[28]: [9, 8]

takeOrdered ( )

Si vous souhaitez obtenir l’élément N sur la base d’un ordre, vous pouvez utiliser une action takeOrdered(). Vous pouvez également utiliser la transformation sortBy(), suivie d’une action take(). Les deux approches déclenchent un remaniement des données. Dans l’exemple suivant, nous retirons 3 éléments du RDD, contenant des nombres de 0 à 9, en fournissant nos propres critères de tri :

#Python

spark.sparkContext.parallelize(range(10)).takeOrdered(3, key = lambda x: -x)

Out[3]: [9, 8, 7]

Ici, nous avons pris les 3 premiers éléments par ordre décroissant.

first ( )

L’action first() renvoie le premier élément du RDD. L’exemple suivant retourne le premier élément du RDD :

#Python

spark.sparkContext.parallelize(range(10)).first()

Out[4]: 0

countByValue ( )

L’action countByValue() peut être utilisée pour trouver l’occurrence de chaque élément dans le RDD. Voici le code Scala qui renvoie une Map de paire clé-valeur. Dans la sortie, Map , la clé est l’élément RDD et la valeur est le nombre d’occurrences de cet élément dans le RDD:

//Scala

spark.sparkContext.parallelize(Array(“A”,”A”,”B”,”C”)).countByValue()

res0: scala.collection.Map[String,Long] = Map(A -> 2, B -> 1, C -> 1)

reduce ( )

L’action reduce() combine les éléments RDD en parallèle et donne des résultats agrégés en sortie. Dans l’exemple suivant, nous calculons la somme des 10 premiers nombres naturels :

//Scala

spark.sparkContext.parallelize(1 to 10).reduce( _ + _ )

res1: Int = 55

saveAsTextFile ( )

Pour enregistrer les résultats dans un magasin de données externe, nous pouvons utiliser saveAsTextFile() pour enregistrer votre résultat dans un répertoire. Vous pouvez également spécifier un codec de compression pour stocker vos données sous forme compressée. Écrivons notre numéro RDD dans un fichier :

#Python

spark.sparkContext.parallelize(range(10)).saveAsTextFile(‘/FileStore/tables/result’)

Dans l’exemple précédent, nous fournissons un répertoire comme argument et Spark écrit des données dans ce répertoire dans plusieurs fichiers, avec le fichier de réussite ( _success ).

Remarque

Si un répertoire existant est fourni comme argument à l’action saveAsTextFile(), le travail échouera avec l’ exception FileAlreadyExistsException. Ce comportement est important car nous pourrions réécrire accidentellement un répertoire contenant les données d’un travail lourd.

foreach()

La fonction foreach() applique une fonction à chaque élément du RDD. L’exemple suivant concatène la chaîne Mr. à chaque élément à l’aide de foreach() :

//Scala

spark.sparkContext.parallelize(Array(“Smith”,”John”,”Brown”,”Dave”)).foreach{ x => println(“Mr. “+x) }

Si vous exécutez l’exemple précédent en mode local, vous verrez la sortie. Mais, dans le cas du mode cluster, vous ne pourrez pas voir les résultats, car foreach() exécute la fonction donnée à l’intérieur des exécuteurs et ne renvoie aucune donnée au pilote.

Ceci est principalement utilisé pour travailler avec des accumulateurs. Nous verrons cela plus en détail dans le chapitre 5, Flux d’exécution d’architecture et d’application Spark.

Vous pouvez trouver plus de transformations et d’actions sur https://spark.apache.org/docs/2.3.0/rdd-programming-guide.html#transformations.

Types de RDD

Les RDD peuvent être classés en plusieurs catégories. Voici quelques exemples :

| Hadoop RDD | Shuffled RDD | PairRDD |

| Mapped RDD | Union RDD | JSON RDD |

| Filtered RDD | Double RDD | Vertex RDD |

Nous ne les aborderons pas tous dans ce chapitre, car ils sortent du cadre de ce chapitre. Mais nous allons discuter de l’un des types importants de RDD: pair RDDs.

Pairs RDD

Un Pair RDD est un type spécial de RDD qui traite les données sous forme de paires clé-valeur. Pair RDD est très utile car il permet des fonctionnalités de base telles que join et les aggregations. Spark fournit certaines opérations spéciales sur ces RDD de manière optimisée. Si nous rappelons les exemples où nous avons calculé le nombre de messages INFO et ERROR dans sampleFile.log à l’aide de ReduceByKey(), nous pouvons clairement voir l’importance de la paire RDD.

L’une des façons de créer une paire RDD consiste à paralléliser une collection qui contient des éléments sous la forme de Tuple. Regardons quelques-unes des transformations fournies par une paire RDD.

groupByKey ( )

Les éléments ayant la même clé peuvent être regroupés à l’aide d’une transformation groupByKey(). L’exemple suivant regroupe les données de chaque clé :

#Python

pairRDD = spark.sparkContext.parallelize([(1, 5),(1, 10),(2, 4),(3, 1),(2, 6)])

result = pairRDD.groupByKey().collect()

for pair in result:

print ‘key -‘,pair[0],’, value -‘, list(pair[1])

Output:

key – 1 , value – [5, 10]

key – 2 , value – [4, 6]

key – 3 , value – [1]

Le code suivant effectue la même opération dans Scala :

//Scala

val pairRDD = spark.sparkContext.parallelize(Array((1, 5),(1, 10),(2, 4),(3, 1),(2, 6)))

val result = pairRDD.groupByKey().collect()

result.foreach {

pair => println(“key – “+pair._1+”, value -“+pair._2.toList)

}

Output:

key – 1, value -List(5, 10)

key – 2, value -List(4, 6)

key – 3, value -List(1)

La transformation groupByKey() est une transformation large qui mélange les données entre les exécuteurs en fonction de la clé. Un point important ici est de noter que groupByKey ( ) n’agrège pas les données, il regroupe seulement les groupes en fonction de la clé. La transformation groupByKey() doit être utilisée avec prudence. Si vous comprenez très bien vos données, alors groupByKey() peut apporter certains avantages dans certains scénarios. Par exemple, supposons que vous ayez des données de valeur-clé, où la clé est le code du pays et la valeur est le montant de la transaction, et vos données sont fortement asymétriques en raison du fait que plus de 90% de vos clients sont basés aux États-Unis. Dans ce cas, si vous utilisez groupByKey() pour regrouper vos données, vous risquez de rencontrer des problèmes car Spark mélangera toutes les données et tentera d’envoyer des enregistrements avec les États-Unis à une seule machine. Cela pourrait entraîner un échec. Il existe certaines techniques telles que les salted keys pour éviter de tels scénarios.

Malgré cet inconvénient, groupByKey peut être très utile dans certains scénarios. Si vous savez que vos données ne sont pas asymétriques et que vous souhaitez calculer plusieurs agrégations telles que max, min et average utilisant les mêmes données sous-jacentes, vous pouvez d’abord grouper les éléments à l’aide de groupByKey() et les conserver.

reduceByKey()

Une transformation ReduceByKey() est disponible sur Pair RDD. Il permet l’agrégation de données en minimisant le brassage de données et effectue des opérations sur chaque clé en parallèle. Une transformation ReduceByKey() effectue d’abord l’agrégation locale au sein de l’exécuteur, puis mélange les données agrégées entre chaque nœud. Dans l’exemple suivant, nous calculons la somme de chaque clé à l’aide de ReduceByKey :

#Python

pairRDD = spark.sparkContext.parallelize([(1, 5),(1, 10),(2, 4),(3, 1),(2, 6)])

pairRDD.reduceByKey(lambda x,y : x+y).collect()

Output:

[(1, 15), (2, 10), (3, 1)]

Le code suivant effectue la même opération dans Scala :

//Scala

val pairRDD = spark.sparkContext.parallelize(Array((1, 5),(1, 10),(2, 4),(3, 1),(2, 6)))

pairRDD.reduceByKey(_+_).collect()

Output:

Array[(Int, Int)] = Array((1,15), (2,10), (3,1))

Remarque

Une transformation ReduceByKey() ne peut être utilisée que pour les agrégations associatives, par exemple: (A + B) + C = A + (B + C).

sortByKey()

Le sortByKey() peut être utilisé pour trier la paire RDD en fonction des clés. Dans l’exemple suivant, nous créons d’abord un RDD en parallélisant une liste de tuples, puis nous le trions par le premier élément du tuple :

#Python

pairRDD = spark.sparkContext.parallelize([(1, 5),(1, 10),(2, 4),(3, 1),(2, 6)])

pairRDD.sortByKey().collect()

Output:

[(1, 5), (1, 10), (2, 4), (2, 6), (3, 1)]

Par défaut, sortByKey() trie les éléments dans l’ordre croissant, mais vous pouvez modifier l’ordre de tri en passant votre commande personnalisée. Par exemple, sortByKey ( keyfunc = lambda k: -k) triera le RDD dans l’ordre décroissant.

join()

La transformation join() joindra deux paires de RDD en fonction de leurs clés. L’exemple suivant joint les données en fonction du pays et renvoie uniquement les enregistrements correspondants :

//Scala

val salesRDD = spark.sparkContext.parallelize(Array((“US”,20),(“IND”, 30),(“UK”,10)))

val revenueRDD = spark.sparkContext.parallelize(Array((“US”,200),(“IND”, 300)))

salesRDD.join(revenueRDD).collect()

Output:

Array[(String, (Int, Int))] = Array((US,(20,200)), (IND,(30,300)))

Il y a quelques autres transformations disponibles sur la paire RDD tels que aggregateByKey ( ) , cogroup () , leftOuterJoin () , rightOuterJoin () , subtractByKey () , et plus encore. Certaines des actions spéciales incluent countByKey ( ) , collectAsMap () et lookup () .

Mise en cache et point de contrôle

La mise en cache et les points de contrôle sont quelques-unes des fonctionnalités importantes de Spark. Ces opérations peuvent améliorer considérablement les performances de vos travaux Spark.

Mise en cache

La mise en cache des données dans la mémoire est l’une des principales fonctionnalités de Spark. Vous pouvez mettre en cache de grands ensembles de données en mémoire ou sur disque en fonction du matériel de votre cluster. Vous pouvez choisir de mettre vos données en cache dans deux scénarios :

- Utilisez plusieurs fois le même RDD

- Évitez la réoccupation d’un RDD qui implique des calculs lourds, tels que join() et groupByKey()

Si vous souhaitez exécuter plusieurs actions d’un RDD, ce sera une bonne idée de le mettre en cache dans la mémoire afin d’éviter la recompilation de ce RDD. Par exemple, le code suivant extrait d’abord quelques éléments du RDD, puis renvoie le nombre d’éléments :

//Scala

val baseRDD = spark.sparkContext.parallelize(1 to 10)

baseRDD.take(2)

baseRDD.count()

Le code suivant utilise cache ( ) pour rendre l’application efficace:

//Scala

val baseRDD = spark.sparkContext.parallelize(1 to 10)

baseRDD.cache() //Caching baseRDD

baseRDD.take(2)

baseRDD.count()

Spark calculera deux fois baseRDD pour effectuer les actions take() et count() . Nous mettons en cache notre baseRDD puis exécutons les actions. Cela ne calcule le RDD qu’une seule fois et exécute l’action au-dessus des données mises en cache. Dans cet exemple, il pourrait ne pas y avoir beaucoup de différence dans les performances, car ici nous avons affaire à de très petits ensembles de données. Mais vous pouvez imaginer le goulot d’étranglement dans le cas des mégadonnées.

Spark ne met pas les données en cache immédiatement dès que nous écrivons l’opération cache(). Mais il prend note de cette opération, et une fois qu’il rencontre la première action, il calculera le RDD et le mettra en cache en fonction du niveau de mise en cache.

Le tableau suivant répertorie plusieurs niveaux de persistance des données fournis par Spark :

| Niveau | Définition |

| MEMORY_ONLY | Stocke les données en mémoire en tant qu’objets Java non sérialisés |

| MEMORY_ONLY_SER | Stocke les données en mémoire mais en tant qu’objets Java sérialisés |

| MEMORY_AND_DISK | Objets Java non sérialisés en mémoire et données sérialisées restantes sur le disque |

| MEMORY_AND_DISK_SER | Objets Java sérialisés en mémoire plus les données sérialisées restantes sur le disque |

| DISK_ONLY | Stocke les données sur le disque |

| OFF_HEAP | Stocke les RDD hors série en série dans Techyon (stockage en mémoire de Spark) |

Remarque

Vous pouvez répliquer les données mises en cache sur deux nœuds en écrivant _2 à la fin du niveau persistant.

Un point important à noter ici est que dans le cas du niveau de mise en cache MEMORY_ONLY , si certaines données ne rentrent pas dans la mémoire, les données restantes ne sont pas stockées par défaut dans le disque. Les partitions restantes sont recalculées au moment de l’exécution. Le cache n’est pas une transformation ni une action.

Remarque

Il est recommandé d’annuler la résistance de vos RDD mis en cache une fois que vous avez terminé avec ce RDD. Vous pouvez appeler unpersist() , qui supprime les données de la mémoire.

Checkpointing

Le cycle de vie du RDD mis en cache prendra fin à la fin de la session Spark. Si vous avez calculé un RDD et que vous souhaitez l’utiliser dans un autre programme Spark sans le recalculer, vous pouvez utiliser l’opération checkpoint(). Cela permet de stocker le contenu RDD sur le disque, qui peut être utilisé pour les opérations ultérieures. Discutons-en à l’aide d’un exemple :

#Python

baseRDD = spark.sparkContext.parallelize([‘A’,’B’,’C’])

spark.sparkContext.setCheckpointDir(“/FileStore/tables/checkpointing”)

baseRDD.checkpoint()

Nous créons d’abord un baseRDD et définissons un répertoire de point de contrôle à l’aide de la méthode setCheckpointDir(). Enfin, nous stockons le contenu de baseRDD en utilisant checkpoint().

Comprendre les partitions

Le partitionnement des données joue un rôle très important dans l’informatique distribuée, car il définit le degré de parallélisme des applications. Comprendre et définir les partitions de la bonne manière peut améliorer considérablement les performances des travaux Spark. Il existe deux façons de contrôler le degré de parallélisme des opérations RDD :

- repartition() et fusion()

- partitionBy()

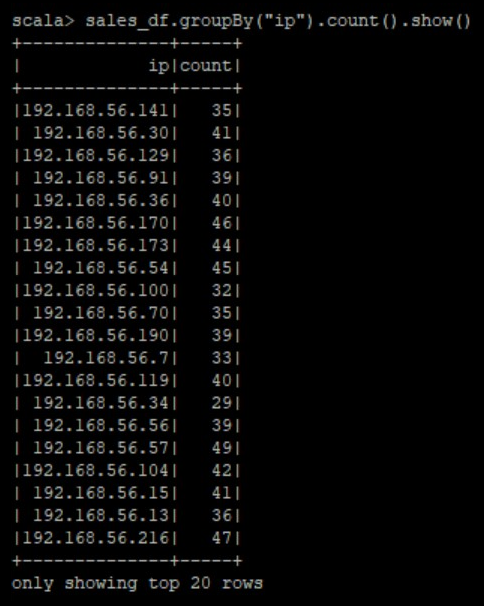

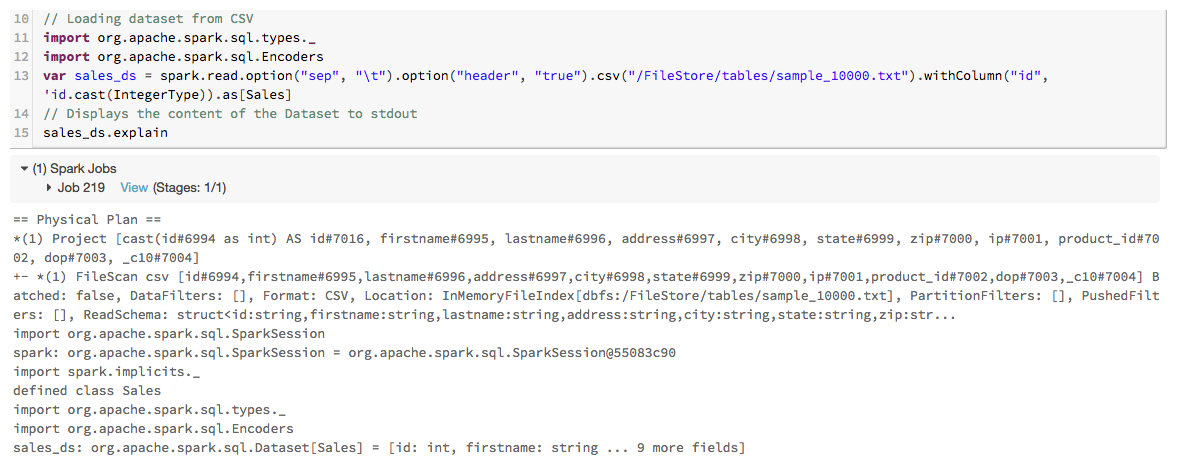

repartition ( ) VS coalesce ()