0. Développer avec la plateforme Cloud Foundry

0.1 Résumé de la publication

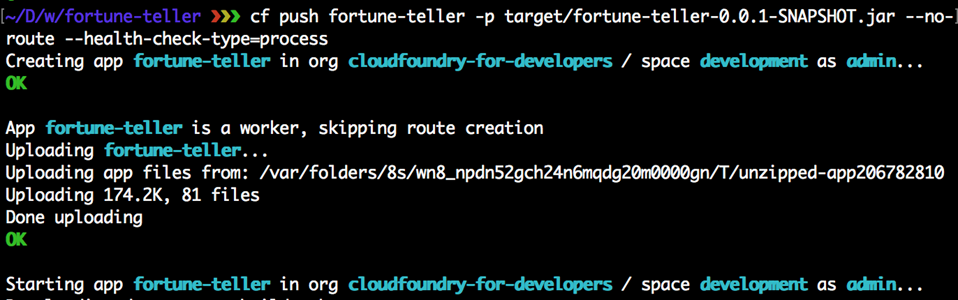

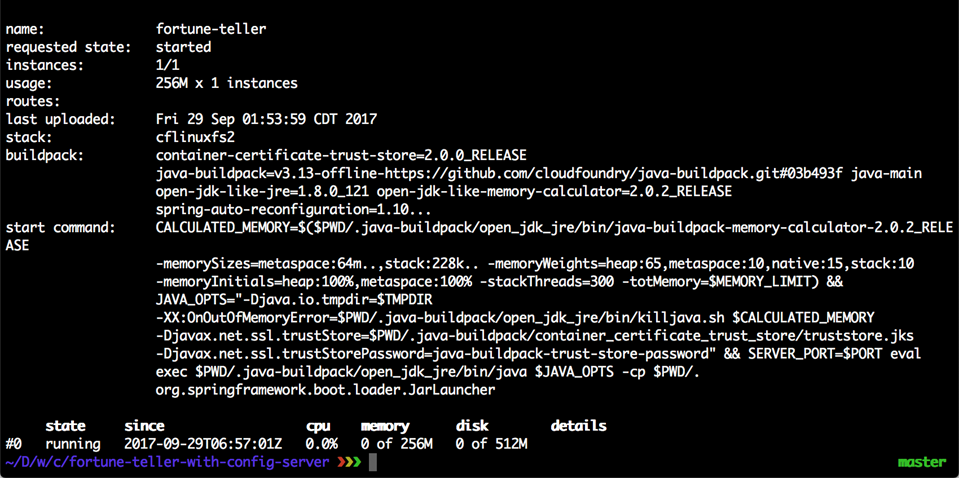

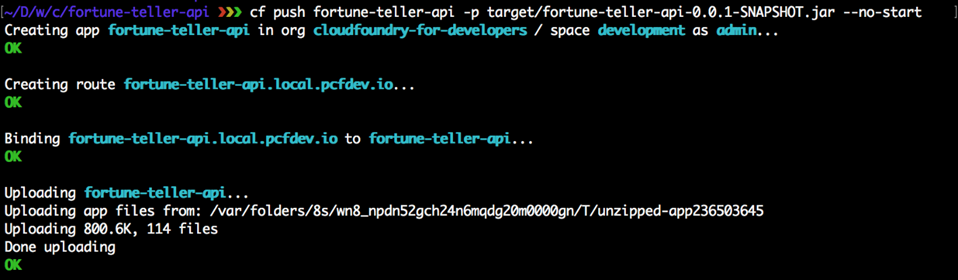

Cloud Foundry est la plateforme open source pour déployer, exécuter et faire évoluer des applications. Cloud Foundry se développe rapidement et est un produit leader qui fournit des capacités PaaS (Platform as a Service) aux entreprises, aux gouvernements et aux organisations du monde entier. Des géants comme Dell Technologies, GE, IBM, HP et le gouvernement américain utilisent Cloud Foundry pour innover plus rapidement dans un monde en évolution rapide.

Cloud Foundry est le rêve d’un développeur. Leur permettre de créer des applications modernes qui peuvent tirer parti des dernières réflexions, techniques et capacités du cloud, notamment :

- DevOps

- Virtualisation des applications

- Agnosticisme des infrastructures

- Conteneurs orchestrés

- Automatisation

- Aucune mise à niveau de temps d’arrêt

- Déploiement A / B

- Faire évoluer ou déployer rapidement les applications

Cet article emmène les lecteurs dans un voyage où ils apprendront d’abord les bases de Cloud Foundry, y compris comment déployer et faire évoluer une application simple en quelques secondes. Les lecteurs approfondiront leurs connaissances sur la façon de créer des applications et des microservices natifs du cloud hautement évolutifs et résilients exécutés sur Cloud Foundry. Les lecteurs apprendront à intégrer leur application aux services fournis par Cloud Foundry et à ceux externes à Cloud Foundry. Les lecteurs apprendront à structurer leur environnement Cloud Foundry avec des organisations et des espaces. Après cela, nous discuterons des aspects de l’intégration continue / livraison continue (CI / CD), de la surveillance et de la journalisation. Les lecteurs apprendront également comment activer les contrôles d’intégrité, dépanner et déboguer les applications.

À la fin de cet article, les lecteurs auront une expérience pratique de l’exécution de diverses tâches de déploiement et de mise à l’échelle. De plus, ils auront une compréhension de ce qu’il faut pour migrer et développer des applications pour Cloud Foundry.

0.2 Objectifs de la publication

- Comprendre les outils et les concepts de Cloud Foundry (CF).

- Comprenez l’étendue des possibilités offertes grâce à une approche agile légère pour la création et le déploiement d’applications.

- Concevez et déployez des applications natives cloud qui fonctionnent bien sur Cloud Foundry.

- Apprenez les concepts de conception de microservices et les applications de travail.

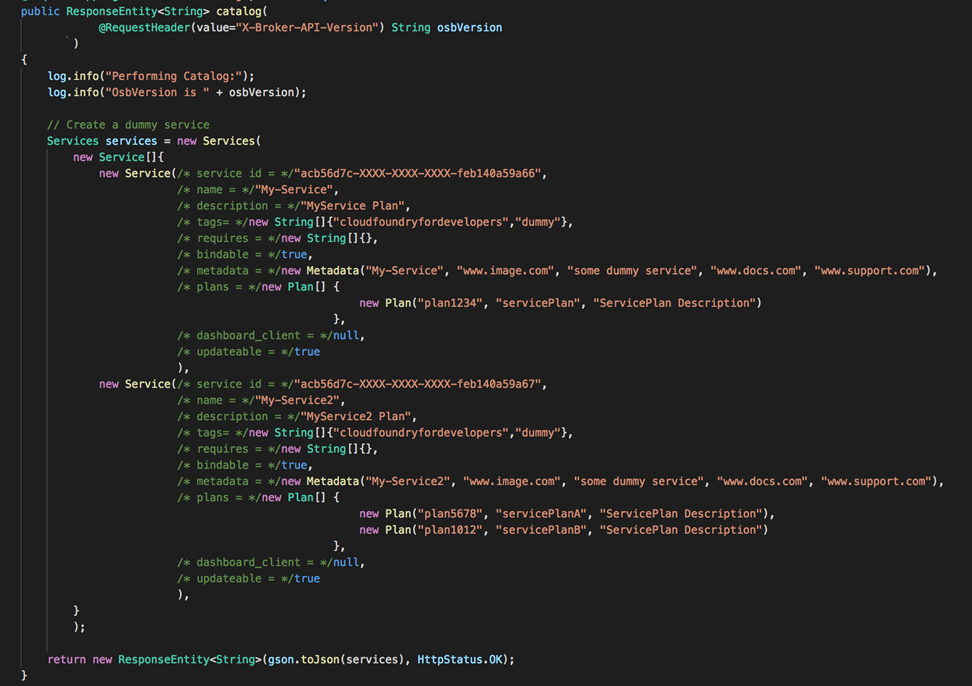

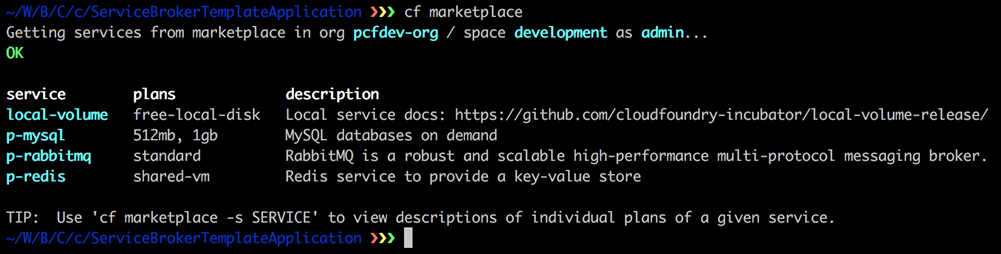

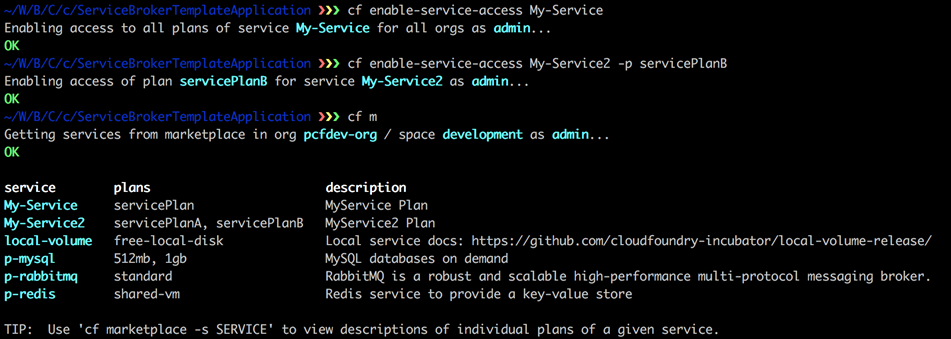

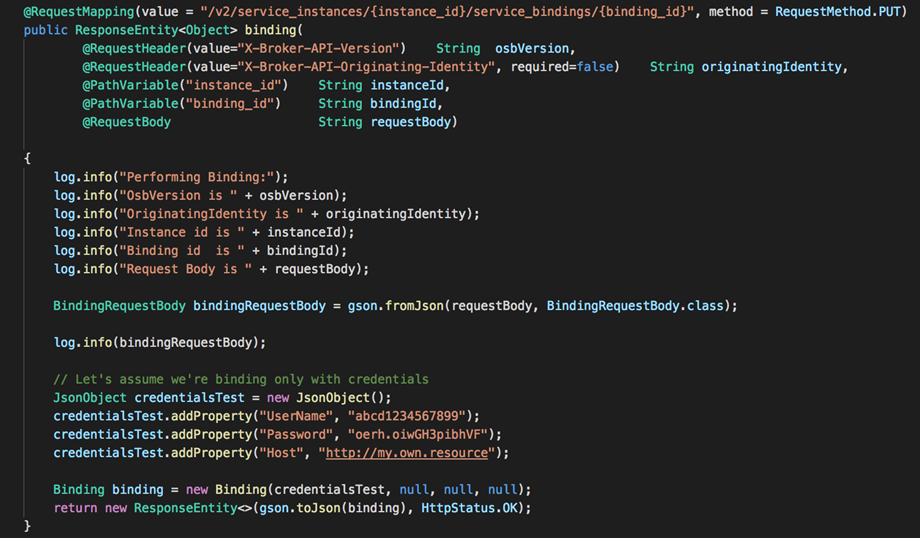

- Personnalisez les courtiers de services pour publier vos services sur le marché Cloud Foundry.

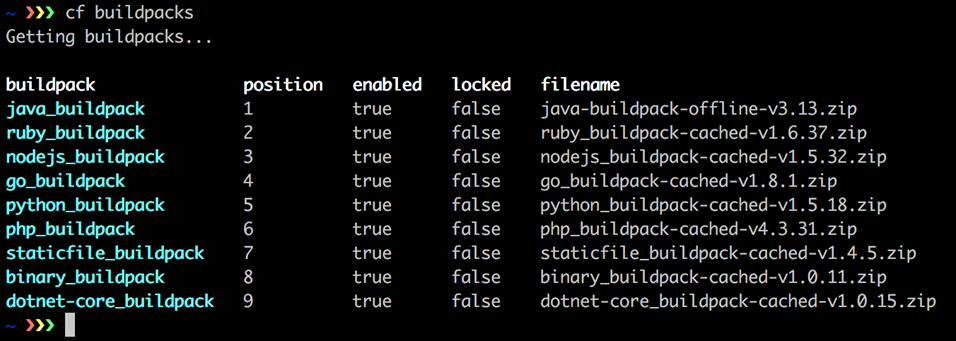

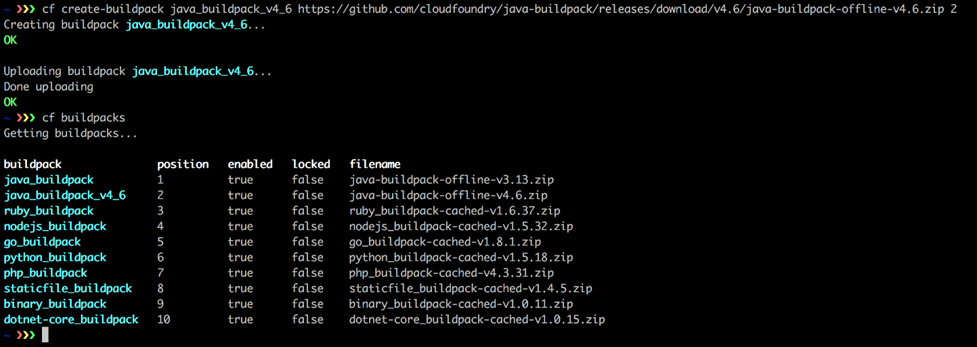

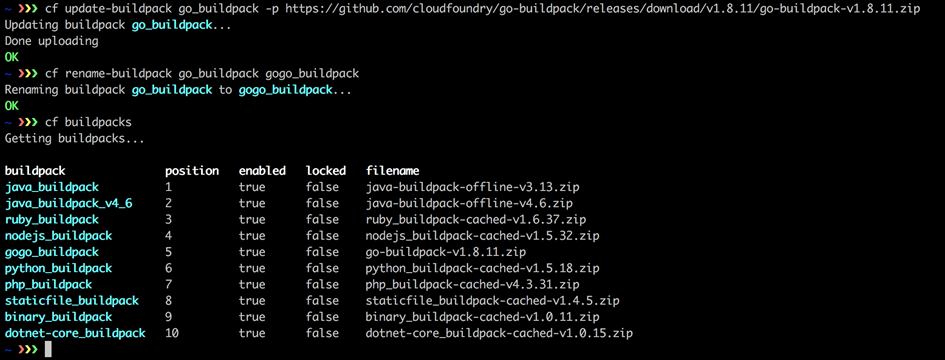

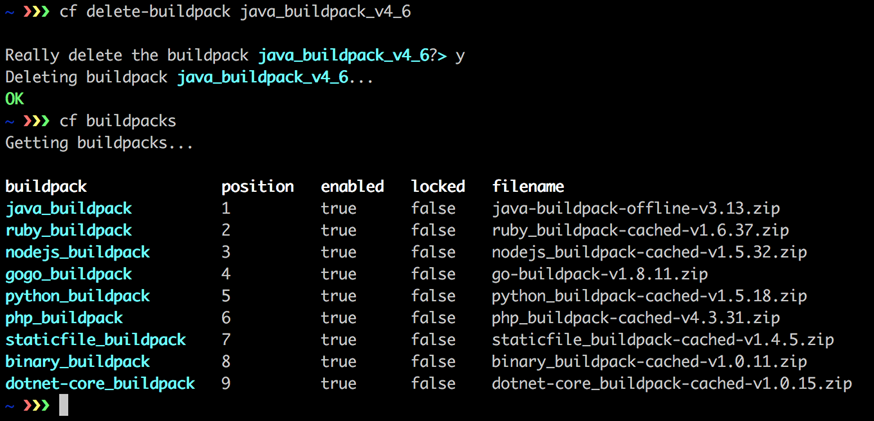

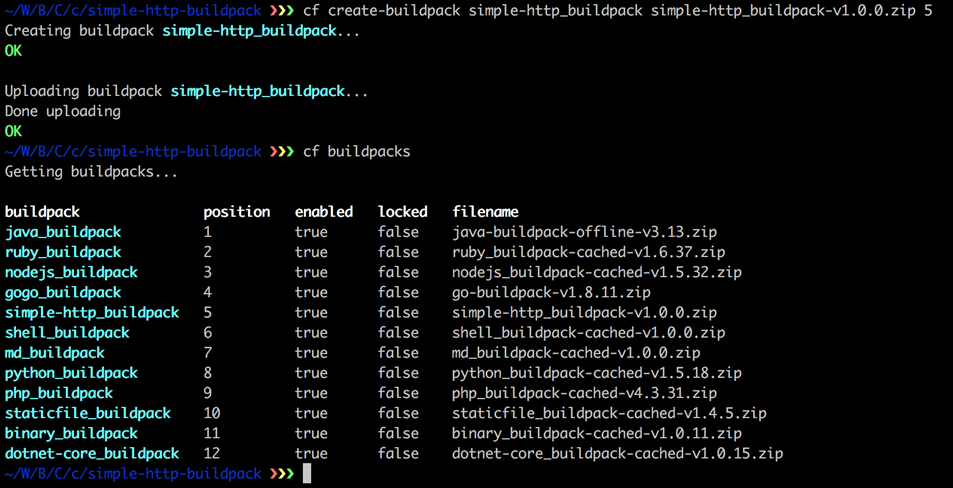

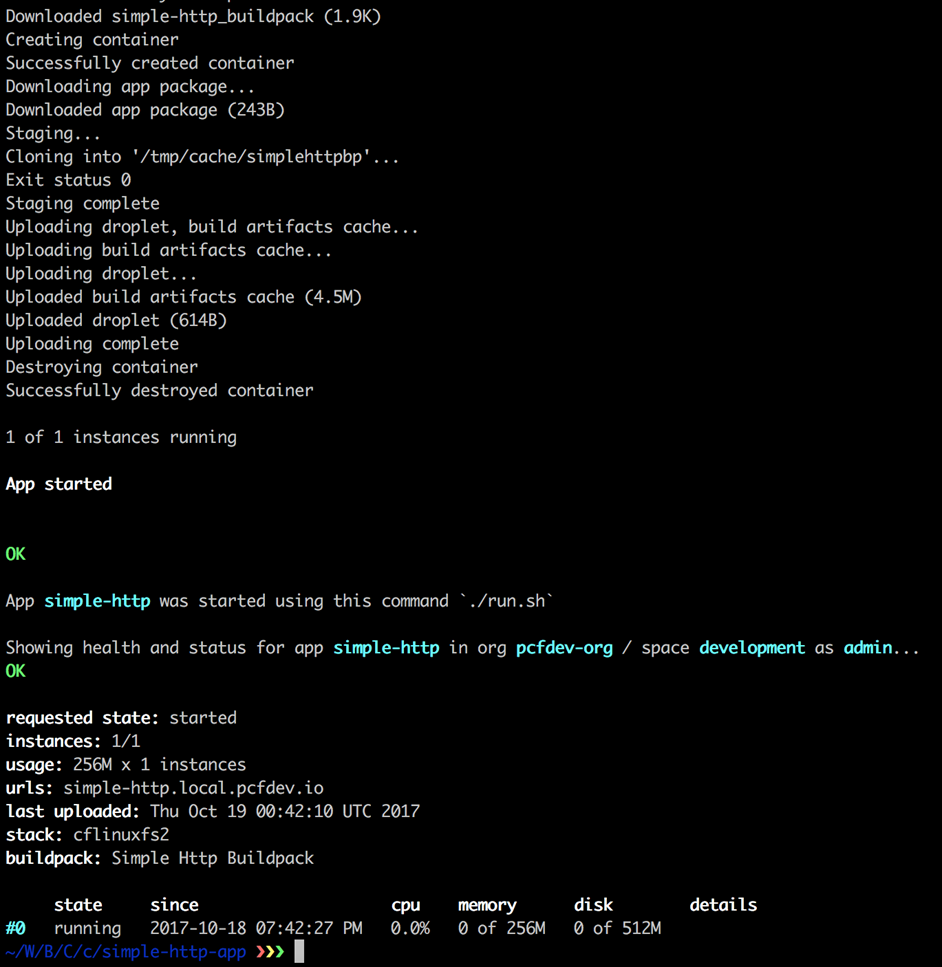

- Utilisation, gestion et création de buildpacks pour la plateforme Cloud Foundry.

- Dépanner les applications sur Cloud Foundry

- Effectuez des déploiements sans temps d’arrêt à l’aide de routes bleues / vertes, de tests A / B et de restaurations indolores vers les versions antérieures de l’application.

1 Chapitre 1. Présentation de Cloud Foundry

Dans ce chapitre, nous présentons Cloud Foundry en fournissant des informations sur le produit lui-même et certains concepts connexes qui peuvent être utiles à ceux qui ne le connaissent pas. Nous approfondissons ensuite les détails de l’utilisation de Cloud Foundry du point de vue des développeurs d’applications dans les chapitres suivants.

Dans ce chapitre, nous couvrirons les sujets suivants :

- Pourquoi Cloud Foundry ?

- Qu’est-ce que le PaaS ?

- Qu’est-ce que Cloud Foundry ?

- Qu’est-ce que Pivotal Cloud Foundry ?

1.1 Pourquoi Cloud Foundry ?

cf push

C’est ça. C’est la réponse essentielle à la question Pourquoi Cloud Foundry?, Anti-climatique, non? Du moins, jusqu’à ce que vous compreniez le saut révolutionnaire qu’a entraîné le développement d’applications.

Sans cf push , le cycle de développement d’application typique est compliqué et complexe car, souvent, une grande partie de l’activité de développement est consommée en trouvant un endroit où votre application peut vivre et servir le monde en toute sécurité, fiabilité et robustesse. Trois problèmes ont entravé le développement:

- Il est difficile de fournir des applications qui sont précieuses pour vous, votre organisation et / ou le monde si vous n’êtes pas en mesure de vous concentrer sur la création de l’application elle-même. Dans certaines grandes organisations, les développeurs ont déclaré que 80% de nos efforts sont en train de préparer l’infrastructure. Imaginez un jour où vous n’avez qu’à créer votre application, pas à assembler un middleware; installer les temps d’exécution des applications; ou jouer avec un système d’exploitation (OS), une machine virtuelle (VM), des serveurs, un stockage ou un réseau.

- Les développeurs d’applications ne sont pas des administrateurs système ou des opérateurs système, et ils ne devraient pas non plus être obligés de l’être. Si vous demandez aux opérateurs de développer du code que l’on attend d’un développeur d’applications, la plupart déclineront probablement. Il y a des limites de leur point de vue. Les deux disciplines relèvent de l’informatique, oui. Les deux sont des rôles extrêmement techniques, nécessitant une expertise approfondie pour être sûr. Les deux font le gros du travail nécessaire pour finalement mettre une application d’une certaine valeur à la disposition d’un public qui en a besoin. Cependant, le fossé entre Dev et Ops est large et profond. Il existe des spécialisations, des préoccupations et des risques fondamentaux qui entraînent un comportement dans les deux rôles, ce qui crée une ligne de fracture évidente et tout à fait naturelle à suivre lors de la division de la charge de travail liée au démarrage et à l’exécution des applications en production. Bien sûr, les deux doivent travailler ensemble, partager et apprendre des techniques qui sont interfonctionnelles et pertinentes pour être plus efficaces et agiles dans leurs rôles respectifs, telles que l’intégration continue et le déploiement continu (CI / CD). En fin de compte, les développeurs d’applications prospèrent s’ils se concentrent sur le développement d’applications et la résolution de problèmes dans cet espace très difficile, sans se soucier d’être un ingénieur ou un opérateur de plate-forme fantôme.

- Il est difficile de créer un environnement de production cohérent, fiable, sécurisé et hautement disponible. Bien plus encore en regroupant les capacités de calcul, de stockage et de réseau dans un système cohérent qui répond aux exigences des entreprises modernes et aux attentes des consommateurs d’applications. Tout en offrant la rigueur et la flexibilité qui permettent aux développeurs de se concentrer sur le développement d’applications en toute simplicité. VMware a révolutionné le monde de l’informatique avec la virtualisation des serveurs en 1998. Ils ont fait abstraction des limites du matériel physique en pools de serveurs virtuels. Cela nous a permis de mieux utiliser le matériel sous-jacent en répartissant et en adaptant des charges de travail importantes et complexes sur les boîtiers physiques.

Ce sont les problèmes que Cloud Foundry a dû résoudre : mettre fin à la bataille éternelle de la concentration du développeur sur les applications par rapport à l’exploitation et à l’ingénierie de la plate-forme sur laquelle ces applications sont exécutées.

Cloud Foundry y parvient en proposant une virtualisation des applications de niveau entreprise. Pour ce faire, il exploite et orchestre une symphonie de conteneurs dans un système distribué élastiquement évolutif comprenant tous les composants dont une application donnée a besoin pour servir le monde. Cela change le jeu de la même manière que VMware l’a fait avec les machines virtuelles et la virtualisation des serveurs. Cloud Foundry est une plate-forme de virtualisation d’applications éprouvée qui redonne le contrôle au développeur, permettant aux développeurs de se concentrer sur le développement d’applications, plutôt que sur les opérations d’infrastructure.

Remarque

cf push était à l’origine vmc push, qui signifiait VMware Cloud. Cloud Foundry a été conçu chez VMware en 2009 et est né en tant que projet open source en 2011. Le code original pour VMC peut être trouvé sur https://github.com/cloudfoundry-attic/vmc .

1.2 Qu’est-ce que le PaaS ?

Platform as a Service (Paas) est l’un des nombreux termes de la taxonomie du cloud computing, notamment Infrastructure as a Service (Iaas) et Software as a Service (Saas).

Alors que, en général, IaaS est axé sur le serveur et SaaS est axé sur l’utilisateur, PaaS est axé sur les développeurs. PaaS améliore la productivité des développeurs en activant la virtualisation des applications, il y a donc une réduction significative de la nécessité pour les développeurs d’effectuer le levage de charges indifférencié associé à la plomberie, ce qui nuit au travail réel sur le code d’application et les préoccupations. Souvent, cela s’appelle le rasage de yak. Par exemple, cela peut inclure tout, de l’installation des durées d’exécution des applications, des dépendances, de l’empaquetage des applications, de la mise en attente et du déploiement, à la configuration plus en profondeur de la pile dans des problèmes d’infrastructure tels que la configuration des équilibreurs de charge, la mise en réseau, la sécurité, le provisionnement des machines virtuelles – presque tout ce qui vous intéresse hors construction d’une excellente application.

Remarque

Selon Jeremy H. Brown au MIT vers l’an 2000, le rasage de yak est ce que vous faites lorsque vous effectuez une petite tâche stupide et délicate qui n’a aucun lien évident avec ce sur quoi vous êtes censé travailler, mais pourtant une chaîne de douze relations causales relie ce que vous faites à la méta-tâche d’origine. Le terme a été inventé par Carlin Vieri . L’e-mail d’origine sur le sujet peut être trouvé à http://projects.csail.mit.edu/gsb/old-archive/gsb-archive/gsb2000-02-11.html.

Le logo de l’application à douze facteurs sur https://12factor.net © 2017 Salesforce.com. Tous les droits sont réservés.

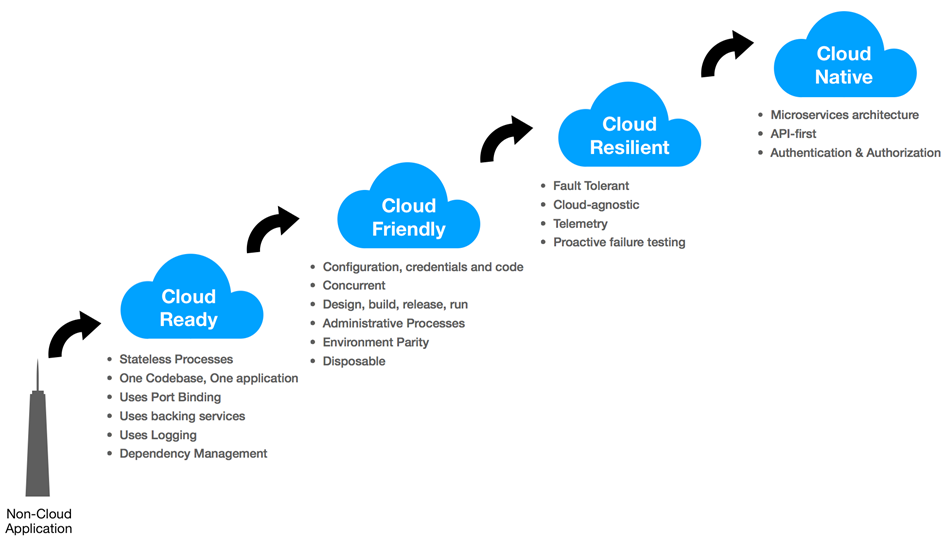

Heroku (https://www.heroku.com) est le nom de l’un des pionniers originaux de PaaS. Disponible depuis 2007, Heroku est une plate-forme cloud qui permet aux développeurs de pousser des applications dans un service hébergé sur Internet. L’idée était de concentrer les développeurs sur la création d’applications et non sur l’infrastructure. En utilisant les connaissances acquises par l’équipe Heroku grâce à l’exploitation d’une grande plate-forme avec diverses applications en cours d’exécution, Adam Wiggins et son équipe ont constitué la base de ce que l’on appelle désormais des applications natives du cloud via leur application à douze facteurs d’origine (https://12factor.net ) motifs. Ils étaient motivés pour sensibiliser à certains problèmes systémiques rencontrés dans le développement d’applications modernes, pour fournir un vocabulaire partagé pour discuter de ces problèmes et pour proposer un ensemble de solutions conceptuelles générales à ces problèmes avec la terminologie qui l’accompagne. Nous discuterons des applications natives du cloud et des développements ultérieurs depuis l’écriture de la méthodologie originale de l’application à douze facteurs dans les prochains chapitres. De plus, le modèle de buildpack de Heroku est utilisé pour Cloud Foundry et sera également discuté un peu plus loin dans l’article.

1.2.1 La définition de Cloud Foundry de PaaS

À l’ère du cloud, la plateforme d’application est livrée en tant que service, souvent appelé PaaS. PaaS facilite le déploiement, l’exécution et la mise à l’échelle des applications. Certaines offres PaaS ont une prise en charge limitée du langage et du cadre, ne fournissent pas de services d’application clés ou ne limitent pas le déploiement à un seul cloud. Cloud Foundry est le PaaS ouvert de l’industrie et propose un choix de clouds, de frameworks et de services d’application.

1.3 Qui sont Pivotal et la Cloud Foundry Foundation?

En avril 2013, Dell EMC et VMware ont formé une nouvelle société appelée Pivotal. Chaque société mère a apporté à cette nouvelle entité des personnes, des logiciels, des produits et des garanties qui n’étaient pas au cœur de ses propres activités. Cela comprenait 11 sociétés qui avaient été acquises par les sociétés mères à un moment ou à un autre. Peu de temps après, avec de nouveaux investissements de sociétés supplémentaires, telles que General Electric, Ford et Microsoft, la mission de Pivotal s’est fortement concentrée sur la transformation de la façon dont le monde fabrique des logiciels.

Cloud Foundry, ainsi que plusieurs autres projets notables comme Spring Framework pour Java (https://spring.io) et RabbitMQ (http://www.rabbitmq.com) pour le courtage de messages, ont été inclus dans l’histoire d’origine Pivotal.

Le logo Pivotal. © 2017 Pivotal Software, Inc. Tous droits réservés.

Peu de temps après sa création, Pivotal, en collaboration avec d’autres chefs d’entreprise, a cherché à créer la Cloud Foundry Foundation pour assurer la gestion continue de la communauté Cloud Foundry et de ses logiciels open source. La fondation a été créée en tant qu’organisme à but non lucratif indépendant sous la Fondation Linux. Depuis sa création en janvier 2015, plus de 70 entreprises (https://www.cloudfoundry.org/members/) ont rejoint la Cloud Foundry Foundation et poursuivent leur mission de sensibilisation et d’adoption mondiale du projet open source Cloud Foundry, pour développer une communauté dynamique de contributeurs et créer une cohérence dans la stratégie et l’action dans toutes les entreprises membres pour le projet.

La Fondation Cloud Foundry existe pour :

- Établir et maintenir Cloud Foundry en tant que technologie open source PaaS standard de l’industrie avec un écosystème florissant

- Offrir une qualité, une valeur et une innovation continues aux utilisateurs, aux opérateurs et aux fournisseurs de technologie Cloud Foundry

- Fournissez une expérience dynamique et agile aux contributeurs de la communauté qui fournit des applications et des logiciels natifs du cloud de la plus haute qualité, à grande vitesse et à l’échelle mondiale.

Remarque

Vous pouvez trouver plus de détails sur la Cloud Foundry Foundation et sa mission sur https://www.cloudfoundry.org/foundation .

1.4 Qu’est-ce que Cloud Foundry?

Cloud Foundry est une plate-forme pour développer et exécuter des applications natives du cloud. Il s’agit d’une plate-forme polyglotte qui vous permet de déployer une myriade d’applications écrites dans de nombreux langages informatiques différents – Java, Python, Node.js, Ruby, Go, langages .NET, et bien d’autres. Utilisez simplement le meilleur langage pour la tâche à accomplir avec la liberté de savoir que Cloud Foundry le prend en charge.

Le logo Cloud Foundry. © 2017 Cloud Foundry, Inc. Tous droits réservés.

Cloud Foundry est agnostique IaaS et open source. Il résume l’IaaS sous-jacent, que vous exécutiez sur VMware vSphere, Amazon Web Services (AWS), Google Cloud Platform (GCP), Microsoft Azure, OpenStack ou autres. Cela signifie qu’une véritable portabilité des applications est possible quels que soient les choix d’infrastructure et permet une stratégie multicloud cohérente – publique, privée ou hybride.

Le développement d’applications Cloud Foundry nécessite que les ingénieurs logiciels comprennent comment créer et déployer des applications prêtes pour le cloud. Cependant, il y a un petit secret: vos applications n’ont pas besoin d’être entièrement natives dans le cloud, les applications à douze facteurs pour fonctionner sur Cloud Foundry. Souvent, les applications existantes fonctionneront très bien sur Cloud Foundry avec quelques modifications mineures – si vous connaissez des recettes simples!

Remarque

Le moyen le plus simple de voir si une application a besoin de quelques modifications pour s’exécuter sur Cloud Foundry est simplement de cf pousser l’application. Voir les éventuelles erreurs pouvant survenir. Ensuite , faire les corrections nécessaires, puis cf pousser à nouveau. Répétez ce processus jusqu’à ce que l’application s’exécute dans Cloud Foundry. Il est souvent surprenant de constater le peu d’efforts nécessaires pour faire fonctionner une application sur Cloud Foundry. Et, dans de nombreux cas, ce sont les personnalisations spécifiques au middleware du code de l’application qui sont destinées à intégrer ou à lancer l’application sur un serveur d’application donné comme WebLogic ou WebSphere où certains points de friction se trouvent couramment dans la pratique – plus encore que le code fonctionnel de l’application réelle.

Cloud Foundry fournit une plate-forme hautement disponible, évolutive et sécurisée pour déployer votre application. Et avec la mise à l’échelle automatique, votre application peut évoluer pour s’adapter aux pics de trafic, puis évoluer une fois le trafic diminué – automatiquement !

Voici un guide de Cloud Foundry en un coup d’œil :

- Sortie initiale en 2011

- Une plate-forme ouverte native du cloud (PaaS)

- Construire, tester, déployer et faire évoluer des applications rapidement et facilement

- Fonctionne avec n’importe quel langage ou cadre

- Disponible en open source, en distribution commerciale ou en offres hébergées

- Open source avec une licence Apache, hébergé sur GitHub

- Les développeurs utilisent l’ utilitaire de ligne de commande cf pour interagir avec un déploiement CF

- L’ interface de ligne de commande cf (interpréteur de ligne de commande) est préconfigurée pour Windows, Mac et Linux

- Le cf prend en charge n’importe quel langage ou framework via des buildpacks

En tant que développeur, Cloud Foundry effectue les opérations suivantes:

- Vous permet de vous concentrer sur la création d’applications

- Vous fait sortir du jeu de provisionnement de VM

- Vous permet de recréer en continu l’environnement d’exécution d’une application

- Déploie et fait évoluer une application en quelques secondes

- Externalise et injecte des dépendances spécifiques à l’environnement

- Possède une API qui améliore la productivité de la gestion des versions

- Utilise des conteneurs pour isoler les applications et créer la virtualisation d’applications

- Gère le cycle de vie complet de votre application

Le code du projet Cloud Foundry se trouve à l’adresse suivante:

- https://github.com/cloudfoundry/

- https://github.com/cloudfoundry-incubator/

1.4.1 Architecture de Cloud Foundry

L’architecture Cloud Foundry résume de nombreuses complexités du développement d’applications au quotidien pour fournir un environnement riche et robuste pour le déploiement. Cloud Foundry gère de nombreuses demandes opérationnelles et infrastructurelles dans les coulisses de manière unifiée et cohérente afin que les opérateurs et les ingénieurs de Cloud Foundry puissent gérer et entretenir la plate-forme sans temps d’arrêt dans la plupart des cas, permettant ainsi des mises à niveau sans interruption et des correctifs à la plate-forme sans que les développeurs ne remarquent quoi que ce soit en baisse. La mise à l’échelle de Cloud Foundry en ajoutant plus d’infrastructure est intégrée à la plate-forme pour permettre la croissance au fil du temps à mesure que la demande augmente.

La plateforme Cloud Foundry est composée d’un ensemble de services distribués évolutifs horizontalement. Il comprend des outils qui automatisent et orchestrent l’infrastructure sous-jacente, fournissant une couche d’abstraction sur les plates-formes IaaS.

Cloud Foundry est très robuste. Il utilise ce qui peut être nominalement appelé IA faible en raison de sa focalisation étroite sur le maintien d’une boucle de rétroaction d’auto-guérison sous le capot via son ingénierie de libération et ses outils de gestion, appelés BOSH. Par exemple, lorsqu’une machine virtuelle dans Cloud Foundry se comporte mal, elle est mise hors service et remplacée rapidement. Cela permet la détection et la récupération des pannes à tous les niveaux : application, conteneur, machine virtuelle ou l’ensemble de la Cloud Foundry Foundation lorsqu’ils sont configurés pour la haute disponibilité (HA).

Du point de vue d’un ingénieur de plate-forme, l’aspect le plus inhabituel de Cloud Foundry est qu’il est indépendant de l’infrastructure, ce qui signifie qu’un opérateur peut exécuter Cloud Foundry sur une variété d’IaaS telles que VMware vSphere, Amazon Web Services, Google Cloud Platform, Microsoft Azure, OpenStack, serveurs bare-metal et autres. C’est aussi révolutionnaire que le concept de l’écriture unique, exécutez n’importe où le rêve de portabilité des applications que les développeurs d’applications recherchaient avec le slogan créé par Sun Microsystems pour illustrer les avantages multiplateformes du langage Java. Cloud Foundry le fait en utilisant une abstraction, appelée Cloud Provider Interface (CPI), qui traduit un ensemble commun de commandes de construction d’infrastructure en une traduction spécifique à l’IaaS à l’aide d’un projet open source appelé Fog (http://fog.io). Le brouillard permet à Cloud Foundry d’éviter le blocage des fournisseurs, ce qui vous contraint à un seul IaaS. Fait intéressant, de nombreux fournisseurs IaaS ajoutent directement la prise en charge de Fog, comme la plate-forme Google Compute. Ce faisant, Cloud Foundry bénéficie de ce riche héritage qui lui permettra de s’exécuter sur une liste sans cesse croissante de fournisseurs de cloud à mesure qu’ils deviennent disponibles et pris en charge.

Remarque

AI faible versus IA forte : l’IA faible est une intelligence artificielle non sensible qui se concentre sur une tâche étroite, tandis que l’IA forte est une machine capable d’appliquer l’intelligence à n’importe quel problème, plutôt qu’à un seul problème spécifique. La plupart des systèmes actuellement existants considérés sous l’égide de l’intelligence artificielle sont tout au plus une IA faible.

Les capacités et les aspects opérationnels de Cloud Foundry sont vraiment remarquables, sinon révolutionnaires, du point de vue de l’ingénieur système et de l’ingénierie de la plate-forme.

Remarque

BOSH est l’un des composants les plus intéressants de l’écosystème Cloud Foundry. Bien qu’il appartienne fermement au domaine de l’ingénieur de plate-forme, car il automatise et dirige le déploiement des composants Cloud Foundry eux-mêmes, il est utilisé pour déployer et maintenir une fondation Cloud Foundry (installation). BOSH est une chaîne d’outils open source pour l’ingénierie des versions, le déploiement et la gestion du cycle de vie des systèmes distribués à grande échelle. Si vous êtes intéressé à regarder le côté opérationnel de Cloud Foundry, vous pouvez en savoir plus sur BOSH à https://bosh.io et trouver le code open source pour celui-ci à https://github.com/cloudfoundry/bosh.

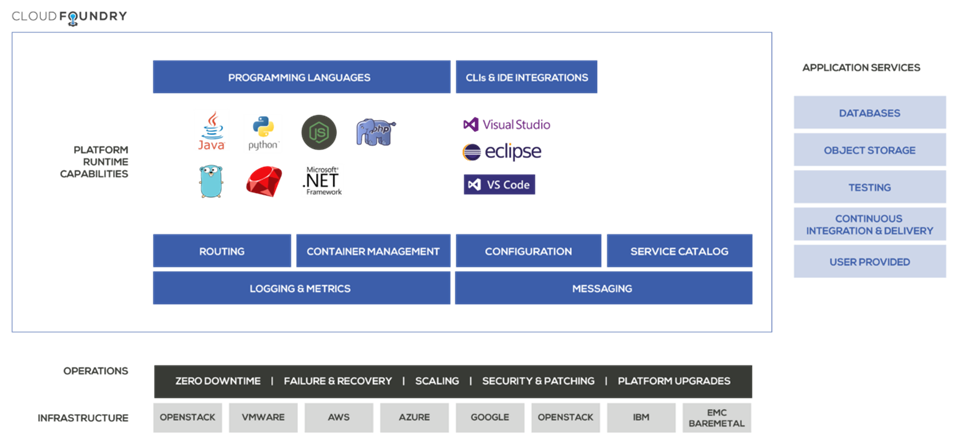

La plateforme Cloud Foundry fournit des éléments clés tels que le routage, la gestion des conteneurs, la journalisation et les métriques, ainsi que la configuration des applications, le catalogue de services et la messagerie intégrés.

Cloud Foundry est une plateforme polyglotte, en ce que vous êtes libre d’utiliser n’importe quel langage de programmation de votre choix pour développer votre application pour le déploiement. Il prend en charge Java, .NET Core, Python, Ruby, Go, Node.js et PHP et peut en prendre davantage en ajoutant une variété de buildpacks qui contiennent tout le nécessaire pour l’exécution des applications dans des langages supplémentaires. La plupart des buildpacks sont open source et gérés par la communauté. Ils peuvent être trouvés sur https://github.com/cloudfoundry-community/cf-docs-contrib/wiki/Buildpacks#community-created.

Un aperçu simplifié de l’écosystème Cloud Foundry:

Une vue d’ensemble de l’écosystème Cloud Foundry. Plus de détails peuvent être trouvés sur https://cloudfoundry.org/ © 2017 Cloud Foundry, Inc. Tous droits réservés.

De plus, il existe des intégrations CLI (Command Line Interpreter) et IDE (Integrated Development Environment) pour les outils de développement populaires tels qu’Eclipse, Visual Studio, IntelliJ IDEA et VS Code, entre autres.

Qu’en est-il de la connexion de votre application à des services tels que des bases de données, des courtiers de messages, des magasins d’objets, etc. ? La plupart des applications dépendent de ces types d’externalités. Cloud Foundry répond à cette nécessité avec élégance, offrant bien sûr plusieurs façons de répondre à ces capacités. Nous en discuterons en détail dans les prochains chapitres.

Un aperçu simplifié de l’architecture de la plateforme Cloud Foundry:

Un aperçu conceptuel de l’architecture de la plateforme Cloud Foundry. Plus de détails peuvent être trouvés sur https://cloudfoundry.org/application-runtime/ © 2017 Cloud Foundry, Inc. Tous droits réservés.

La figure précédente montre la pile d’infrastructure et de BOSH que les ingénieurs de la plateforme Cloud Foundry utilisent pour installer, gérer et entretenir Cloud Foundry. Il y a le Cloud Foundry Application Runtime ™ (précédemment connu sous le nom d’Elastic Runtime) à l’intérieur du contour de la grande boîte qui comprend les différents composants. Du point de vue du développeur, il s’agit de Cloud Foundry. Mais du point de vue holistique des systèmes, ce n’est qu’une partie, quoique très, très importante. Le CF Application Runtime est exactement comme son nom l’indique :

L’environnement d’exécution d’application évolutif et élastique qui rassemble le recueil de composants nécessaires pour s’étendre sur les ressources d’infrastructure sous-jacentes afin de créer et gérer des pools de calcul, de mémoire, de banque de données, de blobstore et de réseaux pour prendre en charge la vue centrée sur l’application du monde que nous appelons application virtualisation. Cela comprend tous les systèmes d’orchestration, de mise en réseau, de conteneurisation, de gestion et de contrôle que vous pourriez imaginer nécessaires pour rassembler un ballet aussi complexe de technologie dynamique.

Principalement, ceux-ci entrent dans les catégories suivantes :

- Acheminement

- Authentification

- Gestion du cycle de vie des applications

- Exécution d’application

- Services de plateforme

- Messagerie, mesures et journalisation

- Tous ces éléments sont unifiés derrière l’API Cloud Controller, qui permet une intégration RESTful avec CF Application Runtime via la Cloud Foundry CLI (alias la cf CLI) et d’autres interfaces utilisateur commerciales (UI) telles que l’interface utilisateur Web Pivotal Cloud Foundry Application Manager basée sur le Web

Nous les détaillerons plus en détail dans les prochains chapitres. De plus amples informations sont disponibles sur https://www.cloudfoundry.org/platform/.

1.4.2 Sécurité de Cloud Foundry

Cloud Foundry permet une réévaluation à l’avenir, sur le cloud, des fondamentaux et hypothèses de sécurité de longue date en raison de la façon dont son composant BOSH fonctionne en arrière-plan. C’est une période passionnante pour repenser et recadrer la sécurité de manière proactive, ce qui n’était pas imaginable il y a encore quelques années sans les boucles d’automatisation et de rétroaction que nous offre BOSH. BOSH détruit constamment les machines virtuelles qui ne sont plus en bon état ou ne fonctionnent pas comme prévu, et les recrée à la volée. BOSH élimine toujours un fléau que toute infrastructure qui n’est pas entièrement automatisée rencontrera éventuellement : la dérive de la configuration.

BOSH fonctionne toujours sur une boucle de rétroaction, validant l’état de l’infrastructure du monde réel avec la configuration attendue. En cas de dérive, BOSH élimine cette mauvaise pomme et la remplace rapidement par une qui répond aux spécifications exactes de la configuration. Il s’agit d’un processus appelé repavage. Le repavage garantit en permanence que nous avons une infrastructure sous-jacente en douceur qui répond aux besoins de notre Cloud Foundry Foundation et de nos applications. BOSH le fait en toute transparence dans les coulisses sans aucun temps d’arrêt pour votre application (à condition que vous ayez au moins deux instances d’application en cours d’exécution).

Remarque

La dérive de la configuration se produit naturellement dans les environnements de datacenter lorsque les modifications apportées au logiciel et au matériel sont apportées de manière ponctuelle et ne sont pas enregistrées ou suivies de manière complète et systématique. Souvent, les gens, aussi variés que les opérateurs ou les développeurs, se connectent directement à un serveur ou à une machine virtuelle et apportent des modifications qui feront fonctionner quelque chose avec la configuration réglée d’un serveur, mais ne fonctionneront pas ailleurs si ce changement n’est pas présent. Souvent, cet endroit est un environnement de production et le problème n’est découvert que lorsque quelque chose a mal tourné. La dérive de configuration est analogue à l’excuse insidieusement formulée de Cela fonctionne sur ma machine. Cela afflige les développeurs qui ont des variations fondamentales et non prises en compte dans leurs configurations système qui permettent à une application de s’exécuter uniquement sur leur machine. Nous entendrions probablement moins cette phrase si nous amenions immédiatement cette machine particulière dans le centre de données et la faisions fonctionner en production chaque fois qu’elle était entendue.

Pour cette raison, une nouvelle façon de penser la posture de sécurité est devenue courante avec l’avènement des trois R de la sécurité : réparer, repaver et faire pivoter.

Ces principes ont été formulés pour la première fois par Justin Smith, un leader d’opinion chez Pivotal, dans une présentation intitulée Cloud Native Security : Repair, Repave, Rotate en 2016, qui peut être trouvée à https://www.infoq.com/presentations/cloud- sécurité native.

Justin définit la sécurité d’entreprise native du cloud comme :

- Réparation : réparez les logiciels vulnérables dès que les mises à jour sont disponibles.

- Repave : repave les serveurs et les applications d’un bon état connu. Faites-le souvent.

- Rotation : faites souvent pivoter les informations d’identification de l’utilisateur afin qu’elles ne soient utiles que pendant de courtes périodes. Minimiser le vecteur d’attaque du temps.

Cloud Foundry gère déjà certains d’entre eux pour vous. Et, il s’améliore rapidement car les trois R sont devenus un élément clé pour la communauté Cloud Foundry pour faire avancer l’histoire de la posture de sécurité basée sur le cloud.

1.4.3 Conteneurs Cloud Foundry

Tout comme Cloud Foundry change la façon de penser à une posture de sécurité proactive, moderne, agile et adaptable qui répare, repavage et tourne en permanence aux niveaux opérationnels des composants Cloud Foundry, il en va de même pour la réflexion sur l’approvisionnement, la mise à l’échelle et la gestion de la capacité a été modifiée pour refléter la manière dynamique et adaptable dont Cloud Foundry permet aux conteneurs de fonctionner.

Dans le passé, au moins dans la plupart des entreprises, si vous vouliez une infrastructure, vous auriez probablement besoin de vous frayer un chemin à travers les cercles de l’enfer de l’approvisionnement. Souvent, le processus ressemble à ceci :

- Demandez un serveur ou une machine virtuelle à approvisionner ou à acheter.

- Attendez que ce serveur ou cette machine virtuelle ait été provisionné.

- En attendant, vous devez vous mettre au travail pour créer l’application. Alors non plus,

- Trouvez une boîte que vous pouvez exécuter temporairement sous votre bureau en tant que bac à sable de votre application.

- Ou, sortez la carte de crédit et fournissez un calcul à partir d’un fournisseur de cloud public comme un trou d’arrêt.

- Ou, tirez parti d’une version de l’informatique fantôme vers laquelle votre organisation ferme les yeux tandis que le processus informatique normal exécute le gant officiel

- Obtenez le serveur en rack dans le centre de données ou la machine virtuelle lancée.

- Obtenez l’accès et les informations d’identification à ssh et connectez-vous à la boîte.

- Découvrez les problèmes de configuration.

- Demander la résolution des problèmes par l’équipe des opérations.

- Une fois que tout est en ordre, installez et configurez votre environnement d’exécution d’application et votre middleware.

- Enfin, après une semaine, des mois ou des années, déployez votre application pour livrer la valeur commerciale ou de mission promise.

- Découvrez que vous êtes sous-provisionné pour gérer la demande – puis recommencez rapidement le processus pour obtenir plus de capacité et calculez pour maintenir l’application en ligne et disponible à mesure qu’elle grandit.

- Apprenez votre leçon et commandez toujours bien plus de capacité que vous ne pensez en avoir besoin, juste au cas où, car cela prend trop de temps pour mettre plus en ligne une fois que vous êtes en production.

La dernière étape est très courante dans les grandes organisations avec beaucoup de processus et de paperasserie. Et, souvent en raison de la protection des ressources limitées des serveurs montés dans le centre de données et des watts gorgés par ces serveurs supplémentaires, les organisations se retrouvent largement surapprovisionnées, ce qui signifie qu’elles ont plus de capacité à prendre en pieds carrés dans le centre de données qu’elles ne le font avoir besoin. Dans certaines organisations où cela a été mesuré, le surapprovisionnement peut être bien supérieur à 40%. C’est-à-dire que plus de 40% des serveurs en rack peuvent être non rackés et mis hors ligne sans aucun effet sur la capacité de l’organisation à fournir une bonne maison à partir de laquelle les applications peuvent servir leurs utilisateurs.

Ce serait une situation entièrement évitable si ce n’était de la montée difficile et du temps requis par les développeurs et les opérateurs pour passer à travers le processus et les formalités administratives. La psychologie qui prend le relais est celle d’avoir des animaux de compagnie à longue durée de vie. En raison de l’effort considérable requis pour obtenir ces serveurs ou machines virtuelles, les développeurs dans cette situation demandent toujours plus qu’ils ne pensent pouvoir répondre à leurs besoins immédiats. Ils deviennent attachés et même si certains de ces serveurs n’ont encore rien sur eux, ils les défendent et les protègent contre la récupération, et à juste titre.

Dans les grandes organisations, la partie la plus difficile du développement d’applications est la mise en production. Il n’est pas surprenant dans les organisations de grande envergure d’attendre un mois entier, en passant pas à pas les barrages routiers, jusqu’à ce que l’infrastructure de production soit provisionnée et dispose d’une tonalité pour enfin déployer votre application dans le monde. Cloud Foundry raccourcit cela du côté de l’infrastructure, mais il y a souvent encore des améliorations bien nécessaires sur la bureaucratie du processus.

Une partie de la solution consiste à se débarrasser des serveurs en tant que vision du monde des animaux de compagnie qui alimente ce comportement. Les conteneurs sont une bonne réponse à ce défi. En effet, ils peuvent être traités comme des objets jetables qui peuvent être reproduits très rapidement pour permettre à nos applications de se développer automatiquement lorsque la demande est élevée, puis de les adapter une fois que la demande se dissipe, ce qui permet de toujours dimensionner correctement notre capacité de calcul et la consommation d’énergie à ce dont nous avons réellement besoin à l’époque, et, éliminant la peur et les maux de tête que l’on doit toujours parcourir à travers le fourré de jungles de billets pour obtenir plus de capacité lorsque nous en avons besoin.

1.4.3.1 Que sont les conteneurs ?

Les conteneurs sont omniprésents dans la discussion sur le cloud. Une bonne définition vient d’Amazon Web Services (AWS):

Les conteneurs sont une méthode de virtualisation du système d’exploitation qui vous permet d’exécuter une application et ses dépendances dans des processus isolés de ressources. Les conteneurs vous permettent de regrouper facilement le code, les configurations et les dépendances d’une application dans des blocs de construction faciles à utiliser qui assurent la cohérence environnementale, l’efficacité opérationnelle, la productivité des développeurs et le contrôle des versions. Les conteneurs peuvent aider à garantir un déploiement rapide, fiable et cohérent des applications, quel que soit l’environnement de déploiement.

Source : AWS, Que sont les conteneurs ? (Https://aws.amazon.com/containers/)

Les conteneurs sont excellents, mais orchestrer et gérer les correctifs de sécurité et les mises à niveau en continu sans temps d’arrêt est un problème très difficile dans la plupart des scénarios, laissant nos applications ouvertes aux vulnérabilités et nous exposant à des risques que nous ne voulons pas prendre.

Cloud Foundry améliore le fonctionnement des conteneurs en les orchestrant automatiquement. Il fait toutes les choses difficiles dont les conteneurs ont besoin pour les garder à jour, corrigés, heureux et sains – et tout cela sans aucun temps d’arrêt. Il existe peu d’autres PaaS basés sur des conteneurs qui peuvent bien faire cela dans une entreprise ou un environnement critique à l’heure actuelle.

Les conteneurs Cloud Foundry sont basés sur des normes. La spécification provient de l’Open Container Initiative (OCI) (https://www.opencontainers.org). L’OCI est un consortium d’organisations hautement visibles telles que Docker, Dell Technologies, Microsoft, IBM, Google, Red Hat, etc. qui servent de gardien de la flamme de la bibliothèque runC que Cloud Foundry utilise comme bibliothèque d’exécution principale du conteneur pour Noeuds basés sur Linux. L’engagement envers cette norme d’interopérabilité des conteneurs par une grande variété d’acteurs permet à Cloud Foundry de faire des choses intéressantes pour tirer parti de la norme et étendre les capacités de la plateforme. Par exemple, Cloud Foundry peut exécuter des images Docker à partir de référentiels Docker, tels que Docker Hub. Pour plus d’informations, voir https://github.com/opencontainers/runc.

Cela permet à Cloud Foundry d’exécuter tout sur les applications Linux et Windows (tout noyau .NET et la plupart des classiques .NET), de charger et d’exécuter des images Docker précuites avec des configurations et des exécutions d’applications spécifiques.

1.5 Qu’est-ce que Pivotal Cloud Foundry?

Pivotal Cloud Foundry ™ ou Pivotal CF ™, communément appelé PCF, est actuellement la principale entreprise PaaS alimentée par Cloud Foundry. De nombreuses entreprises qui composent le Fortune 1000 utilisent Pivotal Cloud Foundry en interne dans le cadre de leur offre de portefeuille cloud. À l’aide de cette distribution Cloud Foundry particulière, ils créent leurs propres applications natives du cloud et migrent les applications existantes afin qu’ils puissent tirer parti de nombreux avantages du passage à un PaaS. C’est en raison de cette pénétration profonde de l’entreprise et de la probabilité plus élevée de rencontrer Pivotal Cloud Foundry dans les limites des entreprises, du gouvernement et des organisations que nous discuterons de certaines des capacités supplémentaires fournies par Pivotal Cloud Foundry au-dessus de la version open source de Cloud Foundry.

Pivotal Cloud Foundry offre une expérience clé en main toujours disponible pour la mise à l’échelle et la mise à jour de PaaS sur des infrastructures multicloud publiques, privées ou hybrides telles que VMware vSphere, Amazon Web Services, Google Cloud Platform, Microsoft Azure et OpenStack.

En tant que distribution commerciale de Cloud Foundry, il fournit plusieurs fonctionnalités supplémentaires importantes et un engagement à prendre en charge le produit auquel les organisations sont habituées par les fournisseurs. Par exemple, Pivotal Cloud Foundry fournit des outils supplémentaires pour simplifier l’installation et l’administration non inclus dans le produit logiciel open source.

Par exemple, si vous souhaitez installer une distribution Cloud Foundry sur votre propre infrastructure, vous devez effectuer les opérations suivantes à un niveau élevé:

- Configurez toutes les dépendances externes, telles qu’un compte IaaS, des équilibreurs de charge externes, des enregistrements DNS et tout composant supplémentaire.

- Créez un manifeste pour déployer un directeur BOSH.

- Déployez le directeur BOSH.

- Créez un manifeste pour déployer Cloud Foundry.

- Déployez Cloud Foundry.

Source : Déploiement de Cloud Foundry sur http://docs.cloudfoundry.org/deploying/index.html

Il s’agit initialement d’un processus manuel qui nécessite une grande expertise BOSH et en ingénierie de plate-forme, bien que tout ingénieur de plate-forme digne de ce nom commence généralement à automatiser une bonne partie de ce processus. Cependant, il peut être très difficile d’obtenir la configuration distribuée d’un grand système composé d’une variété de machines virtuelles multiples, de composants réseau, de calcul, d’accès IaaS, de stockage, de DNS, de certificats SSL, et bien plus encore correctement décrits dans le fichier manifeste que vous doit définir, que BOSH utilise ensuite pour construire la fondation Cloud Foundry. Même pour atteindre la ligne de départ, il faut créer un manifeste pour déployer un directeur BOSH, ce qui peut être difficile si vous n’êtes pas familier avec le fonctionnement interne de BOSH ; un sujet intéressant certes, mais aussi profond et complexe avec une courbe d’apprentissage et un engagement abrupts.

En s’appuyant sur les bases fournies par la version open source de Cloud Foundry (https://github.com/cloudfoundry/cf-release), comme on pourrait s’y attendre, Pivotal Cloud Foundry ajoute de nombreuses fonctionnalités au sommet de la version open source qui ont été pilotées et façonné par les besoins des entreprises, du gouvernement et des organisations pour simplifier l’administration et les opérations quotidiennes de Cloud Foundry.

Sans fournir les détails les plus fins des différences entre les distributions open source et pivot de Cloud Foundry, il y a quelques différences qui méritent d’être soulignées.

Comme mentionné précédemment, une bonne expertise en BOSH est une condition préalable à l’installation de la version open source de Cloud Foundry. Pivotal Cloud Foundry fournit une interface utilisateur Web simplifiée pour l’installation et la gestion de l’installation de Cloud Foundry et de divers composants, tels que CF Application Runtime, et d’autres services tels que RabbitMQ, Redis, MySQL, etc., sous forme de tuiles de service simplifiées. Normalement, chacun aurait besoin de sa propre installation BOSH et de la création de manifeste pour se déployer de manière cohérente – un défi plutôt important s’il est fait manuellement. Cette interface utilisateur est appelée Ops Manager et permet des mises à niveau sans interruption de service pour la plate-forme et les services, ainsi qu’une maintenance simplifiée et des modifications des configurations de déploiement sur lesquelles repose la Fondation Pivotal Cloud Foundry.

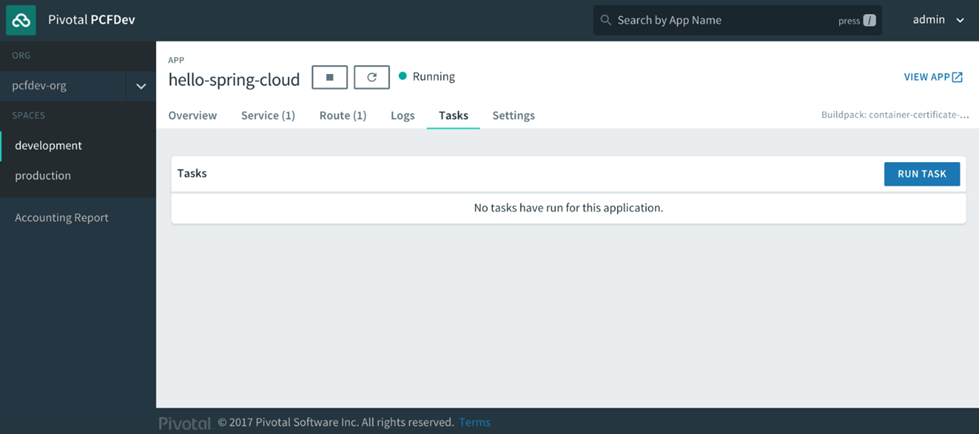

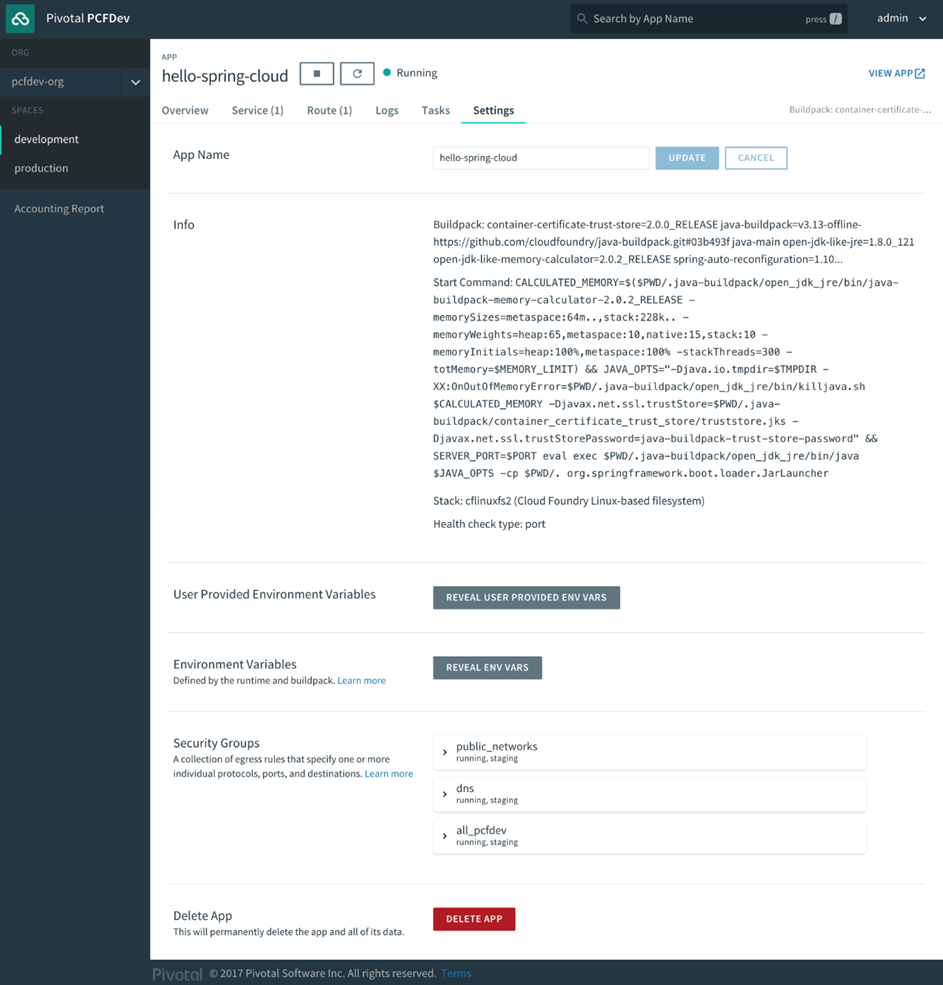

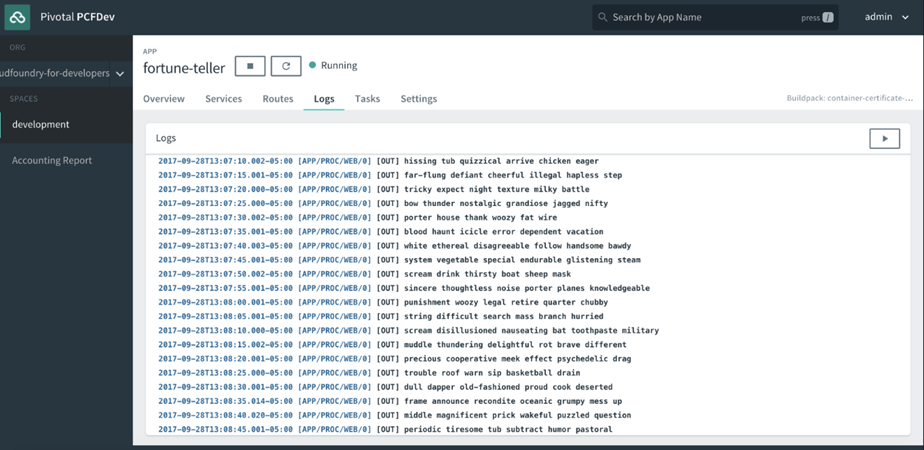

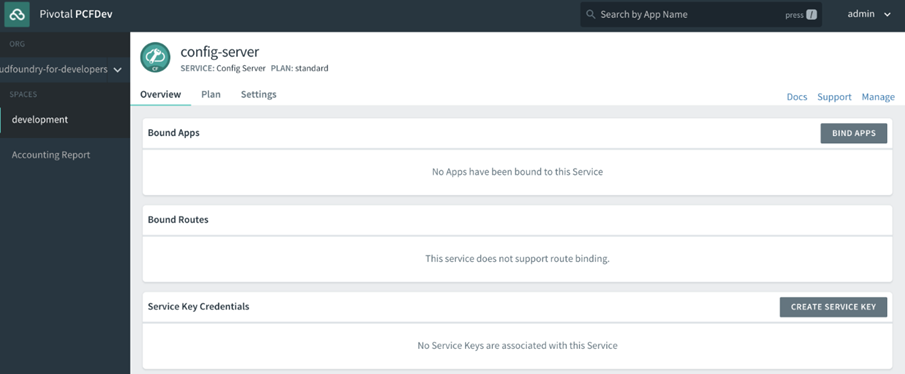

Une deuxième différence significative entre les versions open source et Pivotal de Cloud Foundry est centrée sur les développeurs. Apps Manager est une interface utilisateur administrative qui permet aux développeurs d’accéder à de nombreuses fonctionnalités de la CLI Cloud Foundry de manière plus intuitive. Apps Manager fournit un moyen visuel de configurer et de gérer de nombreuses fonctionnalités essentielles nécessaires pour gérer les tenants et aboutissants quotidiens de la gestion de vos applications en termes d’évolutivité, de performances, de paramètres, de services, de journalisation et d’intégrations telles que la mise à l’échelle automatique qui ne sont disponibles qu’avec Pivotal Distribution Cloud Foundry.

La distribution Pivotal Cloud Foundry fournit un support supplémentaire pour les applications natives du cloud via une grande partie de la fonctionnalité NetFlixOSS sous le couvert de Spring Cloud et Spring Cloud Services (SCS). Cela fournit des implémentations de modèles communs qui améliorent la résilience, la facilité de configuration et la haute disponibilité dans les applications que vous concevez et déployez sur Cloud Foundry, y compris la coordination et la découverte des services, les modèles de disjoncteurs pour éviter les temps d’arrêt et d’autres modèles particulièrement utiles pour les microservices. .

Une autre caractéristique notable de la distribution Pivotal est le tableau de bord PCF Metrics, qui présente un accès et des visualisations faciles des événements d’application récents, des mesures et de la journalisation.

1.5.1 Glossaire des composants de Pivotal Cloud Foundry

Les composants Pivotal Cloud Foundry et ce qu’ils font inclus :

- Ops Manager : une interface Web pour installer, configurer, mettre à niveau et faire évoluer Pivotal CF et Pivotal Services

- Apps Manager : une interface Web pour travailler avec Cloud Foundry et gérer les organisations, les espaces, les utilisateurs, les applications, les services, les itinéraires, etc.

- Pivotal Cloud Foundry Metrics: composant de surveillance, d’événement et de journalisation du tableau de bord pour les applications exécutées dans PCF

- Services pivots : services gérés, y compris la mise à l’échelle automatique, MySQL, RabbitMQ, Redis, Spring Cloud Services, etc.

1.5.2 Autres distributions Cloud Foundry et fournisseurs publics

En plus de l’offre commerciale de Pivotal Cloud Foundry, la Cloud Foundry Foundation certifie des fournisseurs de plate-forme supplémentaires pour garantir la cohérence des principaux composants de Cloud Foundry afin d’assurer la portabilité. La certification Cloud Foundry Certified PaaS nécessite des offres certifiées pour utiliser réellement le logiciel publié par les équipes de projet de la Fondation. Pour plus de détails sur les fournisseurs de plateformes certifiées Cloud Foundry, veuillez consulter https://www.cloudfoundry.org/provider-faq/.

Une liste partielle des offres des fournisseurs comprend :

- AppFog de CenturyLink (https://www.ctl.io/appfog/): plateforme de CenturyLink basée sur Cloud Foundry.

- Atos Cloud Foundry (https://atos.net/en/solutions/application-cloudenablement-devops): une Pivotal Cloud Foundry sous licence et gérée commercialement.

- GE Predix (https://www.predix.io/registration/): une offre Internet industrielle de Cloud Foundry pour l’IoT (dispositifs Internet of Things) et d’analyse.

- IBM Cloud (https://www.ibm.com/cloud/): plateforme cloud d’IBM basée sur Cloud Foundry, qui permet d’accéder aux services IBM, y compris Watson. Anciennement appelé IBM Bluemix.

- Pivotal Web Services (https://run.pivotal.io/): Pivotal le Cloud Foundry Pivotal publique. Une version entièrement gérée de Cloud Foundry qui s’exécute sur un cloud public.

- Plateforme SAP HANACloud (https://cloudplatform.sap.com/capabilities/runtimes-containers/cloud-foundry.html): plateforme cloud HANA de SAP basée sur Cloud Foundry, qui donne accès aux services SAP.

- Swisscom Developer Portal (https://developer.swisscom.com/): Application Cloud de Swisscom. Une version entièrement gérée de Cloud Foundry offerte sur un cloud public qui stocke toutes vos données en Suisse.

Une liste complète des fournisseurs de plates-formes certifiées Cloud Foundry et leurs offres peut être consultée à l’ adresse https://www.cloudfoundry.org/how-can-i-try-out-cloud-foundry-2016/ .

1.6 Résumé

Nous avons exploré comment Cloud Foundry simplifie le développement et le déploiement d’applications évolutives hautement disponibles. En se concentrant moins sur les préoccupations opérationnelles et administratives de la plate-forme, les développeurs d’applications peuvent plutôt transférer cet effort en écrivant un meilleur code et en améliorant la valeur des fonctionnalités qui composent l’application.

Nous avons abordé une conception d’application native pour le cloud qui permet aux développeurs de tirer pleinement parti d’une plate-forme en tant que service (PaaS) comme Cloud Foundry. De plus, nous avons constaté que tirer parti de Cloud Foundry ouvre la possibilité de mettre à l’échelle rapidement les applications pour répondre à la demande en pleine augmentation tout en offrant d’autres avantages, tels que des déploiements sans interruption, qui seraient difficiles à réaliser dans un environnement de déploiement de middleware traditionnel.

Enfin, nous avons discuté de certaines différences de haut niveau entre notre distribution open source Cloud Foundry et une distribution commerciale populaire appelée Pivotal Cloud Foundry parmi d’autres offres qui sont généralement disponibles.

2 Chapitre 2. CLI de Cloud Foundry et Gestionnaire d’applications

Dans ce chapitre, nous allons explorer les façons les plus courantes un des développeurs interagit avec l’application Cloud Foundry: la cf Interface ligne de commande (CLI) et le Gestionnaire Apps sur Pivotal Web Services (PWS) Les. Nous allons nous familiariser avec les bases de pousser les applications à Cloud Foundry à la fois le cf CLI et le Gestionnaire Apps, et comment ils se rapportent les uns aux autres.

Plus précisément, nous couvrirons les éléments suivants :

- Création d’un compte PWS

- Installation du cf CLI

- Configuration initiale du cf CLI

- La commande d’aide cf CLI

- Déployer une application dans Cloud Foundry

- Accès au gestionnaire d’applications sur PWS

2.1 Le cf CLI

Presque tous les grands progrès de l’informatique ont commencé à un moment donné dans un terminal. Baigné dans la gloire d’une interface utilisateur à base de texte (UI), les cf CLI émet des commandes en texte tapé par l’utilisateur à un programme invisible en cours d’exécution dans les coulisses de la scène une séquence complexe d’étapes pour exécuter la volonté du développeur. L’interpréteur de ligne de commande, souvent confondu avec l’interface de ligne de commande, est également abrégé en acronyme CLI. Les programmes CLI basés sur terminal sont un outil quotidien commun dans le monde de l’opérateur système, mais souvent moins courant dans le monde des développeurs d’applications. L’essor des environnements de développement intégrés (IDE) tels qu’Eclipse, Visual Studio et IntelliJ en tant qu’endroits où tout le code est écrit et compilé, avec des améliorateurs de productivité tels que des suggestions de code et la saisie semi-automatique, a réduit la nécessité pour les développeurs de descendre au niveau du terminal aussi souvent que leurs racines historiques le leur ont demandé. L’IDE est un excellent outil dans la façon dont il résume les commandes du terminal en les exécutant pour le développeur dans les coulisses.

En fonction de leurs antécédents, une partie importante des développeurs d’applications peut trembler à l’idée d’utiliser une CLI pour déployer leur application. Soyez assuré qu’il existe en effet une belle interface utilisateur pour interagir avec Cloud Foundry sur Pivotal Web Services, appelé Apps Manager. Cependant, l’apprentissage de la cf CLI vous servira extraordinairement bien une fois que vous commencez à l’automatisation de loin le travail du temps de déploiement d’applications avec la cohérence et la facilité à différents environnements de déploiement (appelés espaces dans le langage Cloud Foundry), de bac à sable les tests utilisateurs (UAT), à la mise en scène (pré-production), à la production ou à tout autre nom que vous ou votre organisation les appelez.

Avec cf CLI, vous obtenez :

- CI / CD simplifié

- La possibilité de créer des scripts pour les tests automatisés, le code, la sécurité et les contrôles de conformité

- ZDD (Zero Downtime Deployments), connus sous le nom de déploiements bleu-vert, qui vous donnent un test A / B comme effet secondaire.

- Dépannage approfondi lorsque les choses tournent mal avec votre application ou votre déploiement

- Un ensemble complet de fonctionnalités qu’une interface utilisateur ne peut encapsuler qu’un sous-ensemble sans être trop complexe pour fonctionner de manière simplifiée

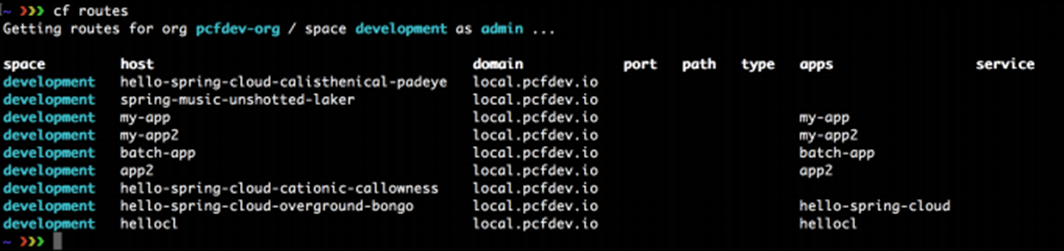

Lorsque vous utilisez la version open source de Cloud Foundry, la cf CLI va être l’outil principal de gestion pour le déploiement et la gestion des applications, la gestion des instances de services, des organisations, des espaces, des domaines, des routes, des utilisateurs et des quotas. Si vous utilisez la distribution Pivotal Cloud Foundry, vous bénéficierez de l’utilisation supplémentaire de l’interface utilisateur Apps Manager.

Tout d’abord, nous aurons besoin d’une Cloud Foundry pour travailler et un moyen facile d’accéder à un déploiement Cloud Foundry consiste à utiliser Pivotal Web Services (PWS).

Deuxièmement, nous allons installer la CLI cf et explorer certaines configurations et commandes de base.

Troisièmement, nous proposerons une application de test simple pour comprendre le flux de base du déploiement d’applications dans Cloud Foundry.

Quatrièmement, nous allons explorer le gestionnaire d’applications fourni par PWS.

À la fin, vous aurez les éléments suivants :

- Accès à une fondation Cloud Foundry pour pousser votre code et attacher des services

- Une CLI Cloud Foundry installée

- Accès au gestionnaire d’applications sur PWS

2.2 Qu’est – ce que Pivotal Web Services (PWS)?

Pivotal Web Services (PWS, prononcé P-Dubs), est l’une des plus grandes fondations Pivotal Cloud Foundry en activité. Il est hébergé sur AWS et est une rampe d’accès facile à Cloud Foundry pour les développeurs, car il est accessible au public sur Internet. PWS est une version entièrement gérée de Cloud Foundry qui s’exécute sur un cloud public. Vous pouvez être opérationnel immédiatement avec un abonnement d’essai gratuit, sans avoir besoin d’utiliser une carte de crédit, ce qui en fait une offre exceptionnelle pour les développeurs d’applications qui souhaitent apprendre et se familiariser avec Cloud Foundry et les fonctionnalités supplémentaires fournies par Pivotal Cloud Distribution de fonderie.

Les services Web Pivotal sont disponibles sur Internet à l’adresse https://run.pivotal.io.

Le site Web Pivotal Web Services. © 2017 Pivotal Software, Inc. Tous droits réservés.

Au moment de la rédaction du présent document, l’essai gratuit des services Web Pivotal comprend :

- Crédit de 87 $ US pour l’utilisation de l’application jusqu’à 1 an

- Jusqu’à 2 Go de mémoire à partager entre les instances d’application

- Choix de services de marché gratuits à essayer

- Collaborateurs illimités

2.3 Création d’ un compte PWS

La création d’un compte PWS est un processus simple. Et, une fois que vous aurez accès à PWS, vous pourrez explorer un vaste écosystème de services tiers, tels que les bases de données, la messagerie et les métriques, que les développeurs d’applications peuvent exploiter lors de la création de leurs applications. Avec PWS, vous pouvez déployer, mettre à jour et faire évoluer vos applications comme vous le feriez sur n’importe quel PaaS Cloud Foundry.

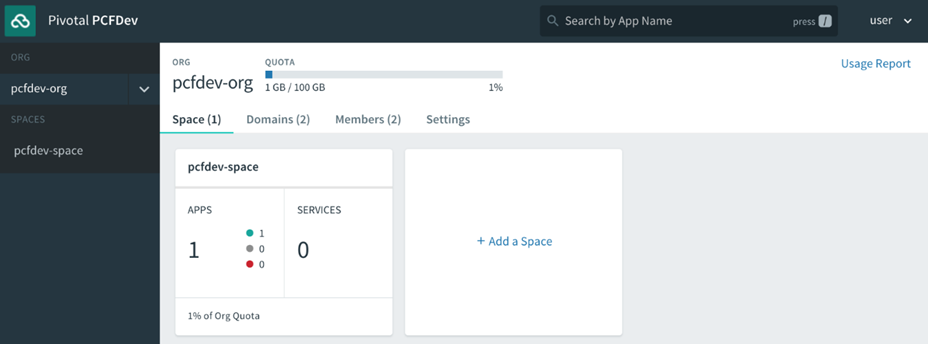

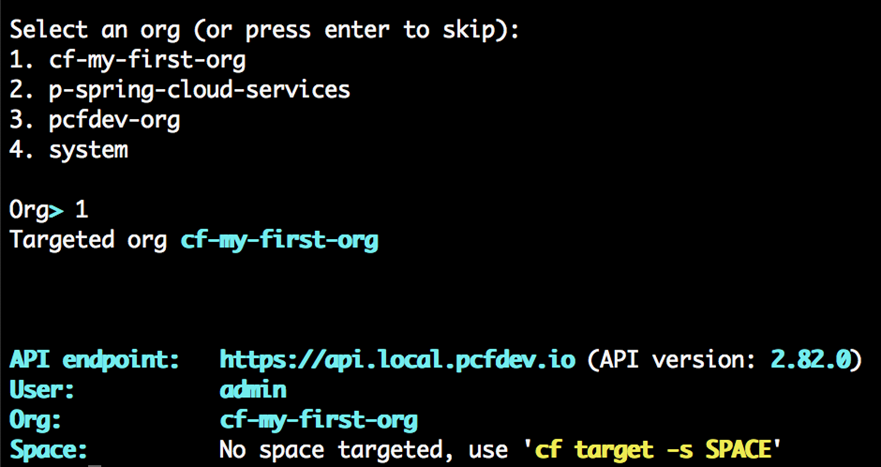

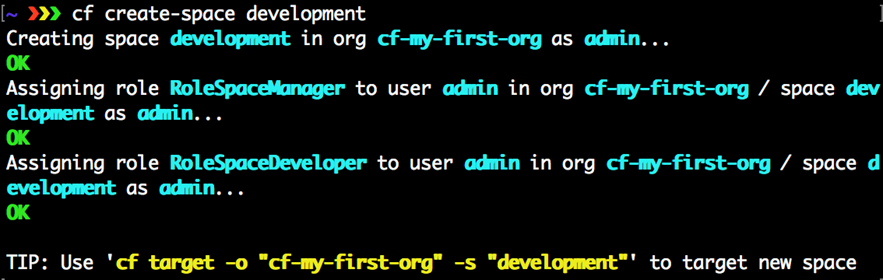

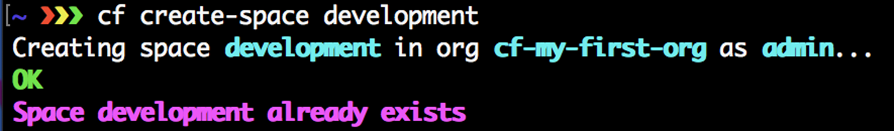

2.3.1 Ce que vous obtenez lorsque vous vous inscrivez à PWS

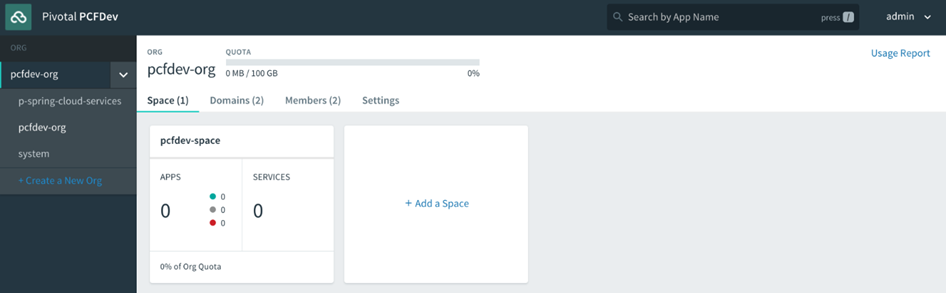

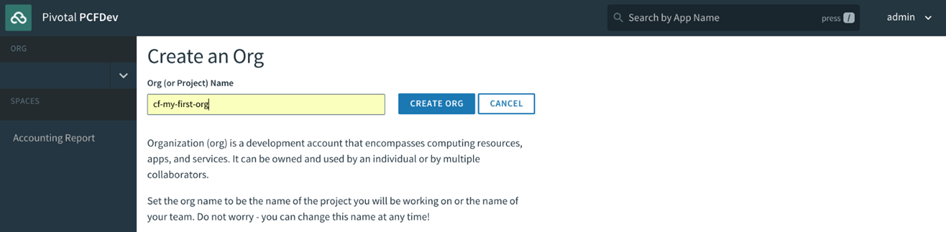

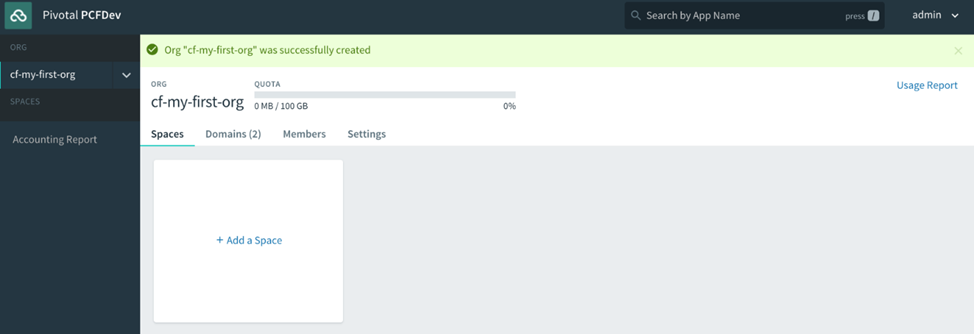

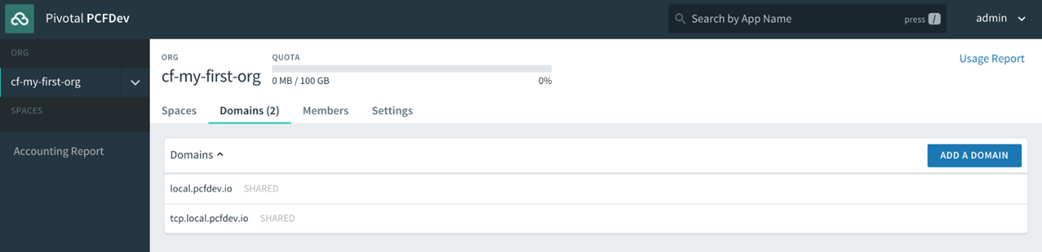

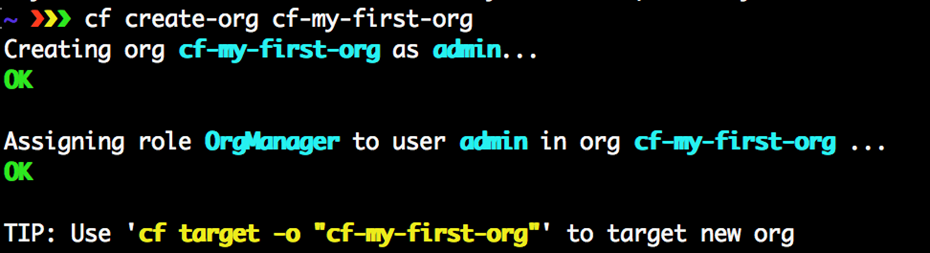

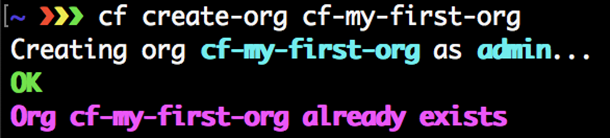

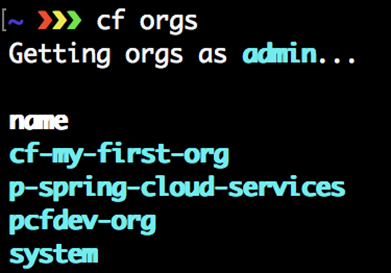

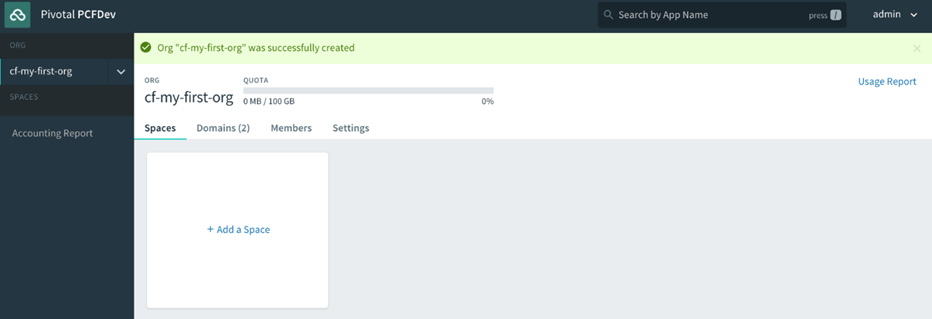

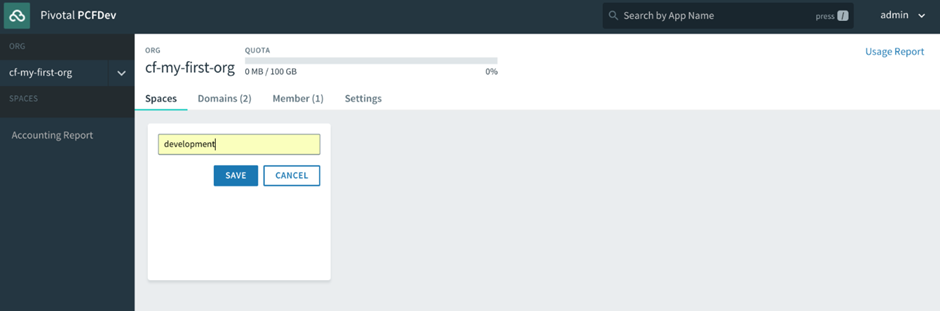

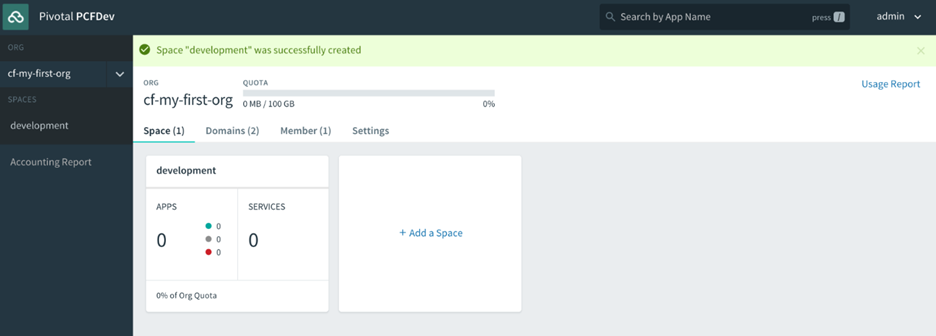

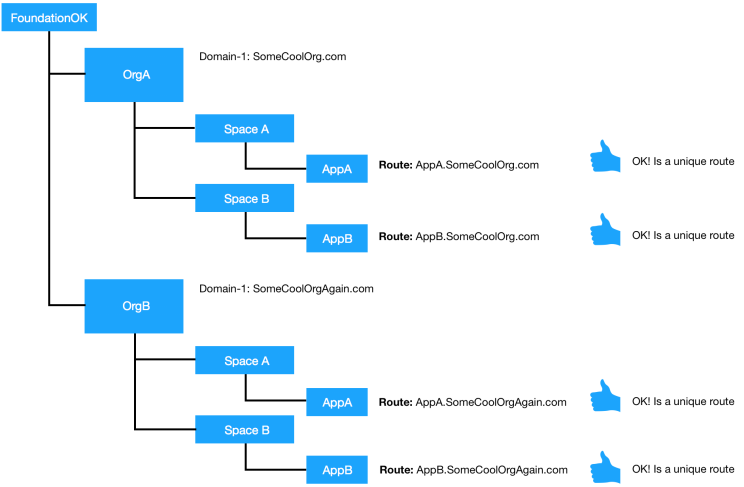

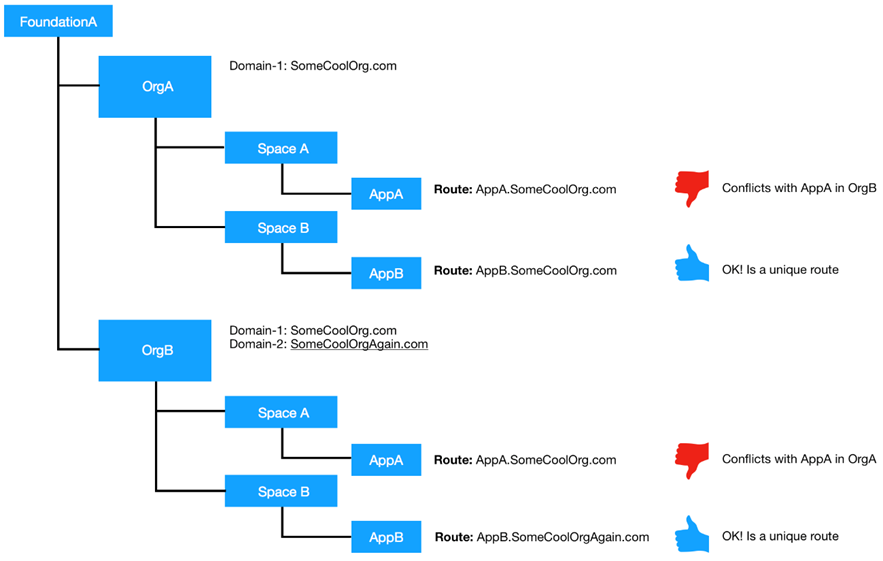

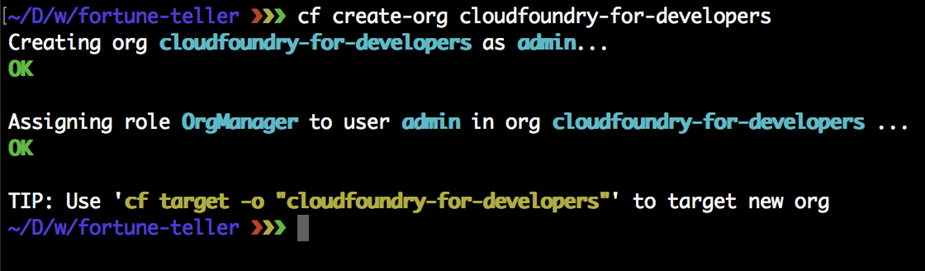

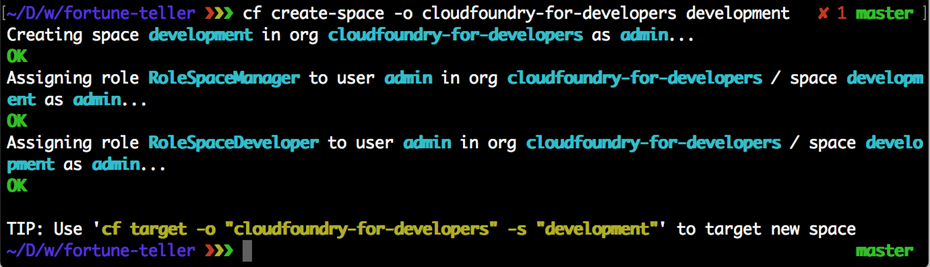

Lorsque vous vous inscrivez pour un compte PWS, un compte utilisateur Cloud Foundry est créé pour vous qui vous donne une fonderie Nuage Org et S rythme. Toutes les fondations Cloud Foundry vous offriront la même chose une fois votre compte utilisateur créé. Nous aborderons en détail les organisations et les espaces dans le chapitre 4 , Utilisateurs, organisations, espaces et rôles . Pour l’instant, considérez les organisations et les espaces comme de simples systèmes d’organisation avec l’organisation au niveau supérieur, sous lesquels vous disposerez de plusieurs espaces, qui sont à peu près équivalents à un environnement de déploiement comme un bac à sable, développement, assurance qualité, mise en scène, prod et ainsi de suite, que l’on trouve dans la plupart des entreprises pour permettre à une application de progresser dans la chaîne des environnements jusqu’à ce qu’ils soient finalement promus en production, où les consommateurs interagiront avec l’application.

2.3.2 Inscription

Commencez par ouvrir https://try.run.pivotal.io/gettingstarted dans votre navigateur Internet. Cela vous amènera directement à l’écran de création de compte PWS pour remplir les informations de base nécessaires pour créer un compte, comme indiqué dans la capture d’écran suivante :

Un e-mail de vérification sera envoyé à votre adresse e-mail qui vous fournira un lien pour créer votre compte PWS :

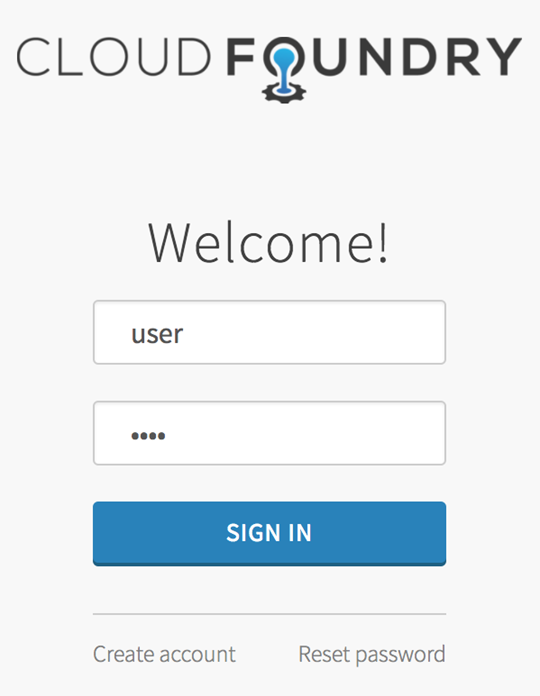

Lorsque vous êtes prêt à vous connecter, ouvrez https://login.run.pivotal.io/login et il ouvrira la page de connexion, comme suit :

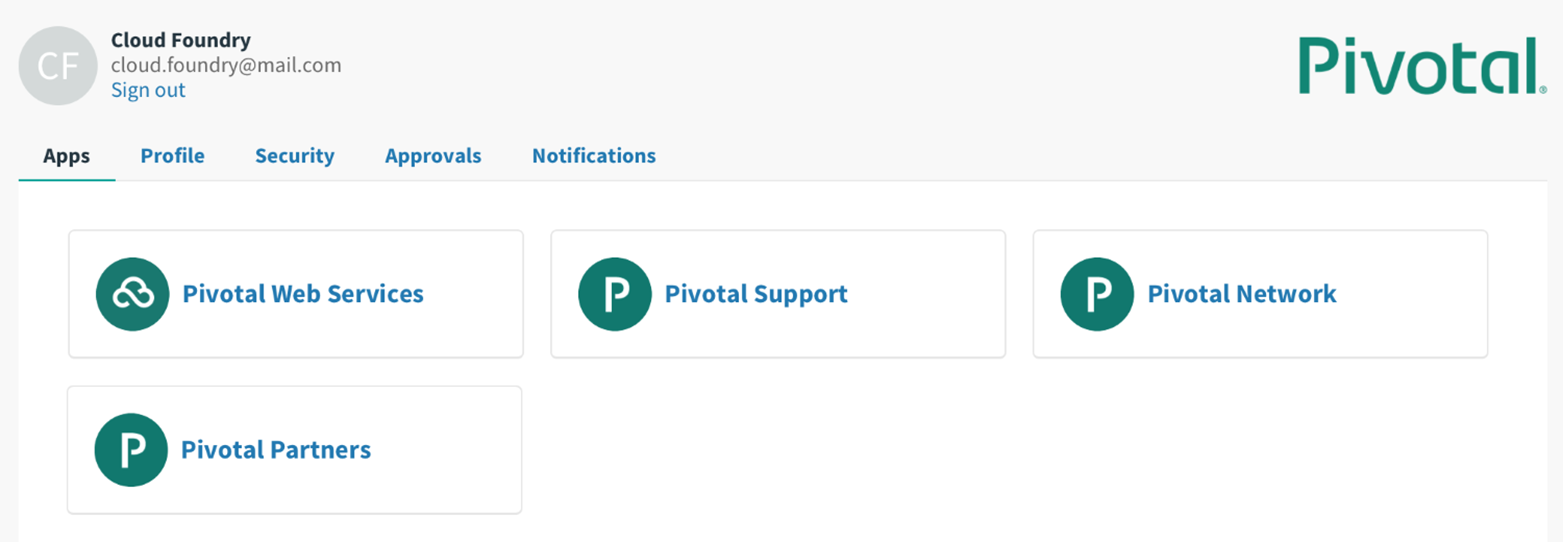

Sélectionnez Pivotal Web Services dans l’ensemble d’applications par défaut que vous obtenez avec votre compte PWS :

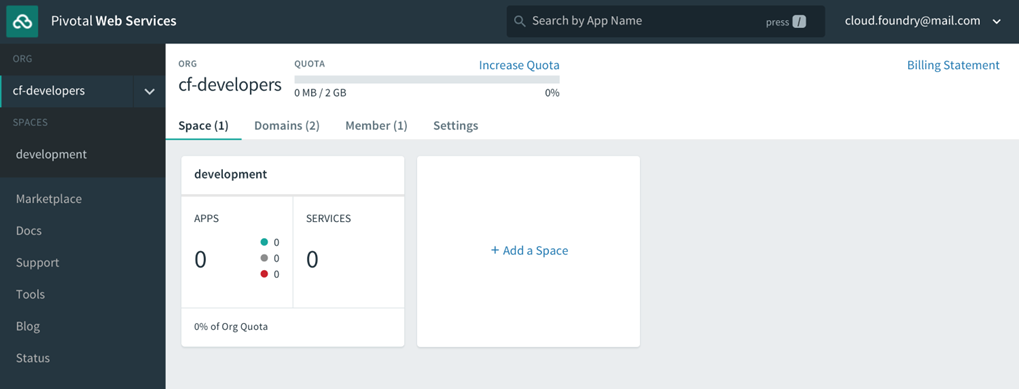

Donnez un nom à votre organisation (dans l’exemple suivant, la nôtre s’appelle cf -developers), puis vous verrez l’interface utilisateur du gestionnaire d’applications avec un espace par défaut créé, appelé développement, pour commencer à déployer des applications dans :

2.4 Installation du cf CLI

Pour installer la cf CLI, accédez à https://console.run.pivotal.io/tools. Téléchargez et exécutez le programme d’installation de votre plate-forme.

Vérifiez l’installation en ouvrant une fenêtre Terminale et en tapant cf –version. Avec cela, vous avez maintenant un client Cloud Foundry qui peut communiquer avec n’importe quelle installation Cloud Foundry, y compris PWS.

Remarque

Assurez-vous que la dernière version de l’interface de ligne de commande cf est installée. Il peut y avoir des cas où une version précédemment installée de la CLI cf est déjà présente. Cela causera de la frustration s’il y a eu des changements importants dans l’outil depuis l’installation de la version précédente.

Si vous êtes intéressé par d’autres manières d’installer la cf CLI, il existe quelques possibilités supplémentaires, notamment :

- Téléchargement et installation depuis GitHub

- L’installer à l’aide d’un gestionnaire de packages

Remarque

L’ interface de ligne de commande cf est écrite dans le langage de programmation Go de sorte qu’il s’agit d’une application très performante. Il est distribué comme un binaire autonome sans dépendances externes. Si le code de la CLI cf vous intéresse , vous pouvez le trouver sur https://github.com/cloudfoundry/cli .

2.4.1 Téléchargement et installation depuis GitHub

Depuis Cloud Foundry est un logiciel open source (OSS), vous pouvez télécharger la dernière version de composants tels que le cf CLI de GitHub et les installer directement :

- Accédez à https://github.com/cloudfoundry/cli/releases .

- Téléchargez le programme d’installation de votre plate-forme, tel que macOS X, Windows, Debian ou Red Hat.

Installez la cf CLI en suivant les instructions de votre système d’exploitation :

- Installer cf CLI sur Windows

- Décompressez le fichier .zip.

- Double-cliquez sur le cf CLI exécutable.

- Lorsque vous y êtes invité, cliquez sur Installer, puis sur Fermer.

- Installer cf CLI sur macOS X et Linux

- Ouvrez le .pkg | .deb | Fichier .rpm.

- Suivez l’assistant d’installation du package.

- Lorsque vous y êtes invité, cliquez sur Installer, puis sur Fermer.

2.4.2 Installation à l’aide d’un gestionnaire de packages

Pour les utilisateurs de Mac OS X, vous pouvez utiliser le gestionnaire de packages Homebrew . Factures homebrew lui – même comme le gestionnaire de paquets manquants pour OS X .

Remarque

Vous pouvez trouver Homebrew sur https://brew.sh – il est utile pour bien plus que simplement installer la cf CLI. Il fournit également un moyen facile de simplifier la mise à jour des outils que vous avez installés à l’aide de la commande brew update .

$ brew tap cloudfoundry/tap

$ brew install cf-cli

Pour les distributions Linux basées sur Debian et Ubuntu:

# …first add the Cloud Foundry Foundation public key and package repository to your system$ wget -q -O – https://packages.cloudfoundry.org/debian/cli.cloudfoundry.org.key | sudo apt-key add –

echo”deb http://packages.cloudfoundry.org/debian stable main”| sudo tee /etc/apt/sources.list.d/cloudfoundry-cli.list# …then, update your local package index, then finally install the cf CLI$ sudo apt-get update$ sudo apt-get install cf-cli

Systèmes Enterprise Linux et Fedora (RHEL6 / CentOS6 et plus) :

# …first configure the Cloud Foundry Foundation package repository$ sudo wget -O /etc/yum.repos.d/cloudfoundry-cli.repo https://packages.cloudfoundry.org/fedora/cloudfoundry-cli.repo# …then, install the cf CLI (which will also download and add the public key to your system)$ sudo yum install cf-cli

2.5 Configuration initiale de cf CLI

Après avoir installé le cf CLI, vérifiez qu’il fonctionne correctement en tapant la commande suivante :

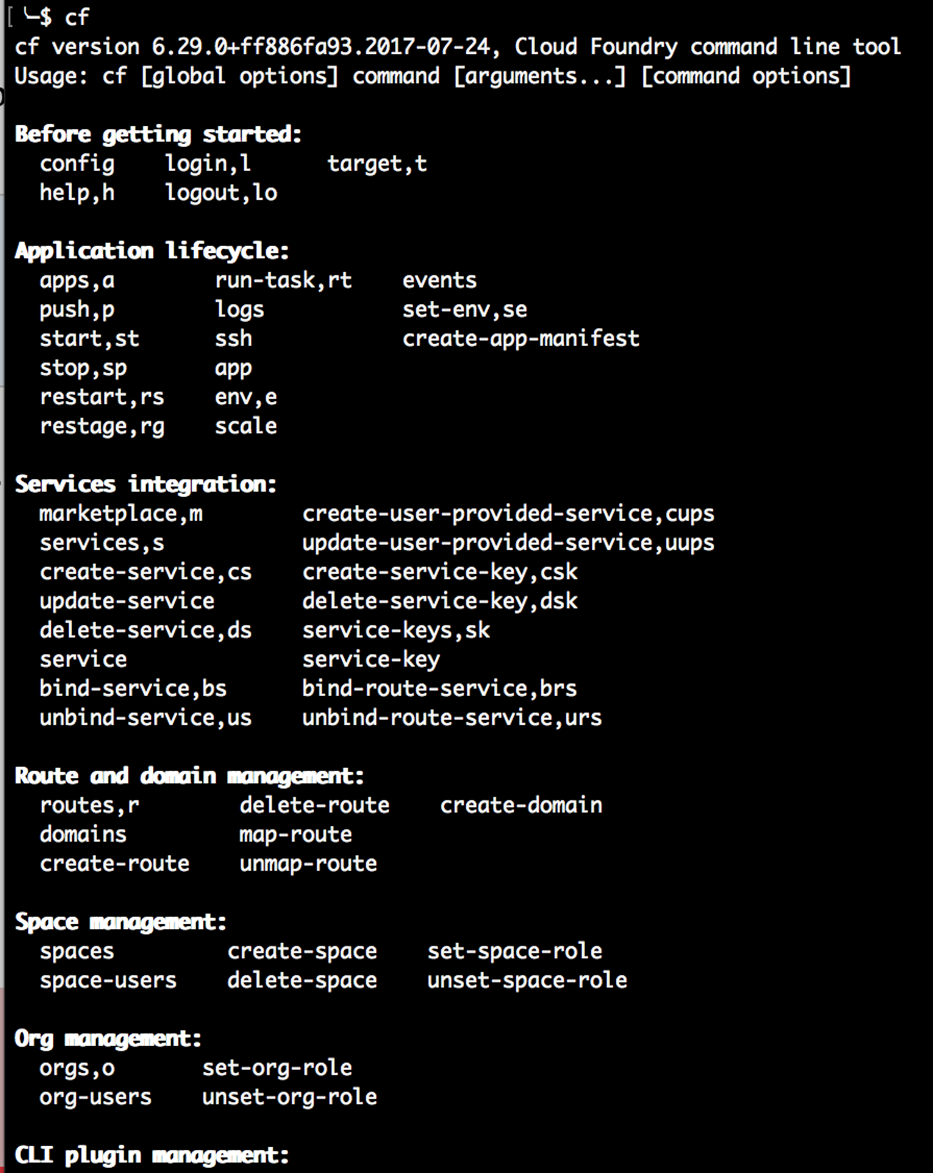

$ cf

Si tout se passe bien, vous devriez voir apparaître le texte d’aide cf CLI, ressemblant à ceci :

Pour voir la version de la CLI cf installée, tapez la commande suivante :

$ cf – version

2.6 La commande d’aide cf CLI

Peut-être la commande la plus utile lors du démarrage avec la CLI cf est la suivante:

$ cf help

Cela vous permet de voir les commandes CLI disponibles et de comprendre leur utilisation et leur syntaxe. La CLI cf vous permet de contrôler une large gamme de commandes qui vous aident à déployer et configurer vos applications sur Cloud Foundry.

2.6.1 Recherche des commandes CLI cf

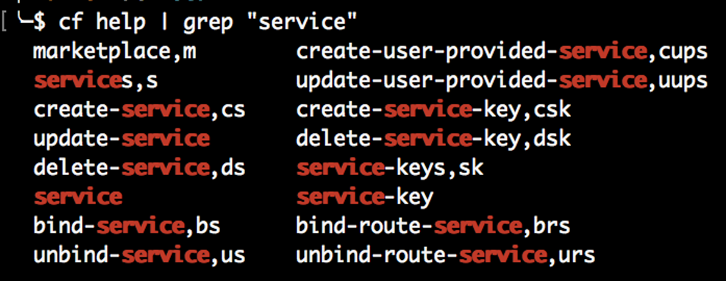

Comme il y a beaucoup cf commandes CLI disponibles, il peut être un peu écrasante pour trouver la commande que vous êtes vraiment intéressé à un moment donné. Si vous l’avez disponible sur votre système, vous pouvez trouver des commandes contenant des mots clés cf CLI en utilisant grep :

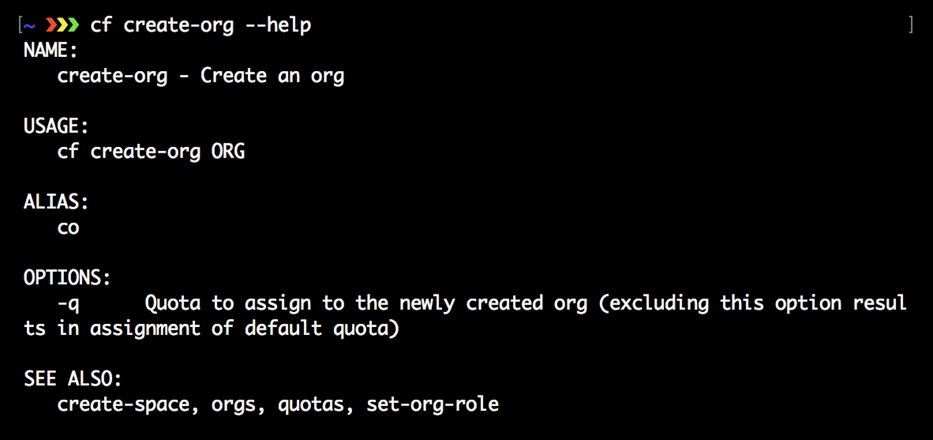

2.6.2 Aide spécifique à la commande

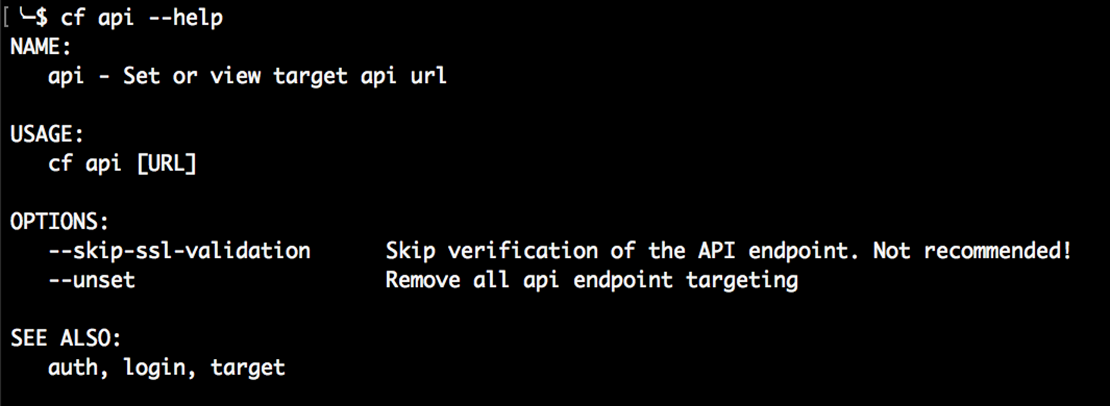

Avec cf CLI, les commandes peuvent avoir des sous-commandes spécifiques sur lesquelles vous pouvez demander de l’aide pour obtenir plus d’informations.

Pour voir la syntaxe cf CLI pour des commandes spécifiques, ajoutez –help ou -h après la commande, comme illustré ici:

Remarque

La documentation officielle de la CF CLI se trouve sur http://docs.cloudfoundry.org/cf-cli . Il comprend des détails importants sur les différentes commandes. De plus, il existe un guide de référence CLI Cloud Foundry officiel qui peut être trouvé à http://cli.cloudfoundry.org/en-US/cf/.

2.7 Déployer une application dans Cloud Foundry

Nous avons maintenant notre compte PWS configuré et fonctionnel, et nous avons également notre CF CLI installé et fonctionnel. Maintenant, nous voulons simplement pousser une application simple pour la voir s’exécuter sur Cloud Foundry. Pour ce faire que , nous devons faire quelques choses :

- Définissez l’instance Cloud Foundry cible afin que notre CLI cf sache où nous poussons nos bits d’application.

- Connectez-vous à l’instance Cloud Foundry ciblée à l’aide de la CLI cf.

- Poussez notre application simple.

2.7.1 Ciblage du point de terminaison Pivotal cf API

Quoi de plus logique que de cibler l’instance Cloud Foundry dans laquelle vous souhaitez déployer votre application ? Pour ce faire, vous devez définir le point de terminaison de l’API Cloud Foundry vers lequel votre cf CLI émettra des commandes. Dans les coulisses, votre cf CLI aura une conversation aller-retour avec l’instance Cloud Foundry à l’aide d’appels RESTful. Et, comme pour tous les appels RESTful, vous devez disposer d’un point de terminaison API avec lequel communiquer.

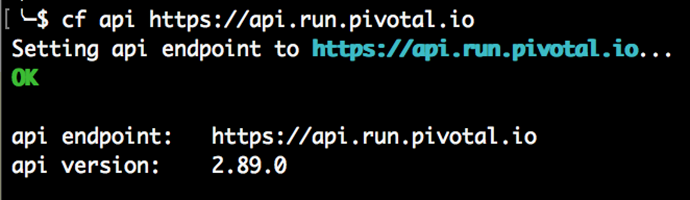

Pour définir le point de terminaison API sur PWS, tapez la commande suivante dans votre terminal :

$ cf api https://api.run.pivotal.io

Vous devriez voir la cible API définie avec les commentaires de la ligne de commande, comme ceci :

Si tel est le cas, vous avez correctement ciblé le point de terminaison de l’API PWS et êtes prêt à vous connecter.

Remarque

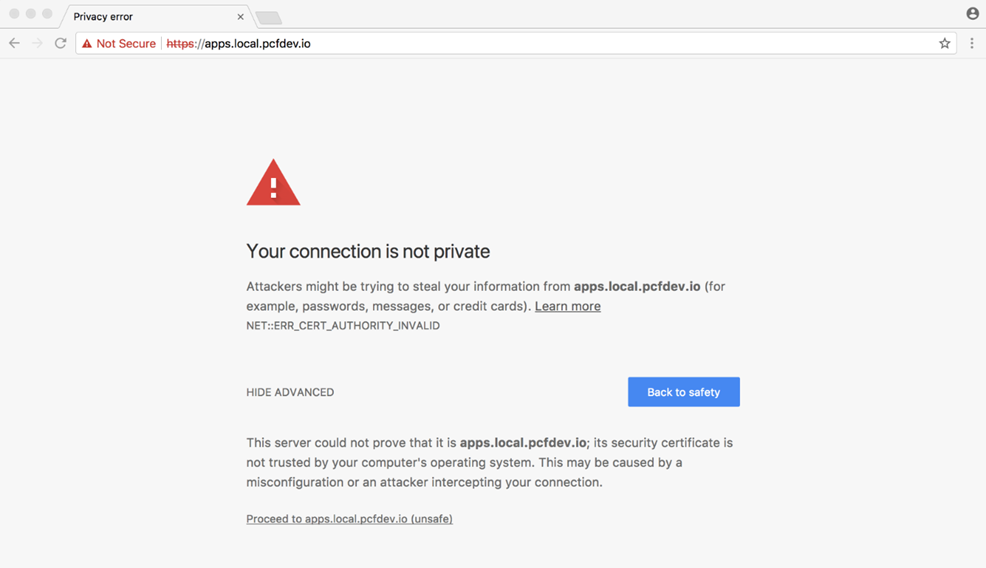

Si vous n’utilisez pas PWS ou une instance Cloud Foundry qui possède tous les certificats SSL publics nécessaires en place, il est possible que vous voyiez une erreur de validation SSL lorsque vous essayez de cibler le point de terminaison API. Cela se produit généralement si votre système utilise des certificats auto-signés. Si vous voyez cela, utilisez simplement le –skip ssl -validation drapeau avec l’habituel cf api commande.

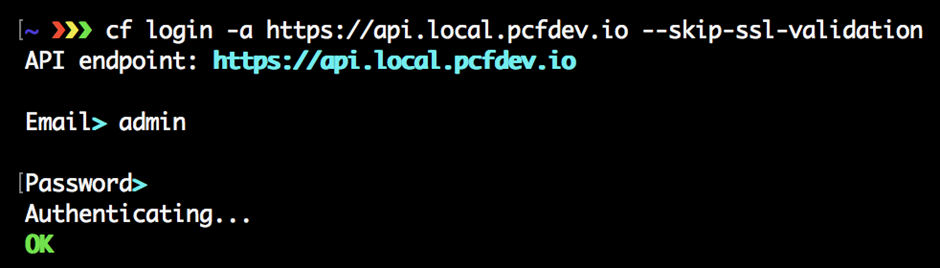

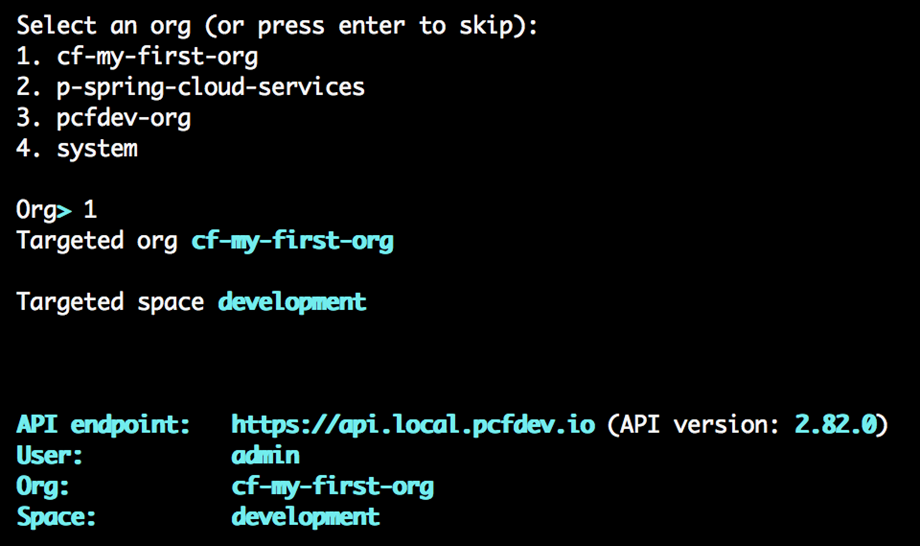

2.8 Connexion au point de terminaison de l’API Cloud Foundry

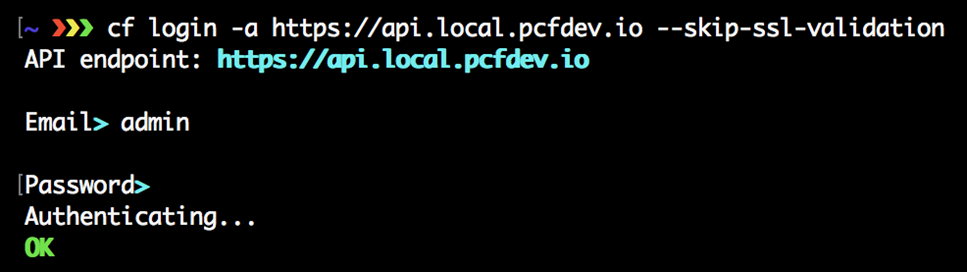

Nous avons indiqué à la CLI cf à quel point de terminaison Cloud Foundry parler avec la commande cf api ; nous allons maintenant utiliser la commande cf login pour s’authentifier auprès de ce point de terminaison API. Pour ce faire, tapez simplement ce qui suit dans votre terminal :

$ cf connexion

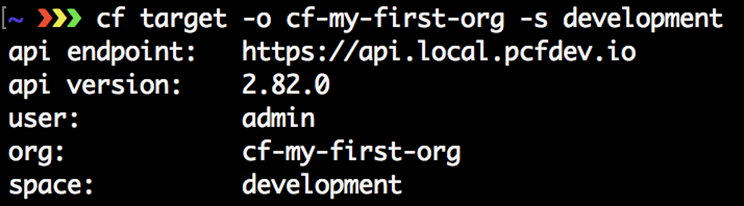

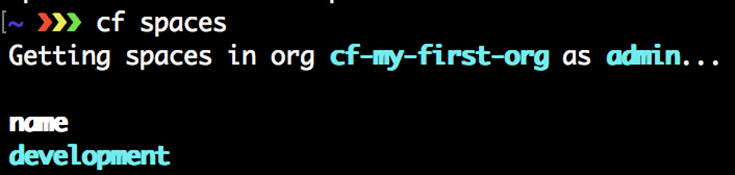

À ce stade, il vous indiquera le point de terminaison API de l’instance Cloud Foundry que vous ciblez et vous demandera votre nom d’utilisateur, qui est souvent sous la forme d’une adresse e-mail, et le mot de passe que vous avez défini lors de votre inscription pour votre utilisateur PWS Compte. Une fois que vous avez entré ces informations, vous verrez les cibles définies pour l’organisation et l’espace que vous avez configuré sur votre instance Cloud Foundry chez PWS, comme suit:

Remarque

Nous avons suivi un processus en deux étapes pour vous familiariser avec ce qui se passe dans les coulisses, en ciblant d’abord l’instance Cloud Foundry puis en vous y connectant. Mais il existe un processus simple en une seule étape que vous pouvez utiliser pour faire les deux en même temps à l’avenir: utilisez la commande $ cf login -a https://api.run.pivotal.io .

2.9 Pousser une application simple

Non seulement allons-nous pousser une application simple vers Cloud Foundry, mais nous allons pousser l’application Cloud Foundry la plus simple au monde. Vous ne pouvez pas obtenir plus de base qu’une simple page HTML statique qui affiche le bonjour Hello World !.

Téléchargez l’application avec Git :

$ git clone https://github.com/rickfarmer/worlds-simplest-cloud-foundry-app.git

Remarque

Si vous n’avez pas encore installé Git, vous pouvez télécharger un fichier ZIP de la simple application Cloud Foundry sur https://github.com/rickfarmer/worlds-simplest-cloud-foundry-app/archive/master.zip .

Accédez au répertoire de l’application :

$ cd worlds-simplest-cloud-foundry-app

Poussez l’application vers Cloud Foundry:

$ cf push

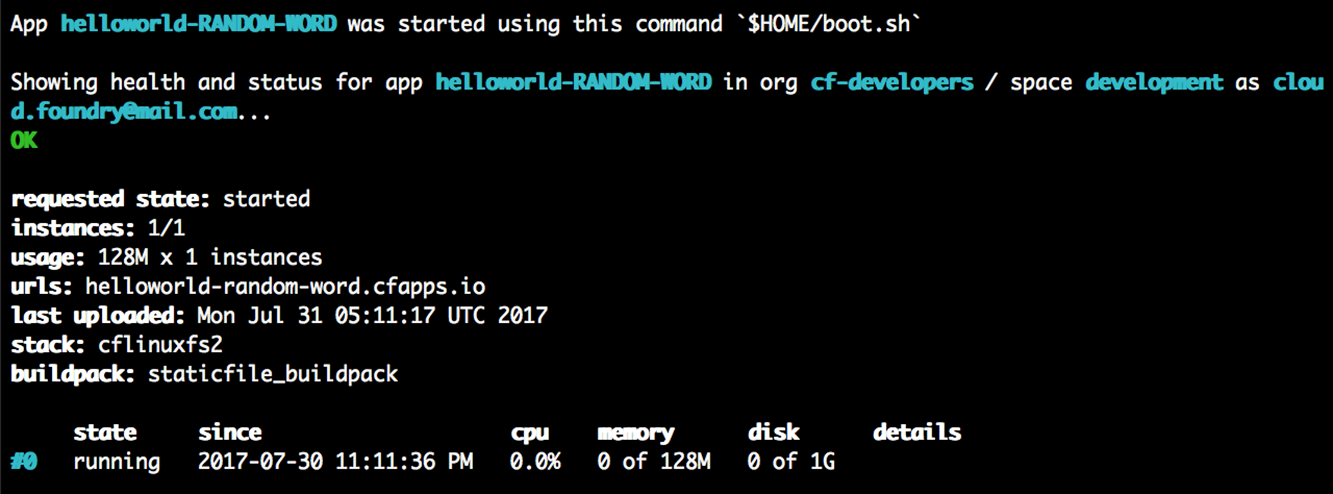

L’application sera poussée vers Cloud Foundry, et dans la sortie du terminal, vous verrez l’URL à ouvrir dans votre navigateur afin de visualiser l’application en cours d’exécution, comme suit :

Dans l’exemple de sortie précédent, l’application en cours d’exécution se trouve sur http://helloworld-random-word.cfapps.io .

Votre déploiement sera à une URL aléatoire différente qui est automatiquement générée pour vous afin de vous assurer qu’elle est unique parmi toutes les URL d’application sur PWS.

Remarque

Lorsque vous déployez cette application simple, des mots générés de manière aléatoire seront ajoutés au nom de base de l’application pour créer une URL unique. Dans ce cas, cela se fait car chaque URL sur une instance Cloud Foundry donnée doit être unique pour une application déployée. Par exemple, avec PWS, il est probable que quelqu’un d’autre lisant cet article aura déjà utilisé le nom de l’application comme URL. Pour éviter ce problème, un indicateur a été ajouté à manifest.yml qui effectue la génération aléatoire de l’URL via random-route: true . Plus d’informations sur manifest.yml et les différentes configurations que vous pouvez utiliser avec lui viendront plus tard.

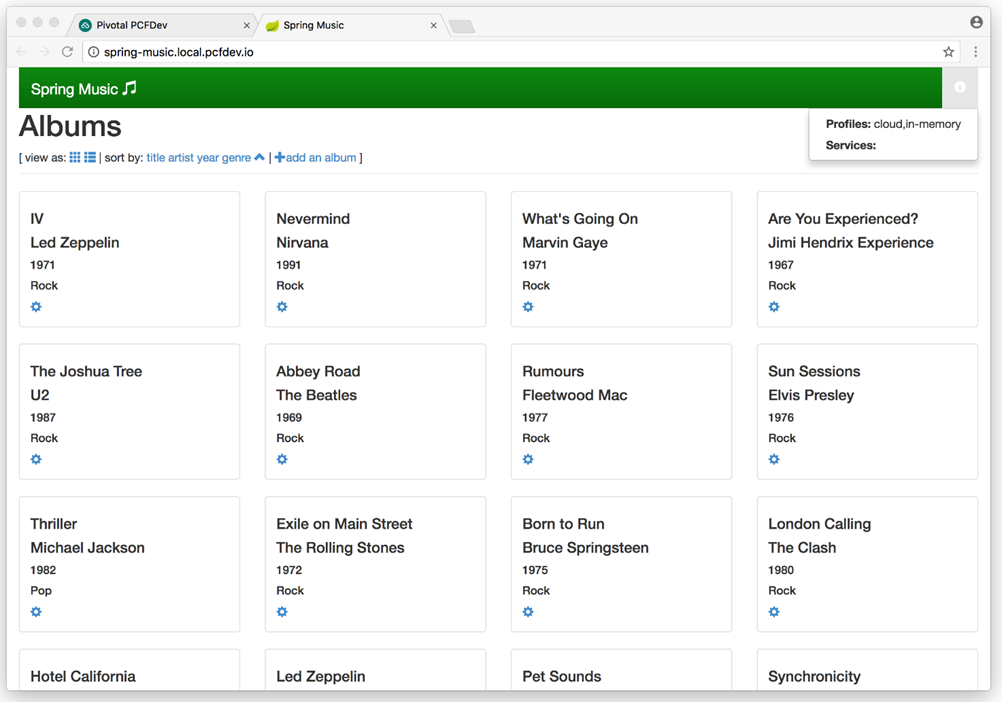

L’ouverture du navigateur révélera l’application Cloud Foundry la plus simple au monde dans toute sa splendeur :

Toutes nos félicitations ! Vous venez de déployer une application sur Cloud Foundry.

2.10 Accès au gestionnaire d’applications sur PWS

Qu’est-ce que Cloud Foundry Apps Manager ?

- Une interface Web pour gérer les organisations, les espaces, les applications et d’autres paramètres

- Il offre un sous-ensemble des fonctionnalités de gestion disponibles via l’interface de ligne de commande cf

- Il vous offre un marché de services que vous pouvez attacher et exploiter dans le développement de votre application

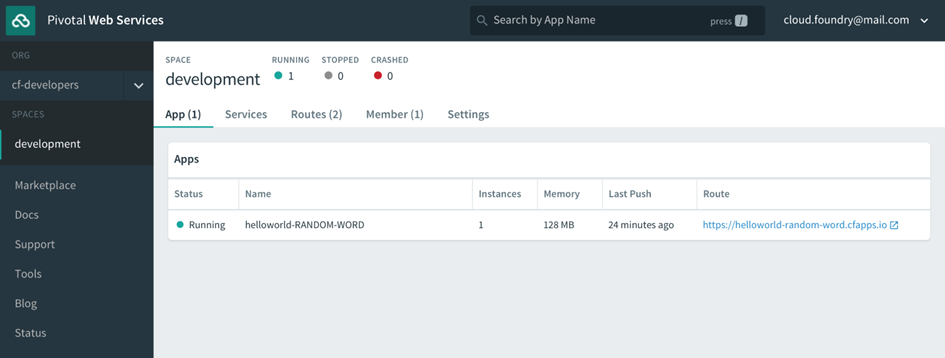

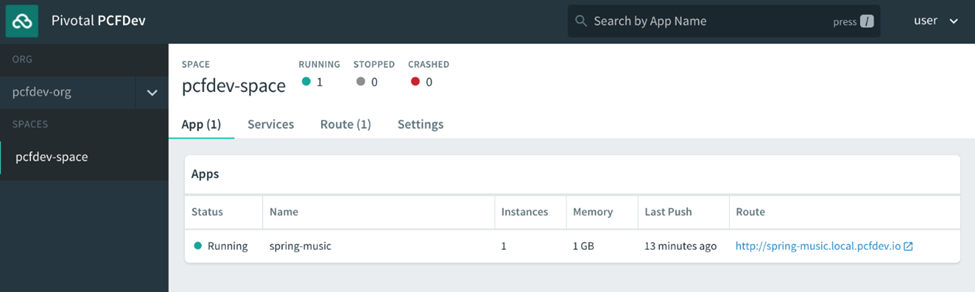

Rappelez-vous qu’après vous être inscrit au compte PWS et vous y être connecté, nous avons eu un aperçu de l’interface utilisateur d’Apps Manager en cours d’exécution sur https://console.run.pivotal.io. Maintenant, avec une application simple déployée, vous pouvez voir l’application nommée hello world-RANDOM-WORD s’exécuter correctement dans le gestionnaire d’applications.

Les informations incluent l’état, le nombre d’instances en cours d’exécution, la dernière fois que l’application a été poussée et l’itinéraire, le terme de Cloud Foundry pour l’URL de l’application:

Le gestionnaire d’applications nous donne un sous-ensemble des fonctionnalités de la CLI cf. Dans les coulisses, il parle au même point de terminaison RESTful avec lequel le cf CLI parle et fait en grande partie le même travail pour nous. Nous ne passons beaucoup de temps sur le Gestionnaire Apps à ce stade, car il ne s’applique qu’à Pivotal Cloud Foundry, mais il est une interface standard pour l’affichage de certaines fonctionnalités disponibles dans la cf CLI, et pour la gestion et le déploiement d’applications dans un moyen visuel pour ceux qui peuvent être moins à l’aise avec la ligne de commande.

Remarque

La documentation officielle d’Apps Manager est disponible à l’ adresse http://docs.run.pivotal.io/console .

2.11 Résumé

Dans ce chapitre, nous avons abordé le gestionnaire d’applications qui fournit une interface utilisateur conviviale pour les paramètres et commandes communs liés au déploiement et à la gestion des applications et des services utilisés dans Cloud Foundry. Nous avons également pris notre premier coup d’œil à la cf CLI et trouvé qu’il prend en charge un large éventail de commandes pour la gestion des applications et des activités connexes dans Cloud Foundry.

La configuration initiale de la cf CLI est nécessaire avant d’effectuer la plupart des tâches de gestion liées au développement sur le Cloud Foundry. Nous avons constaté que la cf CLI est un outil qui peut être utilisé avec l’une des différentes distributions de Cloud Foundry, y compris Cloud Foundry déploiements open source, Pivotal Web Services, Pivotal Cloud Foundry et PCF Dev (utilisé pour le développement local et déploiement). Et cf CLI est utilisé avec d’autres public Cloud Foundry variantes, telles que IBM Cloud (anciennement Bluemix), GE Predix, et plus encore.

3 Chapitre 3. Premiers pas avec PCF Dev

Le développement TDD ou piloté par les tests est essentiel aux 3 piliers d’un grand développement logiciel :

- Développement piloté par les tests (TDD)

- Intégration et déploiement continus (CI / CD)

- Programmation en binôme

Cependant, pour exécuter la boucle TDD rapidement et pour que TDD en vaille la peine à partir du moment où les mains sont placées sur les clés, les développeurs préfèrent raccourcir le cycle de déploiement de code autant que possible. Tout en équilibrant la nécessité d’exécuter leur code par rapport à un environnement en cours d’exécution local qui imite de manière fiable l’environnement de production, le code finira par s’exécuter. Et, avec le moins de sauts possible sur des sites potentiellement latents ou, dans des installations hautement sécurisées, une connexion Internet inexistante. Et, tout aussi important, pour éviter une grande partie des ennuis et du labeur qui découlent des différences entre ces environnements locaux où le code est développé et l’environnement de production à partir duquel le code servira finalement le monde.

Entrez PCF Dev.

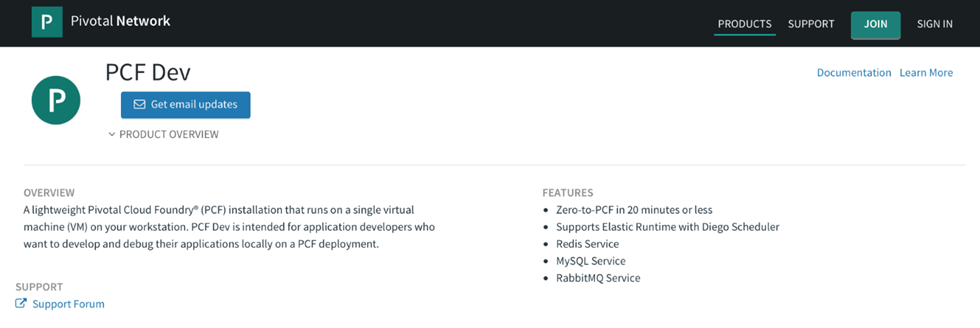

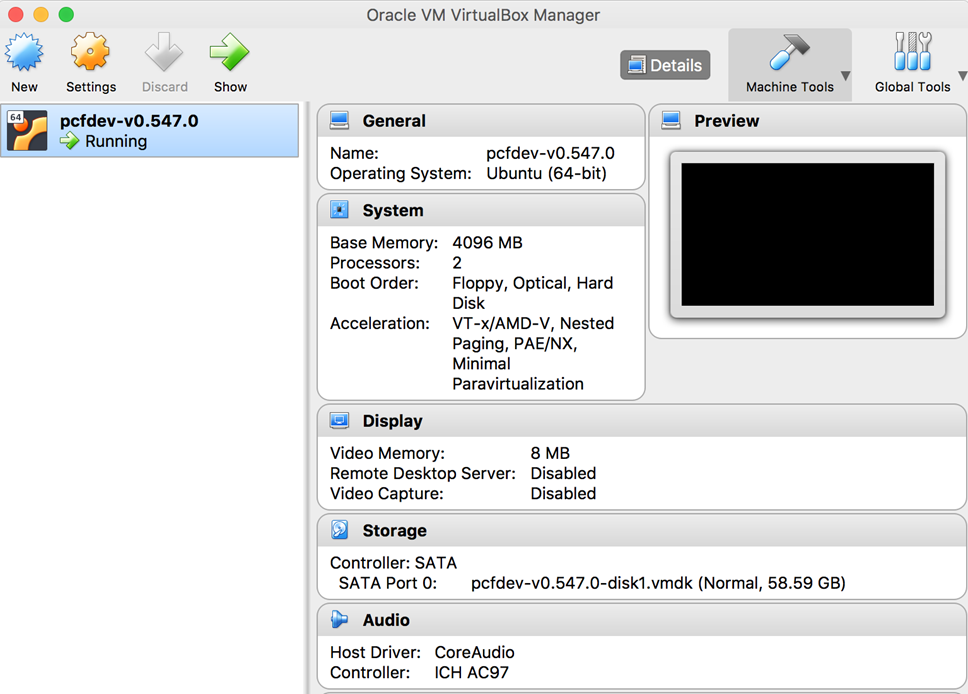

PCF Dev vous permet de pousser des applications vers PCF dès le premier jour de votre projet.

Dans ce chapitre, nous explorerons comment installer PCF Dev de Pivotal pour développer des applications localement. Nous couvrirons les bases de PCF Dev et où il s’intègre dans votre ceinture d’outils en tant que développeur d’applications Cloud Foundry. De plus, PCF Dev est un autre moyen facile de vous présenter au développement d’applications Cloud Foundry ou d’évaluer PCF sans avoir à installer une fondation Cloud Foundry complète. Peut-être, plus important encore, PCF Dev vous permet également d’itérer plus rapidement lors du développement d’applications CF. Vous permettant d’utiliser confortablement TDD dans le cadre de votre flux de travail. Et, si vous êtes déjà développeur CF, PCF Dev peut être une alternative plus simple et plus rapide à BOSH-lite, qui est une autre voie vers le développement de Cloud Foundry qui s’adresse davantage aux ingénieurs de plate-forme, aux administrateurs et aux opérateurs, en particulier si vous ne le faites pas. t besoin d’utiliser BOSH pour déployer des produits supplémentaires au-delà de Cloud Foundry. Et, PCF Dev est un moyen facile de démarrer avec Cloud Foundry avec un minimum d’agitation.

Dans ce chapitre, nous couvrirons les sujets suivants :

- Une brève introduction au TDD

- Pourquoi PCF Dev?

- Exigences techniques PCF

- 20 minutes pour cf push avec PCF Dev

- Alternatives à PCF Dev

3.1 Une brève introduction au TDD

Souvent, en tant que développeurs, nous préférons exécuter nos applications localement pendant que nous les développons. C’est un gain de temps énorme dans de nombreux cas, car nous rincons et répétons les mises à jour ou le débogage tout en exécutant notre code à travers le cycle TDD bien usé de rouge, vert, itéré. Cela signifie que nous commençons par créer un nouveau test qui prouve un aspect d’une fonctionnalité que nous voulons que notre code ait avant que le code de fonctionnalité soit créé, de sorte que le test, lorsqu’il est exécuté, échoue (devient rouge). Nous créons ensuite le code de fonctionnalité réel pour satisfaire le test précédemment écrit qui permet au test de réussir (passer au vert), suivi d’itérations répétées de débogage du code de fonctionnalité ou de création de tests supplémentaires à l’aide du même flux de travail. Le bon effet secondaire de TDD est que, non seulement nous nous retrouvons avec du code qui fonctionne comme prévu – respectant la promesse de valeur que la fonction incarne; mais, nous avons également des tests clairement écrits qui peuvent servir de documentation pour chaque fonctionnalité.

Avec TDD, nous obtenons du code prouvable qui a de nombreux tests qui peuvent être exécutés de manière automatisée chaque fois que nous déployons et exécutons notre dernier code de fonctionnalité. Le résultat le plus important de la création de code prouvable est qu’il nous permet d’apporter des ajouts et des modifications à une base de code existante sans craindre inquiétant de casser les fonctionnalités qui fonctionnent déjà bien, provoquant des échecs difficiles à éliminer et à corriger. La méthodologie TDD crée une couverture contre la régression de la base de code dans un état de bogue involontaire. Essentiellement, lors de l’automatisation de l’exécution du test, nous avons une base de référence vivante de code prouvable qui nous permet d’apporter des modifications en toute confiance, sans craindre que nous ayons accidentellement cassé quelque chose d’autre, quelque part ailleurs dans le code et sans avoir la moindre idée de ce qui s’est mal passé sans creuser profondément dans les recoins d’une base de code qui a peut-être été écrite par quelqu’un d’autre il y a longtemps.

Fait intéressant, il y a cette montée sismique révolutionnaire de DevOps en cours qui remodèle la façon dont les opérateurs de systèmes, les ingénieurs de plate-forme et les administrateurs abordent la construction des infrastructures. Avec DevOps, ils développent maintenant l’infrastructure sous forme de code en utilisant les mêmes processus et techniques reproductibles, idempotents, pilotés par les tests et axés sur l’automatisation CI / CD que les développeurs d’applications sont les praticiens depuis des décennies.

Cela change le monde informatique de manière fondamentale, affectant les processus et les pratiques en place depuis l’aube de l’époque Unix le 1er janvier 1970. Maintenant, avec l’adoption de ces techniques de développement, les rôles opérationnels traditionnels se transforment en ceux de la fiabilité de la plate-forme Des ingénieurs (PRE) hyperfocalisés et orientés vers l’augmentation de la fiabilité de ces plateformes et infrastructures extrêmement complexes qui sont l’axe autour duquel tourne le monde numérique moderne. Pour ce faire, ils créent les mêmes couvertures contre la régression et réduisent les risques tout en offrant une valeur commerciale, comme le fait toute équipe de développement logiciel agile. En utilisant les trois piliers pour favoriser l’excellence opérationnelle et la résilience face au changement.

Cette approche même est profondément encapsulée dans l’installation de Cloud Foundry et les processus du jour 1. Par exemple, il existe des pipelines CI / CD qui, non seulement installent Cloud Foundry sur un IaaS donné; mais qui génèrent l’infrastructure elle-même dans une architecture de référence normalisée, créant les réseaux, renforçant la sécurité, provisionnant la capacité de la mémoire au CPU aux banques de données, et bien plus encore. De plus, il existe des pipelines qui automatisent également les processus de gestion et de maintenance en cours de Cloud Foundry jour 2 – en cours d’exécution en continu pour effectuer des mises à niveau et des correctifs automatisés sans temps d’arrêt, sauvegardant des fondations Cloud Foundry entières, l’intégration des utilisateurs, des organisations et des espaces dans une fondation donnée, repavage de la fondation, rotation régulière des informations d’identification et bien d’autres encore. Et, tous ces pipelines sont définis dans des fichiers texte yaml qui sont écrits comme tout autre code, qui est versionné et archivé dans un référentiel de code – exactement comme le ferait n’importe quel développeur d’application.

Remarque

Tous les pipelines open source Pivotal Cloud Foundry sont disponibles sur: https://github.com/pivotal-cf/pcf-pipelines et https://github.com/pivotalservices/concourse-pipeline-samples .

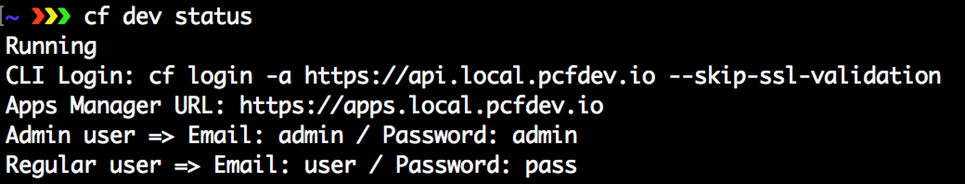

3.2 Pourquoi PCF Dev?