Résumé de la publication

Docker est une plate-forme de conteneur de niveau entreprise qui vous permet de créer et de déployer vos applications. Son format portable vous permet d’exécuter votre code directement depuis vos postes de travail vers les fournisseurs de cloud computing populaires. Ce guide complet améliorera vos flux de travail Docker et garantira le bon fonctionnement de l’environnement de production de votre application.

Cet article commence par un rappel sur la configuration et l’exécution de Docker et détaille la configuration de base pour la création d’un cluster Docker Swarm. Vous apprendrez ensuite à automatiser ce cluster en utilisant Chef Server et Cookbook. Après cela, vous exécuterez le système de surveillance Docker avec Prometheus et Grafana et déploierez la pile ELK. Vous apprendrez également quelques conseils pour optimiser les images Docker.

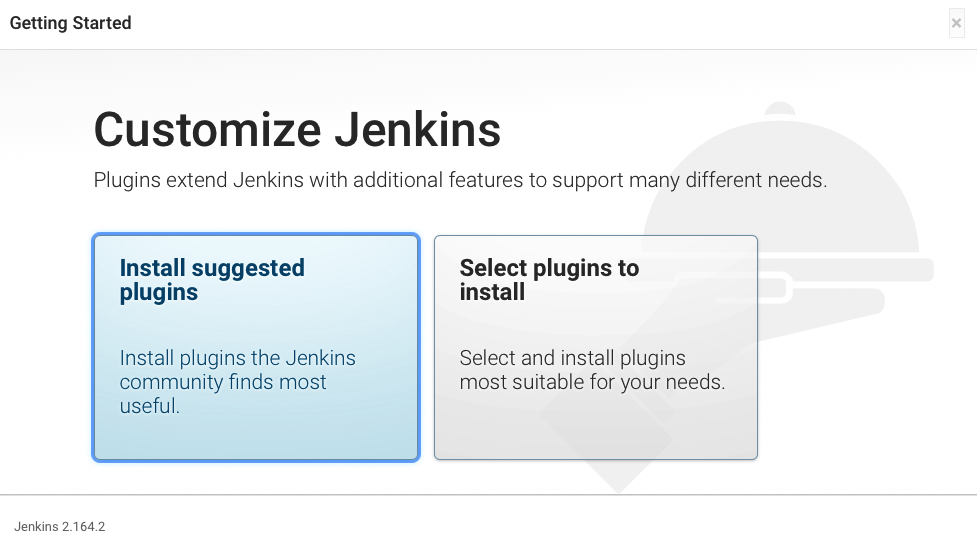

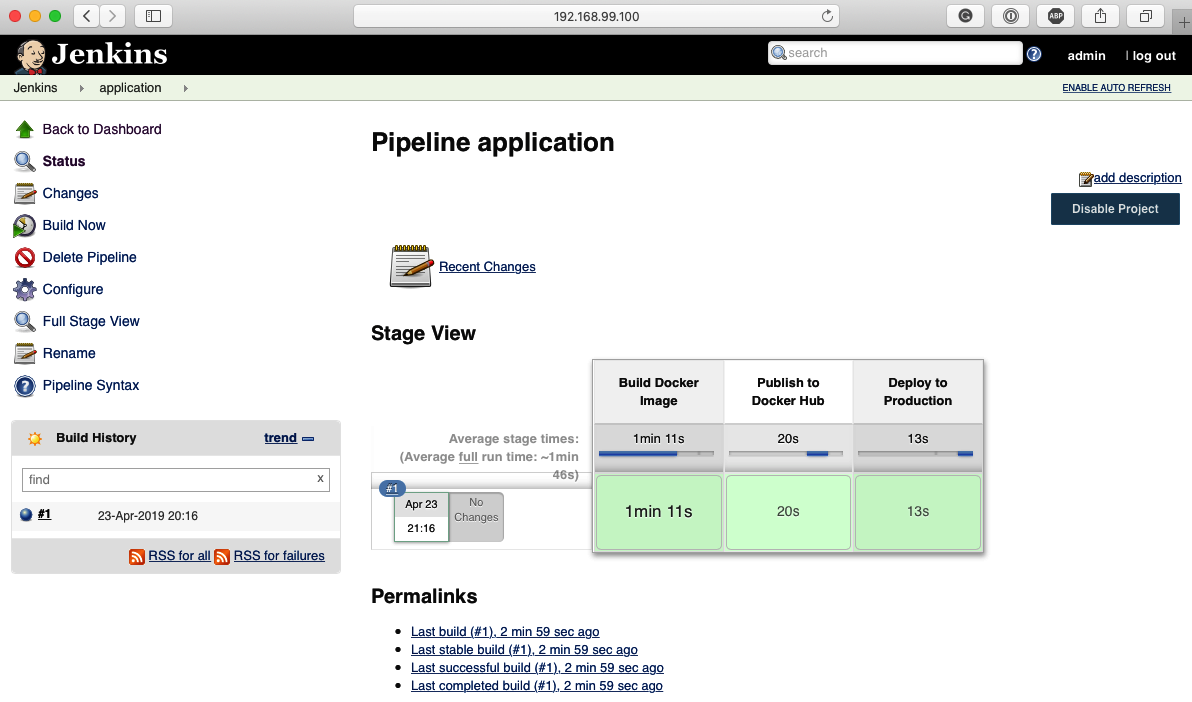

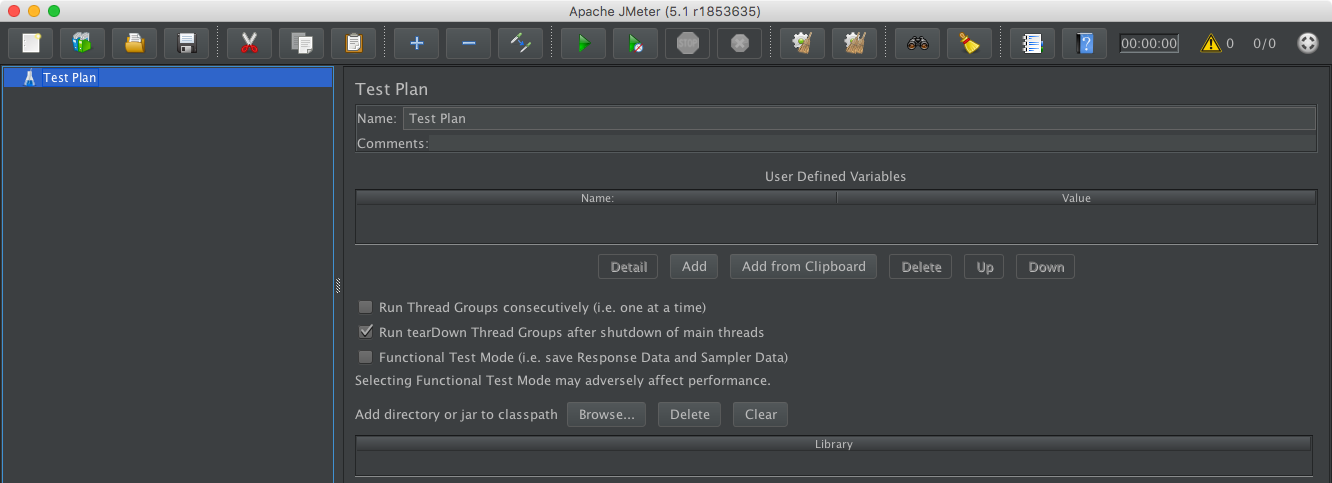

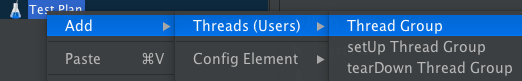

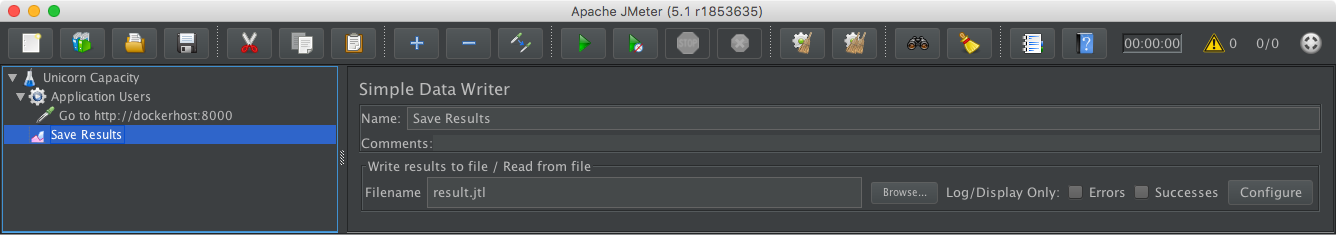

Après avoir déployé des conteneurs à l’aide de Jenkins, vous passerez ensuite à un didacticiel sur l’utilisation d’Apache JMeter pour analyser les performances de votre application. Vous apprendrez comment utiliser Docker Swarm et NGINX pour équilibrer la charge de votre application et comment les outils de débogage courants sous Linux peuvent être utilisés pour dépanner les conteneurs Docker.

À la fin de cet article, vous pourrez intégrer toutes les optimisations que vous avez apprises et tout mettre en pratique dans vos applications.

Objectifs de la publication

- Automatisez le provisionnement et la configuration des nœuds dans un cluster Docker Swarm

- Configurer un système de surveillance avec Prometheus et Grafana

- Utilisez Apache JMeter pour créer des charges de travail pour comparer les performances des conteneurs Docker

- Comprendre comment équilibrer la charge d’une application avec Docker Swarm et Nginx

- Déployer strace, tcdump, blktrace et d’autres outils de débogage Linux pour dépanner les conteneurs

- Intégrez les optimisations Docker pour DevOps, Site Reliability Engineering, CI et CD

Préparation des hôtes Docker

Docker nous permet de fournir des applications à nos clients plus rapidement. Il simplifie les flux de travail nécessaires pour obtenir le code du développement à la production en étant capable de créer et de lancer facilement des conteneurs Docker. Ce chapitre sera un rappel rapide sur la façon de préparer notre environnement à exécuter le flux de travail de développement et d’opérations basé sur Docker en procédant comme suit :

- Préparation d’un hôte Docker

- Activation de l’accès à distance aux hôtes Docker

- Création d’un cluster Docker Swarm

La plupart des parties de ce chapitre sont des concepts que nous connaissons déjà et qui sont facilement disponibles sur le site Web de documentation Docker. Ce chapitre présente les commandes sélectionnées et les interactions avec l’hôte Docker qui seront utilisées dans les chapitres suivants.

Préparation d’un hôte Docker

On suppose que nous savons déjà comment configurer un hôte Docker. Pour la plupart des chapitres de cet article, nous fonctionnerons contre l’environnement suivant, sauf mention explicite :

- Système d’exploitation : CentOS 7.5

- Version Docker : 18.09.0

Les commandes suivantes affichent le système d’exploitation et la version du moteur Docker exécutés dans notre hôte Docker :

$ ssh dockerhost

dockerhost$ lsb_release -a

LSB Version: :core-4.1-amd64:core-4.1-noarch

Distributor ID: CentOS

Description: CentOS Linux release 7.5.1804 (Core)

Release: 7.5.1804

Codename: Core

dockerhost$ docker version

Version: 18.09.0

API version: 1.39

Go version:go1.10.4

Git commit:4d60db4

Built: Wed Nov 7 00:48:22 2018

OS/Arch: linux/amd64

Experimental: false

Server: Docker Engine – Community

Engine:

Version: 18.09.0

API version: 1.39 (minimum version 1.12)

Go version: go1.10.4

Git commit: 4d60db4

Built: Wed Nov 7 00:19:08 2018

OS/Arch: linux/amd64

Experimental: false

Si nous n’avons pas configuré notre environnement Docker, nous pouvons suivre les instructions du site Web Docker disponible sur https://docs.docker.com/install/linux/docker-ce/centos/ pour préparer notre hôte Docker.

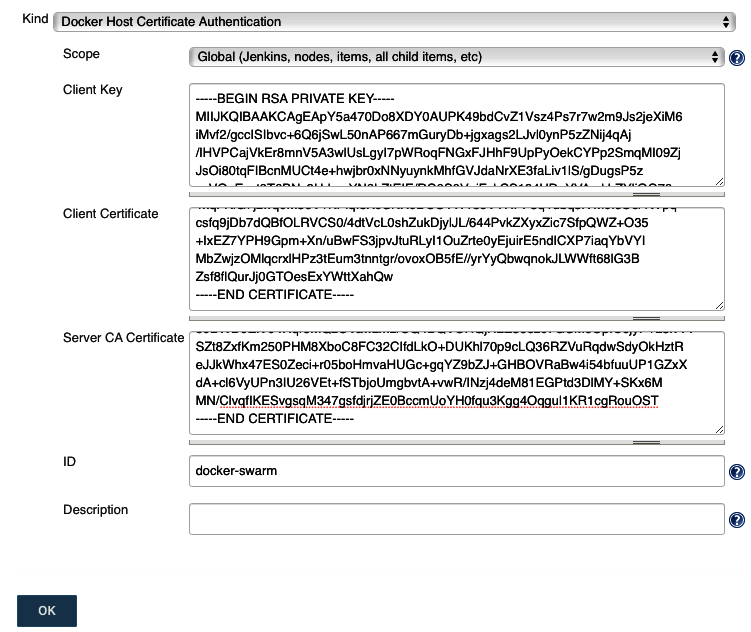

Activation de l’accès à distance

Au lieu de vous connecter à distance à notre hôte Docker pour exécuter des conteneurs, nous accéderons à l’hôte Docker en activant l’API distante dans Docker Engine. Cela nous permet de gérer nos conteneurs Docker à partir de notre poste de travail client ou serveur de livraison continue. Nous interagirons ensuite avec notre hôte Docker pour représenter notre environnement de production. L’API distante sera ensuite utilisée à partir de notre poste de travail client pour effectuer des déploiements de nos conteneurs Docker.

Cette section couvrira les étapes pour sécuriser et activer l’accès à distance à notre hôte Docker :

- Configuration d’une autorité de certification

- Reconfiguration de Docker Engine pour permettre l’accès à distance

- Configuration du client Docker pour l’accès à distance

Configuration d’une autorité de certification

Pour le reste de cette section, nous allons installer des certificats TLS sur notre serveur hôte et client Docker. Pour assurer une communication fiable entre le serveur et le client, nous allons mettre en place une infrastructure à clé publique (PKI). Cela permettra au moteur Docker en cours d’exécution sur notre hôte et à notre client Docker d’établir la connexion pour vérifier l’identité l’un de l’autre.

La première étape de la création de l’ICP consiste à configurer l’autorité de certification (CA). Une autorité de certification est un tiers de confiance qui délivre des certificats numériques aux membres de notre infrastructure à clé publique, à savoir notre hôte et client Docker.

Dans les prochaines étapes, nous allons configurer notre autorité de certification à l’intérieur de notre poste de travail client :

1. Tout d’abord, nous allons créer un répertoire pour notre PKI et générer la clé privée de l’autorité de certification dans un fichier appelé ca-key.pem :

client$ mkdir ~/ca

client$ cd ~/ca

client$ openssl genrsa -aes256 -out ca-key.pem 4096

Generating RSA private key, 4096 bit long modulus

………………………………..++

…………………………………………++

e is 65537 (0x10001)

Enter pass phrase for ca-key.pem: ****

Verifying — Enter pass phrase for ca-key.pem: ****

Nous devons nous souvenir des mots de passe définis pour la clé privée de notre autorité de certification, car nous en aurons toujours besoin pour le reste de ce chapitre.

2. Ensuite, nous nous assurons que cette clé privée est sécurisée en nous restreignant l’accès en lecture et en écriture :

client$ chmod 600 ca-key.pem

client$ ls -l ca-key.pem

-rw——-. 1 dockeruser group 3326 Dec 2 20:45 ca-key.pem

3. Enfin, nous allons générer un certificat auto-signé pour notre autorité de certification. Laissez ‘ s tapez la commande suivante pour placer le certificat auto-signé dans un fichier appelé ca.pem :

client$ openssl req -key ca-key.pem -new -x509 \

-subj ‘/CN=Certificate Authority’ \

-sha256 -days 365 -out ca.pem

Enter pass phrase for ca-key.pem: ****

Nous avons maintenant une autorité de certification et nous distribuerons son certificat ca.pem à notre hôte et client Docker plus tard dans cette section. Pour l’instant, « inspectent s le certificat génèrent :

client$ cat ca.pem

—–BEGIN CERTIFICATE—–

MIIFEzCCAvugAwIBAgIJAM19ce5sap+kMA0GCSqGSIb3DQEBCwUAMCAxHjAcBgNV

BAMMFUNlcnRpZmljYXRlIEF1dGhvcml0eTAeFw0xODEyMDYwMzQ5MTNaFw0xOTEy

MDYwMzQ5MTNaMCAxHjAcBgNVBAMMFUNlcnRpZmljYXRlIEF1dGhvcml0eTCCAiIw

DQYJKoZIhvcNAQEBBQADggIPADCCAgoCggIBAKCESs7QpRZ78v8p2nKomCGABqCN

b3E0vBpjveTnjA4kOEWVsHloq2o66yuuNff75GNWghzq791KyKJOy/dehNL9DauA

DD3DJh0+uaOGn547W827Z37wJ64acNyvIQjyiyeLrpF4BzzxaZ/AJFVgqar5Kuqc

qiOG3GUYcnfu6mpmlKoa1XqBtSQ+A2fd4/mpXC0zrDrz9MSEOCs5/Xm6/faexYae

V8gBkCYWiUVUi+RRRc2vU1LzuiI5FsXmD3kNHCjNIbYIoyqKMzbTJjEffhN+5B/V

Rc3qfRmfoEv8P0Hc4Wx55qH8BLWwhvNFAZ+nre+j7zPz+dTfLVyveOPxErHaI1V8

WH9qEVf+haNqUBrjNCuL+xyVNx7evPygD88jyZDWLK5Y0JTh2GSPqMeVi3hSKzNP

GbVjT8tmkCUEsYbSJg2vkPYJR4aC8LLdJsjr7wkWBF1IcYYZpLo3EsUnkjNi7MGS

pGdLob3UtoekXaA1D6esDhlEB+3Tt/RWJkS91ijUiDs2kTSmDfnxUQGyeD4wx/rj

lPFRSLdUUYiFcdI5VegZVSqYxW/Qw2/t+GvoLkrOrggqY1f++XugK5hSoT8EqgiG

SjapkgphMEquVP8UlZ3jC0VmgwFnRUEdqau6yLWMYG6TvLkyVi1Vmfam7CoB1aDn

TccUszk+rezX+1nJAgMBAAGjUDBOMB0GA1UdDgQWBBTrqfPKO0i2peZ6Hd/BYOMq

WXD9kDAfBgNVHSMEGDAWgBTrqfPKO0i2peZ6Hd/BYOMqWXD9kDAMBgNVHRMEBTAD

AQH/MA0GCSqGSIb3DQEBCwUAA4ICAQCa6SPGncEZSWu0WLfkh1mERa9JfBQzJFpv

1E7M3tZeFyJS7LfXdcf9WEAaWqTpha87A+5g9uBi/whYk47dyTik07/k+CyF112i

9GXK8j/UNCjAMOSluOCxpIsmMXp2Dn+ma21msN1K/lHK0ZhGWB9ZDggvdzRRPjic

Dq3aQ49ATHQHGg9cqgZO0zXtcQYaHfCNds5YLNVL66eDhuN91V2MEqWtRDHfr0vA

F3KldXfQ/clnrjGLqo7a3oR1R4QofQ03bV+PRIgub+l3Fee1D68BqF9dLRjUABd2

zm5OzNAmmHPSGWGvOxylvPrUS0ulUzMUWdoXN85SDdLHFXTXwpbD/GgqK+Y3BtgO

7d+mOoTHVEdw2gUXLaqeEchBge2Kh/LqtiN7Zp8OY7snX66Z8tF6W2MKhnSpDzcW

J4WmbmaRqsTEeaRk0aTWkhBZukSZf4zjaa/abF+iRvU5c1OGS9GmYfuGq3Tlj+Xo

JZNuKp9HzOPaj8qiD0DJW9EnuZ24zzpDSiSdmOdARcaaFFKhW8i+SVP6VqrAR3Nb

OL8ne6w6kdoiq4+hPKfWVS9Yh0aQstJMNP91Nnw3J+aRz9eN03jpl/z18vHhW/xl

nYJrB2KlC7SonUT7TMJr4O5Aw1SidxMH6NliiC1jbTWXDMuYL8UghDIk9Ne/WhBd

qg0sW+boLw==

—–END CERTIFICATE—–

Activation de l’accès à distance dans Docker Engine

Maintenant que nous avons une autorité de certification pour notre infrastructure à clé publique, nous pouvons l’utiliser pour vérifier l’identité de notre hôte Docker. Les étapes suivantes prépareront l’identité de notre hôte Docker :

1. Tout d’abord, nous nous connectons à notre hôte Docker. Ici, nous générerons une clé privée qui sécurisera l’API distante servie en exécutant Docker Engine. La commande suivante enregistrera la clé privée dans un fichier appelé /etc/docker/server-key.pem :

dockerhost$ openssl genrsa -out /etc/docker/server-key.pem 2048

Generating RSA private key, 2048 bit long modulus

…………………………..+++

……..+++

e is 65537 (0x10001)

2. Ensuite, nous nous assurons que ce fichier est sécurisé et accessible uniquement par le démon Docker Engine (via l’utilisateur root):

dockerhost$ chmod 600 /etc/docker/server-key.pem

dockerhost$ ls -l /etc/docker/server-key.pem

-rw——-. 1 root root 1675 Dec 2 21:09 /etc/docker/server-key.pem

3. Maintenant que la clé privée est prête, nous allons utiliser ce fichier pour générer une demande de signature de certificat (CSR). La commande suivante openssl req générera une CSR:

dockerhost$ openssl req -key /etc/docker/server-key.pem

-new -subj “/CN=dockerhost” -sha256 -out

dockerhost.csr

dockerhost$ ls -l dockerhost.csr

-rw-r—r–. 1 root root 891 Dec 2 21:33 dockerhost.csr

4. Ensuite, nous revenons à notre poste de travail client où les fichiers de notre autorité de certification sont hébergés. Ici, nous téléchargerons la CSR à partir de notre hôte Docker :

client$ scp dockerhost:~/dockerhost.csr dockerhost.csr

dockerhost.csr 100% 891 1.5MB/s 00 :00

5. Nous préparons maintenant un fichier de configuration OpenSSL server-ext.cnf qui indique que les certificats que notre autorité de certification délivrera sont utilisés pour l’authentification du serveur:

extendedKeyUsage = serverAuth

6. Enfin, nous pouvons signer le CSR avec notre CA. La commande suivante placera notre hôte Docker ‘ certificat signé dans un fichier appelé dockerhost.pem :

client$ cd ~/ca

client$ openssl x509 -req -CA ca.pem -Cakey ca-key.pem \

-Cacreateserial -extfile server-ext.cnf \

-in dockerhost.csr -out dockerhost.pem

Signature ok

subject=/CN=dockerhost

Getting CA Private Key

Enter pass phrase for ca-key.pem: ****

Maintenant que l’identité de notre hôte Docker est vérifiée par notre autorité de certification, nous pouvons maintenant activer le port TCP sécurisé dans notre hôte Docker. Nous allons afficher l’API distante sécurisée avec les étapes suivantes :

- Maintenant revenir dans notre hôte Docker. Ici, nous allons copier les certificats de notre hôte Docker et de notre autorité de certification depuis notre poste de travail client:

dockerhost$ scp client:~/ca/ca.pem /etc/docker/ca.pem

ca.pem 100% 1911 1.1MB/s 00:00

dockerhost$ scp client:~/ca/dockerhost.pem /etc/docker/server.pem

dockerhost.pem 100% 1428 1.2MB/s 00 :00

2. Maintenant que nos actifs TLS sont en place, laissez ‘ s reconfigurer maintenant le fichier démon Engine Docker, /etc/docker/daemon.json , d’utiliser ces certificats:

{

“tlsverify”: true,

“tlscacert”: “/etc/docker/ca.pem”,

“tlskey”: “/etc/docker/server-key.pem”,

« tlscert » : « /etc/docker/server.pem »

}

3. Ensuite, nous configurons le démon Docker Engine pour écouter un port sécurisé en créant un fichier de remplacement 1 ystem / etc / 1 ystem /system/docker.service.d/override.conf :

[Service]

ExecStart=

ExecStart=/usr/bin/dockerd -H unix:// -H tcp://0.0.0.0:2376

4. Enfin, nous sommes maintenant prêts à redémarrer Docker Engine:

dockerhost$ systemctl daemon-reload

dockerhost$ systemctl restart docker.service

Notre hôte Docker est maintenant prêt et sert une API sécurisée.

Connexion à distance à partir du client Docker

Maintenant que notre hôte Docker est sécurisé, il ne répondra pas encore aux demandes de notre client Docker. L’hôte Docker ne répondra qu’aux demandes des clients vérifiées par notre autorité de certification.

Les étapes suivantes généreront une identité pour notre client Docker :

1. Tout d’abord, laissez ‘ s générer la clé privée de notre client Docker dans ~ / .docker / key.pem :

client$ openssl genrsa -out ~/.docker/key.pem 4096

Generating RSA private key, 4096 bit long modulus

……………….++

…………………………………………………++

e is 65537 (0x10001)

2. Ensuite, nous nous assurons que cette clé privée nous est réservée pour la visualisation :

client$ chmod 600 ~/.docker/key.pem

3. Nous générons maintenant la CSR pour le client dans un fichier appelé client.csr :

client$ openssl req -subj ‘/CN=client’ -new \

-key ~/.docker/key.pem -out client.csr

4. Maintenant que notre CSR est prête, nous allons maintenant créer une configuration OpenSSL pour indiquer que les certificats seront utilisés pour l’authentification du client. La commande OpenSSL suivante crée cette configuration dans un fichier appelé ~ / ca / client-ext.cnf :

extendedKeyUsage = clientAuth

5. Enfin, nous sommes prêts à émettre le certificat pour notre client Docker. La commande suivante écrit le certificat de notre client Docker dans ~ / .docker / cert.pem :

client$ openssl x509 -req -CA ca.pem

-Cakey ca-key.pem -Cacreateserial

-extfile client-ext.cnf -in

~/client.csr -out ~/.docker/cert.pem

Signature ok

subject=/CN=client

Getting CA Private Key

Enter pass phrase for ca-key.pem: ****

6. Enfin, nous indiquons à notre client Docker que nous nous connecterons en toute sécurité à notre hôte Docker distant en exportant les variables d’environnement suivantes :

client$ cp ca.pem ~/.docker/ca.pem

7. Enfin, nous indiquons à notre client Docker que nous nous connecterons en toute sécurité à notre hôte Docker distant en exportant les variables d’environnement suivantes :

client$ export DOCKER_HOST=tcp://dockerhost:2376

client$ export DOCKER_TLS_VERIFY=true

Toutes nos félicitations ! Nous avons maintenant un canal de communication sécurisé entre notre client Docker et l’hôte Docker. Pour vérifier la connexion, nous pouvons exécuter la commande suivante et afficher des informations sur notre hôte Docker distant :

client$ docker info

Création d’un cluster Docker Swarm

Docker a introduit le mode Swarm dans son moteur Docker à partir de la version 1.12.0. Docker Swarm nous permet de regrouper plusieurs hôtes Docker pour déployer nos conteneurs de manière évolutive et à haute disponibilité. Dans cette section, nous allons construire un petit cluster Docker Swarm.

Plongeons dans la construction de notre cluster avec les étapes suivantes :

1. Tout d’abord, nous allons aller sur notre hôte Docker et l’initialiser en tant que gestionnaire. Le gestionnaire est responsable du maintien de l’état de notre cluster Docker Swarm. Il envoie également des tâches aux autres hôtes Docker de notre cluster. Tapons la commande suivante pour commencer l’initialisation :

dockerhost$ docker swarm init

Swarm initialized: current node (w49smc2ciy100gaecgx77yir3)

is now a manager

To add a worker to this swarm, run the following command:

docker swarm join –token SWMTKN-1-4wbs…aq2r \

172.16.132.187:2377

La commande précédente a généré un jeton qui sera utilisé par d’autres hôtes Docker pour rejoindre notre cluster.

2. Ensuite, nous irons à un nouvel hôte Docker appelé node1. Nous utilisons le jeton de l’étape précédente pour que cet hôte Docker rejoigne notre cluster Docker Swarm en tant que travailleur. Les travailleurs sont membres du cluster qui sont responsables de la gestion de nos conteneurs. Tapons maintenant la commande suivante pour que ce nouveau nœud rejoigne notre cluster :

node1$ docker swarm join –token SWMTKN-1-4…aq2r \ 172.16.132.187:2377

This node joined a swarm as a worker.

Nous pouvons étendre notre cluster Docker Swarm en ajoutant plus de gestionnaires et de travailleurs à l’aide de la même commande Docker Swarm join . Plus de détails peuvent être trouvés dans la documentation Docker en amont à https://docs.docker.com/engine/swarm/join-nodes.

Nous avons maintenant terminé la configuration de notre cluster Docker Swarm. Revenons à notre poste de travail client Docker et confirmons les membres de notre cluster :

client$ docker node ls

ID HOSTNAME STATUS AVAILABILITY MANAGER STATUS ENGINE VERSION

w49smc * dockerhost Ready Active Leader 18.09.0

2e0aif node1 Ready Active 18.09.0

Résumé

J’espère qu’à ce stade, nous nous sommes familiarisés avec l’interaction avec Docker Engine. Nous avons préparé un hôte Docker où nous gérerons nos conteneurs. Nous avons construit une PKI pour assurer une communication sécurisée entre notre hôte Docker et notre station de travail client Docker, et nous avons construit un petit cluster Docker Swarm composé de plusieurs hôtes Docker.

Nous avons accompli tout cela en nous connectant aux serveurs et en tapant manuellement les commandes de configuration. Dans le chapitre suivant, nous apprendrons à automatiser le provisionnement de ces hôtes Docker et à nous éviter de taper !

Configuration de Docker avec Chef

Maintenant, nous connaissons déjà les différents aspects de l’écosystème Docker. L’hôte Docker a plusieurs paramètres de configuration. Cependant, la configuration manuelle des hôtes Docker est un processus lent et sujet aux erreurs. Nous aurons des problèmes pour faire évoluer nos déploiements Docker en production si nous n’avons pas de stratégie d’automatisation en place.

Dans ce chapitre, nous apprendrons le concept de gestion de configuration pour résoudre ce problème. Nous utiliserons Chef, un logiciel de gestion de configuration, pour gérer les hôtes Docker à grande échelle. Ce chapitre couvrira les sujets suivants :

- Importance de la gestion de la configuration

- Utilisation de Chef

- Provisionnement des hôtes Docker

- Configuration du mode Docker Swarm

- Outils d’automatisation alternatifs

Importance de la gestion de la configuration

Le moteur Docker a plusieurs paramètres à régler, tels que les groupes de contrôle, la mémoire, le processeur, les systèmes de fichiers, la mise en réseau, etc. L’identification des conteneurs Docker exécutés sur les hôtes Docker est un autre aspect de la configuration. Obtenir la combinaison de paramètres pour optimiser notre application prendra du temps.

La réplication de tous les éléments de configuration précédents vers un autre hôte Docker est difficile à effectuer manuellement. Nous ne nous souvenons peut-être pas de toutes les étapes requises pour créer un hôte, et c’est un processus lent et sujet aux erreurs. La création de documentation pour capturer ce processus n’aide pas non plus, car ces artefacts ont tendance à devenir périmés au fil du temps.

Si nous ne pouvons pas approvisionner de nouveaux hôtes Docker en temps opportun et de manière fiable, nous n’aurons pas d’espace pour étendre notre application Docker. Par conséquent, il est important de préparer et de configurer nos hôtes Docker de manière cohérente et rapide. Sinon, la capacité de Docker à créer des packages de conteneurs pour notre application deviendra rapidement inutile.

La gestion de la configuration est une stratégie pour gérer les changements qui se produisent dans tous les aspects de notre application, et elle rend compte et vérifie les modifications apportées à notre système. Cela ne s’applique pas uniquement lors du développement de notre application. Pour notre cas, il enregistre toutes les modifications apportées à nos hôtes Docker. Docker, dans un sens, accomplit les aspects suivants de la gestion de la configuration de notre application :

- Les conteneurs Docker reproduisent n’importe quel environnement pour notre application, du développement à la préparation, au test et à la production.

- La création d’images Docker est un moyen simple de modifier les applications et de les déployer dans tous les environnements.

- Docker permet à tous les membres de l’équipe d’obtenir des informations sur notre application et d’apporter les modifications nécessaires pour fournir efficacement le logiciel aux clients. En inspectant le Dockerfile , ils peuvent savoir quelle partie de l’application doit être mise à jour et ce dont elle a besoin pour fonctionner correctement.

- Docker suit tout changement dans notre environnement vers une image Docker particulière. Ensuite, il le retrace à la version correspondante du Dockerfile. Il retrace ce qu’est le changement, qui l’a fait et quand il a été fait.

Mais qu’en est-il de l’hôte Docker exécutant notre application ? Tout comme un Dockerfile nous permet de gérer l’environnement de notre application dans le contrôle de version, les outils de gestion de la configuration peuvent décrire nos hôtes Docker en code. Il simplifie le processus de création d’hôtes Docker. Dans le cas de l’extension de notre application Docker, nous pouvons recréer un nouvel hôte Docker à partir de zéro facilement. En cas de panne matérielle, nous pouvons faire apparaître de nouveaux hôtes Docker ailleurs dans leur configuration connue. La gestion de la configuration nous permet de gérer nos déploiements Docker à grande échelle.

Dans la section suivante, nous allons configurer Chef comme système de gestion de configuration pour notre infrastructure Docker.

Utilisation de Chef

Chef est un outil de gestion de configuration qui fournit un langage spécifique au domaine pour modéliser la configuration de notre infrastructure. Chaque élément de configuration de notre infrastructure est modélisé comme une ressource. Une ressource est essentiellement une méthode Ruby qui accepte plusieurs paramètres dans un bloc. L’exemple de ressource suivant décrit l’installation du package docker-engine :

package ‘docker-engine’ do

action :install

end

Ces ressources sont ensuite écrites ensemble dans des fichiers source Ruby appelés recettes. Lors de l’exécution d’une recette sur un serveur (un hôte Docker dans notre cas), toutes les ressources définies sont exécutées pour atteindre la configuration d’état souhaitée.

Certaines recettes Chef peuvent dépendre d’autres éléments supplémentaires, tels que les modèles de configuration et d’autres recettes. Toutes ces informations sont rassemblées dans les cookbook avec les recettes. Un cookbook est une unité fondamentale pour distribuer la configuration et la politique à nos serveurs.

Nous allons écrire des recettes Chef pour représenter la configuration d’état souhaitée de nos hôtes Docker. Nos recettes seront organisées dans des cookbook Chef pour les diffuser dans notre infrastructure. Cependant, tout d’abord, préparons notre environnement Chef afin de pouvoir commencer à décrire notre infrastructure Docker dans des recettes. Un environnement Chef comprend trois éléments :

- Un serveur Chef

- Un poste de travail

- Un nœud

Les prochaines sous-sections vous donneront une description détaillée de chaque composant. Ensuite, nous les configurerons pour préparer notre environnement Chef afin de pouvoir gérer notre hôte Docker.

Il y a plus de détails sur la configuration d’un environnement Chef qui sortent du cadre de ce chapitre. Plus d’informations peuvent être trouvées sur le site Web de documentation de Chef à http://docs.chef.io .

Inscription à un serveur Chef

Le serveur Chef est le référentiel central des cookbook et d’autres éléments de politique régissant l’ensemble de notre infrastructure. Il contient des métadonnées sur l’infrastructure que nous gérons. Dans notre cas, le serveur Chef contient le cookbook, la politique et les métadonnées sur notre hôte Docker.

Pour préparer un serveur Chef, nous allons simplement nous inscrire à un serveur Chef hébergé. Un compte de serveur Chef gratuit nous permet de gérer jusqu’à cinq nœuds dans notre infrastructure. Suivez les étapes suivantes pour préparer un compte de serveur Chef hébergé :

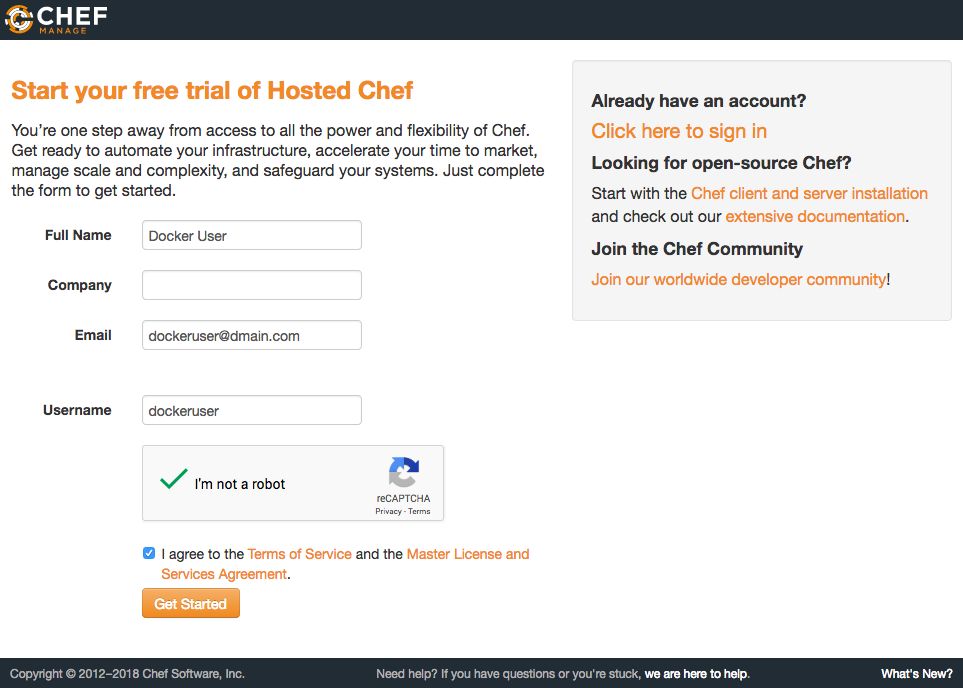

1. Accédez à https://manage.chef.io/signup et remplissez le formulaire pour les détails de notre compte, comme indiqué dans la capture d’écran suivante :

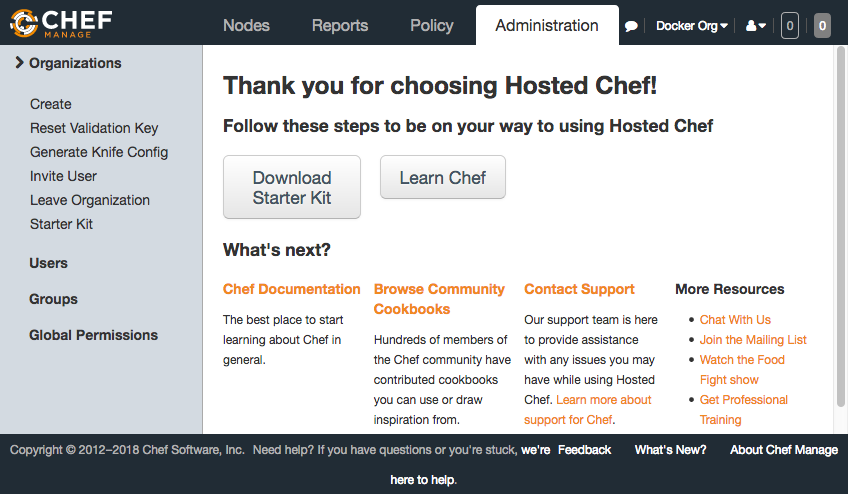

2. Après avoir créé un compte utilisateur, le serveur Chef hébergé va maintenant nous inviter à créer une organisation. Les organisations sont simplement utilisées pour gérer le contrôle d’accès basé sur les rôles pour notre serveur Chef. Créez une organisation en fournissant les détails sur le formulaire et cliquez sur le bouton Créer une organisation.

3. Nous avons maintenant presque terminé d’obtenir notre compte de serveur Chef hébergé. Enfin, cliquez sur Télécharger le kit de démarrage. Cela va télécharger un fichier ZIP contenant notre chef-repo de démarrage. Nous parlerons plus du chef-repo dans la section suivante :

Configuration de notre poste de travail

La deuxième partie de notre environnement Chef est le poste de travail. Le poste de travail est utilisé pour interagir avec le serveur Chef. C’est là que nous ferons la plupart du travail de préparation et créerons le code à envoyer au serveur Chef. Dans notre poste de travail, nous préparerons les éléments de configuration de notre infrastructure dans un référentiel Chef.

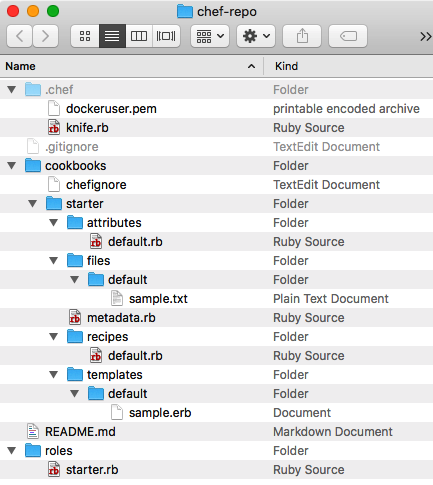

Le référentiel Chef contient toutes les informations nécessaires pour interagir et se synchroniser avec le serveur Chef. Il contient la clé privée et les autres fichiers de configuration nécessaires pour s’authentifier et interagir avec le serveur Chef. Ces fichiers se trouvent dans le répertoire chef de notre référentiel Chef. Il contient également les cookbook que nous écrirons et synchroniserons plus tard avec le serveur Chef dans le répertoire cookbook / . Il existe d’autres fichiers et répertoires dans un référentiel Chef, tels que des sacs de données, des rôles et des environnements. Cependant, il suffit, pour l’instant, de connaître les cookbook et les fichiers d’authentification pour pouvoir configurer notre hôte Docker.

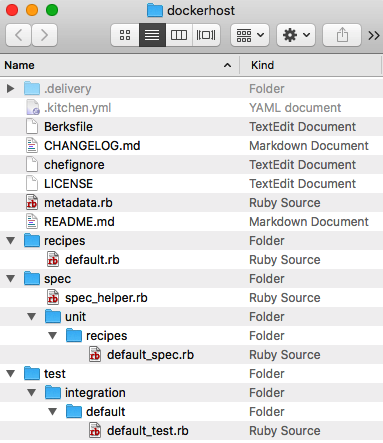

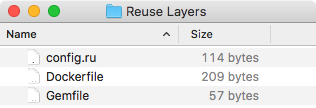

Vous souvenez-vous du kit de démarrage que nous avons téléchargé dans la section précédente ? Vous devez décompresser ce fichier pour extraire notre chef-repo. Nous devrions avoir les fichiers suivants décrits dans l’arborescence des répertoires :

Un autre composant important de notre poste de travail est le Kit de développement Chef. Il contient tous les programmes nécessaires pour lire toute la configuration de notre chef-repo et interagir avec le serveur Chef. Des programmes pratiques pour créer, développer et tester nos cookbook sont également disponibles dans le Kit de développement Chef. Nous utiliserons divers programmes dans le kit de développement tout au long de ce chapitre.

Maintenant, téléchargeons le Kit de développement Chef à partir de https://downloads.chef.io/chefdk selon la plate-forme de notre station de travail.

Ensuite, ouvrez le programme d’installation téléchargé. Installez le Kit de développement Chef selon les invites de notre plateforme. Enfin, confirmez que l’installation a réussi avec la commande suivante :

$ chef -v

Chef Development Kit Version: 3.5.13

chef-client version: 14.7.17

delivery version: master (6862f27aba89109a9630f0b6c6798efec56b4efe)

berks version: 7.0.6

kitchen version: 1.23.2

inspec version: 3.0.52

Maintenant que nous avons configuré notre poste de travail, allons dans notre répertoire chef-repo / pour préparer le dernier composant de notre environnement Chef.

Nœuds d’amorçage

La dernière partie de notre environnement Chef est constituée des nœuds. Un nœud est un ordinateur géré par Chef. Il peut s’agir d’une machine physique, d’une machine virtuelle, d’un serveur dans le cloud ou d’un périphérique réseau. Dans notre cas, notre hôte Docker est un nœud. Dans les prochaines étapes, nous allons configurer les hôtes Docker suivants :

- dockerhost : servira de Docker Swarm Manager

- node1 : se connectera en tant que nœud Docker Swarm à notre cluster

Le composant central de tout nœud à gérer par Chef est le chef-client. Il se connecte au serveur Chef pour télécharger les fichiers nécessaires pour amener notre nœud à son état de configuration. Lorsqu’un chef-client est exécuté sur notre nœud, il effectue les étapes suivantes :

- Il enregistre et authentifie le nœud avec le serveur Chef

- Il rassemble des informations système dans notre nœud pour créer un objet nœud

- Ensuite, il synchronise les cookbook Chef nécessaires à notre nœud

- Il compile les ressources en chargeant les recettes nécessaires de notre nœud

- Ensuite, il exécute toutes les ressources et effectue les actions correspondantes pour configurer notre nœud

- Enfin, il signale le résultat de l’exécution du client-chef sur le serveur Chef et d’autres points de terminaison de notification configurés.

Maintenant, préparons notre hôte Docker en tant que nœud en l’amorçant à partir de notre poste de travail. Le processus d’amorçage se connectera à notre nœud et installera le chef-client. Exécutez la commande suivante pour démarrer ce processus d’amorçage :

$ cd ~/chef-repo

$ knife bootstrap dockerhost -N dockerhost

Creating new client for dockerhost

Creating new node for dockerhost

Connecting to dockerhost

dockerhost —–> Installing Chef Omnibus (-v 14)

…

dockerhost Installing chef 14

dockerhost installing with rpm…

dockerhost warning: /tmp/install.sh.24627/chef-14.7.17-1.el7.x86_64.rpm: Header V4 DSA/SHA1 Signature, key ID 83ef826a: NOKEY

dockerhost Preparing… ################################# [100%]

dockerhost Updating / installing…

dockerhost 1:chef-14.7.17-1.el7 ################################# [100%]

dockerhost Thank you for installing Chef!

dockerhost Starting the first Chef Client run…

dockerhost Starting Chef Client, version 14.7.17

dockerhost resolving cookbooks for run list: []

dockerhost Synchronizing Cookbooks:

dockerhost Installing Cookbook Gems:

dockerhost Compiling Cookbooks…

dockerhost [2018-12-09T03:18:19+00:00] WARN: Node dockerhost has an empty run list.

dockerhost Converging 0 resources

dockerhost

dockerhost Running handlers:

dockerhost Running handlers complete

dockerhost Chef Client finished, 0/0 resources updated in 03 seconds

Comme nous pouvons le constater dans la commande précédente, le processus d’amorçage a fait deux choses. Tout d’abord, il a installé et configuré le chef-client sur notre nœud hôte Docker. Ensuite, il a démarré le chef-client pour synchroniser son état souhaité avec notre serveur Chef. Comme nous n’avons pas encore attribué d’état conçu à notre hôte Docker, cela n’a rien fait.

Enfin, fournissons le reste de nos hôtes Docker :

$ knife bootstrap node1 -N node1

Nous pouvons personnaliser ce processus d’amorçage selon nos besoins. Pour plus d’informations sur l’utilisation du bootstrap au couteau, rendez -vous sur http://docs.chef.io/knife_bootstrap.html. Dans certains cas, les fournisseurs de cloud ont déjà une intégration profonde de Chef. Donc, au lieu du bootstrap au couteau, nous allons simplement utiliser le SDK du fournisseur de cloud. Là, il suffit de préciser que nous voulons intégrer Chef. Nous lui fournirons les informations, telles que la configuration client.rb du chef-client et les informations d’identification des clés de validation.

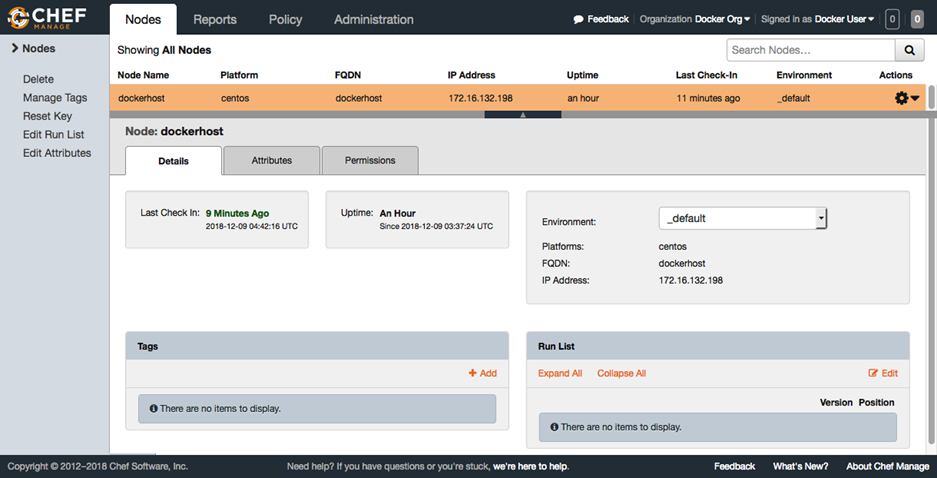

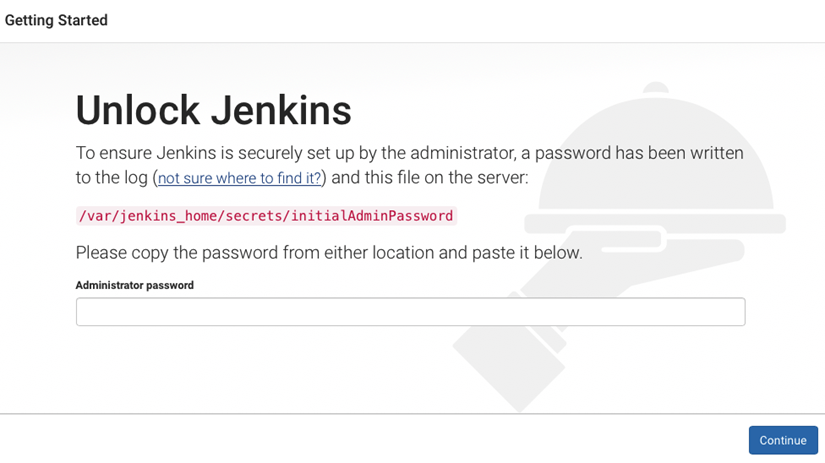

Notre hôte Docker est désormais correctement enregistré sur le serveur Chef, prêt à saisir sa configuration. Accédez à https://manage.chef.io/organizations/dockerorg/nodes/dockerhost pour vérifier notre hôte Docker en tant que nœud dans notre environnement Chef, comme indiqué dans la capture d’écran suivante :

Dans la section suivante, nous allons spécifier la configuration de nos hôtes Docker avec Chef.

Configuration de l’hôte Docker

Maintenant que tous les composants de notre environnement Chef sont correctement configurés, nous pouvons commencer à écrire des recettes Chef pour décrire réellement la configuration que nos hôtes Docker devraient avoir. De plus, nous dépasserons notre productivité en tirant parti des cookbook Chef existants dans l’écosystème Chef. Comme Docker est une pile d’infrastructure populaire à déployer, nous pouvons utiliser des cookbook à l’état sauvage qui nous permettent de configurer nos hôtes Docker. Les cookbook du chef fournis par la communauté se trouvent dans le supermarché Chef. Nous pouvons aller sur http://supermarket.chef.io pour découvrir d’autres cookbook que nous pouvons facilement utiliser.

Dans cette section, nous apprendrons à écrire des recettes Chef et à les appliquer à notre nœud.

Rédaction de recettes de chef

Les prochaines étapes nous montrent comment écrire la recette du chef pour notre hôte Docker:

1. Utilisons la commande chef générer du cookbook du kit de développement Chef pour générer un passe-partout pour notre cookbook. Après être entré dans le répertoire des cookbook, exécutez la commande suivante :

$ cd cookbooks

$ chef generate cookbook dockerhost

Generating cookbook dockerhost

– Ensuring correct cookbook file content

– Ensuring delivery configuration

– Ensuring correct delivery build cookbook content

Your cookbook is ready. Type `cd dockerhost` to enter it.

There are several commands you can run to get started locally

developing and testing your cookbook.

Type `delivery local –help` to see a full list.

Why not start by writing a test? Tests for the default recipe are stored at:

test/integration/default/default_test.rb

If you’d prefer to dive right in, the default recipe can be found at:

recipes/default.rb

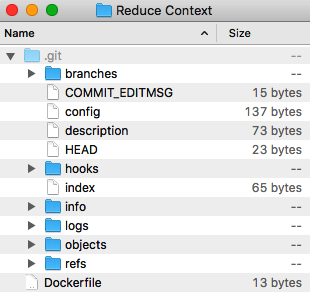

La structure du répertoire du cookbook passe-partout ressemblera à la capture d’écran suivante :

2. Ensuite, nous nous préparerons à éditer notre cookbook. Remplacez notre répertoire de travail par le cookbook que nous avons créé précédemment à l’aide de la commande suivante :

$ cd dockerhost

3. Installez le cookbook docker du supermarché Chef comme notre dépendance. Ce cookbook fournit des définitions de ressources supplémentaires qui peuvent être utilisées dans nos recettes. Nous les utiliserons plus tard comme blocs de construction pour configurer notre hôte Docker. Pour ajouter les dépendances, mettez à jour le fichier metadata.rb , comme suit:

name ‘dockerhost’

maintainer ‘The Authors’

maintainer_email ‘you@example.com’

license ‘all_rights’

description ‘Installs/Configures a dockerhost’

long_description ‘Installs/Configures a dockerhost’

version ‘0.1.0’

depends ‘docker’, ‘~> 4.8’

Le fichier metadata.rb fournit des métadonnées sur nos cookbook Chef. Les informations contenues dans les métadonnées fournissent des conseils au serveur Chef afin que le cookbook puisse être correctement déployé sur nos nœuds. Pour plus d’informations sur la configuration des métadonnées dans nos cookbook Chef, visitez http://docs.chef.io/config_rb_metadata.html.

4. Nous allons maintenant créer une recette Chef dans recipes / base.rb pour décrire la configuration de base de nos hôtes Docker. Le contenu de la recette suivante installe et démarre le moteur Docker à partir du référentiel YUM de Docker CE :

yum_repository ‘docker-stable’ do

description ‘Docker CE Stable’

baseurl ‘https://download.docker.com/linux’\

‘/centos/7/$basearch/stable’

gpgkey ‘https://download.docker.com/linux/centos/gpg’

end

docker_service ‘default’ do

version ‘18.09.0’

install_method ‘package’

setup_docker_repo false

action %w(create start)

end

5. Maintenant que notre cookbook est prêt, nous allons créer un fichier de règles de chef pour gérer l’emballage de notre cookbook et ses dépendances. Nous allons créer une stratégie appelée policies / base.rb pour décrire la configuration de base de notre hôte Docker :

name ‘base’

default_source :supermarket

cookbook ‘dockerhost’, path: ‘../cookbooks/dockerhost’

run_list ‘dockerhost::base’

6. Maintenant que nos dépendances sont déclarées, nous pouvons les télécharger en exécutant la commande suivante :

$ cd ~/chef-repo

$ chef install policies/base.rb

Building policy base

Expanded run list: recipe[dockerhost::base]

Caching Cookbooks…

Installing dockerhost >= 0.0.0 from path

Using docker 4.8.0

Lockfile written to ./policies/base.lock.json

Policy revision id: 67435037674caf004468b9a775eb44

Nous avons maintenant terminé de créer notre politique de base pour décrire notre hôte Docker. Notre dernière étape a généré un chef Policyfile lock policies / base.lock.json qui représente l’ensemble de cookbook que nous avons utilisé pour cette politique.

Politiques Push Chef

La dernière étape consiste à appliquer cette politique à nos hôtes Docker afin de récupérer la configuration souhaitée. Nous effectuerons les étapes suivantes pour y parvenir :

1. Tout d’abord, nous téléchargeons la stratégie sur notre serveur Chef dans un groupe de stratégies appelé production . Notez que dans la sortie de la commande suivante, le cookbook docker dont nous dépendons sera également automatiquement téléchargé :

$ chef push production policies/base.lock.json

Uploading policy base (6743503767) to policy group production

Uploaded docker 4.8.0 (d074b095)

Uploaded dockerhost 0.1.0 (3f2a6710)

2. Ensuite, nous affecterons tous nos hôtes Docker au groupe de règles de production et à la base de règles que nous avons téléchargées précédemment :

$ knife node policy set dockerhost production base

Successfully set the policy on node dockerhost

$ knife node policy set node1 production base

Successfully set the policy on node node1

3. Enfin, nous exécuterons le chef-client sur nos deux hôtes Docker. Le chef-client récupérera et appliquera la configuration d’état souhaitée que nous avons appliquée dans les étapes précédentes :

$ knife ssh ‘policy_group:production’ ‘chef-client’

node1 Starting Chef Client, version 14.7.17

dockerhost Starting Chef Client, version 14.7.17

node1 Using policy ‘base’ at revision…

dockerhost Using policy ‘base’ at revision…

…

node1 * service[docker] action start dockerhost * service[docker] action start

node1

node1 Running handlers:

node1 Running handlers complete

node1 Chef Client finished, … in 53 seconds

dockerhost

dockerhost Running handlers:

dockerhost Running handlers complete

dockerhost Chef Client finished, … in 53 seconds

Maintenant, nous avons installé et configuré Docker dans notre hôte Docker à l’aide de Chef. Chaque fois que nous devons ajouter un autre hôte Docker, nous pouvons simplement créer un autre serveur dans notre fournisseur de cloud et l’affecter à notre groupe de politiques de production et à notre base de politiques.

Dans un environnement de production, le but d’avoir un logiciel de gestion de configuration installé sur notre hôte Docker n’est jamais d’avoir à s’y connecter juste pour effectuer des mises à jour de configuration. L’exécution manuelle du chef-client ne représente que la moitié de l’automatisation.

Nous voudrons exécuter le chef-client comme un processus démon afin de ne pas avoir à l’exécuter à chaque fois que nous effectuons une mise à jour. Le démon chef-client interrogera le serveur Chef pour vérifier s’il existe des mises à jour du nœud qu’il gère. Par défaut, cet intervalle d’interrogation est défini sur 30 minutes.Pour plus d’informations sur la configuration de chef-clien t en tant que démon, reportez-vous à la documentation de Chef sur https://docs.chef.io/chef_client.html .

Dans la section suivante, nous allons itérer sur notre cookbook Chef pour inclure l’initialisation de notre cluster Docker Swarm.

Initialisation de Docker Swarm

Maintenant que nous avons une configuration de base pour configurer un hôte Docker, passons au niveau suivant et configurons automatiquement un cluster Docker Swarm:

1. Tout d’abord, nous avons besoin d’un moyen de stocker le jeton de jointure Docker Swarm en toute sécurité. Nous utiliserons chef-vault comme moyen de stocker le jeton. Pour pouvoir utiliser chef-vault , nous l’ajouterons simplement en tant que dépendance de notre cookbook dans cookbooks / dockerhost / metadata.rb :

name ‘dockerhost’

# …

version ‘0.1.0’

depends ‘docker’, ‘~> 4.7’

depends ‘chef-vault’, ‘~> 3.1’ # update here

2. Ensuite, nous allons créer une recette Chef pour initialiser le nœud du gestionnaire dans cookbooks / dockerhost / recipes / manager.rb :

include_recipe ‘dockerhost::base’

execute ‘init swarm’ do

command ‘docker swarm init’

not_if ‘docker info -f “{{.Swarm.LocalNodeState}}” | egrep “^active”‘

end

Notez que nous avons utilisé les clauses de garde du chef pour empêcher l’initialisation de l’essaim de docker de s’exécuter plusieurs fois. Cela rend notre recette de chef idempotente.

3. De retour dans notre recette de base, cookbook / dockerhost / recipes / base.rb , nous allons récupérer le jeton de jointure de chef-vault et exécuter docker join avec :

# previous contents of

# cookbooks/dockerhost/recipes/base.rb

# …

swarm = begin

chef_vault_item(‘docker’, ‘swarm’)\

[node.policy_group]

rescue Net::HTTPServerException

{}

end

execute ‘join swarm’ do

command ‘docker swarm join ‘\

“–token #{swarm[‘token’]} #{swarm[‘manager’]}”

not_if { swarm.empty? }

not_if ‘docker info -f “{{.Swarm.LocalNodeState}}” | egrep “^active”‘

end

4. Ensuite, nous lierons toutes nos modifications en mettant à jour nos politiques Chef Cheffile / base.rb :

name ‘base’

default_source :supermarket

cookbook ‘dockerhost’, path: ‘../cookbooks/dockerhost’

run_list ‘dockerhost::base’

named_run_list ‘manager’, ‘dockerhost::manager’

5. Une fois que tout est mis à jour, nous mettrons à jour la politique pour générer un nouveau fichier de verrouillage :

$ chef update policies/base.rb

Building policy base

Expanded run list: recipe[dockerhost::base]

Caching Cookbooks…

Installing dockerhost >= 0.0.0 from path

Using docker 4.8.0

Installing chef-vault 3.1.1

Lockfile written to ./policies/base.lock.json

Policy revision id: 9f698c0ddb57b3dcc6af62406588c3

6. Enfin, poussons maintenant cette nouvelle politique vers notre serveur Chef :

$ chef push production policies/base.lock.json

Maintenant que nous avons mis à jour notre politique, nous pouvons maintenant l’appliquer à nouveau à nos hôtes Docker. Les prochaines étapes initialiseront notre cluster Docker Swarm:

1. Tout d’abord, nous exécutons la recette du gestionnaire que nous avons créée précédemment dans notre hôte Docker dockerhost :

$ knife ssh -m dockerhost ‘chef-client –named-run-list manager’

dockerhost Starting Chef Client, version 14.7.17

…

dockerhost * execute[join swarm] action run (skipped due to not_if)

dockerhost Recipe: dockerhost::manager

dockerhost * execute[init swarm] action run

dockerhost – execute docker swarm init

dockerhost

dockerhost Running handlers:

dockerhost Running handlers complete

dockerhost Chef Client finished, … in 09 seconds

2. Ensuite, nous allons nous connecter à cet hôte Docker pour récupérer le jeton de jointure :

$ knife ssh -m dockerhost ‘docker swarm join-token worker’

dockerhost To add a worker to this swarm, run the following command:

dockerhost

dockerhost

docker swarm join –token SWMTKN-1-31h15evixetseazrs… 172.16.132.218:2377

dockerhost

3. Maintenant que nous savons ce qu’est le jeton de jointure, nous allons utiliser ces informations pour créer un fichier d’élément chef-vault dans vault / docker / swarm.json :

{

“production”: {

“token”: “SWMTKN-1-31h15evixetseazrs…”,

“manager”: “172.16.132.218:2377”

}

}

4. Ensuite, nous téléchargerons cet élément chef-vault en exécutant la commande suivante:

$ knife vault create -m client \

docker swarm “$(cat vault/docker/swarm.json) \

-S ‘policy_group:production’

5. Enfin, nous exécuterons à nouveau Chef dans tous nos hôtes Docker:

$ knife ssh ‘policy_group:production’ ‘chef-client’

dockerhost Starting Chef Client, version 14.7.17

node1 Starting Chef Client, version 14.7.17

…

dockerhost * execute[join swarm] action run (skipped…)

node1 * execute[join swarm] action run

node1 – execute docker swarm join –token …

dockerhost

dockerhost Running handlers:

dockerhost Running handlers complete

dockerhost Chef Client finished, … in 09 seconds

node1

node1 Running handlers:

node1 Running handlers complete

node1 Chef Client finished, … in 10 seconds

Comme nous pouvons le voir dans l’extrait précédent, node1 a rejoint notre cluster Docker Swarm. Notre noeud gestionnaire dockerhost n’a pas réinitialisé l’essaim car il fait déjà partie du cluster.

Nous avons maintenant terminé la configuration de notre cluster Docker Swarm comme nous l’avons fait dans le chapitre précédent. Mais maintenant, nous avons automatisé la plupart des étapes de sa configuration.

Nous pouvons également utiliser chef-vault pour distribuer les clés TLS et les certificats du gestionnaire Docker Swarm de la même manière.

Méthodes alternatives

Il existe d’autres outils de gestion de configuration à usage général qui nous permettent de configurer notre hôte Docker. Voici une courte liste des autres outils que nous pouvons utiliser :

- Puppet : Reportez-vous à http://puppetlabs.com .

- Ansible : Vous pouvez le trouver sur http://ansible.com .

- CFEngine : disponible sur http://cfengine.com .

- SaltStack : Vous pouvez trouver plus d’informations à ce sujet sur http://saltstack.com .

- Docker Machine : il s’agit d’un outil de gestion de configuration très spécifique qui nous permet de provisionner et de configurer les hôtes Docker dans notre infrastructure. Plus d’informations sur Docker Machine peuvent être trouvées sur la page de documentation Docker sur https://docs.docker.com/machine .

Si nous ne voulons pas du tout gérer notre infrastructure hôte Docker, nous pouvons utiliser les services d’hébergement Docker. Les fournisseurs de cloud populaires ont commencé à proposer des hôtes Docker en tant qu’image cloud pré-provisionnée que nous pouvons utiliser. D’autres offrent une solution plus complète qui nous permet d’interagir avec tous les hôtes Docker dans le cloud en tant qu’hôte Docker virtuel unique. Voici une liste de liens des fournisseurs de cloud populaires décrivant leur intégration avec l’écosystème Docker:

- Moteur Google Kubernetes ( https://cloud.google.com/kubernetes-engine )

- Amazon EC2 Container Service ( http://aws.amazon.com/documentation/ecs )

- Instances de conteneur Azure ( https://azure.microsoft.com/en-us/services/container-instances/ )

- Joyent Triton Compute ( https://www.joyent.com/triton/compute )

En termes de déploiement de conteneurs Docker, plusieurs outils de conteneur vous permettent de le faire. Ils fournissent des API pour exécuter et déployer nos conteneurs Docker. Certaines des API proposées sont même compatibles avec le moteur Docker lui-même. Cela nous permet d’interagir avec notre pool d’hôtes Docker comme s’il s’agissait d’un seul hôte Docker virtuel. Voici une liste de quelques outils qui nous permettent d’orchestrer le déploiement de nos conteneurs sur un pool d’hôtes Docker :

- CNCF Kubernetes ( http://kubernetes.io )

- Marathon mésophere ( https://mesosphere.github.io/marathon )

- Moteur SmartDataCenter Docker ( https://github.com/joyent/sdc-docker )

Cependant, nous avons toujours besoin d’outils de gestion de la configuration tels que Chef pour déployer et configurer nos systèmes d’orchestration au sommet de notre pool d’hôtes Docker.

Résumé

Dans ce chapitre, nous avons appris à automatiser la configuration de nos déploiements Docker. L’utilisation de Chef nous permet de configurer et de provisionner plusieurs hôtes Docker à l’échelle. À partir de ce moment, nous pouvons écrire des recettes Chef pour conserver toutes les techniques d’optimisation Docker que nous apprendrons dans cet article.

Dans le chapitre suivant, nous présenterons l’instrumentation pour surveiller l’ensemble de notre infrastructure et application Docker. Cela nous donnera d’autres réactions sur la façon d’optimiser nos déploiements Docker mieux pour de meilleures performances.

Surveillance de Docker

Nous savons maintenant comment optimiser nos déploiements Docker. Nous savons également comment évoluer pour améliorer les performances. Mais comment savons-nous que nos hypothèses de réglage étaient correctes ? Il est important de pouvoir surveiller notre infrastructure et notre application Docker pour comprendre pourquoi et quand nous devons optimiser. Mesurer les performances de notre système nous permet d’identifier ses limites pour évoluer et régler en conséquence.

En plus de surveiller les informations de bas niveau sur Docker, il est également important de mesurer les performances commerciales de notre application. En traçant le flux de valeur de notre application, nous pouvons corréler les mesures liées à l’entreprise à celles au niveau du système. Grâce à cela, nos équipes de développement et d’exploitation Docker peuvent montrer à leurs collègues comment Docker réduit les coûts de leur organisation et augmente la valeur commerciale.

Dans ce chapitre, nous aborderons les sujets suivants concernant notre capacité à surveiller notre infrastructure Docker et nos applications à grande échelle :

- L’importance du suivi

- Collecte de métriques dans Prometheus

- Consolidation des journaux dans une pile ELK

L’importance du suivi

La surveillance est importante car elle fournit une source de rétroaction sur le déploiement Docker que nous avons construit. Il offre une vue approfondie de notre application, des performances du système d’exploitation de bas niveau aux cibles commerciales de haut niveau. L’insertion d’une instrumentation appropriée dans nos hôtes Docker nous permet d’identifier l’état de notre système. Nous pouvons utiliser cette source de commentaires pour déterminer si notre application se comporte comme prévu à l’origine.

Si notre hypothèse initiale était incorrecte, nous pouvons utiliser les données de rétroaction pour réviser notre plan et changer notre système en conséquence en ajustant notre hôte Docker et ses conteneurs ou en mettant à jour notre application Docker en cours d’exécution. Nous pouvons également utiliser le même processus de surveillance pour identifier les erreurs et les bogues après le déploiement de notre système en production.

Docker a des fonctionnalités intégrées pour se connecter et surveiller. Par défaut, un hôte Docker stocke les flux d’erreur et de sortie standard d’un conteneur Docker dans des fichiers JSON dans /var/lib/docker/<container_id>/<container_id>-json.log. La commande docker logs demande au démon Docker Engine de lire le contenu des fichiers ici.

Une autre fonction de surveillance est la commande docker stats. Cela interroge le point de terminaison / containers / <contain_id> / stats de l’API distante du moteur Docker pour rapporter des statistiques d’exécution sur le groupe de contrôle du conteneur en cours d’exécution concernant son processeur, sa mémoire et l’utilisation du réseau. Voici un exemple de sortie de la commande docker stats signalant ces mesures :

dockerhost$ docker run –name running –d busybox \

/bin/sh -c ‘while true; do echo hello && sleep 1; done’

dockerhost$ docker stats running

CONTAINER CPU % MEM USAGE/LIMIT MEM % NET I/O

running 0.00% 0 B/518.5 MB 0.00% 17.06 MB/119.8 kB

Les commandes Docker logs et docker stats intégrées fonctionnent bien pour surveiller nos applications Docker pour le développement et les déploiements à petite échelle. Lorsque nous arrivons à un point de notre déploiement Docker de niveau production où nous gérons des dizaines, des centaines, voire des milliers d’hôtes Docker, cette approche ne sera plus évolutive. Il n’est pas possible de se connecter à chacun de nos milliers d’hôtes Docker et de saisir les journaux et les statistiques de docker.

Faire cela un par un rend également difficile la création d’une image plus globale de l’ensemble de notre déploiement Docker. De plus, toutes les personnes intéressées par les performances de notre application Docker ne peuvent pas se connecter à nos hôtes Docker. Les collègues qui ne traitent que l’aspect commercial de notre application voudront peut-être poser certaines questions concernant la façon dont le déploiement de notre application dans Docker améliore ce que notre organisation veut ; cependant, ils ne veulent pas nécessairement apprendre à se connecter et à commencer à taper des commandes Docker dans notre infrastructure.

Par conséquent, il est important de pouvoir consolider tous les événements et mesures de nos déploiements Docker dans une infrastructure de surveillance centralisée. Cela permet à nos opérations d’évoluer en ayant un point unique à partir duquel nous pouvons savoir ce qui se passe dans notre système. Un tableau de bord centralisé permet également aux personnes extérieures à notre équipe de développement et d’exploitation, telles que nos collègues de travail, d’avoir accès aux commentaires fournis par notre système de surveillance. Les sections restantes vous montreront comment consolider les messages des journaux Docker et collecter des statistiques à partir de sources de données, telles que les statistiques Docker.

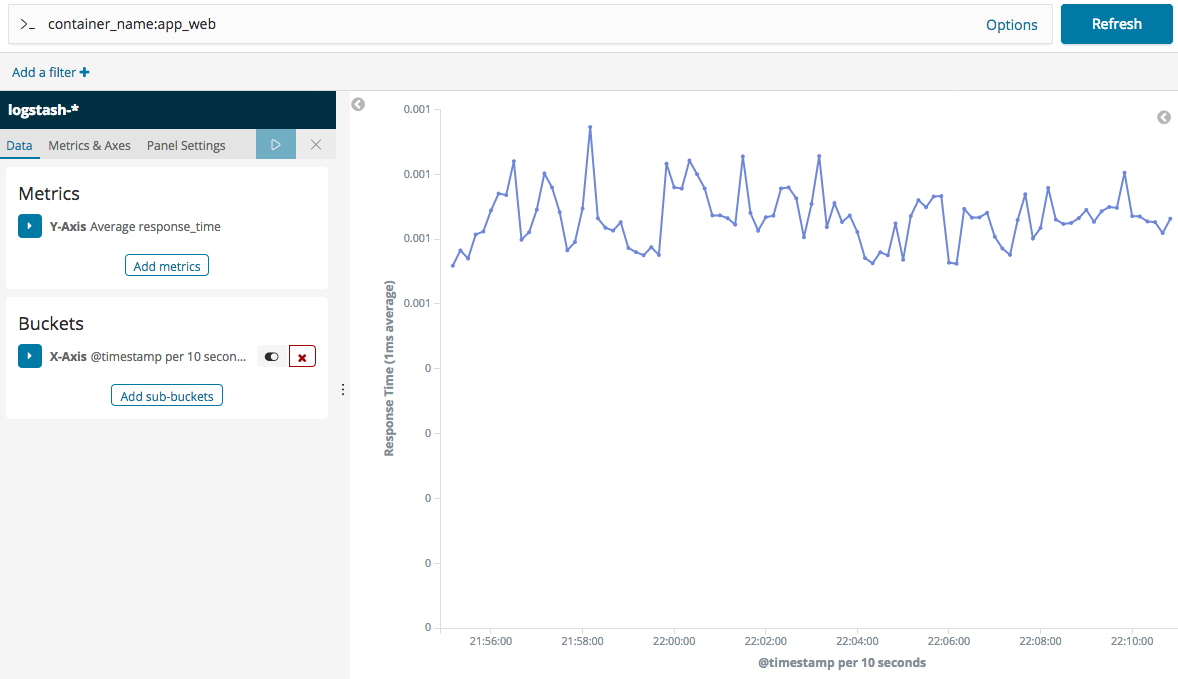

Collecte de métriques avec Prometheus

Pour commencer à surveiller nos déploiements Docker, nous devons d’abord configurer un point de terminaison auquel envoyer nos valeurs surveillées. Prometheus est une pile de surveillance populaire pour collecter diverses mesures. Il fournit une API simple pour l’intégration avec divers outils. La plupart des outils natifs du cloud et liés aux conteneurs prennent déjà en charge l’intégration avec Prometheus. Plus tard, nous configurerons Prometheus pour collecter les métriques de notre infrastructure Docker.

Dans cette section, nous allons configurer les composants suivants pour construire notre infrastructure de surveillance basée sur Prometheus:

- Clients / exportateurs de Prometheus : il s’agit essentiellement de tout type de composant utilisant le format d’exposition de Prometheus qui expose les mesures à collecter par Prometheus. Nous activerons l’intégration de Prometheus avec Docker Engine pour surveiller les métriques liées à Docker dans notre cluster. Nous déploierons également cAdvisor, un outil pour surveiller les conteneurs qui s’exécutent dans tous nos nœuds Docker Swarm.

- Prometheus : nous allons configurer Prometheus lui-même pour extraire et rassembler les métriques des différents clients / exportateurs que nous avons mis en place.

- Grafana : Grafana fournit une belle visualisation pour divers moteurs de stockage métriques. Bien que Prometheus fournisse des graphiques de base prêts à l’emploi, Grafana possède une interface plus agréable pour visualiser les métriques que nous rassemblerons. Nous allons configurer Grafana pour se connecter à notre service Prometheus et inspecter les conteneurs exécutés à l’intérieur de notre cluster Docker Swarm.

Exposer les métriques de Prometheus

Pour commencer à surveiller notre infrastructure Docker, nous devons exposer les métriques des nœuds de notre cluster Docker Swarm. À la fin de cette section, nous obtiendrons des mesures compatibles avec Prometheus à partir des composants suivants :

- Docker Engine : fournit une intégration Prometheus intégrée au Docker Engine lui-même

- cAdvisor : un outil de Google qui surveille tous les conteneurs fonctionnant sur une machine. Il fournit une intégration avec Docker prêt à l’emploi

Tout d’abord, nous devons mettre à jour le démon Docker Engine s’exécutant dans chacun de nos nœuds. Les étapes suivantes illustrent comment effectuer cette mise à jour :

1. Tout d’abord, revenons à notre cookbook Chef que nous avons écrit dans le chapitre précédent. Mettons à jour notre recette de chef dans les cookbook / dockerhost / recipes / base.rb en utilisant le code suivant :

# cookbooks/dockerhost/recipes/base.rb

# …

docker_service ‘default’ do

misc_opts ‘–experimental=true –metrics-addr=0.0.0.0:1337’

# …

end

# …

Dans le code précédent, nous avons permis à Prometheus de s’intégrer au Docker Engine en spécifiant l’indicateur –metrics-addr. À l’heure actuelle, il s’agit toujours d’une fonctionnalité expérimentale de Docker, nous devons donc également définir l’indicateur –experimental .

2. Maintenant que nous avons édité notre cookbook, mettons à jour notre politique Chef et transmettons-la à notre serveur Chef, comme suit :

$ chef update policies/base.rb

$ chef push production policies/base.lock.json

3. Enfin, exécutons le chef-client dans tous nos nœuds, comme suit. Cela redémarrera tous les démons Docker Engine pour récupérer la configuration mise à jour :

$ knife ssh policy_group:production ‘sudo chef-client’

Nos métriques Prometheus sont exposées. Nous pouvons tester cela en interrogeant manuellement les points de terminaison Prometheus de chacun de nos nœuds Docker :

$ curl http://dockerhost:1337/metrics

…

$ curl http://node1:1337/metrics

…

swarm_store_write_tx_latency_seconds_bucket{le=”2.5″} 0

swarm_store_write_tx_latency_seconds_bucket{le=”5″} 0

swarm_store_write_tx_latency_seconds_bucket{le=”10″} 0

swarm_store_write_tx_latency_seconds_bucket{le=”+Inf”} 0

swarm_store_write_tx_latency_seconds_sum 0

swarm_store_write_tx_latency_seconds_count 0

Au moment de la rédaction de ce document, l’intégration de Prometheus dans Docker prend uniquement en charge l’exposition des métriques pour le moteur Docker lui-même. Afin de collecter les métriques réelles de nos conteneurs en cours d’exécution sur chaque hôte, nous devrons installer cAdvisor de Google.

Les prochaines étapes déploieront cAdvisor sur tous les nœuds participant à notre cluster Docker Swarm :

1. Tout d’abord, nous allons créer un fichier Docker Compose YAML appelé compose-monitoring.yml pour décrire comment exécuter le service cAdvisor, comme suit :

—

version: ‘3.7’

services:

cadvisor:

image: google/cadvisor

hostname: ‘{{.Node.Hostname}}’

deploy:

mode: global

command: -logtostderr=true -docker_only=true

volumes:

– /:/rootfs:ro

– /var/run:/var/run:rw

– /sys:/sys:ro

– /var/lib/docker:/var/lib/docker:ro

# Set for debugging and testing purposes

networks:

default:

driver: overlay

attachable: true

L’aspect important de cette définition de service est le déploiement / mode : entrée globale. Un service global exécutera des conteneurs cAdvisor sur chaque nœud de notre cluster Docker Swarm. Cela inclut également les nœuds de gestionnaire.

2. Après avoir créé le fichier Compose YAML, déployons-le maintenant sur notre cluster Docker Swarm, comme suit :

$ docker stack deploy -c compose-monitoring.yml monitoring

Creating network monitoring_default

Creating service monitoring_cadvisor

3. Nous pouvons maintenant tester si cAdvisor expose des métriques de conteneur en contactant le service Docker en cours d’exécution, comme suit :

$ docker run –network monitoring_default -it –rm alpine /bin/sh

/ # apk add -y curl

/ # curl http://cadvisor:8080/metrics

…

# HELP process_start_time_seconds Start time of the process since unix epoch in seconds.

# TYPE process_start_time_seconds gauge

process_start_time_seconds 1.54791282078e+09

# HELP process_virtual_memory_bytes Virtual memory size in bytes.

# TYPE process_virtual_memory_bytes gauge

process_virtual_memory_bytes 7.63068416e+0

Nous avons maintenant des processus qui exposent les métriques Prometheus pour nos conteneurs. Vous pouvez utiliser les références suivantes pour en savoir plus sur ces outils :

- Docker : https://docs.docker.com/config/thirdparty/prometheus

- cAdvisor : https://github.com/google/cadvisor

Gratter et visualiser les métriques

Maintenant que tous les noeuds finaux Prometheus sont préparés, nous pouvons maintenant procéder à la collecte de ces métriques dans Prometheus lui-même. Ensuite, nous exécuterons Grafana pour visualiser toutes les métriques que nous avons exposées dans la sous-section précédente.

Les étapes suivantes déploieront Prometheus en tant que service dans notre cluster Docker Swarm:

1. Tout d’abord, préparons une configuration de service pour Prometheus dans un fichier appelé prometheus.yml, comme suit :

—

global:

scrape_interval: 15s

scrape_configs:

– job_name: cadvisor

dns_sd_configs:

– names:

– ‘tasks.cadvisor’

type: A

port: 8080

– job_name: docker

static_configs:

– targets:

– dockerhost:1337

– node1:1337

Dans la configuration précédente, nous avons supprimé chaque moteur Docker de notre cluster Docker Swarm en spécifiant le nom d’hôte de chaque nœud. Pour cAdvisor, nous avons utilisé la découverte de service intégrée de Prometheus via DNS pour nous connecter à tous les conteneurs cAdvisor exécutés dans chaque nœud.

2. Pour démarrer Prometheus, mettons à jour notre fichier compose-monitoring.yml avec l’entrée suivante :

—

version: ‘3.7’

services:

prometheus:

image: prom/prometheus

configs:

– source: prometheus.yml

target: /etc/prometheus/prometheus.yml

# … cadvisor:

configs:

prometheus.yml:

file: ./prometheus.yml

# networks …

Dans la mise à jour précédente, nous nous sommes assurés que la configuration du service est correctement référencée.

3. Enfin, mettons à jour le déploiement de notre pile de services de surveillance, comme suit :

$ docker stack deploy -c compose-monitoring.yml monitoring

Creating config monitoring_prometheus.yml

Creating service monitoring_prometheus

Updating service monitoring_cadvisor (id: eiqb0w6e86bjm596vsut377)

Prometheus est maintenant prêt et élimine les points de terminaison métriques que nous avons configurés plus tôt. Confirmez que tous les points de terminaison sont correctement supprimés en interrogeant le point de terminaison de l’API cible de notre service Prometheus, comme suit :

$ docker run –network monitoring_default -it –rm alpine /bin/sh

/ # apk add -y curl jq

/ # curl -s http://prometheus:9090/api/v1/targets \

| jq ‘.data.activeTargets | .[].labels’

{

“instance”: “10.0.4.3:8080”,

“job”: “cadvisor”

}

{

“instance”: “10.0.4.4:8080”,

“job”: “cadvisor”

}

{

“instance”: “dockerhost:1337”,

“job”: “docker”

}

{

“instance”: “node1:1337”,

“job”: “docker”

}

Le composant suivant de notre pile de surveillance est Grafana. Les étapes suivantes déploieront Grafana en tant que service dans notre cluster Docker Swarm :

1. Tout d’abord, mettons à jour le fichier Docker Compose nommé compose-logging.yml pour définir comment Grafana s’exécutera dans notre cluster, comme suit :

—

version: ‘3.7’

services:

grafana:

image: grafana/grafana

ports:

– 3000:3000

# prometheus:

# cadvisor:

# …

2. Maintenant que nous avons terminé la mise à jour du fichier Compose, effectuons un redéploiement à l’aide de la commande suivante :

$ docker stack deploy -c compose-monitoring.yml monitoring

Creating service monitoring_grafana

Updating service monitoring_prometheus (id: hzarfvo8kd9g6cj441n31db7g)

Updating service monitoring_cadvisor (id: eiqb0w6e86bjm596vsut377ws)

3. Grafana devrait maintenant être prêt. Puisque nous avons configuré un port d’entrée pour le maillage de routage de Docker Swarm, nous pouvons aller sur http://dockerhost:3000 pour visiter notre déploiement Grafana.

4. Lorsque nous lançons Grafana pour la première fois, il nous sera demandé de nous connecter. Utilisons le nom d’utilisateur par défaut admin et le mot de passe admin configurés dans le conteneur officiel Grafana, comme indiqué dans la capture d’écran suivante :

Bien que facultatif, modifions également le mot de passe administrateur par défaut de notre installation Grafana :

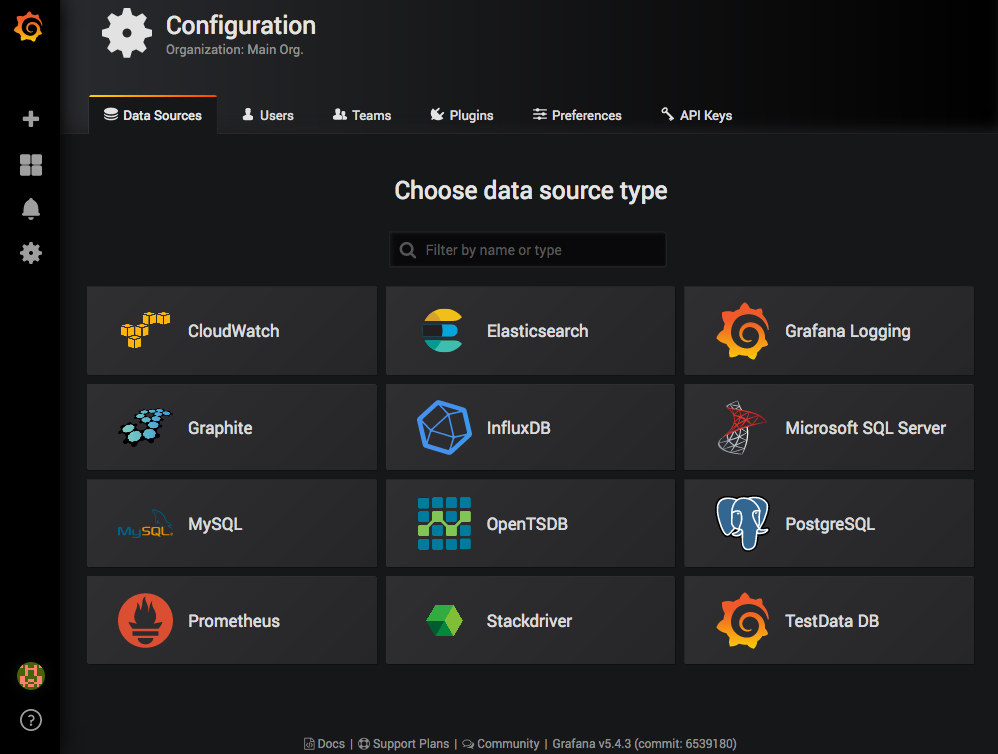

5. Sur le tableau de bord principal, l’installation de Grafana nous dit quoi faire en premier, qui est d’ajouter une source de données. Dans la page de configuration (comme illustré dans la capture d’écran suivante), nous allons insérer un type de source de données Prometheus :

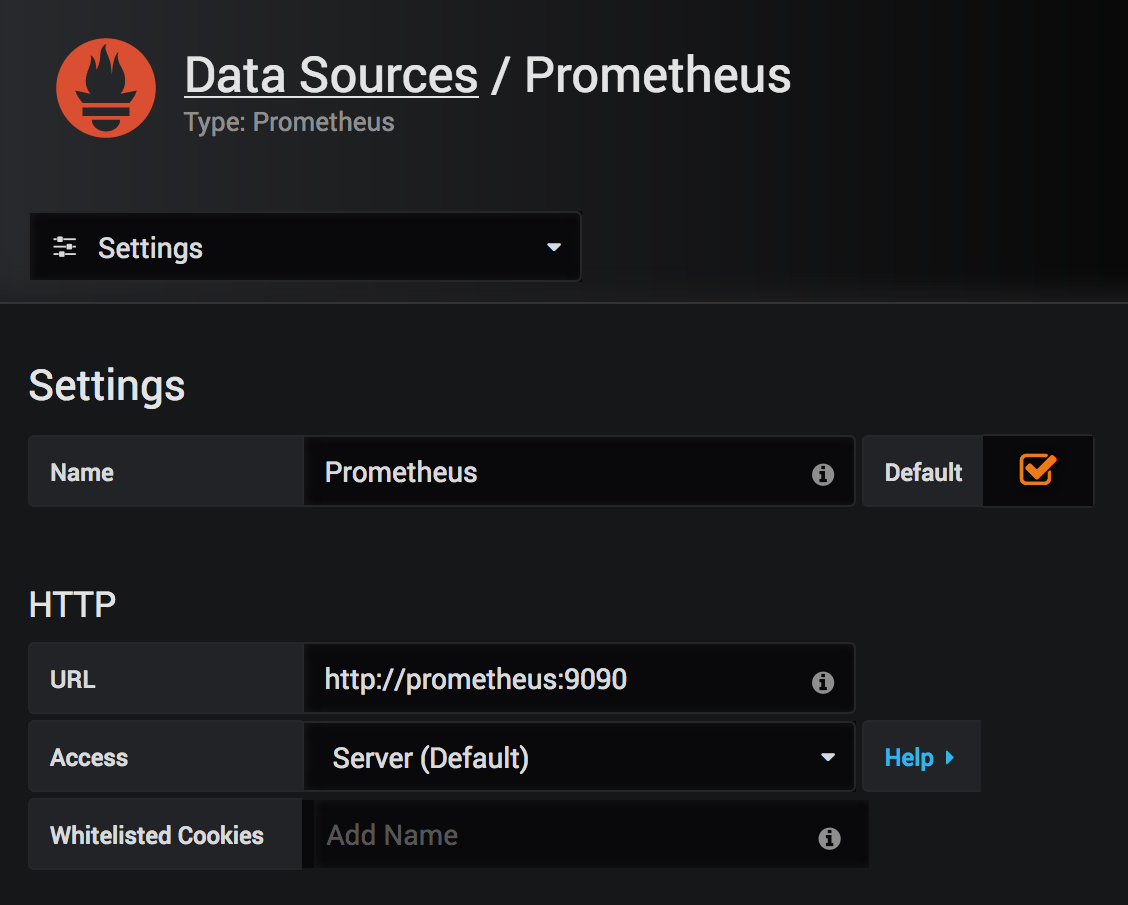

2. Pour configurer Grafana pour interroger notre service Prometheus, définissons l’URL HTTP à http://prometheus:9090, comme indiqué dans la capture d’écran suivante. C’est là que se trouve le service en fonction de la définition de notre fichier Docker Compose :

3. Pour mettre à jour les modifications, descendons tout le long de la page et appuyez sur le bouton Enregistrer et tester .

4. Nous sommes maintenant prêts à visualiser les métriques des conteneurs dans notre cluster Docker Swarm.

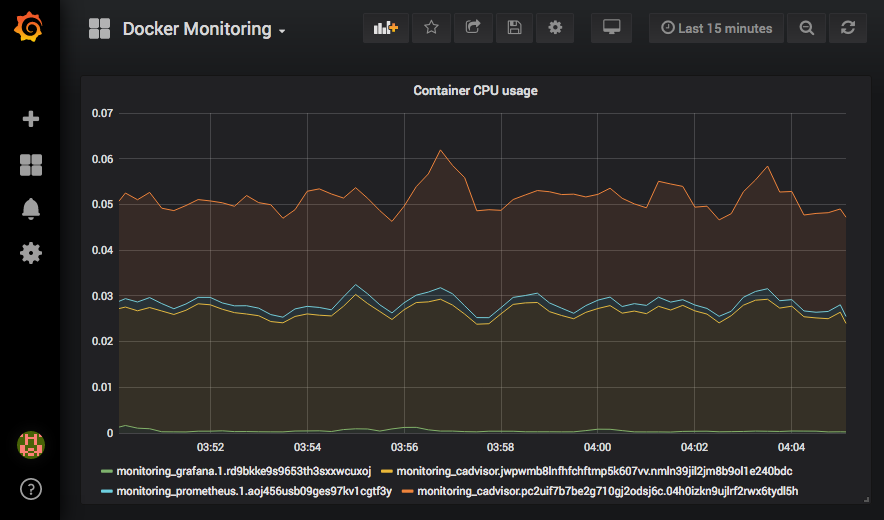

5. Allons dans la zone de recherche du tableau de bord de Grafana et cliquez sur Importer le tableau de bord . Collons le texte suivant dans la zone de texte JSON :

{

“panels”: [

{

“id”: 2,

“stack”: true,

“targets”: [

{

“expr”: “rate(container_cpu_usage_seconds_total

{container_label_com_docker_stack_namespace=\”monitoring\”}[1m])”,

“legendFormat”: “{{name}}”

}

],

“title”: “Container CPU usage”,

“type”: “graph”

}

],

“title”: “Docker Monitoring”

}

Nous pouvons avoir besoin d’ajuster la taille de la zone graphique dans notre tableau de bord si nécessaire pour voir la visualisation correctement.

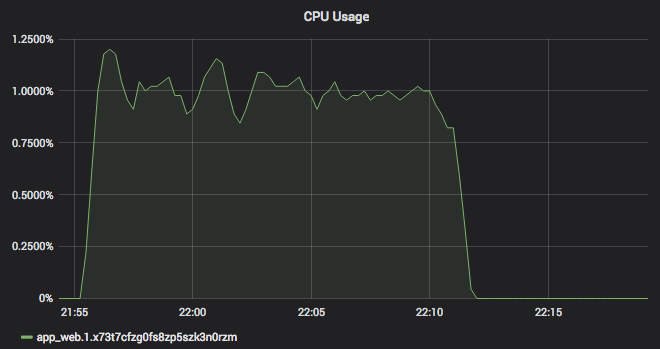

Une fois le tableau de bord importé, nous verrons l’utilisation du processeur de la pile de surveillance que nous venons de déployer dans cette section. Le tableau de bord ressemblera à la capture d’écran suivante :

Toutes nos félicitations ! Nous avons maintenant une pile de surveillance appropriée pour notre cluster Docker Swarm.

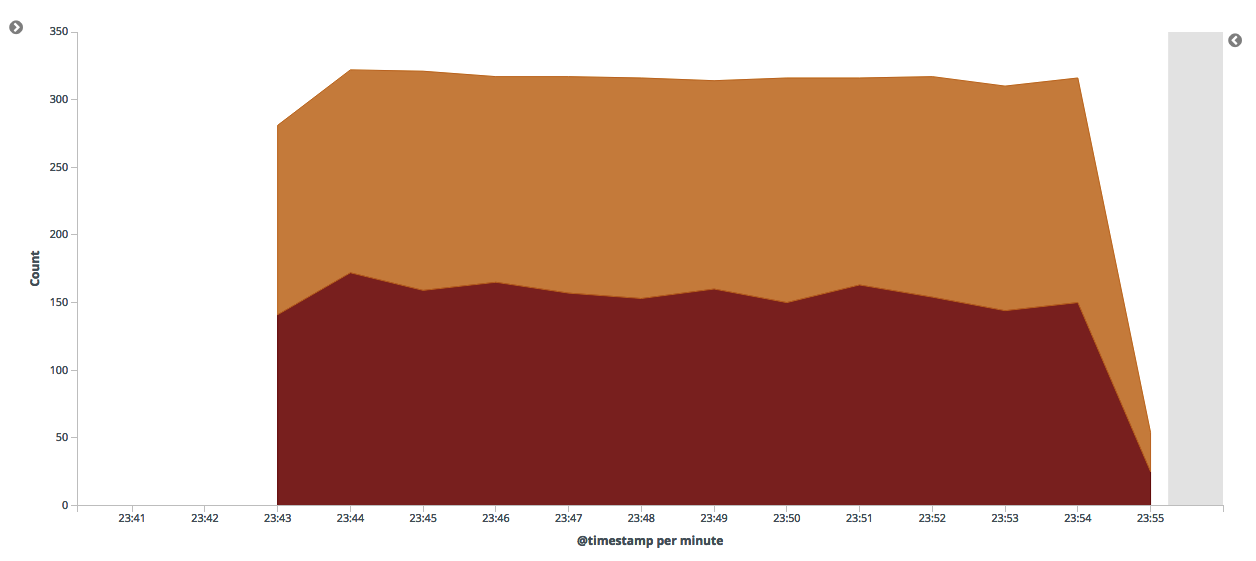

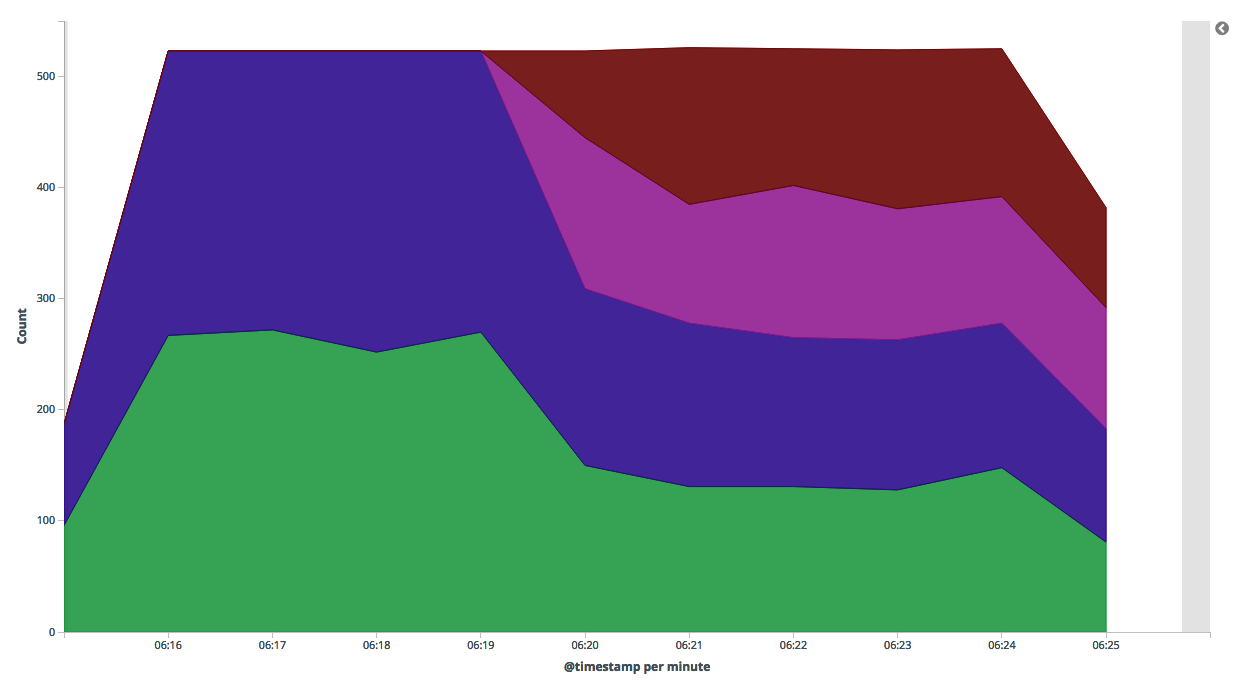

Consolidation des journaux dans une pile ELK

Tous les statuts de nos hôtes et conteneurs Docker ne sont pas facilement disponibles pour être interrogés avec notre solution de surveillance dans Prometheus. Certains événements et mesures ne sont disponibles que sous forme de lignes brutes de texte dans les fichiers journaux. Nous devons transformer ces journaux bruts et non structurés en mesures significatives. Semblable aux mesures brutes, nous pouvons plus tard poser des questions de niveau supérieur sur ce qui se passe dans notre application Docker à l’aide de l’analyse.

La pile ELK est une suite de combinaisons populaire d’Elastic qui résout ces problèmes. Chaque lettre de l’acronyme représente chacun de ses composants. La liste suivante contient des descriptions de chacun d’eux :

- Elasticsearch : Elasticsearch est un moteur de recherche distribué hautement évolutif. Ses capacités de partage nous permettent de développer et de faire évoluer notre stockage de journaux alors que nous continuons à recevoir de plus en plus de journaux de nos conteneurs Docker. Son moteur de base de données est orienté document. Cela nous permet de stocker et d’annoter les journaux comme bon nous semble alors que nous continuons à découvrir plus d’informations sur les événements que nous gérons dans nos grands déploiements Docker.

- Logstash : Logstash est le composant utilisé pour collecter et gérer les journaux et les événements. Il s’agit du point central que nous utilisons pour collecter tous les journaux de différentes sources de journaux, tels que plusieurs hôtes Docker et conteneurs exécutés dans notre déploiement. Nous pouvons également utiliser Logstash pour transformer et annoter les journaux que nous recevons. Cela nous permet de rechercher et d’explorer les fonctionnalités plus riches de nos journaux plus tard.

- Kibana : Kibana est un tableau de bord d’analyse et de recherche pour Elasticsearch. Sa simplicité nous permet de créer des tableaux de bord pour nos applications Docker ; Cependant, Kibana est également très flexible à personnaliser, nous pouvons donc créer des tableaux de bord qui peuvent fournir des informations précieuses aux personnes qui souhaitent comprendre nos applications basées sur Docker, qu’elles aient un faible niveau de détails techniques ou un besoin commercial de niveau supérieur.

Dans les autres parties de cette section, nous allons configurer chacun de ces composants et leur envoyer nos journaux d’accueil et de conteneur Docker.

Déploiement d’Elasticsearch, Logstash et Kibana

Nous allons configurer la pile ELK en créant un fichier Docker Compose pour décrire ces services. Les étapes suivantes décrivent comment créer la pile ELK :

1. Tout d’abord, déployons le service Elasticsearch en créant le fichier appelé compose-logging.yml , comme indiqué dans le code suivant :

—

version: ‘3.7’

services:

elasticsearch:

image: elasticsearch:6.5.4

environment:

discovery.type: single-node

networks:

default:

driver: overlay

attachable: true

2. Ensuite, nous déployons ce fichier Docker Compose et faisons un test rapide pour confirmer qu’Elasticsearch s’exécute à l’aide du code suivant. Selon la capacité de notre hôte Docker, Elasticsearch peut mettre un certain temps à être prêt :

$ docker stack deploy -c compose-logging.yml logging

Creating network logging_default

Creating service logging_elasticsearch

$ docker run –network logging_default -it –rm alpine /bin/sh

/ # apk add curl

/ # curl http://elasticsearch:9200/_cluster/health\?pretty=true

{

“cluster_name” : “docker-cluster”,

“status” : “green”,

“timed_out” : false,

“number_of_nodes” : 1,

…

}

3. Ensuite, nous mettrons à jour le fichier compose-logging.yml pour lancer Kibana, comme suit :

—

version: ‘3.7’

services:

kibana:

image: kibana:6.5.4

ports:

– 5601:5601

# elasticsearch: …

# networks: …

4. Une fois le nouveau fichier Docker Compose prêt, lancez Kibana en réexécutant le déploiement de la pile comme suit :

$ docker stack deploy -c compose-logging.yml logging

Creating service logging_kibana

Updating service logging_elasticsearch (id:\ lewcnk24h7xdc3obwd7nwy9nm)

5. Depuis que nous avons activé le port d’entrée Docker Swarm pour Kibana, nous pouvons visiter http://dockerhost:5601 pour voir si notre service Kibana fonctionne. Nous devrions voir une page d’accueil comme celle de la capture d’écran suivante :

Nous examinerons la création d’un tableau de bord à partir des données Elasticsearch dans la section suivante :

1. Pour créer la dernière partie de notre pile de journalisation, nous devons d’abord créer un fichier de configuration nommé logstash.conf pour Logstash, comme suit :

input {

gelf { }

}

output {

# Optional: Enable for debugging

# stdout { }

elasticsearch {

hosts => [“http://elasticsearch:9200”]

}

}

2. Ensuite, nous mettons à jour le fichier compose-logging.yml en définissant le mode d’exécution du service Logstash à l’aide du code suivant. Notez que nous incluons également le fichier logstash.conf que nous avons préparé à l’étape précédente :

—

version: ‘3.7’

services:

# kibana: …

# elasticsearch: …

logstash:

configs:

– source: logstash.conf

target: /usr/share/logstash/pipeline/logstash.conf

image: logstash:6.5.4

ports:

– 12201:12201/udp

configs:

logstash.conf:

file: ./logstash.conf

# networks: …

3. Enfin, nous déployons Logstash et confirmons qu’il fonctionne en utilisant le code suivant :

$ docker stack deploy -c compose-logging.yml logging

Creating config logging_logstash.conf

Updating service logging_kibana (id: 1utcs8yl6k3zavdrms8q7vccm)

Updating service logging_elasticsearch (id:\ lewcnk24h7xdc3obwd7nwy9nm)

Creating service logging_logstash

$ docker run –network logging_default -it –rm alpine /bin/sh

/ # apk add curl

/ # curl http://logstash:9600/\?pretty

{

“host” : “3645f635a7b8”,

“version” : “6.5.4”,

“http_address” : “0.0.0.0:9600”,

“id” : “704b7fa5-1286-49ed-8381-f5ed79eb109d”,

“name” : “3645f635a7b8”,

“build_date” : “2018-12-17T22:04:46+00:00”,

“build_sha” : “7bf353ed88a10f3f2a9b81f6f3510ee41061e2f8”,

“build_snapshot” : false

}/

Nous avons maintenant la pile complète de notre infrastructure de journalisation en place. Nous devons maintenant configurer notre cluster Docker Swarm pour envoyer des journaux aux services de cette pile.

Transfert des journaux de conteneur Docker

Maintenant que nous avons une pile ELK fonctionnelle de base, nous pouvons commencer à lui transmettre nos journaux Docker. La prise en charge des pilotes de journalisation personnalisés est disponible à partir de Docker 1.7. Dans cette section, nous allons configurer notre hôte Docker pour utiliser le pilote GELF. Passons en revue les étapes suivantes pour commencer à recevoir nos journaux de conteneur dans la pile ELK :

1. Mettez à jour la recette base.rb comme suit :

# cookbooks/dockerhost/recipes/base.rb

# …

docker_service ‘default’ do

log_driver ‘gelf’

log_opts “gelf-address=udp://#{node[‘ipaddress’]}:12201”

# misc_opts … (for metrics in the previous section)

# …

end

# …

2. Mettez à jour la stratégie et déployez-la à l’aide du code suivant :

$ chef update policies/base.rb

$ chef push production policies/base.lock.json

3. Exécutez chef-client dans les nœuds Docker Swarm, comme suit :

$ knife ssh policy_group:production ‘sudo chef-client’

Tous les flux de sortie et d’erreur standard provenant de notre conteneur Docker doivent maintenant être capturés et placés dans notre pile ELK. Nous pouvons faire quelques tests préliminaires pour confirmer que la configuration fonctionne. Tapez la commande suivante pour créer un message de test à partir de Docker :

$ docker run –rm busybox echo message to elk

La commande docker run prend également en charge les options de ligne de commande –log-driver et –log-opt = [] pour configurer le pilote de journalisation uniquement pour le conteneur que nous voulons exécuter. Nous pouvons l’utiliser pour affiner nos politiques de journalisation pour chaque conteneur Docker exécuté sur notre hôte Docker.

Dans les étapes suivantes, nous effectuerons une configuration minimale dans Kibana afin de pouvoir rechercher le message de journal que nous avons envoyé de Docker plus tôt :

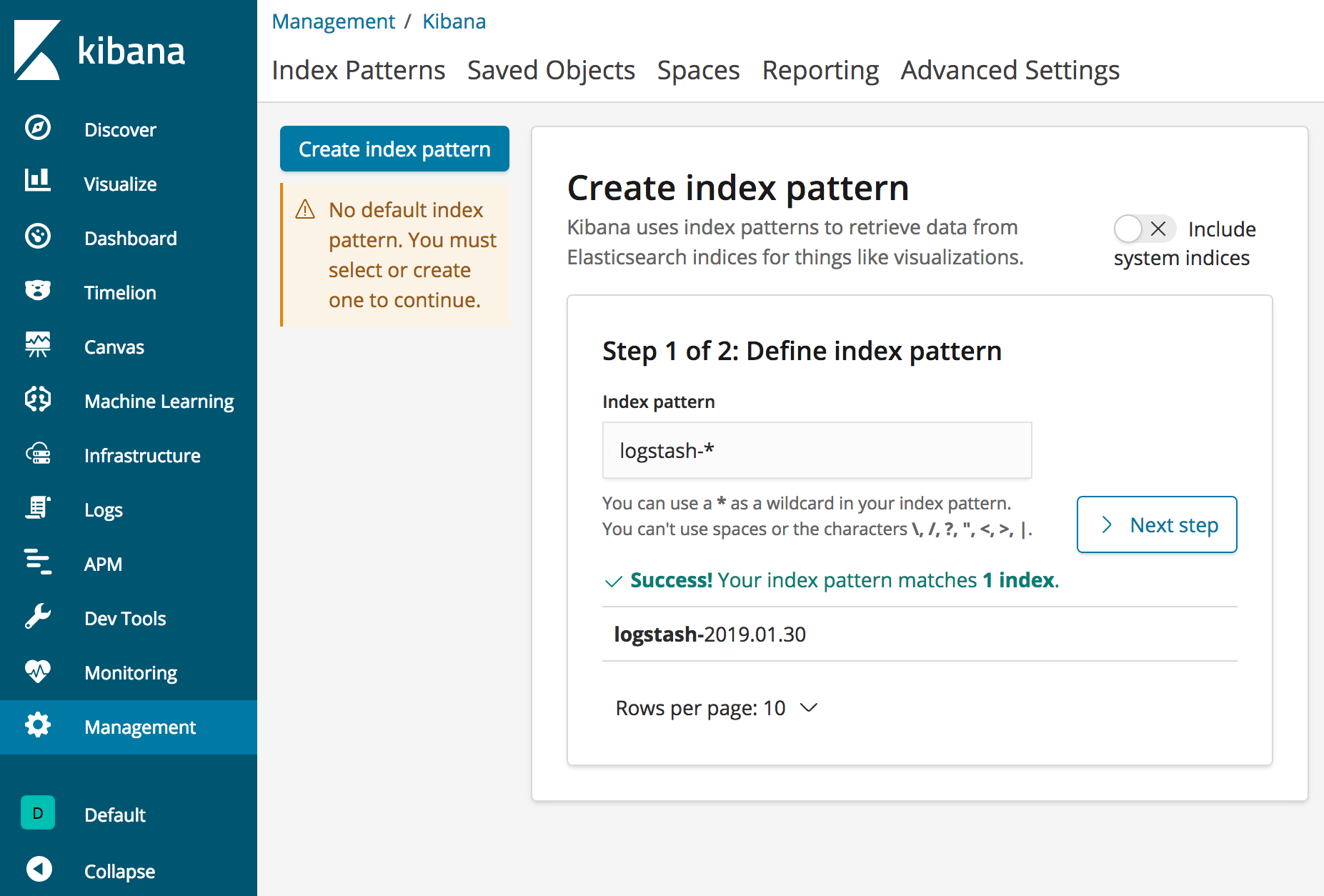

1. Tout d’abord, nous devons créer un modèle d’index dans lequel Kibana recherchera les journaux Elasticsearch. Allons à http://dockerhost:5601/app/kibana#/management/kibana/ index et utilisons les indices par défaut générés par Logstash logstash- * comme modèle d’index, comme le montre la capture d’écran suivante :

Cliquons sur Étape suivante pour passer aux boîtes de dialogue de configuration suivantes.

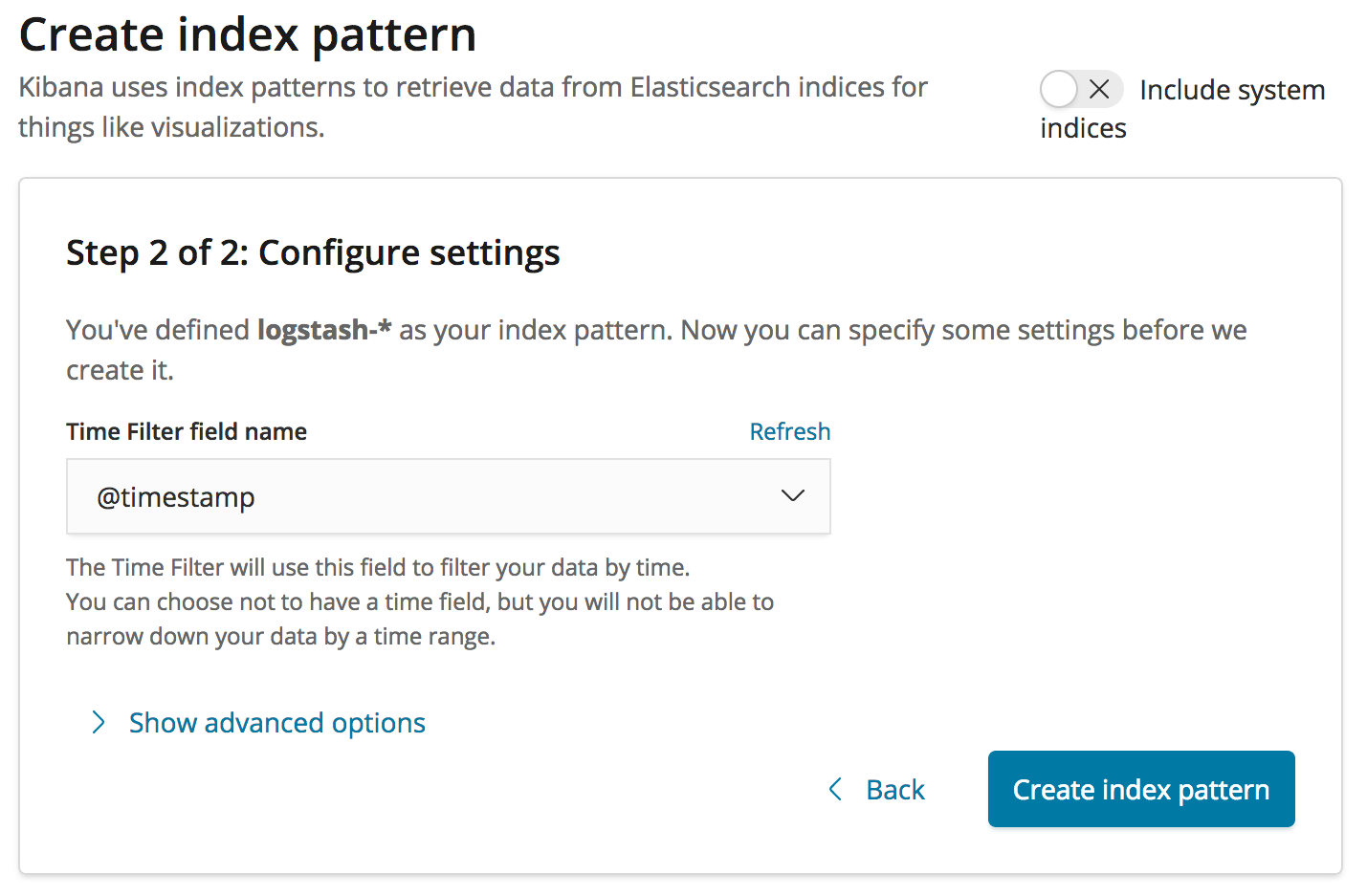

2. Maintenant que nous avons un modèle d’index, nous devons indiquer quels champs dans les documents d’index contiennent l’horodatage de nos journaux. Utilisons le champ temporel par défaut @timestamp, comme suit :

3. Enfin, cliquons sur le bouton Créer un modèle d’index pour terminer la création de notre modèle d’index.

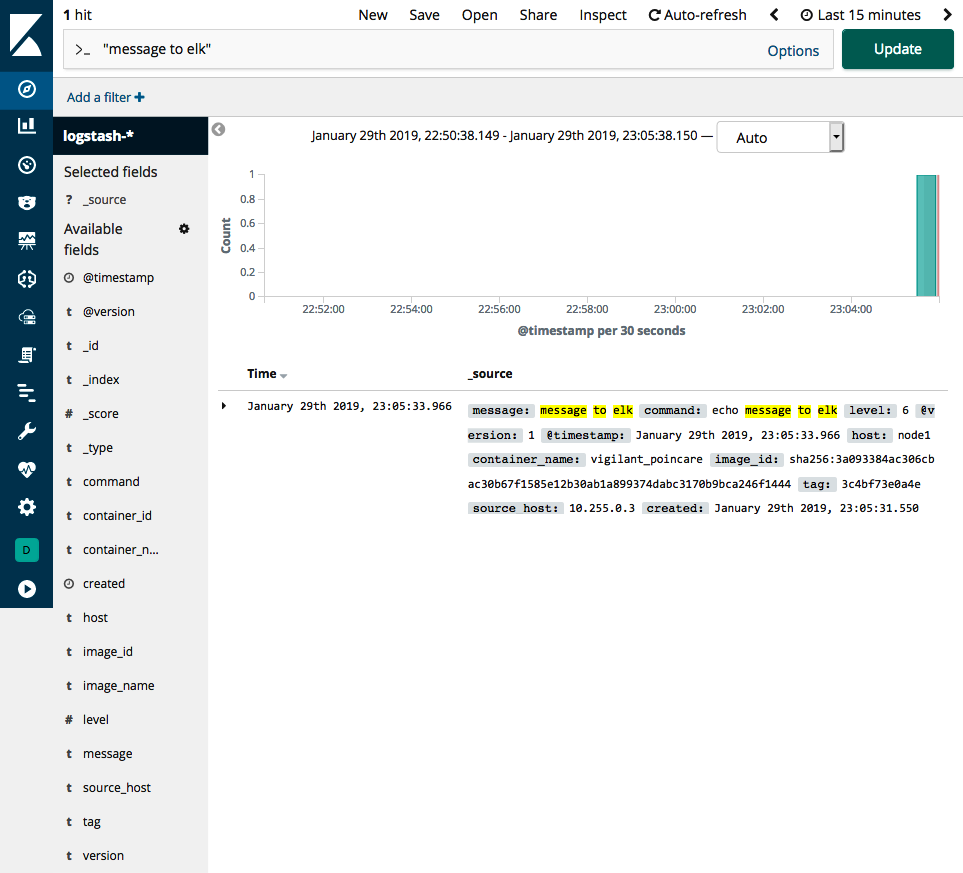

Kibana est maintenant configuré pour consulter nos journaux Docker. Allons à notre point de terminaison Kibana dans http://dockerhost:5601/app/kibana#/ découvrez et recherchez l’expression “message à wapiti” (y compris les guillemets) dans la zone de texte. Le résultat de la recherche doit donner l’entrée du message que nous avons envoyé plus tôt. La capture d’écran suivante est à quoi devrait ressembler le résultat de la recherche :

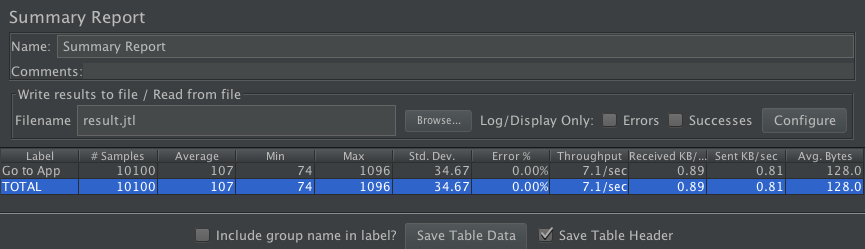

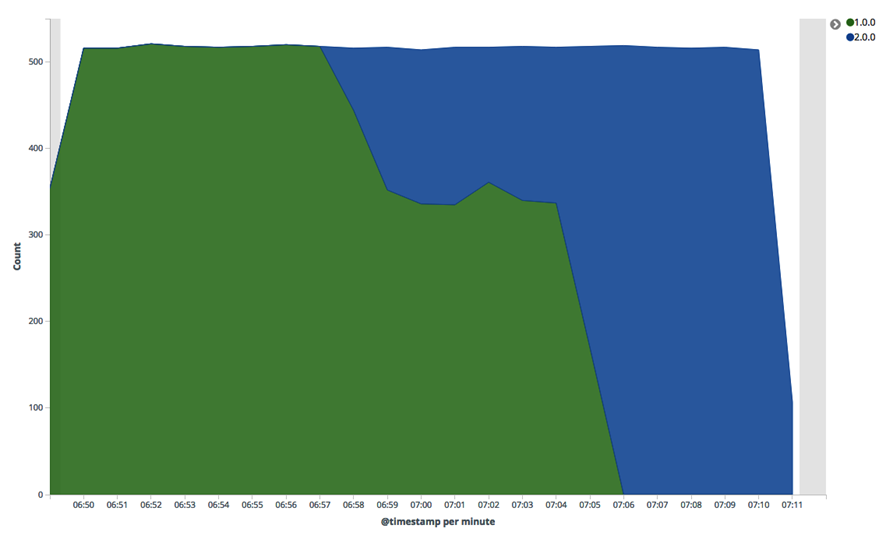

Dans la capture d’écran précédente, nous pouvons voir le message que nous avons envoyé. Il existe également d’autres informations sur le conteneur qui a généré le message de journal. Le pilote de journal GELF de Docker contient des informations telles que le nom de l’image Docker source, l’identification du conteneur et l’hôte Docker sur lequel le conteneur a été exécuté.