Introduction à l’intelligence artificielle

Résumé de la publication

L’intelligence artificielle (IA) est « l’ensemble des théories et des techniques mises en œuvre en vue de réaliser des machines capables de simuler l’intelligence ». Elle correspond donc à un ensemble de concepts et de technologies plus qu’à une discipline autonome constituée. Au travers de cette publication, nous allons essayer d’apporter la première pierre de compréhension à un débutant en intelligence artificielle.

Objectifs de la publication

- Comprendre le fonctionnement de l’intelligence artificielle

- Comprendre les différents paliers d’intelligence artificielle existants

- Définir le but de l’intelligence artificielle

- Découvrir quels sont les avantages et les inconvénients de l’intelligence artificielle

- Découvrir les applications de l’intelligence artificielle

- Découvrir les métiers de l’intelligence artificielle

- Découvrir les différentes technologies de l’intelligence artificielle (ML, DL, etc.)

Qu’est-ce que l’intelligence artificielle ?

La réponse courte à ce qui est l’intelligence artificielle est qu’elle dépend de la personne qui vous posez la question. Un profane avec une compréhension fugace de la technologie le relierait aux robots. Ils diraient que l’Intelligence Artificielle est un terminateur qui peut agir et penser tout seul. Un chercheur en IA dirait que c’est un ensemble d’algorithmes qui peuvent produire des résultats sans avoir à être explicitement instruits pour le faire. Et ils auraient tous raison. Donc, pour résumer, l’Intelligence Artificielle est :

- Une entité « intelligente » créée par l’homme.

- Capable d’effectuer des tâches « intelligemment » sans être explicitement instruit.

- Capable de penser et d’agir rationnellement et humainement.

Comment mesurer si l’Intelligence Artificielle agit comme un être humain ?

Même si nous atteignons cet état où une IA peut se comporter comme un être humain, comment pouvons-nous être sûrs qu’elle peut continuer à se comporter de cette façon ? Nous pouvons baser la ressemblance humaine d’une entité d’IA avec :

- Le test de Turing

- L’approche de modélisation cognitive (Un modèle cognitif est une représentation simplifiée visant à modéliser des processus psychologiques ou intellectuels.)

- L’approche de la loi de la pensée

- L’approche de l’agent rationnel

Examinons en détail le détail de ces approches :

Qu’est-ce que le test de Turing?

La base du test de Turing est que l’entité d’intelligence artificielle devrait être en mesure de tenir une conversation avec un être humain. L’agent humain idéalement ne devrait pas pouvoir discerner qu’ils parlent à une Intelligence Artificielle. Pour atteindre ces objectifs, l’IA doit posséder ces qualités :

- Traitement du langage naturel pour communiquer avec succès.

- Représentation du savoir pour agir comme sa mémoire.

- Raisonnement automatisé pour utiliser les informations stockées pour répondre aux questions et tirer de nouvelles conclusions.

- Apprentissage automatique pour détecter les modèles et s’adapter à de nouvelles circonstances.

Approche de modélisation cognitive

Comme son nom l’indique, cette approche tente de construire un modèle d’intelligence artificielle basé sur la cognition humaine. Pour distiller l’essence de l’esprit humain, il y a 3 approches :

- Introspection : observer nos pensées, et la construction d’un modèle basé sur cette

- Expériences psychologiques : mener des expériences sur les humains et observer leur comportement

- Imagerie cérébrale : Utilisation de l’IRM pour observer le fonctionnement du cerveau dans différents scénarios et reproduire cela par le code.

Les lois de l’approche de la pensée

Les Lois de la Pensée sont une grande liste d’énoncés logiques qui régissent le fonctionnement de notre esprit. Les mêmes lois peuvent être codifiées et appliquées aux algorithmes d’intelligence artificielle. Les problèmes avec cette approche, pour que la résolution d’un problème en principe (strictement selon les lois de la pensée) et leurs résolutions dans la pratique peut être tout à fait différentes, nécessitant des nuances contextuelles à appliquer. En outre, il y a certaines actions que nous prenons sans être 100% certain d’un résultat qu’un algorithme pourrait ne pas être en mesure de reproduire s’il y a trop de paramètres.

L’approche de l’agent rationnel

Un agent rationnel agit pour obtenir le meilleur résultat possible dans ses circonstances actuelles. Selon l’approche des Lois de la Pensée, une entité doit se comporter selon les énoncés logiques. Mais il y a des cas, où il n’y a pas de bonne chose logique à faire, avec de multiples résultats impliquant des résultats différents et des compromis correspondants. L’approche de l’agent rationnel tente de faire le meilleur choix possible dans les circonstances actuelles. Cela signifie que c’est un agent beaucoup plus dynamique et adaptable. Maintenant que nous comprenons comment l’Intelligence Artificielle peut être conçue pour agir comme un être humain, jetons un coup d’œil à la façon dont ces systèmes sont construits.

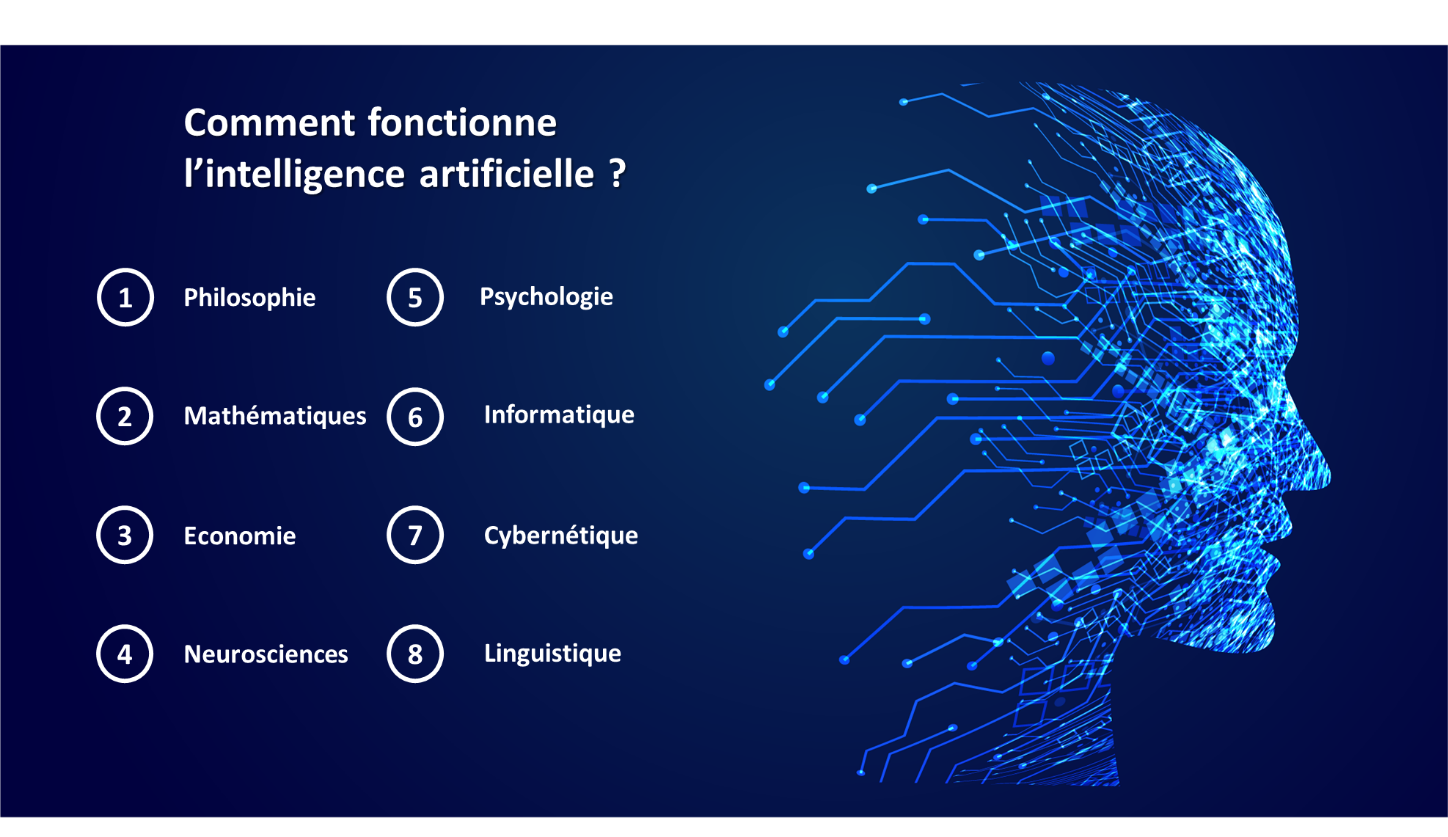

Comment fonctionne l’Intelligence Artificielle ?

Construire un système d’IA est un processus minutieux de l’ingénierie inverse des traits humains et des capacités dans une machine, et en utilisant ses prouesses de calcul pour dépasser ce que nous sommes capables de. L’Intelligence Artificielle peut être construite sur un ensemble diversifié de composants et fonctionnera comme une fusion de :

- Philosophie

- Mathématiques

- Économie

- Neurosciences

- Psychologie

- Ingénierie informatique

- Théorie du contrôle et cybernétique

- Linguistique

Jetons un coup d’œil détaillé à chacune de ces composantes.

Philosophie

Le but de la philosophie pour les humains est de nous aider à comprendre nos actions, leurs conséquences, et comment nous pouvons prendre de meilleures décisions. Des systèmes intelligents modernes peuvent être construits en suivant les différentes approches de la philosophie qui permettront à ces systèmes de prendre les bonnes décisions, reflétant la façon dont un être humain idéal penserait et se comporterait. La philosophie aiderait ces machines à penser et à comprendre la nature de la connaissance elle-même. Cela les aiderait également à établir un lien entre la connaissance et l’action au moyen d’une analyse axée sur les objectifs afin d’obtenir des résultats souhaitables.

Mathématiques

Les mathématiques sont le langage de l’univers et le système construit pour résoudre les problèmes universels devrait être compétent en elle. Pour que les machines comprennent la logique, le calcul et la probabilité sont nécessaires. Les premiers algorithmes n’étaient que des voies mathématiques pour faciliter les calculs, qui seront bientôt suivis par des théorèmes, des hypothèses et plus encore, qui ont tous suivi une logique prédéfinie pour arriver à une sortie de calcul. La troisième application mathématique, la probabilité, permet des prédictions précises des résultats futurs sur lesquels les algorithmes d’intelligence artificielle fonderaient leurs prises de décision.

Économie

L’économie est l’étude de la façon dont les gens font des choix en fonction de leurs résultats préférés. Ce n’est pas seulement une question d’argent, bien que l’argent soit le résultat attendu préféré des gens se manifeste dans le monde réel. Il existe de nombreux concepts importants en économie, tels que la théorie du design, la recherche opérationnelle et les processus de décision Markov. Ils ont tous contribué à notre compréhension des « agents rationnels » et des lois de la pensée, en utilisant les mathématiques pour montrer comment ces décisions sont prises à grande échelle avec leurs résultats collectifs. Ces types de techniques de décision-théorétique aident à construire ces systèmes intelligents.

Neurosciences

Depuis les neurosciences étudient comment le cerveau fonctionne et l’intelligence artificielle essaie de reproduire la même chose, il y a un chevauchement évident ici. La plus grande différence entre les cerveaux humains et les machines est que les ordinateurs sont des millions de fois plus rapide que le cerveau humain, mais le cerveau humain a encore l’avantage en termes de capacité de stockage et d’interconnexions. Cet avantage est lentement fermé avec des progrès dans le matériel informatique et des logiciels plus sophistiqués, mais il y a encore un grand défi à surmonter que ne soit toujours pas conscients de la façon d’utiliser les ressources informatiques pour atteindre le niveau du cerveau de l’intelligence.

Psychologie

La psychologie peut être considérée comme le point médian entre les neurosciences et la philosophie. Il tente de comprendre comment notre cerveau spécialement configuré et développé réagit aux stimuli et réagit à son environnement, qui sont tous deux importants pour construire un système intelligent. La psychologie cognitive considère le cerveau comme un dispositif de traitement de l’information, fonctionnant sur la base de croyances, d’objectifs et de croyances, semblable à la façon dont nous pourrions construire notre propre machine intelligente. De nombreuses théories cognitives ont déjà été codifiées pour construire des algorithmes qui alimentent les chatbots d’aujourd’hui.

Ingénierie informatique

L’application la plus évidente ici, mais nous avons mis cela la fin pour vous aider à comprendre sur quoi se base toute cette ingénierie informatique. L’ingénierie informatique traduira toutes nos théories et concepts dans un langage lisible à la machine afin qu’elle puisse faire ses calculs pour produire une sortie que nous poussions comprendre. Chaque progrès dans l’ingénierie informatique a ouvert plus de possibilités de construire des systèmes d’intelligence artificielle encore plus puissants, qui sont basés sur des systèmes d’exploitation avancés, des langages de programmation, des systèmes de gestion de l’information, des outils, et matériel de pointe.

Théorie du contrôle et cybernétique

Pour être vraiment intelligent, un système doit être capable de contrôler et de modifier ses actions pour produire la sortie désirée. La sortie souhaitée en question est définie comme une fonction objective, vers laquelle le système tentera de s’orienter, en modifiant continuellement ses actions en fonction des changements dans son environnement en utilisant des calculs mathématiques et la logique pour mesurer et optimiser son Comportements.

Linguistique

Toute pensée est basée sur un langage et est la représentation la plus compréhensible des pensées. La linguistique a conduit à la formation du traitement du langage naturel, qui aident les machines à comprendre notre langage syntaxique, et aussi à produire la production d’une manière qui est compréhensible pour presque tout le monde. Comprendre une langue, c’est plus qu’apprendre comment les phrases sont structurées, elle exige aussi une connaissance du sujet et du contexte, ce qui a donné naissance à la branche de la représentation des connaissances de la linguistique.

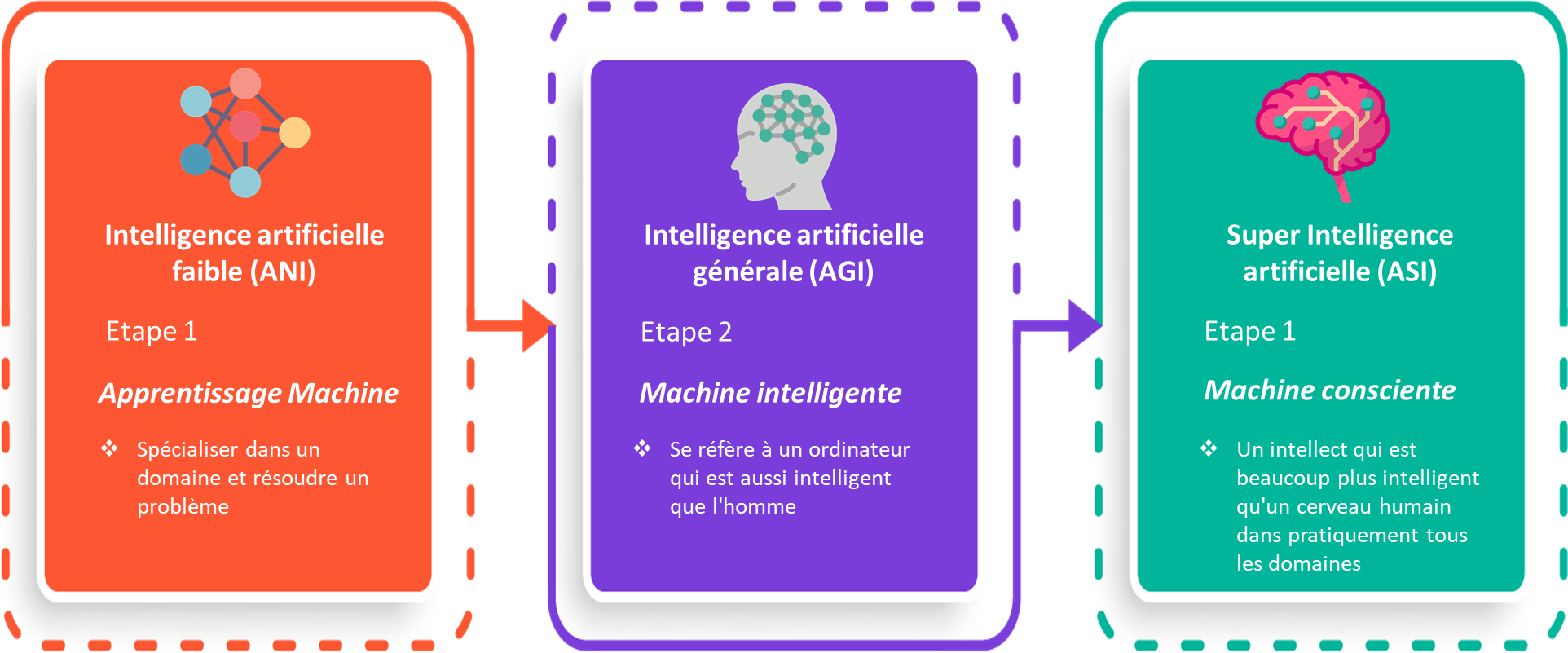

Quels sont les 3 types d’Intelligence Artificielle ?

Tous les types d’IA n’utilisent pas tous les champs ci-dessus simultanément. Différentes entités d’Intelligence Artificielle sont construites à des fins différentes, et c’est ainsi qu’elles varient. Les trois grands types d’IA sont :

- Intelligence étroite artificielle (ANI)

- Intelligence générale artificielle (AGI)

- Super Intelligence Artificielle (ASI)

Qu’est-ce que l’intelligence artificielle « faible » (ANI : Artificial Narrow Intelligence)?

C’est la forme la plus commune de l’IA que vous trouverez sur le marché maintenant. Ces systèmes d’Intelligence Artificielle sont conçus pour résoudre un seul problème et seraient en mesure d’exécuter une seule tâche vraiment bien. Par définition, ils ont des capacités étroites, comme recommander un produit pour un utilisateur de commerce électronique ou prédire la météo. C’est le seul type d’Intelligence Artificielle qui existe aujourd’hui. Ils sont capables de se rapprocher du fonctionnement humain dans des contextes très spécifiques, et même de les dépasser dans de nombreux cas, mais seulement exceller dans des environnements très contrôlés avec un ensemble limité de paramètres.

Qu’est-ce que l’intelligence artificielle générale (AGI : Artificial General Intelligence)?

L’AGI est encore un concept théorique. Il est défini comme l’IA qui a un niveau humain de fonction cognitive, à travers une grande variété de domaines tels que le traitement du langage, le traitement d’image, le fonctionnement et le raisonnement computationnel et ainsi de suite. Nous sommes encore loin de la construction d’un système d’AGI. Un système AGI devrait comprendre des milliers de systèmes d’intelligence étroite artificielle travaillant en tandem, communiquant les uns avec les autres pour imiter le raisonnement humain. Même avec les systèmes et les infrastructures informatiques les plus avancés, tels que le K de Fujitsu ou le Watson d’IBM, il leur a fallu 40 minutes pour simuler une seule seconde d’activité neuronale. Cela témoigne à la fois de l’immense complexité et de l’interconnexion du cerveau humain, et de l’ampleur du défi de construire une IGA avec nos ressources actuelles.

Qu’est-ce que la Super Intelligence Artificielle (ASI : Artificial Super Intelligence)?

Nous entrons presque dans le territoire de la science-fiction ici, mais ASI est considéré comme la progression logique d’AGI. Un système de super intelligence artificielle (ASI) serait en mesure de surpasser toutes les capacités humaines. Cela comprendrait la prise de décisions, la prise de décisions rationnelles, et même comprendre des choses comme faire de l’art ou l’établissement de relations émotionnelles. Une fois que nous aurons atteint l’Intelligence Générale Artificielle, les systèmes d’IA seraient rapidement en mesure d’améliorer leurs capacités et d’avancer dans des domaines dont nous n’aurions peut-être même pas rêvé. Alors que l’écart entre AGI et ASI serait relativement étroit (certains disent aussi peu qu’une nanoseconde, parce que c’est la vitesse à laquelle l’Intelligence Artificielle apprendrait) le long voyage qui nous attend vers AGI lui-même semble être un concept qui se profile loin dans l’avenir.

Quel est le but de l’intelligence artificielle ?

Le but de l’Intelligence Artificielle est d’aider les capacités humaines et de nous aider à prendre des décisions avancées avec des conséquences profondes. C’est la réponse d’un point de vue technique. D’un point de vue philosophique, l’Intelligence Artificielle a le potentiel d’aider les humains à vivre une vie plus significative, dépourvue de dur labeur, et d’aider à gérer le réseau complexe d’individus, d’entreprises, d’États et de nations interconnectés pour fonctionner d’une manière qui est bénéfique pour toute l’humanité.

Actuellement, le but de l’Intelligence Artificielle est partagé par tous les différents outils et techniques que nous avons inventés au cours des mille dernières années – pour simplifier l’effort humain, et pour nous aider à prendre de meilleures décisions. L’Intelligence Artificielle a également été présentée comme notre invention finale, une création qui inventerait des outils et des services novateurs qui changeraient de façon exponentielle la façon dont nous menons nos vies, en éliminant, espérons-le, les conflits, les inégalités et la souffrance humaine.

C’est pour un avenir lointain – nous sommes encore loin de ce genre de résultats. À l’heure actuelle, l’intelligence artificielle est principalement utilisée par les entreprises pour améliorer leur efficacité des processus, automatiser les tâches lourdes en ressources et faire des prédictions d’entreprise basées sur des données dures plutôt que sur des sentiments instinctifs. Comme toutes les technologies qui ont précédé cela, les coûts de recherche et développement doivent être subventionnés par les entreprises et les organismes gouvernementaux avant qu’ils ne deviennent accessibles à la communauté de tous les jours.

Où l’intelligence artificielle est-elle utilisée ?

L’IA est utilisée dans différents domaines pour donner un aperçu du comportement des utilisateurs et formuler des recommandations basées sur les données. Par exemple, l’algorithme de recherche prédictive de Google a utilisé les données utilisateurs passés pour prédire ce qu’un utilisateur tape ensuite dans la barre de recherche. Netflix utilise les données utilisateurs passés pour recommander le film qu’un utilisateur pourrait vouloir voir ensuite, ce qui rend l’utilisateur accroché à la plate-forme et augmenter le temps d’utilisation. Facebook utilise les données des utilisateurs pour donner automatiquement des suggestions pour marquer vos amis, en fonction de leurs traits du visage dans leurs images. L’IA est utilisée partout par les grandes organisations pour simplifier la vie d’un utilisateur final. Les utilisations de l’intelligence artificielle relèveraient largement de la catégorie du traitement des données, qui comprendrait les éléments suivants :

- Rechercher dans les données et optimiser la recherche pour donner les résultats les plus pertinents

- Logique-chaînes pour le raisonnement if-then, qui peut être appliquée pour exécuter une chaîne de commandes basées sur des paramètres

- Détection de modèles pour identifier des modèles significatifs dans un ensemble de données volumineux pour des informations uniques

- Modèles probabilistes appliqués pour prédire les résultats futurs

Quels sont les avantages de l’intelligence artificielle ?

Les avantages de l’intelligence artificielle sont énormes et peuvent révolutionner n’importe quel secteur professionnel. Certains de ses avantages incluent :

- Réduction des erreurs humaines

- Disponible 24 × 7

- Aide au travail répétitif

- Assistance numérique

- Des décisions plus rapides

Réduction des erreurs humaines

Dans un modèle d’intelligence artificielle, toutes les décisions sont prises à partir des informations précédemment collectées après avoir appliqué un certain ensemble d’algorithmes. Par conséquent, les erreurs sont réduites et les chances de précision n’augmentent qu’avec un degré de précision plus élevé.

Disponible 24 × 7

Alors qu’un humain moyen travaille 6 à 8 heures par jour, l’IA quant à elle, parvient à faire fonctionner les machines 24h / 24 et 7j / 7 sans interruption ni ennui.

Aide au travail répétitif

L’IA peut automatiser de manière productive les tâches humaines banales et les libérer pour devenir de plus en plus créatives – directement de l’envoi d’un courrier de remerciement, de la vérification de documents à l’encombrement ou à la réponse à des requêtes.

Assistance numérique

De nombreuses organisations hautement avancées utilisent des assistants numériques pour interagir avec les utilisateurs afin d’économiser les ressources humaines. Ces assistants numériques sont également utilisés dans de nombreux sites Web pour répondre aux requêtes des utilisateurs et fournir une interface de fonctionnement fluide.

Des décisions plus rapides

L’intelligence artificielle, avec d’autres technologies, peut permettre aux machines de prendre des décisions plus rapidement qu’un humain moyen pour mener des actions plus rapidement. En effet, tout en prenant une décision, les humains ont tendance à analyser de nombreux facteurs à la fois émotionnellement et pratiquement par opposition aux machines alimentées par l’IA qui fournissent rapidement des résultats programmés.

Quels sont les inconvénients de l’Intelligence Artificielle ?

Comme c’est le cas pour toute technologie nouvelle et émergente, l’IA a aussi sa juste part d’inconvénients tels que :

- Dépassements de coûts

- Manque de talent

- Manque de produits pratiques

- Manque de normes dans le développement de logiciels

- Potentiel d’abus

Dépassements de coûts

Ce qui sépare l’IA du développement logiciel normal est l’échelle à laquelle elle s’opère. En raison de cette échelle, les ressources informatiques nécessaires augmenteraient de façon exponentielle, ce qui augmenterait le coût de l’opération, ce qui nous amène à un résultat de dépassement des coûts.

Manque de talent

Comme il s’agit encore d’un domaine assez naissant, il y a un manque de professionnels expérimentés, et les meilleurs sont rapidement casés dans des entreprises et des instituts de recherche. Cela augmente le coût des talents, ce qui fait grimper encore les prix de mise en œuvre de l’intelligence artificielle.

Manque de produits pratiques

Pour tout le battage médiatique qui a entouré l’IA, elle ne semble pas encore avoir démontré tout son potentiel même dans un contexte d’IA « faible ». Certes, des applications telles que les chatbots et les moteurs de recommandation existent, mais les applications ne semblent pas s’étendre au-delà. Il est donc difficile de plaider en faveur d’un investissement de plus en plus fort pour améliorer les capacités de l’IA.

Manque de normes dans le développement de logiciels

La véritable valeur de l’Intelligence Artificielle se retrouve en collaboration lorsque différents systèmes d’IA s’unissent pour former une application plus grande et plus précieuse. Mais l’absence de normes dans le développement de logiciels d’IA signifie qu’il est difficile pour les différents systèmes de « communiquer » les uns aux autres. Le développement de logiciels d’intelligence artificielle lui-même est lent et coûteux à cause de cela, ce qui agit en outre comme un obstacle au développement de l’IA.

Potentiel d’abus

La puissance de l’Intelligence Artificielle est énorme, et elle a le potentiel pour réaliser de grandes choses. Malheureusement, elle a aussi le potentiel d’être utilisé à mauvais escient. L’Intelligence Artificielle en elle-même est un outil neutre qui peut être utilisé pour n’importe quoi, mais si elle tombe entre de mauvaises mains, elle peut avoir de graves répercussions. Dans ce stade naissant où les ramifications des développements de l’IA ne sont pas encore complètement comprises, le risque d’abus pourrait être encore plus élevé.

Applications de l’intelligence artificielle dans les affaires ?

L’IA a vraiment le potentiel de transformer de nombreuses industries, avec un large éventail de cas d’utilisation possibles. Ce que toutes ces différentes industries et cas d’utilisation ont en commun, c’est qu’ils sont tous axés sur les données. Étant donné que l’Intelligence Artificielle est un système de traitement de données efficace à la base, il y a beaucoup de potentiel d’optimisation partout.

Jetons un coup d’œil aux industries où l’IA brille actuellement.

Santé

- Administration : Les systèmes d’IA aident à accomplir les tâches administratives courantes et quotidiennes afin de minimiser les erreurs humaines et de maximiser l’efficacité. Transcriptions de notes médicales à travers NLP et aide à structurer l’information des patients pour le rendre plus facile pour les médecins de le lire.

- Télémédecine : Dans les situations non urgentes, les patients peuvent consulter le système d’IA d’un hôpital pour analyser leurs symptômes, entrer leurs signes vitaux et évaluer s’il y a besoin de soins médicaux. Cela réduit la charge de travail des professionnels de la santé en ne leur apportant que des cas cruciaux.

- Diagnostic assisté : Grâce à la vision par ordinateur et aux réseaux neuronaux convolutionnels, l’IA est maintenant capable de lire des IRM pour vérifier la recherche de tumeurs et d’autres croissances malignes, à un rythme exponentiellement plus rapide que les radiologistes ne le peuvent, avec une marge d’erreur considérablement plus faible.

- Chirurgie assistée par robot : Les chirurgies robotiques ont une marge d’erreur très minuscule et peuvent toujours effectuer des chirurgies 24 heures sur 24 sans s’épuiser. Étant donné qu’elles fonctionnent avec un tel degré de précision, elles sont moins invasives que les méthodes traditionnelles, ce qui réduit potentiellement le temps que les patients passent à l’hôpital à récupérer.

- Surveillance des statistiques vitales : l’état de santé d’une personne est un processus continu, en fonction des différents niveaux de ses statistiques vitales respectives. Les appareils portables atteignant désormais la popularité du marché de masse, ces données ne sont pas disponibles en temps réel, attendant d’être analysées pour fournir des informations exploitables. Étant donné que les signes vitaux ont le potentiel de prédire les fluctuations de la santé avant même que le patient ne soit au courant, il existe de nombreuses applications permettant de sauver des vies grâce à cela.

Commerce électronique

- Meilleures recommandations : C’est généralement le premier exemple que les gens donnent lorsqu’on les interroge sur les applications commerciales de l’IA, et c’est parce que c’est un domaine où l’IA a déjà donné d’excellents résultats. La plupart des grands acteurs du commerce électronique ont incorporé l’intelligence artificielle pour faire des recommandations de produits qui pourraient intéresser les utilisateurs, ce qui a conduit à des augmentations considérables de leurs résultats.

- Chatbots : Un autre exemple célèbre, basé sur la prolifération des chatbots d’intelligence artificielle à travers les industries, et tous les autres sites Web que nous semblons visiter. Ces chatbots sont maintenant au service des clients dans les heures impaires et les heures de pointe, supprimant le goulot d’étranglement des ressources humaines limitées.

- Filtrer le spam et les faux commentaires : En raison du volume élevé d’avis que les sites comme Amazon reçoivent, il serait impossible pour les yeux humains de scanner à travers eux pour filtrer le contenu malveillant. Grâce à la puissance de NLP, l’Intelligence Artificielle peut scanner ces commentaires pour identifier les activités suspectes et les filtrer, ce qui rend une meilleure expérience de l’acheteur.

- Optimisation de la recherche : Tout le commerce électronique dépend de la recherche d’utilisateurs de ce qu’ils veulent et de leur recherche. L’intelligence artificielle a été l’optimisation des résultats de recherche en fonction de milliers de paramètres pour s’assurer que les utilisateurs trouvent le produit exact qu’ils recherchent.

- Chaîne d’approvisionnement : L’IA est utilisée pour prédire la demande de différents produits dans différents délais afin qu’ils puissent gérer leurs stocks pour répondre à la demande.

Ressources humaines

- Construire une culture du travail : l’IA est utilisée pour analyser les données des employés et les placer dans les bonnes équipes, attribuer des projets en fonction de leurs compétences, recueillir des commentaires sur le lieu de travail et même essayer de prédire s’ils sont sur le point de quitter leur entreprise.

- Embauche : Avec NLP, l’IA peut passer par des milliers de CV en quelques secondes, et de vérifier s’il y a un bon ajustement. Cela est bénéfique parce qu’il serait dépourvu de toute erreur humaine ou de biais, et réduirait considérablement la durée des cycles d’embauche.

Tendances de carrière dans l’intelligence artificielle

Les carrières en IA ont augmenté régulièrement au cours des dernières années et continueront de croître à un rythme accéléré. 57% des entreprises indiennes sont impatientes d’embaucher les bons talents pour correspondre au besoin du marché. En moyenne, il y a eu une augmentation de 60 à 70% des salaires des aspirants qui ont réussi leur transition vers des postes d’IA. Selon la recherche, la demande d’emplois en IA a augmenté, mais la main-d’œuvre efficace n’a pas suivi le rythme. Selon le WEF, 133 millions d’emplois seraient créés en intelligence artificielle en 2020.

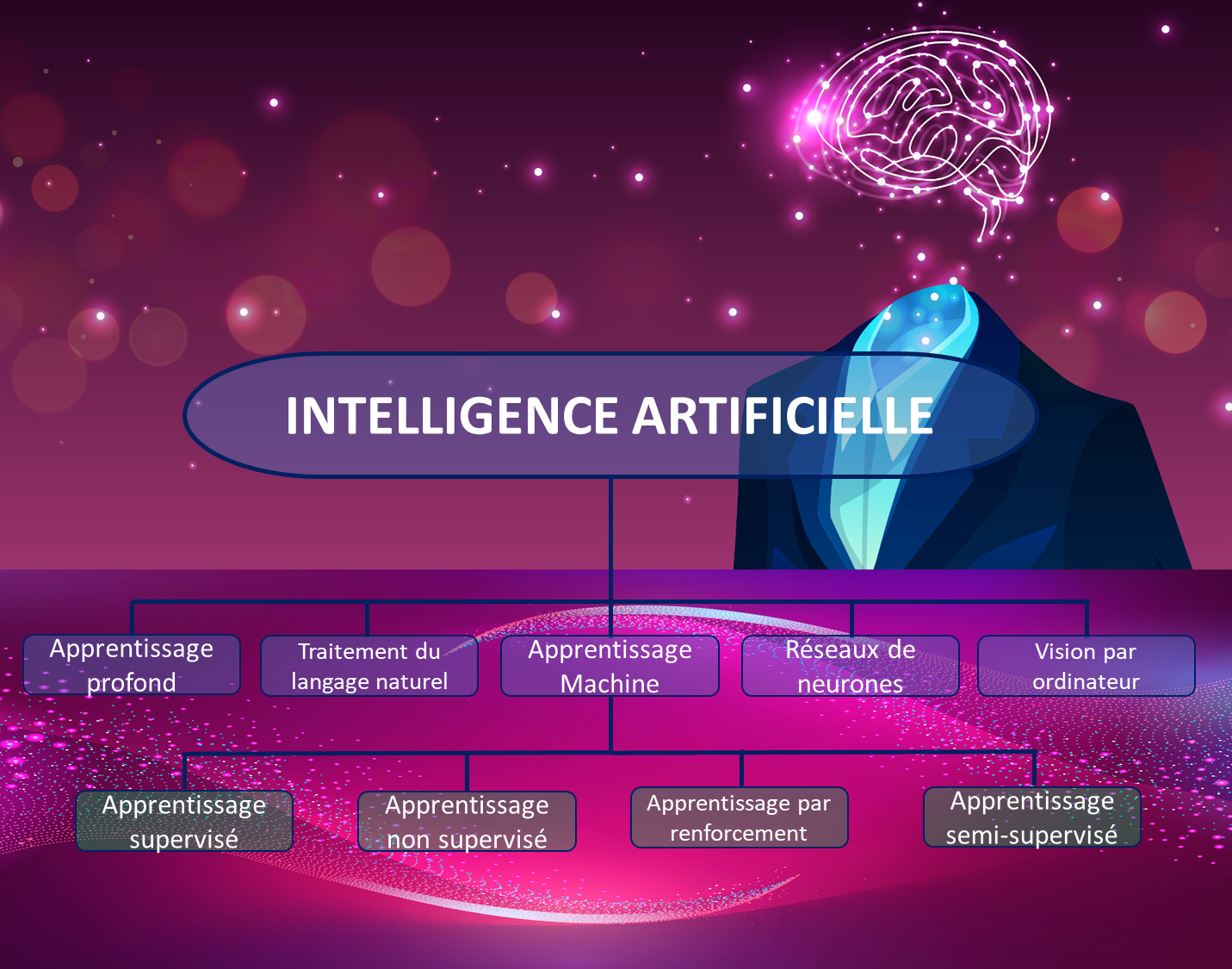

Qu’est-ce que l’apprentissage automatique ?

L’apprentissage automatique est un sous-ensemble de l’intelligence artificielle (IA) qui définit l’un des principes fondamentaux de l’Intelligence Artificielle – la capacité d’apprendre de l’expérience, plutôt que de simples instructions. Les algorithmes d’apprentissage automatique apprennent et s’améliorent automatiquement en apprenant de leur production. Ils n’ont pas besoin d’instructions explicites pour produire la sortie désirée. Ils apprennent en observant leurs ensembles de données accessibles et les comparent avec des exemples de la sortie finale. L’examen de la sortie finale pour tous les modèles reconnaissables tenterait d’inverser l’ingénierie des facettes pour produire une sortie.

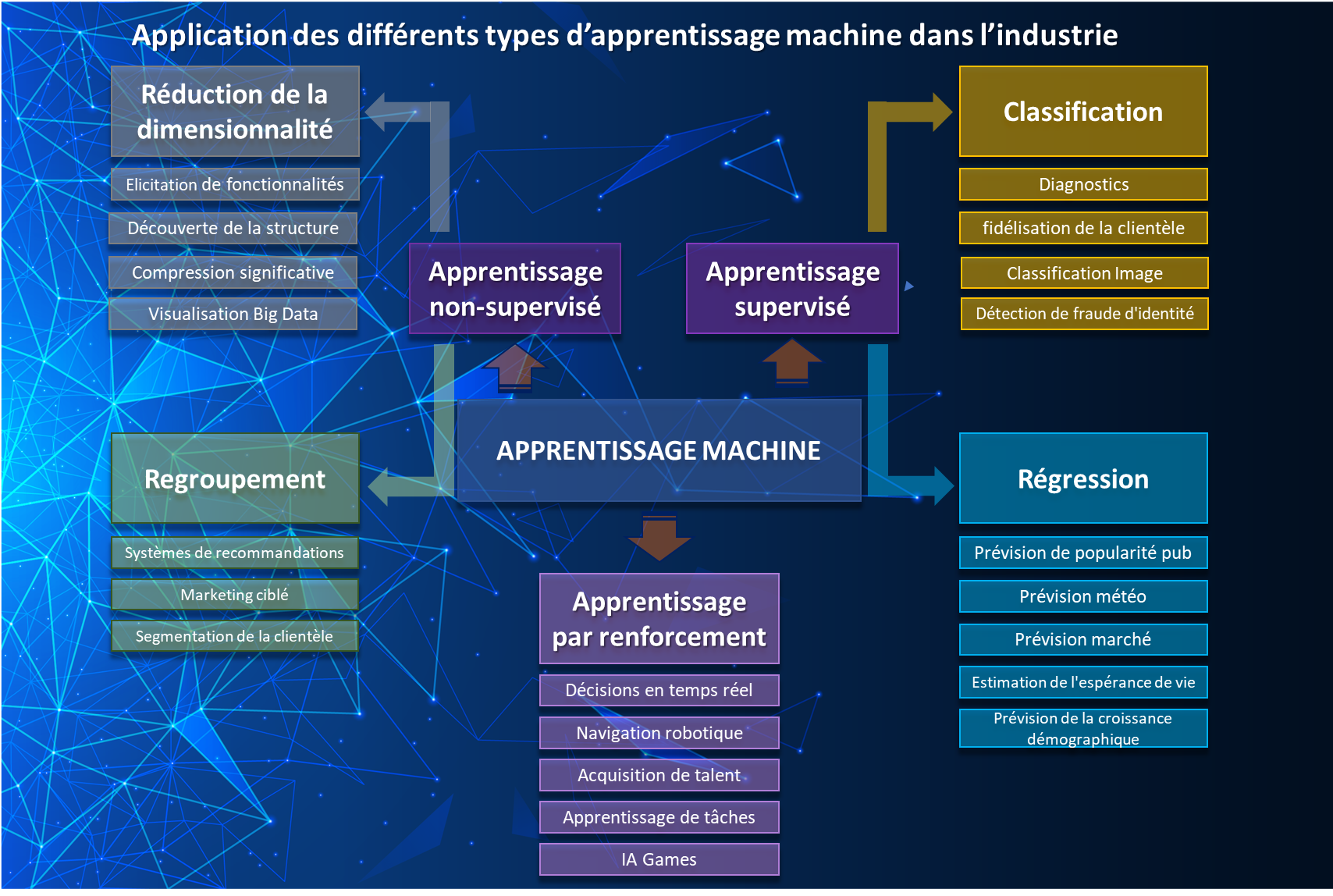

Quels sont les différents types d’apprentissage automatique ?

Les types d’apprentissage automatique sont :

- Apprentissage supervisé

- Apprentissage non supervisé

- Apprentissage semi-supervisé

- Apprentissage de renforcement

Qu’est-ce que l’apprentissage supervisé ?

L’apprentissage automatique supervisé applique ce qu’il a appris sur la base de données antérieures et l’applique pour produire la sortie souhaitée. Ils sont généralement formés avec un ensemble de données spécifique sur la base duquel l’algorithme produirait une fonction inférée. Il utilise cette fonction inférée pour prédire la sortie finale et en fournit une approximation.

C’est ce qu’on appelle un apprentissage supervisé car l’algorithme doit être enseigné avec un ensemble de données spécifique pour l’aider à former la fonction inférée. L’ensemble de données est clairement étiqueté pour aider l’algorithme à « mieux comprendre » les données. L’algorithme peut comparer sa sortie avec la sortie étiquetée pour modifier son modèle pour être plus précis.

Qu’est-ce que l’apprentissage non supervisé ?

Avec un apprentissage non supervisé, les données de formation sont toujours fournies mais elles ne sont pas étiquetées. Dans ce modèle, l’algorithme utilise les données d’apprentissage pour faire des inférences basées sur les attributs des données d’apprentissage en explorant les données pour trouver des modèles. Il forme sa logique pour décrire ces modèles et base sa sortie sur cela.

Qu’est-ce que l’apprentissage semi-supervisé ?

Ceci est similaire aux deux précédents, à la seule différence qu’il utilise une combinaison de données étiquetées et non étiquetées. Cela résout le problème d’avoir à étiqueter de grands ensembles de données – le programmeur peut simplement étiqueter un petit sous-ensemble des données et laisser la machine comprendre le reste en fonction de cela. Cette méthode est généralement utilisée lorsque l’étiquetage des ensembles de données n’est pas réalisable, soit en raison de volumes importants soit à cause d’un manque de ressources qualifiées pour l’étiqueter.

Qu’est-ce que l’apprentissage profond ?

Le Deep Learning est un sous-domaine du machine learning qui s’intéresse aux algorithmes inspirés par la structure et la fonction du cerveau appelés réseaux de neurones artificiels. Les concepts de Deep Learning sont utilisés pour enseigner aux machines ce qui nous vient naturellement. En utilisant le Deep Learning, un modèle informatique peut apprendre à exécuter des actes de classification en prenant une image, du texte ou du son en entrée.

Le Deep Learning devient populaire car les modèles sont capables d’atteindre une précision de pointe. De grands ensembles de données étiquetés sont utilisés pour former ces modèles avec les architectures de réseaux de neurones.

Autrement dit, le Deep Learning utilise des simulations cérébrales dans l’espoir de rendre les algorithmes d’apprentissage efficaces et plus simples à utiliser. Voyons maintenant quelle est la différence entre le Deep Learning et le Machine Learning.

Deep Learning vs Machine Learning

| Apprentissage profond (Deep Learning) | Apprentissage automatique (Machine Learning) |

| Les performances d’un modèle d’apprentissage en profondeur augmentent à mesure que la quantité de données d’entrée augmente | Le graphique des performances des plateaux du modèle d’apprentissage automatique et ne s’améliore pas avec l’augmentation de la quantité de données au-delà d’un certain point |

| Les algorithmes d’apprentissage en profondeur dépendent de machines haut de gamme car ils nécessitent des GPU comme partie intégrante de leur fonctionnement | La dépendance matérielle est bien moindre par rapport à l’apprentissage en profondeur |

| Les algorithmes d’apprentissage en profondeur tentent d’apprendre des fonctionnalités de haut niveau à partir des données. Par conséquent, l’apprentissage en profondeur réduit la tâche de développer de nouveaux extracteurs de fonctionnalités pour chaque problème | Dans le Machine Learning, la plupart des fonctionnalités appliquées doivent être identifiées par un expert, puis codées manuellement selon le domaine et le type de données |

| L’apprentissage en profondeur préconise la résolution d’un problème de bout en bout | L’approche d’apprentissage automatique consiste à décomposer le problème en plusieurs parties, à résoudre chaque partie et à combiner pour obtenir le résultat final |

| La formation d’un modèle d’apprentissage en profondeur prend plus de temps et peut aller jusqu’à des semaines | La formation d’un modèle d’apprentissage automatique prend beaucoup moins de temps, moins de minutes d’heures |

| Tester un modèle de Deep Learning prend beaucoup moins de temps | Tester un modèle d’apprentissage automatique prend beaucoup plus de temps par rapport à un modèle d’apprentissage en profondeur |

| Il est difficile d’interpréter comment le modèle d’apprentissage en profondeur a fait ce qu’il a fait, même si les résultats générés sont exacts | Les algorithmes d’apprentissage automatique donnent des règles précises sur la façon dont il est arrivé à une conclusion. Par conséquent, il est facile d’interpréter le raisonnement sous-jacent |

Comment l’apprentissage profond est-il utilisé : applications

Les applications d’apprentissage profond ont commencé à faire surface, mais ont une portée beaucoup plus grande pour l’avenir. Voici quelques-unes des applications d’apprentissage profond qui décideront de l’avenir.

- Ajout d’éléments d’image et de vidéo – Des algorithmes d’apprentissage profond sont en cours de développement pour ajouter de la couleur aux images en noir et blanc. En outre, ajouter automatiquement des sons aux films et clips vidéo.

- Traductions automatiques par machine – Traduire automatiquement le texte dans d’autres langues ou traduire des images en texte. Bien que les traductions automatiques aient été équivalente pendant un certain temps, l’apprentissage profond atteint désormais les meilleurs résultats.

- Classification et détection d’objets – Cette technologie aide dans des applications comme la détection du visage pour les systèmes de fréquentation dans les écoles, ou la détection des criminels à l’aide de caméras de surveillance. La classification et la détection d’objets sont obtenues en utilisant de très grands réseaux neuronaux convolutionnels et ont des cas d’utilisation dans de nombreuses industries.

- Génération de texte automatique – Un grand corpus de texte est appris par l’algorithme d’apprentissage automatique et ce texte est utilisé pour écrire un nouveau texte. Le modèle est très productif dans la génération de texte significatif et peut même cartographier la tonalité du corpus dans le texte de sortie.

- Voitures autonomes – Beaucoup a été dit sur les voitures autonomes et c’est probablement l’application la plus populaire de l’apprentissage profond. Ici, le modèle doit apprendre à partir d’un grand ensemble de données pour comprendre toutes les parties clés de la conduite, d’où les algorithmes d’apprentissage profond sont utilisés pour améliorer les performances, que de plus en plus de données d’entrée viennent les alimenter.

- Applications dans le domaine de la santé – L’apprentissage profond montre des résultats prometteurs dans la détection de maladies chroniques comme le cancer du sein et le cancer de la peau. Il a également une grande portée dans les applications mobiles et de surveillance, et la prédiction et la médecine personnalisée.

Pourquoi l’apprentissage profond est-il important ?

Aujourd’hui, nous pouvons enseigner aux machines comment lire, écrire, voir et entendre en poussant suffisamment de données dans les modèles d’apprentissage et faire réagir ces machines comme les humains font, ou même mieux. L’accès à une puissance de calcul illimitée soutenue par la disponibilité d’une grande quantité de données générées par les smartphones et l’Internet a permis d’utiliser des applications d’apprentissage profond dans des problèmes de la vie réelle. C’est le moment de l’explosion de l’apprentissage profond et les leaders de la technologie comme Google sont déjà en train de l’appliquer partout où cela est possible. La performance d’un modèle d’apprentissage profond s’améliore avec une augmentation de la quantité de données d’entrée par rapport aux modèles d’apprentissage automatique, où les performances ont tendance à diminuer avec une augmentation de la quantité de données d’entrée.

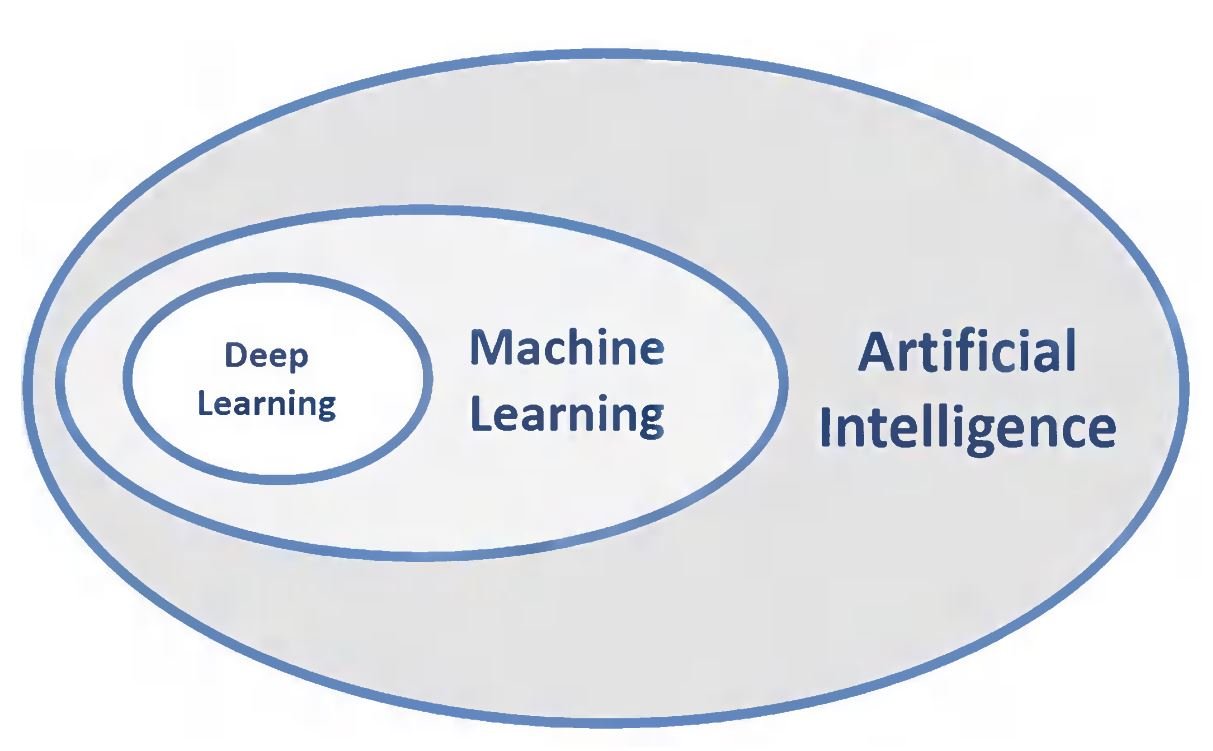

Quels sont les relations entre l’IA, le ML et le DL

Comme le montre l’image ci-dessus, les trois ovales concentriques décrivent DL comme un sous-ensemble de ML, qui est également un autre sous-ensemble de AI. Par conséquent, l’IA est le concept global qui a initialement éclaté. Il a ensuite été suivi par ML qui a prospéré plus tard, et enfin DL qui promet maintenant d’escalader les avancées de l’IA à un autre niveau.

Qu’est-ce que NLP ?

Une composante de l’Intelligence Artificielle, Le Traitement du Langage Naturel est la capacité d’une machine à comprendre la langue humaine telle qu’elle est parlée. L’objectif de NLP est de comprendre et de déchiffrer le langage humain pour finalement présenter un résultat. La plupart des techniques NLP utilisent l’apprentissage automatique pour tirer des idées du langage humain.

Quelles sont les différentes étapes de NLP ?

Les étapes de la mise en œuvre de NLP sont les suivantes :

- Le programme informatique recueille toutes les données requises. Cela comprend les fichiers de base de données, les feuilles de calcul, les chaînes de communication par courriel, les conversations téléphoniques enregistrées, les notes et toutes les autres données pertinentes.

- Un algorithme est utilisé pour supprimer tous les mots d’arrêt de ces données et normalise certains mots qui ont le même sens.

- Le texte restant est divisé en groupes connus sous le nom de jetons.

- Le programme NLP analyse les résultats pour repérer les modèles de durabilité, leur fréquence et d’autres statistiques pour comprendre l’utilisation des jetons et leur applicabilité.

Où est-utilisé NLP ?

Voici quelques-unes des applications courantes qui sont pilotées par Natural Language Processing :

- Application de traduction linguistique

- Processeurs de texte pour vérifier l’exactitude grammaticale du texte

- Les centres d’appels utilisent interactive Voice Response pour répondre aux demandes des utilisateurs ; IVR est une application NLP

- Les assistants virtuels personnels tels que Siri et Cortana sont un exemple classique de NLP

Qu’est-ce que Python ?

Python est un langage de programmation populaire orienté objet qui a été créé par Guido Van Rossum et publié en 1991. C’est l’un des langages de programmation les plus utilisés pour le développement Web, le développement de logiciels, les scripts système et de nombreuses autres applications.

Pourquoi Python est-il si populaire ?

Il y a de nombreuses raisons derrière la popularité de Python comme langage de programmation préféré, c’est-à-dire :

- La syntaxe facile à apprendre contribue à améliorer la lisibilité et donc le coût réduit de l’entretien du programme

- Il prend en charge les modules et les paquets pour encourager la réutilisation du code

- Il permet une productivité accrue car il n’y a pas d’étape de compilation rendant le cycle edit-test-debug incroyablement plus rapide

- Débogage en Python est beaucoup plus facile par rapport à d’autres langages de programmation

Où Python est-il utilisé ?

Python est utilisé dans de nombreuses applications du monde réel telles que :

- Développement du Web et d’Internet

- Applications dans Desktop GUI

- Applications scientifiques et numériques

- Applications de développement de logiciels

- Applications en entreprise

- Demandes dans l’éducation

- Accès à la base de données

- Jeux et graphiques 3D

- Programmation réseau

Comment puis-je apprendre Python ?

Il y a beaucoup de contenu en ligne sous la forme de vidéos, blogs et e-books pour apprendre Python. Vous pouvez extraire autant d’informations que vous pouvez à travers le matériel en ligne. Mais, si vous voulez un apprentissage plus pratique dans un format guidé, vous pouvez vous inscrire à des cours Python fournis par de nombreuses entreprises et apprendre Python avec l’apprentissage pratique grâce à des projets d’un expert qui serait votre mentor. Il y a beaucoup de cours hors ligne en classe disponibles aussi.

Qu’est-ce que la vision par ordinateur ?

Computer Vision est un domaine d’étude où des techniques sont développées permettant aux ordinateurs de « voir » et de comprendre les images et vidéos numériques. Le but de la vision par ordinateur est de tirer des inférences de sources visuelles et de l’appliquer à la résolution d’un problème réel.

À quoi s’attaque la Computer Vision ?

Il existe de nombreuses applications de la vision par ordinateur aujourd’hui, et l’avenir a une portée immense.

- Reconnaissance faciale pour les systèmes de surveillance et de sécurité

- Les magasins de détail utilisent également la vision par ordinateur pour le suivi des stocks et des clients

- Véhicules autonomes

- La vision par ordinateur en médecine est utilisée pour diagnostiquer les maladies

- Les institutions financières utilisent la vision par ordinateur pour prévenir la fraude, autoriser les dépôts mobiles et afficher l’information visuellement

Qu’est-ce que Deep Learning Computer Vision

Voici les utilisations de l’apprentissage profond pour la vision par ordinateur :

- Classification et localisation des objets : Il s’agit d’identifier les objets de différentes classes d’images ou de vidéos ainsi que leur emplacement mis en évidence généralement avec une boîte carrée autour d’eux.

- Segmentation sémantique : Il s’agit de réseaux neuronaux pour classer et localiser tous les pixels d’une image ou d’une vidéo.

- Colorisation : Conversion d’images à l’échelle grise en images en couleur.

- Reconstruire des images : Reconstruire des images corrompues et falsifiées.

Qu’est-ce que les réseaux neuronaux ?

Neural Network est une série d’algorithmes qui imitent le fonctionnement du cerveau humain pour déterminer les relations et les modèles sous-jacents dans un ensemble de données.

À quoi sont utilisés les réseaux neuronaux ?

Le concept de Réseaux Neuronal s’est avéré utile dans le développement de systèmes de négociation pour le secteur financier. Ils aident également à l’élaboration de processus tels que la prévision des séries chronologiques, la classification des sécurités et la modélisation du risque de crédit.

Quels sont les différents réseaux neuronaux ?

Les différents types de réseaux neuronaux sont :

- Réseau de neurones à action directe : Neurone artificiel: Ici, les entrées de données se déplacent dans une seule direction, en provenance du nœud d’entrée et en sortant sur le nœud de sortie.

- Réseau de neurones à fonction de base radiale : Pour leur fonctionnement, le réseau de neurones à fonction de base radiale tient compte de la distance entre un point et le centre.

- Réseau neuronal auto-organisateur de Kohonen : L’objectif ici est de saisir des vecteurs de dimension arbitraire sur une carte discrète composée de neurones.

- Réseau de neurones récurrents (RNN) : le réseau de neurones récurrents enregistre la sortie d’une couche et la renvoie à l’entrée pour aider à prédire la sortie de la couche.

- Réseau neuronal convolutif : il est similaire aux réseaux neuronaux à action directe, les neurones ayant des biais et des poids apprenants. Il est appliqué au traitement du signal et de l’image.

- Réseaux neuronaux modulaires : il s’agit d’un ensemble de nombreux réseaux neuronaux différents, chacun traitant une sous-tâche. Chacun d’eux a un ensemble unique d’entrées par rapport à d’autres réseaux de neurones contribuant à la sortie.

Quels sont les avantages des réseaux de neurones?

Les trois principaux avantages des réseaux de neurones sont:

- La capacité d’apprendre et de modéliser des relations non linéaires et complexes

- Les RNA peuvent également généraliser des modèles qui infèrent des relations invisibles sur des données invisibles

- ANN n’impose aucune restriction sur les variables d’entrée.

Des organisations du monde entier sont à l’origine d’innovations révolutionnaires en matière d’intelligence artificielle et d’apprentissage automatique. Par conséquent, il existe d’immenses possibilités pour les professionnels formés et certifiés d’entrer dans une carrière enrichissante. À mesure que ces technologies continueront de croître, elles auront de plus en plus d’impact sur le milieu social et la qualité de vie.

Laisser un commentaire

Vous devez être dentifié pour poster un commentaire.