Résumé de la publication

VMware vSphere est une plate-forme de virtualisation de VMware, qui transforme les centres de données en infrastructures informatiques agrégées incluant le CPU, le stockage et les ressources de mise en réseau. vSphere gère ces infrastructures sous forme d’environnement d’exploitation unifié et fournit les outils permettant d’administrer les centres de données qui participent à cet environnement.

Les deux principaux composants de vSphere sont ESXi et vCenter Server. ESXi est la plate-forme de virtualisation sur laquelle vous créez et exécutez des machines virtuelles et des dispositifs virtuels. vCenter Server est le service qui vous permet de gérer plusieurs hôtes connectés dans un réseau et les ressources d’hôtes dans un pool.

Objectifs de la publication

- Comprendre le fonctionnement de vSphere

- Apprendre à déployer une solution vSphere

- Mettre à jour une solution vSphere

- Configurer une solution vSphere (réseau, stockage, etc.)

- Mettre en place une banque de données avec VMFS un stockage SIOC

- Configuration de DRS, DPM et EVC

- Mettre en place une architecture haute disponibilité

- Gestion de profil et création d’images ESXi

Lien vers la partie 2

Déploiement d’une nouvelle infrastructure vSphere 6.7

vSphere est une suite de solutions d’infrastructure de base qui constituent la base de tout centre de données moderne virtualisé à l’aide de VMware. La planification du déploiement de ces composants et de leur mise en œuvre est importante car elle constitue la base de toute autre solution.

vSphere comprend essentiellement l’hyperviseur (ESXi), vCenter Server et ses plug-ins, prenant en charge les bases de données et les agents de gestion d’hôte. Ces hyperviseurs créent une plate-forme pour exécuter des machines virtuelles (VM) et vCenter forme la couche de gestion. vCenter permet la création de centres de données virtuels. Toutes les autres solutions s’interfacent et interagissent avec vCenter pour gérer ou utiliser le centre de données virtuel. Par exemple, vRealize Automation, NSX et vRealize Operations interagissent avec vCenter.

Cela dit, VMware propose des API qui permettent aux développeurs de logiciels tiers de créer des outils qui aident à gérer les plates-formes ou à tirer parti de la couche de gestion formée par les serveurs vCenter dans un environnement. Par exemple, votre logiciel de sauvegarde interagit avec vCenter pour gérer les sauvegardes de machines virtuelles.

Les composants logiciels suivants constituent la base d’un environnement vSphere :

- Hyperviseur : VMware ESXi 6.7

- Logiciel de gestion de base : serveur VMware vCenter 6.7 et ses composants

- Logiciel de gestion des correctifs : VMware Update Manager 6.7

ESXi Hypervisor est la couche d’abstraction qui vous permet d’exécuter plusieurs instances de systèmes d’exploitation traditionnels en tant que VM partageant les mêmes ressources physiques. Avec chaque version majeure, la version 6.7 améliore la capacité de l’hyperviseur à évoluer, ainsi que d’autres nouvelles fonctionnalités. L’une des nouvelles fonctionnalités notables est le démarrage rapide. Contrairement aux versions précédentes, un redémarrage ne redémarre pas l’hôte; au lieu de cela, il redémarre uniquement l’hyperviseur, réduisant ainsi une quantité considérable de temps qui serait autrement nécessaire lors de l’initialisation du serveur.

Lisez le livre blanc QUOI DE NEUF DANS VMWARE vSPHERE 6.7 pour un bref aperçu de toutes les nouvelles fonctionnalités de vSphere 6.7 sur https://www.vmware.com/content/dam/digitalmarketing/vmware/en/pdf/products/vsphere/vmware- whats-new-in-vsphere-whitepaper.pdf.

Bien que le livre soit basé sur vSphere 6.7 U1, VMware a publié deux mises à jour supplémentaires après cela. Lisez les notes de publication de vSphere 6.7 U2 et U3 pour plus de détails.

vSphere 6.7 U2: https://docs.vmware.com/en/VMware-vSphere/6.7/rn/vsphere-esxi-67u2-release-notes.html et https://docs.vmware.com/en/VMware- vSphere / 6.7 / rn / vsphere-vcenter-server-67u2-release-notes.html

vSphere 6.7U3: https://docs.vmware.com/en/VMware-vSphere/6.7/rn/vsphere-esxi-67u3-release-notes.html et https://docs.vmware.com/en/VMware- vSphere / 6.7 / rn / vsphere-vcenter-server-67u3-release-notes.html

Logiciel de gestion de base – VMware vCenter Server 6.7 et ses composants :

Le vCenter Appliance avec vSphere 6.5 a été une amélioration significative et a vu un changement substantiel dans l’adoption de vCenter Server Appliance (VCSA). VCSA 6.5 / 6.7 est également évolutif, car la version Windows du vCenter, il va sans dire, est plus stable et plus facile à dépanner car tous les composants logiciels sont conditionnés pour fonctionner sur un système d’exploitation Linux léger appelé PHOTON OS (https: // vmware.github.io/photon/ ). En outre, VMware s’éloigne progressivement de sa dépendance à l’égard des systèmes de base de données Microsoft SQL et Oracle en utilisant une base de données basée sur PostgreSQL ( https://www.postgresql.org/ ) appelée vPostgres.

vSphere 6.7 sera la dernière version qui inclut une version Windows installable de vCenter. Toutes les futures versions de vCenter seront uniquement en tant qu’appliance (VCSA).

VMware a commencé à regrouper les services essentiels, tels que l’authentification unique, le service d’inventaire et la gestion des certificats, en un seul composant gérable appelé Platform Services Controller ( PSC ), à partir de vSphere 6.0. Avec les versions antérieures à vCenter 6.0 pour Windows, tous ces composants avaient des programmes d’installation individuels, ce qui leur permettait soit d’être installés sur la même machine que vCenter soit installés sur des machines distinctes. Par conséquent, il est devenu nécessaire de protéger et de gérer plusieurs machines virtuelles ou physiques exécutant Windows. Il a également rendu la mise à niveau et le dépannage fastidieux. Les regrouper sur la même machine Windows ou les déployer en tant qu’appliance a facilité la gestion et la mise à niveau de ces composants.

PSC peut être déployé en tant que machine virtuelle distincte (Windows / VCSA) ou rester en tant que composant intégré de VCSA. Depuis vSphere 6.7, le besoin d’un PSC externe est obsolète.

SSO est un composant serveur d’authentification intégré au PSC. Il agit comme une passerelle d’authentification et accepte les demandes d’authentification des composants enregistrés et valide la paire d’informations d’identification par rapport aux sources d’identité qui sont ajoutées au serveur SSO. Une fois authentifiés avec succès, ils reçoivent des jetons de sécurité pour les échanges d’authentification à l’avenir.

vCenter Update Manager ( VUM ) est utilisé pour mettre à niveau ou corriger un environnement vSphere. Il est principalement utilisé pour installer des correctifs ou effectuer des mises à niveau ESXi. Il peut effectuer des tâches supplémentaires, telles que la mise à niveau des outils VMware et la mise à niveau du matériel de la machine virtuelle. La solution est entièrement intégrée à vCenter Appliance et est activée par défaut.

Certificat vSphere Manager est un certificat intégré gestionnaire qui utilise l’autorité de certification VMware (VMCA) comme l’autorité par défaut émission.

VMware Licensing Service est un référentiel pour les informations de licence de tous les produits VMware qui fonctionnent avec PSC / vCenter. Les informations de licence sont répliquées entre les PSC qui se trouvent dans le même domaine SSO.

La base de données vCenter est la source de vérité pour vCenter. vCenter ne fonctionnera pas sans une connexion active à la base de données.

Dans ce chapitre, nous couvrirons les recettes suivantes :

- Installer ESXi – la méthode interactive

- Configuration du réseau de gestion ESXi

- Déploiement scripté d’ESXi

- Déploiement de vCenter Server Appliance (VCSA)

- Déploiement de vCenters dans une configuration Linked Mode

- Configuration des sources d’identité à authentification unique (SSO)

- Configuration des rôles et autorisations vCenter

- Joindre ESXi à un domaine Active Directory

Installer ESXi – la méthode interactive

VMware ESXi peut être installé de plusieurs manières. L’approche traditionnelle consiste à utiliser l’image du CD / DVD-ROM ESXi pour effectuer une installation interactive. Dans cette recette, nous apprendrons comment installer ESXi à l’aide de l’image du programme d’installation amorçable.

Se préparer

Avant de commencer, il est recommandé de consulter le Guide de compatibilité VMware pour vérifier si le matériel du serveur est compatible avec VMware ESXi 6.7.

Le Guide de compatibilité VMware est disponible à l’adresse http://www.vmware.com/resources/compatibility/search.php.

Configuration matérielle requise

Une fois que vous vous êtes assuré que le matériel du serveur est compatible, l’étape suivante consiste à vous assurer que le serveur répond aux exigences de capacité matérielle, qui sont les suivantes :

- Le serveur physique doit avoir au moins deux cœurs de processeur x86 64 bits.

- Les fonctions de processeur AMD No Execute (NX) et Intel Execute Disable (XD) doivent être activées dans le BIOS du serveur.

- Pour pouvoir exécuter des systèmes d’exploitation 64 bits sur des machines virtuelles, vous devez autoriser l’utilisation de la virtualisation matérielle (Intel VT-x ou AMD RVI) dans le BIOS du serveur.

- Un minimum de 4 Go de mémoire physique pour l’hyperviseur seul et 4 Go supplémentaires pour commencer à héberger des machines virtuelles.

Logiciel requis pour l’installation

L’image ISO de l’hyperviseur VMware ESXi 6.7 peut être téléchargée à partir de la page de téléchargements de VMware, à l’adresse https://my.vmware.com/web/vmware/downloads.

Les fournisseurs de serveurs fournissent des images personnalisées d’ESXi afin qu’il puisse inclure les pilotes et d’autres composants, tels que les fournisseurs CIM. Contactez toujours le fournisseur pour télécharger l’image OEM ESXi.

Utilisation de l’image ESXi

Vous avez besoin d’un moyen de présenter l’ISO à la machine physique afin qu’elle puisse démarrer à partir de celle-ci.

Bien sûr, vous pouvez graver l’ISO sur un DVD physique, puis l’insérer dans le lecteur DVD de la machine physique. Cependant, la plupart des serveurs modernes auront une méthode pour présenter l’image ISO au serveur en tant que lecteur virtuel via son interface IPMI. Si vous êtes administrateur, vous connaissez peut-être déjà des termes tels que ILO (HP), DRAC (Dell) et KVM manager (Cisco). Ce sont des outils Web qui se connecteront à une carte d’accès à distance ( RAC ) sur le serveur et permettront l’accès à distance à la console du serveur via l’interface Web.

Comment le faire

La procédure suivante vous guidera à travers les étapes impliquées dans le déploiement d’ESXi 6.7 à l’aide du programme d’installation interactif :

- Montez l’ISO sur le serveur via son interface IPMI.

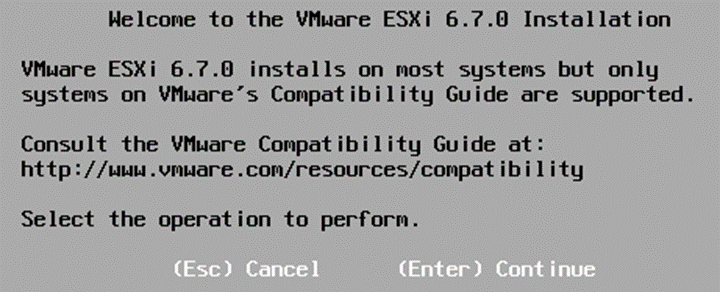

- Démarrez le serveur de l’ISO. Contrairement à l’ancienne version des programmes d’installation, il ne vous présente plus le menu de démarrage du programme d’installation. Au lieu de cela, il commence à charger le programme d’installation dans la mémoire et affiche ensuite l’écran de bienvenue suivant dans l’installation de VMware ESXi 6.7.0 :

- Une fois que vous avez appuyé sur Entrée pour continuer, sur l’écran suivant, appuyez sur F11 pour accepter le contrat de licence et continuer.

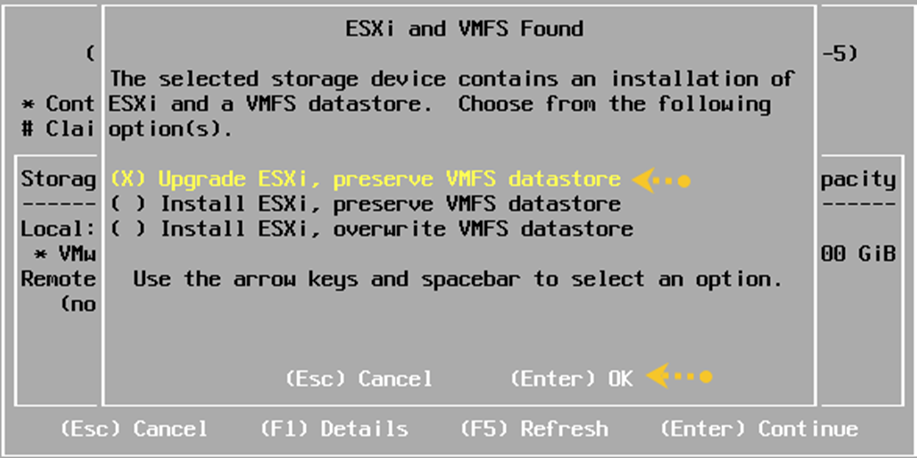

- Sur l’écran suivant, vous serez invité à choisir un périphérique de stockage sur lequel installer ESXi, qui pourrait être un SSD local, un disque dur local ou un LUN du stockage distant (dans un démarrage à partir d’un scénario SAN). Utilisez le clavier pour faire une sélection et appuyez sur Entrée pour confirmer. Alternativement, pour faire un effort prudent pour vous assurer que vous avez sélectionné le bon disque et avant de confirmer la sélection en appuyant sur Entrée, appuyez sur F1 pour obtenir plus de détails concernant le périphérique de stockage que vous avez sélectionné. L’étape 5 couvre ce processus :

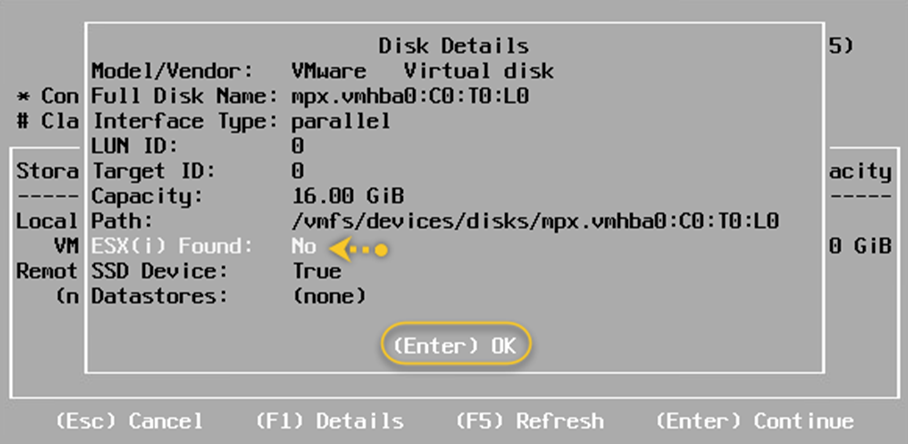

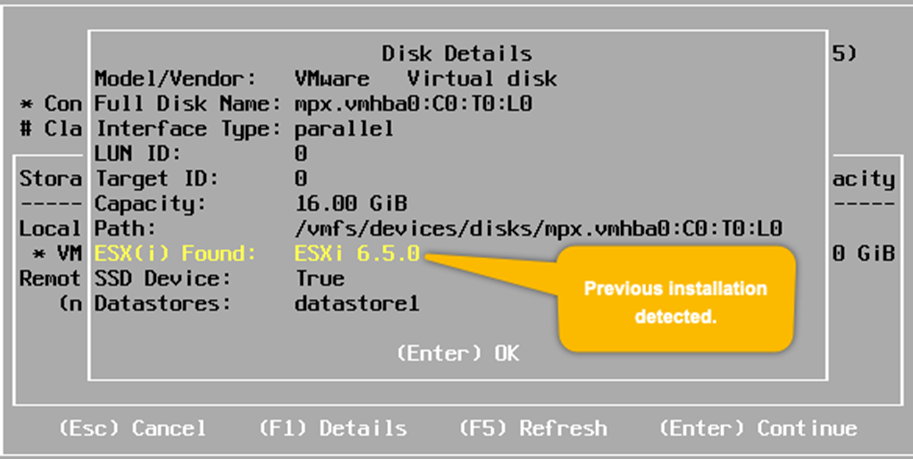

- Une étape facultative : sélectionnez le périphérique de stockage et appuyez sur F1. Il vous sera présenté aujourd’hui avec des détails uniques, tels que le chemin de CTL au périphérique, LUN ID, ID cible (si vous utilisez iSCSI), et la capacité du disque, ainsi que d’autres informations générales. Il vous indiquera également si une installation existante d’ESXi est présente sur le périphérique de stockage :

Détails généraux sur le disque

- Une fois que vous avez terminé le processus de vérification, appuyez sur Entrée. Vous serez ramené à l’écran Sélectionner un disque à installer ou à mettre à niveau. Appuyez sur Entrée pour confirmer la sélection de l’appareil.

- Sur l’écran suivant, sélectionnez une disposition de clavier. La valeur par défaut aux États-Unis est présélectionnée. Faites une sélection différente si nécessaire et appuyez sur Entrée pour continuer.

- Vous serez invité à définir un mot de passe pour le compte racine ESXi. Une fois que vous avez tapé le mot de passe, appuyez sur Entrée pour continuer.

À ce stade, le programme d’installation analysera le matériel du serveur pour rechercher des informations supplémentaires ou des conditions préalables dont il aurait besoin pour continuer. Si l’une des vérifications préalables échoue, vous serez averti en conséquence. Par exemple, si vous n’avez pas activé Intel VT-x ou AMD-V dans le BIOS, il vous en avertira. Il peut également vous avertir des périphériques non pris en charge qui sont détectés lors de l’analyse. La plupart des avertissements ne vous empêcheront pas de continuer et indiqueront uniquement ce qui ne sera pas configuré ou pris en charge. Appuyez sur Entrée pour continuer.

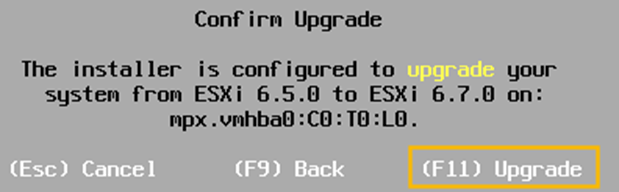

- Sur l’écran Confirmer l’installation, vérifiez le nom du périphérique de stockage qui s’affiche. Si c’est le bon appareil, appuyez sur F11 pour démarrer l’installation. En cas de doute, utilisez F9 pour revenir en arrière et apporter les modifications nécessaires :

- L’écran Installer ESXi 6.7.0 affichera la progression de l’installation. Cela pourrait prendre quelques minutes.

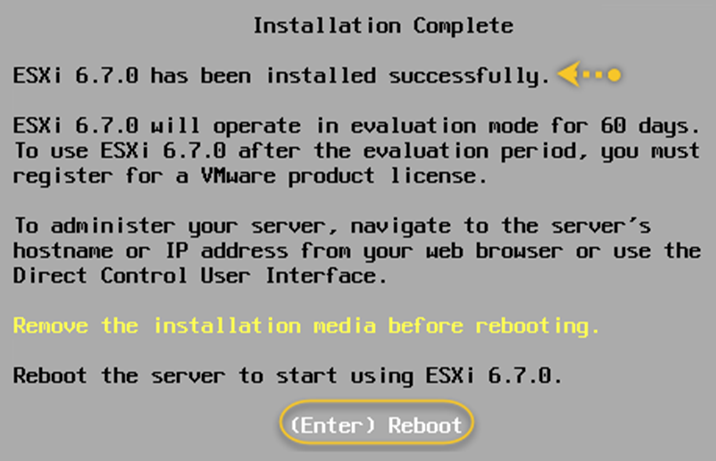

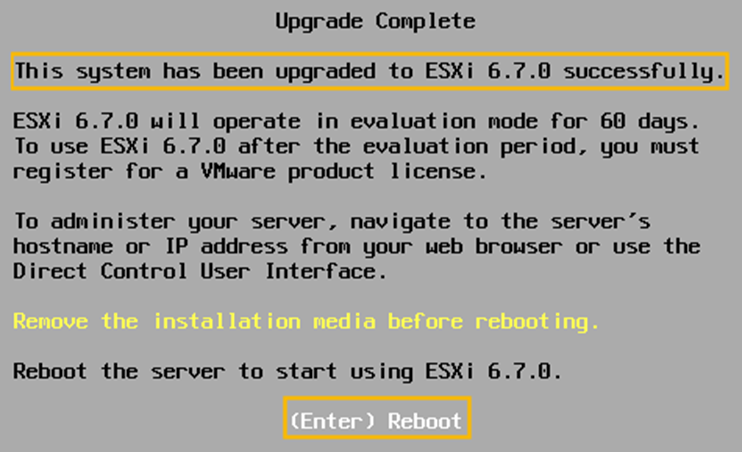

- Une fois l’installation terminée, il vous sera conseillé de retirer le support d’installation (démonter l’ISO) avant de redémarrer le serveur. Une fois cela fait, appuyez sur Entrée pour redémarrer :

- Après un redémarrage, vous serez sur l’écran principal d’ESXi 6.7.0.

Ceci termine le processus d’installation d’ESXi sur un serveur bare-metal à l’aide du programme d’installation ISO ESXi.

Comment ça marche

Le programme d’installation ESXi charge tous les modules nécessaires dans la mémoire, détecte les ressources matérielles, puis vous permet d’effectuer l’installation sur un périphérique de stockage spécifié. Une fois installé, ESXi s’exécute dans un mode d’évaluation de 60 jours et doit être concédé sous licence pour une utilisation en production. La première étape de post-installation consiste à rendre l’hôte ESXi disponible sur le réseau en configurant sa pile TCP / IP de gestion. Lisez la configuration suivante de la recette du réseau de gestion ESXi pour en savoir plus.

Configuration du réseau de gestion ESXi

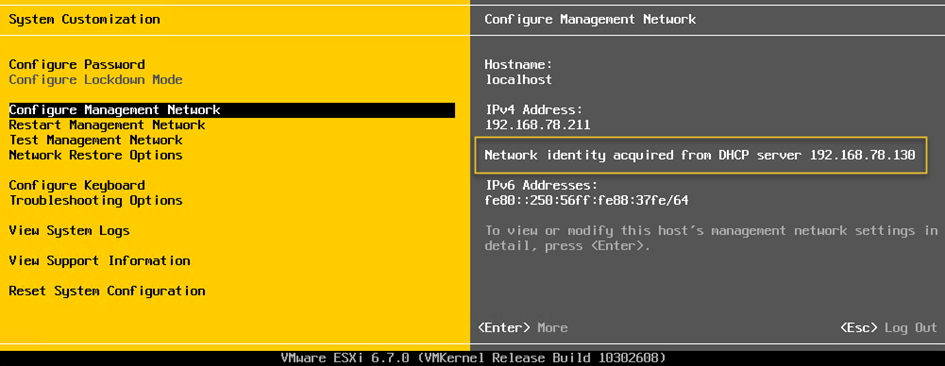

Après avoir installé ESXi, il est indispensable de configurer son réseau de gestion. La configuration du réseau de gestion est associée à une interface VMkernel. Considérez-le comme une interface réseau virtuelle pour VMkernel. Nous en apprendrons plus à ce sujet dans le chapitre 3, Configuration de l’accès réseau à l’aide de commutateurs standard vSphere. L’hyperviseur ESXi exécute un client DHCP, il obtient donc une adresse DHCP s’il y a un serveur DHCP sur son réseau ; cependant, dans la plupart des cas, cela ne suffit pas. Par exemple, si votre réseau de gestion est sur un VLAN, vous devrez configurer un ID VLAN. De plus, il est recommandé d’attribuer une adresse IP statique au réseau de gestion ESXi.

Dans cette recette, nous utiliserons l’interface utilisateur de la console directe (DCUI) pour y parvenir.

Se préparer

Vous aurez besoin des informations suivantes pour poursuivre les étapes :

- Vous aurez besoin d’accéder à la console distante du serveur via son interface IPMI (Dell DRAC, HPE ILO, Cisco KVM).

- Mot de passe du compte root.

- Configuration TCP / IP – Adresse IP, masque de sous-réseau, adresse de passerelle IP, ID VLAN, adresses de serveur DNS et nom d’hôte.

Comment le faire

La procédure suivante vous guidera à travers les étapes requises pour installer la configuration TCP / IP pour le réseau de gestion d’ESXi :

- Sur l’écran principal d’ESXi, appuyez sur F2 pour vous connecter à DCUI en fournissant le mot de passe root.

- Accédez à Configurer le réseau de gestion et appuyez sur Entrée :

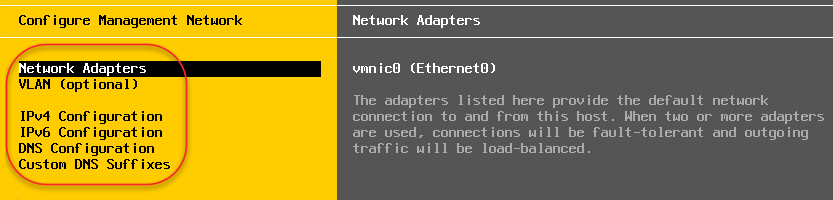

- L’écran Configurer le réseau de gestion vous présente des options pour sélectionner les adaptateurs réseau, attribuer un ID VLAN si nécessaire et configurer les paramètres IPv4 / IPv6 et la configuration DNS. Chacune de ces sections peut être sélectionnée en appuyant sur Entrée puis en utilisant les instructions à l’écran pour sélectionner / modifier / confirmer les paramètres :

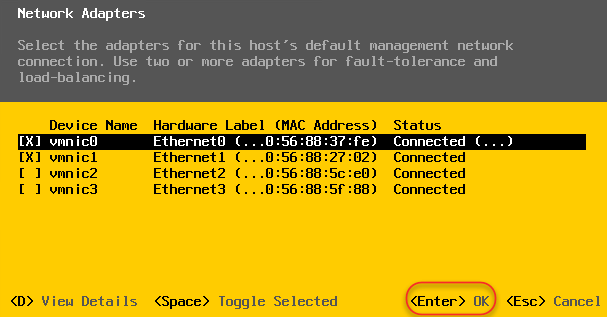

- La section Adaptateurs réseau peut être utilisée pour attribuer / annuler l’attribution d’adaptateurs au groupe de ports du réseau de gestion. Utilisez les instructions à l’écran pour effectuer des sélections et les confirmer :

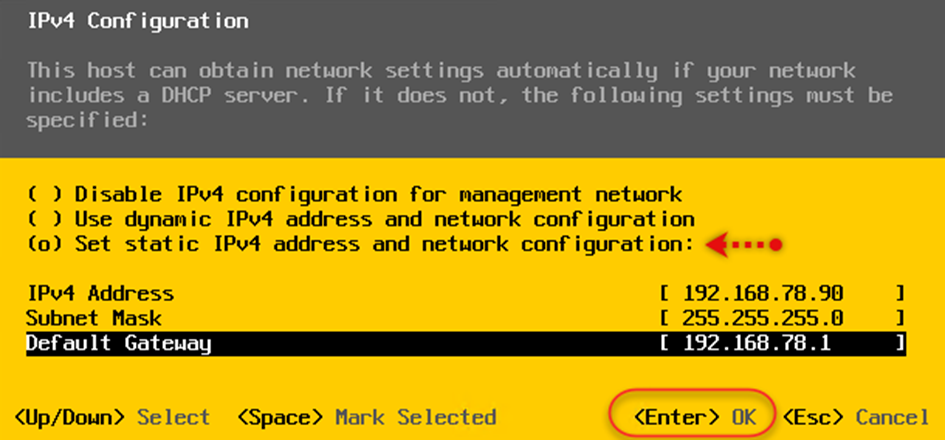

- La section VLAN (facultative) est utilisée pour fournir un ID VLAN pour l’interface. La section Configuration IPv4 est utilisée pour fournir une adresse IP / un masque de sous – réseau / une passerelle par défaut :

- La section Configuration IPv6 est utilisée pour fournir des adresses IPv6. IPv6 est activé par défaut. Si IPv6 n’est pas requis pour votre environnement, sélectionnez l’option Désactiver IPv6 (redémarrage requis) et appuyez sur Entrée.

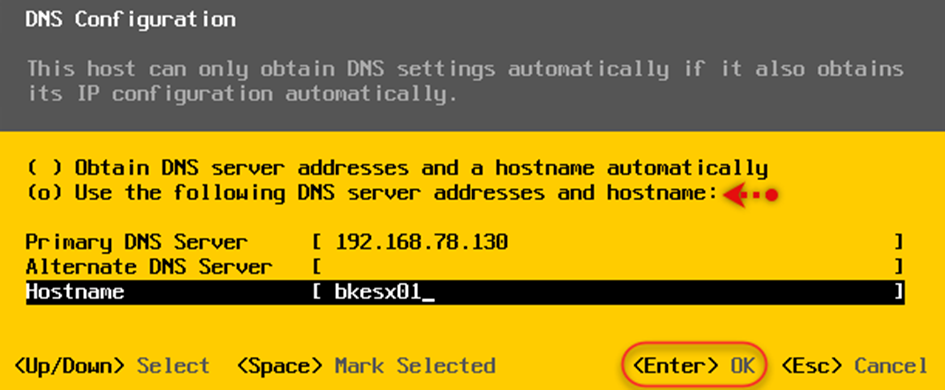

- La section Configuration DNS peut être utilisée pour fournir des adresses de serveur DNS principal / secondaire et des noms d’hôte :

Si vous ne fournissez pas de FDQN lors de la définition du nom d’hôte, assurez-vous de configurer un suffixe DNS personnalisé.

- Les suffixes DNS personnalisés sont facultatifs si vous avez utilisé un nom de domaine complet comme nom d’hôte à l’étape précédente :

- Une fois que vous avez terminé avec toute la configuration du réseau, sur l’écran Configurer le réseau de gestion : Confirmer, appuyez sur Échap. Vous serez invité à appliquer les modifications en redémarrant le réseau de gestion. Appuyez sur Y pour appliquer les paramètres et redémarrer les hôtes :

- Une fois le redémarrage terminé, vous devriez pouvoir atteindre l’hôte ESXi via le réseau. À partir de là, l’hôte ESXi peut être géré directement à l’aide du client hôte ou peut être ajouté à vCenter Server.

Comment ça marche

Tout comme les machines virtuelles qui s’exécuteraient sur les hôtes ESXi, le VMkernel devrait également s’interfacer avec le réseau à diverses fins. Ces interfaces agissent comme des points de nœud de réseau pour le VMkernel. La toute première interface VMkernel – vmk0 est créée lors de l’installation d’ESXi. Cette interface est l’interface de gestion de l’hôte ESXi. VMware vous permet de créer un maximum de 256 interfaces VMkernel (vmk0 – vmk255) sur un hôte ESXi.

Les cas d’utilisation incluent des interfaces pour le trafic de gestion, le trafic VMotion, le trafic FT, le trafic Virtual SAN, iSCSI et les interfaces NAS. Étant donné que chaque interface est un point de nœud de réseau, elle aura besoin d’une configuration IP et d’une adresse MAC.

La première interface VMkernel (vmk0) fournira l’adresse MAC de la carte réseau physique à laquelle elle est connectée. Les interfaces restantes récupèrent l’adresse MAC VMware OUI générée par l’hôte ESXi.

Déploiement scripté d’ESXi

Lorsque vous avez un grand nombre d’hôtes ESXi à déployer, toute méthode pour automatiser et réduire la quantité de travail manuel est considérée comme la meilleure solution. L’automatisation de l’installation présente l’avantage principal de normaliser plusieurs installations sans avoir à auditer soigneusement chaque installation. VMware a toujours pris en charge l’installation scriptée des hôtes ESXi, et cela n’a pas changé avec vSphere 6.7.

Comme pour toute tâche automatisée, l’installation scriptée d’un hôte ESXi nécessite l’utilisation d’un fichier de configuration qui contient la configuration d’hôte prévue qui est stockée à un emplacement accessible à l’hôte ESXi. Le fichier de configuration est appelé fichier kickstart ( .cfg ) .

Un fichier kickstart peut être stocké à l’un des emplacements pris en charge suivants :

- Un serveur web (accès via HTTP ou HTTPS)

- Un serveur de fichiers réseau (FTP / NFS)

- Un support de stockage local accessible à l’hôte (CD-ROM / USB)

Dans cette recette, nous apprendrons comment effectuer une installation sans assistance d’ESXi à l’aide du support d’installation, d’un périphérique USB local et d’un emplacement réseau.

Se préparer

Avant de commencer, préparez un script pour l’installation. Un script par défaut est disponible sur chaque hôte ESXi à /etc/vmware/weasel/ks.cfg . Bien que l’extension soit .cfg , le nom de fichier n’a pas besoin d’être le même. Il doit s’agir d’un fichier texte brut avec l’extension .cfg .

Voici un exemple de script:

# Sample scripted installation file for vdescribed.lab

# Accept the VMware End User License Agreement

vmaccepteula

# Clear/format existing partitions

clearpart –firstdisk –overwritevmfs

# Set the root password for the DCUI and Tech Support Mode

rootpw password@123

# The install media is in the CD-ROM drive

install –firstdisk –overwritevmfs

# Set a static IP Configuration

network –bootproto=static –device=vmnic0 –ip=192.168.78.91 –netmask=255.255.255.0 –gateway=192.168.78.1 –nameserver=192.168.78.130 –hostname=bkesx02

reboot

# Post Installation Tasks

%firstboot –interpreter=busybox

#Create vSwitch

esxcli network vswitch standard add –vswitch-name=vSwitch2

# Disable ipv6

esxcli network ip set –ipv6-enabled=false

sleep 30

reboot

Une fois le script préparé, stockez-le dans l’un des emplacements d’assistance. Pour cette recette, je l’ai stockée sur un serveur NFS.

Comment le faire

La procédure suivante vous guidera à travers les étapes requises pour effectuer une installation scriptée de l’hôte ESXi :

- Démarrez le serveur à l’aide de l’ISXi ISO. L’ISO peut être monté sur le serveur via son interface IPMI (DRAC, ILO, etc.).

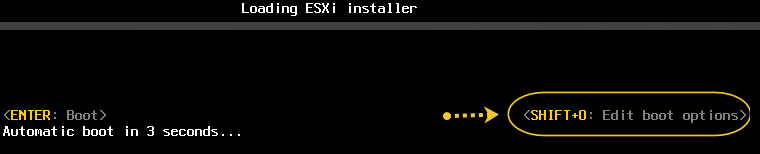

- Sur l’écran Loading ESXi Installer, avant qu’il ne démarre automatiquement, appuyez sur Maj + O pour modifier les options de démarrage. Ceci est indiqué dans le coin inférieur droit de l’écran :

- Sur l’écran suivant, entrez l’emplacement du fichier kickstart et appuyez sur Entrée pour commencer l’installation :

![]()

- Une fois l’installation terminée, si le script kickstart comprend une commande de redémarrage, comme il le fait dans notre script, le serveur sera redémarré ; sinon, vous serez invité à confirmer.

Comment ça marche

Lorsque vous utilisez un fichier kickstart, l’installation ESXi ne nécessite aucune intervention de l’utilisateur. Le fichier kickstart peut être configuré pour exécuter une variété de tâches. Il peut également être configuré pour exécuter des scripts Python après l’installation.

Examinons l’exemple de script utilisé dans cette recette. Ce script est disponible dans la section Préparation :

| Script command | Purpose |

| vmaccepteula | Accepts the ESXi End User License Agreement. |

| clearpart –firstdisk –overwritevmfs | Used to format the selected disk and overwrite any VMFS volume. This is a destructive process and cannot be reversed. |

| install –firstdisk –overwritevmfs | Used to indicate that this is a fresh installation, and the installation will be informed on the first disk in the list by overwriting any VMFS volume. |

| rootpw password@123 | Sets the root password as password@123. |

| network –bootproto=static –device=vmnic0 –ip=192.168.78.91 –netmask=255.255.255.0 –gateway=192.168.78.1 –nameserver=192.168.78.130 –hostname=bkesx02 | Configures a static IP address, a DNS server address, and a hostname for ESXi. |

| reboot | Reboots the ESXi host. |

| %firstboot –interpreter=busybox | This is used to indicate that the commands following this line will be executed on first boot. Setting the interpreter to busybox will let you execute the CLI command. Setting it to Python will let you run Python scripts. |

| esxcli network vswitch standard add -v=vSwitch2 | Creates a second standard switch with the name vSwitch2. |

| esxcli network ip set –ipv6-enabled=false | Disables IPv6. |

| sleep 30 | Will not execute any commands for 30 seconds. |

Pour obtenir la liste de toutes les commandes prises en charge dans le fichier kickstart, reportez-vous à la section Commandes de script d’installation et de mise à niveau à la page 78 du guide d’installation et de configuration de VMware ESXi, disponible à l’adresse https://docs.vmware.com/en/VMware-vSphere/6.7/vsphere-esxi-67-installation-setup-guide.pdf.

Il y a plus

Bien que l’installation par script automatise le processus dans une certaine mesure, elle vous oblige toujours à vous connecter à chaque hôte ESXi et à fournir un emplacement pour le fichier de script. Un déploiement sans assistance ne doit nécessiter aucune intervention de l’utilisateur autre que le simple démarrage du serveur. Pour ce faire, PXE démarre les hôtes et utilise le script kickstart à partir d’un emplacement réseau pour exécuter l’installation. Cependant, si un déploiement sans assistance a été pris en compte, la recommandation est d’utiliser vSphere Auto Deploy, qui offre plus de contrôle et de gestion. vSphere Auto Deploy sera traité dans un chapitre ultérieur.

Déploiement de vCenter Server Appliance (VCSA)

Le déploiement de VCSA se fait avec un programme d’installation, qui déploie la machine virtuelle VCSA sur un hôte ESXi choisi. L’interface graphique du programme d’installation collecte toutes les informations requises pour configurer le serveur vCenter.

Il existe deux types de déploiement :

- Appliance intégrée

- VCenter et PSC Appliance séparés (obsolètes)

Un PSC externe était une exigence dans le passé si vous avez choisi de configurer le mode lié amélioré pour vos vCenters. Ce n’est plus le cas dans vSphere 6.7. Avec vCenter 6.7, le concept d’un PSC externe est déconseillé et le mode lié amélioré entre les vCenters avec des PSC intégrés est désormais entièrement pris en charge. Nous en apprendrons plus sur Enhanced Linked Mode dans la rubrique Déploiement de serveurs vCenter dans une recette de configuration Linked Mode.

Se préparer

Voici ce dont vous aurez besoin avant d’installer vCenter Server :

- Téléchargez l’ISO de VMware VCSA 6.7 depuis https://my.vmware.com/web/vmware/downloads

- Accès à une machine (Windows / Linux / macOS) pour exécuter le programme d’installation de vCenter à partir de

- Adresse IP / FQDN de l’hôte ESXi ou du vCeter sur lequel VCSA sera déployé

- Configuration IP (adresse IP statique, masque de sous-réseau, adresse de passerelle et adresses de serveur DNS)

- Un enregistrement d’hôte DNS pour le VCSA

Comment le faire

La procédure suivante vous guidera à travers les étapes impliquées dans le déploiement de VCSA 6.7 avec un PSC intégré :

- Montez le VCSA ISO sur une machine à partir de laquelle exécuter le programme d’installation.

- Accédez au CD – ROM : \\ VMware VCSA \ vcsa-ui-installer \ win32 et exécutez installer.exe pour afficher l’assistant d’installation VCSA.

L’étape 1 du déploiement commence ici :

- Dans l’écran Étape 1 : Déployer l’appliance , cliquez sur Installer .

- Sur l’écran Introduction, cliquez sur Suivant pour continuer.

- Acceptez le contrat de licence utilisateur final et cliquez sur Suivant.

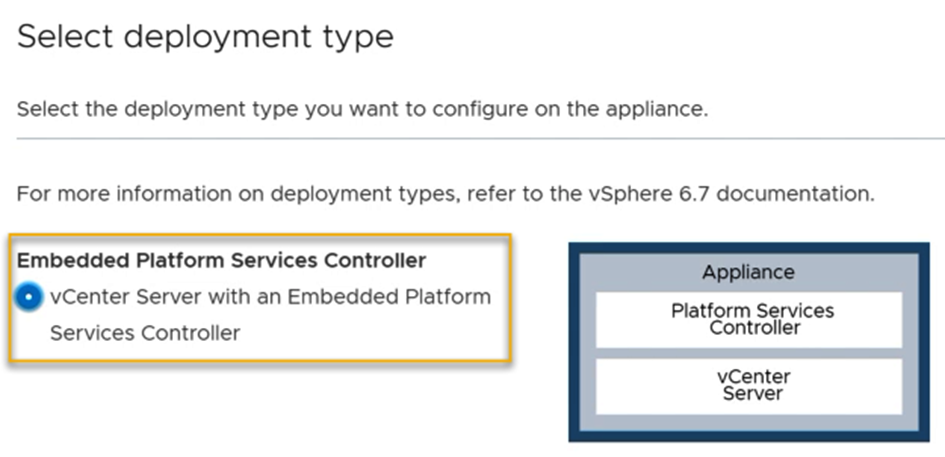

- Dans l’écran Sélectionner le type de déploiement, choisissez Embedded Platform Services Controller :

- Sur l’ écran cible de déploiement de l’appliance, indiquez l’adresse IP de l’hôte ESXi ou du vCenter sur lequel VCSA sera déployé et fournissez ses informations d’identification. Cliquer sur Suivant pour continuer.

- Acceptez le certificat vCenter / ESXi en cliquant sur Oui.

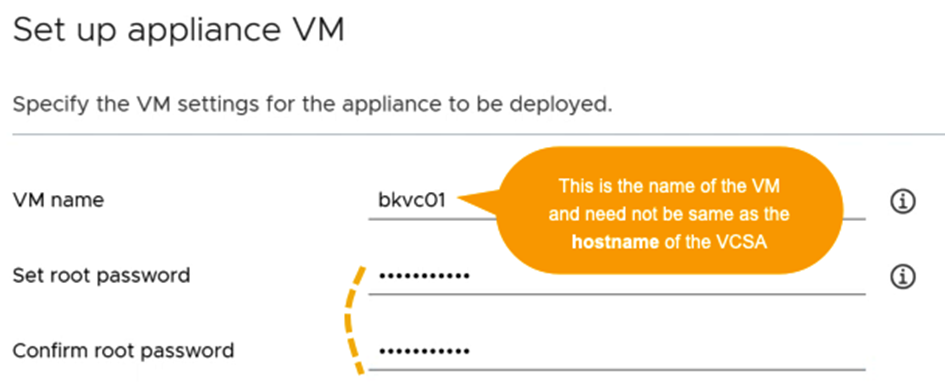

- Dans l’écran Configurer la machine virtuelle de l’appliance, spécifiez un nom de machine virtuelle pour VCSA et définissez son mot de passe racine. Le nom de la machine virtuelle n’a pas besoin d’être identique au nom d’hôte ou au nom de domaine complet de l’appliance:

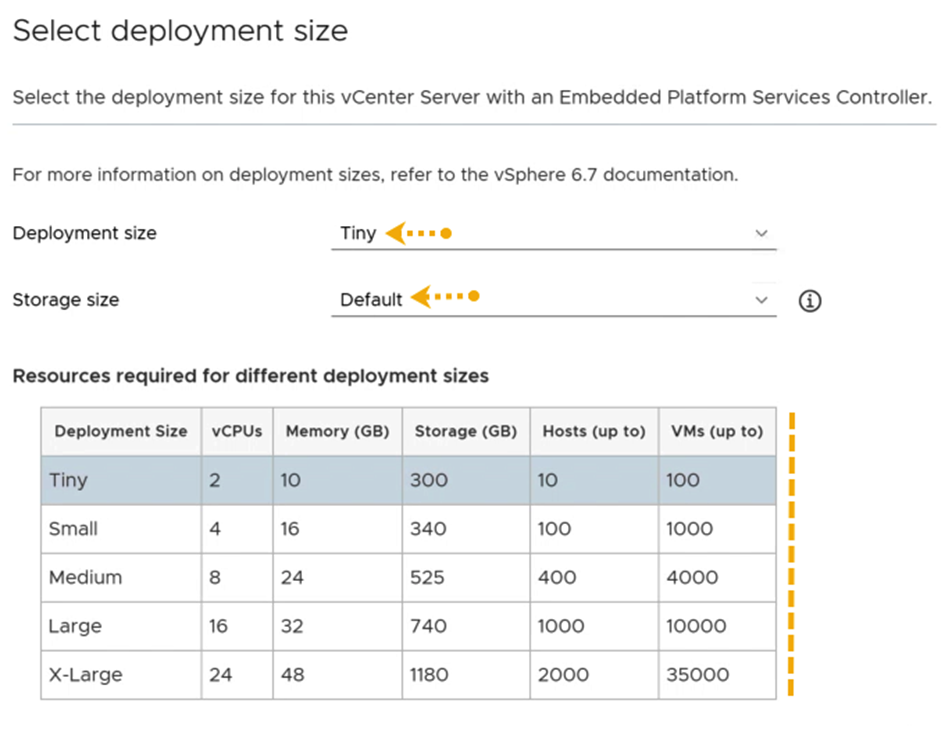

- Dans l’écran Sélectionner la taille de déploiement, spécifiez une taille de déploiement et une taille de stockage pour l’appliance. Il existe une taille de stockage par défaut pour chaque taille de déploiement. Cependant, cela peut être remplacé en sélectionnant une taille de stockage plus grande (Large ou X-Large) si vous voulez un disque plus grand (vmdk) pour la partition / storage / seat qui stocke les statistiques, les tâches, les événements et les alarmes :

- Sur l’écran Sélectionner une banque de données, choisissez une banque de données pour le VCSA et cliquez sur Suivant pour continuer. Activer le mode disque mince est sélectionné par défaut.

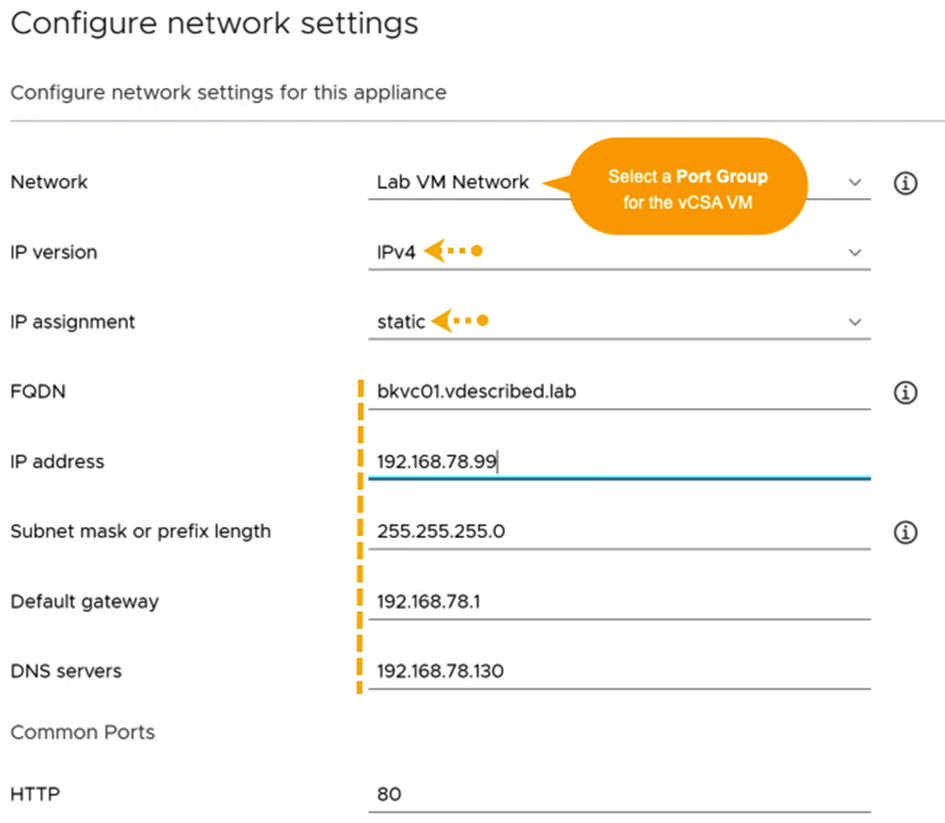

- Sur l’écran Configurer les paramètres réseau, choisissez un groupe de ports VM pour la machine virtuelle VCSA, la version IP et définissez le type d’adresse IP sur statique. Spécifiez le FQDN, l’adresse IP / le masque de réseau, la passerelle et les adresses de serveur DNS. Ne modifiez pas les ports communs (HTTP / HTTPS) de 80/443, sauf si cela est absolument nécessaire :

- Sur l’écran Prêt à terminer l’étape 1, passez en revue les paramètres et cliquez sur Terminer pour commencer à déployer la machine virtuelle.

- Une fois le déploiement terminé, un écran vous le confirmera. Cliquez sur Continuer :

Si vous fermez accidentellement l’assistant ou choisissez de continuer ultérieurement, le programme d’installation de l’étape 2 peut être démarré en se connectant à l’URL d’administration de l’appliance, c’est-à-dire https://VCSA IP ou FQDN:5480 , et en utilisant la configuration Option vCenter Server Appliance.

L’étape 2 du déploiement commence ici :

- Sur l’écran d’ installation – Étape 2: configurer vCenter Server Appliance avec un écran PSC intégré, cliquez sur Suivant.

- Sur l’écran de configuration de l’appliance, spécifiez un mode de synchronisation de l’heure et activez l’accès SSH (désactivé par défaut).

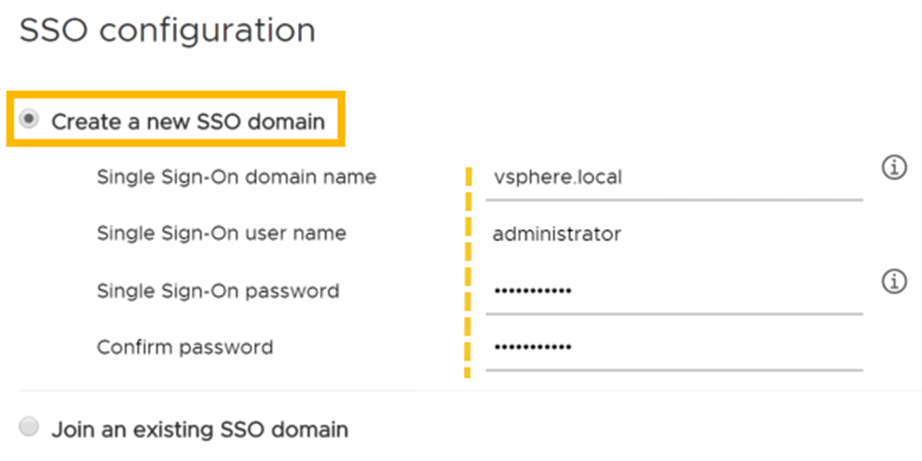

- Sur l’écran de configuration SSO, choisissez de créer un nouveau domaine SSO. Spécifiez un nom de domaine (la valeur par défaut est vsphere.local ) et définissez le mot de passe pour l’administrateur SSO:

- Sur l’écran Configure CEIP, choisissez de décocher le programme Join VMware Customer Experience Improvement Program (CIEP).

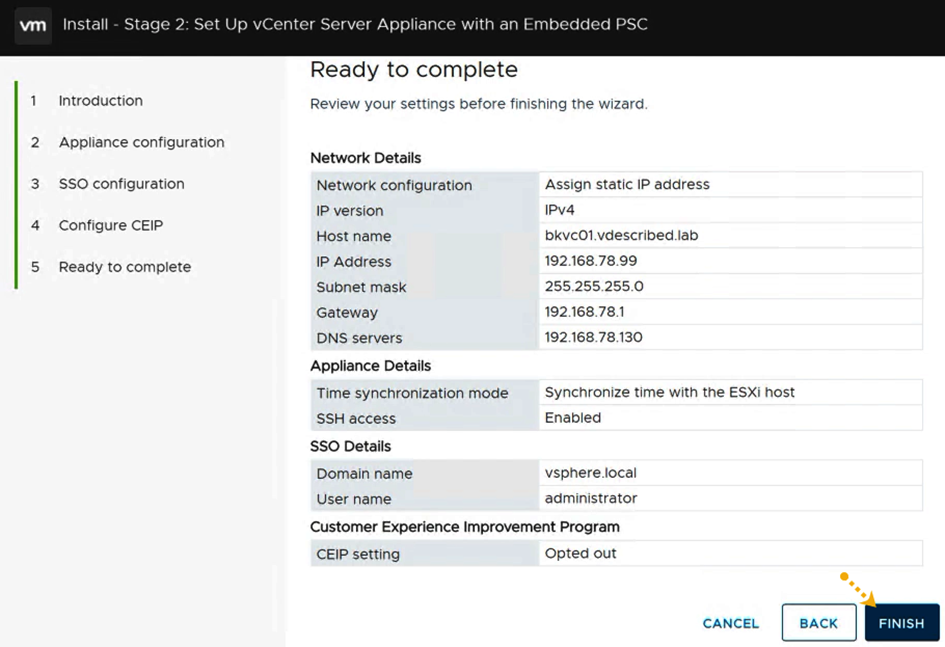

- Sur l’écran Prêt à terminer, vérifiez les paramètres et cliquez sur TERMINER pour lancer la configuration :

- Vous serez invité avec un avertissement indiquant qu’une fois que vous choisissez de continuer, l’opération ne peut pas être arrêtée. Cliquez OK pour continuer.

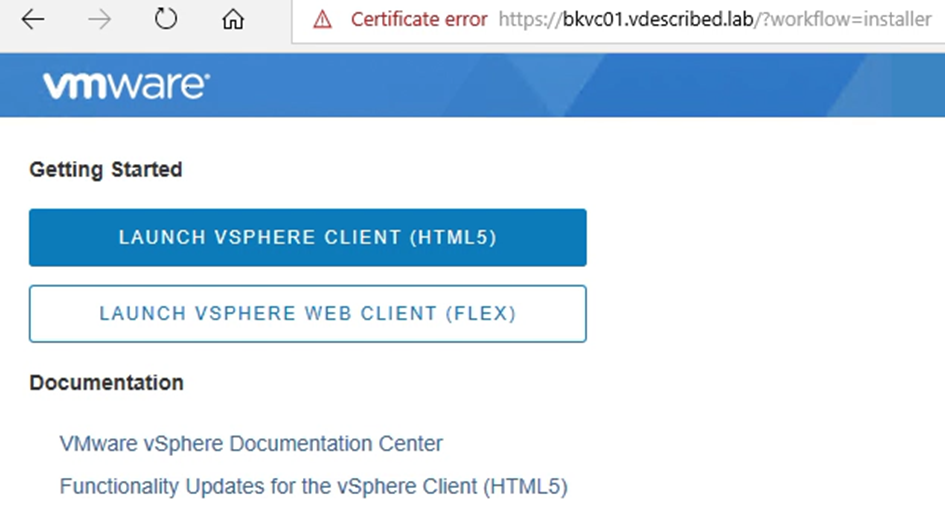

- Une fois l’installation / configuration terminée, un écran de confirmation et l’URL ( https: // FQDN de vCSA: 443 ) vous seront présentés vers la page de démarrage de vCenter. Cliquez sur Fermer pour quitter le programme d’installation.

Ceci termine l’installation, et vous pourrez maintenant accéder à la page de démarrage de vCenter:

Comment ça marche

Le processus de déploiement d’un VCSA est divisé en deux phases. Dans la phase 1 , le programme d’installation déploie une machine virtuelle de dispositif vCenter en fonction des exigences de dimensionnement spécifiées, tandis que dans la phase 2 , vous devez spécifier la configuration SSO. Il est courant de prendre un instantané du VCSA nouvellement déployé après la phase 1 afin qu’il puisse être réutilisé en cas d’échec de la phase 2 de l’installation pour une raison quelconque.

Déploiement de vCenters dans une configuration Linked Mode

Lorsque vous avez plusieurs vCenter à gérer dans votre environnement, pouvoir les gérer sous une seule vue est toujours avantageux. Ceci est réalisé en configurant les PSC pour qu’ils fassent partie du même domaine SSO, les plaçant ainsi dans une configuration Enhanced Linked Mode. Les vCenters en mode lié répliqueront les rôles et les autorisations, les licences et d’autres détails, permettant à l’administrateur d’effectuer une connexion unique dans vSphere Web Client pour afficher et gérer les objets d’inventaire de tous les serveurs vCenter liés.

vCenter 6.7 prend désormais entièrement en charge la configuration des PSC intégrés dans une configuration en mode lié, éliminant ainsi la nécessité de protéger les nœuds PSC lors de la configuration de la haute disponibilité pour vCenter.

Se préparer

Vous aurez besoin des informations suivantes à portée de main avant de continuer :

- ISO de VMware VCSA 6.7 sur https://my.vmware.com/web/vmware/downloads

- Accès à une machine (Windows / Linux / macOS) pour exécuter le programme d’installation de vCenter à partir de

- L’adresse IP / FQDN de l’hôte ESXi ou du vCenter sur lequel VCSA sera déployé

- La configuration IP (y compris l’adresse IP statique, le masque de sous-réseau, l’adresse de passerelle et les adresses de serveur DNS)

- Un enregistrement d’hôte DNS créé pour le nouveau VCSA

- L’adresse IP / FQDN du PSC homologue

- Le nom de domaine SSO du PSC homologue

- Informations d’identification de l’administrateur SSO pour le domaine choisi

Comment le faire

La procédure suivante vous guidera à travers les étapes requises pour configurer vCenters dans une configuration Linked Mode:

- Passez à l’étape 1 de l’installation en déployant un nouveau VCSA.

- Sur l’écran d’installation – Étape 2: configurer vCenter Server Appliance avec un écran PSC intégré, cliquez sur Suivant.

- Sur l’écran de configuration de l’appliance, spécifiez un mode de synchronisation de l’heure et activez l’accès SSH (désactivé par défaut).

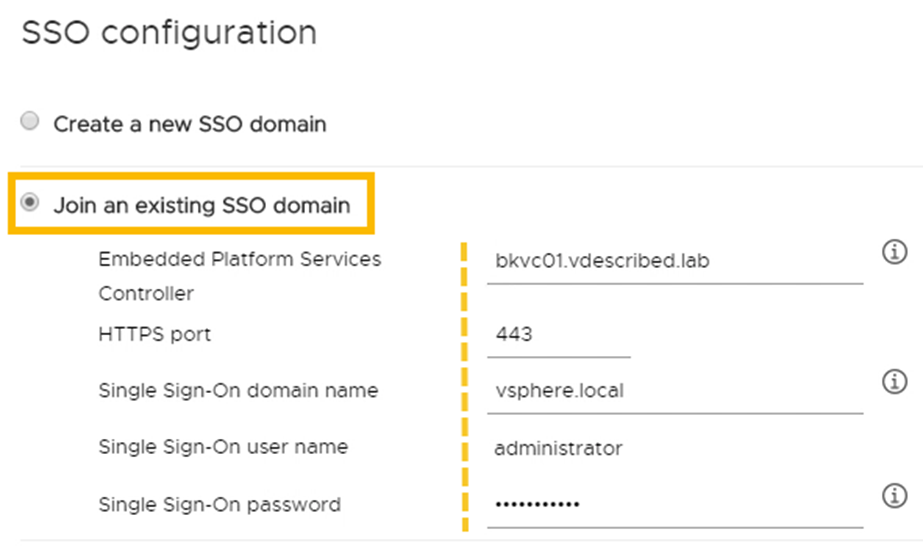

- Sur l’écran de configuration SSO, choisissez de rejoindre un domaine SSO existant. Spécifiez le FQDN / IP du PSC homologue, son domaine SSO et les informations d’identification de l’administrateur:

- Sur l’écran Configure CEIP, choisissez de décocher le programme Join VMware Customer Experience Improvement Program (CIEP).

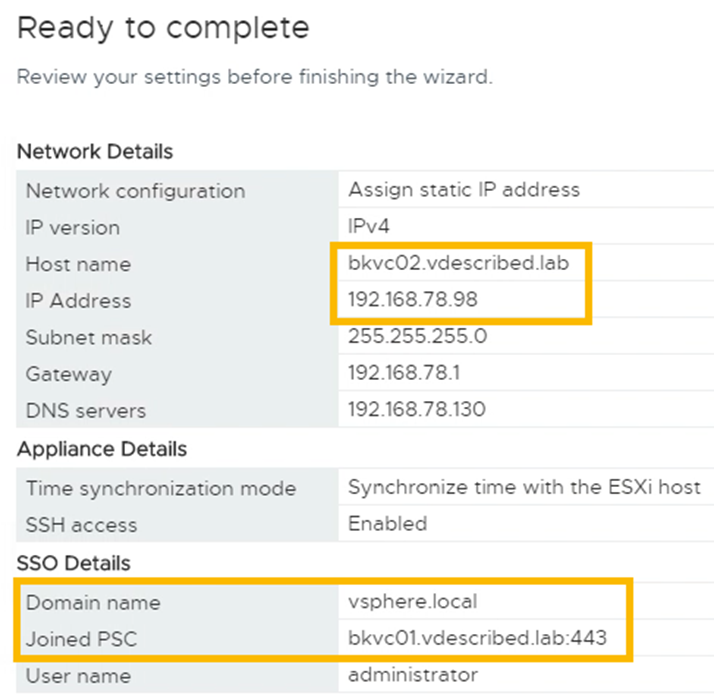

- Sur l’écran Prêt à terminer, vérifiez les paramètres et cliquez sur TERMINER pour lancer la configuration :

- Une fois la configuration / configuration terminée, un écran de confirmation vous sera présenté, ainsi que l’URL (https://FQDN de VCSA:443) de la page de démarrage de vCenter. Cliquez sur Fermer pour quitter le programme d’installation.

Ceci termine la configuration du mode lié :

Maintenant, lorsque vous vous connectez au client Web, il doit répertorier tous les serveurs vCenter dans le même domaine PSC.

Comment ça marche

Une fois que les vCenters sont dans ELM, ils répliquent le contenu VMDir, les clés de licence, les autorisations globales, les balises et les catégories.

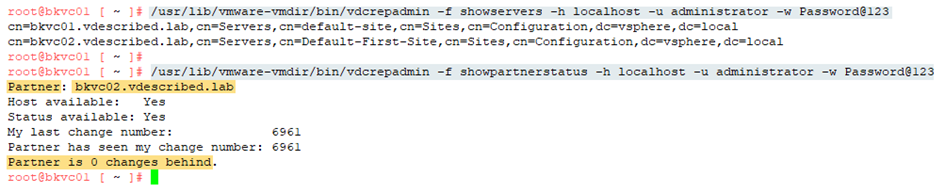

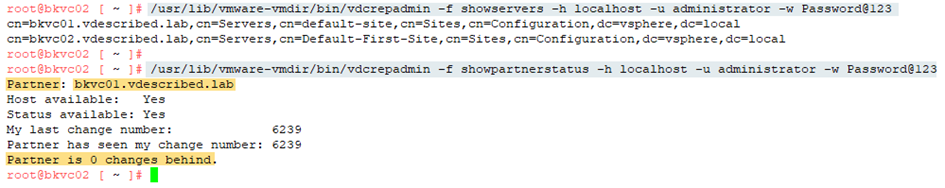

L’état de réplication peut être vérifié à partir de chaque nœud en exécutant les commandes suivantes :

Les mêmes commandes, lorsqu’elles sont exécutées sur le vCenter / PSC homologue, doivent signaler des données similaires:

Il y a plus

Vous pouvez toujours déployer des PSC externes dans vSphere 6.7, bien qu’il n’y ait pas de cas d’utilisation fort pour le faire. Si votre environnement 6.5.x ou plus ancien avait des serveurs PSC ou SSO externalisés, ils seront migrés / mis à niveau pour devenir des PSC externes par défaut. Ceux-ci peuvent cependant être convertis en VCSA intégrés lors de la mise à niveau. Nous en apprendrons plus à ce sujet dans le chapitre suivant.

Configuration des sources d’identité SSO (Single Sign-On)

Une source d’identité SSO est un référentiel d’utilisateurs ou de groupes. Il peut s’agir d’un référentiel d’utilisateurs d’OS locaux, Active Directory ou OpenLDAP et VMDir. L’ajout d’une source d’identité vous permet d’attribuer des autorisations vCenter aux utilisateurs à partir d’un tel référentiel.

Le VCSA Photon OS (OS local) et le domaine SSO ( vsphere.local ) sont des sources d’identité pré-reconnues. Cependant, lorsque vous essayez d’ajouter des sources d’identité, vous êtes autorisé à ajouter trois types différents :

- Active Directory (authentification intégrée Windows)

- Active Directory sur LDAP

- Ouvrez LDAP

Dans cette recette, nous apprendrons comment ajouter une source d’identité Active Directory.

Comment le faire

La procédure en deux parties suivantes vous permettra de joindre le PSC à Active Directory et d’ajouter une source d’identité Active Directory.

Partie 1 – Joindre le PSC à Active Directory

La jonction du PSC à Active Directory doit être effectuée une seule fois au cours du cycle de vie du PSC.

- Connectez-vous à vCenter Server / PSC en tant qu’administrateur SSO ( administrator@vsphere.local ).

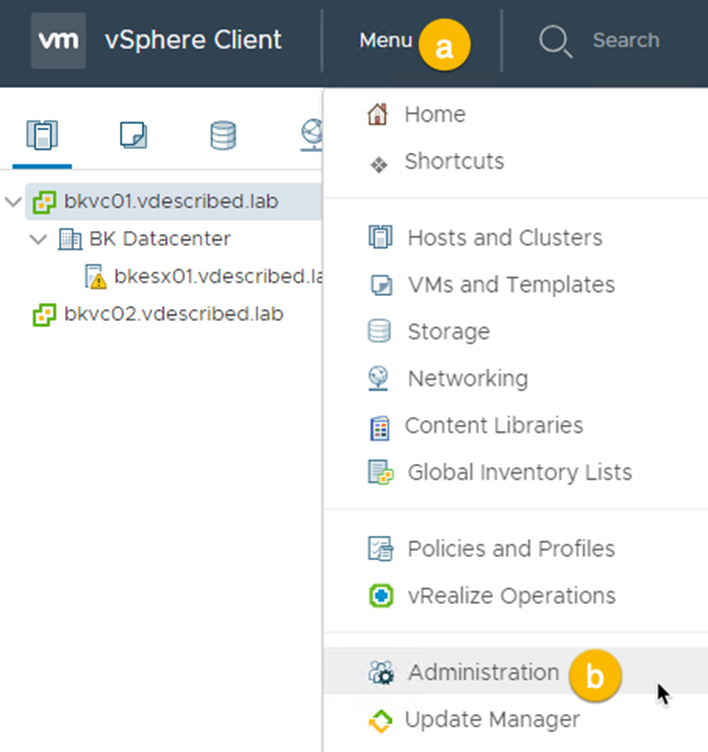

- Utilisez le menu pour accéder à Administration:

Menu | Administration

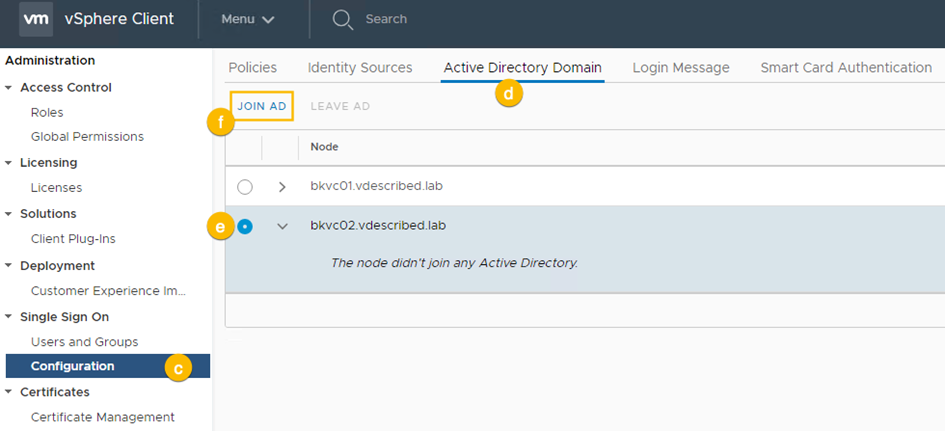

- Sur la page Administration, accédez à Authentification unique | Configuration | Domaine Active Directory et cliquez sur JOIN AD :

- Dans la fenêtre Rejoindre un domaine Active Directory, spécifiez le nom du domaine, l’unité d’organisation (facultative) et les informations d’identification d’un utilisateur de domaine autorisé à joindre la machine au domaine. Cliquez sur Rejoindre.

- Une fois cela fait, l’hôte doit être redémarré pour que les modifications prennent effet.

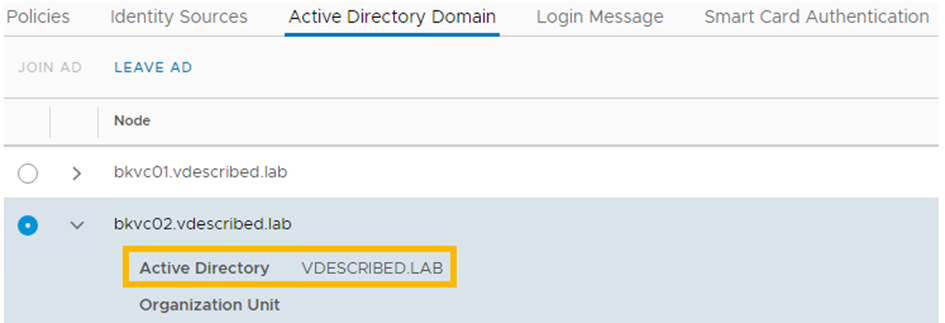

- Une fois le redémarrage terminé, il devrait afficher le vCenter / PSC comme joint au domaine :

Partie 2 – Ajout de la source d’identité

Utilisez le processus suivant pour ajouter une source d’identité :

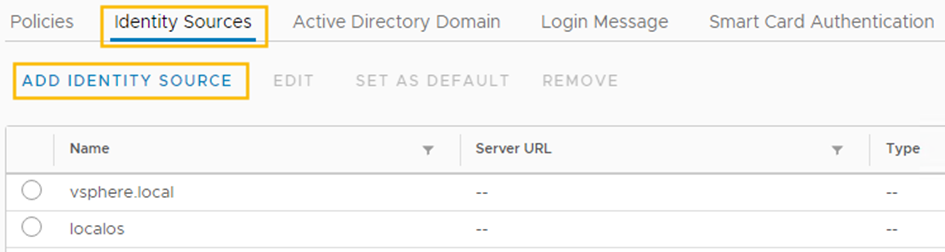

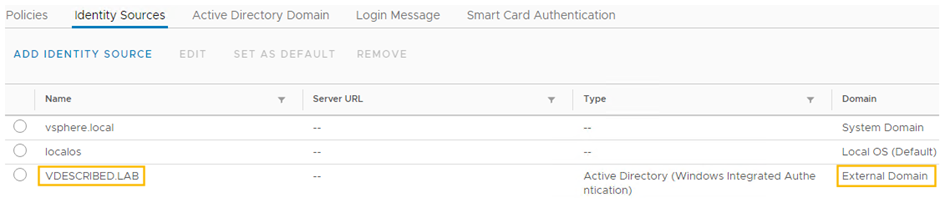

- Accédez à la page Administration, accédez à Authentification unique | Configuration | Sources d’identité, puis cliquez sur AJOUTER UNE SOURCE D’IDENTITÉ :

- Dans la fenêtre Ajouter une source d’identité, définissez le type de source d’identité sur Active Directory (authentification intégrée Windows). Le nom de domaine sera prérempli avec le FQDN du domaine auquel le PSC est joint. Utilisez le compte d’ordinateur pour vous authentifier :

- Une fois cela fait, le domaine Active Directory sera répertorié parmi les autres sources d’identité :

Ceci termine le processus de configuration des sources d’identité SSO sur un vCenter Server.

Comment ça marche

VMware SSO est un serveur d’authentification mis à disposition à partir de vSphere 5.1. Avec la version 5.5, il a été redéfini afin qu’il soit simple à planifier et à déployer, ainsi que plus facile à gérer. Avec vSphere 6.0 et 6.5, il est désormais intégré au PSC.

SSO agit comme une passerelle d’authentification, qui prend les demandes d’authentification de divers composants enregistrés et valide la paire d’informations d’identification par rapport aux sources d’identité qui sont ajoutées au serveur SSO. Les composants sont enregistrés sur le serveur SSO lors de leur installation.

Une fois authentifiés, les clients SSO reçoivent un jeton pour les échanges ultérieurs. L’avantage ici est que l’utilisateur ou l’administrateur du service client n’est pas invité à entrer une paire d’informations d’identification (nom d’utilisateur et mot de passe) chaque fois qu’il doit s’authentifier.

SSO prend en charge l’authentification par rapport aux sources d’identité suivantes:

- Active Directory

- Active Directory en tant que serveur LDAP

- Ouvrez LDAP

- OS local

Voici certains des composants qui peuvent être enregistrés auprès de VMware SSO et tirer parti de ses fonctionnalités. Ces composants, en termes d’authentification unique, sont appelés clients SSO:

- VMware vCenter Server

- VMware vCenter Orchestrator

- VMware NSX

- VMware vCloud Director

- VMware vRealize Automation

- VMware vSphere Web Client

- Protection des données VMware vSphere

- Navigateur de journaux VMware

Configuration des rôles et autorisations vCenter

Par défaut, le groupe SSO-Domain \ Administrators ( vsphere.local \ Administrators ) se voit attribuer un rôle d’administrateur sur le vCenter et est défini comme une autorisation globale . Cela signifie que s’il devait y avoir plus d’un vCenter dans une configuration Enhanced Linked Mode, le groupe vsphere \ Administrators disposera des autorisations de rôle d’administrateur sur tous les vCenters connectés.

Le seul membre du groupe vsphere.local \ Administators est l’administrateur SSO ( administator@vsphere.local ). Des utilisateurs d’autres sources d’identité peuvent être ajoutés en tant que membres de ce groupe si vous le souhaitez.

Cependant, dans la plupart des environnements, bien que plusieurs vCenters soient gérés sous un seul parapluie ELM, vous devrez parfois fournir des autorisations spécifiques à vCenter. Par exemple, si vous gérez plusieurs vCenters appartenant à différents clients, l’attribution d’autorisations globales n’est pas considérée comme idéale. Dans de tels cas, vous devrez fournir un accès utilisateur à des vCenters spécifiques uniquement.

Dans cette recette, nous apprendrons comment attribuer des autorisations vCenter à un utilisateur / groupe Active Directory.

Se préparer

Avant de démarrer et d’attribuer des autorisations vCenter, assurez-vous que le domaine hébergeant l’utilisateur / le groupe prévu est ajouté en tant que source d’identité. Pour savoir comment ajouter des sources d’identité, lisez la recette Configuration des sources d’identité SSO dans ce chapitre.

Comment faire

La procédure suivante vous guidera à travers les étapes requises pour configurer les autorisations vCenter pour un utilisateur ou un groupe de domaine :

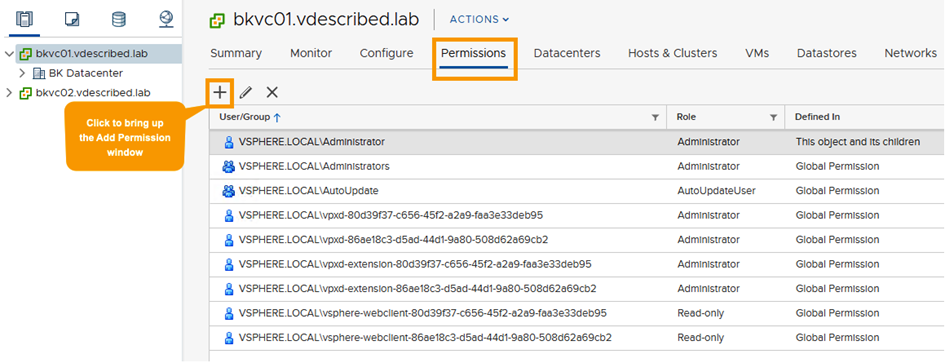

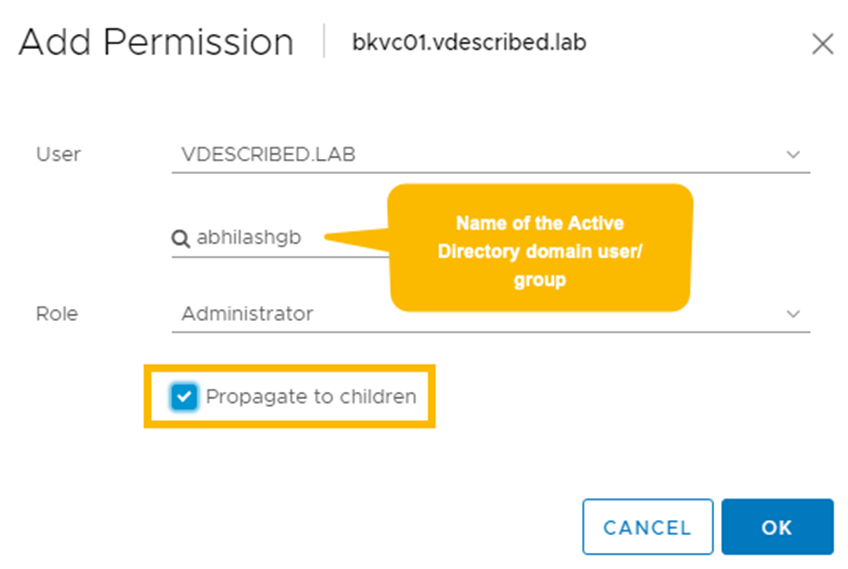

- Connectez-vous à l’interface vSphere Client (HTML 5) en tant qu’administrateur SSO.

- Sélectionnez l’objet vCenter dans l’inventaire, accédez à son onglet Autorisations et cliquez sur + pour afficher la fenêtre Ajouter une autorisation :

- Dans la fenêtre Ajouter une autorisation, sélectionnez un utilisateur ou un groupe de domaine à l’aide de la zone de recherche, puis spécifiez un rôle. Vous pouvez également choisir de propager les autorisations de cascade vers d’autres objets d’inventaire. Cliquez sur OK pour confirmer:

- Une fois cela fait, l’utilisateur / groupe doit être répertorié sous Autorisations.

Comment ça marche

Tout compte d’utilisateur utilisé pour se connecter à vSphere Web Client a besoin d’une autorisation sur le vCenter pour pouvoir afficher et gérer son inventaire. Lors de la configuration des autorisations globales, il est important de s’assurer qu’il est propagé aux objets enfants afin que les autorisations soient également définies sur le ou les vCenter Server. Les autorisations peuvent être configurées pour les utilisateurs locaux et Active Directory, à condition que les sources d’identité requises soient ajoutées à SSO.

Joindre ESXi à un domaine Active Directory

En tant qu’administrateur gérant un environnement vSphere, la dernière chose que vous voudriez faire est de partager le mot de passe root. N’oubliez pas qu’un mot de passe root oublié ne peut pas être récupéré / réinitialisé et nécessitera une réinstallation d’ESXi.

Rejoindre un hôte ESXi à un domaine Active Directory permet aux utilisateurs d’un groupe d’utilisateurs de domaine particulier de se connecter à l’hôte ESXi sans avoir besoin de connaître le mot de passe root. Cela élimine non seulement la nécessité de changer périodiquement le mot de passe root, mais permet également un meilleur audit.

Se préparer

Voici ce dont vous aurez besoin avant de rejoindre l’hôte ESXi au domaine et de configurer l’accès à celui-ci:

- Le nom du domaine

- Nom d’utilisateur et mot de passe d’un utilisateur de domaine autorisé à joindre la machine au domaine

- Le nom du groupe d’utilisateurs du domaine dont les utilisateurs sélectionnés feront partie

Comment faire

La procédure suivante vous guidera à travers les étapes nécessaires pour joindre l’hôte ESXi au domaine et permettre à un groupe d’utilisateurs de domaine d’y accéder :

- Connectez-vous à l’interface HTML 5 du vCenter Server, c’est-à-dire https://FQDN of vCenter / ui.

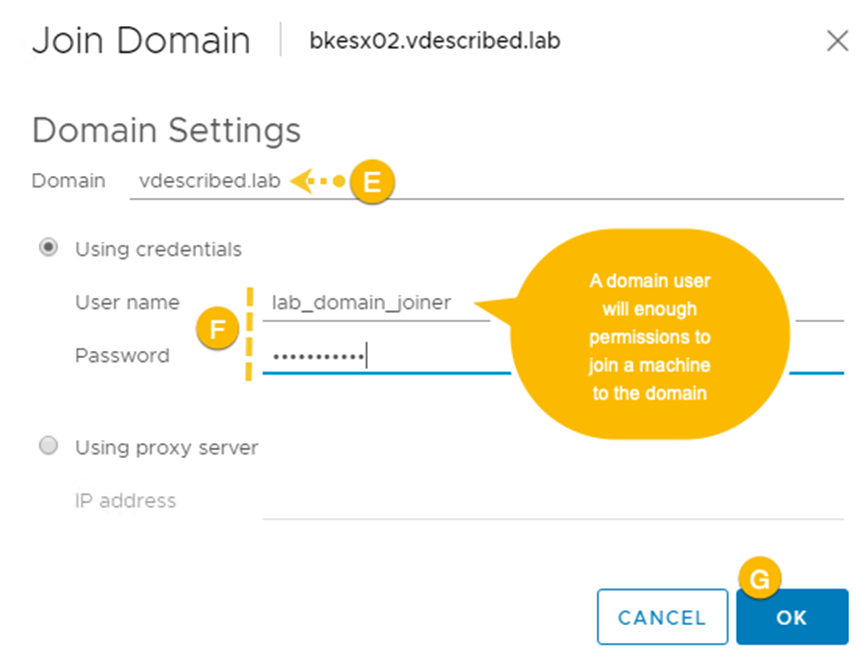

- Sélectionnez l’hôte ESXi dans l’inventaire et accédez à Configurer | Système | Services d’authentification. À partir d’ici, cliquez sur Rejoindre le domaine.

- Sur l’écran Join Domain, spécifiez un nom de domaine et des informations d’identification de domaine et cliquez sur OK :

- Vous devriez voir un message Tâche de rejoindre le domaine Windows terminée avec succès dans le volet Tâches récentes.

Maintenant que l’hôte est joint au domaine, nous pouvons le configurer pour autoriser l’accès à un groupe d’utilisateurs de domaine.

- Avec l’hôte sélectionné, accédez à Configurer | Système | Paramètres système avancés et cliquez sur Modifier.

- Sur l’écran Modifier les paramètres système avancés, tapez esxadmin dans la zone de recherche pour filtrer les paramètres.

- Cliquez sur le champ Valeur correspondant au paramètre Config.HostAgent.plugins.hostsvc.esxAdminsGroup et entrez le nom du groupe d’utilisateurs du domaine:

Vous devriez maintenant pouvoir vous connecter en tant qu’utilisateur de domaine à la console (direct / SSH) et DCUI en utilisant les formats suivants :

- user @ domain : par exemple, abhilashgb @ vdescribed

- domaine \ utilisateur : par exemple, vdescribed \ abhilashgb

Comment ça marche

Une fois que l’hôte ESXi a été joint au domaine Active Directory, un groupe d’utilisateurs de domaine peut être autorisé à se connecter à l’hôte ESXi. Cet accès est activé en spécifiant le nom du groupe d’utilisateurs à l’aide du paramètre système avancé, c’est-à-dire Config.HostAgent.plugins.hostsvc.esxAdminsGroup .

Par défaut, ce groupe d’utilisateurs bénéficie de privilèges d’administrateur. Ce comportement peut cependant être modifié en utilisant le paramètre système avancé, c’est-à-dire Config.HostAgent.plugins.hostsvc.esxAdminsGroupAutoAdd .

Planification et exécution de la mise à niveau de vSphere

L’objectif de ce chapitre est de vous aider à comprendre, planifier et exécuter le processus de mise à niveau de votre infrastructure vSphere principale vers VMware vSphere 6.7. Le noyau comprend votre hyperviseur ESXi, vCenter Server et les composants de vCenter Server. La mise à niveau des produits de troisième couche qui exploitent l’infrastructure de base de vSphere, tels que vRealize Automation, NSX et VMware Horizon View, ne sont pas traités dans ce chapitre car ils dépassent la portée et l’objectif de ce livre.

Permettez-moi de vous présenter les principaux composants de l’infrastructure qui seront mis à niveau :

- VMware vCenter Server : la viabilité d’une mise à niveau ou la nécessité d’une nouvelle version dépendra de la version actuelle de vCenter et du chemin de mise à niveau pris en charge.

- vCenter Inventory Service : il ne s’agit plus d’un service distinct dans vCenter 6.5 / 6.7.

- vSphere Web Client : le composant Web Client sera mis à niveau dans le cadre de la mise à niveau de vCenter.

- vSphere Platform Services Controller (PSC) : si vous effectuez une mise à niveau de vSphere 6.0 vers 6.7, vous devrez revoir le modèle de déploiement actuel et appliquer une stratégie appropriée pour mettre à niveau le PSC. Une fois que les PSC ont été mis à niveau vers 6.7 Update 1, ils peuvent être convergés vers vCenter Appliance puis mis hors service.

- vSphere Update Manager (VUM) : VUM doit être mis à jour vers la dernière version avant de pouvoir être utilisé pour mettre à niveau les hôtes ESXi qui sont gérés par le vCenter VUM avec lequel il est intégré. Les composants VUM sont désormais intégrés à vCenter Appliance.

- VMware ESXi : l’hyperviseur peut être mis à niveau en démarrant le serveur à l’aide de l’image ISO, à l’aide de vSphere Update Manager ou en mettant à jour le profil d’image si les serveurs existants sont déployés automatiquement.

Il est important de noter qu’il n’y a pas de chemin de mise à niveau directe de vSphere 5.5 vers vSphere 6.7 . Vous devrez mettre à niveau vers vSphere 6.0 / 6.5 avant de pouvoir mettre à niveau l’environnement vers vSphere 6.7.

Dans ce chapitre, nous couvrirons les recettes suivantes :

- Planification de la mise à niveau de votre infrastructure vSphere

- Exécution de VMware Migration Assistant

- Mise à niveau des contrôleurs de services de plate-forme (PSC)

- Mise à niveau des serveurs vCenter

- Utilisation de l’outil de convergence vCenter

- Mise à niveau des hôtes ESXi à l’aide du programme d’installation interactif

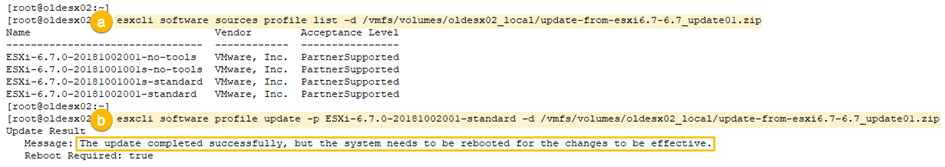

- Mise à niveau d’ESXi à l’aide de l’interface de ligne de commande

Planification de la mise à niveau de votre infrastructure vSphere

Avant de vous lancer dans la mise à niveau de tous les différents composants de votre infrastructure vSphere, il est essentiel de préparer et de mettre en page les effets de la mise à niveau des composants, qui incluent la prise en compte des temps d’arrêt nécessaires. Où commençons-nous? La réponse dépend des composants / solutions de notre environnement et des effets de leur compatibilité une fois mis à niveau.

Nous commençons par utiliser des ouvrages de référence tels que les matrices d’interopérabilité des produits VMware et les guides de compatibilité VMware. Il en va de même pour les autres produits / solutions de notre environnement. Par exemple, si nous avons une solution de sauvegarde tierce, il est essentiel de s’assurer que la solution de sauvegarde est compatible avec la version de vSphere vers laquelle nous procédons à la mise à niveau.

Un autre aspect critique est l’atténuation des défaillances. Et si la mise à niveau échoue? Il est essentiel d’inclure une procédure de restauration lorsque vous préparez un runbook.

Dans cette recette, vous apprendrez à planifier la mise à niveau de votre environnement vSphere.

Se préparer

Vous aurez besoin des outils suivants pour planifier la mise à niveau:

- Guide de compatibilité VMware (www.vmware.com/resources/compatibility/search.php)

- Matrices d’interopérabilité des produits VMware (www.vmware.com/resources/compatibility/sim/interop_matrix.php)

- Accès à la documentation du fournisseur pour les produits tiers qui s’intègrent avec vSphere

Comment le faire

Les procédures de haut niveau suivantes peuvent être utilisées pour planifier la mise à niveau d’un environnement vSphere:

- Déterminez la version et la compatibilité des composants vSphere.

- Vérifiez le chemin de mise à niveau et assurez-vous qu’il est pris en charge.

- Planifiez la séquence de mise à niveau des composants vSphere.

- Planifiez le temps d’arrêt des composants vSphere.

- Planifiez l’atténuation des échecs de mise à niveau.

Comment ça marche

Passons en revue ces étapes, une par une:

Partie 1 : Déterminer la version et la compatibilité :

- Rassemblez la version actuelle et les numéros de build des hôtes vCenter Server et ESXi.

- Vérifiez si le matériel du serveur est compatible avec VMware ESXi 6.7.x à l’aide du Guide de compatibilité VMware.

- Faites une liste de tous les plug-ins vCenter Server actuellement installés.

- Pour les plug-ins VMware, utilisez les matrices d’interopérabilité des produits VMware pour confirmer leur compatibilité avec vSphere 6.7.

- Pour les plug-ins tiers, utilisez la documentation du fournisseur correspondant pour confirmer leur compatibilité avec vSphere 6.7.

Partie 2 : Vérifiez le chemin de mise à niveau :

- Chaque produit, qu’il s’agisse de VMware ou d’une solution tierce qui s’intègre à vSphere, doit suivre un chemin de mise à niveau. Par exemple, un environnement vSphere 5.5 ne peut pas être directement mis à niveau vers 6.7. Il doit être mis à niveau vers 6.0 ou version ultérieure pour vCenter et ESXi 6.0 U3 ou version ultérieure avant de pouvoir être mis à niveau vers vSphere 6.7.

Pour ce faire, utilisez la section Chemin de mise à niveau des matrices d’interopérabilité des produits VMware.

- Certains produits tiers devront également passer à une version particulière (build) avant de pouvoir être mis à niveau vers une version compatible avec vSphere 6.7. Reportez-vous à la documentation du fournisseur pour vérifier le chemin de mise à niveau.

Partie 3 : Planifiez la séquence de mise à niveau des composants vSphere :

- Une fois les versions du produit et leur compatibilité confirmées, vous devrez arriver à une commande (séquence) dans laquelle les composants seront mis à niveau.

- Pour les produits VMware, utilisez VMware KB # 53710 (kb.vmware.com/kb/53710) pour comprendre la séquence dans laquelle les solutions doivent être mises à niveau. Si votre infrastructure vSphere possède d’autres produits VMware, tels que vROPS, vRA, SRM, NSX, etc., il est essentiel d’utiliser la base de connaissances pour comprendre la séquence.

- Une fois vCenter mis à niveau, vous pouvez ensuite mettre à niveau les hôtes ESXi.

- La mise à niveau des composants vCenter ne modifie pas le modèle / la topologie de déploiement. Cela signifie que, s’il existe des PSC externes dans l’environnement, ils devront d’abord être mis à niveau.

- vCenter 6.7 Update 1 comprend un outil de convergence , qui peut être utilisé pour transformer des PSC externes en composants intégrés de VCSA 6.7 Update 1.

- Avec chaque version majeure d’ESXi, VMware inclut une nouvelle version matérielle virtuelle qui apporte de nouvelles fonctionnalités et améliorations. vSphere 6.7 a la version matérielle 14. Nous apprendrons comment mettre à niveau les outils VMware et le matériel virtuel sur des machines virtuelles individuelles (VM) au chapitre 13, Création et gestion de machines virtuelles. Ce processus peut être orchestré à l’aide de VMware Update Manager afin de gérer les mises à niveau de plusieurs machines virtuelles. Nous en apprendrons plus à ce sujet dans un chapitre distinct qui couvre VMware Update Manager.

Partie 4 : planifier le temps d’arrêt des composants vSphere :

- La plupart de la mise à niveau peut être effectuée sans aucun temps d’arrêt pour les charges de travail VM. Cependant, les solutions mises à niveau entraîneront un temps d’arrêt temporaire. La durée d’indisponibilité requise dépend du temps nécessaire à la mise à niveau. Par exemple, si vous deviez migrer de vCenter (Windows) vers vCSA, pendant la mise à niveau, la base de données est transférée vers vCSA via le réseau. La quantité de données et l’encombrement du réseau pourraient jouer un rôle dans la détermination du temps requis pour l’importation et la mise à niveau.

- La mise à niveau des hôtes ESXi nécessitera un redémarrage.

- Lors de la prise en compte du temps d’arrêt requis, vous devrez prendre en compte le temps nécessaire pour dépanner une mise à niveau ou le temps nécessaire pour effectuer une restauration en cas d’échec de la mise à niveau.

Partie 5 : Plan d’atténuation des défaillances :

- En mettant à niveau la version actuelle de Windows / Appliance vers 6.7, Appliances déploie toujours un nouveau VCSA avec les données qui lui sont transférées, ce qui signifie qu’il n’apportera aucune modification au VCSA source. Cependant, il est toujours recommandé de prendre des instantanés des machines virtuelles source avant la mise à niveau afin de pouvoir les restaurer si nécessaire. Une restauration sans instantané est également possible en mettant simplement hors tension l’appliance cible et en mettant sous tension les machines virtuelles source.

- Une mise à niveau ESXi est non destructive dans la plupart des cas. Si la mise à niveau échoue pour une raison quelconque, l’hôte doit simplement être redémarré. Cependant, dans de rares cas, vous devrez effectuer une nouvelle installation.

- Il est recommandé de prendre des instantanés sur la machine virtuelle avant une mise à niveau des outils VMware ou du matériel virtuel. Le processus de mise à niveau des outils et du matériel virtuel sera traité dans le chapitre 14 , Mise à niveau et correction à l’aide de vSphere Update Manager .

Une fois que vous avez atteint un plan vérifié et documenté, vous pouvez procéder à l’exécution de la mise à niveau. Si votre environnement existant comprend des composants vCenter basés sur Windows, vous devrez commencer par apprendre à utiliser l’assistant de migration. Veuillez-vous référer à la recette Running VMware Migration Assistant pour plus d’informations.

Exécution de VMware Migration Assistant

VMware Migration Assistant est utilisé comme agent proxy afin que vous puissiez collecter des informations de configuration sur les composants vCenter exécutés sur Microsoft Windows et exécuter des vérifications de pré-mise à niveau, et il facilite le transfert de données de la machine Windows vers l’appliance vCenter.

L’assistant de migration est fourni avec l’ISO du programme d’installation de vCenter Server Appliance.

Dans cette recette, vous apprendrez à exécuter VMware Migration Assistant sur des machines Windows en exécutant les composants PSC, vCenter et Update Manager vCenter.

Se préparer

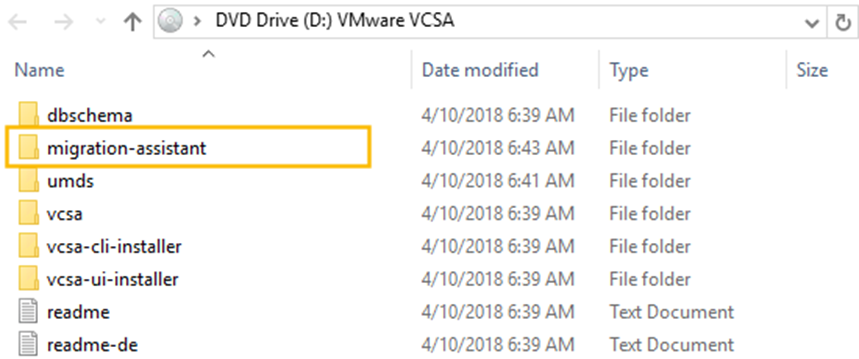

Avant de commencer, téléchargez l’ISO du programme d’installation de vCenter Server Appliance 6.7 et montez-le sur la machine Windows exécutant PSC ou vCenter.

Comment le faire

La procédure suivante vous guidera à travers les étapes impliquées dans l’exécution de l’assistant de migration vCenter 6.7 sur une machine de composant vCenter source :

- Copiez le dossier de l’assistant de migration de la racine de l’ISO du programme d’installation de VCSA 6.7 vers le PSC source qui doit être mis à niveau :

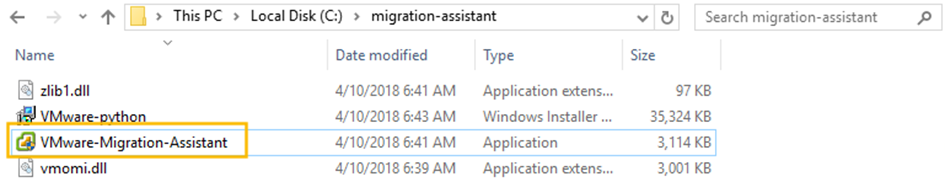

- Exécutez VMware-Migration-Assistant à partir du dossier migration-assistant sur le disque dur :

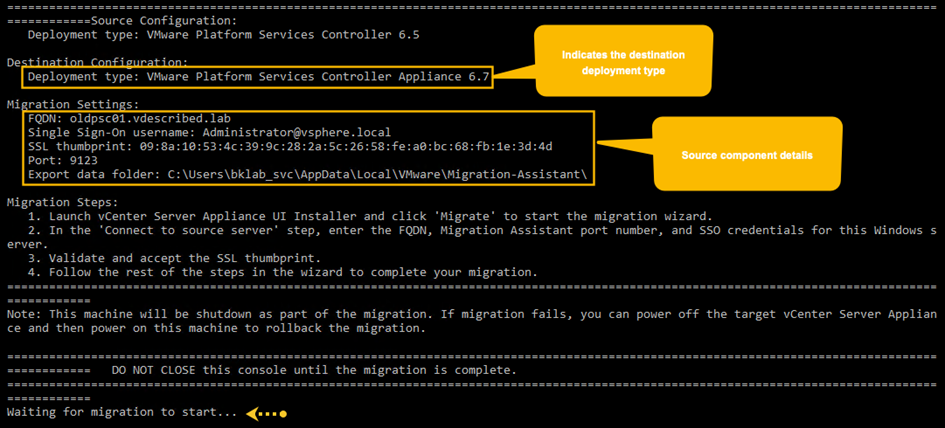

- Lors de son initialisation, vous serez invité à saisir le mot de passe administrateur SSO. Tapez le mot de passe et appuyez sur Entrée ; il commencera à exécuter des vérifications préalables.

- Une fois les vérifications préalables terminées, il affichera la configuration source et confirmera qu’il est prêt à démarrer le processus de migration:

- L’assistant de migration doit continuer de fonctionner jusqu’à la fin de la mise à niveau. Ne fermez pas la fenêtre avant d’avoir terminé.

Pendant la mise à niveau de vCenter Server, si Update Manager s’exécute sur une autre machine Windows, l’assistant de migration doit également être exécuté sur celle-ci.

Comment ça marche

migration-assistant doit être exécuté séparément sur les machines hébergeant les services vCenter / PSC / Update Manager avant de lancer la migration / mise à niveau de vCenter. Le processus de migration / mise à niveau migre uniquement les données de tous les serveurs de composants avec une session d’assistant de migration active .

Si le programme d’installation détecte un plug-in Update Manager enregistré sur vCenter et si l’assistant de migration n’est pas actif sur la machine Windows exécutant le service Update Manager, l’installation peut échouer en l’indiquant.

Mise à niveau des contrôleurs de services de plate-forme (PSC)

Dans un environnement où les PSC sont externalisés, vous devrez d’abord mettre à niveau tous les PSC d’un domaine SSO avant de mettre à niveau les serveurs vCenter correspondants. Pendant la mise à niveau, les PSC seront d’une version ultérieure par rapport à leurs vCenters correspondants. Une telle configuration de version mixte n’est prise en charge qu’au cours de la mise à niveau.

Dans cette recette, nous apprendrons comment mettre à niveau ou migrer des PSC.

Se préparer

Vous aurez besoin des éléments suivants avant de procéder à la mise à niveau :

- Une compréhension de la topologie actuelle : vous devrez identifier tous les PSC dans un seul domaine SSO. Les vCenters correspondant à ces PSC seront dans une configuration ELM ( Enhanced Linked Mode ).

- Adresses IP temporaires pour les appliances PSC qui seront déployées : Une IP temporaire est attribuée à l’appliance lors de son installation afin que les données / configuration puissent être transférées du PSC source vers l’appliance. Le nouvel appareil prendra l’identité du PSC source lors de la dernière étape de la mise à niveau (une fois le transfert de données terminé).

- Créez un instantané du PSC source (facultatif).

Comment le faire

La procédure suivante vous guidera à travers les étapes de la mise à niveau des PSC (Windows / Appliance) vers PSC 6.7.

Migration de PSC (Windows) vers PSC (Appliance) 6.7

- Exécutez l’assistant de migration sur le PSC source. Pour obtenir des instructions, lisez la recette Running VMware Migration Assistant.

- Exécutez le programme d’installation de VCSA 6.7 à partir d’une machine autre que le PSC source.

L’emplacement du programme d’installation pour Windows est CDROM : \ vcsa-ui-installer \ win32 \ installer.exe.

Migrer – Étape 1: déployer l’appliance :

- Sur l’écran du programme d’installation de vCenter Server Appliance 6.7 – Étape 1: Déployer l’appliance, cliquez sur Migrer.

- Sur l’écran Introduction, cliquez sur Suivant pour continuer.

- Acceptez le contrat de licence utilisateur final et cliquez sur Suivant pour continuer.

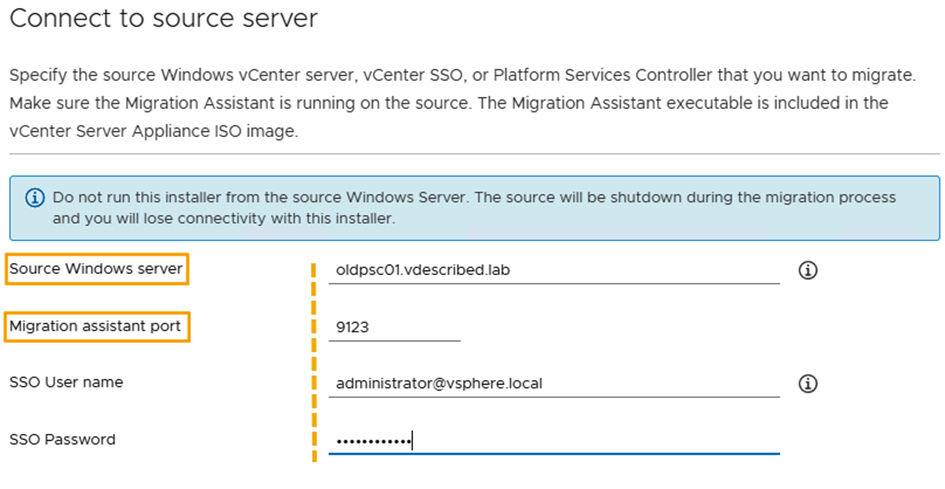

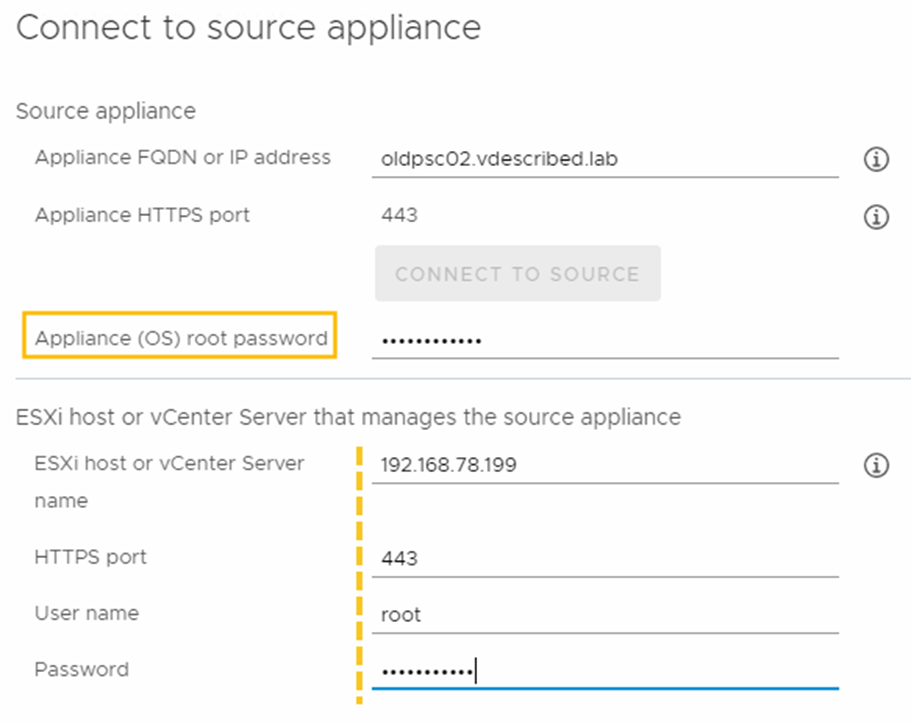

- Sur l’écran Se connecter au serveur source, indiquez l’adresse FQDN / IP de la machine Windows source exécutant le PSC et les informations d’identification de l’administrateur SSO. Cliquer sur Suivant pour continuer :

- Sur l’écran Vérifier l’empreinte numérique, comparez l’empreinte numérique avec la configuration source capturée par l’assistant de migration (sous Paramètres de migration dans la fenêtre Assistant de migration sur la source) et cliquez sur Oui pour continuer.

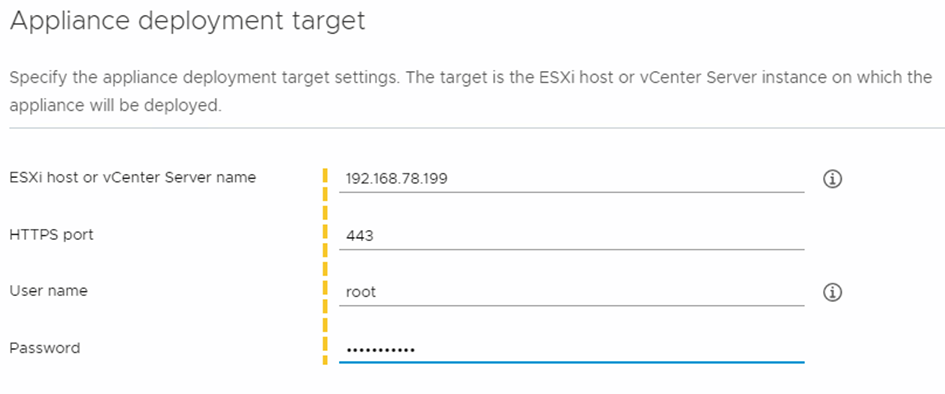

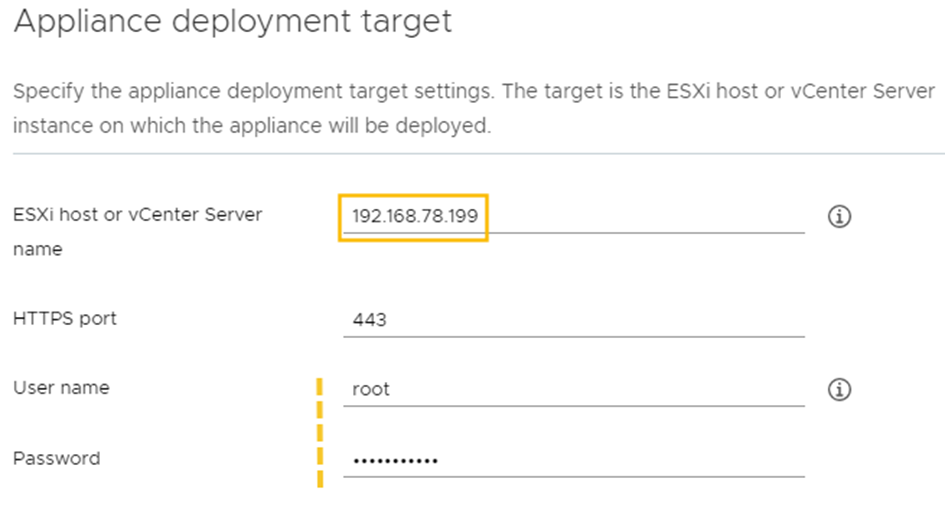

- Sur l’écran cible de déploiement de l’appliance, indiquez l’adresse IP / FQDN de l’hôte ESXi sur lequel l’appliance sera déployée et fournissez les informations d’identification racine ESXi. Cliquer sur Suivant pour continuer :

- Sur l’écran Avertissement de certificat, vérifiez l’empreinte numérique de l’hôte ESXi et cliquez sur Oui.

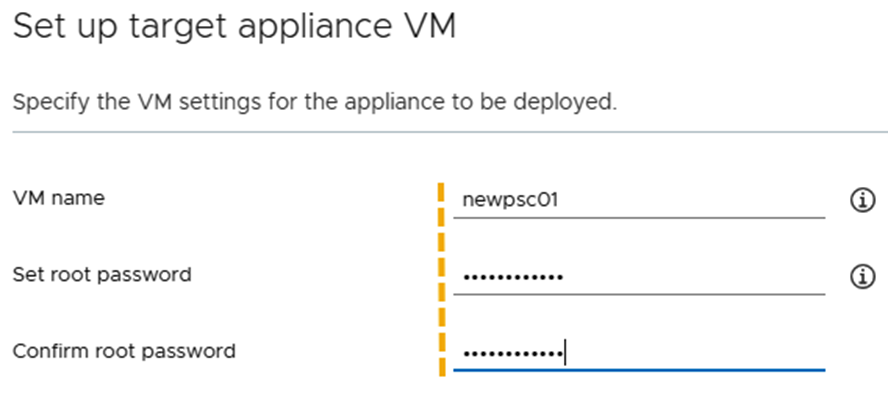

- Dans l’écran Configurer la machine virtuelle de l’appliance cible, spécifiez un nom pour la machine virtuelle de l’appliance PSC et définissez le mot de passe racine. Lorsque vous avez terminé, cliquez sur Suivant pour continuer :

- Sur l’écran Sélectionner la banque de données, choisissez la banque de données souhaitée pour placer la machine virtuelle. Si vous le souhaitez, vous pouvez choisir d’allouer de manière dynamique ses VMDK en cochant la case Activer le mode disque léger. Cliquer sur Suivant pour continuer.

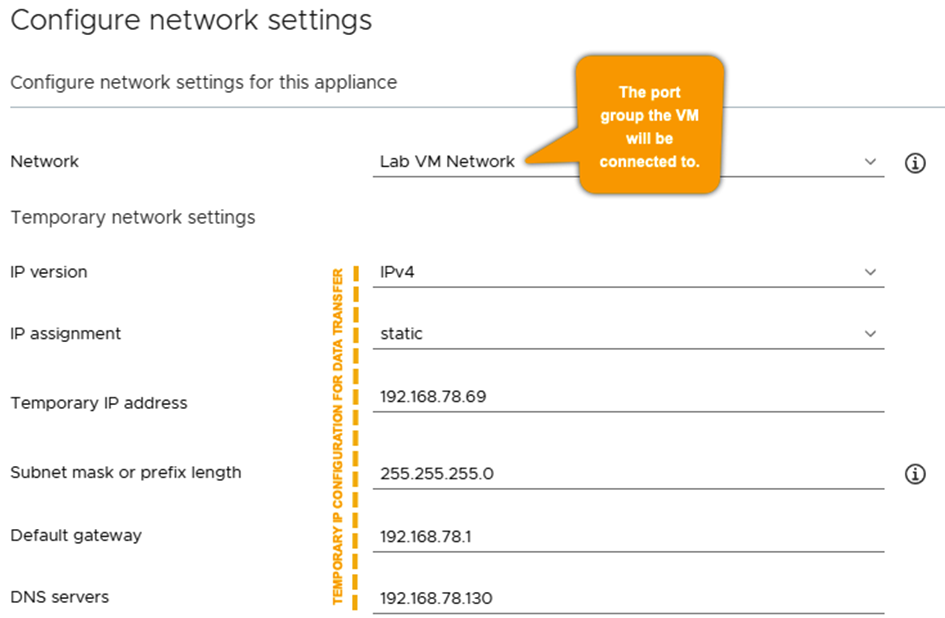

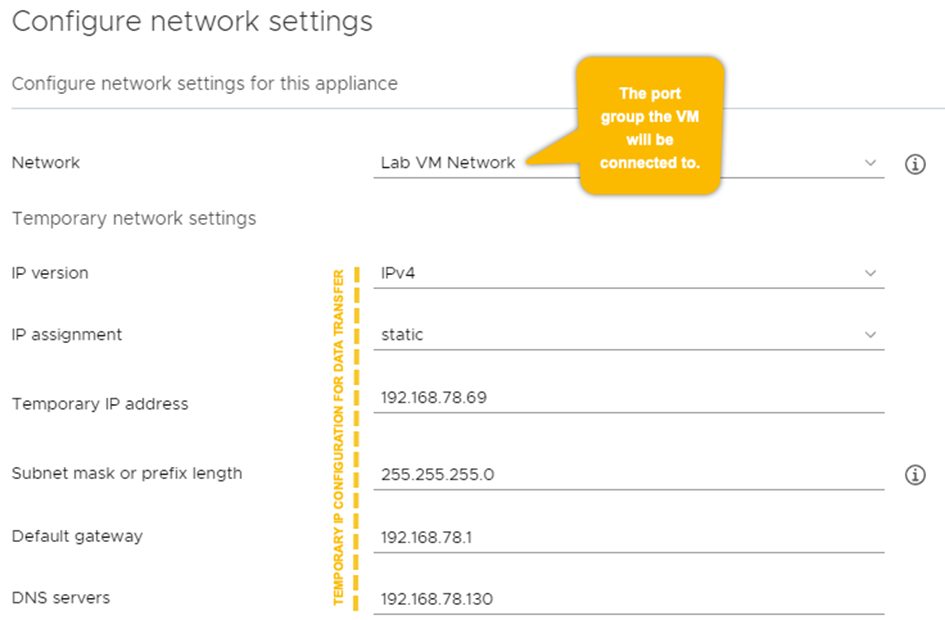

- Dans l’écran Configurer les paramètres réseau, sélectionnez le groupe de ports pour la machine virtuelle de l’appliance PSC à connecter à une configuration d’adresse IP temporaire. Cliquer sur Suivant pour continuer :

- Sur l’écran de l’étape 1 Prêt à terminer, vérifiez les paramètres et cliquez sur Terminer.

- Une fois que l’appliance PSC a été déployée avec succès, il confirmera la même chose et suggérera de passer à l’étape 2. Cela peut être fait en cliquant sur CONTINUER ou en utilisant la page https://Temp-IP:5480 :

Migrer – Étape 2: Appliance Platform Service Controller :

- Dans l’écran Introduction de l’assistant Migrate – Étape 2 : Appliance Platform Service Controller, cliquez sur Suivant pour continuer.

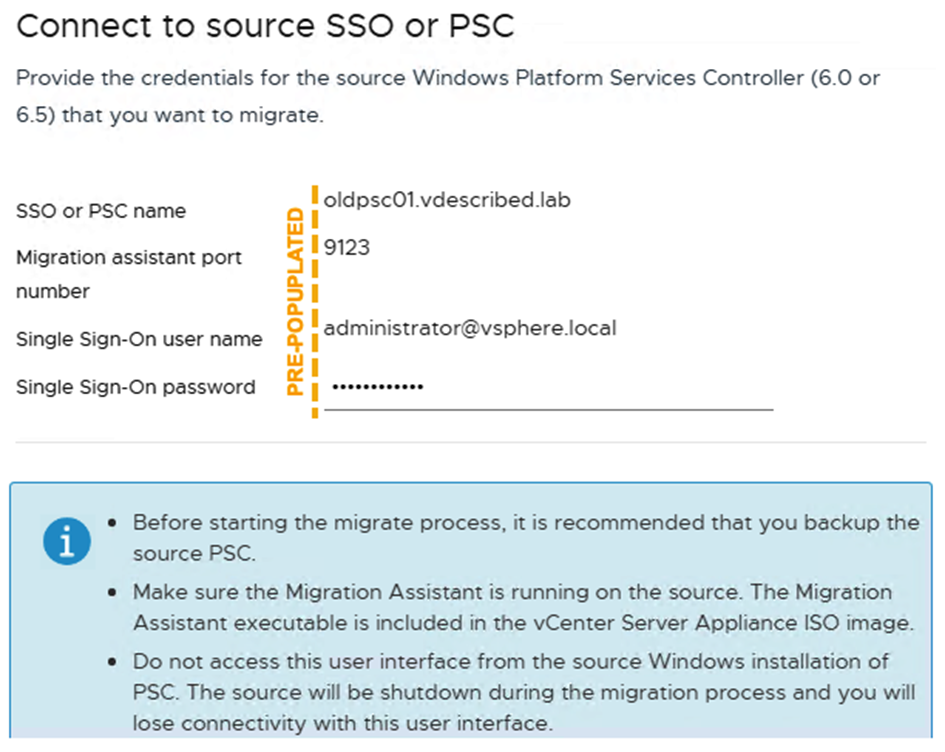

- Sur l’écran Connexion à la source SSO ou PSC, la plupart des informations sont préremplies (y compris le mot de passe SSO). Cliquer sur Suivant pour continuer :

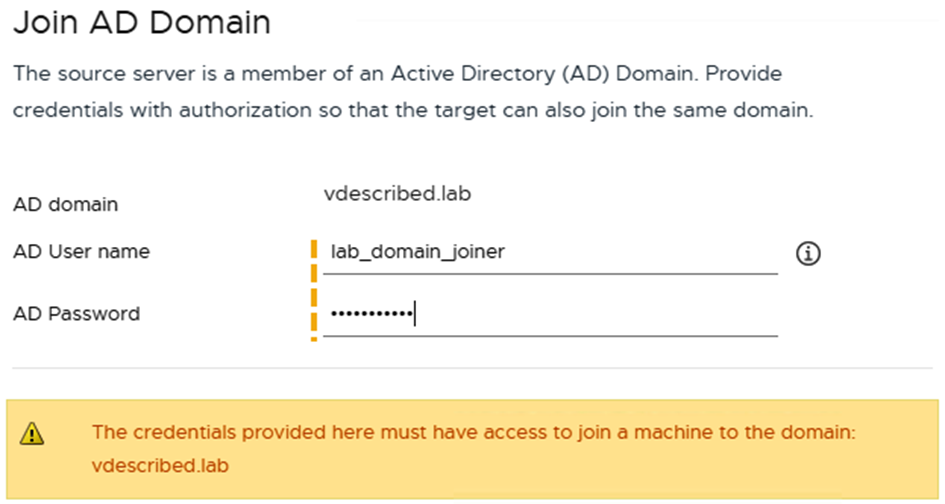

- Il effectue ensuite une vérification de prémigration et passe à l’ écran Join AD Domain. Fournissez les informations d’identification AD pour joindre l’appliance PSC au domaine et cliquez sur Suivant pour continuer:

- Sur l’écran Configurer le CIEP, vous pouvez choisir de rejoindre ou de ne pas rejoindre le CIEP. Faites un choix et cliquez sur Suivant pour continuer.

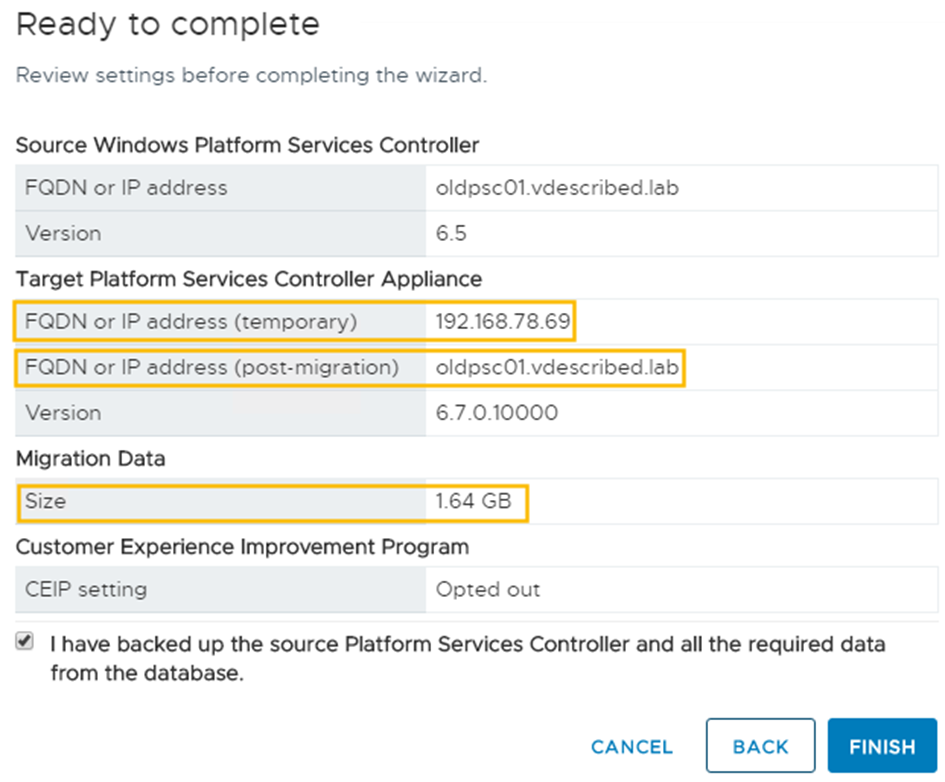

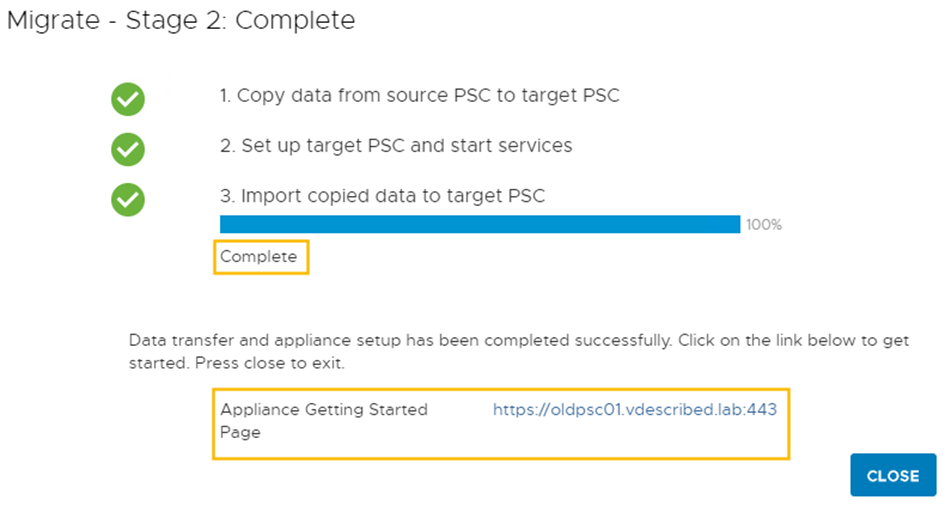

- Sur l’écran Prêt à terminer, cochez la case qui confirme que vous avez sauvegardé le PSC source , vérifiez les paramètres et cliquez sur TERMINER:

- Sur l’écran Avertissement d’arrêt, cliquez sur OK.

- Le programme d’installation va commencer à copier les données du PSC source vers le PSC cible, arrêter le PSC source, puis configurer le PSC cible pour prendre l’identité du PSC source, démarrer les services et importer les données / la configuration qui a été copiée de la source PSC.

- Une fois le déploiement terminé, un écran Migrate – Étape 2 : Terminé s’affiche. Cliquez sur FERMER pour quitter le programme d’installation :

Ceci termine la migration de PSC (Windows) vers PSC 6.7 (Appliance).

Mise à niveau de l’ appliance PSC vers PSC 6.7

Contrairement à la migration depuis PSC (Windows), la mise à niveau d’une appliance ne nécessite pas l’utilisation d’un assistant de migration. Commençons :

Mise à niveau – Étape 1: Déployez l’appliance PSC cible :

- Exécutez le programme d’installation VCSA à partir d’une machine disposant d’un accès réseau au PSC source et à l’hôte ESXi de destination sur lequel le PSC cible sera placé.

- Dans l’écran du programme d’installation de vCenter Server Appliance 6.7 – Étape 1: Déployer l’appliance, cliquez sur Mettre à niveau.

- Sur l’écran Introduction, cliquez sur Suivant pour continuer.

- Acceptez le contrat de licence utilisateur final et cliquez sur Suivant pour continuer.

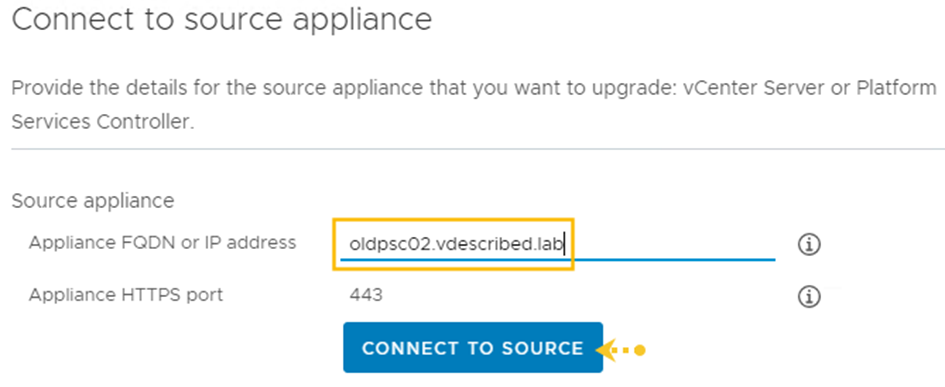

- Sur l’écran Se connecter à l’appliance source, indiquez l’adresse FQDN / IP de l’appliance PSC source et cliquez sur CONNECTER À LA SOURCE:

- Si le programme d’installation peut se connecter à l’appliance PSC source, le même écran est automatiquement développé pour demander des détails supplémentaires, tels que le mot de passe racine de l’appliance PSC, l’adresse FQDN / IP de l’ESXi / vCenter qui gère la machine virtuelle de l’appliance PSC source, et le nom d’utilisateur / mot de passe (root si les informations d’identification ESXi ou SSO si vCenter). Fournissez les détails demandés et cliquez sur Suivant pour continuer :

- L’avertissement de certificat affiche les empreintes pour le PSC source et pour la gestion d’ESXi / vCenter. Cliquez sur Oui pour confirmer.

- Sur l’écran cible de déploiement de l’appliance, spécifiez un ESXi / vCenter cible et ses informations d’identification :

- L’avertissement de certificat affiche l’empreinte numérique de l’ESXi / vCenter cible. Cliquez sur Oui pour confirmer.

- Dans l’écran Configurer la machine virtuelle de l’appliance cible, spécifiez un nom pour la machine virtuelle PSC cible et définissez un mot de passe racine pour l’appliance:

- Sur l’écran Sélectionner la banque de données, choisissez la banque de données souhaitée pour placer la machine virtuelle. Si vous le souhaitez, vous pouvez choisir d’allouer de manière dynamique ses VMDK en cochant la case Activer le mode Think Disk. Cliquer sur Suivant pour continuer.

- Dans l’écran Configurer les paramètres réseau, sélectionnez un groupe de ports pour la machine virtuelle de l’appliance PSC cible et spécifiez une configuration d’adresse IP temporaire. Cliquer sur Suivant pour continuer :

- Sur l’écran Prêt à terminer l’étape 1, vérifiez les paramètres et cliquez sur Terminer.

- Une fois que l’appliance PSC cible a été déployée avec succès, elle confirmera la même chose et vous suggérera de passer à l’étape 2, ce qui peut être fait en cliquant sur Continuer ou en utilisant la page https://Temp-IP:5480 .

Mise à niveau – Étape 2: utilisez l’assistant de Platform Services Controller Appliance :

- Dans l’écran Mise à niveau – Étape 2 : Introduction, cliquez sur Suivant pour continuer.

- Sur l’écran Se connecter au PSC source, indiquez le PSC source et les détails de gestion d’ESXi / vCenter. Cliquer sur Suivant pour continuer.

- Il va maintenant effectuer une vérification préalable à la mise à niveau et passer à l’écran suivant.

- Sur l’écran Configurer CEIP, choisissez de rejoindre ou de ne pas rejoindre VMware CEIP et cliquez sur Suivant pour continuer.

- Sur l’écran Prêt à terminer, vérifiez les paramètres et utilisez la case à cocher pour confirmer que l’appliance PSC source a été sauvegardée. Cliquez ensuite sur Terminer.

- Sur l’écran Avertissement d’arrêt, cliquez sur OK.

- Une fois la mise à niveau terminée, un écran Upgrade – Stage 2: Complete vous sera présenté . Cliquez sur Fermer pour quitter le programme d’installation.

Ceci termine la mise à niveau du Platform Service Controller.

Comment ça marche

Le processus de migration déploie une vCSA Appliance et importe les données de l’installation de Windows vCenter. Il conserve l’adresse IP, l’UUID, le nom d’hôte, les certificats SSL et les ID de référence des objets de gestion du vCenter Server ; par conséquent, une fois l’installation terminée, la machine Windows vCenter Server est arrêtée. Si, pour une raison quelconque, la mise à niveau échoue et que la machine vCenter Windows est arrêtée, il vous suffit de mettre hors tension la machine virtuelle VCSA et de mettre sous tension la machine vCenter Windows. Le processus de mise à niveau et de migration n’apportera aucune modification à la machine Windows source.

Tous les PSC de votre infrastructure vCenter doivent être mis à niveau avant de mettre à niveau vCenter Server. Par conséquent, vous devez répéter la même procédure sur d’autres PSC dans le même domaine SSO. Une fois que tous les PSC ont été migrés / mis à niveau, vous pouvez procéder à la migration / mise à niveau de vCenter Server.

Mise à niveau des serveurs vCenter

vSphere 6.7 est la dernière version à inclure ou à prendre en charge l’installation de vCenter sous Windows. À l’avenir, toutes les versions de vCenter seront des appliances. Par conséquent, il est logique d’adopter le modèle d’appareil. Un vCenter basé sur Windows peut être migré (pendant le processus de mise à niveau) pour devenir une appliance.

Dans cette recette, nous couvrirons les étapes impliquées dans la mise à niveau de vCenter, en supposant que leurs PSC correspondants ont déjà été mis à niveau.

Se préparer

Vous aurez besoin des éléments suivants pour pouvoir compléter cette recette :

- VCSA 6.7 Installer ISO

- FQDN ou adresse IP du vCenter source

- IP temporaires pour le VCSA

Comment le faire

La procédure suivante vous guidera à travers les étapes de la mise à niveau d’une paire vCenter et PSC Windows vers les appliances VCSA 6.7 et PSC 6.7:

Mise à niveau – Étape 1: Déployer vCenter Server: Déployez l’appliance cible :

- Montez l’ISO vCSA 6.7 Installer sur une machine Windows.

- Exécutez le programme d’installation à partir de la source, c’est-à-dire CD – ROM : \ vcsa-ui-installer\win32\installer.exe.

- Sur l’écran du programme d’installation de vCenter Server Appliance 6.7 – Étape 1 : Déployer l’appliance , cliquez sur Migrer.

- Sur l’écran Introduction, cliquez sur Suivant pour continuer.

- Acceptez le contrat de licence utilisateur final et cliquez sur Suivant pour continuer.

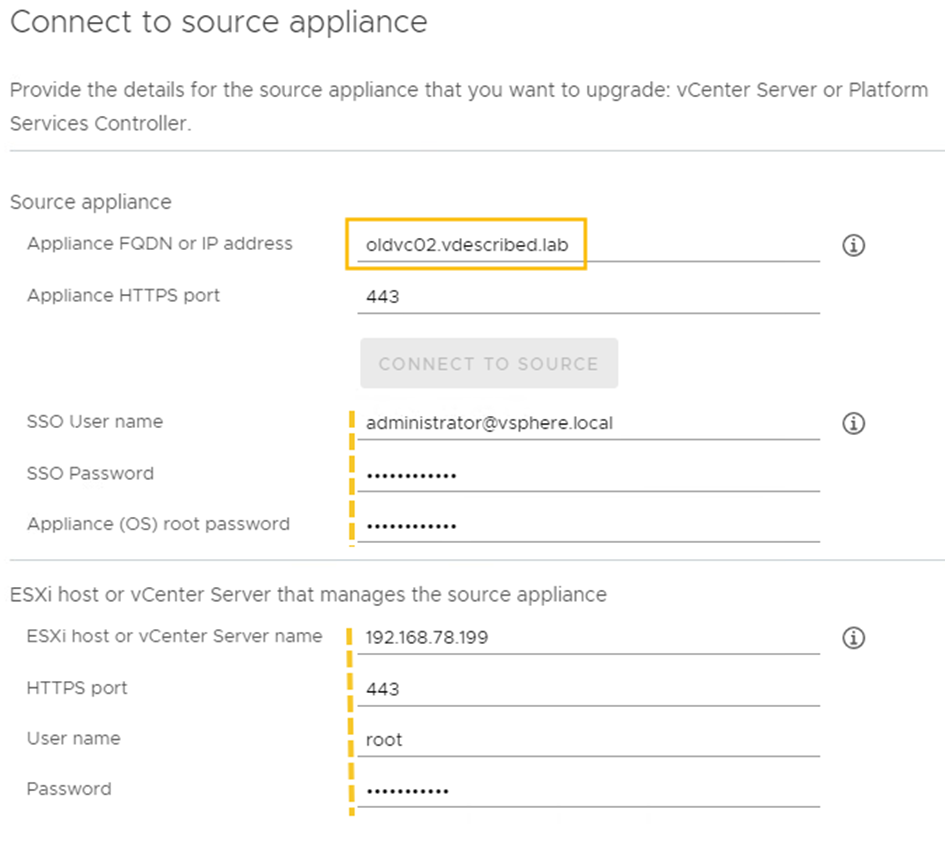

- Sur l’écran Se connecter à l’appareil source, fournissez les détails de l’appareil source (FQDN / IP source, informations d’identification SSO, mot de passe racine de l’appareil source) et la gestion ESXi / vCenterFQDN / IP et ses informations d’identification :

Acceptez l’avertissement de certificat, si vous y êtes invité.

- Sur l’écran cible de déploiement de l’appliance, spécifiez les détails du vCenter / ESXi sur lequel l’appliance cible sera déployée et cliquez sur Suivant pour continuer.

- Dans l’écran Configurer la machine virtuelle de l’appareil cible, spécifiez un nom pour la machine virtuelle de l’appareil cible et définissez le mot de passe racine de l’appareil cible.

- Dans l’écran Sélectionner la taille de déploiement, choisissez une taille de déploiement (petite, petite, moyenne, grande ou très grande). Une taille de stockage par défaut est choisie en fonction du type de déploiement sélectionné, mais vous pouvez choisir une taille de stockage non par défaut si vous le souhaitez. Faites un choix et cliquez sur Suivant pour continuer.

- Sur l’écran Sélectionner la banque de données, choisissez un emplacement pour la machine virtuelle cible, choisissez d’alléger la provision si vous le souhaitez, puis cliquez sur Suivant pour continuer.

- Sur l’écran Configurer les paramètres réseau, sélectionnez un groupe de ports auquel connecter la machine virtuelle cible et spécifiez la configuration IP temporaire. Celui-ci sera utilisé lors du transfert de données. Cliquer sur Suivant pour continuer.

- Sur l’écran Prêt à terminer l’étape 1, vérifiez les paramètres et cliquez sur Terminer.

- Une fois que l’appliance VCSA a été déployée avec succès, elle confirmera la même chose et vous suggérera de passer à l’étape 2. Cela peut être fait en cliquant sur Continuer ou en utilisant la page https: // Temp-IP: 5480 .

Mise à niveau – Stage 2 vCenter Appliance :

- En cliquant sur Continuer, vous serez redirigé vers l’assistant de mise à niveau – Étape 2: vCenter Appliance.

- Sur l’écran Introduction, cliquez sur Suivant.

- L’écran Se connecter à la source utilisera des détails préremplis pour démarrer automatiquement la vérification de pré-mise à niveau. Si ce n’est pas le cas, entrez les détails lorsque vous y êtes invité et cliquez sur Suivant.

- Une fois les vérifications préalables à la mise à niveau terminées, un écran de résultats de vérification préalable à la mise à niveau peut s’afficher. Si vous l’êtes, cliquez sur FERMER pour continuer :

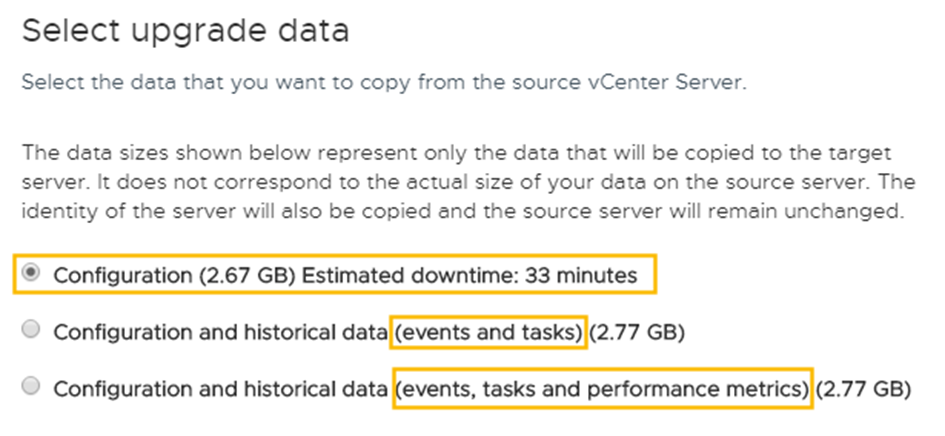

- Sur l’écran Sélectionner les données de mise à niveau, vous pouvez choisir de transférer uniquement la configuration ou inclure des données historiques et des mesures de performances. Par défaut, seule la configuration est sélectionnée. Faites la sélection souhaitée et cliquez sur Suivant pour continuer:

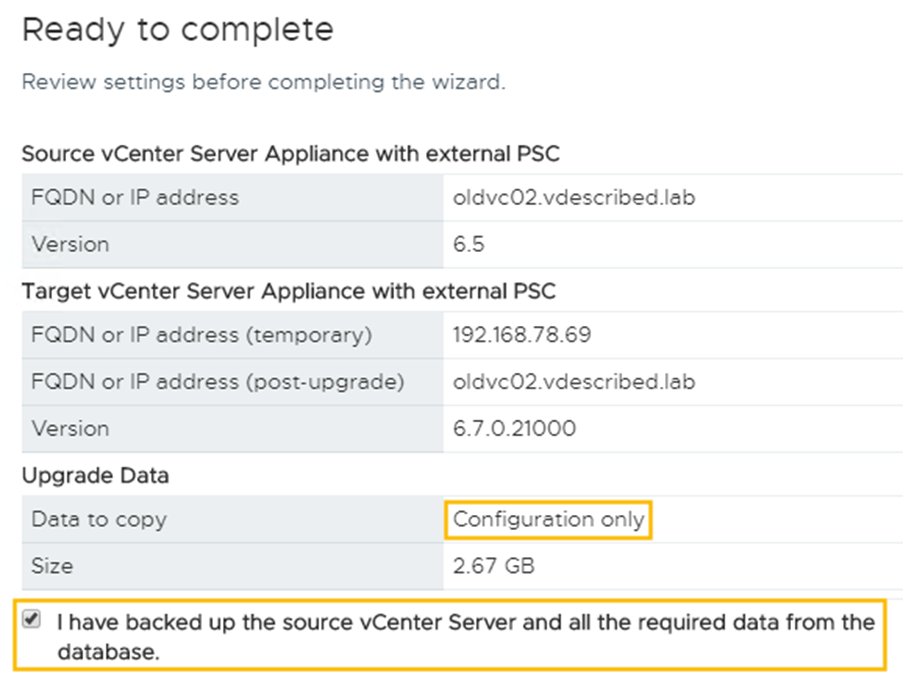

- Sur l’écran Prêt à terminer, vérifiez les paramètres et utilisez la case à cocher pour confirmer que vous avez sauvegardé l’appliance source. Cliquez ensuite sur Terminer:

Cliquez sur OK dans l’avertissement d’arrêt indiquant que l’appliance source sera finalement arrêtée.

- Une fois la mise à niveau terminée, un écran Upgrade – Stage 2: Complete vous sera présenté . Cliquez sur Fermer pour quitter le programme d’installation.

Ceci termine la mise à niveau du vCSA.

Comment ça marche

La procédure de migration d’un vCenter à partir de Windows est similaire, à l’exception de l’exécution de VMware Migration Assistant sur les machines Windows source exécutant vCenter Server et Update Manager.

Utilisation de l’outil de convergence vCenter

À partir de vSphere 6.7, il n’est pas nécessaire d’externaliser le PSC pour ELM, ce qui simplifie la protection des serveurs vCenter à l’aide de vCenter High Availability ( vCHA ). Cependant, si votre environnement existant possède des PSC externes, leur mise à niveau vers vCenter 6.7 conservera la même topologie.

Avec vCenter 6.7 Update 1, VMware comprend un outil de convergence, qui peut être utilisé pour installer des composants PSC dans les nœuds VCSA 6.7U1 existants et migrer la configuration PSC des PSC externes vers celui-ci, éliminant ainsi les nœuds PSC externes.

PSC 6.7 U1 (Windows) ne peut pas être converti en composants intégrés d’un vCenter existant. Les outils de convergence ne fonctionnent qu’avec vCenter et les appareils PSC.

Au moment de la publication de ce livre, la version la plus récente était vCenter 6.7 U2. La mise à jour 2 comprend une version GUI de l’outil de convergence. Cependant, le problème est que les PSC source devraient également exécuter 6.7U2. Pour plus de détails, reportez-vous à la démonstration de VMware Tech Pubs – https://youtu.be/HlL4KzAPx0c

Se préparer

Les conditions suivantes doivent être remplies avant de pouvoir utiliser l’outil de convergence vCenter :

- vCenter et PSC doivent être des appliances exécutant la version 6.7 Update 1 ou ultérieure.

- vCHA doit être désactivé. Notez qu’il ne s’agit pas de vSphere HA.

- Créez des instantanés sur les vCSA et les PSC.

- Vous pouvez également créer des sauvegardes basées sur des fichiers vCSA du VCSA et des PSC.

- Passez en revue le vCenter pour tous les plugins / solutions qui sont actuellement enregistrés et authentifiez-les avec PSC. Ceci est nécessaire car l’adresse IP et le nom de domaine complet du PSC changeront après leur convergence vers le vCSA.

- Définissez le niveau d’automatisation de vSphere Distributed Resource Scheduler (DRS) sur Manual sur le cluster de destination pour éviter la migration du vCSA cible ou du PSC source pendant la convergence.

Comment faire

La procédure suivante vous guidera à travers les étapes de la migration des composants PSC et de leur configuration vers un vCSA existant :

- Assurez-vous que les conditions préalables mentionnées dans la section Préparation sont remplies.

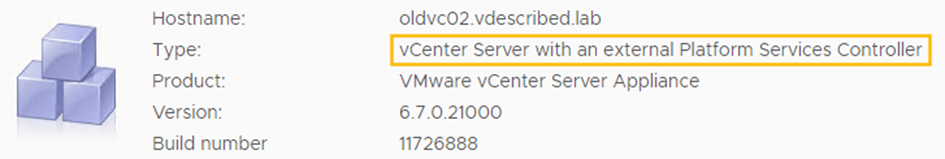

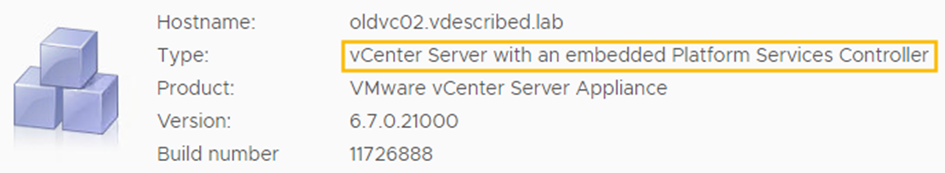

- Notez le Type du vCenter dans l’onglet Résumé du VAMI du vCenter. Il doit lire vCenter Server avec un Platform Services Controller externe :

- Montez l’ISO du programme d’installation VCSA 6.7U1 sur une machine Windows.

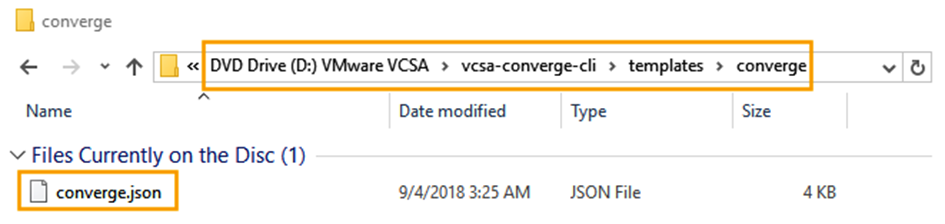

- Localisez le fichier converge.json sur le lecteur de DVD. Il doit être dans vcsa-converge-cli \ templates \ converge :

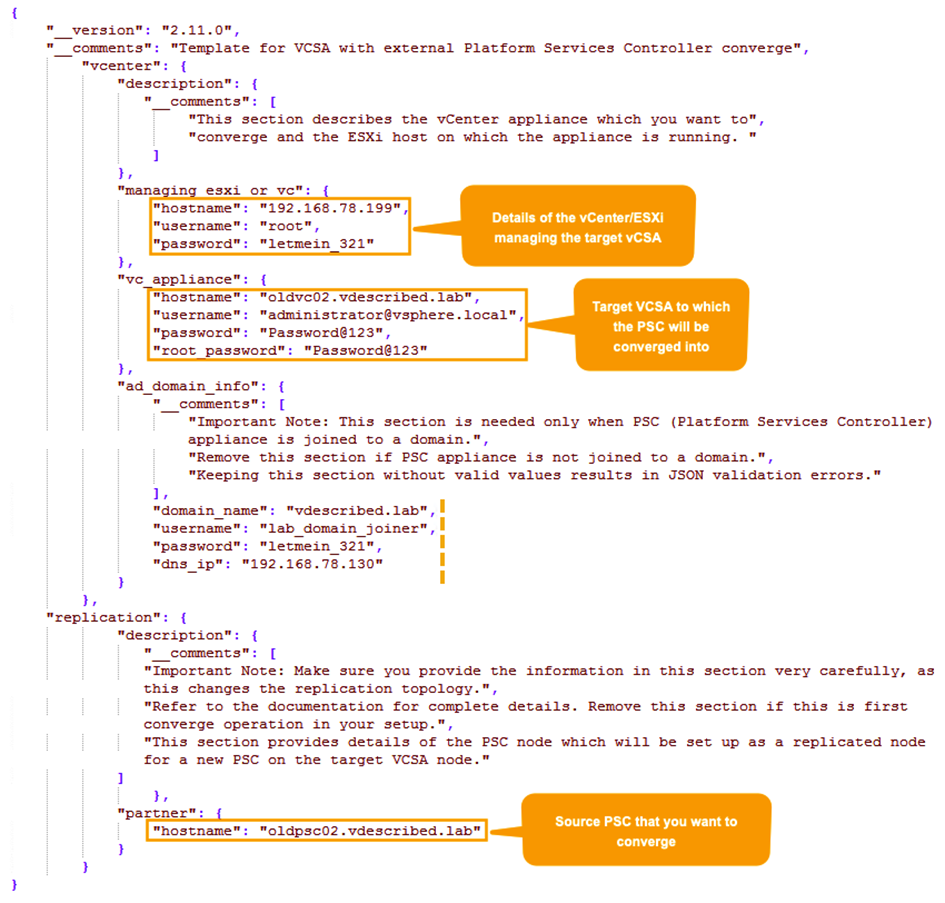

- Copiez le fichier converge.json dans un emplacement de lecture / écriture, tel que C: \ Converge \ converge.json . Ouvrez le fichier dans un éditeur de texte enrichi tel que WordPad et spécifiez les détails demandés. Ensuite, enregistrez les modifications:

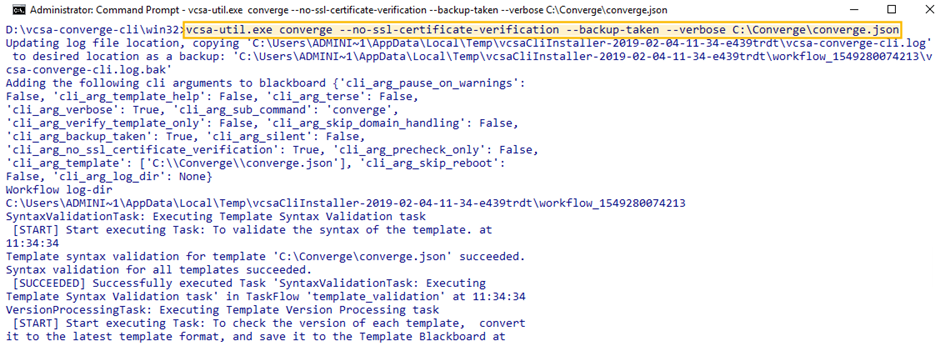

- Démarrez l’invite de commandes Windows en tant qu’administrateur et accédez au répertoire DVD ROM: \ vcsa-converge-cli \ win32 . Ensuite, exécutez la commande suivante:

vcsa-util.exe converge –no-ssl-certificate-verification –backup-taken –verbose <Ptch to converge.json>

Voici la sortie de la commande précédente:

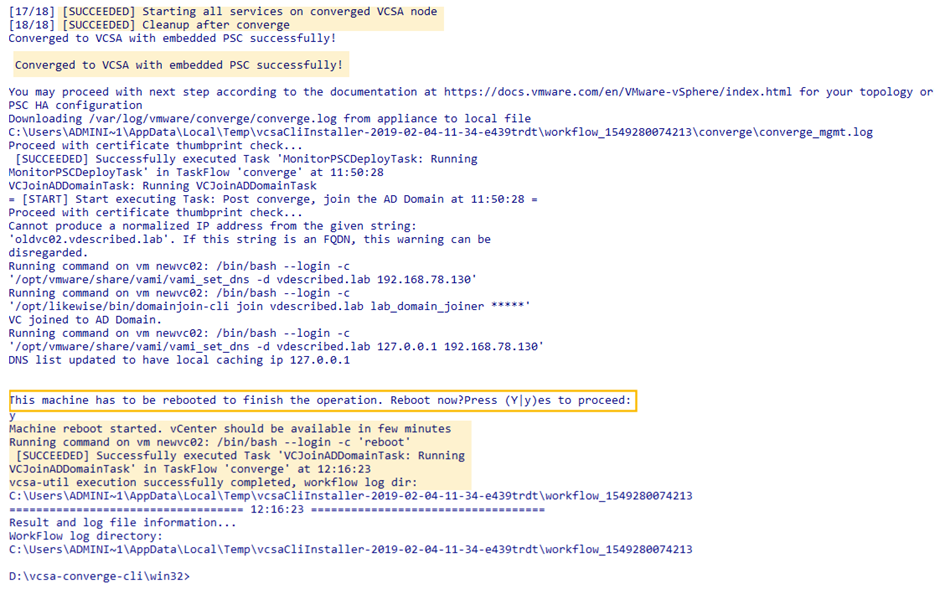

- Une fois la convergence terminée, il l’indiquera et recommandera un redémarrage. Appuyez sur Y pour continuer :

- Une fois terminé, l’onglet Résumé de vCenter indiquera qu’il s’agit désormais d’un vCenter avec un Platform Services Controller intégré :

- Une fois la convergence terminée, l’étape suivante consiste à mettre hors service le PSC source qui a réussi à converger.