0. Gestion des conteneurs avec Docker Enterprise – Partie 1

0.1 Résumé de la publication

Bien que connu principalement comme le moteur open source derrière des dizaines de millions de nœuds de serveur, Docker propose également des outils d’entreprise pris en charge commercialement appelés Docker Enterprise. Cette plate-forme exploite les racines profondes de Docker Engine – Community (anciennement Docker CE) et Kubernetes, mais ajoute un support et des outils pour exploiter efficacement une plate-forme de conteneurs sécurisée à grande échelle. Avec des centaines d’entreprises à bord, les meilleures pratiques et les modèles d’adoption émergent rapidement. Ces points d’apprentissage peuvent être utilisés pour informer les adoptants et aider à gérer la transformation d’entreprise associée à l’adoption du conteneur d’entreprise.

Cet article commence par expliquer le cas de Docker Enterprise, ainsi que sa structure et son architecture de référence. À partir de là, nous progressons à travers les étapes du PoC, du pilote et de la production en tant que modèle de travail pour l’adoption, en faisant évoluer la conception et la configuration de la plate-forme pour chaque étape et en utilisant des exemples d’application détaillés en cours de route pour clarifier et démontrer les concepts importants. L’article conclut avec l’impact de Docker sur d’autres technologies logicielles émergentes, telles que la Blockchain et l’informatique sans serveur.

À la fin de cet article, vous comprendrez mieux ce qu’il faut pour que votre entreprise soit opérationnelle avec Docker Enterprise et au-delà.

0.2 Objectifs de la publication

- Comprendre pourquoi les conteneurs sont importants pour une entreprise

- Comprendre les fonctionnalités et les composants de Docker Enterprise 2

- Découvrez les phases PoC, pilote et adoption de la production

- Découvrez les meilleures pratiques d’installation et d’exploitation de Docker Enterprise

- Comprendre ce qui est important pour une entreprise Docker en production

- Exécutez Kubernetes sur Docker Enterprise

0.3 Lien vers la partie 2

1 Docker Enterprise – L’apogée d’une architecture

1.1 De zéro à partout en cinq ans

Les équipes d’opérations techniques sont à juste titre sceptiques quant aux nouvelles plateformes technologiques telles que les conteneurs. Ils sont généralement plus préoccupés par le renforcement de la sécurité et de la fiabilité, car ils existent pour maintenir les applications d’entreprise opérationnelles et en toute sécurité. Dans le même temps, les propriétaires de produits au sein de leurs organisations doivent fournir des logiciels meilleurs, souvent plus complexes, plus rapidement. Oui, le paysage des affaires a profondément changé ; dans le monde des affaires d’aujourd’hui, les logiciels ne sont pas seulement utilisés pour obtenir un avantage concurrentiel, ils constituent l’entreprise et fournissent l’expérience client de première ligne.

Par la suite, une pression importante monte pour accélérer le pipeline de logiciels dans presque toutes les organisations. Cette section explique brièvement les racines des conteneurs et pourquoi leurs avantages (un pipeline logiciel sécurisé et rapide) ont conduit à une adoption aussi rapide des conteneurs.

1.1.1 L’histoire de Docker

Docker est né d’une présentation éclair, intitulée The future of Linux Containers, livrée à PyCon le vendredi 15 mars 2013. Le présentateur était Solomon Hykes, le fondateur de Docker. Ce jour-là, le monde du logiciel a changé même si les conteneurs Linux évoluaient dans la communauté Linux depuis près de 13 ans. Ce n’est pas la technologie que Salomon a dirigée qui a fait décoller le mouvement Docker, c’est la vision derrière elle et l’emballage de l’écosystème de conteneurs. La vision de Salomon était de créer des outils pour l’innovation de masse et son emballage de conteneurs Linux dans l’expérience Docker a livré cette technologie puissante et a mis les conteneurs à la portée de simples mortels. Aujourd’hui, Docker fonctionne sur des dizaines de millions de serveurs dans le monde.

Voici quelques notes sur les conteneurs Linux :

- Ils évoluent depuis 2000

- LinuxContainers (LXC) est sorti en 2008

- Le lmctfy de Google (laissez-moi le conteneur pour vous) prend en charge le libcontainer de Docker en 2015

- Des normes sont apparues, notamment OCI et CNCF, vers 2015

- Centre de support de référence de sécurité Internet

Au cours des 5 dernières années, des milliers de développeurs ont rejoint la communauté open source de Docker pour proposer ce que l’on appelle Docker Community Edition ( Docker Engine-Community ). Docker est resté attaché à une plateforme ouverte et à des règles du jeu équitables. Docker a fait don d’importants actifs à la communauté open source et aux normes, y compris le format de conteneur Docker et le runtime, pour fournir la pierre angulaire de l’Open Container Initiative (OCI) en 2015 et le runtime du conteneur à la Cloud Native Computing Foundation (CNCF) en 2017.

À Dockercon en 2017, Solomon Hykes a lancé Project Moby, qui donne à quiconque les outils dont ils ont besoin pour construire leur propre Docker. C’était très cool et finalement dans le meilleur intérêt de la communauté des conteneurs. Cependant, cet effort bien intentionné a conduit à un reconditionnement complet des actifs de la communauté Docker sans adhésion de la communauté. D’un point de vue global, Docker a démontré son engagement envers la communauté et la vision de Salomon des outils pour l’innovation de masse.

1.1.2 Les conteneurs modifient le développement et le déploiement d’applications

Les conteneurs permettent aux développeurs d’applications de regrouper leur application, ainsi que toutes leurs dépendances, dans une unité portable appelée image. Ces images sont ensuite stockées dans un référentiel distant où elles peuvent être extraites et exécutées sur n’importe quel moteur de conteneur compatible. De plus, les applications exécutées sur chaque moteur de conteneur sont isolées les unes des autres et du système d’exploitation hôte :

- Scénario illustratif : Disons que je veux tester NGINX sans rien installer (j’ai déjà Docker bien sûr installé). Je crée un exemple de page HTML appelée index.html dans mon répertoire local et exécute ce qui suit :

docker run -p 8000:80 -v ${PWD}:/usr/share/nginx/html:ro -d nginx

- Que se passe-t-il ici ?

- Je dis à Docker d’exécuter l’image nginx officielle en arrière-plan sur mon Docker Engine local, de transmettre le port 8000 de mon adaptateur hôte au port 80 du conteneur et de monter mon répertoire local pour partager mon fichier HTML avec nginx en tant que dossier en lecture seule.

- Ensuite, je pointe mon navigateur local sur http://localhost:8000 et je vois ma page HTML rendue. Quand j’ai fini, je demande à Docker de retirer le conteneur. Donc, en l’espace d’une minute environ, j’ai créé une page Web de test, utilisé NGINX pour le rendre localement sans rien installer localement, et l’ai exécuté en toute isolation. La seule collision possible avec une ressource hôte était autour du port 8000 de l’adaptateur hôte, ce qui était arbitraire.

- C’est cool, mais les VM ne le font-elles pas déjà pour nous ?

- Sur le plan conceptuel, il existe certaines similitudes, mais la mise en œuvre des conteneurs est beaucoup plus légère et efficace. Les principales différences de mise en œuvre sont :

- Tous les conteneurs partagent le noyau de l’hôte :

- Docker utilise les contrats à terme de sécurité des conteneurs Linux pour isoler les conteneurs de l’hôte et d’autres conteneurs.

- Étant donné que le noyau est déjà en cours d’exécution, le temps de démarrage des conteneurs est généralement d’une seconde ou deux, par rapport à l’attente d’une minute ou deux pour que le système d’exploitation invité démarre sur une machine virtuelle.

- Les conteneurs utilisent un système de fichiers en couches avec mise en cache :

- Les images Docker sont composées de couches en lecture seule qui peuvent être mises en cache et partagées sur plusieurs conteneurs.

- Les parties principales des images Docker peuvent être partagées entre les conteneurs, ce qui signifie que vous n’avez pas à extraire l’image entière à chaque fois. D’un autre côté, les machines virtuelles ont un système de fichiers monolithique et opaque qui est complètement rechargé à chaque démarrage. Cela entraîne des temps de chargement lents et un stockage d’image inefficace avec les machines virtuelles.

- Tous les conteneurs partagent le noyau de l’hôte :

- Sur le plan conceptuel, il existe certaines similitudes, mais la mise en œuvre des conteneurs est beaucoup plus légère et efficace. Les principales différences de mise en œuvre sont :

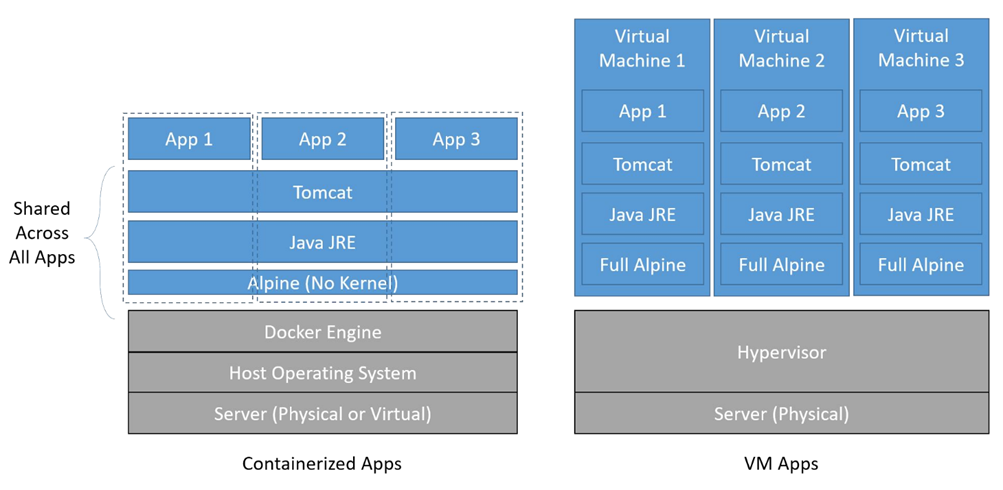

Dans la figure suivante, vous pouvez voir comment les applications des machines virtuelles (côté droit du diagramme) ont une copie complète du système d’exploitation et des binaires de prise en charge dans chaque machine virtuelle, tandis que les applications conteneurisées (côté gauche du diagramme) partagent toutes les mêmes binaires Alpine (aucun noyau nécessaire ~ 3 Mo) et binaires d’exécution. Il y a eu divers rapports sur l’impact financier des conteneurs par rapport aux machines virtuelles, mais le nombre que j’ai vu varie de 15% à 70% de réduction des coûts d’exploitation. Comme ils le disent, votre kilométrage peut varier en fonction de votre système d’exploitation, de vos binaires et de votre passage au bare metal pour éliminer les coûts de licence de l’hyperviseur :

Applications conteneurisées vs applications VM

1.1.3 Les conteneurs gagnent en popularité

Ce qui suit est globalement un résumé de ce que j’entends des clients et des étudiants :

- Intégration plus rapide des développeurs : développement basé sur des conteneurs

- Facile à exécuter et à tester sur les machines de développement : idéal pour simuler la production

- Cycles de publication plus rapides et temps plus court pour corriger les bogues : plus de déploiements monolithiques

- Logiciel de meilleure qualité : images cohérentes dans tous les environnements

- Il est trop difficile de gérer les microservices sans eux : les piles sont idéales pour l’isolement et le déploiement

- Prise en charge plus facile des applications Web héritées : conteneurisez les anciennes applications et gérez-les sur une plate-forme moderne

- Réduction de la taxe VMware : meilleure utilisation des ressources de calcul grâce à une densité et une consolidation accrues de plusieurs environnements non prod (à l’aide de Docker Enterprise RBAC)

Même le matériel gratuit vous coûtera quelque chose: je termine cette section sur une note pratique en suggérant que vos économies opérationnelles initiales seront compensées par l’investissement nécessaire pour transformer votre entreprise en une plate-forme de conteneurs. Une fois bien fait, l’impact de l’adoption des conteneurs affecte un large groupe au sein de l’entreprise, couvrant l’ensemble du développement de logiciels et du pipeline de livraison. Comme toute transformation qui en vaut la peine, certains investissements sont nécessaires. Plus d’informations sur l’impact de l’adoption de conteneurs plus tard.

1.1.4 Docker Engine-Community – Docker gratuit

La version open source de Docker s’appelle Docker Engine-Community et est distribuée sous la licence Apache 2.0. Parfois appelée Docker gratuit, cette version est prise en charge par la communauté et elle-même. Docker a deux schémas d’emballage :

- Docker Engine-Community pour les architectures de bureau x86 64 bits pour Mac et Windows 10 Pro +

- CE Server pour le ciblage CentOS, Debian, Fedora et Ubuntu Linux distributions

Outre le packaging de la plateforme, Docker Engine-Community est livré avec deux canaux. Il est important de noter qu’à partir de la version 18.09 de Docker Engine-Community, le canal stable sortira sur une cadence de six mois et le canal périphérique sera remplacé par une version nocturne :

- Canal stable : le code de disponibilité générale est publié via ce canal après avoir été soigneusement testé.

- Canal Edge pour les plates – formes de bureau : version mensuelle du code préliminaire qui se trouve à différentes étapes des tests.

- Chaîne nocturne : Un nouveau code est publié ici ! Par la suite, de nouvelles fonctionnalités intéressantes apparaissent ici en premier, mais cette base de code n’est pas complètement testée et ne doit pas être utilisée pour la production. De plus, si vos développeurs utilisent le canal de périphérie (ou s’exécutent avec le drapeau —experimental) sur leurs postes de travail, vous devrez être très prudent pour éviter les travaux sur mon scénario de machine ! Veillez à ce que le nouveau code ne repose pas sur des fonctionnalités GA inédites ou expérimentales qui fonctionneront sur la station de travail du développeur, mais se rompra plus tard à mesure que les images et / ou les configurations se déplaceront dans le pipeline.

Vous pouvez envisager d’avoir un cluster de développement où les développeurs déploient leur code sur une infrastructure Docker qui correspond aux versions de production. Si un cluster de développement est disponible, les développeurs doivent toujours se déployer sur le développement avant que leur code ne soit archivé, pour garantir qu’aucune génération n’est rompue.

1.1.4.1 Docker Engine-Community comprend des fonctionnalités clés

Docker Engine-Community est une plate-forme de conteneur riche en fonctionnalités qui comprend une API complète, une CLI (client Docker) et une architecture de plug-in riche pour l’intégration et l’extension. Il vous permet d’exécuter des applications de production sur un seul nœud ou dans un cluster sécurisé qui inclut un réseau de superposition et un équilibrage de charge de couche 4. Tout est inclus lorsque vous installez le moteur Docker Engine-Community !

1.1.4.2 Exécution de Docker Engine-Community sur AWS ou Azure

Veuillez noter qu’il existe des packages de démarrage rapide AWS et Azure pour les utilisateurs du cloud. Ces bundles pratiques incluent une image AMI / VM prise en charge par Docker, ainsi que des utilitaires cloud pour câbler et prendre en charge un cluster de nœuds Docker Engine-Community. Les véritables atouts ici sont les modèles IaaS natifs du fournisseur cloud (AWS CloudFormation ou Azure resource manager), les images Docker VM et les conteneurs d’utilitaires Docker4x pour interagir avec les services du fournisseur cloud. Par exemple, le bundle AWS vous permet d’inclure le plug-in de volume cloudstore, où au lieu d’utiliser des volumes EBS locaux, vous pouvez utiliser des volumes sauvegardés EFS et S3 sur l’ensemble du cluster.

Bien que vous puissiez utiliser NFS pour obtenir une solution de stockage à l’échelle du cluster sur site, en raison d’une latence imprévisible sur les réseaux des fournisseurs de cloud, où les montages NFS peuvent devenir inopinément en lecture seule, je recommande fortement d’utiliser Cloudstor sur AWS et Azure. Plus d’informations peuvent être trouvées sur https://docs.docker.com/docker-for-aws/persistent-data-volumes/ .

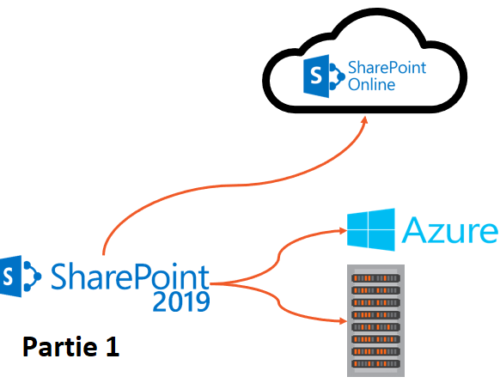

Enfin, veuillez noter que Docker pour AWS et Docker pour Azure s’appliquent uniquement aux installations Docker Engine-Community. Docker Enterprise utilise désormais les outils d’infrastructure certifiés Docker, utilisant Terraform et Ansible pour cibler les implémentations VMware, Azure et AWS de Docker Enteprise.

1.1.5 Docker Enterprise – prise en charge et fonctionnalités d’entreprise

Docker gratuit est super ! Mais vous soutenir n’est pas toujours aussi génial. Par conséquent, Docker Engine-Community est généralement un bon choix pour apprendre et démarrer, mais dès que vous vous dirigez vers la production, vous devriez envisager de passer à Docker Enterprise pour le support et / ou les outils de classe entreprise qu’il fournit.

Docker Enterprise s’appuie sur l’ensemble de fonctionnalités déjà riche de Docker Engine-Community et ajoute une prise en charge commerciale du Docker Engine (Docker Enterprise Basic), ainsi que des outils importants pour la gestion de plusieurs équipes et applications de production, y compris les applications Kubernetes (Kubernetes est inclus dans Docker Enterprise Standard et avancé).

Docker offre les modèles de support suivants pour Docker Engine-Community et Docker Enterprise :

- Docker Engine-Community : à partir de CE 18.09, vous devrez mettre à niveau (gérer les éventuelles modifications) tous les 7 mois si vous souhaitez des correctifs et une prise en charge des correctifs. Il s’agit d’une amélioration récente car, avant CE 18.09, le cycle de support n’était que de quatre mois. Docker Engine-Community s’appuie sur des forums de support communautaire ; vous postez un problème dans un forum public et attendez que quelqu’un vous aide ou génère un correctif. Docker a une grande communauté, mais avec Docker Engine-Community, il n’y a pas d’accords de niveau de service (SLA).

- Docker Enterprise : vous devrez mettre à niveau (gérer les éventuels changements de rupture) tous les 24 mois pour maintenir l’accès aux correctifs et à la prise en charge des correctifs. La pierre angulaire de Docker Enteprise est son canal de support privé de niveau entreprise avec un accord de niveau de support critique pour l’entreprise ou le jour ouvrable.

- Astuce : l’entreprise critique a un SLA de temps de réponse plus rapide, mais coûte plus cher.

Docker Enterprise inclut également une prise en charge transparente des plug-ins et des conteneurs certifiés Docker fournis par ISV. Cela signifie que si vous avez un problème avec un plugin ou un conteneur certifié, vous appelez simplement Docker pour obtenir de l’aide.

Les problèmes de support de Docker Engine-Community sont publiés publiquement pour que tout le monde puisse les voir. Cela peut être un problème si vous êtes, par exemple, une institution financière annonçant publiquement une vulnérabilité de sécurité que vous avez découverte et donc en prévenant les pirates. Si vous avez des inquiétudes concernant la visibilité publique de vos problèmes ou si vous avez besoin de SLA, vous pouvez envisager d’acheter Docker Enterprise Basic avec une assistance le jour ouvrable.

Docker Enterprise est également disponible en trois niveaux :

- Niveau de base de Docker Enterprise : ensemble de fonctionnalités Docker Engine-Community avec prise en charge de Docker Enterprise, comme décrit précédemment.

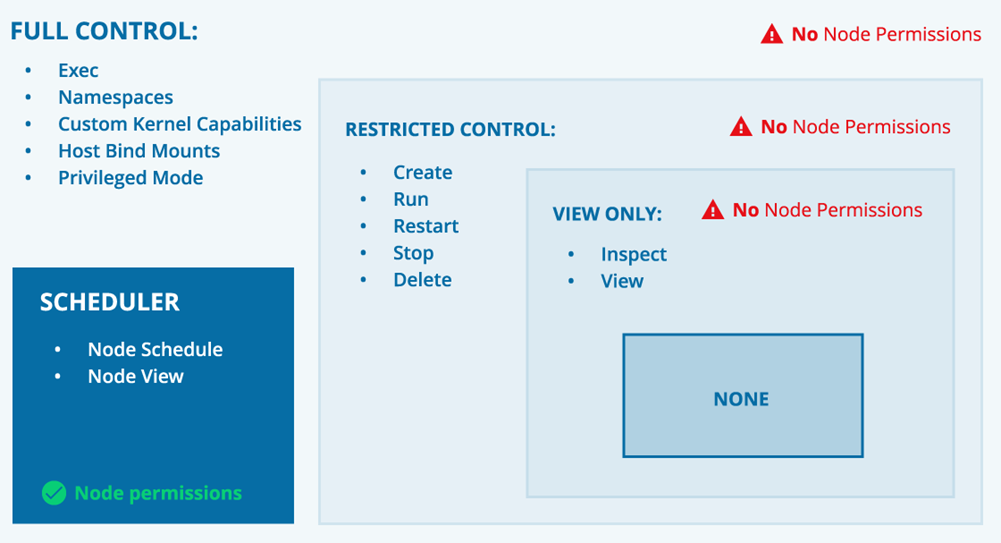

- Niveau standard de Docker Enterprise : intégré à Docker Engine-Community avec prise en charge de Docker Enterprise comme décrit précédemment, mais ajoute le plan de contrôle universel (UCP; sécurité intégrée avec les connexions LDAP et RBAC via un bundle GUI ou CLI pour la gestion des politiques, couche 7) routage, Kubernetes prêt à l’emploi et une interface Web) et le Docker Trusted Registry (DTR; un registre d’images privé lié au modèle de sécurité UCP avec signature d’images, promotions, webhooks et API complète) accès).

- Niveau avancé de Docker Enterprise : inclut toutes les fonctionnalités du niveau standard de Docker Enterprise, mais donne à Universal Control Plane (UCP) un RBAC plus fin pour permettre l’isolement des nœuds. Le niveau avancé améliore le Docker Trusted Registry (DTR) avec l’analyse de la vulnérabilité des images et la mise en miroir d’images sur les DTR distants.

Le niveau avancé applique un degré élevé d’isolement des ressources jusqu’au niveau du nœud. Cela permet à une entreprise de consolider tous ses environnements de non-production en un seul cluster de dockers non prod. Cela peut considérablement réduire le nombre de services requis pour les activités hors production. Les développeurs, testeurs et opérateurs reçoivent des subventions RBAC appropriées pour travailler de manière isolée.

1.1.6 Kubernetes et Docker Enterprise

À moins que vous ne vous cachiez sous un rocher, vous avez probablement entendu parler de Kubernetes. Trop souvent, j’ai entendu des membres (non informés) de la communauté technologique dire que nous n’utilisons pas Docker, nous utilisons Kubernetes. C’est un peu naïf puisque la grande majorité des clusters exécutant Kubernetes orchestration le font avec le Docker Engine.

Les orchestrateurs permettent aux développeurs de câbler des nœuds de conteneur individuels dans un cluster pour améliorer l’évolutivité et la disponibilité, et récolter les avantages de l’auto-réparation et de la gestion des applications distribuées / microservices. Dès que les applications multiservices devaient coordonner plus d’un conteneur pour s’exécuter, l’orchestration est devenue une chose. Orchestrators permet aux développeurs d’applications conteneurisées de spécifier comment leur collection de conteneurs fonctionne ensemble pour former une application. Ils déploient ensuite l’application à l’aide de cette spécification pour planifier les conteneurs requis sur un cluster (généralement Docker) d’hôtes.

Au début, les startups nées dans le cloud qui fonctionnaient à grande échelle et déployaient généralement des microservices ont pris conscience d’un besoin d’orchestration. Par conséquent, les esprits brillants de Google ont créé ce qui est devenu le cadre d’orchestration Kubernetes et ont ensuite créé un organisme indépendant pour le gérer, la Cloud Native Computing Foundation (CNCF), avec Kubernetes comme projet de pierre angulaire de la CNCF. Pendant ce temps, la communauté Docker a commencé à travailler sur son propre projet d’orchestration appelé Swarmkit.

1.1.6.1 Orchestration de Kubernetes et Swarm

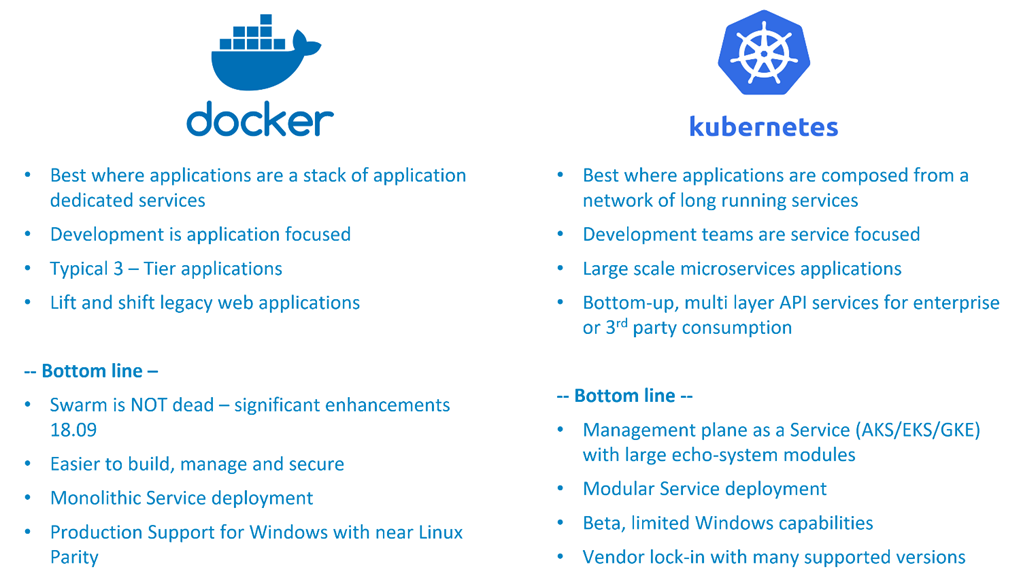

Bien qu’il existe de nombreuses variations et incantations dans l’espace d’orchestration, le marché se résume à des acteurs très différents : Kubernetes et Swarm. Et non, Swarm n’est pas mort.

Kubernetes a rapidement évolué en tant que plateforme d’orchestration tierce modulaire et hautement configurable prise en charge et utilisée par des développeurs natifs du cloud à 12 facteurs. D’un point de vue technique, c’est une plateforme très intéressante avec de nombreux degrés de liberté et des points d’extensibilité. Pour les gens hardcore à 12 facteurs (également connus sous le nom de cool kids) qui fournissent généralement des systèmes très complexes à grande échelle, l’utilisation de Kubernetes est une évidence. Cependant, si vous n’êtes pas Google ou eBay, Kubernetes pourrait être un peu pour vous, surtout au début.

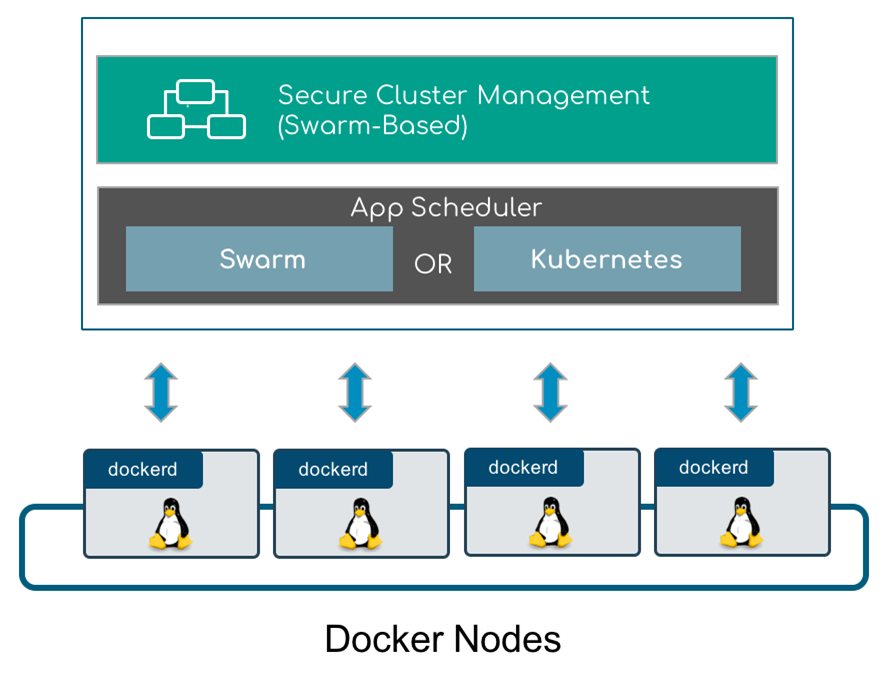

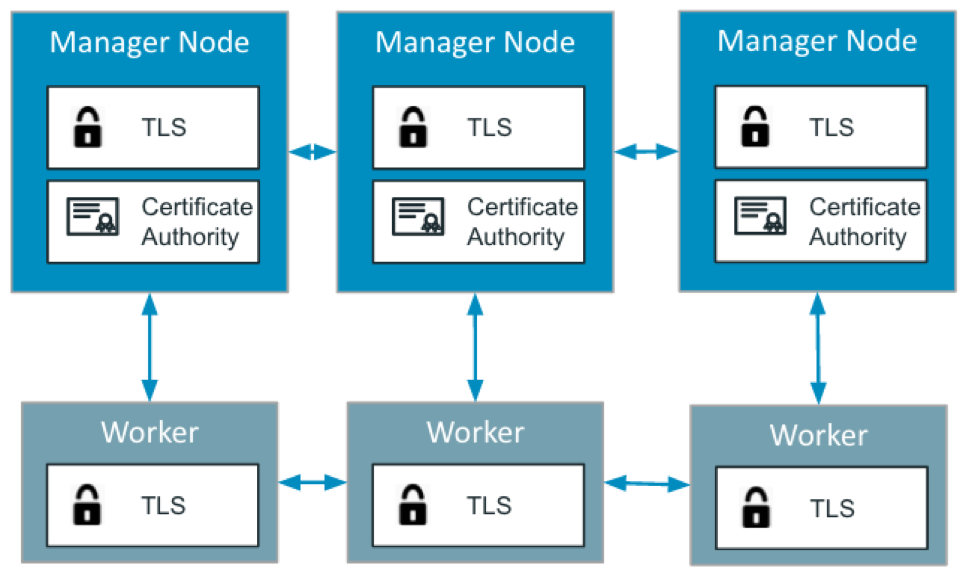

Swarm, l’outil d’orchestration de Docker, a commencé comme un complément, mais dans la version 1.12 a été ajouté au moteur Docker. En tant que tel, il n’y a rien à installer ; vous l’activez plutôt à l’aide des commandes docker swarm init et docker swarm join pour créer un cluster crypté TLS avec un réseau de superposition prêt à l’emploi ! Donc, c’est en quelque sorte le bouton facile pour l’orchestration car il n’y a rien de plus à installer, et il est à la fois sécurisé et prêt à l’emploi. Swarm est inclus dans Docker Engine-Community et les ferroutages UCP de Docker Enterprise directement hors de Swarm.

1.1.6.2 Kubernetes et Swarm – différentes philosophies pour résoudre différents problèmes

Quel est le meilleur (pour vous) ? En fait ça dépend…

Débuter avec Kubernetes est assez difficile. Cela est dû au fait qu’en plus d’un environnement d’exécution de conteneur (tel que Docker Engine-Community), vous devez installer et configurer kubectl , kubeadm et kubelet , mais ce n’est que le début. Vous devez également prendre certaines décisions à l’avance, comme choisir un modèle de mise en réseau et configurer / installer l’implémentation CNI du conteneur du fournisseur. Kubernetes ne fournit généralement pas d’options par défaut (certains services cloud le font pour vous), ce qui vous donne une grande flexibilité, mais vous oblige naturellement à prendre une décision initiale et complique l’installation. Encore une fois, c’est parfait si vous avez besoin de cette flexibilité et que vous savez exactement ce que vous faites.

D’un autre côté, si vous avez Docker 1.12 ou plus récent (nous vous recommandons fortement d’avoir quelque chose de beaucoup plus récent), il vous suffit de l’activer avec la commande docker swarm init. Il crée une autorité de certification, un magasin Raft chiffré et un réseau de superposition automatiquement, ainsi qu’une commande de jointure à jetons pour ajouter en toute sécurité des nœuds supplémentaires à votre cluster. Cependant, dans un esprit de simplicité et de sécurité, Docker a fait certains choix par défaut pour vous. C’est formidable si vous pouvez vivre avec ces choix, au moins pendant que vous vous familiarisez avec les plates-formes de conteneurs d’entreprise.

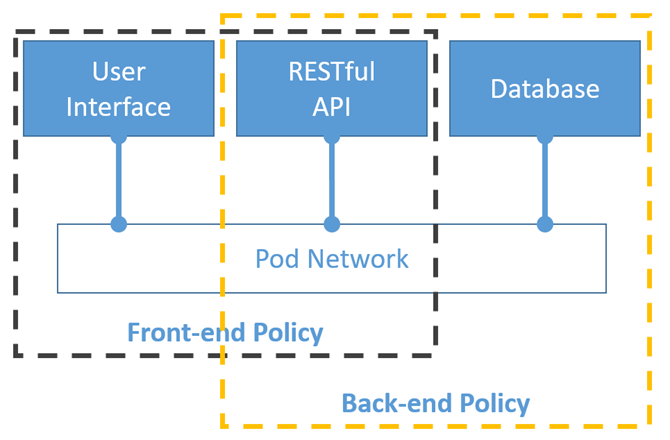

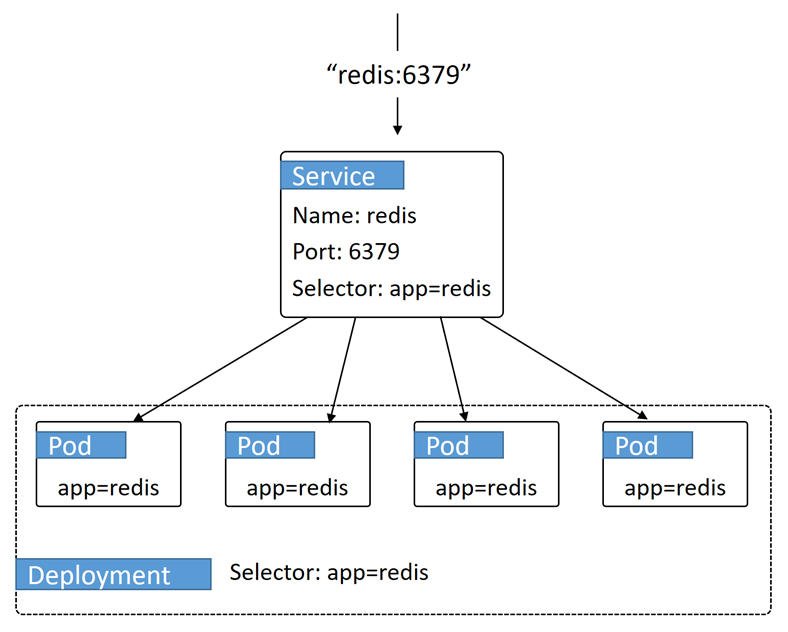

Au-delà de l’installation, la description du déploiement d’applications (à l’aide de fichiers YAML) dans Kubernetes est intrinsèquement plus complexe. En ce qui concerne les styles de déploiement, Kubernetes déploie des composants discrets et les relie à une collection de fichiers YAML qui s’appuient sur des étiquettes et des sélecteurs pour les connecter. Toujours dans le style Kubernetes, lors de la création de composants, vous devez définir un large éventail de paramètres de comportement pour décrire exactement ce que vous voulez, plutôt que de supposer un comportement par défaut. Cela peut être verbeux, mais c’est très puissant, précis et flexible !

Kubernetes inclut également le pod en tant qu’unité de déploiement atomique, ce qui peut être pratique pour isoler un ensemble de conteneurs du modèle de mise en réseau plat. Cela conduit à l’utilisation de conteneurs side-car qui interfacent essentiellement les pods avec le reste du monde. C’est très cool et c’est un excellent moyen de gérer des réseaux de services partagés, de longue durée et faiblement couplés dans un espace d’adressage plat :

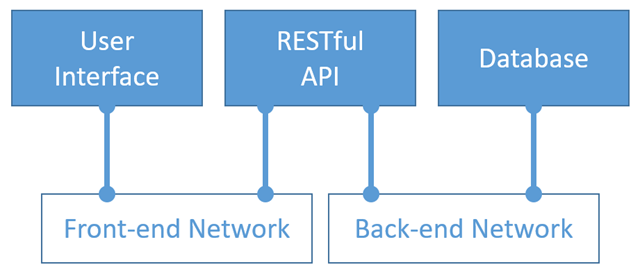

Docker Swarm et Kubernetes

Swarm adopte une approche monolithique centrée sur l’application en définissant une pile de services associés dans un fichier .yaml . Les piles d’essaim supposent que vous exécutez une collection de services connexes, isolés par des réseaux de superposition, pour prendre en charge des fonctionnalités spécifiques dans le contexte d’une application. Cela facilite le déploiement d’une pile d’applications typique telle qu’un frontend angulaire avec l’API RESTful d’une application et une base de données Postgres.

1.1.6.3 Déplacer Kubernetes vers le courant dominant

De nombreux fournisseurs PaaS et IaaS plongent dans Kubernetes et proposent des configurations clé en main. Ils parient sur l’API Kubernetes comme spécification pour déployer des charges de travail d’application dans leur service. Les exemples incluent le moteur Kubernetes de Google, le service Azure Kubernetes et enfin et surtout, le service Amazon Elastic Container Service pour Kubernetes (Amazon EKS). Celles-ci sont excellentes pour vous aider à démarrer, mais qu’en est-il si / quand vous transférez des charges de travail stables sur site en raison de problèmes de coût ou de sécurité ?

Enfin, méfiez-vous des limitations liées aux solutions PaaS. Si vous utilisez un plan de gestion PaaS Kubernetes, vous pouvez être limité à utiliser le plug-in CNI du fournisseur PaaS et leur implémentation peut limiter vos options. Par exemple, si vous exécutez Kubernetes sur AWS, la mise en œuvre réseau peut nécessiter une IP / pod virtuelle, mais vous n’obtenez qu’un nombre limité d’IP virtuelles par type d’instance. Par la suite, vous devrez peut-être passer à un type d’instance plus grand et plus cher pour prendre en charge plus de pods, même si vous n’avez pas vraiment besoin de CPU, de réseau ou de stockage plus / meilleurs.

1.2 Nouvelle ère pour les applications Dev, DevOps et les opérations informatiques

L’utilisation de conteneurs et d’orchestrateurs change la façon dont nous envisageons la création de logiciels et la définition d’un pipeline de livraison de logiciels. Le développement basé sur des conteneurs prend en charge fondamentalement ce que les gens de DevOps appellent un décalage vers la gauche, où les développeurs de systèmes distribués deviennent plus responsables de la qualité de la solution globale, c’est-à-dire les binaires et la façon dont ils sont connectés. Par conséquent, le câblage de mes services n’est plus le problème des équipes de mise en réseau, d’intégration ou d’exploitation ; il appartient aux développeurs. En fait, la spécification YAML pour la connexion et le déploiement de leur application est maintenant un artefact qui est vérifié dans le contrôle du code source !

Un déploiement plus rapide des correctifs et des améliorations est une motivation essentielle pour conteneuriser des applications Web monolithiques conçues avec Job et .NET. La conteneurisation permet à chaque équipe de fonctionner de manière indépendante et de déployer son application dès qu’elle est prête à fonctionner, sans avoir à attendre toutes les autres équipes d’application ou le prochain cycle de publication trimestriel.

La conteneurisation des applications peut être très utile pour éliminer les bourrages de journaux d’organisation associés aux déploiements monolithiques pré-conteneur, car chaque application obtient son propre conteneur d’exécution. Ce conteneur comprend toutes leurs dépendances d’exécution spécifiques, telles que Java et Tomcat, pour l’application à exécuter. Étant donné que nous utilisons des conteneurs, nous nous préoccupons moins des frais généraux associés au démarrage et à l’exploitation de conteneurs similaires en production en nous rappelant comment Docker isole l’exécution des applications, tout en partageant les couches communes du système de fichiers pour des heures de démarrage rapides et une utilisation efficace des ressources. Ainsi, plutôt que de devoir coordonner toutes les équipes impliquées dans un déploiement, chaque équipe a sa propre pile isolée de dépendances, ce qui lui permet de se déployer et de tester selon son propre calendrier. Sans surprise, une fois les applications conteneurisées, il est beaucoup plus facile de les refactoriser indépendamment.

Commencez par conteneuriser les applications sans changer de code si possible. Une fois l’application conteneurisée, procédez à une refactorisation. Essayer d’accomplir simultanément la conteneurisation et la refactorisation peut être intimidant et peut bloquer le projet.

1.2.1 DevOps

Tirer parti des conteneurs dans votre pipeline d’intégration continue et de déploiement continu est devenu une meilleure pratique pour la plupart des équipes DevOps. Même le pipeline lui-même est souvent exécuté comme une plateforme conteneurisée. La motivation ici est un produit de meilleure qualité, basé sur le modèle de serveur immuable où les conteneurs sont construits une fois et promus à travers le pipeline. En d’autres termes, l’application n’est pas réinstallée sur un nouveau serveur virtuel entre chaque étape du pipeline. Au lieu de cela, la même image de conteneur est extraite d’un référentiel central et exécutée à l’étape suivante. Les variables d’environnement et les fichiers de configuration sont utilisés pour tenir compte des variations entre les environnements.

1.2.2 Opérations

Étant donné que l’équipe d’application a assumé les tâches de câblage et de configuration de l’application pour le déploiement, l’équipe des opérations peut se concentrer sur la plate-forme de conteneurs. Cela inclut la configuration et la maintenance des environnements opérationnels de la plate-forme de conteneurs, la surveillance et la journalisation centralisée des applications s’exécutant dans le cluster, et la gestion de la sécurité / des politiques au sein du cluster pour garantir que les applications et les utilisateurs se comportent comme prévu.

1.3 Impact sur les conteneurs d’abord et stratégique des conteneurs

Les conteneurs ajoutent de nouvelles possibilités à l’approche de la stratégie d’application de votre entreprise, principalement en ce qui concerne la migration vers le cloud et la modernisation des applications. Les conteneurs permettent aux organisations d’élever cette conversation des tactiques de migration vers le cloud et des piles d’applications à une plate-forme d’application commune où pratiquement n’importe quelle pile d’applications s’exécute plus efficacement tout en rendant les applications portables dans le cloud.

1.3.1 Le conteneur d’abord comme stratégie d’adoption du cloud

Que se passe-t-il si, avant de commencer la migration de toutes vos applications vers un fournisseur spécifique au cloud, vous préférez d’abord conteneuriser vos applications, puis les migrer vers le cloud. Ceci est parfois appelé une stratégie de conteneur d’abord. Cette approche présente plusieurs avantages importants :

- Résumé des connaissances spécifiques à la plate-forme des équipes d’application

- Gagner en efficacité opérationnelle (généralement entre 15% et 70%) grâce aux applications conteneurisées

- Il vous donne la possibilité de déplacer vos applications entre sur site et tout fournisseur de cloud avec un minimum d’effort

La réflexion sur les conteneurs devrait réduire les besoins en personnel spécifiques au cloud; au lieu d’un administrateur / application cloud, vous disposez d’un cluster administrateur / conteneur cloud. Une fois conteneurisées, les migrations d’applications entre les fournisseurs de cloud et sur site doivent être mesurées en heures et non en semaines ou en mois.

1.3.2 Préparez-vous à ramener les charges de travail du cloud public

Passer au cloud est amusant et cool! Cependant, cela peut devenir très coûteux et difficile à contrôler pour une entreprise. La plupart de ce que je vois des clients est que le cloud est logique pour les charges de travail très variables où la capacité élastique est très importante. Cependant, lorsque des charges de travail stables et prévisibles sont impliquées, de nombreuses organisations trouvent le cloud public trop cher et les migrent finalement vers leur centre de données ou leur cloud privé. C’est ce qu’on appelle le rapatriement de la charge de travail et cela devient un événement très courant.

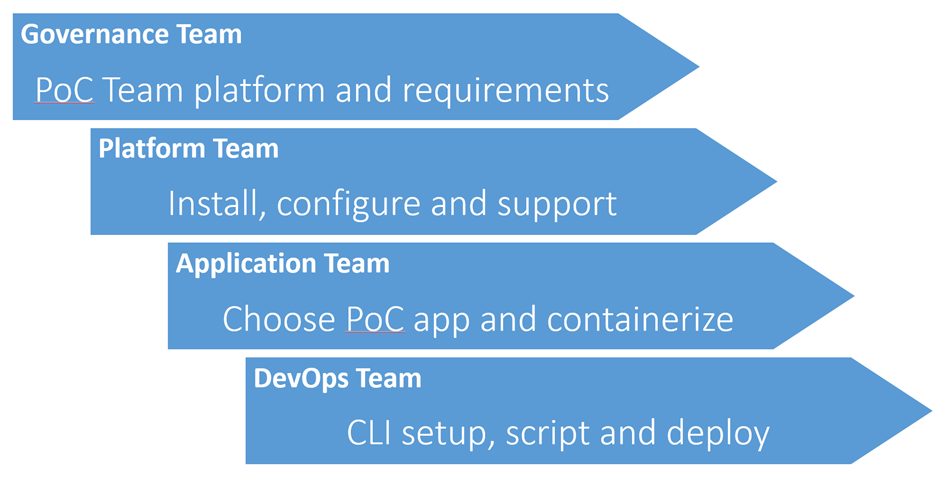

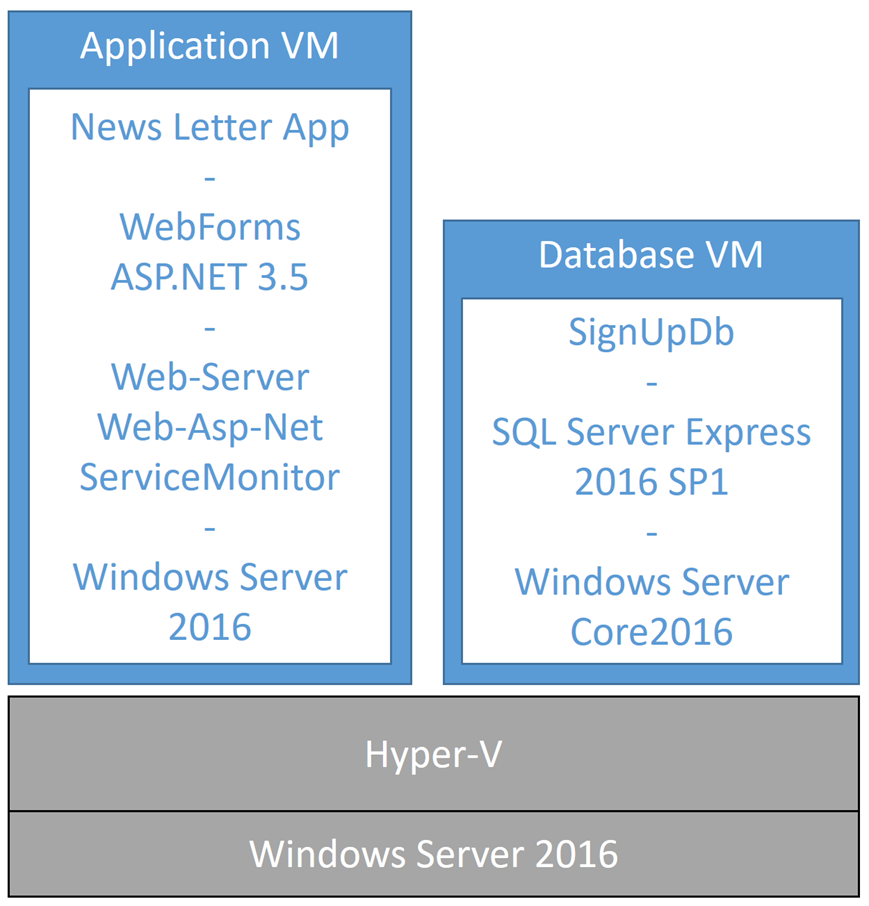

1.3.3 Modernisation des applications – le chemin de la conteneurisation

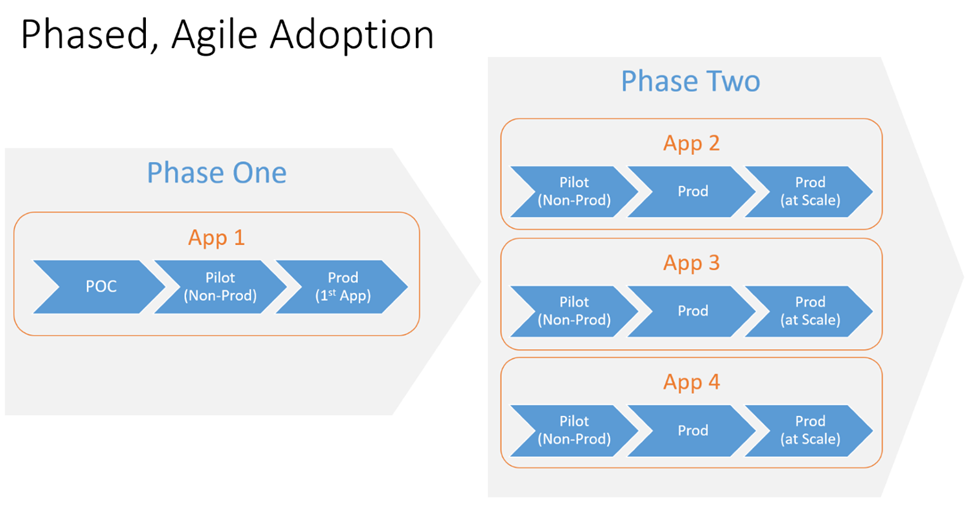

Les clients Docker ont documenté des réductions significatives des coûts opérationnels obtenus en conteneurisant simplement les applications Web traditionnelles (.NET 2.0+ et Java) et en mettant en place une infrastructure Docker Enterprise pour les exécuter. Cette infrastructure peut fonctionner dans le cloud, VMware ou même le bare metal. Il existe une méthodologie utilisée par les architectes de solutions Docker pour aider les entreprises à migrer les applications traditionnelles. Il commence par un PoC accéléré, passe à une application pilote et enfin à la production, où chaque étape s’appuie sur la dernière.

1.3.4 Prise en charge des microservices et DevOps

À ce stade du jeu, la plupart des équipes de développement n’essaieront même pas de créer et de déployer des microservices sans conteneurs ni orchestrateurs. Les équipes de développement de style à 12 facteurs ont beaucoup de pièces mobiles et se déploient souvent – un ajustement parfait pour Docker et Kubernetes! Ces équipes utilisent des systèmes CI / CD décentralisés et conteneurisés qui prennent en charge les conteneurs intégrés pour atteindre de faibles taux d’erreur à l’aide de déploiements automatisés à haute vitesse.

1.3.5 Conformité

Alors que la conformité pour les plates-formes de conteneurs est réalisable avec des produits tiers tels que Sysdig Secure, Twistlock et AquaSec, Docker Enterprise 2.1 ajoute la prise en charge de la conformité FIPS pour les plates-formes Windows et RHEL. Cela signifie que la plate-forme Docker est validée par rapport aux normes et aux meilleures pratiques largement acceptées lors du développement de produits Docker Enterprise.Ainsi, les entreprises et les agences obtiennent une confiance supplémentaire pour adopter les conteneurs Docker. La publication 140-2 de la norme FIPS (Federal Information Processing Standard) étant les normes les plus remarquables, vérifie et autorise l’utilisation de divers modules de chiffrement de sécurité au sein d’une pile logicielle d’organisation qui comprend désormais le Docker Enterprise Engine.

Pour plus d’informations sur les FIP, veuillez visiter le site Web de Docker : https://docs.docker.com/compliance/nist/fips140_2/ . Pour plus d’informations sur la conformité générale de Docker, veuillez visiter: https://docs.docker.com/compliance/ .

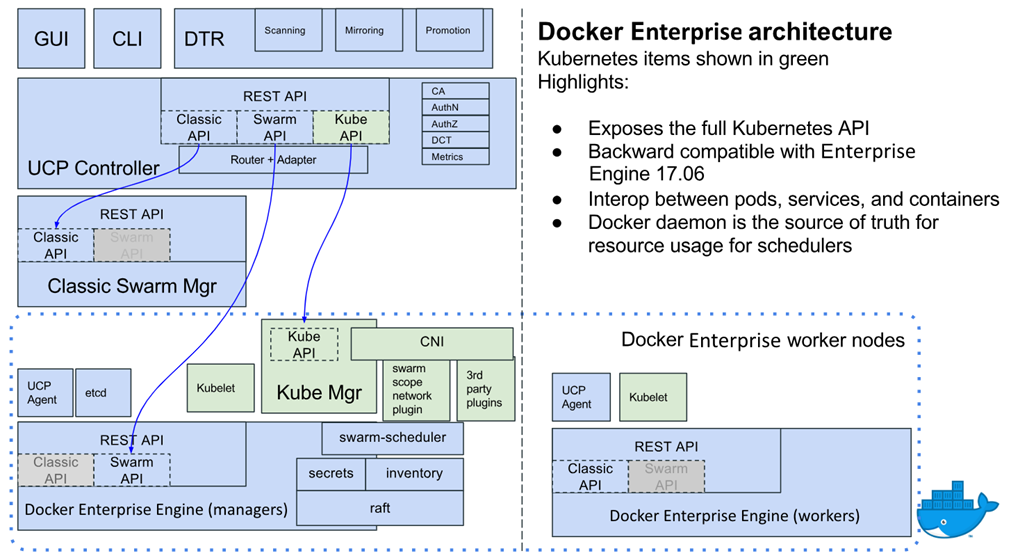

1.4 Comment Docker Enterprise 2.0 a changé le jeu

En avril 2018, Docker Enterprise 2.0 était une version. Dans cette version, Docker a ajouté la prise en charge de Kubernetes. Pas une version emballée ou reconditionnée, mais la vraie version open source. L’avantage de l’exécution de Kubernetes sur Docker Enterprise 2.0 est la simplicité. Avec Docker Enterprise 2.0, le plan de contrôle universel comprend Kubernetes préinstallé, qui fonctionne avec Swarm. Cela signifie que les entreprises n’ont pas besoin de choisir entre Kubernetes et Swarm; ils peuvent les avoir tous les deux. C’est un gros problème pour les organisations qui doivent gérer à la fois des poches d’applications avancées de microservices et des applications traditionnelles à n niveaux plus simples. Avec Docker Enterprise 2.0, les équipes de microservices sont libres de mettre leur Kube en marche, tandis que les autres équipes se familiarisent avec Swarm. En outre, il permet à une entreprise de gérer une courbe d’apprentissage plus facile à gérer en démarrant avec Swarm et en introduisant plus tard des configurations Kubernetes plus complexes si nécessaire.

De plus, lors de Dockercon 2018, Docker a annoncé des fonctionnalités très intéressantes sur sa feuille de route à court terme concernant l’intégration entre Docker Enterprise et les services Kubernetes basés sur le cloud. Essentiellement, Docker Enterprise 2 pourra utiliser une application Kubernetes sur site exécutée sur Docker Enterprise 2.0 et la déployer sur un fournisseur Kubernetes basé sur le Web tel qu’Amazon ou Google.

Bien que Docker Enterprise 2.0 ne soit pas le choix parfait pour une petite startup native du cloud, sa flexibilité, son modèle de sécurité intégré et sa plate-forme unique devraient en faire une considération primordiale pour les plates-formes de conteneurs sur site et hybrides.

1.5 Résumé

Au cours des 5 dernières années, les conteneurs sont sortis de l’obscurité et ont été mis à l’honneur dans l’industrie du logiciel et DevOps. L’impact organisationnel profond des conteneurs s’étend aux développeurs de logiciels, aux administrateurs informatiques, aux ingénieurs DevOps, aux architectes et aux cadres. Depuis le début, Docker, Inc. a été au centre du mouvement des conteneurs et reste attaché au succès à long terme en soutenant les normes de l’industrie, la communauté open source et, plus récemment, les clients d’entreprise avec un Docker Enterprise 2 compatible Kubernetes.

Au cours des 5 prochaines années, l’adoption par les entreprises de conteneurs va s’épanouir. Par la suite, la plupart des organisations commenceront à rechercher une solution de niveau entreprise qui équilibre les coûts et la sécurité avec la vitesse et les fonctionnalités de plate-forme de pointe. La vitre unique de Docker Enterprise pour le cloud hybride et les clusters sur site, ainsi que la prise en charge des dernières technologies de conteneurs, y compris la prise en charge de Kubernetes, sont très susceptibles d’attirer l’attention des leaders informatiques astucieux du monde entier.

À venir dans le chapitre 2 , Docker Enterprise – an Architectural Overview , notre voyage continue alors que nous explorons les fonctionnalités et l’architecture de Docker Enterprise.

2 Docker Enterprise – un aperçu architectural

Alors que nous approfondissons les détails de Docker Enterprise, il est important de savoir où il s’inscrit dans le paysage concurrentiel des fournisseurs de plates-formes de conteneurs d’entreprise. Informer les acheteurs des grandes catégories de fournisseurs peut les aider à décider si Docker Enterprise est le meilleur pour leur organisation. De plus, nous fournissons une vue d’ensemble de l’économie de Docker Enterprise ainsi que des fonctionnalités clés, de l’architecture et des composants pour prendre en charge des produits ouverts et pris en charge pour les clients d’entreprise.

Les sujets suivants seront traités dans ce chapitre :

- Position de Docker Enterprise sur le marché émergent des plates-formes de conteneurs d’entreprise

- Les coûts / avantages économiques de l’architecture de Docker Enterprise

- Le contexte architectural de Docker Enterprise

- Les composants clés de Docker Enterprise

- Architecture de référence de Docker Enterprise

2.1 Passer des projets scientifiques aux plateformes de production

Au début, et pour les conteneurs jusqu’à la mi-2017 environ, les applications basées sur Docker ressemblent davantage à des projets scientifiques qu’à des plates-formes de production bien conçues. Il semble qu’aucun montant de dette technique ne soit trop élevé tant que votre application est en cours d’exécution, stable et cool. De plus, l’outillage roulé à la main qu’il a fallu pour prendre en charge les premières applications Docker / Kubernetes n’était pleinement compris que par un ou deux membres d’une équipe d’entreprise, et ils étaient généralement plus alignés avec les développeurs et moins alignés avec l’équipe des opérations, créant un énorme écart dans l’ensemble de compétences de l’entreprise requis pour soutenir les conteneurs dans la production. Alors que la dette technique augmentait et que l’écart de compétences se creusait, une grande opportunité de marché s’est présentée.

Avec la croissance explosive de Docker depuis 2013, une opportunité de marché importante est apparue pour prendre en charge les conteneurs dans l’entreprise. Pour réussir, ces plateformes doivent considérer les objectifs suivants :

- Donner aux développeurs la possibilité de construire, de tester (localement sur des postes de travail de développement ainsi que sur un cluster de développement distant) et de déployer des applications multi-conteneurs sécurisées à volonté

- Fournir un pipeline CI efficace et sécurisé, géré par les développeurs

- Permettre aux opérateurs (DevOps, TechOps et SecOps) de sécuriser, gérer, surveiller et faire évoluer efficacement plusieurs environnements pour des applications de développement, de test, d’assurance qualité et de production

- Prise en charge des exigences de conformité au niveau de la plate-forme, pas seulement au niveau de l’application

2.1.1 Le paysage des plateformes de conteneurs émergentes

De nombreuses sociétés technologiques de pointe sont impliquées dans le jeu de plate-forme de conteneurs et je vais les regrouper en trois grandes catégories pour résumer la place de Docker Enterprise. Les noms de fournisseurs spécifiques sont intentionnellement cachés pour éviter tout argument émotionnel ou guerre juridique, donc juste quelques tamisage et tri de niveau pour l’instant:

- Des catégories de plateformes de conteneurs émergent :

- Plates-formes de conteneurs de fournisseurs de virtualisation :

- Résumé : Les grands fournisseurs de virtualisation d’entreprise sont à juste titre préoccupés par l’érosion des revenus de virtualisation par les conteneurs. En effet, l’exécution de Docker peut réduire, ou dans le cas de Docker sur du métal nu, éliminer le besoin de produits de virtualisation commerciaux. Actuellement, Docker sur du métal nu est assez rare dans la nature, mais il représente une menace énorme pour l’industrie de la virtualisation de plusieurs milliards de dollars au cours des 10 prochaines années.

- Plates-formes de conteneurs de fournisseurs de virtualisation :

De manière réaliste, les conteneurs et les technologies de virtualisation seront considérés comme des technologies complémentaires à court terme, mais à plus long terme, il existe un risque réel pour l’industrie de la virtualisation.

En réponse à la menace des conteneurs, les fournisseurs de virtualisation répondent avec leur propre plateforme de conteneurs, mais ils ont besoin d’une licence de leur dernière plateforme de produit pour l’utiliser.

-

-

- Avantages :

- S’appuyer sur les plates-formes technologiques et les compétences existantes

- Tirer parti des contrats juridiques existants (peut nécessiter certaines mises à niveau cependant)

- Facile à utiliser / mêmes canaux de support

- Inconvénients :

- Nécessite généralement des mises à niveau vers les options les plus récentes / avancées

- Bloqué dans leur pile et pas facile de passer à des plates-formes différentes, peut-être moins chères à l’avenir

- Taxe de virtualisation : nécessite une pile complète de fournisseurs et des licences partout où vous déployez, sur site ou dans le cloud

- Avantages :

- Piles de fournisseurs de plate-forme de système d’exploitation :

- Résumé : Les fournisseurs fournissant un support d’entreprise pour les systèmes d’exploitation Linux ont également jeté leur chapeau dans le ring. Dans l’espoir de conserver des parts de marché grâce à la commodité, ces fournisseurs offrent des options intéressantes, mais vous enferment dans leurs modèles de licence pour utiliser leur version de conteneurs. Ces plates-formes fournissent généralement des versions plus anciennes de Docker (presque 2 ans dans certains cas) ou des moteurs de conteneur alternatifs dont elles sont propriétaires.

- Avantages :

- S’appuyer sur les plateformes technologiques et les compétences existantes du système d’exploitation

- Tirer parti des contrats juridiques existants

- Facile à utiliser / mêmes canaux de support

- Inconvénients :

- Habituellement, plusieurs versions derrière leurs homologues open source

- Verrouillé dans leur version du système d’exploitation et doit utiliser leur pile de système d’exploitation sous licence pour être pris en charge

- Enveloppez les API sous-jacentes : nécessite des API supplémentaires et de longs délais entre la version de fonctionnalité ouverte et la version de version encapsulée du fournisseur

- Plates-formes de conteneurs basées sur les fournisseurs de cloud :

- Résumé : La plupart des déploiements initiaux d’applications de microservices utilisant Docker et Kubernetes étaient des applications nées dans le cloud. Initialement, ceux-ci étaient roulés à la main avec des réseaux virtuels et des machines virtuelles cloud, mais les fournisseurs de cloud ont vu une grande opportunité sur le marché des conteneurs et ont commencé à offrir des services de plate-forme liés aux conteneurs (* CS) en 2015. Initialement, ces services étaient axés sur d’héberger des déploiements de conteneurs, mais la maturité rapide de l’orchestration de conteneurs a conduit à la sortie d’une nouvelle génération de services de plateforme cloud liés à l’orchestration (* KS) en 2017 et 2018.

- Avantages :

- Facile à démarrer

- Facile à connecter aux autres services du fournisseur de cloud

- Coût initialement bas

- Inconvénients :

-

- Besoin de fournir, de câbler, de gérer et de payer vos propres clusters

- Versions antérieures de Docker et Kubernetes

- L’isolement par groupe de ressources ou VPC conduit à l’étalement des clusters – devient coûteux et compliqué pour une gestion d’accès intégrée centralisée

- Intégration permanente : services de fournisseurs de cloud faciles à utiliser, difficiles à migrer vers un autre fournisseur de cloud ou sur site

-

- Plateforme ouverte prise en charge, technologies extensibles :

- Résumé : Docker Enterprise appartient à la catégorie des technologies ouvertes et extensibles prises en charge. La complexité de rassembler de nombreux produits open source sous un même toit est un défi, mais en fin de compte, c’est beaucoup pour les clients. Les clients Docker ont le choix et la transparence de cette plate-forme, mais une intégration plus poussée est nécessaire. C’est ce que la plupart des entreprises feraient si elles le pouvaient, mais elles ne peuvent généralement pas se permettre une équipe dédiée d’ingénieurs rock star.

-

Docker Enterprise est soutenu par des ingénieurs dédiés et ils s’efforcent de fournir une plate-forme de conteneur portable dans le cloud, offrant au client le choix de s’exécuter sur n’importe quelle plate-forme cloud / OS populaire avec prise en charge Docker et un cycle de publication stable pour les technologies ouvertes sous-jacentes – et cela sans emballer ou bifurquer des technologies clés telles que Kubernetes. Docker Enterprise comprend l’API Docker / conteneur D et la véritable API Kubernetes prête à l’emploi.

-

-

- Avantages :

- Une plate-forme de conteneur d’entreprise portable ou compatible avec les hybrides que Docker prend en charge du moteur jusqu’au plan de contrôle, y compris des plug-ins certifiés Docker pour la mise en réseau et le stockage

- Tout ce dont vous avez besoin (Docker Enterprise Standard +) pour exécuter une plateforme de conteneur d’entreprise, y compris un cluster sécurisé, un plan de contrôle universel et un registre de conteneurs sécurisé et riche en fonctionnalités

- Très rentable pour les plateformes à l’échelle de l’entreprise

- En raison de RBAC, il suffit généralement de deux clusters pour tous les environnements

- Inconvénients :

- Peut être coûteux pour un petit cluster HA: les clusters HA nécessitent généralement trois gestionnaires / maîtres, trois nœuds DTR et nécessitent donc un 7e nœud pour démarrer l’exécution des charges de travail. Veuillez noter que cette surcharge est rapidement compensée par la consolidation de tous les environnements de non-production dans un seul cluster non-prod avec RBAC.

- Une version initiale de Docker Enterprise peut prendre un peu de temps et de réflexion. Étant donné que l’approche de plate-forme ouverte de Docker permet d’innombrables permutations de l’infrastructure appropriée, la préparation d’une plate-forme spécifique à l’entreprise pour l’installation nécessite une certaine planification et expertise (matériel / machines virtuelles, système d’exploitation, réseaux, stockage, surveillance / alerte). Les services professionnels de Docker et les partenaires de conseil autorisés peuvent vous aider (beaucoup) ici, mais je couvrirai beaucoup de ces éléments de configuration dans les chapitres suivants pour vous aider à démarrer par vous-même.

- Avantages :

-

Plus récemment, les analystes de l’industrie technologique ont créé une catégorie de suite logicielle de plate-forme de conteneurs. Au quatrième trimestre 2018, les recherches de Forrester ont affirmé que Docker Enerprise était en tête du peloton: https://goto.docker.com/the-forrester-wave-enterprise-container-platform-software-suites-2018.html .

2.1.2 Économie, fonctionnalités et composants clés de Docker Enterprise

Quand il s’agit de décider d’une plate-forme de conteneurs d’entreprise dans le monde des affaires numérique d’aujourd’hui, il s’agit d’équilibrer l’innovation (généralement dans le but d’augmenter les revenus du top) avec les coûts associés pour prendre en charge et opérationnaliser ces nouvelles applications. Ainsi, comme la plupart des décisions commerciales importantes, cela se résume à l’économie et dans ce cas à l’économie associée aux applications conteneurisées à l’appui de l’innovation, ou peut-être à la conteneurisation d’anciennes applications Web pour des coûts de support continus plus bas afin de libérer des ressources pour le budget de l’innovation. Dans tous les cas, vous devrez comprendre les coûts et les avantages de Docker Enterprise.

2.1.2.1 Le coût estimé de Docker Enterprise

Nous commençons notre brève discussion coûts / avantages par le côté coût de l’équation et en commençant par la plate-forme Docker Enterprise et les licences.

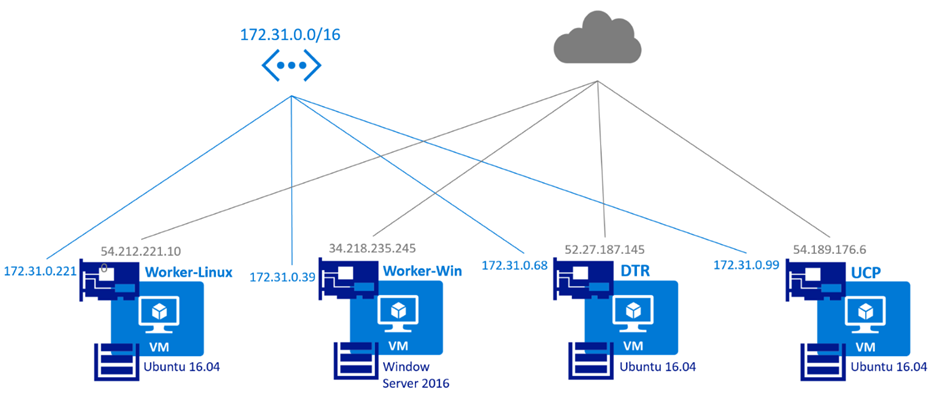

Pour exécuter Docker Enterprise, vous aurez besoin de serveurs virtuels pour chaque nœud, d’un réseau pour les connecter et d’un stockage basé sur cluster (NFS fonctionne généralement très bien pour le stockage en cluster sur site). N’oubliez pas que Docker Enterprise peut s’exécuter dans le cloud, sur site, sur une machine virtuelle ou sur des serveurs bare-metal, à vous de choisir. À des fins d’estimation des coûts, prévoyez six nœuds de gestionnaire avec quatre cœurs et 16 Go de RAM pour les gestionnaires et les nœuds Docker Trusted Registry ( DTR ). Les ressources requises pour les nœuds de travail dépendent des types de charges de travail que vous exécutez sur votre cluster. Par exemple, avec une application basée sur Java, vous avez généralement besoin d’une grande empreinte mémoire de peut-être quatre cœurs et 32 Go de RAM par nœud de travail. Alors qu’avec une application basée sur un nœud, vous pouvez avoir plus d’équilibre entre le processeur et la mémoire et pouvez exécuter plusieurs applications confortablement avec deux cœurs et 16 Go de RAM.

Quelle que soit la plate-forme d’infrastructure que vous choisissez, il est généralement judicieux de cibler une plate-forme sur laquelle votre équipe d’exploitation dispose d’un ensemble de compétences existant, afin qu’elle puisse concentrer son apprentissage énergétique Docker Enterprise sans avoir à gravir une nouvelle courbe d’apprentissage de plate-forme en même temps.

En outre, gardez à l’esprit qu’un cluster de démarrage typique aura environ 10 nœuds, car six des nœuds sont utilisés pour la gestion des clusters et des images, laissant quatre nœuds pour gérer les charges de travail. Cela peut sembler être un ratio élevé de nœuds de surcharge par rapport à la charge de travail, mais n’oubliez pas que vous pouvez probablement ajouter des centaines de nœuds de travail supplémentaires sans ajouter de surcharge.

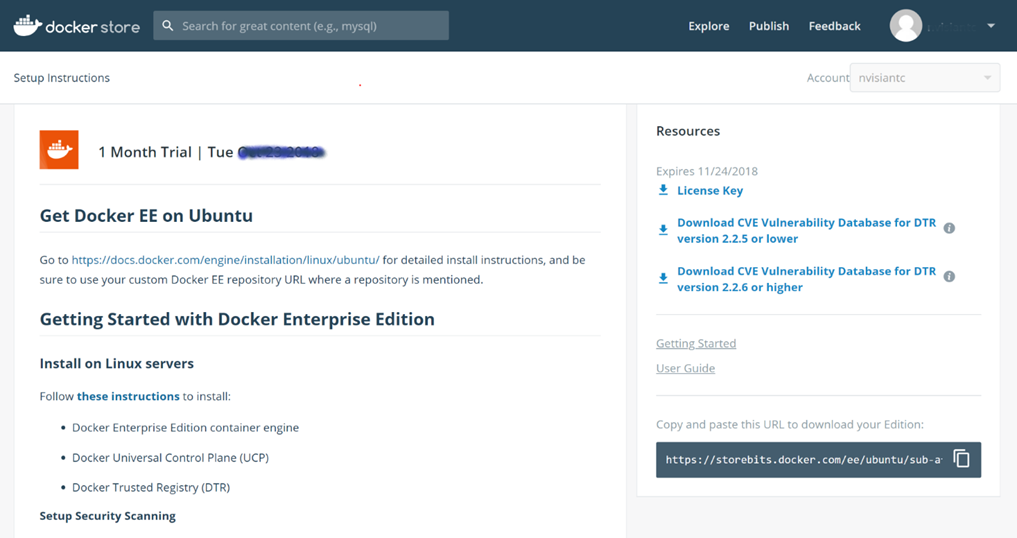

Docker Enterprise est un produit commercial et peut être acheté auprès de Docker, Inc. ou d’un revendeur agréé Docker. Les coûts estimatifs suivants sont susceptibles de changer et sont basés sur des informations accessibles au public provenant de la boutique en ligne de Docker. Lorsque vous envisagez sérieusement Docker Enterprise, vous devez contacter directement Docker ou un revendeur agréé pour obtenir des prix actualisés et éventuellement réduits.

Par conséquent, à titre d’exemple, voici une tarification représentative (à partir de https://hub.docker.com/ ) pour les configurations de cluster haute disponibilité ( HA ) courantes . Veuillez noter que l’assistance le jour ouvrable est de 9 h à 18 h, heure locale, du lundi au vendredi, et l’assistance critique pour l’entreprise est de 24 heures / jour x 7 jours / semaine x 365 jours / an.

2.1.2.2 Illustration de la tarification de Docker Enterprise

Le tableau suivant montre un exemple de matrice de tarification pour Docker Enterprise:

| Édition standard de Docker Enterprise (support le jour ouvrable) | Docker Enterprise advanced (support le jour ouvrable) | Docker Enterprise advanced (support stratégique) | |

| Nœuds de gestionnaire | 3 x 150 $ / mois | 3 x 200 $ / mois | 3 x 350 $ / mois |

| DTRnodes | 3 x 150 $ / mois | 3 x 200 $ / mois | 3 x 350 $ / mois |

| Noeuds de travail | 4 x 150 $ / mois | 4 x 200 $ / mois | 4 x 350 $ / mois |

| Total | 10 nœuds = 1500 $ / mois | 10 nœuds = 2000 $ / mois | 10 nœuds = 3500 $ / mois |

Ce tableau des prix est fourni à des fins d’illustration uniquement. Pour obtenir un numéro de planification budgétaire réel, veuillez contacter Docker, Inc. ou un revendeur agréé Docker. Trois gestionnaires et trois nœuds DTR sont requis pour les clusters HA. Bien que cela puisse sembler une surcharge, vous pouvez ajouter des centaines de nœuds de travail supplémentaires sans ajouter d’autres nœuds de gestionnaire ou DTR.

2.1.2.3 Avantages liés à l’architecture de Docker Enterprise

Docker Enterprise offre un large éventail d’avantages spécifiquement destinés aux utilisateurs Enterprise qui souhaitent opérer à grande échelle avec des niveaux de support commerciaux. Cependant, ils souhaitent également que leur personnel de développement soit en mesure d’innover rapidement et de fournir des applications sécurisées et évolutives.

2.1.2.3.1 Avantages du support Docker

L’une des principales raisons pour lesquelles les entreprises commencent à envisager Docker Enterprise est le support. Alors que l’édition communautaire de Docker fournit un support communautaire ; cela oblige les organisations à publier leurs problèmes dans des forums publics. Non seulement il n’y a aucune garantie que le problème soit résolu en temps opportun, il peut être inapproprié de publier un rapport de bogue lié à une vulnérabilité dans l’infrastructure d’une entreprise. Ceci est particulièrement sensible pour les utilisateurs d’une industrie réglementée.

La prise en charge de la pile complète de Docker commence au Docker Engine. Bien que nous nous concentrions principalement sur Docker Enterprise Standard et Advanced, il existe une offre de base qui prend en charge uniquement le moteur Docker et ne fournit pas UCP et DTR. Il s’agit également du niveau de prise en charge inclus avec Windows Server 2016. Toutes les plates-formes prises en charge par Docker permettent aux clients de recevoir des correctifs sur le même niveau de version pendant jusqu’à 2 ans. Sans support, vous êtes obligé de mettre à niveau tous les 6 mois.

Avec les éditions Docker Enterprise Standard et Advanced, la prise en charge s’étend au-delà du moteur jusqu’au plan de contrôle universel, au registre de confiance Docker et à tous les plug-ins ou conteneurs certifiés Docker utilisés par le client.

Encore une fois, comme mentionné précédemment, il existe deux niveaux de support : stratégique, qui fournit un support 24/7, et jour ouvrable, qui est disponible pendant les heures normales de bureau.

2.1.2.3.2 Avantages de l’efficacité de calcul

L’exécution d’applications avec une architecture de conteneur a démontré une réduction significative des coûts d’exploitation pour de nombreuses applications Web traditionnelles. Ces réductions de coûts ont été documentées jusqu’à 70% et sont généralement réalisées en réduisant les frais généraux associés aux machines virtuelles, ainsi qu’en créant une densité d’applications plus élevée par serveur.

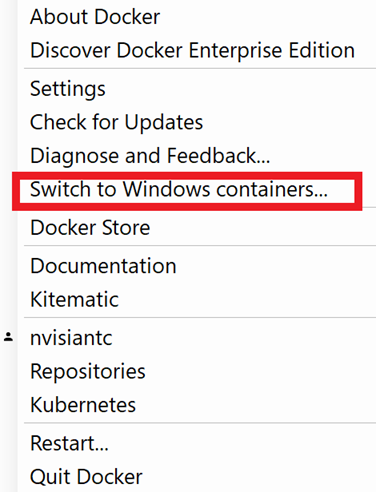

2.1.2.3.3 Avantages du choix

Docker Enterprise propose un large éventail de choix d’infrastructure pour exécuter votre plate-forme EE. Cela signifie que vous pouvez installer Docker Enterprise dans le cloud, sur site, sur une machine virtuelle ou sur du bare metal. Vous disposez également d’une grande variété de systèmes d’exploitation Linux ouverts et pris en charge commercialement pour exécuter UCP et DTR. Les nœuds de travail peuvent être installés sur Linux, Windows Server 2016 et même sur OS 390. Il est courant d’utiliser des clusters mixtes avec des nœuds Linux et Windows pour fournir une pile d’applications distribuée polyglotte de conteneurs Linux et Windows.

Ce genre de choix est vraiment important ! Il permet aux clients Docker de migrer une plate-forme de conteneurs entière d’un fournisseur d’infrastructure à un autre avec une relative facilitée. Par conséquent, si un fournisseur d’infrastructure devient trop cher, un client Docker Enterprise peut récupérer son cluster et le déplacer vers un fournisseur à moindre coût avec une relative facilité.

En plus des choix d’infrastructure, Docker propose également un choix d’orchestrateurs. Docker Enterprise inclut Swarm et Kubernetes prêts à l’emploi. Alors que certains experts natifs du cloud ne prétendent pas grand-chose à Swarm, c’est là que la plupart des entreprises, lorsqu’elles ont le choix, aiment démarrer en raison de sa sécurité et de sa simplicité. Plus tard, ils peuvent passer à des applications Kubernetes plus sophistiquées.

2.1.2.3.4 Innovation rapide – les compétences DevOps indépendantes de la plateforme bénéficient à la stratégie de décalage à gauche

Dans le monde DevOps, nous entendons beaucoup parler de décalage vers la gauche. Cela signifie prendre des responsabilités qui faisaient autrefois partie de l’organisation des opérations techniques et les déplacer dans les domaines DevOps et de développement d’applications. Dans ce monde, Docker devient un outil vraiment important pour ce type de migration car le langage utilisé pour décrire la manière dont les applications sont construites, câblées et déployées est basé sur les API Docker et Kubernetes indépendantes de la plateforme. Sans cette approche, votre personnel de développement d’applications et de DevOps aurait besoin d’apprendre des détails spécifiques à la plate-forme pour chaque environnement cible, comme AWS, Azure ou GCE. Cela crée non seulement une courbe d’apprentissage plus abrupte, mais crée également une autre couche de verrouillage dans la plate-forme d’un fournisseur.

2.1.2.3.5 Avantages UCP et DTR

Docker Enterprise standard et avancé est livré avec le plan de contrôle universel (UCP) et le Docker Trusted Registry (DTR).

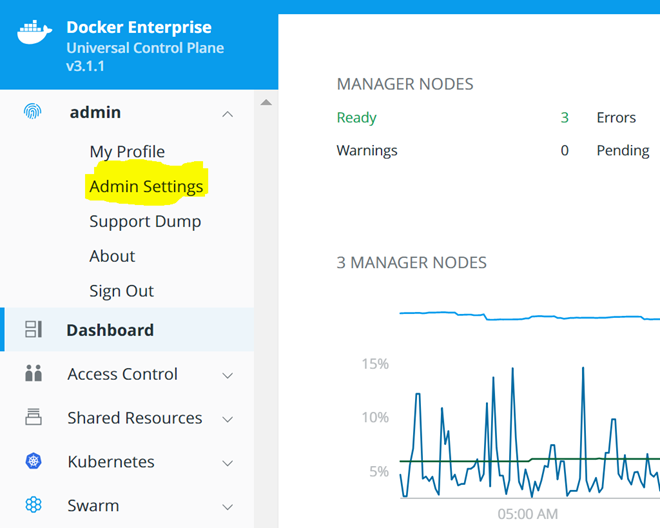

L’UCP de Docker comprend des fonctionnalités d’entreprise essentielles telles que le contrôle d’accès basé sur les rôles intégré LDAP, une interface de ligne de commande gérée par certificat, une interface graphique Web et l’orchestrateur Kubernetes installé et prêt à l’emploi. UCP fournit également une interface API sécurisée pour les scripts et l’extensibilité.

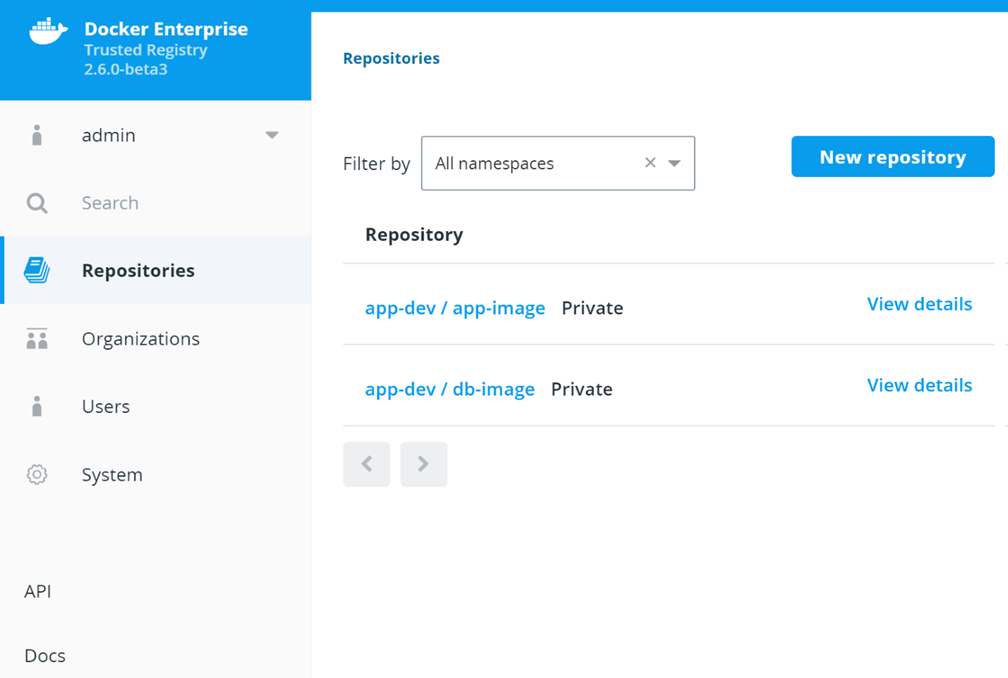

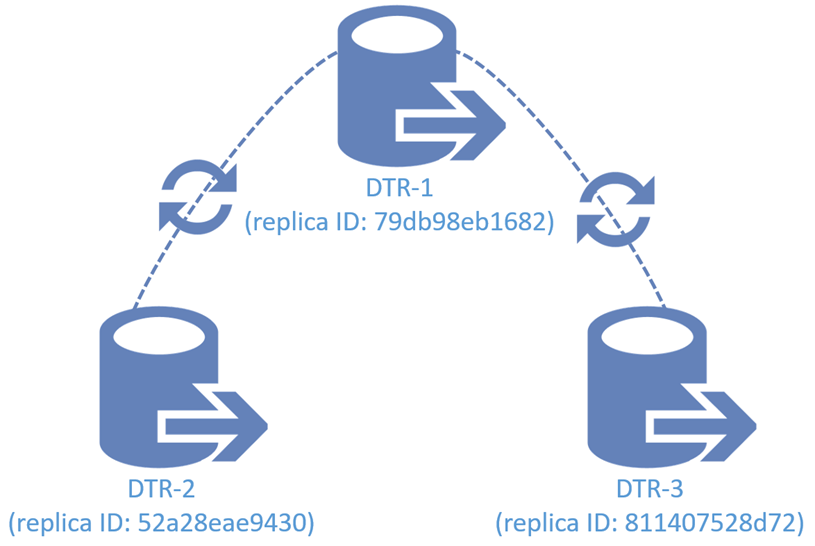

Plutôt que d’utiliser un référentiel d’images public tel que Docker Hub pour les images d’entreprise, Docker Enterprise utilise un référentiel d’images privé appelé DTR pour des raisons de sécurité et de disponibilité. Si, pour une raison quelconque, un référentiel d’images devient indisponible pour un cluster, les applications ne peuvent pas être déployées. Ainsi, DTR est une partie intégrante répliquée de la plate-forme Docker Enterprise.

Le DTR de Docker s’exécute dans le même cluster où les images du conteneur de charge de travail sont déployées. Le DTR est l’endroit où les images d’entreprise sont stockées en toute sécurité après leur construction et d’où elles sont extraites au moment du déploiement. DTR est un élément essentiel d’un cluster de conteneurs de classe entreprise et est également le cœur et l’âme d’un pipeline d’images sécurisé. À cet effet, DTR inclut la numérisation d’images (fonctionnalité Advanced Edition uniquement), la signature d’images avec l’implémentation TUF du notaire et des webhooks pour l’intégration de CI / CD et les politiques de promotion d’image, et est entièrement intégré au système UCP RBAC.

2.1.2.3.6 Avantages du conteneur d’abord

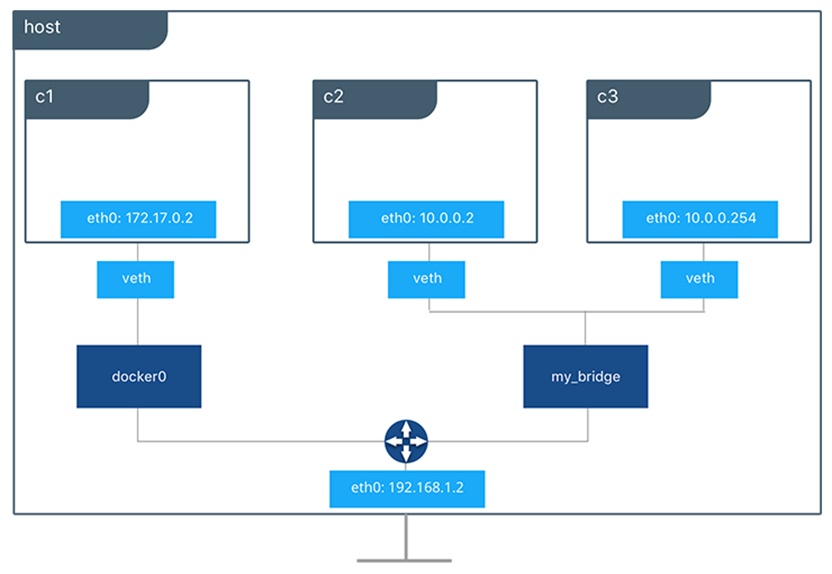

La mise en place d’une plate-forme de conteneur vous aide à commencer à réaliser les avantages du développement sans serveur. Dans une entreprise Docker Enterprise, un monde de conteneurs d’abord, les développeurs créent et testent des piles de conteneurs à l’aide des outils indépendants de la plate-forme Docker, y compris Docker Desktop et Docker Enterprise. Par la suite, leur application peut être déployée sur une plateforme Docker Desktop ou Docker Enterprise sans savoir si elle s’exécute localement sur un ordinateur de bureau, sur site ou dans le cloud. En outre, les conteneurs d’une pile d’applications peuvent communiquer librement entre eux, mais sont isolés des autres conteneurs dans différentes piles d’applications à l’aide de réseaux de superposition Swarm ou d’espaces de noms Kubernetes.

2.2 Architecture opérationnelle de Docker Enterprise

Cette section fournit une introduction aux principaux composants de Docker Enterprise, les place dans un contexte architectural orienté opérationnellement, puis décrit chaque couche dans le contexte. L’objectif est de présenter les principales parties de Docker Enterprise dans un environnement opérationnel et de décrire leur fonctionnement dans un environnement réel. En d’autres termes, décrivez les composants et la plate-forme Docker Enterprise du point de vue quotidien d’un développeur / DevOps et d’un membre de l’équipe d’exploitation.

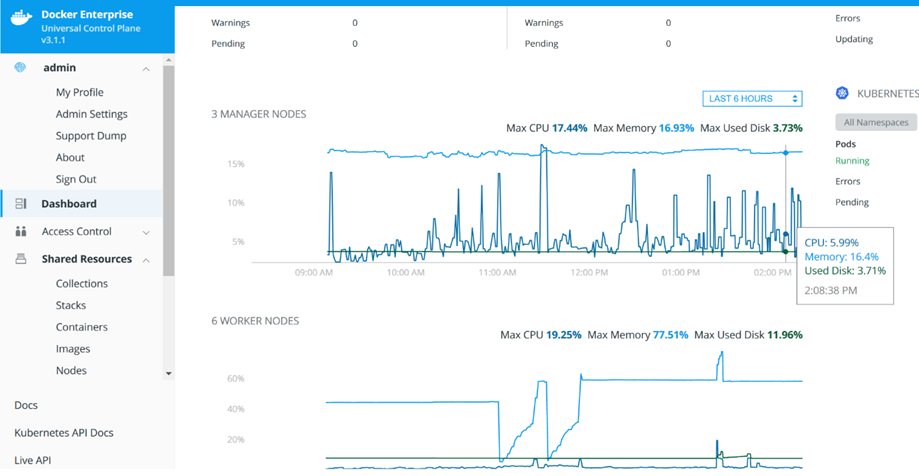

2.2.1 Principaux composants de Docker Enterprise

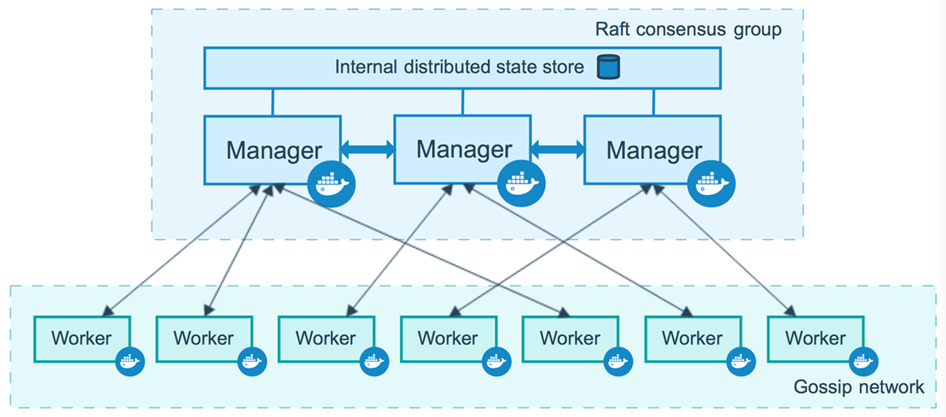

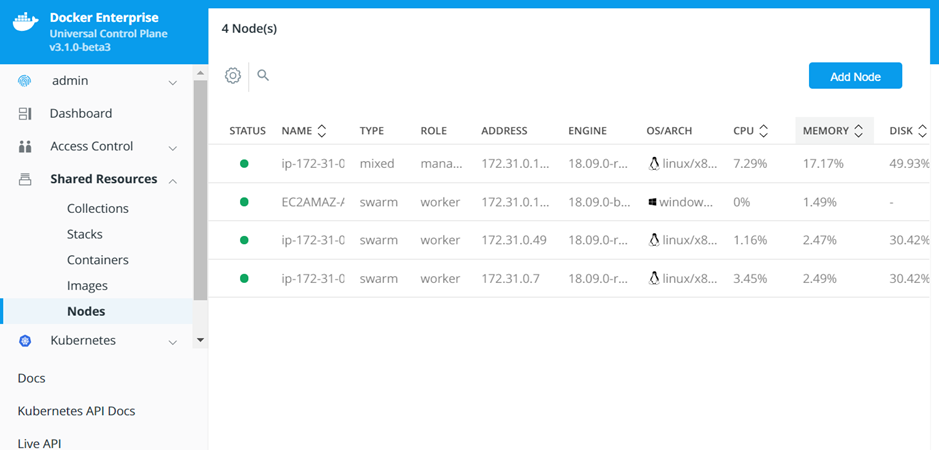

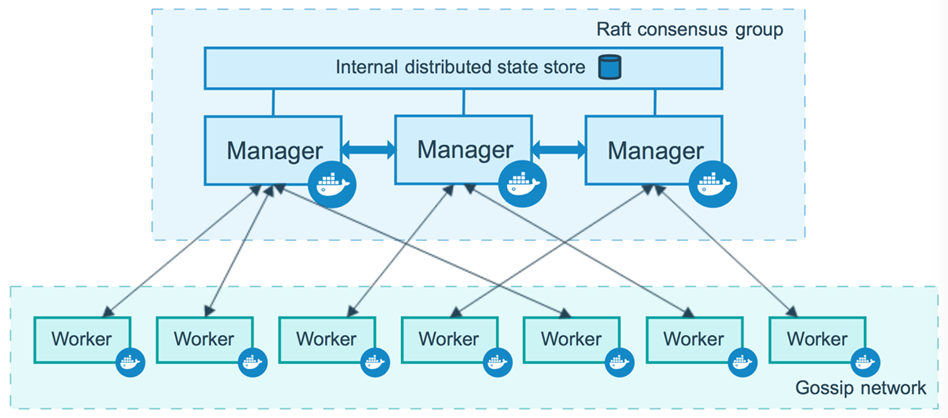

Puisque Docker Enterprise se superpose au mode Swarm de Docker Engine-Community, notre discussion commence par un aperçu des clusters Swarm. La figure 1 représente un cluster Docker Swarm à 10 nœuds. Il est composé de trois nœuds de gestionnaire et de sept nœuds de travail. Chacun des nœuds est une machine virtuelle ou un serveur nu exécutant le moteur Docker en mode Swarm.

Nos trois nœuds de gestion sont membres d’un groupe de consensus Raft soutenu par un cluster Etcd chiffré pour stocker des éléments tels que l’état du cluster, les certificats et les secrets. Pour fonctionner correctement, il doit y avoir un nombre impair de nœuds de gestionnaire dans l’état d’intégrité, car vous devez maintenir un quorum (la majorité des gestionnaires doivent se mettre d’accord sur les modifications apportées à l’état du cluster). Un cluster de nœuds de gestionnaire est efficace, mais si le gestionnaire tombe en panne, le cluster est mort. Pour une meilleure disponibilité, les clusters ont généralement trois et parfois cinq gestionnaires pour la redondance.

Comme son nom l’indique, les nœuds de travail sont l’endroit où s’exécutent les charges de travail conteneurisées. Il peut y avoir un nombre illimité de travailleurs et ces nœuds peuvent être augmentés et diminués selon les besoins :

Figure 1: cluster Swarm hautement disponible © 2013-2018 Docker, Inc. Tous droits réservés

À ce jour, la plupart des gens ont entendu l’expression animaux de compagnie contre bétail. Il semble remonter à la présentation de Bill Baker ( http://www.pass.org/eventdownload.aspx?suid=1902 ), mais s’applique également aux clusters de conteneurs. Nous parlons du bétail comme de bêtes anonymes qui vont et viennent, en grande partie sans connexion personnelle. S’il y a quelque chose qui ne va pas avec une vache, vous ne la remettez pas à la santé, mais vous en obtenez une autre pour la remplacer. D’un autre côté, les animaux domestiques sont nommés, soignés avec amour et nous les gardons le plus longtemps possible. Dans un cluster Docker Enterprise, les gestionnaires sont vos animaux de compagnie et les nœuds de travail sont vos bovins.

Docker Enterprise ajoute 3 nouvelles parties à l’image :

- Docker Enterprise Engine : une version prise en charge de la plate-forme Docker Engine-Community qui inclut une prise en charge des correctifs de 2 ans pour chaque version principale. Vous avez besoin d’une clé de la boutique Docker pour installer Docker Enterprise Engine.

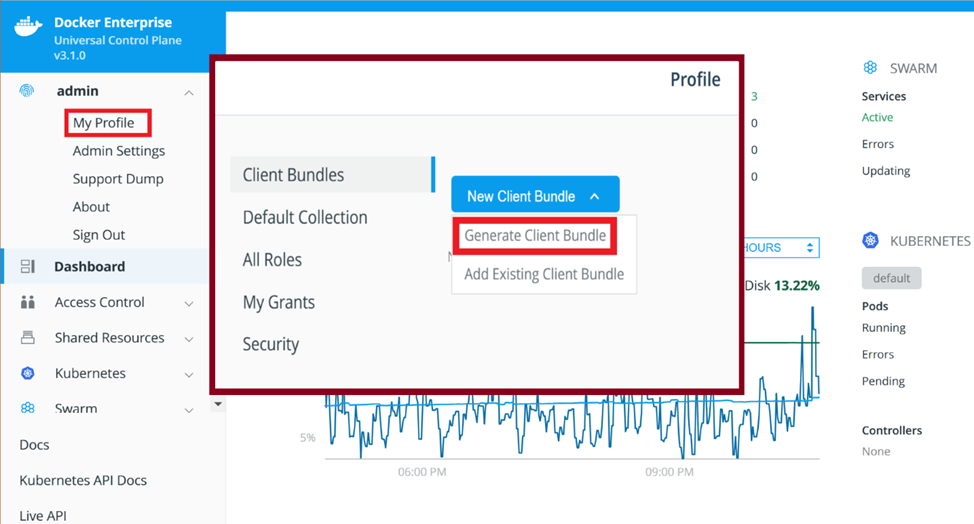

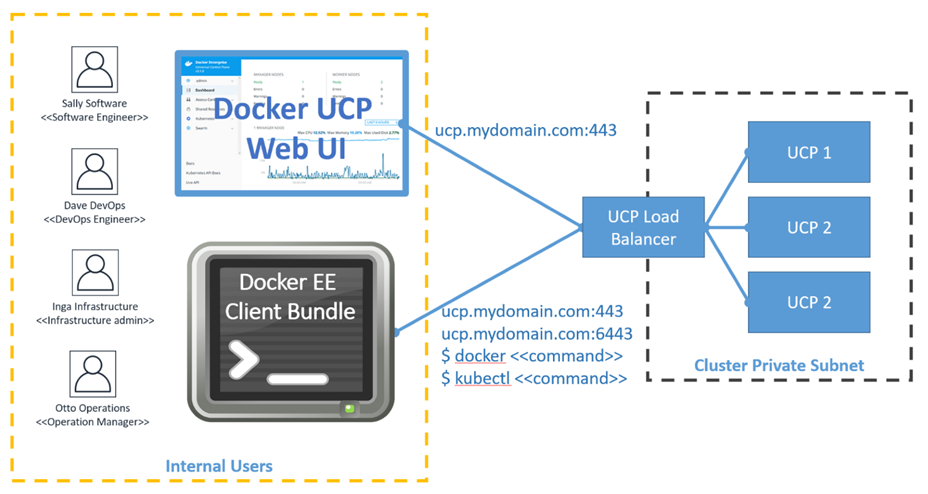

- Plan de contrôle universel (UCP) : fournit GUI, RBAC, un ensemble d’interfaces de ligne de commande basé sur certificat sécurisé, l’intégration LDAP et l’orchestration (Swarm et Kubernetes). UCP fournit un accès sécurisé à l’API via un jeton au porteur pour les scripts tels que les structures et les subventions UCP RBAC.

- Docker Trusted Registry (DTR) : un registre d’images privé intégré au cluster Docker Enterprise en tant que composant essentiel d’un pipeline logiciel sécurisé. DTR prend en charge les référentiels gérés par RBAC (liens avec l’infrastructure UCP RBAC), la signature d’images, la numérisation d’images et la promotion d’images. Toutes les fonctionnalités DTR sont disponibles via une API sécurisée utilisant un jeton d’autorisation pour gérer à la fois les images et les métadonnées du référentiel.

Maintenant, pour mieux comprendre comment les composants de Docker Enterprise s’intègrent dans un environnement réel, nous allons examiner comment les utiliser pour déployer des logiciels.

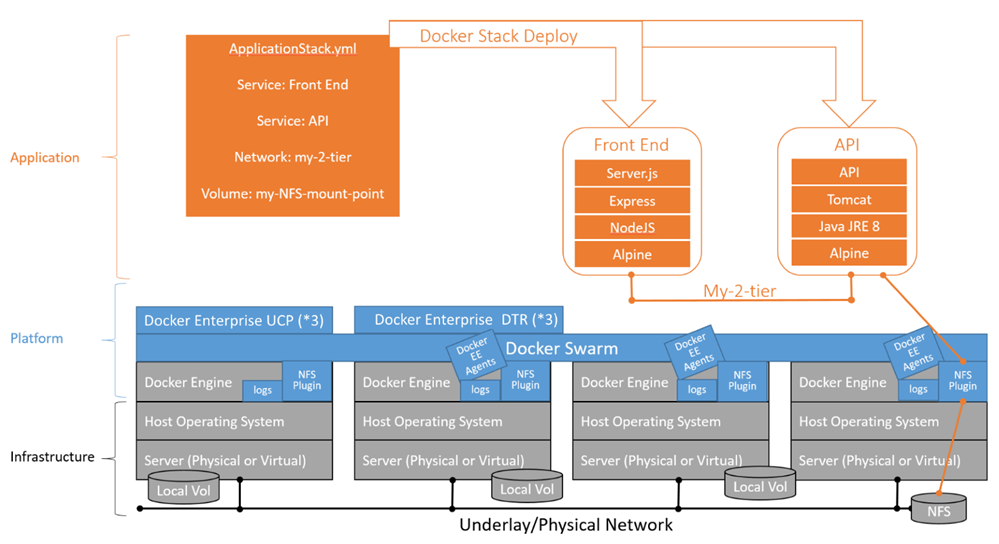

2.2.2 Architecture d’exploitation Docker Enterprise – infrastructure, plate-forme et couches d’application

L’élaboration d’une perspective architecturale orientée vers l’exploitation aide à décrire le point de vue de l’utilisateur constituant. La plate-forme Docker Enterprise atteint à la fois l’efficacité et la sécurité grâce à une séparation des préoccupations en isolant les développeurs d’applications de l’infrastructure à l’aide d’abstractions au niveau de la plate-forme telles que les services, les réseaux, les volumes, les configurations et les secrets. Pendant ce temps, la mise en œuvre réelle de ces abstractions de plate-forme et de leur infrastructure sous-jacente est gérée par un petit groupe de spécialistes des opérations hautement qualifiés. Cette approche permet aux travaux de développement d’applications, y compris les activités DevOps, de créer et de déployer des applications à l’aide d’API indépendantes de la plate-forme (Docker et Kubernetes CLI).

La séparation des plates-formes de Docker Enterprise stimule l’efficacité, la sécurité et l’innovation ! L’utilisation d’une petite équipe d’exploitation pour sauvegarder les abstractions de la plateforme Docker Enterprise avec des implémentations adaptées à l’infrastructure (meilleures pratiques sécurisées et efficaces pour les plates-formes de fournisseurs sur site ou cloud utilisant des plug-ins Docker) permet à toutes les équipes d’applications conteneurisées d’accéder à ces abstractions via un fichier de déploiement .yaml . L’équipe de développement ne se soucie pas de l’endroit où l’application est déployée tant que les abstractions sont correctement implémentées. Cela donne à l’application des outils puissants pour l’innovation de masse (le rêve de Solomon Hykes s’est réalisé), tandis qu’une petite équipe d’exploitation maintient les choses en sécurité et fonctionne sur l’infrastructure sous-jacente.

Les compétences en infrastructure pour AWS, Azure, GCE et VMware sont difficiles à trouver! La séparation des plates-formes de Docker Enterprise permet à une entreprise de tirer parti d’une équipe relativement petite d’experts en infrastructure au sein d’un grand nombre d’équipes d’applications. De plus, la séparation de plate-forme permet un décalage DevOps vers la gauche, permettant aux développeurs de décrire le déploiement de leur pile de services d’application à l’aide de constructions neutres de plate-forme.

La figure 2 décrit les couches de séparation des plates-formes en action. Tout d’abord, l’équipe des opérations installe et configure l’infrastructure à l’aide des directives d’infrastructure certifiées Docker. Cela comprend la préparation du système d’exploitation hôte, la configuration du stockage (NFS), l’installation de Docker Enterprise Engine (pilotes et plug-ins de stockage d’images), l’installation de Docker UCP et l’installation de DTR. Dans notre exemple, l’équipe Ops configure le Docker Enterprise Engine pour la journalisation centrale et installe le plug-in pour le stockage NFS.

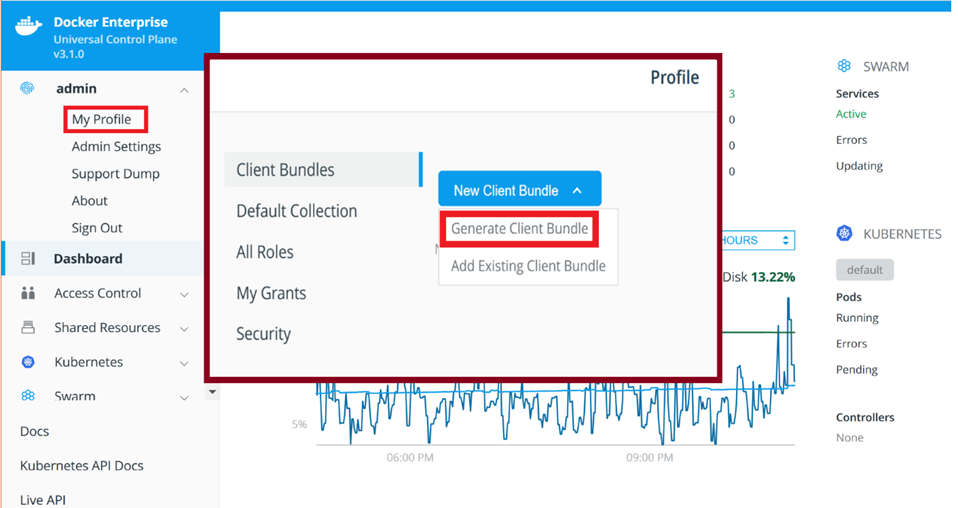

Ensuite, l’équipe de la plate-forme (qui peut être une fonction d’exploitation ou un groupe spécialisé d’opérateurs Docker Enterprise formés à la configuration, aux opérations, au support et à la maintenance de la plate-forme) configure l’accès au cluster avec RBAC afin que les utilisateurs puissent déployer leur pile à l’aide des ressources de cluster appropriées. Enfin, un développeur / membre de l’équipe DevOps utilise un bundle CLI Docker Enterprise pour déployer une pile de conteneurs dans le cluster à l’aide d’une commande de déploiement de pile docker avec le fichier ApplicationStack.yml . Les conteneurs sont planifiés sur le cluster à l’aide des abstractions de plate-forme pour les services, la mise en réseau et les volumes.

Normalement, ce processus de déploiement sur le cluster est géré par un système CI / CD tel que Jenkins, GitLab ou Azure DevOps. L’utilisateur du système CI possède son propre compte utilisateur + certificat UCP RBAC pour accéder au cluster, gérer les images DTR et signer les images qu’il a créées avant de les pousser vers DTR.

Dans ce cas, l’application est déployée sur deux nœuds de travail comme indiqué ci-dessous, connectés par le réseau My-2-tier et a accès aux données externes stockées sur un point de montage NFS. En outre, le fichier ApplicationStack.yml peut décrire la façon dont l’application est exposée en externe à l’aide du routage de couche 7 et peut rendre l’application immédiatement opérationnelle. Au final, l’application peut être entièrement déployée sans aucune intervention de l’équipe infrastructure / opérations :

Figure 2: piles de service sur l’essaim

2.2.3 Décomposition des couches

Un examen des couches à un niveau élevé, de bas en haut, révèle leur contenu ainsi que les principales préoccupations architecturales de chaque couche. Nous commencerons par la couche d’infrastructure fondamentale en examinant les fondements de Docker Enterprise. En remontant la pile jusqu’à la couche de plate-forme, nous passerons en revue les composants sous-jacents de Docker Enterprise. Enfin, nous verrons à quoi ressemble la plateforme du point de vue d’un développeur d’applications.

2.2.3.1 Couche infrastructure – réseau, nœuds et stockage

Au niveau de la couche infrastructure, l’accent est mis sur le réseau opérationnel, les nœuds de calcul et le stockage backend.

Lors de la définition de votre couche d’infrastructure, c’est une très bonne idée de consulter la documentation d’infrastructure certifiée Docker sur le site Web de Docker, https://success.docker.com/ (architecture certifiée). Des guides d’architecture de référence spécifiques sont disponibles pour VMware, AWS et Azure. Ces guides fournissent des informations clés pour la planification et la conception de la couche d’infrastructure Docker Enterprise par l’équipe des opérations.

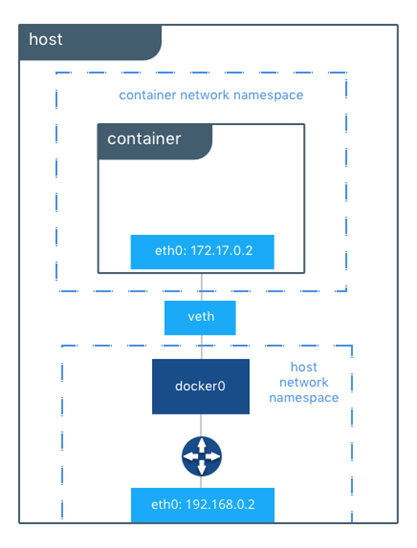

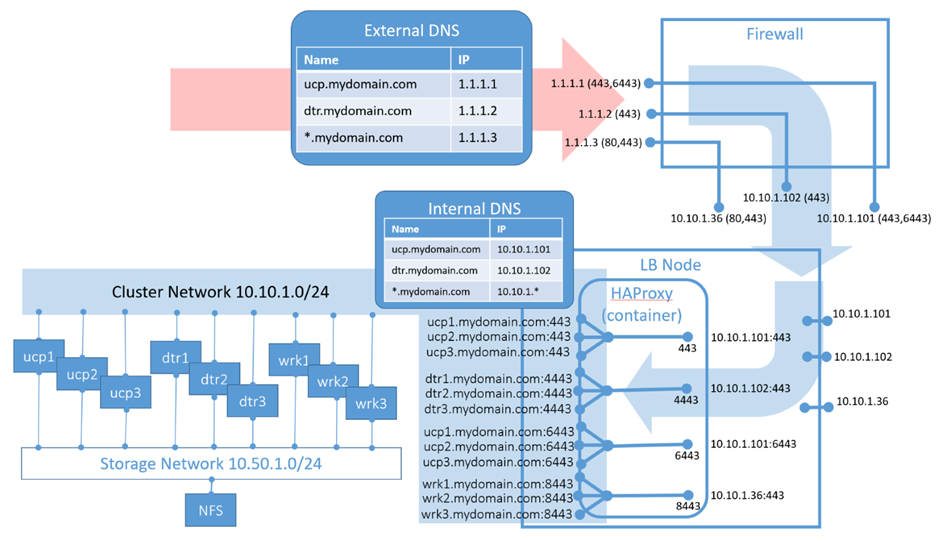

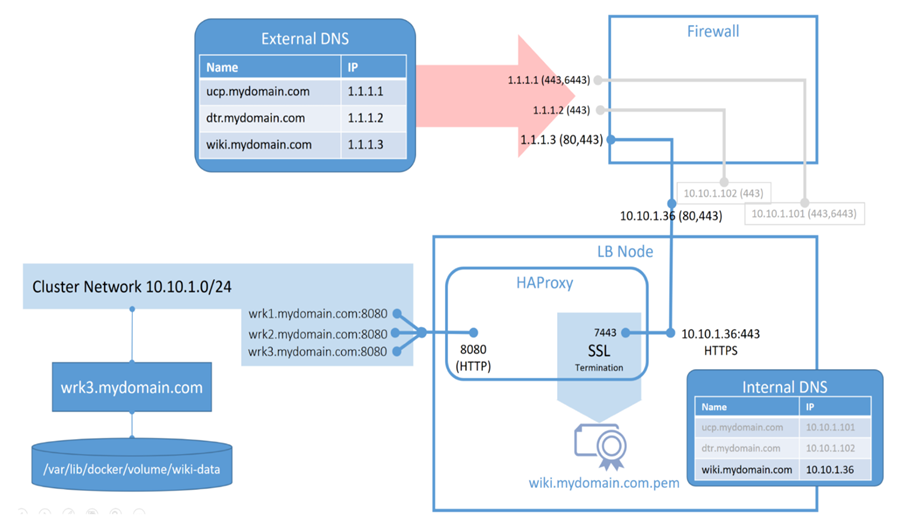

Le réseau opérationnel se préoccupe principalement de l’entrée, de la sortie et du flux de données inter-nœuds avec l’isolement et le chiffrement appropriés des nœuds de cluster Docker. La création d’espace d’adressage et la définition d’une stratégie de groupe de sécurité réseau sont généralement au centre de l’attention. Bien que cela soit généralement assez simple, l’architecture de référence Docker couvre des détails importants. Les éléments suivants sont globalement quelques considérations clés à souligner :

- Considération 1 : Bien qu’il existe une documentation contradictoire sur le sujet, c’est une bonne idée d’épingler vos nœuds de gestionnaire à des adresses IP fixes.

- Considération 2 : Assurez-vous que les espaces réseau de superposition de Docker ne chevauchent pas d’autres espaces d’adressage sur votre réseau. Il existe de nouveaux paramètres à partir de Docker 18.09 pour lancer le cluster Swarm sous-jacent de Docker Enterprise afin de créer des blocs CIDR réseau sûrs pour la mise en réseau de superposition de Docker à utiliser :

docker swarm init –default-addr-pool 10.85.0.0/16 –default-addr-pool 10.91.0.0/16 –default-addr-pool-mask-length 25

Pour une introduction complète à la mise en réseau Docker, veuillez lire l’ article https://success.docker.com/ sur la mise en réseau.

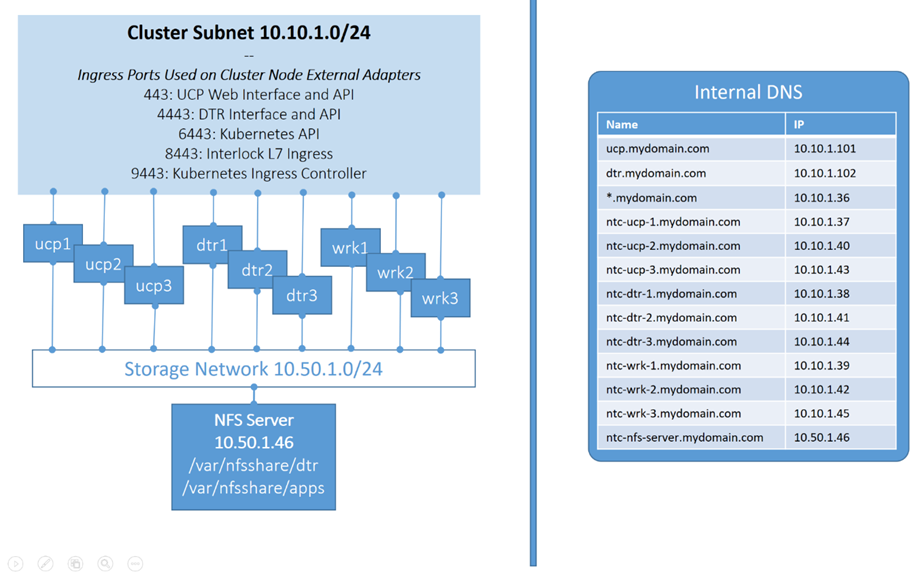

Les nœuds de calcul sont les machines virtuelles ou les nœuds bare-metal exécutant un moteur Docker Enterprise au-dessus d’un système d’exploitation pris en charge. Le moteur Docker Enterprise est actuellement pris en charge sur CentOS, Oracle Linux, Red Hat Enterprise Linux, SUSE Linux Enterprise Server, Ubuntu, Microsoft Windows Server 2016, Microsoft Windows Server 1709 et Microsoft Windows Server 1803. Les principales préoccupations pour la configuration d’un nœud de calcul sont les points de terminaison CPU, RAM, stockage local et stockage de cluster.

Bien qu’il n’y ait pas de formules magiques pour prédire des nœuds de taille parfaite, il existe des paris assez sûrs, tels qu’utilisés à des fins de planification dans la section des coûts précédente. En règle générale, il est prudent d’utiliser quatre cœurs et 16 Go de RAM pour les gestionnaires et les nœuds Docker Trusted Registry (DTR). Encore une fois, les nœuds de travail dépendent des types de charge de travail que vous exécutez sur eux. Les applications Java conteneurisées nécessitent souvent un encombrement mémoire important et peut-être un processeur quatre cœurs et 32 Go de RAM est logique. La plupart des organisations ont des statistiques sur les applications qu’elles exécutent actuellement et peuvent être utilisées à des fins d’estimation. Ne vous attardez pas trop sur le dimensionnement des travailleurs – ce sont vos bovins et en tant que tels peuvent être facilement remplacés.

Une autre considération de nœud de calcul est le stockage. Il y a trois considérations liées au stockage :

- Sauvegarde des systèmes de fichiers pour les pilotes de stockage d’images Docker : Lorsque le moteur Docker est installé (dans la couche de plate-forme), vous avez besoin d’un pilote de stockage d’images pour implémenter efficacement un système de fichiers en couches, copie sur écriture. Ces pilotes nécessitent un système de fichiers de support compatible. La plupart des systèmes Linux modernes utiliseront automatiquement le pilote de stockage Overlay2 soutenu par des systèmes de fichiers ext4. Les versions plus anciennes de CentOS et RHEL (7.3 et antérieures) utilisent généralement le pilote de stockage devicemapper soutenu par un système de fichiers direct-lvm (n’exécutez pas les charges de travail de production direct-lvm en mode boucle). Sur SUSE, utilisez le pilote btrfs et le système de fichiers.

- Stockage local pour les volumes spécifiques aux nœuds : les volumes Docker liés à des nœuds spécifiques peuvent être utiles lorsque vous avez des nœuds spécialisés dans votre cluster. Ces nœuds sont ensuite étiquetés afin que les conteneurs puissent être déployés spécifiquement sur ces nœuds. Cela garantit que tous les volumes sont toujours disponibles sur ces nœuds et est pratique pour les serveurs de construction centralisés basés sur des conteneurs pour stocker les plugins et les espaces de travail. N’oubliez pas que ces volumes doivent être ajoutés à votre liste de sauvegarde !

- Stockage basé sur un cluster : lorsque les nœuds montent des points de terminaison de stockage distant à l’aide de quelque chose comme NFS, vous pouvez ensuite autoriser les conteneurs à monter ces points de montage en tant que volumes pour accéder au stockage distant à partir d’un conteneur. Ceci est courant pour les déploiements sur site plus anciens, mais les installations sur site plus récentes peuvent envisager d’installer NFS sur l’hôte et d’utiliser le volume local opt: nfs , ou ils peuvent envisager d’utiliser un plug-in de volume tiers lié à l’infrastructure de votre fournisseur de stockage pour plus de flexibilité et de stabilité.

Veuillez noter que le stockage NFS fonctionne généralement bien pour les installations sur site où vous avez un contrôle total sur le réseau, mais dans le cloud, les montages NFS peuvent être moins fiables en raison de la latence des voisins bruyants.