0. L’orchestration avec Kubernetes

0.1 Résumé de la publication

Kubernetes est un système open source utilisé pour automatiser le déploiement, la mise à l’échelle et la gestion des applications conteneurisées. Si vous utilisez plus de conteneurs ou souhaitez une gestion automatisée de vos conteneurs, vous avez besoin de Kubernetes à votre disposition. Pour mettre les choses en perspective, Mastering Kubernetes vous guide à travers la gestion avancée des clusters Kubernetes.

Pour commencer, vous apprendrez en détail les principes fondamentaux de l’architecture Kubernetes et de la conception Kubernetes. Vous découvrirez comment exécuter des microservices complexes avec état sur Kubernetes, y compris des fonctionnalités avancées telles que la mise à l’échelle automatique des pods horizontaux, les mises à jour continues, les quotas de ressources et le backend de stockage persistant. À l’aide de cas d’utilisation réels, vous explorerez les options de configuration du réseau et comprendrez comment configurer, utiliser et dépanner divers plug-ins de réseau Kubernetes. En plus de cela, vous vous familiariserez avec le développement et l’utilisation de ressources personnalisées dans les workflows d’automatisation et de maintenance.

Pour étendre vos connaissances sur Kubernetes, vous rencontrerez des concepts supplémentaires basés sur la version Kubernetes 1.10, tels que Promethus, le contrôle d’accès basé sur les rôles, l’agrégation d’API, etc. À la fin de cet article, vous saurez tout ce dont vous avez besoin pour passer du niveau intermédiaire à avancé de la compréhension de Kubernetes.

0.2 Objectifs de la publication

- Concevez un cluster Kubernetes robuste pour un fonctionnement de longue durée

- Découvrez les avantages de l’exécution de Kubernetes sur GCE, AWS, Azure et bare metal

- Comprendre le modèle d’identité de Kubernetes, ainsi que les options de fédération de cluster

- Surveillez et dépannez les clusters Kubernetes et exécutez un Kubernetes hautement disponible

- Créez et configurez des ressources Kubernetes personnalisées et utilisez des ressources tierces dans vos workflows d’automatisation

- Profitez de l’art d’exécuter des applications complexes avec état dans votre environnement de conteneur

- Livrer des applications sous forme de packages standard

1 CHAPITRE 1 Introduction

Kubernetes est un orchestrateur open source pour le déploiement d’applications conteneurisées. Le système a été open source par Google, inspiré par une décennie d’expérience dans le déploiement de systèmes évolutifs et fiables dans des conteneurs via des API orientées application, et développé au cours des quatre dernières années par une communauté dynamique de contributeurs open source.

Il est utilisé par un nombre important et croissant de développeurs pour déployer des systèmes distribués fiables, ainsi que pour exécuter l’apprentissage automatique, le Big Data et d’autres charges de travail par lots. Un cluster Kubernetes fournit une API d’orchestration qui permet de définir et de déployer des applications avec une syntaxe déclarative simple. De plus, le cluster Kubernetes lui-même fournit de nombreux algorithmes de contrôle en ligne, auto-réparateurs, qui réparent les applications en présence de défaillances. Enfin, l’API Kubernetes expose des concepts tels que les déploiements qui facilitent l’exécution de mises à jour sans interruption de vos logiciels et des équilibreurs de charge de service qui facilitent la répartition du trafic sur un certain nombre de répliques de votre service. De plus, Kubernetes fournit des outils pour nommer et découvrir les services afin que vous puissiez créer des architectures de microservices à couplage lâche. Kubernetes est largement utilisé dans les clouds publics et privés, ainsi que dans les infrastructures physiques.

Cet article est dédié au sujet de la gestion d’un cluster Kubernetes. Vous pouvez gérer votre propre cluster sur votre propre matériel, faire partie d’une équipe gérant un cluster pour une organisation plus grande ou un utilisateur de Kubernetes qui souhaite aller au-delà des API et en savoir plus sur les composants internes du système. Peu importe où vous en êtes dans le voyage, approfondir vos connaissances sur la gestion du système peut vous rendre plus capable d’accomplir tout ce que vous devez faire avec Kubernetes.

Lorsque nous parlons d’un cluster, nous faisons référence à une collection de machines qui fonctionnent ensemble pour fournir la puissance de calcul globale que Kubernetes met à la disposition de ses utilisateurs finaux. Un cluster Kubernetes est un ensemble de machines qui sont toutes contrôlées par une seule API et peuvent être utilisées par les consommateurs de cette API.

Il existe une variété de sujets qui composent les compétences nécessaires pour gérer un cluster Kubernetes:

- Comment le cluster fonctionne

- Comment ajuster, sécuriser et régler le cluster

- Comment comprendre votre cluster et réagir en cas de problème

- Comment étendre votre cluster avec des fonctionnalités nouvelles et personnalisées

1.1 Fonctionnement du cluster

En fin de compte, si vous allez gérer un système, vous devez comprendre comment ce système fonctionne. Quelles sont les pièces qui le composent et comment s’emboîtent-elles? Sans au moins une compréhension approximative des composants et de leur interaction, il est peu probable que vous réussissiez à gérer un système. Gérer un logiciel, en particulier un logiciel aussi complexe que Kubernetes, sans cette compréhension, c’est comme tenter de réparer une voiture sans savoir comment le tuyau d’échappement est lié au moteur. C’est une mauvaise idée.

Cependant, en plus de comprendre comment toutes les pièces s’assemblent, il est également essentiel de comprendre comment l’utilisateur consomme le cluster Kubernetes. Ce n’est qu’en sachant comment un outil comme Kubernetes doit être utilisé que vous pouvez vraiment comprendre les besoins et les exigences nécessaires à sa bonne gestion. Pour revisiter notre analogie de la voiture, sans comprendre la façon dont un conducteur s’assoit dans le véhicule et le guide sur la route, il est peu probable que vous réussissiez à gérer le véhicule. Il en va de même pour un cluster Kubernetes.

Enfin, il est essentiel que vous compreniez le rôle que joue le cluster Kubernetes dans la vie quotidienne d’un utilisateur. Qu’est-ce que le cluster accomplit pour l’utilisateur final? Quelles applications y déploient-ils? Que la complexité et les difficultés est le cluster enlève? Quelle complexité ajoute l’API Kubernetes? Pour compléter l’analogie de la voiture, afin de comprendre l’importance d’une voiture pour son utilisateur final, il est essentiel de savoir que c’est la chose qui garantit qu’une personne se présente pour travailler à l’heure. De même avec Kubernetes, si vous ne comprenez pas que le cluster est l’endroit où s’exécute l’application critique d’un utilisateur et que l’API Kubernetes est ce sur quoi un développeur s’appuie pour résoudre un problème lorsqu’un problème se produit à 3 heures du matin, vous avez gagné ‘sais pas vraiment ce qui est nécessaire pour gérer avec succès ce cluster.

1.2 Ajuster, sécuriser et régler le cluster

En plus de savoir comment les éléments du cluster s’emboîtent et comment l’API Kubernetes est utilisée par les développeurs pour créer et déployer des applications, il est également essentiel de comprendre les différentes API et options de configuration pour ajuster, sécuriser et régler votre cluster. Un cluster Kubernetes – ou vraiment n’importe quel logiciel important – n’est pas quelque chose que vous montez, commencez à exécuter et quittez simplement.

Le cluster et son utilisation ont un cycle de vie. Les développeurs rejoignent et quittent les équipes. De nouvelles équipes se forment et les anciennes meurent. Le cluster évolue avec la croissance de l’entreprise. De nouvelles versions de Kubernetes sortent pour corriger des bugs, ajouter de nouvelles fonctionnalités et améliorer la stabilité. L’augmentation de la demande sur le cluster expose des problèmes de performances qui étaient auparavant ignorés. Répondre à tous ces changements dans la durée de vie de votre cluster nécessite une compréhension des façons dont Kubernetes peut être configuré via des indicateurs de ligne de commande, des options de déploiement et des configurations d’API.

De plus, votre cluster n’est pas seulement une cible pour le déploiement d’applications. Il peut également être un vecteur d’attaque de la sécurité de vos applications. La configuration de votre cluster pour qu’il soit protégé contre de nombreuses attaques différentes, des compromis entre les applications au déni de service, est un élément essentiel de la gestion réussie d’ un cluster. La plupart du temps, ce durcissement sert simplement à éviter les erreurs. Dans de nombreux cas, le renforcement et la sécurité ont pour valeur d’empêcher une équipe ou un utilisateur d’attaquer accidentellement le service d’une autre équipe. Cependant, des attaques actives se produisent parfois et la configuration du cluster est essentielle à la fois pour détecter les attaques lorsqu’elles se produisent et pour les empêcher de se produire en premier lieu.

Enfin, selon l’utilisation du cluster, vous devrez peut-être démontrer la conformité aux différentes normes de sécurité requises pour les développeurs d’applications dans de nombreux secteurs, tels que les soins de santé, la finance ou le gouvernement. Lorsque vous comprenez comment créer un cluster conforme, vous pouvez mettre Kubernetes au travail dans ces environnements.

1.3 Répondre lorsque les choses tournent mal

Si les choses ne tournaient jamais mal, ce serait un monde formidable où vivre. Malheureusement, bien sûr, ce n’est pas comme ça que ça se passe, surtout avec aucun système informatique que je n’ai jamais aidé à gérer. Ce qui est critique lorsque les choses tournent mal, c’est que vous en soyez informé rapidement, que vous le découvrez par le biais de l’automatisation et des alertes (plutôt que par un utilisateur), et que vous êtes capable de répondre et de restaurer le système le plus rapidement possible.

La première étape pour détecter le moment où les choses se cassent et pour comprendre pourquoi elles sont cassées est d’avoir les bonnes mesures en place. Heureusement, il existe deux technologies présentes dans le cluster Kubernetes qui facilitent ce travail. Le premier est que Kubernetes lui-même est généralement déployé à l’intérieur des conteneurs. En plus de la valeur d’un emballage et d’un déploiement fiables, le conteneur lui-même forme une frontière où les mesures de base telles que le processeur, la mémoire, le réseau et l’utilisation du disque peuvent être observées. Ces mesures peuvent ensuite être enregistrées dans un système de surveillance à la fois pour l’alerte et l’introspection.

En plus de ces mesures générées par conteneur, la base de code Kubernetes elle-même a été instrumentée avec un nombre important de mesures d’application. Il s’agit notamment du nombre de demandes envoyées ou reçues par divers composants, ainsi que de la latence de ces demandes. Ces métriques sont exprimées à l’aide d’un format popularisé par le projet open source Prometheus , et elles peuvent être facilement collectées et renseignées dans Prometheus, qui peuvent être utilisées directement ou avec d’autres outils, comme Grafana, pour la visualisation et l’introspection.

Combinées ensemble, les métriques de base des conteneurs du système d’exploitation, ainsi que les métriques d’application de Kubernetes lui-même, fournissent un riche ensemble de données qui peuvent être utilisées pour générer des alertes, qui vous indiquent quand le système ne fonctionne pas correctement, ainsi que les données historiques nécessaires pour déboguer et déterminer ce qui s’est mal passé et quand.

Bien sûr, comprendre le problème n’est que la première moitié de la bataille. L’étape suivante consiste à répondre et à se remettre des problèmes du système. Heureusement, Kubernetes a été construit de manière découplée et modulaire, avec un état minimal dans le système. Cela signifie que, généralement, à tout moment, il est sûr de redémarrer tout composant du système qui peut être surchargé ou mal se comporter. Cette modularité et cette idempotence signifient que, une fois que vous avez déterminé le problème, le développement d’une solution est souvent aussi simple que le redémarrage de quelques applications.

Bien sûr, dans certains cas, quelque chose de vraiment terrible se produit et votre seul recours est de restaurer le cluster à partir d’une sauvegarde de récupération après sinistre quelque part. Cela suppose que vous avez activé ces sauvegardes en premier lieu. En plus de toute la surveillance pour vous montrer ce qui se passe, les alertes pour vous informer quand quelque chose se casse, et les playbooks pour vous dire comment le réparer, la gestion réussie d’un cluster nécessite que vous développiez et appliquiez une procédure de réponse et de récupération en cas de catastrophe . Il est important de se rappeler que l’élaboration de ce plan est insuffisante. Vous devez le pratiquer régulièrement, sinon vous ne serez pas prêt (et le plan lui-même peut être défectueux) en présence d’un vrai problème.

1.4 Extension du système avec des fonctionnalités nouvelles et personnalisées

L’une des forces les plus importantes du projet open source Kubernetes a été la croissance explosive des bibliothèques, des outils et des plates-formes qui s’appuient sur, étendent ou améliorent autrement l’utilisation d’un cluster Kubernetes.

Il existe des outils comme Spinnaker ou Jenkins pour un déploiement continu, et des outils comme Helm qui facilitent le conditionnement et le déploiement d’applications complètes. Des plates-formes comme Deis fournissent des flux de travail de développement de style push Git et de nombreuses fonctions en tant que service ( FaaS ) construites au-dessus de Kubernetes pour permettre aux utilisateurs de le consommer via des fonctions simples. Il existe même des outils pour automatiser la création et la rotation des certificats, en plus des technologies de maillage de service qui facilitent la liaison et l’introspection d’une myriade de microservices.

Tous ces outils de l’écosystème peuvent être utilisés pour améliorer, étendre et améliorer le cluster Kubernetes que vous gérez. Ils peuvent fournir de nouvelles fonctionnalités pour faciliter la vie de vos utilisateurs et rendre les logiciels qu’ils déploient plus robustes et plus faciles à gérer.

Cependant, ces outils peuvent également rendre votre cluster plus instable, moins sécurisé et plus sujet aux pannes. Ils peuvent exposer vos utilisateurs à des logiciels immatures et mal pris en charge qui ressemblent à une partie « officielle » du cluster, mais servent en fait à rendre la vie des utilisateurs plus difficile.

Une partie de la gestion d’un cluster Kubernetes consiste à savoir comment et quand ajouter ces outils, plates-formes et projets au cluster. Cela nécessite une exploration et une compréhension non seulement de ce qu’un projet particulier tente d’accomplir, mais aussi des autres solutions qui existent dans l’écosystème. Souvent, les utilisateurs viendront à vous avec une demande pour un outil particulier basé sur une vidéo ou un blog sur lequel ils se sont produits. En vérité, ils demandent souvent une capacité comme l’intégration continue et la livraison continue (CI / CD) ou la rotation des certificats.

C’est votre travail en tant que gestionnaire de cluster d’agir en tant que conservateur de ces projets. Vous êtes également un éditeur et un conseiller qui peut recommander des solutions alternatives ou déterminer si un projet particulier convient à votre cluster ou s’il existe un meilleur moyen d’atteindre le même objectif pour l’utilisateur final.

De plus, l’API Kubernetes elle-même contient des outils riches pour étendre et améliorer l’API. Un cluster Kubernetes ne se limite pas uniquement aux API qui y sont intégrées. Au lieu de cela, de nouvelles API peuvent être ajoutées et supprimées dynamiquement. Outre les extensions existantes qui viennent d’être mentionnées, le travail de gestion d’un cluster Kubernetes implique parfois de développer un nouveau code et de nouvelles extensions qui améliorent votre cluster d’une manière qui était auparavant impossible. Une partie de la gestion d’un cluster peut très bien être le développement de nouveaux outils. Bien sûr, une fois développé, partager cet outillage avec l’écosystème Kubernetes en pleine croissance est un excellent moyen de redonner à la communauté qui vous a apporté le logiciel Kubernetes en premier lieu.

1.5 Résumé

La gestion d’un cluster Kubernetes est plus que le simple fait d’installer un logiciel sur un ensemble de machines. Une gestion réussie nécessite une solide compréhension de la façon dont Kubernetes est assemblé et comment il est mis à profit par les développeurs qui sont des utilisateurs de Kubernetes. Cela nécessite que vous compreniez comment maintenir, ajuster et améliorer le cluster au fil du temps à mesure que ses modèles d’utilisation changent. De plus, vous devez savoir comment surveiller les informations rejetées par le cluster en fonctionnement et comment développer les alertes et les tableaux de bord pour vous dire quand le cluster est malade et comment le remettre en état. Enfin, vous devez comprendre quand et comment étendre le cluster Kubernetes avec d’autres outils pour le rendre encore plus utile pour vos utilisateurs. Nous espérons que dans cet article, vous trouverez des réponses et plus pour tous ces sujets et que, à la fin, vous vous retrouverez avec les compétences nécessaires pour réussir à gérer Kubernetes .

2 CHAPITRE 2 Présentation de Kubernetes

La création, le déploiement et la gestion d’applications par-dessus l’API Kubernetes est un sujet complexe à part entière. Il est hors de la portée de cet article de donner une compréhension complète de l’API Kubernetes dans tous ses détails.

En revanche, si vous êtes responsable de la gestion d’un cluster Kubernetes ou si vous avez une compréhension de haut niveau de l’API Kubernetes, ce chapitre fournit une introduction aux concepts de base de Kubernetes et à leur rôle dans le développement d’une application. Si après avoir lu ce chapitre, vous vous sentez toujours mal à l’aise d’avoir une conversation avec vos utilisateurs sur leur utilisation de Kubernetes, nous vous recommandons fortement de vous prévaloir de ces ressources supplémentaires.

Dans ce chapitre, nous introduisons d’abord la notion de conteneurs et comment ils peuvent être utilisés pour empaqueter et déployer votre application. Ensuite, nous présentons les concepts de base derrière l’API Kubernetes, et enfin, nous concluons avec quelques concepts de niveau supérieur que Kubernetes a ajoutés pour faciliter des tâches spécifiques.

2.1 Conteneurs

Docker a popularisé les conteneurs et a permis une révolution dans la manière dont les développeurs conditionnent et déploient leurs applications. Cependant, en cours de route, le mot même conteneur a pris de nombreuses significations différentes pour de nombreuses personnes différentes. Parce que Kubernetes est un orchestrateur de conteneurs pour comprendre Kubernetes, il est important de comprendre ce que nous voulons dire lorsque nous disons conteneur.

En réalité, un conteneur est composé de deux pièces différentes et d’un groupe de fonctionnalités associées. Un conteneur comprend :

- Une image de conteneur

- Un ensemble de concepts de système d’exploitation qui isole un ou plusieurs processus en cours d’exécution

L’image du conteneur contient le runtime d’application, qui se compose de fichiers binaires, de bibliothèques et d’autres données nécessaires pour exécuter le conteneur. Le développeur peut empaqueter son application en tant qu’image de conteneur sur son ordinateur portable de développement et être convaincu que lorsque cette image est déployée et exécutée dans un paramètre différent – que ce soit l’ordinateur portable d’un autre utilisateur ou un serveur dans un centre de données – le conteneur se comportera exactement comme il l’a fait sur l’ordinateur portable du développeur. Cette portabilité et cette exécution cohérente dans une variété d’environnements sont parmi les valeurs principales des images de conteneurs.

Lorsqu’une image de conteneur est exécutée, elle est également exécutée à l’aide d’espaces de noms dans le système d’exploitation. Ces espaces de noms contiennent le processus et l’isolent, ainsi que ses pairs, des autres éléments exécutés sur la machine. Cette isolation signifie, par exemple, que chaque conteneur en cours d’exécution a son propre système de fichiers séparé (comme un chroot). De plus, chaque conteneur possède son propre réseau et ses propres espaces de noms PID, ce qui signifie que le processus numéro 42 dans un conteneur est un processus différent du numéro 42 dans un autre conteneur. Il existe de nombreux autres espaces de noms dans le noyau qui séparent les différents conteneurs en cours d’exécution les uns des autres. De plus, les groupes de contrôle ( cgroups ) permettent d’isoler l’utilisation des ressources, comme la mémoire ou le processeur. Enfin, les fonctionnalités de sécurité standard du système d’exploitation, comme SELinux ou AppArmor , peuvent également être utilisées avec des conteneurs en cours d’exécution. Combiné, tout cet isolement rend plus difficile l’interférence des différents processus s’exécutant dans des conteneurs séparés.

Lorsque nous parlons d’isolement, il est extrêmement important de savoir qu’il s’agit de ressources, comme le processeur, la mémoire ou les fichiers. Les conteneurs tels qu’implémentés sous Linux et Windows ne fournissent pas actuellement une forte isolation de sécurité pour différents processus. Les conteneurs lorsqu’ils sont combinés avec d’autres isolations au niveau du noyau peuvent fournir une isolation de sécurité raisonnable pour certains cas d’utilisation. Cependant, dans le cas général, seule la sécurité au niveau de l’hyperviseur est suffisamment forte pour isoler des charges de travail vraiment hostiles.

Afin de faire tout cela, un certain nombre d’outils différents ont été créés pour aider à créer et à déployer des applications conteneurisées.

Le premier est le générateur d’image de conteneur. En règle générale, l’outil de ligne de commande docker est utilisé pour créer une image de conteneur. Cependant, le format d’image a été normalisé par la norme Open Container Initiative (OCI). Cela a permis le développement d’autres constructeurs d’images, disponibles via l’API cloud, CI / CD ou de nouveaux outils et bibliothèques alternatifs.

L’outil Docker utilise un Dockerfile , qui spécifie un ensemble d’instructions sur la façon de construire l’image conteneur. Tous les détails sur l’utilisation de l’outil Docker dépassent le cadre de cet article, mais de nombreuses ressources sont disponibles dans d’autres articles du site ou dans des ressources en ligne. Si vous n’avez jamais construit d’image de conteneur auparavant, posez cet article dès maintenant, allez lire sur les conteneurs et revenez lorsque vous aurez construit quelques images de conteneur.

Une fois qu’une image de conteneur a été créée, nous avons besoin d’un moyen de distribuer cette image depuis l’ordinateur portable d’un utilisateur vers d’autres utilisateurs, le cloud ou un centre de données privé. C’est là que le registre d’images entre en jeu. Le registre d’images est une API pour télécharger et gérer des images. Une fois qu’une image a été créée, elle est envoyée au registre d’images. Une fois que l’image est dans le registre, elle peut être extraite ou téléchargée depuis ce registre vers n’importe quelle machine ayant accès au registre. Chaque registre nécessite une certaine forme d’autorisation pour pousser une image, mais certains registres sont publics , ce qui signifie qu’une fois qu’une image est poussée, n’importe qui dans le monde peut tirer et commencer à exécuter l’image. D’autres sont privés et nécessitent également une autorisation pour extraire une image. À ce stade, il existe des registres en tant que service disponibles à partir de chaque cloud public, et il existe des serveurs de registre open source, que vous pouvez télécharger et exécuter dans votre propre environnement. Avant même de commencer à configurer votre cluster Kubernetes, c’est une bonne idée de savoir où vous allez stocker les images que vous y exécutez.

Une fois que vous avez empaqueté votre application en tant qu’image de conteneur et que vous l’avez poussée dans un registre, il est temps d’utiliser ce conteneur pour déployer l’application, et c’est là que l’orchestration de conteneurs entre en jeu.

2.2 Orchestration des conteneurs

Une fois que vous avez une image de conteneur stockée dans un registre quelque part, vous devez l’exécuter pour créer une application qui fonctionne. C’est là qu’un orchestrateur de conteneurs comme Kubernetes entre en scène. Le travail de Kuberentes consiste à prendre un groupe de machines qui fournissent des ressources, comme le processeur, la mémoire et le disque, et à les transformer en une API orientée conteneur que les développeurs peuvent utiliser pour déployer leurs conteneurs.

L’API Kubernetes vous permet de déclarer l’état souhaité du monde, par exemple : « Je veux que cette image de conteneur s’exécute, et elle a besoin de 3 cœurs et de 10 gigaoctets de mémoire pour fonctionner correctement. » Le système Kubernetes passe ensuite en revue son parc de machines, trouve un bon emplacement pour l’exécution de cette image de conteneur et planifie l’exécution de ce conteneur sur cette machine. Les développeurs voient leur image de conteneur s’exécuter et, le plus souvent, ils n’ont pas besoin de se préoccuper de l’emplacement spécifique où s’exécute leur conteneur.

Bien sûr, exécuter un seul conteneur n’est ni intéressant ni fiable, donc l’API Kubernetes fournit également des moyens simples de dire : « Je veux que trois copies de cette image de conteneur s’exécutent sur différentes machines, chacune avec 3 cœurs et 10 gigaoctets de mémoire. ”

Mais le système d’orchestration ne se limite pas à la planification de conteneurs sur des machines. En plus de cela, l’orchestrateur Kubernetes sait comment réparer ces conteneurs en cas d’échec. Si le processus à l’intérieur de votre conteneur se bloque, Kubernetes le redémarre. Si vous définissez des contrôles d’intégrité personnalisés, Kubernetes peut les utiliser pour déterminer si votre application est bloquée et doit être redémarrée (contrôles de vivacité) ou si elle doit faire partie d’un service à charge équilibrée (contrôles de préparation).

En parlant d’équilibrage de charge, Kubernetes fournit également des objets API pour définir un moyen d’équilibrer la charge du trafic entre ces différentes répliques. Il permet de dire : « Veuillez créer cet équilibreur de charge pour représenter ces conteneurs en cours d’exécution. » Ces équilibreurs de charge reçoivent également des noms faciles à découvrir afin de lier facilement différents services au sein d’un cluster.

Kubernetes possède également des objets qui effectuent des déploiements sans interruption de service et qui gèrent les configurations, les volumes persistants, les secrets et bien plus encore. Les sections suivantes détaillent les objets spécifiques de l’API Kubernetes qui rendent tout cela possible.

2.3 L’API Kubernetes

L’API Kubernetes est une API RESTful basée sur HTTP et JSON et fournie par un serveur d’API . Tous les composants de Kubernetes communiquent via l’API. Cette architecture est traitée plus en détail au chapitre 3. En tant que projet open source, l’API Kubernetes est en constante évolution, mais les objets principaux sont stables depuis des années et la communauté Kubernetes fournit une politique de dépréciation solide qui garantit que les développeurs et les opérateurs ne Je ne dois pas changer ce qu’ils font à chaque révision du système. Kubernetes fournit une spécification OpenAPI pour l’API, ainsi que de nombreuses bibliothèques clientes dans une variété de langues.

2.3.1 Objets de base: pods, jeux de réplicas et services

Bien qu’il ait un nombre important et croissant d’objets dans son API, Kubernetes a commencé avec un nombre relativement petit d’objets, et ceux-ci sont toujours au cœur de ce que fait Kubernetes.

2.3.1.1 Pods

Un pod est l’unité atomique de planification dans un cluster Kubernetes. Un pod est composé d’une collection d’un ou plusieurs conteneurs en cours d’exécution. (Un Pod est une collection de baleines, dérivée du logo de la baleine de Docker.) Lorsque nous disons qu’un Pod est atomique, ce que nous voulons dire, c’est que tous les conteneurs d’un Pod sont garantis pour atterrir sur la même machine dans le cluster. Les pods partagent également de nombreuses ressources entre les conteneurs. Par exemple, ils partagent tous le même espace de noms de réseau, ce qui signifie que chaque conteneur d’un pod peut voir les autres conteneurs du pod sur localhost. Les pods partagent également les espaces de noms de communication de processus et interprocessus afin que différents conteneurs puissent utiliser des outils, tels que la mémoire partagée et la signalisation, pour coordonner les différents processus du pod.

Ce regroupement étroit signifie que les pods sont parfaitement adaptés aux relations symbiotiques entre leurs conteneurs, comme un conteneur de service principal et un conteneur de chargement de données en arrière-plan. La séparation des images de conteneur rend généralement plus agile la possibilité pour différentes équipes de posséder ou de réutiliser les images de conteneur, mais en les regroupant dans un pod au moment de l’exécution, elles peuvent fonctionner en coopération.

Lorsque les gens rencontrent des Pods pour la première fois dans Kubernetes, ils émettent parfois de fausses hypothèses. Par exemple, un utilisateur peut voir un pod et penser : « Ah oui, un frontend et un serveur de base de données constituent un pod ». Mais ce n’est généralement pas le bon niveau de granularité. Pour voir pourquoi, considérez que le pod est également l’unité de mise à l’échelle et de réplication, ce qui signifie que, si vous regroupez votre frontend et votre base de données dans le même conteneur, vous répliquerez votre base de données au même rythme que vous répliquez vos frontends. Il est peu probable que vous souhaitiez procéder de cette manière.

Les pods permettent également de faire fonctionner votre application. Si le processus d’un conteneur se bloque, Kubernetes le redémarre automatiquement. Les pods peuvent également définir des contrôles d’intégrité au niveau de l’application qui peuvent fournir un moyen plus riche et spécifique à l’application de déterminer si le pod doit être redémarré automatiquement.

2.3.1.2 ReplicaSets

Bien sûr, si vous déployez un orchestrateur de conteneurs uniquement pour exécuter des conteneurs individuels, vous compliquez probablement trop votre vie. En général, l’une des principales raisons de l’orchestration de conteneurs est de faciliter la création de systèmes répliqués et fiables. Bien que des conteneurs individuels puissent échouer ou être incapables de répondre à la charge d’un système, la réplication d’une application sur un certain nombre de conteneurs en cours d’exécution réduit considérablement la probabilité que votre service échoue complètement à un moment donné. De plus, la mise à l’échelle horizontale vous permet de développer votre application en réponse à la charge. Dans l’API Kubernetes, ce type de réplication sans état est géré par un objet ReplicaSet . Un ReplicaSet garantit que, pour une définition de pod donnée, un certain nombre de réplicas existent dans le système. La réplication réelle est gérée par le gestionnaire de contrôleur Kubernetes, qui crée des objets Pod planifiés par le planificateur Kubernetes. Ces détails de l’architecture sont décrits dans les chapitres suivants.

ReplicaSet est un objet plus récent. Dans sa version v1, Kubernetes avait un objet API appelé ReplicationController . En raison de la politique de dépréciation, les ReplicationControllers continuent d’exister dans l’API Kubernetes, mais leur utilisation est fortement déconseillée en faveur des ReplicaSets .

2.3.1.3 Services

Une fois que vous pouvez répliquer votre application à l’aide d’un jeu de réplicas, le prochain objectif logique est de créer un équilibreur de charge pour répartir le trafic vers ces différentes répliques. Pour ce faire, Kubernetes dispose d’un objet Service. Un service représente un service à charge équilibrée TCP ou UDP . Chaque service créé, qu’il soit TCP ou UDP, obtient trois choses :

- Sa propre adresse IP

- Une entrée DNS dans le DNS du cluster Kubernetes

- Règles d’équilibrage de charge qui procurent du trafic proxy aux pods qui implémentent le service

Lorsqu’un service est créé, une adresse IP fixe lui est attribuée. Cette adresse IP est virtuelle – elle ne correspond à aucune interface présente sur le réseau. Au lieu de cela, il est programmé dans la structure réseau en tant qu’adresse IP à charge équilibrée. Lorsque les paquets sont envoyés à cette adresse IP, ils sont équilibrés en charge vers un ensemble de pods qui implémentent le service. L’équilibrage de charge effectué peut être à tour de rôle ou déterministe, en fonction des tuples d’adresse IP source et de destination.

Compte tenu de cette adresse IP fixe, un nom DNS est programmé dans le serveur DNS du cluster Kubernetes. Cette adresse DNS fournit un nom sémantique (par exemple, «frontend»), qui est le même que le nom de l’objet Service Kubernetes et qui permet à d’autres conteneurs du cluster de découvrir l’adresse IP de l’équilibreur de charge de service. Enfin, l’équilibrage de charge du service est programmé dans la structure réseau du cluster Kubernetes afin que tout conteneur qui essaie de communiquer avec l’adresse IP du service soit correctement équilibré en charge vers les pods correspondants. Cette programmation de la structure réseau est dynamique, de sorte que les pods vont et viennent en raison de défaillances ou de la mise à l’échelle d’un ReplicaSet , l’équilibreur de charge est constamment reprogrammé pour correspondre à l’état actuel du cluster. Cela signifie que les clients peuvent s’appuyer sur les connexions à l’adresse IP du service pour toujours résoudre un pod qui implémente le service.

2.3.1.4 Stockage : volumes persistants, ConfigMaps et secrets

Une question courante qui se pose après une première exploration de Kubernetes est : « Qu’en est-il de mes fichiers ? » Avec tous ces conteneurs qui vont et viennent dans le cluster et atterrissent sur différentes machines, il est difficile de comprendre comment vous devez gérer les fichiers et le stockage que vous souhaitez associer à vos conteneurs. Heureusement, Kubernetes fournit plusieurs objets API différents pour vous aider à gérer vos fichiers.

Le premier concept de stockage introduit dans Kubernetes était Volume, qui fait en fait partie de l’API Pod. Dans un pod, vous pouvez définir un ensemble de volumes. Chaque volume peut être l’un d’un grand nombre de types différents. À l’heure actuelle, il existe plus de 10 types de volumes différents que vous pouvez créer, notamment NFS, iSCSI, gitRepo , des volumes basés sur le stockage dans le cloud, etc.

Bien que l’interface Volume était initialement un point d’extensibilité via l’écriture de code dans Kubernetes, l’explosion de différents types de volume a finalement montré à quel point ce modèle n’était pas durable. Désormais, de nouveaux types de volume sont développés en dehors du code Kubernetes et utilisent la Container Storage Interface (CSI), une interface de stockage indépendante de Kubernetes.

Lorsque vous ajoutez un volume à votre pod, vous pouvez choisir de le monter à un emplacement arbitraire dans chaque conteneur en cours d’exécution. Cela permet à votre conteneur en cours d’exécution d’avoir accès au stockage dans le volume. Différents conteneurs peuvent monter ces volumes à différents endroits ou ignorer complètement le volume.

En plus des fichiers de base, il existe plusieurs types d’objets Kubernetes qui peuvent eux-mêmes être montés dans votre Pod en tant que volume. Le premier d’entre eux est l’ objet ConfigMap . Un ConfigMap représente une collection de fichiers de configuration. Dans Kubernetes, vous souhaitez avoir différentes configurations pour la même image de conteneur. Lorsque vous ajoutez un volume basé sur ConfigMap à votre pod, les fichiers dans ConfigMap s’affichent dans le répertoire spécifié dans votre conteneur en cours d’exécution.

Kubernetes utilise le type de configuration Secret pour les données sécurisées, telles que les mots de passe de base de données et les certificats. Dans le contexte de Volumes, un Secret fonctionne de manière identique à un Con figMap . Il peut être attaché à un pod via un volume et monté dans un conteneur en cours d’exécution pour utilisation.

Au fil du temps, le déploiement d’applications avec Volumes a révélé que la liaison étroite des Volumes aux Pods était en fait problématique. Par exemple, lors de la création d’un conteneur répliqué (via un ReplicaSet ), le même volume exact doit être utilisé par toutes les répliques. Dans de nombreuses situations, cela est acceptable, mais dans certains cas, vous souhaitez migrer un volume différent pour chaque réplique. De plus, la spécification d’un type de volume précis (par exemple, un volume persistant sur le disque Azure) lie votre définition de pod à un environnement spécifique (dans ce cas, le cloud Microsoft Azure), mais il est souvent souhaitable d’avoir une définition de pod qui demande un générique type de stockage (par exemple, 10 gigaoctets de stockage réseau) sans spécifier de fournisseur. Pour ce faire, Kubernetes a introduit la notion de Persis tentVolumes et PersistentVolumeClaims . Au lieu de lier un volume directement dans un pod, un volume persistant est créé en tant qu’objet séparé. Cet objet est ensuite revendiqué à un pod spécifique par un PersistentVolumeClaim et finalement monté dans le pod via cette revendication. Au début, cela semble trop compliqué, mais l’abstraction de Volume et Pod permet à la fois la portabilité et la création automatique de volume requises par les deux cas d’utilisation précédents.

2.3.2 Organisation de votre cluster avec des espaces de noms, des étiquettes et des annotations

L’API Kubernetes facilite la création d’un grand nombre d’objets dans le système, mais une telle collection d’objets peut facilement faire de l’administration d’un cluster un cauchemar. Heureusement, Kubernetes possède également de nombreux objets qui facilitent la gestion, l’interrogation et le raisonnement sur les objets de votre cluster.

2.3.2.1 Espaces de noms

Le premier objet pour organiser votre cluster est l’espace de noms. Vous pouvez considérer un espace de noms comme quelque chose comme un dossier pour vos objets API Kubernetes. Les espaces de noms fournissent des répertoires pour contenir la plupart des autres objets du cluster. Les espaces de noms peuvent également fournir une portée pour les règles de contrôle d’accès basé sur les rôles (RBAC). Comme un dossier, lorsque vous supprimez un espace de noms, tous les objets qu’il contient sont également détruits, alors faites attention ! Chaque cluster Kubernetes possède un seul espace de noms intégré nommé par défaut, et la plupart des installations de Kubernetes incluent également un espace de noms nommé kube -system, où les conteneurs d’administration de cluster sont créés.

Les objets Kubernetes sont divisés en objets avec espace de nom et sans espace de nom, selon qu’ils peuvent être placés dans un espace de nom. Les objets API Kubernetes les plus courants sont des objets à espace de noms. Mais certains objets qui s’appliquent à un cluster entier (par exemple, les objets d’espace de nom eux-mêmes ou le RBAC au niveau du cluster), ne sont pas à espace de noms.

Outre l’organisation des objets Kubernetes, les espaces de noms sont également placés dans les noms DNS créés pour les services et les chemins de recherche DNS fournis aux conteneurs. Le nom DNS complet pour un service est quelque chose comme my- service.svc.mynamespace .cluster.internal , ce qui signifie que deux différents services dans les différents espaces de noms vont se retrouver avec différents noms de domaine complets (FQDN). De plus, les chemins de recherche DNS pour chaque conteneur incluent l’espace de noms, ainsi une recherche DNS pour le frontend sera traduite en frontend.svc.foo.cluster .internal pour un conteneur dans le foo Namespace et frontend.svc.bar.cluster.internal pour un conteneur dans l’espace de noms de la barre.

2.3.2.2 Étiquettes et requêtes d’étiquettes

Chaque objet de l’API Kubernetes peut être associé à un ensemble arbitraire d’étiquettes. Les étiquettes sont des paires clé-valeur de chaîne qui aident à identifier l’objet. Par exemple, une étiquette peut être “role”: “frontend”, ce qui indique que l’objet est un frontend. Ces étiquettes peuvent être utilisées pour interroger et filtrer des objets dans l’API. Par exemple, vous pouvez demander au serveur d’API de vous fournir une liste de tous les pods où le rôle d’étiquette est backend. Ces demandes sont appelées requêtes d’étiquettes ou sélecteurs d’étiquettes. De nombreux objets de l’API Kubernetes utilisent des sélecteurs d’étiquettes pour identifier les ensembles d’objets auxquels ils s’appliquent. Par exemple, une cosse peut avoir un sélecteur de noeud qui identifie l’ensemble des noeuds sur lesquels la nacelle est éligible pour exécuter (nœuds avec GPU, par exemple). De même, un service possède un sélecteur de pod , qui identifie l’ensemble de pods sur lequel le service doit charger le trafic d’équilibrage. Les étiquettes et les sélecteurs d’étiquettes sont la manière fondamentale dont Kubernetes associe librement ses objets.

2.3.2.3 Annotations

Toutes les valeurs de métadonnées que vous souhaitez affecter à un objet API n’identifient pas des informations. Certaines informations sont simplement une annotation sur l’objet lui-même. Ainsi, chaque objet API Kubernetes peut également avoir des annotations arbitraires. Ceux-ci peuvent inclure quelque chose comme l’icône à afficher à côté de l’objet ou un modificateur qui change la façon dont l’objet est interprété par le système.

Souvent, les fonctionnalités expérimentales ou spécifiques au fournisseur dans Kubernetes sont initialement implémentées à l’aide d’annotations, car elles ne font pas partie de la spécification formelle de l’API. Dans ces cas, l’annotation elle-même doit contenir une certaine notion de la stabilité de la fonction (par exemple, beta.kubernetes.io/activate-some-beta-feature).

2.3.2.4 Concepts avancés : déploiements, entrées et ensembles d’états

Bien entendu, les services simples, répliqués et à charge équilibrée ne sont pas le seul style d’application que vous souhaiterez déployer dans des conteneurs. Et, à mesure que Kubernetes a évolué, il a ajouté de nouveaux objets API pour mieux s’adapter à des cas d’utilisation plus spécialisés, notamment des déploiements améliorés, un équilibrage et un routage basés sur HTTP et des charges de travail avec état.

2.3.2.5 Déploiements

Bien que les ReplicaSets soient la primitive pour exécuter de nombreuses copies différentes de la même image de conteneur, les applications ne sont pas des entités statiques. Ils évoluent à mesure que les développeurs ajoutent de nouvelles fonctionnalités et corrigent des bugs. Cela signifie que le fait de déployer un nouveau code dans un service est une fonctionnalité aussi importante que sa réplication pour gérer de manière fiable la charge.

L’objet Déploiement a été ajouté à l’API Kubernetes pour représenter ce type de déploiement sécurisé d’une version à une autre. Un déploiement peut contenir des pointeurs vers plusieurs licaSets de rep (par exemple, v1 et v2), et il peut contrôler la migration lente et sûre d’un ReplicaSet vers un autre.

Pour comprendre le fonctionnement d’un déploiement, imaginez que vous disposez d’une application déployée sur trois réplicas dans un ReplicaSet nommé rs-v1. Lorsque vous demandez à un déploiement ment à déployer une nouvelle image (v2), le déploiement crée une nouvelle replicaSet (rs-v2) avec une seule réplique. Le déploiement attend que cette réplique devienne saine et, lorsqu’elle l’est, le déploiement réduit à deux le nombre de répliques dans rs-v1. Il augmente ensuite le nombre de répliques dans rs-v2 à deux également, et attend que la deuxième réplique de v2 redevienne saine. Ce processus se poursuit jusqu’à ce qu’il n’y ait plus de répliques de v1 et qu’il y ait trois répliques saines de v2.

Les déploiements comportent un grand nombre de boutons différents qui peuvent être réglés pour fournir un déploiement sûr pour les détails spécifiques d’une application. En effet, dans la plupart des groupes modernes, les utilisateurs utilisent exclusivement Déployer ment des objets et ne parviennent pas ReplicaSets directement.

2.3.2.6 Équilibrage de charge HTTP avec Ingress

Bien que les objets Service fournissent un excellent moyen d’effectuer un équilibrage de charge simple au niveau TCP, ils ne fournissent pas un moyen au niveau de l’application pour effectuer l’équilibrage de charge et le routage. La vérité est que la plupart des applications que les utilisateurs déploient à l’aide de conteneurs et de Kubernetes sont des applications Web HTTP. Ceux-ci sont mieux servis par un équilibreur de charge qui comprend HTTP. Pour répondre à ces besoins, l’API Ingress a été ajoutée à Kubernetes. Ingress représente un chemin et un équilibreur de charge et un routeur HTTP basés sur l’hôte. Lorsque vous créez un objet Ingress, il reçoit une adresse IP virtuelle comme un service, mais au lieu de la relation un à un entre une adresse IP de service et un ensemble de pods, une entrée peut utiliser le contenu d’une demande HTTP pour acheminer les demandes vers différents services.

Pour mieux comprendre le fonctionnement d’Ingress, imaginez que nous avons deux services Kubernetes nommés «foo» et «bar». Chacun a sa propre adresse IP, mais nous voulons vraiment les exposer à Internet en tant que partie du même hôte. Par exemple, foo.company.com et bar.company.com. Nous pouvons le faire en créant un objet Ingress et en associant son adresse IP aux noms DNS foo.company.com et bar.company.com. Dans l’objet Ingress, nous mappons également les deux noms d’hôtes différents aux deux services Kubernetes différents. De cette façon, lorsqu’une demande pour https://foo.company.com est reçue, elle est acheminée vers le service «foo» du cluster, et de même pour https://bar.company.com . Avec Ingress, le routage peut être basé sur l’hôte ou le chemin ou les deux, donc https://company.com/bar peut également être routé vers le service « bar ».

L’API Ingress est l’une des API les plus découplées et flexibles de Kubernetes. Par défaut, bien que Kubernetes stocke les objets Ingress, rien ne se produit lors de leur création. Au lieu de cela, vous devez également exécuter un contrôleur d’entrée dans le cluster pour prendre les mesures appropriées lorsque l’objet d’entrée est créé. L’un des contrôleurs Ingress les plus populaires est nginx , mais il existe de nombreuses implémentations qui utilisent d’autres équilibreurs de charge HTTP ou qui utilisent des API d’équilibrage de charge cloud ou physique.

2.3.2.7 StatefulSets

La plupart des applications fonctionnent correctement lorsqu’elles sont répliquées horizontalement et traitées comme des clones identiques. Chaque réplique n’a pas d’identité unique indépendante des autres. Pour représenter de telles applications, un ReplicaSet Kubernetes est l’objet parfait. Cependant, certaines applications, en particulier les charges de travail de stockage avec état ou les applications fragmentées, nécessitent davantage de différenciation entre les répliques de l’application. Bien qu’il soit possible d’ajouter cette différenciation au niveau de l’application au-dessus d’un ReplicaSet , cette opération est compliquée, sujette aux erreurs et répétitive pour les utilisateurs finaux.

Pour résoudre ce problème, Kubernetes a récemment introduit les StatefulSets en complément des ReplicaSets , mais pour des charges de travail plus dynamiques. Comme ReplicaSets , StatefulSets crée plusieurs instances de la même image de conteneur s’exécutant dans un cluster Kubernetes, mais la manière dont les conteneurs sont créés et détruits est plus déterministe, tout comme les noms de chaque conteneur.

Dans un ReplicaSet , chaque pod répliqué reçoit un nom qui implique un hachage aléatoire (par exemple, frontend-14a2 ), et il n’y a aucune notion de classement dans un ReplicaSet . En revanche, avec StatefulSets , chaque réplique reçoit un index à augmentation monotone (par exemple, soutenu-0 , backend-1 , etc.).

De plus, StatefulSets garantit que le réplica zéro sera créé et redeviendra sain avant que le réplica un ne soit créé et ainsi de suite. Lorsqu’elles sont combinées, cela signifie que les applications peuvent facilement s’amorcer elles-mêmes en utilisant la réplique initiale (par exemple, backend-0 ) comme maître d’amorçage. Toutes les répliques suivantes peuvent compter sur le fait que le backend-0 doit exister. De même, lorsque les réplicas sont supprimés d’un StatefulSet , ils sont supprimés à l’index le plus élevé. Si un StatefulSet est réduit de cinq à quatre répliques, il est garanti que la cinquième réplique est celle qui sera supprimée.

De plus, les StatefulSets reçoivent des noms DNS afin que chaque réplique soit accessible directement, en plus du StatefulSet complet. Cela permet aux clients de cibler facilement des fragments spécifiques dans un service partagé.

2.3.2.8 Charges de travail par lots : travail et emploi planifié

En plus des charges de travail avec état, une autre classe spécialisée de charges de travail sont les charges de travail par lots ou ponctuelles. Contrairement aux charges de travail discutées précédemment, celles-ci ne servent pas constamment le trafic. Au lieu de cela, ils effectuent certains calculs et sont ensuite détruits lorsque le calcul est terminé.

Dans Kubernetes, un Job représente un ensemble de tâches qui doivent être exécutées. Comme ReplicaSets et StatefulSets , les Jobs fonctionnent en créant des Pods pour exécuter le travail en exécutant des images de conteneur. Cependant, contrairement aux ReplicaSets et StatefulSets , les pods créés par un Job s’exécutent uniquement jusqu’à ce qu’ils se terminent et se terminent. Un Job contient la définition des Pods qu’il crée, le nombre d’exécutions du Job et le nombre maximum de Pods à créer en parallèle. Par exemple, un Job avec 100 répétitions et un parallélisme maximum de 10 exécutera 10 Pods simultanément, créant de nouveaux Pods comme les anciens, jusqu’à ce qu’il y ait eu 100 exécutions réussies de l’image du conteneur.

ScheduledJobs s’appuie sur l’objet Job en ajoutant une planification à un Job. Un Sched uledJob contient la définition de l’objet Job que vous souhaitez créer, ainsi que la planification sur laquelle ce Job doit être créé.

2.3.3 Agents de cluster et utilitaires : DaemonSets

L’une des questions les plus courantes qui se posent lorsque les gens déménagent vers Kubernetes est : « Comment exécuter les agents de ma machine ?» Des exemples de tâches d’agents incluent la détection d’intrusion, la journalisation et la surveillance, etc. De nombreuses personnes tentent des approches non Kubernetes pour activer ces agents, telles que l’ajout de nouveaux fichiers d’unité systemd ou de scripts d’initialisation. Bien que ces approches puissent fonctionner, elles présentent plusieurs inconvénients. La première est que Kubernetes n’inclut pas l’activité des agents dans sa comptabilité des ressources utilisées sur le cluster. La seconde est que les images de conteneur et les API Kubernetes pour la vérification de l’intégrité, la surveillance, etc. ne peuvent pas être appliquées à ces agents. Heureusement, Kubernetes met l’API DaemonSet à la disposition des utilisateurs pour installer ces agents sur leurs clusters. Un DaemonSet fournit un modèle pour un pod qui doit être exécuté sur chaque machine. Lorsqu’un DaemonSet est créé, Kubernetes s’assure que ce pod s’exécute sur chaque nœud du cluster. Si, à un moment ultérieur, un nouveau nœud est ajouté, Kubernetes crée également un pod sur ce nœud. Bien que par défaut, Kubernetes place un pod sur chaque nœud du cluster, un DaemonSet peut également fournir une requête d’étiquette de sélection de nœud, et Kubernetes ne placera ce pod de DaemonSet que sur des nœuds qui correspondent à cette requête d’étiquette.

2.4 Résumé

L’objectif de cet article est de vous apprendre à gérer avec succès un cluster Kubernetes. Mais pour gérer avec succès un service, vous devez comprendre ce que ce service met à la disposition de l’utilisateur final, ainsi que la façon dont l’utilisateur utilise le service. Dans ce cas, nous fournissons une API Kubernetes fiable aux développeurs. Les développeurs, à leur tour, utilisent cette API pour créer et déployer avec succès leurs applications. Comprendre les différentes parties de l’API Kubernetes vous permettra de comprendre vos utilisateurs finaux et de mieux gérer le système dont ils dépendent pour leurs activités quotidiennes.

3 CHAPITRE 3 Architecture Kubernetes

Bien que Kubernetes soit destiné à faciliter le déploiement et la gestion des systèmes distribués, Kubernetes lui-même est un système distribué qui doit être géré. Pour être en mesure de le faire, un développeur doit avoir une solide compréhension de l’architecture du système, du rôle de chaque élément du système et de la façon dont ils s’emboîtent tous.

3.1 Concepts

Pour comprendre l’architecture de Kubernetes, il est utile, dans un premier temps, d’avoir une bonne compréhension des concepts et des principes de conception qui régissent son développement. Bien que le système puisse sembler assez complexe, il est en fait basé sur un nombre relativement restreint de concepts qui sont répétés tout au long. Cela permet à Kubernetes de se développer, tout en restant accessible aux développeurs. La connaissance d’un composant du système peut souvent être directement appliquée à d’autres.

3.1.1 Configuration déclarative

La notion de configuration déclarative – lorsqu’un utilisateur déclare un état souhaité du monde pour produire un résultat – est l’un des principaux moteurs du développement de Kubernetes. Par exemple, un utilisateur pourrait dire à Kubernetes: «Je veux qu’il y ait en tout temps cinq répliques de mon serveur Web.» Kubernetes, à son tour, prend cette déclaration déclarative et prend la responsabilité de s’assurer qu’elle est vraie. Malheureusement, Kubernetes est incapable de comprendre les instructions en langage naturel et cette déclaration est en fait sous la forme d’un document YAML ou JSON structuré.

La configuration déclarative diffère de la configuration impérative dans laquelle les utilisateurs prennent une série d’actions directes (par exemple, la création de chacune des cinq répliques qu’ils souhaitent avoir opérationnelles). Les actions impératives sont souvent plus simples à comprendre – on peut simplement dire « exécuter ceci » au lieu d’utiliser une syntaxe déclarative plus complexe. Cependant, le pouvoir de l’approche déclarative est que vous donnez au système plus qu’une séquence d’instructions – vous lui donnez une déclaration de votre état souhaité. Parce que Kubernetes comprend votre état souhaité, il peut prendre des mesures autonomes, indépendamment de l’interaction de l’utilisateur. Cela signifie qu’il peut implémenter des comportements d’auto- correction et d’auto-guérison automatiques. Pour un développeur, cela est essentiel, car cela signifie que le système peut se réparer sans vous réveiller au milieu de la nuit.

3.1.2 Rapprochement ou contrôleurs

Pour atteindre ces comportements d’auto-guérison ou d’auto-correction, Kubernetes est structuré sur la base d’un grand nombre de boucles de réconciliation ou de contrôle indépendantes. Lors de la conception d’un système comme Kubernetes, vous pouvez généralement adopter deux approches différentes : une approche basée sur un état monolithique ou une approche basée sur un contrôleur décentralisé.

Dans la conception d’un système monolithique, le système est conscient de l’état du monde entier et utilise cette vue complète pour faire avancer tout de manière coordonnée. Cela peut être très intéressant, car le fonctionnement du système est centralisé et donc plus facile à comprendre. Le problème avec l’approche monolithique est qu’elle n’est pas particulièrement stable. Si quelque chose d’inattendu se produit, le système entier peut tomber en panne.

Kubernetes adopte une approche décentralisée alternative dans sa conception. Au lieu d’un seul contrôleur monolithique, Kubernetes est composé d’un grand nombre de contrôleurs, chacun effectuant sa propre boucle de réconciliation indépendante. Chaque boucle individuelle n’est responsable que d’une petite partie du système (par exemple, la mise à jour de la liste des points de terminaison pour un équilibreur de charge particulier), et chaque petit contrôleur ignore totalement le reste du monde. Cette focalisation sur un petit problème et l’ignorance correspondante de l’état plus large du monde rend l’ensemble du système beaucoup plus stable. Chaque contrôleur est largement indépendant de tous les autres et n’est donc pas affecté par des problèmes ou des changements sans rapport avec lui-même. L’inconvénient, cependant, de cette approche distribuée est que le comportement global du système peut être plus difficile à comprendre, car il n’y a pas un seul endroit pour chercher une explication des raisons pour lesquelles le système se comporte comme il est. Au lieu de cela, il est nécessaire d’examiner l’interopérabilité d’un grand nombre de processus indépendants.

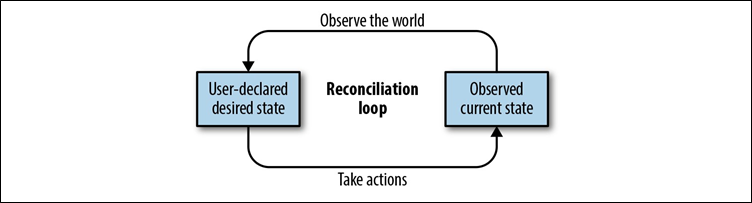

Le modèle de conception de boucle de contrôle rend Kubernetes plus flexible et stable et est répété dans tous les composants du système Kubernetes. L’idée de base derrière une boucle de contrôle est qu’elle répète continuellement les étapes suivantes, comme le montre la figure 3-1:

- Obtenez l’état souhaité du monde.

- Observez le monde.

- Trouvez des différences entre l’observation du monde et l’état souhaité du monde.

- Prenez des mesures pour que l’observation du monde corresponde à l’état souhaité.

Figure 3-1. Une illustration d’une boucle de réconciliation générique

L’exemple le plus simple pour vous aider à comprendre le fonctionnement d’une boucle de contrôle de rapprochement est le thermostat de votre maison. Il a un état souhaité (la température que vous avez entrée sur le thermostat), il fait des observations du monde (la température actuelle de votre maison), il trouve la différence entre ces valeurs, et il prend ensuite des mesures (chauffage ou refroidissement) pour que le monde réel corresponde à l’état souhaité du monde.

Les contrôleurs de Kubernetes font la même chose. Ils observent l’état souhaité du monde via les déclarations déclaratives adressées au serveur API Kubernetes. Par exemple, un utilisateur peut déclarer : « Je veux quatre répliques de ce serveur Web ». Le contrôleur de réplication Kubernetes prend cet état souhaité puis observe le monde. Il se peut qu’il existe actuellement trois répliques du conteneur de service Web. Le contrôleur trouve la différence entre l’état actuel et l’état souhaité (un serveur Web manquant) puis prend des mesures pour que l’état actuel corresponde à l’état souhaité en créant un quatrième conteneur de service Web.

Bien sûr, l’un des défis de la gestion de cet état déclaratif est de déterminer l’ensemble de serveurs Web auxquels la boucle de contrôle de réconciliation doit prêter attention. C’est là que les étiquettes et les requêtes d’étiquettes entrent dans la conception de Kubernetes.

3.1.3 Regroupement implicite ou dynamique

Qu’il s’agisse de regrouper un ensemble de répliques ou d’identifier les backends d’un équilibreur de charge, il y a de nombreuses fois dans l’implémentation de Kubernetes quand il est nécessaire d’identifier un ensemble de choses. Lors du regroupement des éléments dans un ensemble, il existe deux approches possibles : le regroupement explicite / statique ou implicite / dynamique. Avec le regroupement statique, chaque groupe est défini par une liste concrète (par exemple, “Les membres de mon équipe sont Alice, Bob et Carol.”). La liste appelle explicitement le nom de chaque membre du groupe et la liste est statique, c’est-à-dire que l’appartenance ne change pas sauf si la liste elle-même change. Tout comme une approche monolithique de la conception, ce regroupement statique est facilement compréhensible. Pour savoir qui est dans un groupe, il suffit de lire la liste. Le défi du regroupement statique est qu’il est inflexible – il ne peut pas répondre à un monde en évolution dynamique. J’espère qu’à ce stade, vous savez que Kubernetes utilise une approche plus dynamique du regroupement. Dans Kubernetes, les groupes sont définis implicitement.

L’alternative aux groupes statiques explicites est les groupes dynamiques implicites. Avec les groupes implicites, au lieu de la liste des membres, le groupe est défini par une déclaration comme : « Les membres de mon équipe sont les gens qui portent de l’orange ». Ce groupe est implicitement défini. Nulle part dans la définition du groupe les membres ne sont définis ; au lieu de cela, ils sont implicites en évaluant la définition du groupe par rapport à un ensemble de personnes présentes. Parce que l’ensemble des personnes présentes peut toujours changer, la composition du groupe est également dynamique et changeante. Bien que cela puisse introduire de la complexité, en raison de la deuxième étape (dans le cas d’exemple, à la recherche de personnes portant de l’orange), il est également beaucoup plus flexible et stable, et il peut gérer un environnement changeant sans nécessiter des ajustements constants des listes statiques.

Dans Kubernetes, ce regroupement implicite est réalisé via des étiquettes et des requêtes d’étiquettes ou des sélecteurs d’étiquettes. Chaque objet API dans Kubernetes peut avoir un nombre arbitraire de paires clé / valeur appelées « étiquettes » qui sont associées à l’objet. Vous pouvez ensuite utiliser une requête d’étiquette ou un sélecteur d’étiquette pour identifier un ensemble d’objets correspondant à cette requête. Un exemple concret de cela est illustré à la figure 3-2.

Chaque objet Kubernetes possède à la fois des étiquettes et des annotations. Au début, ils peuvent sembler redondants, mais leurs utilisations sont différentes. Les étiquettes peuvent être interrogées et doivent fournir des informations permettant d’identifier l’objet d’une manière ou d’une autre. Les annotations ne peuvent pas être interrogées et doivent être utilisées pour les métadonnées générales sur l’objet – des métadonnées qui ne représentent pas son identité (par exemple, l’icône à afficher à côté de l’objet lorsqu’il est rendu graphiquement).

Figure 3-2. Exemples d’étiquettes et de sélection d’étiquettes

3.2 Structure

Maintenant que vous avez une idée des concepts de conception mis en œuvre dans le système Kubernetes, considérons les principes de conception utilisés pour créer Kubernetes. Les principes de conception fondamentaux suivants sont essentiels au développement de Kubernetes.

3.2.1 Philosophie Unix de nombreux composants

Kubernetes adhère à la philosophie générale Unix de la modularité et des petites pièces qui font bien leur travail. Kubernetes n’est pas une seule application monolithique qui implémente toutes les différentes fonctionnalités dans un seul binaire. Au lieu de cela, il s’agit d’un ensemble d’applications différentes qui fonctionnent toutes ensemble, en grande partie ignorantes les unes des autres, pour implémenter le système global connu sous le nom de Kubernetes. Même lorsqu’il existe un binaire (par exemple, le gestionnaire de contrôleur) qui regroupe un grand nombre de fonctions différentes, ces fonctions sont détenues presque entièrement indépendamment les unes des autres dans ce binaire. Ils sont compilés ensemble en grande partie pour faciliter la tâche de déploiement et de gestion de Kubernetes, pas à cause d’une liaison étroite entre les composants.

Encore une fois, l’avantage de cette approche modulaire est que Kubernetes est flexible. De grandes fonctionnalités peuvent être arrachées et remplacées sans que le reste du système ne s’en aperçoive ou ne s’en soucie. L’inconvénient, bien sûr, est la complexité, car le déploiement, la surveillance et la compréhension du système nécessitent l’intégration des informations et de la configuration à travers un certain nombre d’outils différents. Parfois, ces pièces sont compilées en un seul exécutable binaire, mais même lorsque cela se produit, elles communiquent toujours via le serveur API plutôt que directement dans le processus en cours d’exécution.

3.2.2 Interactions pilotées par l’API

La deuxième conception structurelle au sein de Kubernetes est que toutes les interactions entre les composants passent par une surface API centralisée. Un corollaire important de cette conception est que l’API que les composants utilisent est exactement la même API utilisée par tous les autres utilisateurs du cluster. Cela a deux conséquences importantes pour Kubernetes. La première est qu’aucune partie du système n’est plus privilégiée ou n’a un accès plus direct aux internes que toute autre. En effet, à l’exception du serveur API qui implémente l’API, personne n’a accès aux internes du tout. Ainsi, chaque composant peut être échangé contre une implémentation alternative, et de nouvelles fonctionnalités peuvent être ajoutées sans avoir à reconcevoir les composants principaux. Comme nous le verrons dans les chapitres suivants, même les composants de base comme le planificateur peuvent être échangés et remplacés (ou simplement augmentés) par des implémentations alternatives.

Les interactions pilotées par l’API incitent un système à être conçu de manière stable en présence d’un biais de version. Lorsque vous déployez un système distribué dans un groupe de machines, pendant un certain temps, vous aurez à la fois l’ancienne version et la nouvelle version du logiciel exécutées simultanément. Si vous n’avez pas planifié directement cette asymétrie de version, les interactions non planifiées (et souvent non testées) entre les anciennes et les nouvelles versions peuvent provoquer une instabilité et des pannes. Parce que dans Kubernetes, tout est médié via l’API et que l’API fournit des versions d’API fortement définies et une conversion entre différents numéros de version , les problèmes de biais de version peuvent être largement évités. En réalité, cependant, des problèmes occasionnels peuvent toujours survenir, et les tests de biais et de mise à niveau des versions sont une partie importante de la qualification des versions de Kubernetes.

3.3 Composants

Avec la connaissance des concepts et des structures de l’architecture Kubernetes, nous pouvons maintenant discuter des composants individuels qui composent Kubernetes. Il s’agit en quelque sorte d’un glossaire – une carte du monde à laquelle vous pouvez vous référer lorsque vous avez besoin d’un aperçu de la façon dont les différentes pièces du système Kubernetes s’emboîtent. Certains composants sont plus importants que d’autres, et sont donc traités de manière beaucoup plus détaillée dans les chapitres suivants, mais ce guide de référence aidera à fonder et à contextualiser ces explorations ultérieures.

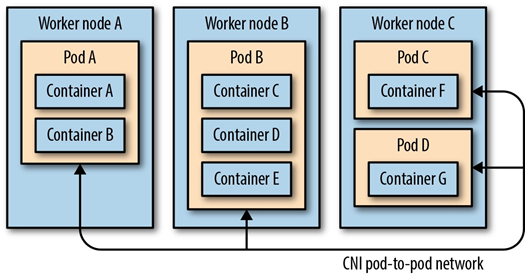

Kubernetes est un système qui regroupe une grande flotte de machines en une seule unité pouvant être consommée via une API, mais la mise en œuvre de Kubernetes subdivise en fait l’ensemble des machines en deux groupes : les nœuds de travail et les nœuds principaux. La plupart des composants qui composent l’infrastructure Kubernetes s’exécutent sur des nœuds de tête ou de plan de contrôle. Il existe un nombre limité de ces nœuds dans un cluster, généralement un, trois ou cinq. Ces nœuds exécutent les composants qui implémentent Kubernetes, comme etcd et le serveur API. Il existe un nombre impair de ces nœuds, car ils doivent conserver le quorum dans un état partagé à l’aide d’un algorithme Raft / Paxos pour le quorum. Le travail réel du cluster est effectué sur les nœuds de travail. Ces nœuds exécutent également une sélection plus limitée de composants Kubernetes. Enfin, certains composants Kubernetes sont planifiés sur le cluster Kubernetes après sa création. Du point de vue de Kubernetes, ces composants ne se distinguent pas des autres charges de travail, mais ils implémentent une partie de l’API Kubernetes globale.

La discussion suivante sur les composants Kubernetes les répartit en trois groupes : les composants qui s’exécutent sur les nœuds principaux, les composants qui s’exécutent sur tous les nœuds et les composants qui s’exécutent sur le cluster.

3.3.1 Composants du nœud principal

Un nœud principal est le cerveau du cluster Kubernetes. Il contient une collection de composants principaux qui implémentent la fonctionnalité de l’API Kubernetes. En règle générale, seuls ces composants s’exécutent sur les nœuds principaux ; aucun conteneur utilisateur ne partage ces nœuds.

3.3.1.1 etcd

Le système etcd est au cœur de tout cluster Kubernetes. Il implémente les magasins de valeurs-clés où tous les objets d’un cluster Kubernetes sont conservés. Les serveurs etcd implémentent un algorithme de consensus distribué, à savoir Raft, qui garantit que même si l’un des serveurs de stockage tombe en panne, il y a une réplication suffisante pour maintenir les données stockées dans etcd et récupérer les données lorsqu’un serveur etcd redevient sain et se reconduit à le cluster. Les serveurs etcd fournissent également deux autres fonctionnalités importantes dont Kubernetes fait un usage intensif. Le premier est la concurrence optimiste. Chaque valeur stockée dans etcd a une version de ressource correspondante. Lorsqu’une paire clé-valeur est écrite sur un serveur etcd , elle peut être conditionnée à une version de ressource particulière. Cela signifie qu’en utilisant etcd , vous pouvez implémenter la comparaison et l’échange , qui est au cœur de tout système de concurrence. La comparaison et l’échange permettent à un utilisateur de lire une valeur et de la mettre à jour en sachant qu’aucun autre composant du système n’a également mis à jour la valeur. Ces assurances permettent au système d’avoir en toute sécurité plusieurs threads manipulant des données dans etcd sans avoir besoin de verrous pessimistes, ce qui peut réduire considérablement le débit vers le serveur.

En plus d’implémenter la comparaison et l’échange, les serveurs etcd implémentent également un protocole de surveillance. La valeur de watch est qu’elle permet aux clients de surveiller efficacement les changements dans les magasins de valeurs-clés pour un répertoire entier de valeurs. Par exemple, tous les objets d’un espace de noms sont stockés dans un répertoire dans etcd. L’utilisation d’une montre permet à un client d’attendre et de réagir efficacement aux changements sans interrogation continue du serveur etcd .

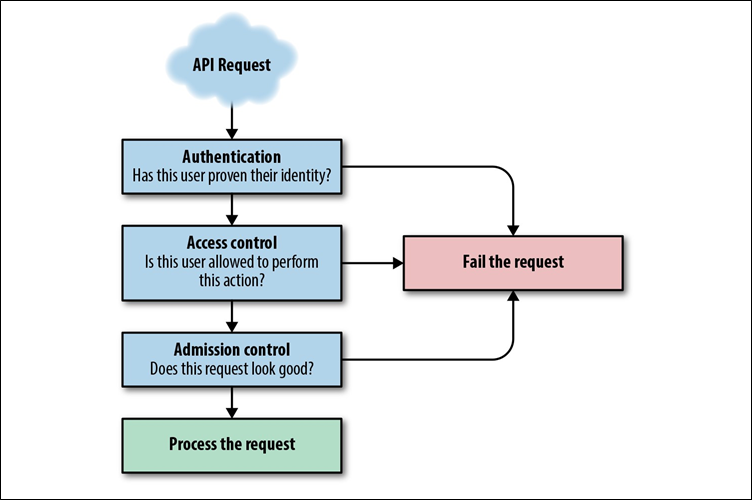

3.3.1.2 Serveur API

Bien que etcd soit au cœur d’un cluster Kubernetes, il n’y a en fait qu’un seul serveur autorisé à avoir un accès direct au cluster Kubernetes, et c’est le serveur API. Le serveur API est le hub du cluster Kubernetes; il assure la médiation de toutes les interactions entre les clients et les objets API stockés dans etcd . Par conséquent, c’est le point de rencontre central pour toutes les différentes composantes. En raison de son importance, le serveur API mérite une introspection plus approfondie et est traité dans le chapitre 4.

3.3.1.3 Planificateur

Avec etcd et le serveur API fonctionnant correctement, un cluster Kubernetes est, à certains égards, fonctionnellement complet. Vous pouvez créer tous les différents objets API, comme les déploiements et les pods. Cependant, vous constaterez qu’il ne commence jamais à fonctionner. La recherche d’un emplacement pour l’exécution d’un pod est la tâche du planificateur Kubernetes. Le planificateur analyse le serveur API pour les pods non planifiés, puis détermine les meilleurs nœuds sur lesquels les exécuter. Comme le serveur API, le planificateur est un sujet complexe et riche qui est traité plus en détail au chapitre 5.

3.3.1.4 Gestionnaire de contrôleur

Une fois que etcd , le serveur d’API et le planificateur sont opérationnels, vous pouvez créer avec succès des pods et les voir planifiés sur les nœuds, mais vous constaterez que les ReplicaSets , les déploiements et les services ne fonctionnent pas comme vous vous y attendez. Cela est dû au fait que toutes les boucles de contrôle de réconciliation nécessaires pour implémenter cette fonctionnalité ne sont pas en cours d’exécution. L’exécution de ces boucles incombe au gestionnaire de contrôleur. Le gestionnaire du contrôleur est le plus varié de tous les composants Kubernetes, puisqu’il a en elle de nombreuses différentes boucles de contrôle de la réconciliation pour mettre en œuvre de nombreuses parties du système global Kubernetes.

3.3.2 Composants sur tous les nœuds

En plus des composants qui s’exécutent exclusivement sur les nœuds principaux, il existe quelques composants qui sont présents sur tous les nœuds du cluster Kubernetes. Ces pièces implémentent les fonctionnalités essentielles requises sur tous les nœuds.

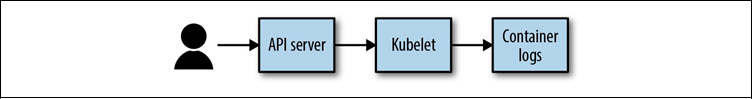

3.3.2.1 Kubelet

Le kubelet est le démon de noeud pour toutes les machines qui font partie d’un cluster Kubernetes. Le kubelet est le pont qui relie le processeur, le disque et la mémoire disponibles pour un nœud dans le grand cluster Kubernetes. Le kubelet communique avec le serveur API pour rechercher les conteneurs qui doivent être exécutés sur son nœud. De même, le kubelet communique l’état de ces conteneurs au serveur API afin que d’autres boucles de contrôle de réconciliation puissent observer l’état actuel de ces conteneurs.

En plus de planifier et de signaler l’état des conteneurs exécutés dans les pods sur leurs machines, les kubelets sont également responsables de la vérification de l’état et du redémarrage des conteneurs qui sont censés s’exécuter sur leurs machines. Il serait assez inefficace de renvoyer toutes les informations d’état d’intégrité vers le serveur API afin que les boucles de réconciliation puissent prendre des mesures pour corriger l’intégrité d’un conteneur sur une machine particulière. Au lieu de cela, le kubelet court- circuite cette interaction et exécute la boucle de réconciliation elle-même. Ainsi, si un conteneur exécuté par le kubelet meurt ou échoue à son contrôle d’intégrité, le kubelet le redémarre, tout en communiquant également cet état d’intégrité (et le redémarrage) au serveur API.

3.3.2.2 kube -proxy

L’autre composant qui s’exécute sur toutes les machines est le kube -proxy. Le kube- proxy est responsable de l’implémentation du modèle de mise en réseau d’équilibrage de charge du service Kubernetes. Le kube- proxy surveille toujours les objets de noeud final pour tous les services du cluster Kubernetes. Le kube- proxy programme ensuite le réseau sur son nœud de sorte que les requêtes du réseau à l’adresse IP virtuelle d’un service soient, en fait, acheminées vers les points de terminaison qui mettent en œuvre ce service. Chaque service de Kubernetes obtient une adresse IP virtuelle et le Kube -proxy est le démon responsable de la définition et la mise en œuvre du programme d’équilibrage de la charge locale que le trafic des routes de pods sur la machine à pods, partout dans le cluster, qui mettent en œuvre le service.

3.3.3 Composants planifiés

Lorsque tous les composants qui viennent d’être décrits fonctionnent correctement, ils fournissent un cluster Kubernetes minimalement viable. Mais il existe plusieurs composants planifiés supplémentaires qui sont essentiels au cluster Kubernetes qui dépendent en fait du cluster lui-même pour leur implémentation. Cela signifie que, bien qu’ils soient essentiels au fonctionnement du cluster, ils sont également planifiés, contrôlés, exploités et mis à jour à l’aide d’appels au serveur Kubernetes API lui-même.

3.3.3.1 KubeDNS

Le premier de ces composants planifiés est le serveur KubeDNS . Quand un Kubernetes

Le service est créé, il obtient une adresse IP virtuelle, mais cette adresse IP est également programmée dans un serveur DNS pour une découverte de service facile. Les conteneurs KubeDNS implémentent ce service de noms pour les objets du service Kubernetes. Le service KubeDNS est lui-même exprimé comme un service Kubernetes, donc le même routage fourni par le proxy kube achemine le trafic DNS vers les conteneurs KubeDNS . La seule différence importante est que le service KubeDNS reçoit une adresse IP virtuelle statique. Cela signifie que le serveur API peut programmer le serveur DNS dans tous les conteneurs qu’il crée, implémentant la dénomination et la découverte de services pour les services Kubernetes.

En plus du service KubeDNS présent dans Kubernetes depuis les premières versions, il existe également une nouvelle implémentation CoreDNS alternative qui a atteint la disponibilité générale (GA) dans la version 1.11 de Kubernetes.

La possibilité d’échanger le service DNS montre à la fois la modularité et la valeur de l’utilisation de Kubernetes pour exécuter des composants tels que le serveur DNS. Remplacer KubeDNS par CoreDNS est aussi simple que d’arrêter un pod et d’en démarrer un autre.

3.3.3.2 Heapster

L’autre composant planifié est un binaire appelé Heapster, qui est responsable de la collecte des mesures telles que l’utilisation du processeur, du réseau et du disque à partir de tous les conteneurs exécutés à l’intérieur du cluster Kubernetes. Ces mesures peuvent être transmises à un système de surveillance, comme InfluxDB, pour les alertes et la surveillance générale de l’intégrité des applications dans le cluster. Il est également important de noter que ces mesures sont utilisées pour implémenter la mise à l’échelle automatique des pods au sein du cluster Kubernetes. Kubernetes a une implémentation de mise à l’échelle automatique, qui, par exemple, peut automatiquement mettre à l’échelle la taille d’un déploiement chaque fois que l’utilisation du processeur des conteneurs dans le déploiement dépasse 80%. Heapster est le composant qui collecte et agrège ces mesures pour alimenter la boucle de réconciliation implémentée par l’autoscaler. L’autoscaler observe l’état actuel du monde via des appels d’API à Heapster .