Architecture à base d’IoT et de Edge Computing

Résumé de la publication

Les industries adoptent les technologies IoT pour améliorer les dépenses opérationnelles, la durée de vie des produits et le bien-être des personnes. Un guide architectural est nécessaire si vous souhaitez parcourir le spectre des technologies nécessaires pour construire un système IoT réussi, qu’il s’agisse d’un seul appareil ou de millions d’appareils IoT.

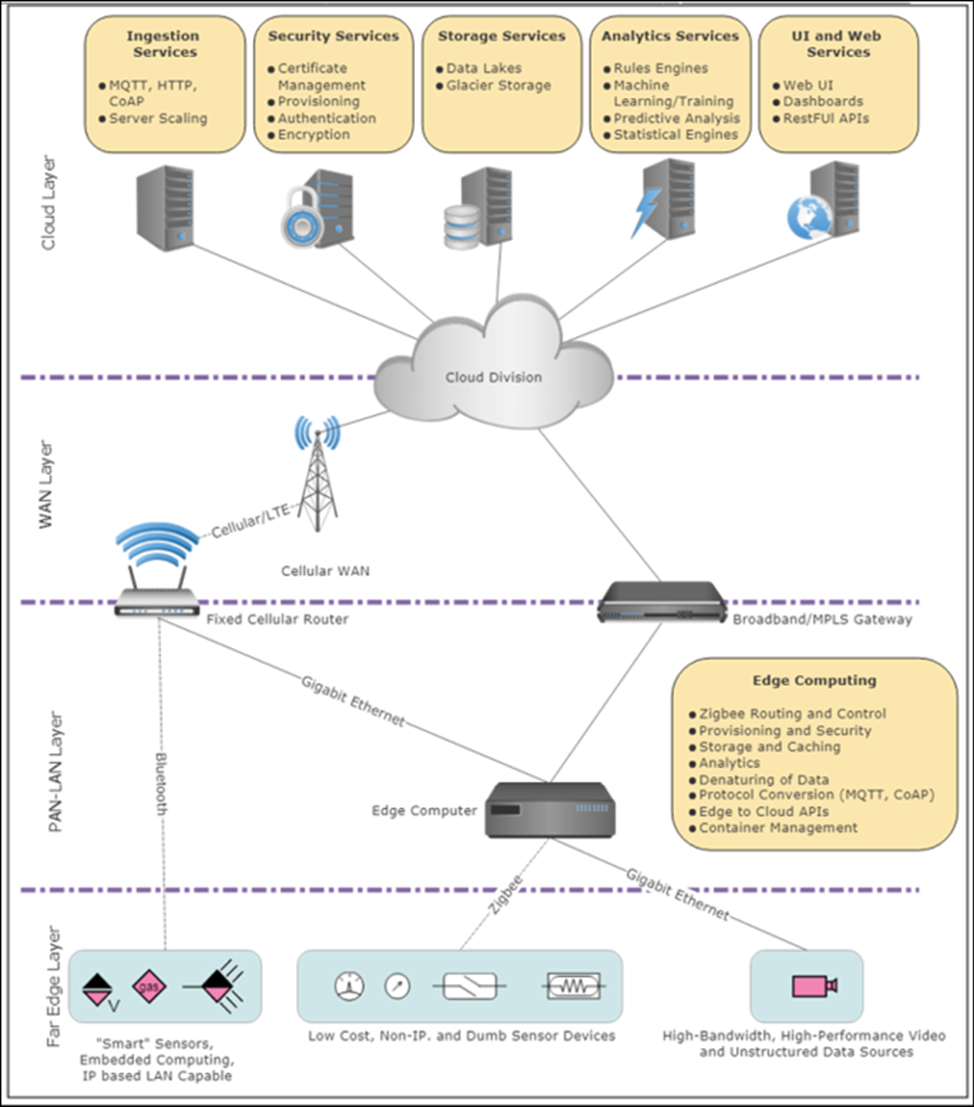

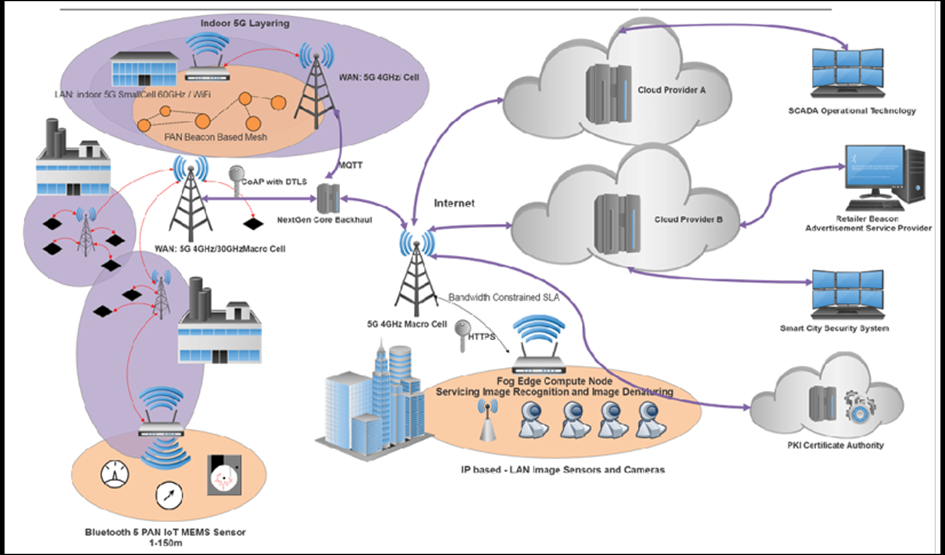

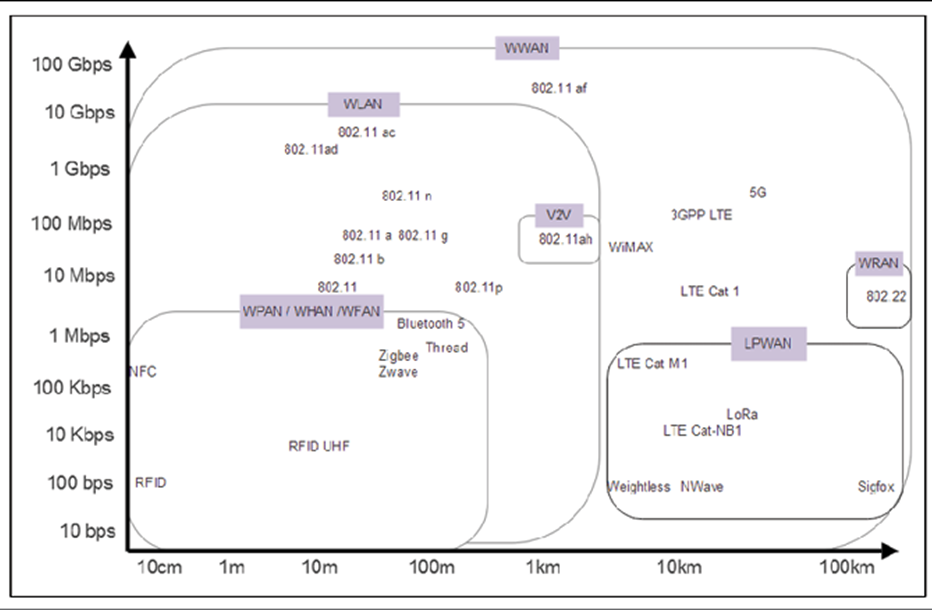

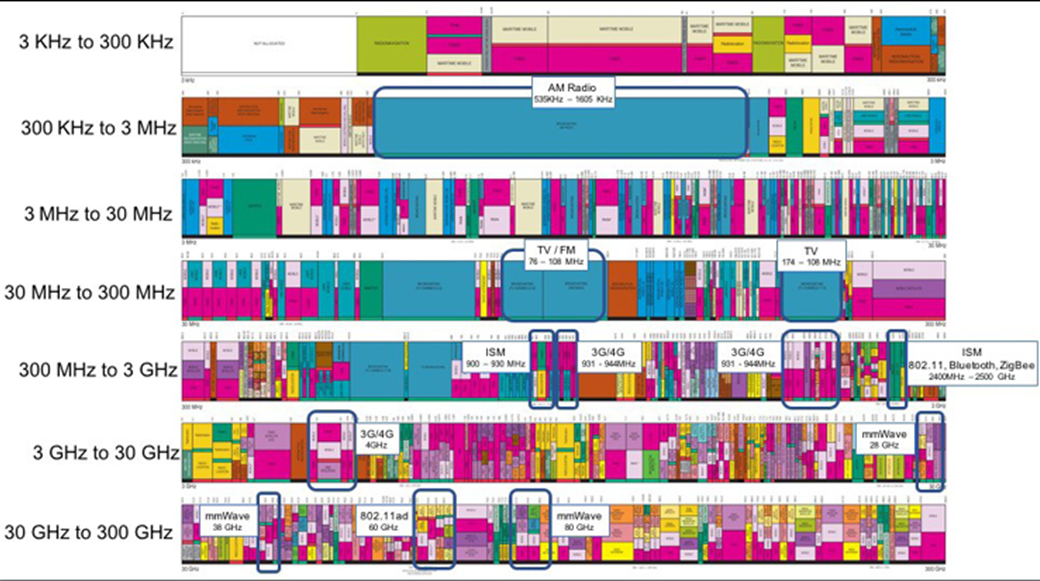

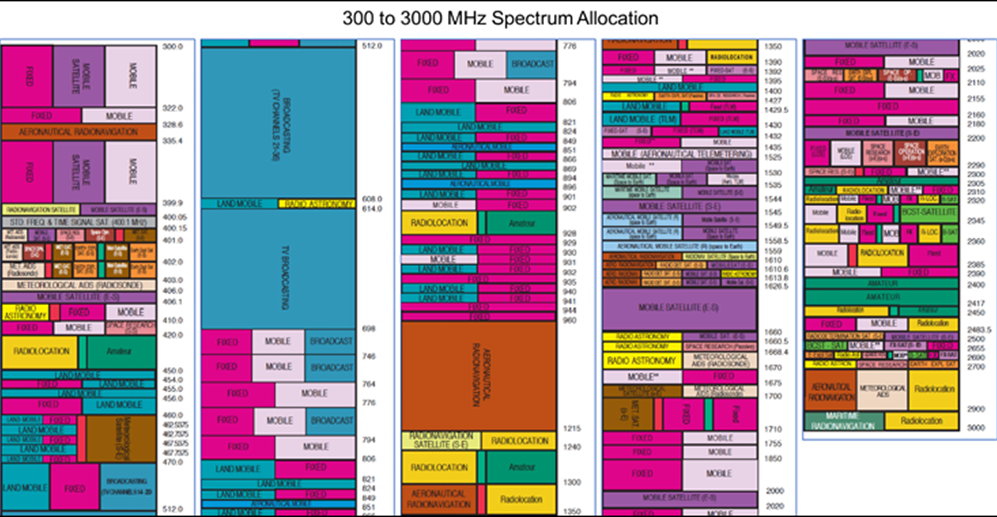

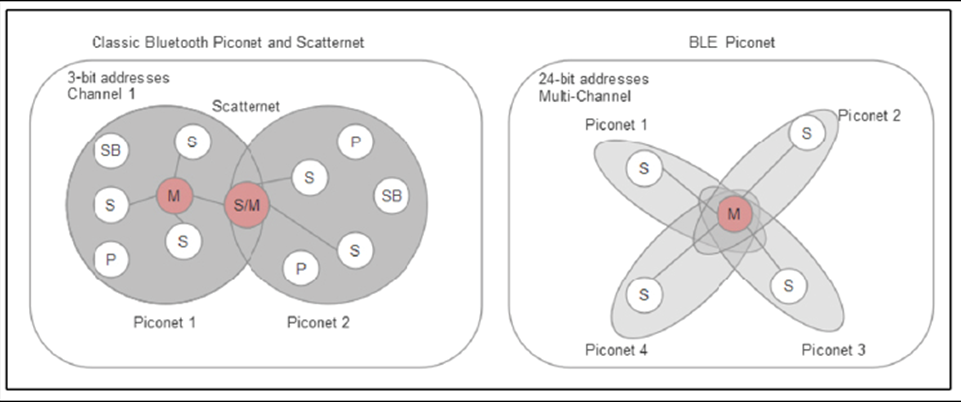

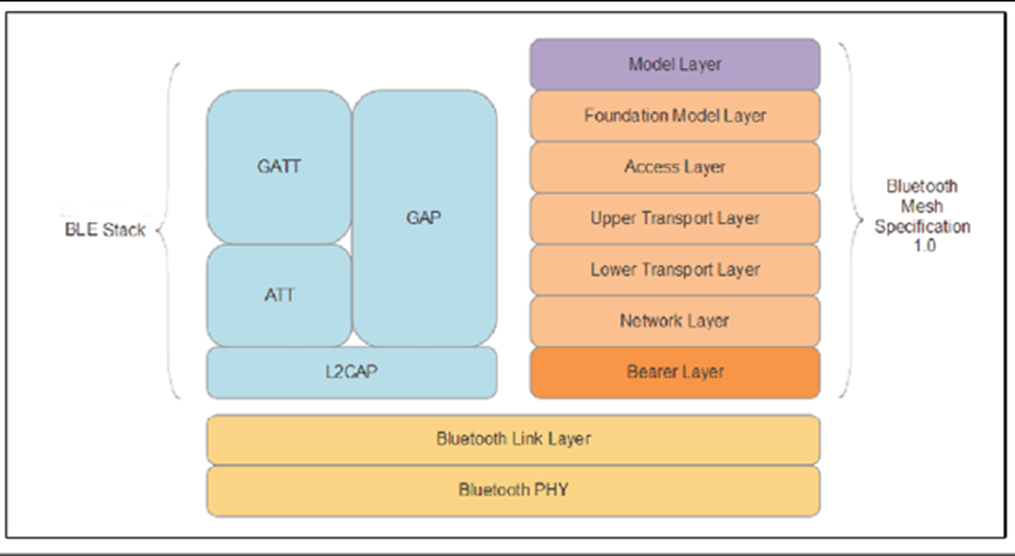

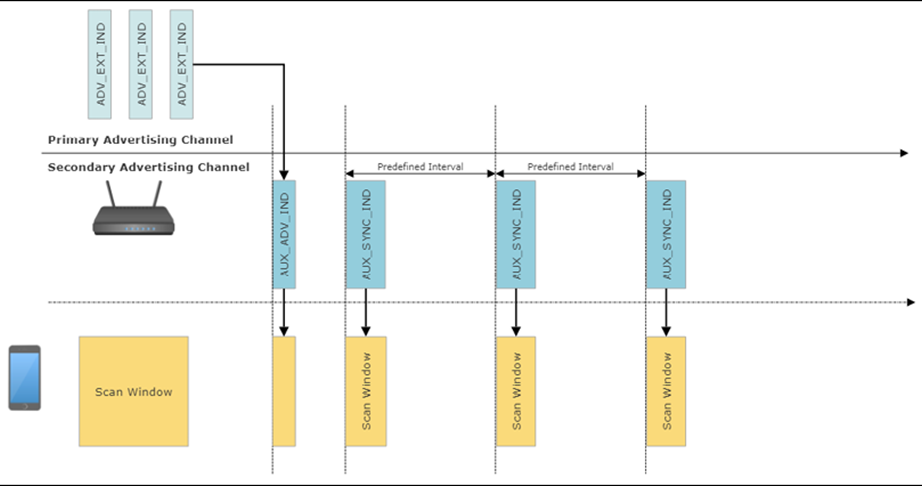

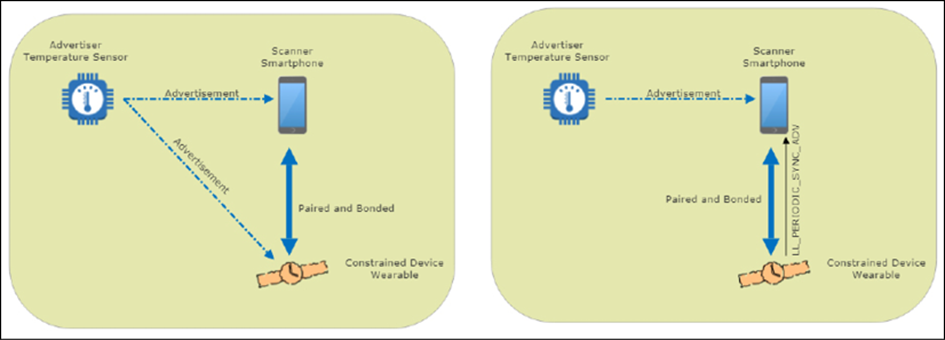

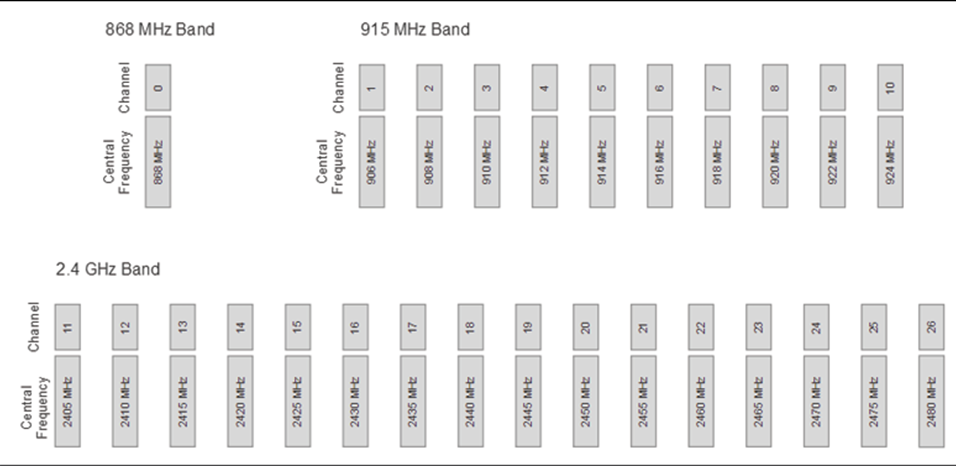

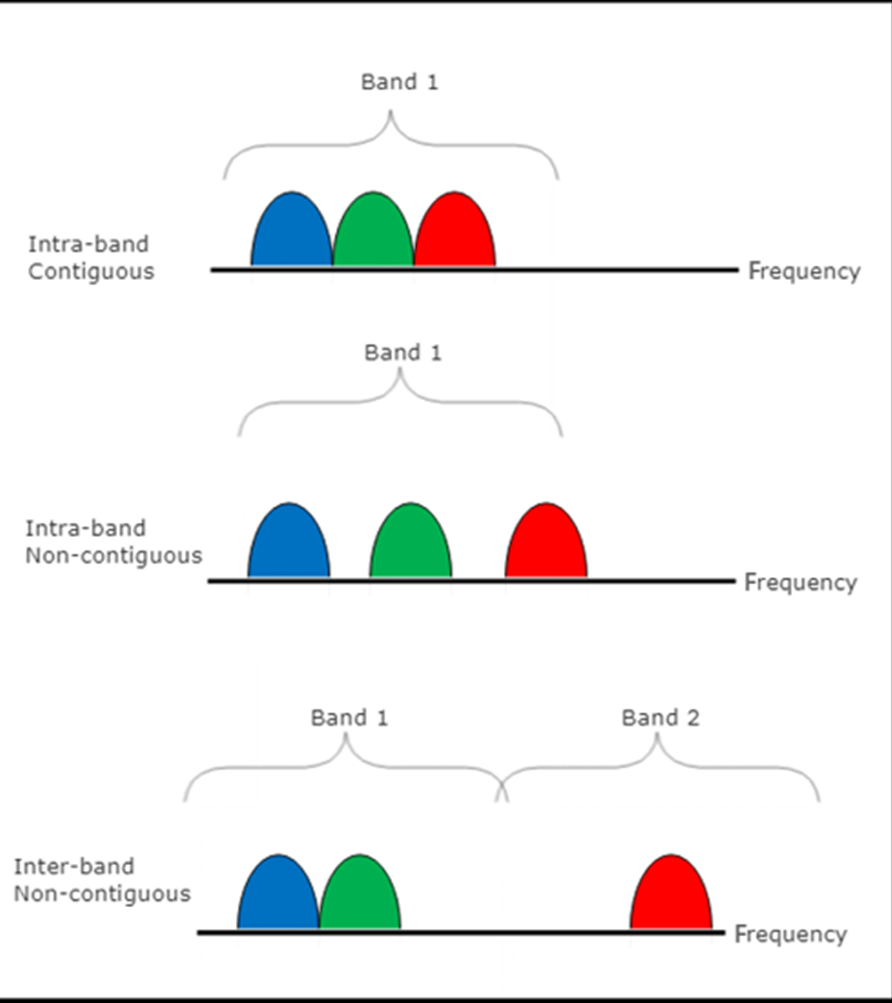

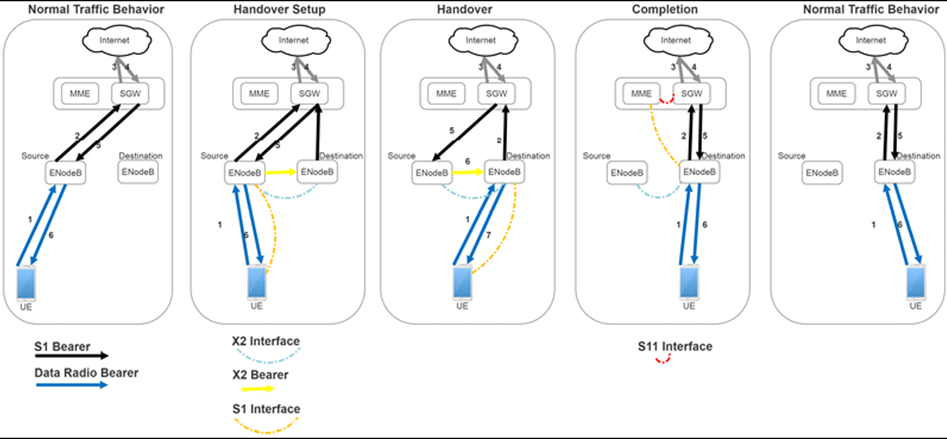

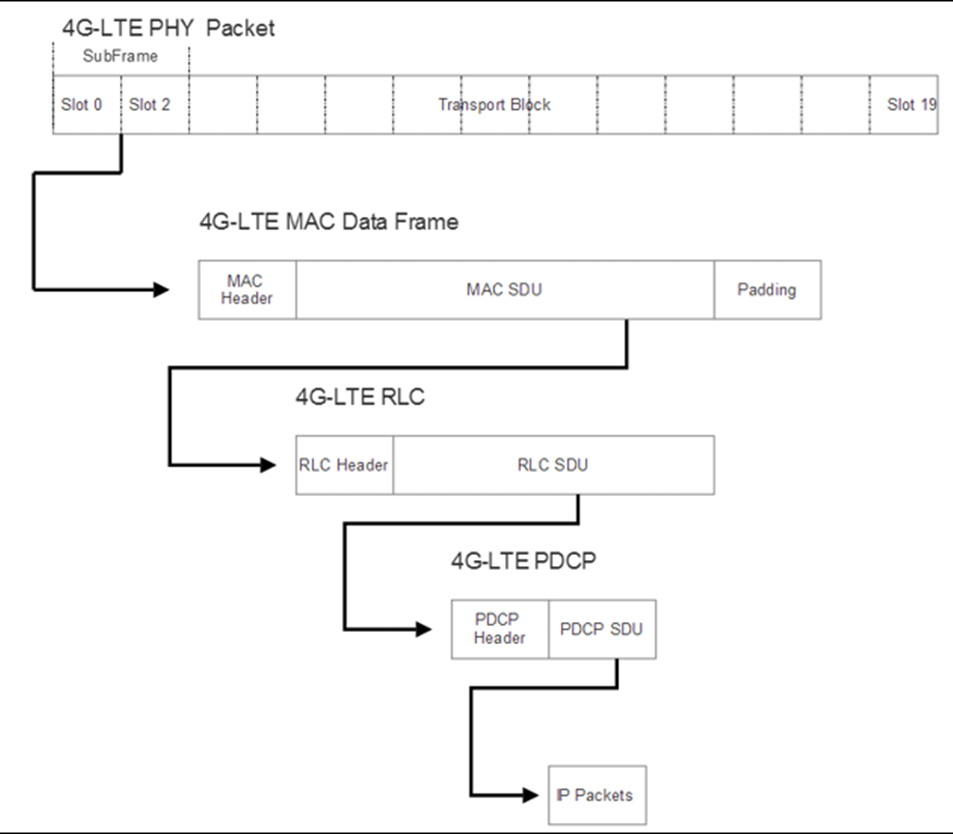

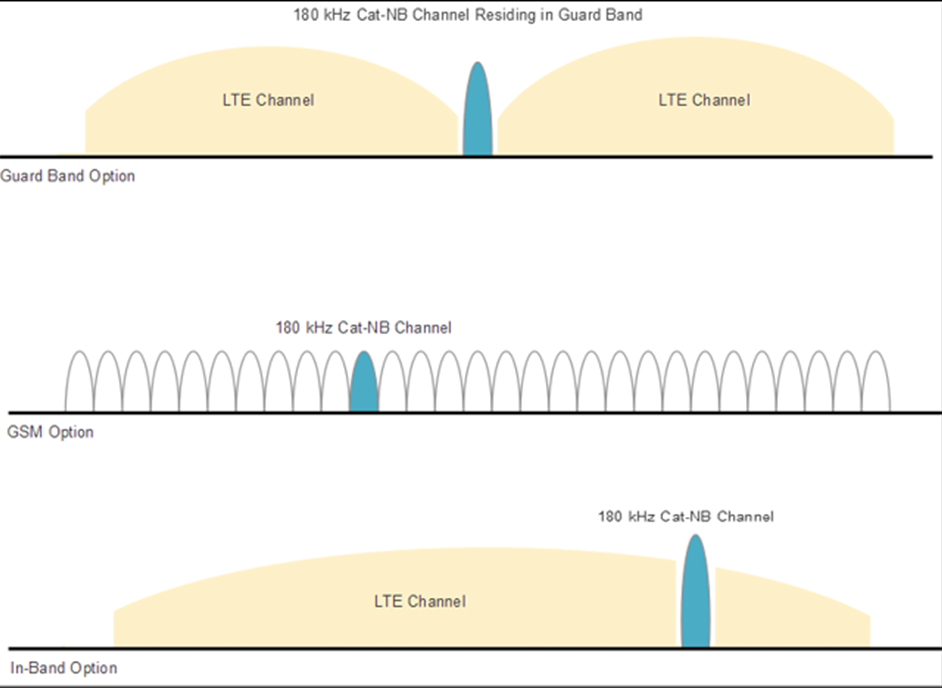

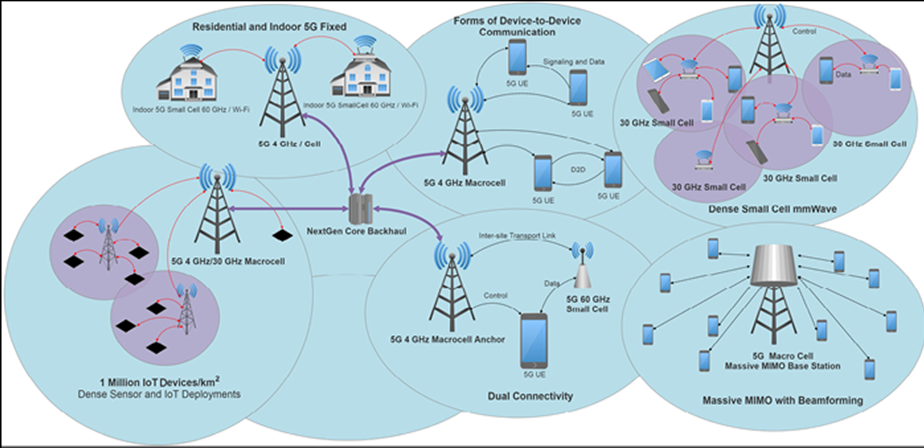

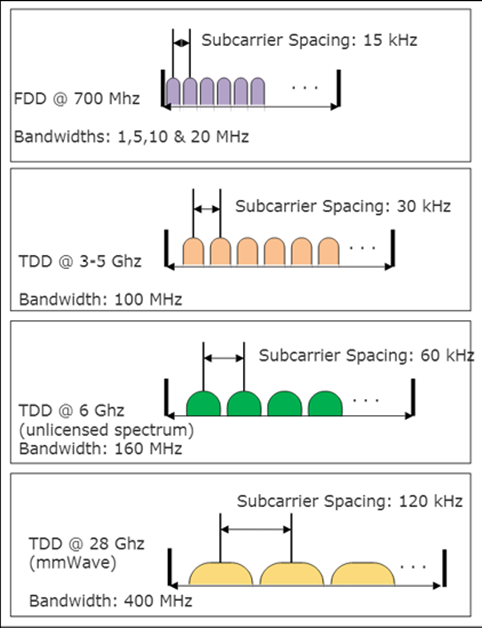

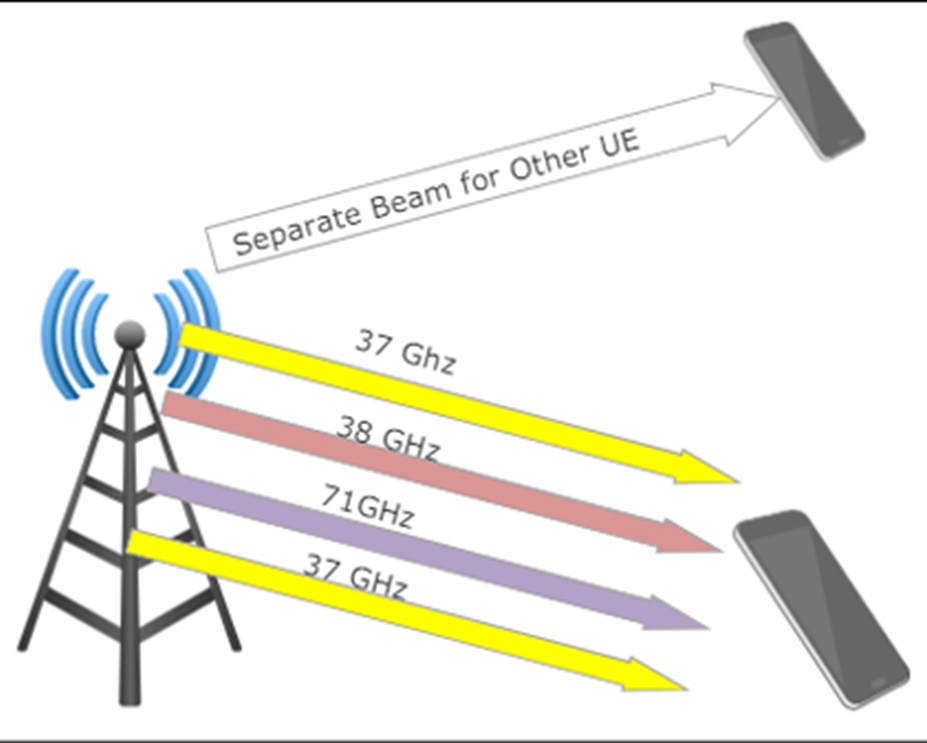

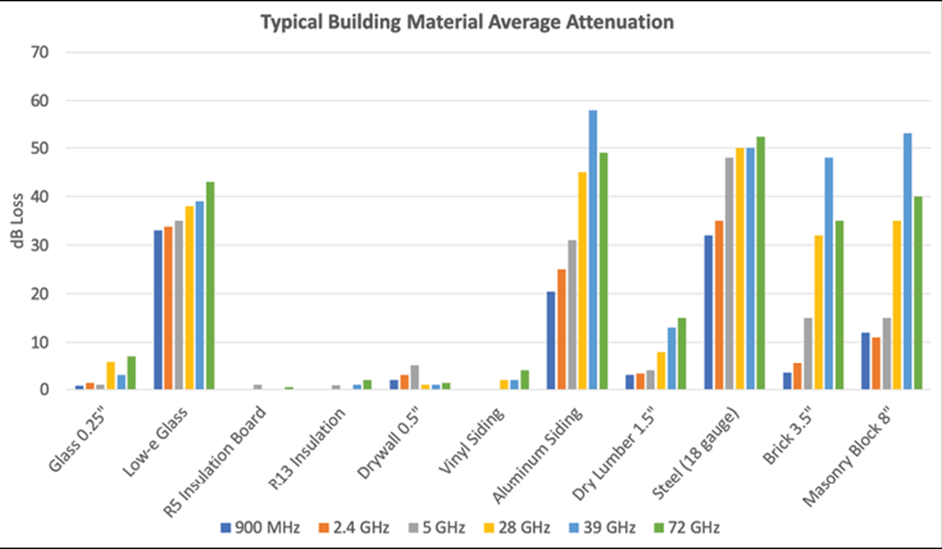

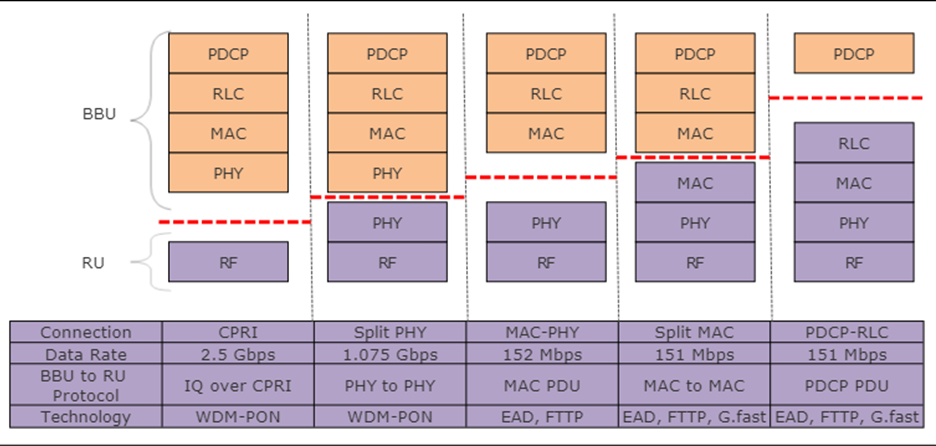

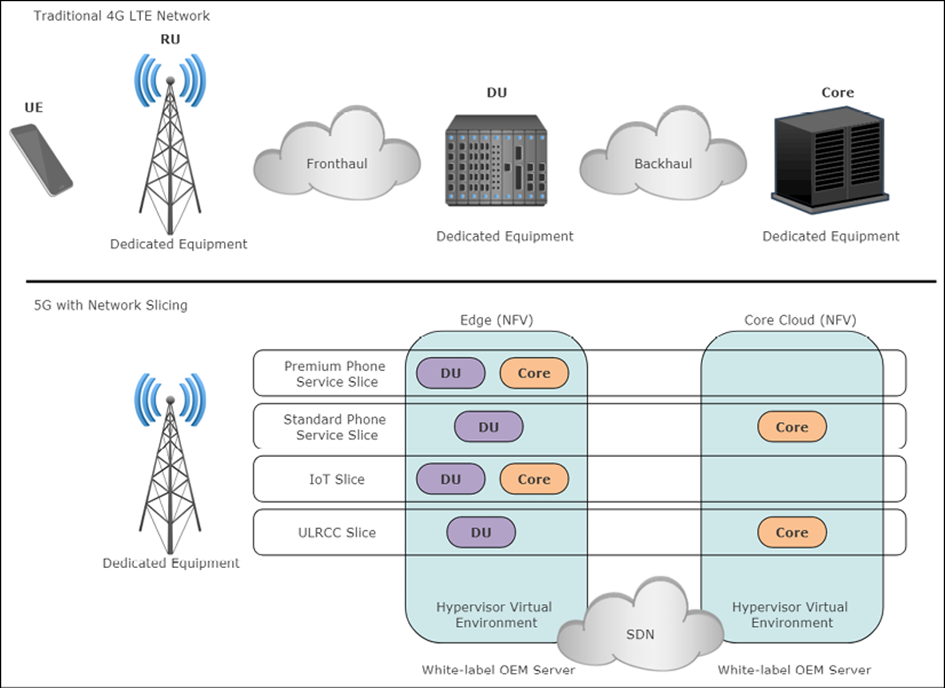

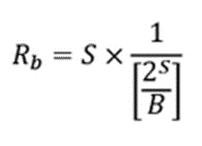

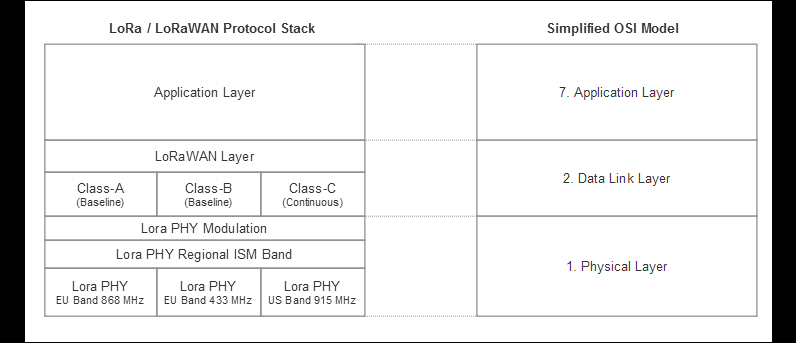

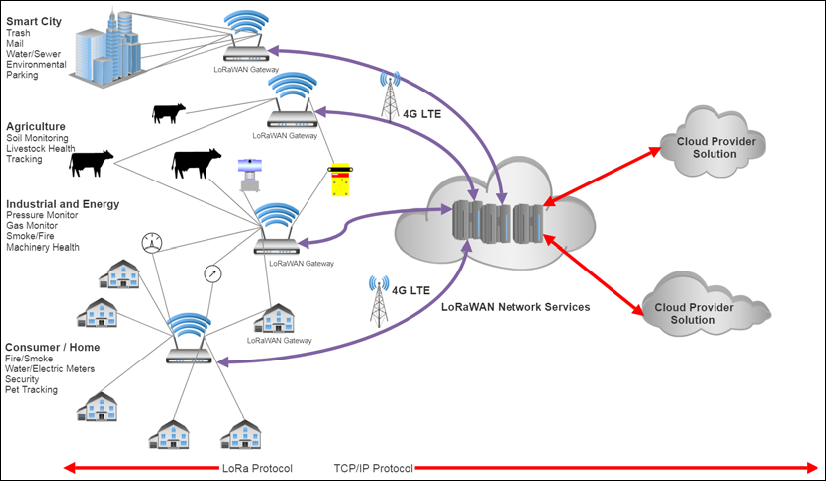

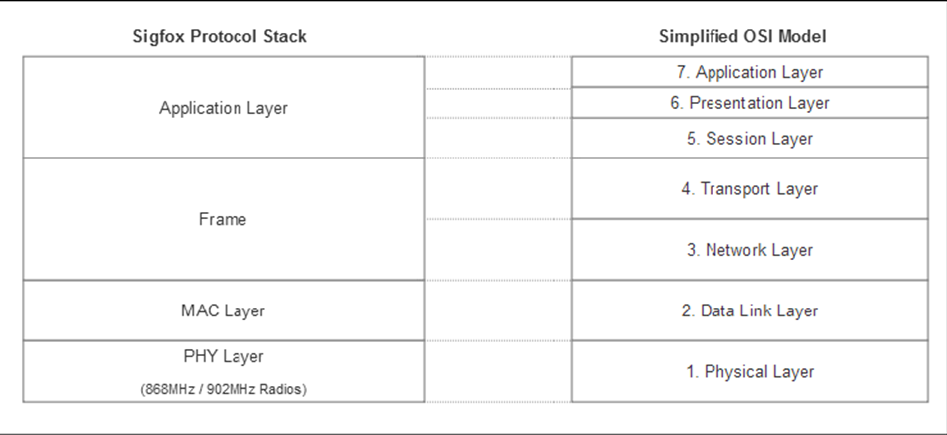

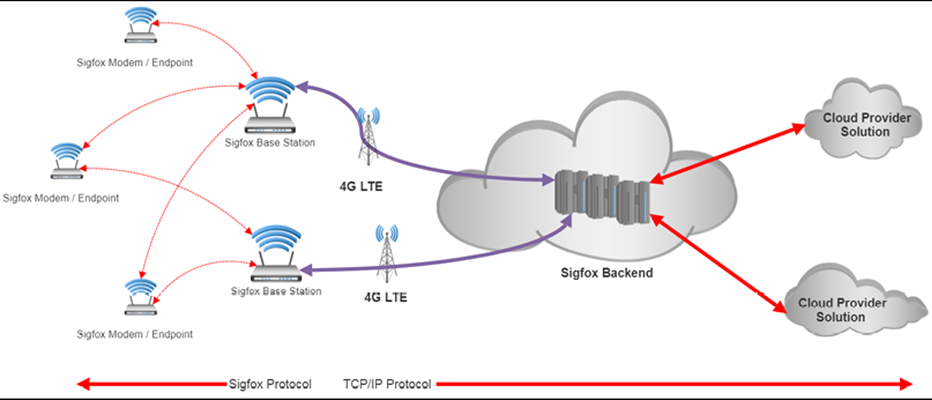

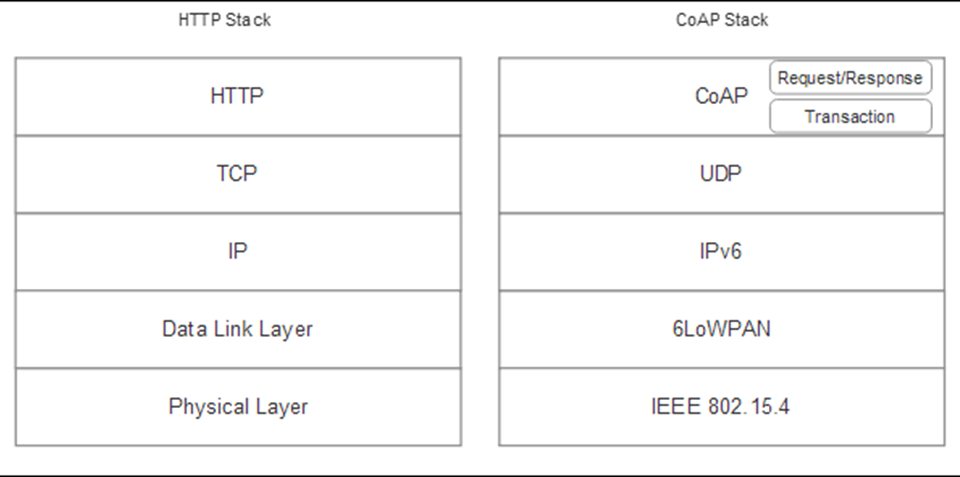

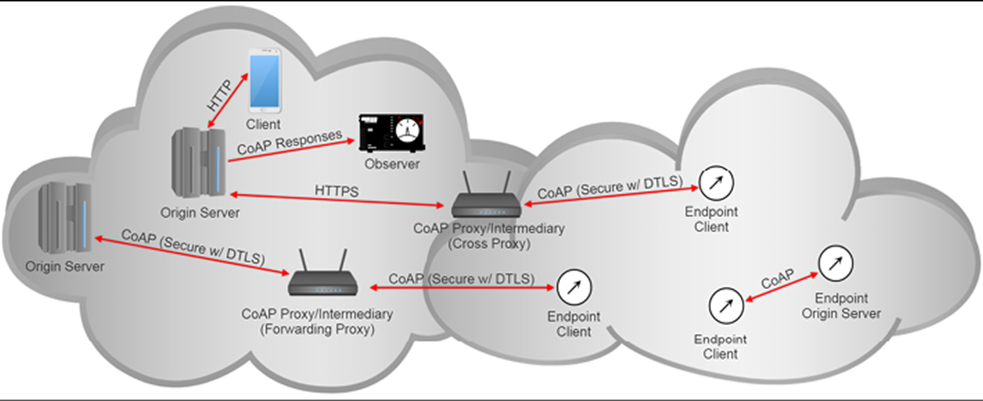

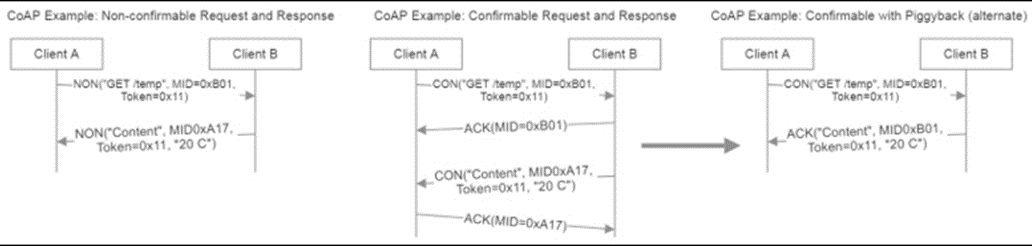

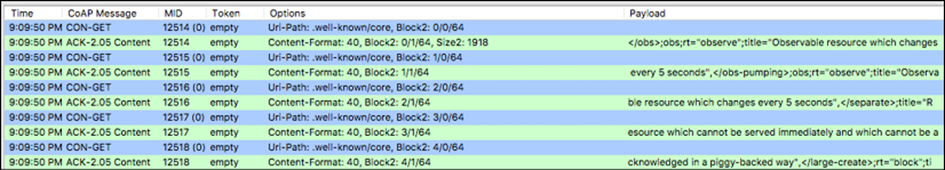

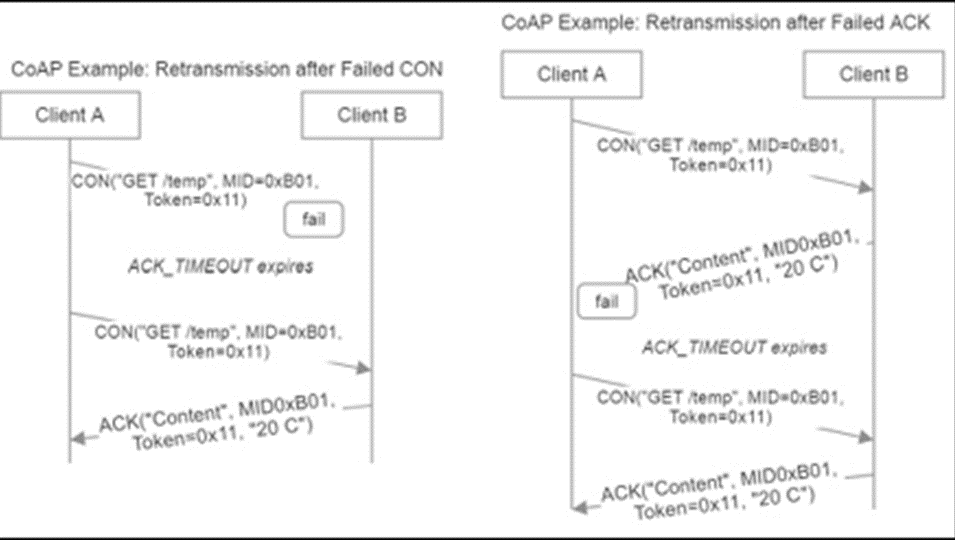

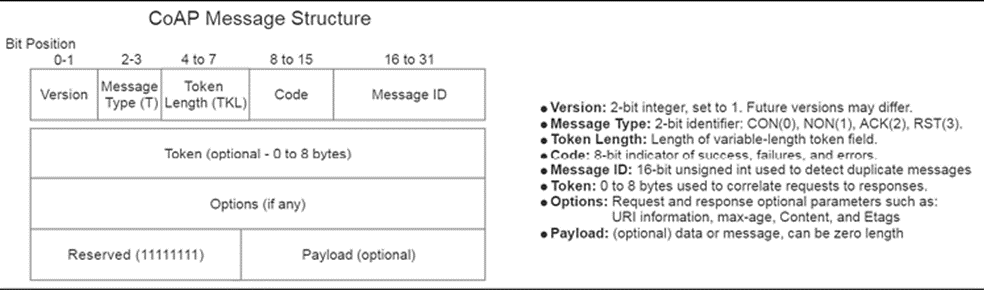

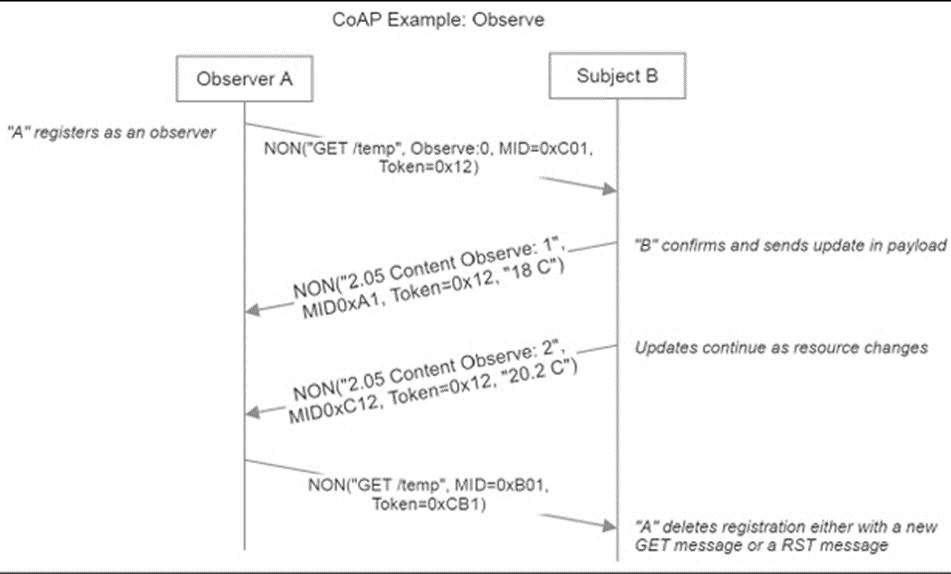

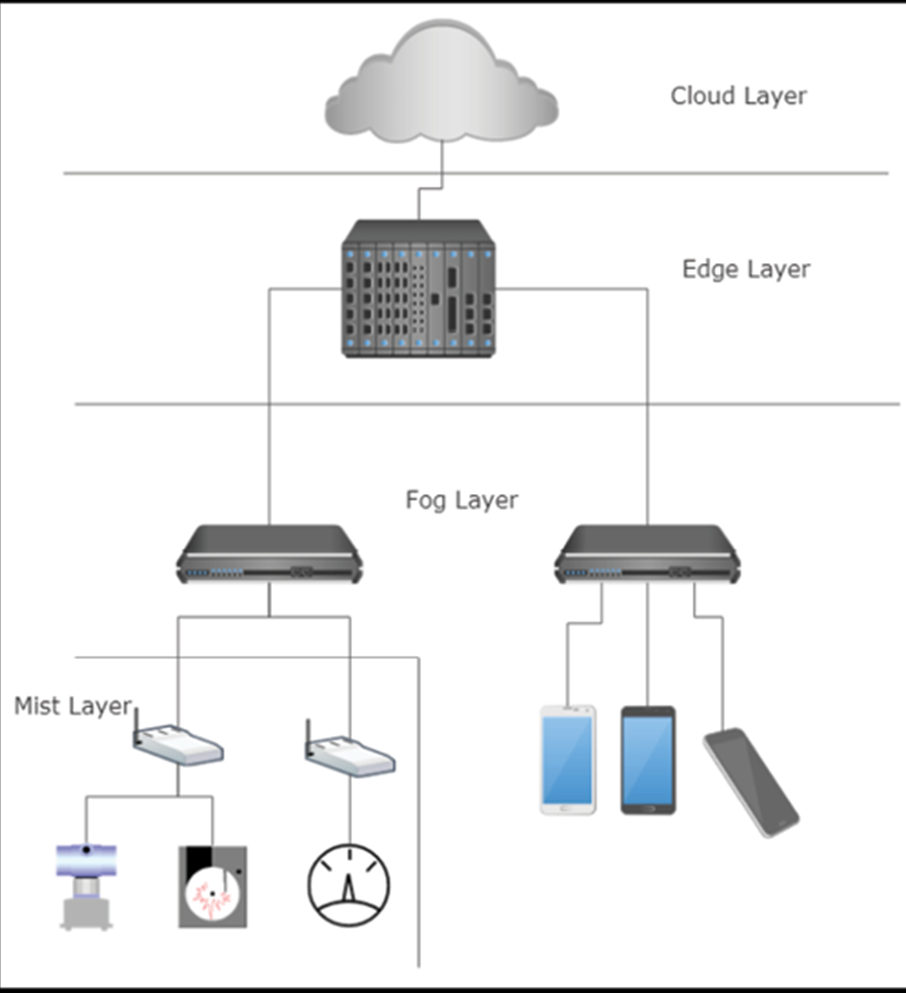

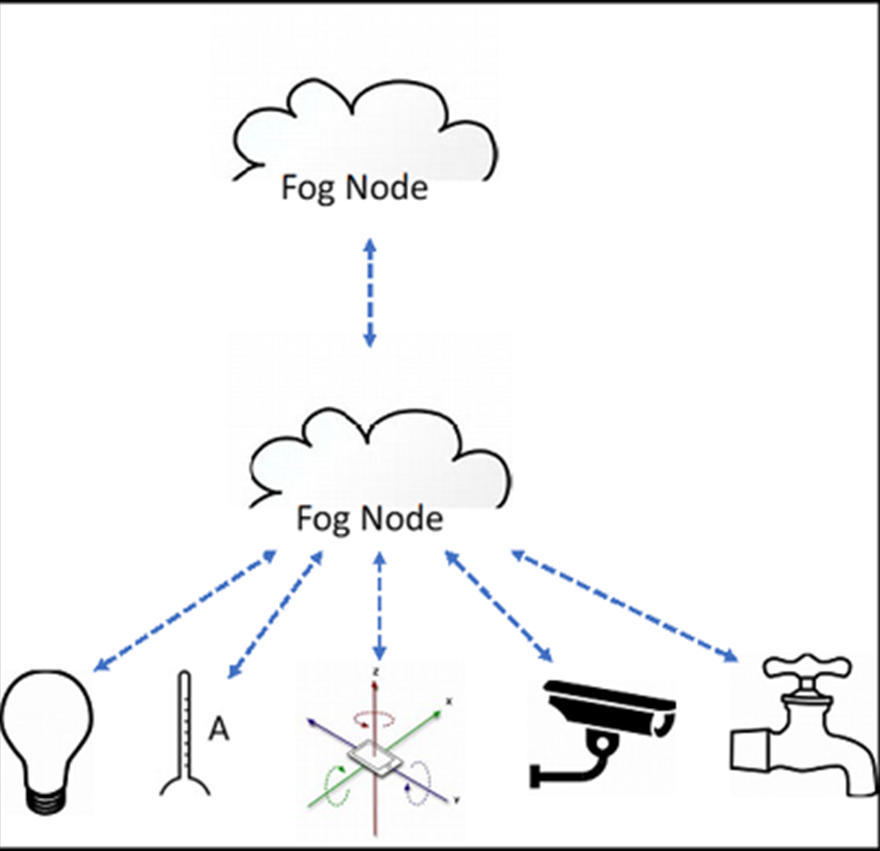

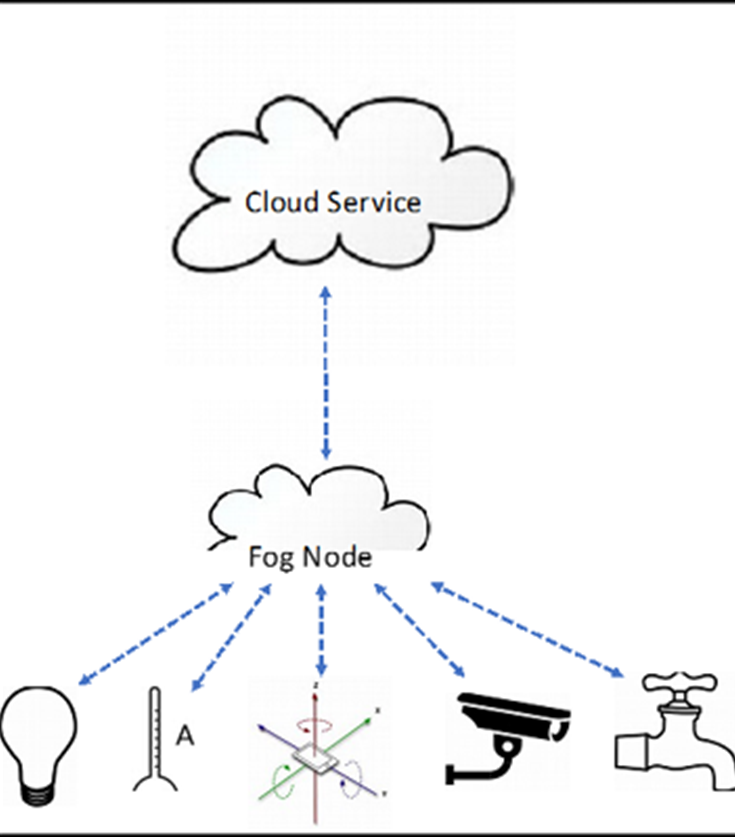

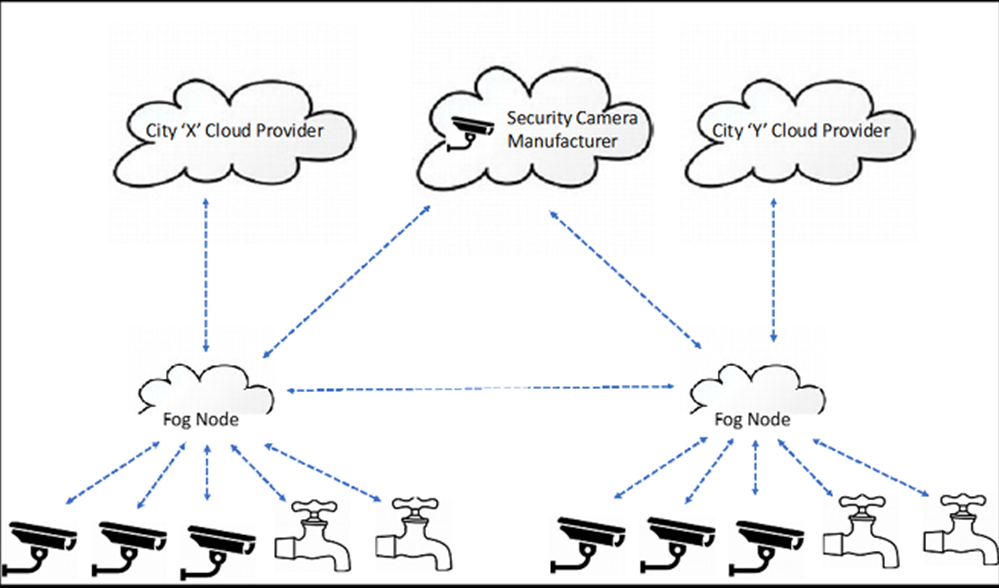

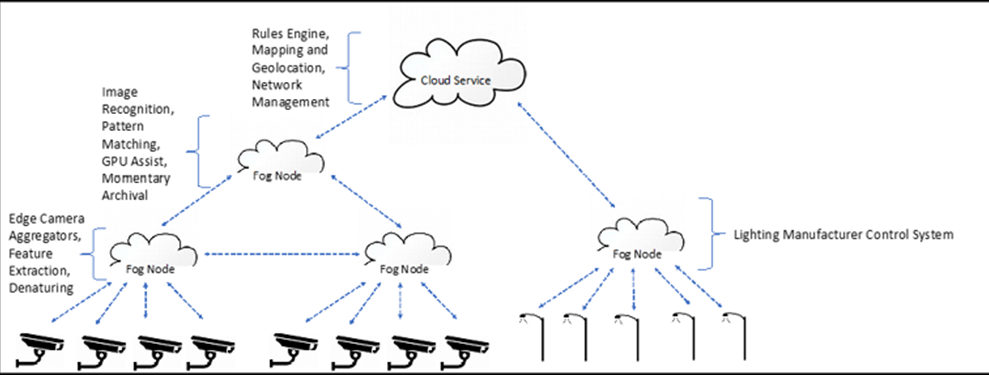

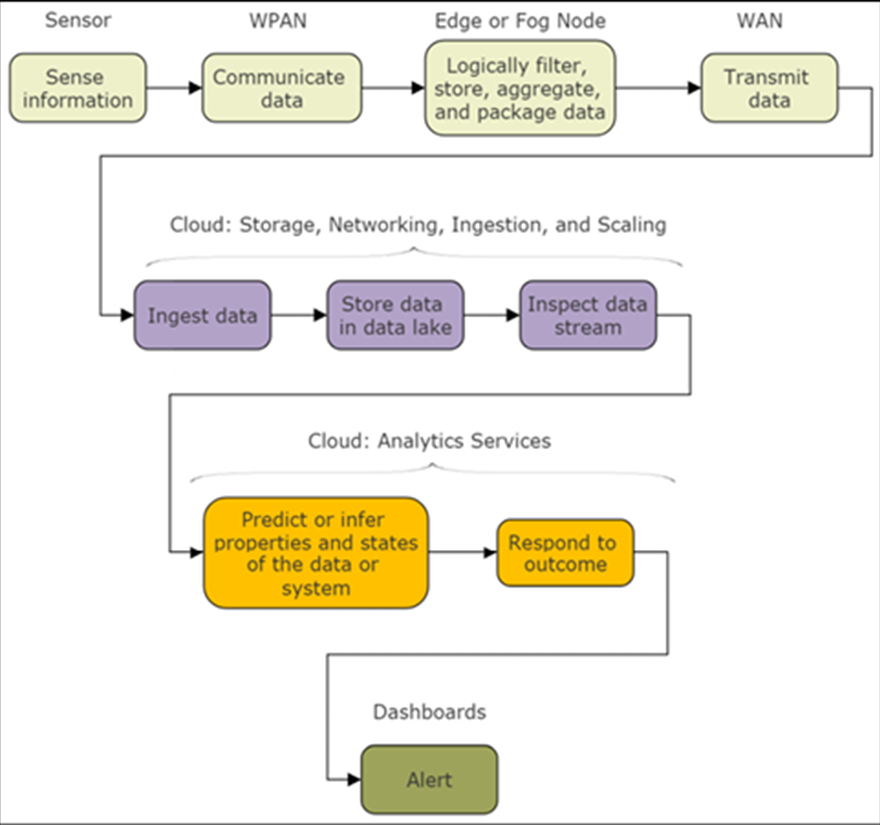

IoT et Edge Computing for Architects, Second Edition englobe tout le spectre des solutions IoT, des capteurs IoT au cloud. Il examine les systèmes de capteurs modernes, en se concentrant sur leur puissance et leur fonctionnalité. Il examine également la théorie de la communication, en accordant une attention particulière au PAN à courte portée, y compris la nouvelle spécification Bluetooth® 5.0 et les réseaux maillés. Ensuite, cet article explore la communication basée sur IP en LAN et WAN, y compris 802.11ah, cellulaire 5G LTE, Sigfox et LoRaWAN. Il explique également l’informatique de périphérie, le routage et les passerelles, et leur rôle dans l’informatique de brouillard, ainsi que les protocoles de messagerie de MQTT 5.0 et CoAP.

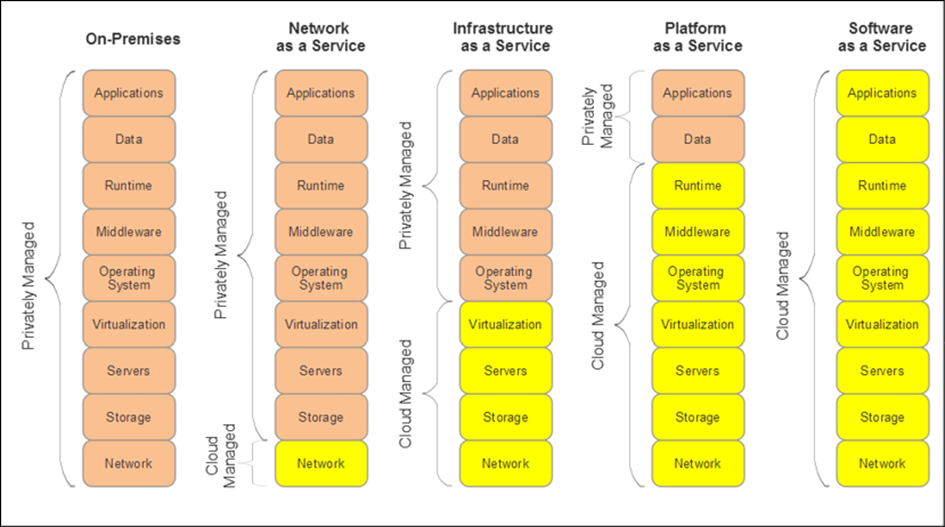

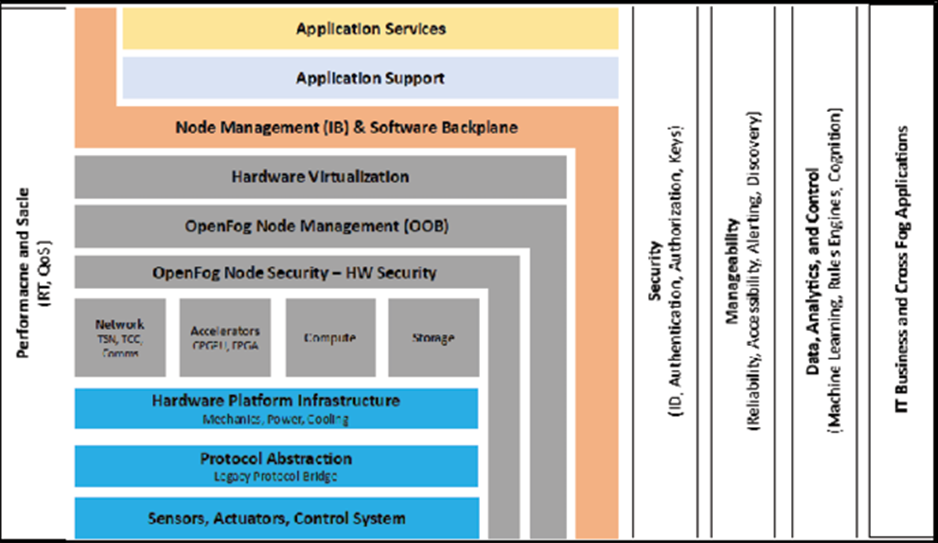

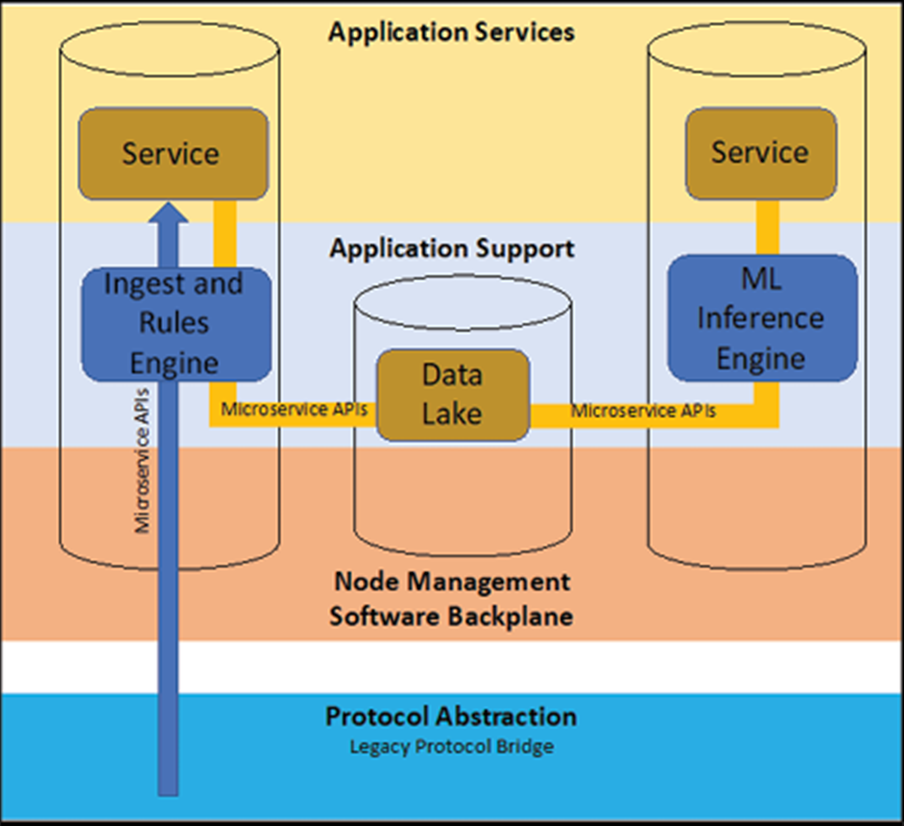

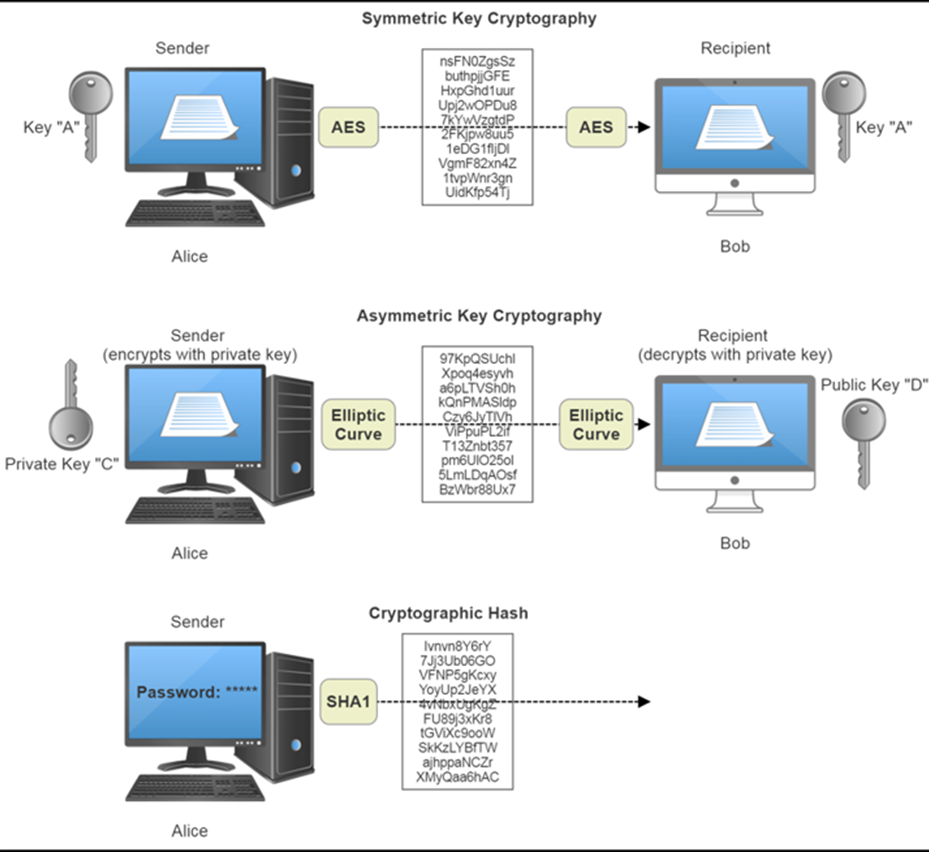

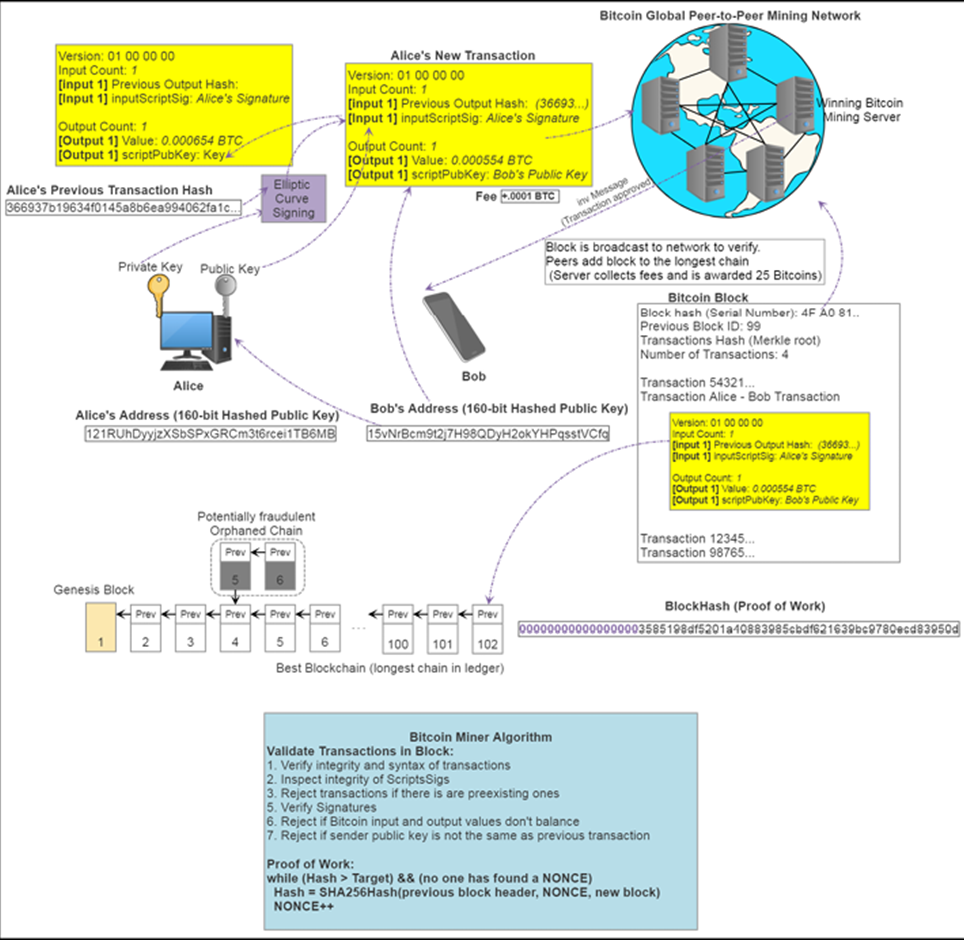

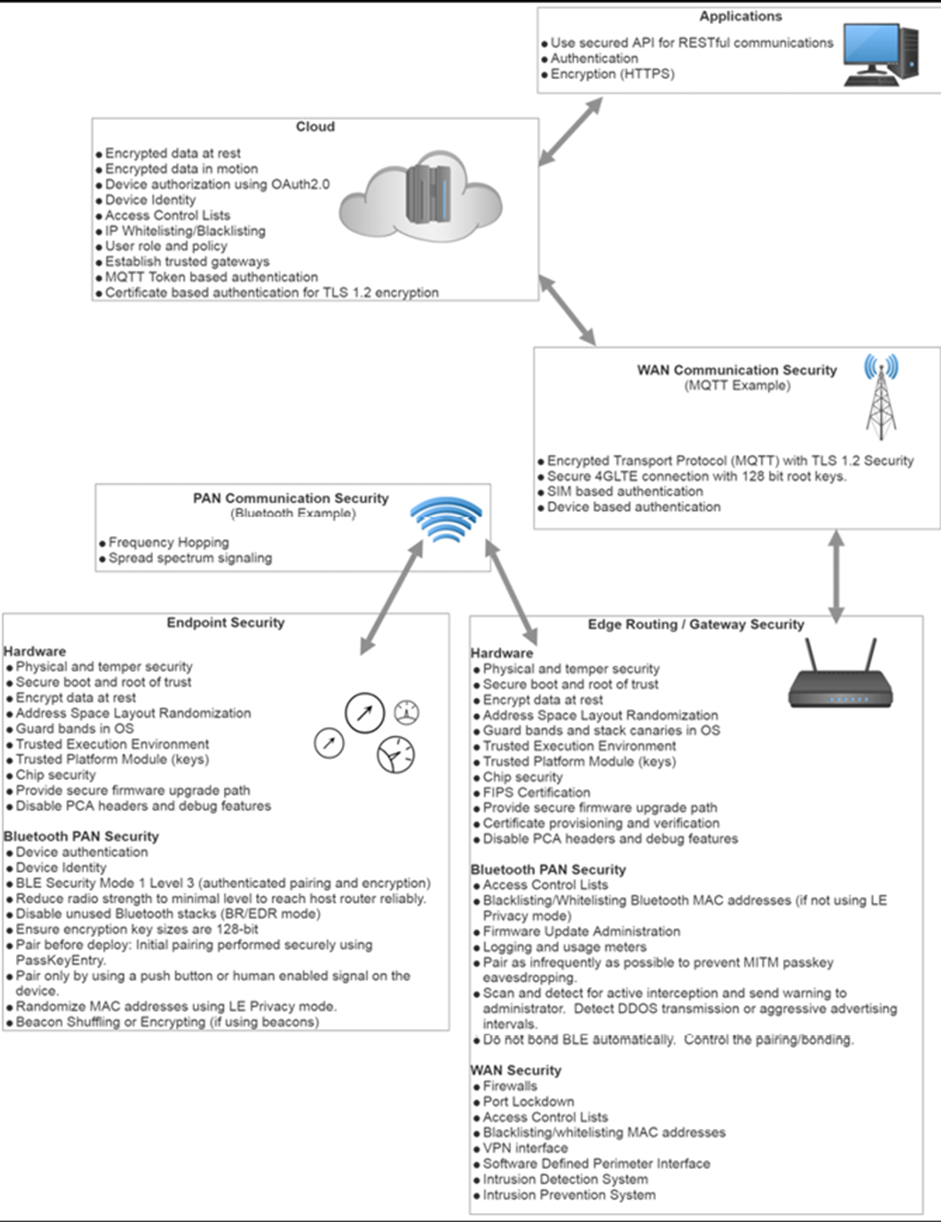

Avec les données maintenant sous forme Internet, vous aurez une compréhension des architectures cloud et Edge, y compris les normes OpenFog. Cet article conclut la partie analytique avec l’application de l’analyse statistique, du traitement des événements complexes et des modèles d’apprentissage en profondeur. Cet article conclut ensuite en fournissant une vue holistique de la sécurité IoT, de la cryptographie et de la sécurité du shell en plus des périmètres et des chaînes de blocs définis par logiciel.

Objectifs de la publication

- Comprendre le rôle et la portée de l’architecture d’un déploiement IoT réussi

- Analysez le paysage des technologies IoT, des capteurs au cloud et plus encore

- Voir les compromis dans les choix de protocoles et de communications dans les déploiements IoT

- Se familiariser avec la terminologie nécessaire pour travailler dans l’espace IoT

- Élargissez vos compétences dans les multiples domaines d’ingénierie nécessaires à l’architecte IoT

- Mettez en œuvre les meilleures pratiques pour garantir la fiabilité, l’évolutivité et la sécurité de votre infrastructure IoT

Caractéristiques clés

- Créez un système IoT complet qui convient le mieux à votre organisation

- Découvrez les différents concepts, technologies et compromis dans la pile architecturale IoT

- Comprendre la théorie et la mise en œuvre de chaque élément qui comprend la conception IoT

Ce que vous apprendrez

- Comprendre le rôle et la portée de l’architecture d’un déploiement IoT réussi

- Analysez le paysage des technologies IoT, des capteurs au cloud et plus encore

- Voir les compromis dans les choix de protocoles et de communications dans les déploiements IoT

- Se familiariser avec la terminologie nécessaire pour travailler dans l’espace IoT

- Élargissez vos compétences dans les multiples domaines d’ingénierie nécessaires à l’architecte IoT

- Mettez en œuvre les meilleures pratiques pour garantir la fiabilité, l’évolutivité et la sécurité de votre infrastructure IoT

À propos

Les industries adoptent les technologies IoT pour améliorer les dépenses opérationnelles, la durée de vie des produits et le bien-être des personnes. Un guide architectural est nécessaire si vous souhaitez parcourir le spectre des technologies nécessaires pour construire un système IoT réussi, qu’il s’agisse d’un seul appareil ou de millions d’appareils IoT.

IoT et Edge Computing for Architects, Second Edition englobe tout le spectre des solutions IoT, des capteurs IoT au cloud. Il examine les systèmes de capteurs modernes, en se concentrant sur leur puissance et leur fonctionnalité. Il examine également la théorie de la communication, en accordant une attention particulière au PAN à courte portée, y compris la nouvelle spécification Bluetooth® 5.0 et les réseaux maillés. Ensuite, cet article explore la communication basée sur IP en LAN et WAN, y compris 802.11ah, cellulaire 5G LTE, Sigfox et LoRaWAN. Il explique également l’informatique de périphérie, le routage et les passerelles, et leur rôle dans l’informatique de brouillard, ainsi que les protocoles de messagerie de MQTT 5.0 et CoAP.

Avec les données maintenant sous forme Internet, vous aurez une compréhension des architectures cloud et brouillard, y compris les normes OpenFog. Cet article conclut la partie analytique avec l’application de l’analyse statistique, du traitement des événements complexes et des modèles d’apprentissage en profondeur. Cet article conclut ensuite en fournissant une vue holistique de la sécurité IoT, de la cryptographie et de la sécurité du shell en plus des périmètres et des chaînes de blocs définis par logiciel.

1 IoT et Edge Computing Définition et cas d’utilisation

Vous vous réveillez le mardi 17 mai 2022, vers 6 h 30 PST, comme vous le faites toujours. Vous n’avez jamais vraiment eu besoin d’un réveil. Vous êtes l’un de ces types avec une certaine forme d’horloge physiologique. Vos yeux s’ouvrent sur une fantastique matinée ensoleillée alors qu’il s’approche de 70 ° F à l’extérieur. Vous participerez à une journée qui sera complètement différente de la matinée du mercredi 17 mai 2017. Tout sur votre journée, votre style de vie, votre santé, vos finances, votre travail, vos déplacements, même votre place de parking sera différente. Tout dans le monde dans lequel vous vivez sera différent : énergie, soins de santé, agriculture, fabrication, logistique, transports en commun, environnement, sécurité, shopping et même vêtements. Il s’agit de l’impact de la connexion d’objets ordinaires à Internet ou à l’Internet des objets (IoT). Je pense qu’une meilleure analogie est l’Internet de tout.

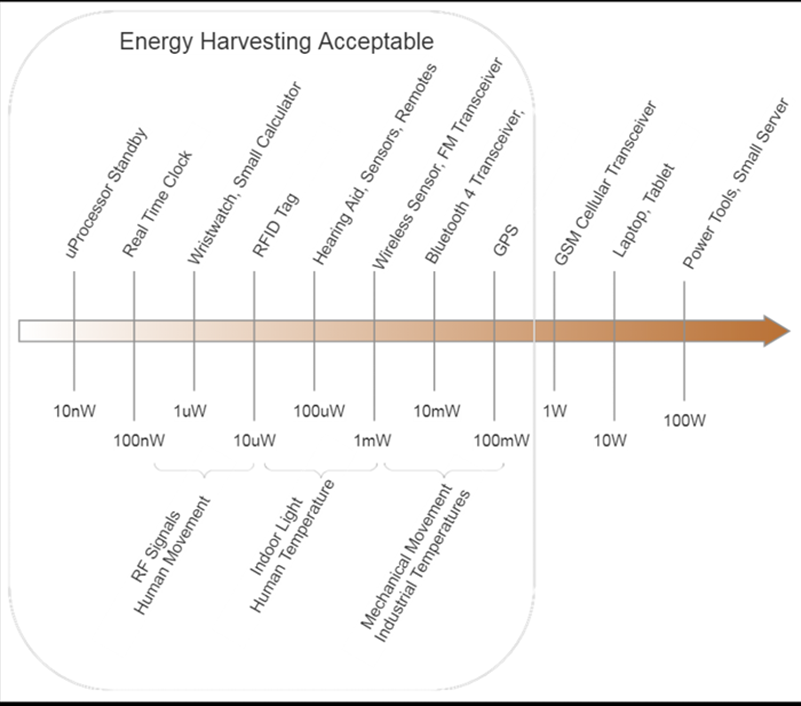

Avant même que vous ne vous réveilliez, il s’est passé beaucoup de choses dans l’IoT qui vous entoure. Votre comportement de sommeil a été surveillé par un capteur de sommeil ou un oreiller intelligent. Les données ont été envoyées à une passerelle IoT, puis transmises à un service cloud que vous utilisez gratuitement et qui sont transmises à un tableau de bord sur votre téléphone. Vous n’avez pas besoin d’un réveil, mais si vous aviez un vol à 5 heures du matin, vous le régleriez – à nouveau, contrôlé par un agent cloud utilisant le protocole if this, then that (IFTTT). Votre fournaise à deux zones est connectée à un autre fournisseur de cloud et est connectée au Wi-Fi 802.11 de votre maison, tout comme vos détecteurs de fumée, sonnette, systèmes d’irrigation, porte de garage, caméras de surveillance et système de sécurité. Votre chien est équipé d’un capteur de proximité utilisant une source de récupération d’énergie qui lui permet d’ouvrir la porte du chien et de vous dire où il se trouve.

Vous n’avez plus vraiment de PC. Vous avez certainement un ordinateur de style tablette et un smartphone comme périphérique de création central, mais votre monde est basé sur l’utilisation d’un casque VR / AR puisque l’écran est tellement meilleur et plus grand. Vous avez une passerelle informatique de pointe dans votre placard. Il est connecté à un fournisseur de services 5G pour vous connecter à Internet et au WAN car les connexions filaires ne fonctionnent pas pour votre style de vie – vous êtes mobile, connecté et en ligne, peu importe où vous êtes, et 5G et votre opérateur préféré s’assurent que votre expérience est parfait dans une chambre d’hôtel à Miami ou chez vous à Boise, en Idaho. La passerelle effectue également de nombreuses actions dans votre maison, telles que le traitement des flux vidéo de ces webcams pour détecter s’il y a eu une chute ou un accident dans la maison. Le système de sécurité est analysé pour détecter des anomalies (bruits étranges, fuites d’eau possibles, lumières laissées allumées, votre chien mâchant à nouveau les meubles). Le nœud périphérique agit également comme hub domestique, sauvegardant votre téléphone quotidiennement parce que vous avez tendance à les casser, et sert de cloud privé même si vous ne savez rien des services cloud.

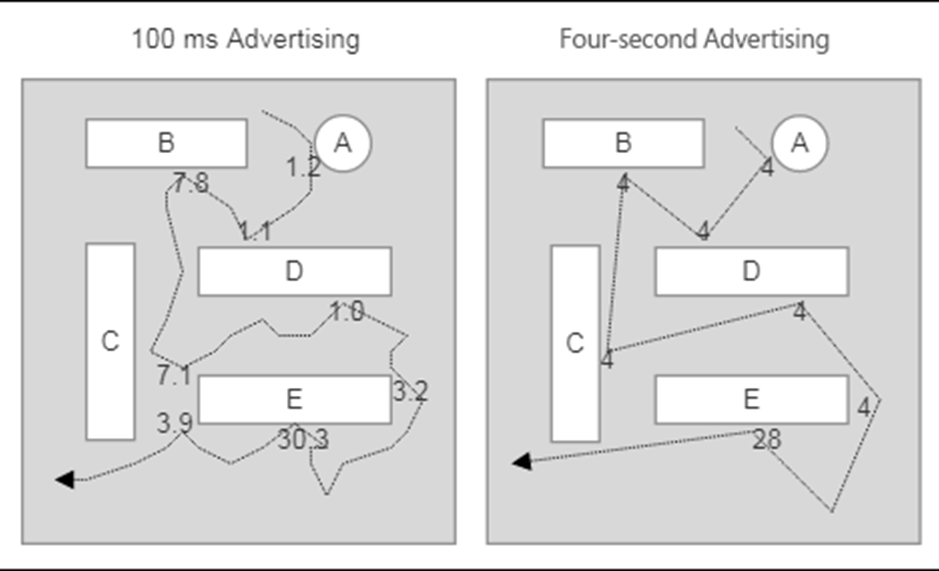

Vous roulez à vélo au bureau. Votre maillot de vélo utilise des capteurs imprimables et surveille votre fréquence cardiaque et votre température. Ces données sont diffusées simultanément via Bluetooth Low Energy sur votre smartphone pendant que vous écoutez le son Bluetooth diffusé depuis votre téléphone vers vos écouteurs Bluetooth. Sur le chemin, vous passez plusieurs panneaux d’affichage affichant tous des annonces vidéo et en temps réel. Vous vous arrêtez à votre café local et il y a un affichage numérique à l’avant vous appelant par son nom et vous demandant si vous voulez la dernière chose que vous avez commandée hier : un Americano de 12 oz avec place pour la crème. Il l’a fait par une balise et une passerelle reconnaissant votre présence à moins de cinq pieds et s’approchant de l’écran. Vous choisissez oui, bien sûr. La plupart des gens arrivent au travail via leur voiture et sont dirigés vers l’espace de stationnement optimal via des capteurs intelligents dans chaque emplacement de stationnement. Bien sûr, vous obtenez la place de stationnement optimale juste devant les autres cyclistes.

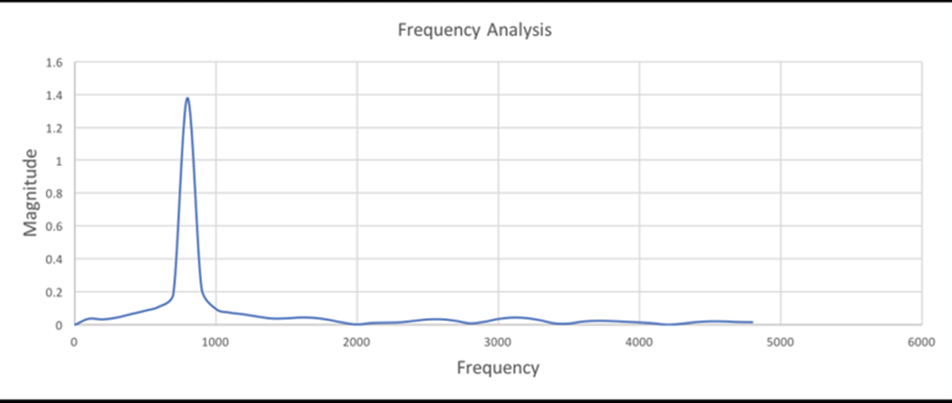

Votre bureau fait partie d’un programme d’énergie verte. Les politiques d’entreprise exigent un espace de bureau zéro émission. Chaque pièce a des capteurs de proximité pour détecter non seulement si une pièce est occupée, mais aussi qui est dans la pièce. Votre badge nominatif pour entrer au bureau est un dispositif de balisage sur une batterie de 10 ans. Votre présence est connue une fois que vous entrez dans la porte. Lumières, CVC, stores automatisés, ventilateurs de plafond, même affichage numérique sont connectés. Un nœud de brouillard central surveille toutes les informations du bâtiment et les synchronise avec un hôte cloud. Un moteur de règles a été mis en œuvre pour prendre des décisions en temps réel en fonction de l’occupation, de l’heure de la journée et de la saison de l’année, ainsi que des températures intérieures et extérieures. Les conditions environnementales augmentent ou diminuent pour maximiser l’utilisation de l’énergie. Il y a des capteurs sur les principaux disjoncteurs qui écoutent les modèles d’énergie et prennent une décision sur les nœuds de brouillard s’il y a des modèles étranges d’utilisation d’énergie qui doivent être examinés.

Il fait tout cela avec plusieurs algorithmes d’analyse et de machine learning en continu en temps réel qui ont été formés sur le cloud et poussés à la limite.

Le bureau héberge une petite cellule 5G pour communiquer à l’extérieur avec la porteuse en amont, mais il héberge également un certain nombre de passerelles à petites cellules en interne pour focaliser les signaux dans les limites du bâtiment. Le 5G interne fait également office de LAN.

Votre téléphone et votre tablette sont passés au signal 5G interne, et vous activez votre superposition réseau définie par logiciel et vous êtes instantanément sur le LAN de l’entreprise. Votre smartphone fait beaucoup de travail pour vous ; c’est essentiellement votre passerelle personnelle vers votre propre réseau personnel entourant votre corps. Vous passez à votre première réunion aujourd’hui, mais votre collègue n’est pas là et arrive quelques minutes en retard. Il s’excuse mais explique que sa volonté de travailler a été mouvementée.

Sa voiture plus récente a informé le constructeur d’un modèle d’anomalies dans le compresseur et le turbocompresseur. Le constructeur en a été immédiatement informé, et un représentant a appelé votre collègue pour l’informer que le véhicule a 70% de chances d’avoir un turbo défectueux dans les deux jours suivant son trajet habituel. Ils ont pris rendez-vous avec le concessionnaire et ont les nouvelles pièces qui arrivent pour réparer le compresseur. Cela lui a permis d’économiser des frais considérables pour remplacer le turbo et beaucoup d’aggravation.

Pour le déjeuner, l’équipe décide de sortir dans un nouveau lieu de tacos au centre-ville. Un groupe de quatre d’entre vous parvient à un coupé plus confortable pour deux et se fraye un chemin. Malheureusement, vous devrez vous garer dans l’une des structures de stationnement les plus chères.

Les tarifs de stationnement sont dynamiques et suivent une offre et une demande. En raison de certains événements et de la saturation des lots, les tarifs ont même doublé mardi midi. Du côté positif, les mêmes systèmes augmentant les frais de stationnement informent également votre voiture et votre smartphone exactement quels lots et quel espace pour conduire. Vous entrez l’adresse du taco au poisson, le lot et la capacité s’affichent et vous réservez une place avant votre arrivée. La voiture s’approche du portail, qui identifie la signature de votre téléphone, la plaque d’immatriculation ou une combinaison de plusieurs facteurs et s’ouvre. Vous conduisez sur place et l’application s’enregistre auprès du nuage de stationnement que vous êtes au bon endroit sur le bon capteur.

Cet après-midi, vous devez vous rendre sur le site de fabrication de l’autre côté de la ville. C’est un environnement d’usine typique : plusieurs machines de moulage par injection, des dispositifs de pick-and-place, des machines d’emballage et toute l’infrastructure de support. Récemment, la qualité du produit a chuté. Le produit final a des problèmes de connexion commune et est cosmétiquement inférieur au lot du mois dernier. Une fois arrivé sur le site, vous parlez au responsable et inspectez le site. Tout semble normal, mais la qualité a certainement été marginalisée. Vous vous rencontrez et montez les tableaux de bord de l’usine.

Le système utilise un certain nombre de capteurs (vibration, température, vitesse, vision et balises de suivi) pour surveiller le sol. Les données sont accumulées et visualisées en temps réel. Il existe un certain nombre d’algorithmes de maintenance prédictive surveillant les différents appareils pour détecter les signes d’usure et d’erreur. Ces informations sont également transmises au fabricant de l’équipement et à votre équipe. Les journaux d’automatisation de fabrication et de diagnostic n’ont détecté aucun modèle anormal, car ils avaient été formés par vos meilleurs experts. Cela ressemble au type de problème qui transformerait les heures en semaines et forcerait les meilleurs et les plus brillants de votre organisation à assister à des réunions d’équipe SWOT (forces, faiblesses, opportunités et menaces) quotidiennes coûteuses. Cependant, vous avez beaucoup de données. Toutes les données de l’usine sont conservées dans une base de données de stockage à long terme. Il y avait un coût pour ce service. Au début, le coût était difficile à justifier, mais maintenant vous pensez qu’il a peut-être été amorti mille fois. En prenant toutes ces données historiques à travers un processeur d’événements complexe et un package d’analyse, vous développez rapidement un ensemble de règles qui modélisent la qualité de vos pièces défaillantes. En travaillant en arrière sur les événements qui ont conduit aux échecs, vous vous rendez compte qu’il ne s’agit pas d’une défaillance ponctuelle, mais présente plusieurs aspects :

- La température interne de l’espace de travail a augmenté de 2 ° C pour conserver l’énergie pendant les mois d’été.

- L’assemblage a ralenti la production de 1,5% en raison de problèmes d’approvisionnement.

- L’une des machines de moulage approchait d’une période de maintenance prédictive, et la température et la vitesse d’assemblage ont poussé son boîtier défaillant au-dessus de la valeur prédite.

Vous avez trouvé le problème et recyclé les modèles de maintenance prédictive avec les nouveaux paramètres pour détecter ce cas à l’avenir. Dans l’ensemble, ce n’est pas une mauvaise journée de travail.

Bien que ce cas fictif puisse être vrai ou non, il est assez proche de la réalité aujourd’hui. Wikipédia définit l’IoT de cette façon : l’Internet des objets (IoT) est l’interconnexion des appareils physiques, des véhicules (également appelés “appareils connectés” et “appareils intelligents”), des bâtiments et d’autres éléments intégrés à l’électronique, aux logiciels, capteurs, actionneurs et connectivité réseau qui permettent à ces objets de collecter et d’échanger des données. ( https://en.wikipedia.org/wiki/internet_of_things )

1.1 Histoire de l’IoT

Le terme « IoT » peut très probablement être attribué à Kevin Ashton en 1997 et à son travail chez Procter and Gamble utilisant des étiquettes RFID pour gérer les chaînes d’approvisionnement. Le travail l’a amené au MIT en 1999, où lui et un groupe de personnes partageant les mêmes idées ont lancé le consortium de recherche Auto-ID Center (pour plus d’informations, visitez http://www.smithsonianmag.com/innovation/kevin-ashton-describes- l’internet des objets-180953749/ ).

Depuis lors, l’IoT est passé de simples balises RFID à un écosystème et à une industrie qui compteront 1 billion d’appareils connectés à Internet d’ici 2030. Le concept des choses connectées à Internet jusqu’en 2012 était principalement des smartphones, tablettes, PC et ordinateurs portables. Essentiellement, les choses qui ont d’abord fonctionné à tous égards comme un ordinateur. Depuis les humbles débuts d’Internet, à commencer par ARPANET en 1969, la plupart des technologies entourant l’IoT n’existaient pas. Jusqu’en 2000, la plupart des appareils associés à Internet étaient, comme indiqué, des ordinateurs de différentes tailles. La chronologie suivante montre la lente progression de la connexion des choses à Internet :

| Année | Périphérique | Référence |

| 1973 | Mario W. Cardullo reçoit le brevet pour la première étiquette RFID. | Brevet américain US 3713148 A |

| 1982 | Machine à soda connectée à Internet Carnegie Mellon. | https://www.cs.cmu.edu/~coke/history_long.txt |

| 1989 | Grille-pain connecté à Internet à Interop ’89. | IEEE Consumer Electronics Magazine (Volume : 6, numéro : 1, janvier 2017) |

| 1991 | HP présente HP LaserJet IIISi: la première imprimante réseau connectée à Ethernet. | http://hpmuseum.net/display_item.php?hw=350 |

| 1993 | Cafetière connectée à Internet à l’Université de Cambridge (la première caméra connectée à Internet). | https://www.cl.cam.ac.uk/coffee/qsf/coffee.html |

| 1996 | General Motors OnStar (2001 télédiagnostic). | https://en.wikipedia.org/wiki/OnStar |

| 1998 | Création du Bluetooth Special Interest Group (SIG). | https://www.bluetooth.com/about-us/our-history |

| 1999 | Réfrigérateur LG Internet Digital GOD. | https://www.telecompaper.com/news/lg-unveils-internetready-refrigerator–221266 |

| 2000 | Premiers exemples du concept Cooltown de l’informatique omniprésente partout: HP Labs, un système de technologies informatiques et de communication qui, combinées, créent une expérience connectée au Web pour les personnes, les lieux et les objets. | https://www.youtube.com/watch?v=U2AkkuIVV-I |

| 2001 | Premier produit Bluetooth lancé: le téléphone mobile compatible KDDI Bluetooth. | http://edition.cnn.com/2001/BUSINESS/asia/04/17/tokyo.kddibluetooth/index.html |

| 2005 | Le rapport de l’Union internationale des télécommunications des Nations Unies prédit pour la première fois la montée de l’IoT. | http://www.itu.int/osg/spu/publications/internetofthings/internetofThings_summary.pdf |

| 2008 | IPSO Alliance s’est formée pour promouvoir la propriété intellectuelle sur les objets, première alliance axée sur l’IoT. | https://www.ipso-alliance.org |

| 2010 | Le concept de Smart Lighting s’est formé après avoir réussi à développer des ampoules LED à semi-conducteurs. | https://www.bu.edu/smartlighting/files/2010/01/BobK.pdf |

| 2014 | Apple crée le protocole iBeacon pour les balises. | https://support.apple.com/en-us/HT202880 |

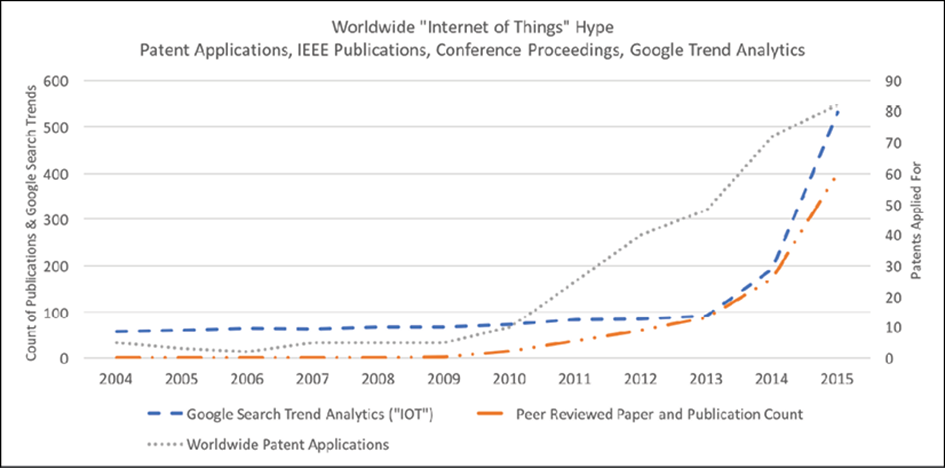

Certes, le terme IoT a suscité beaucoup d’intérêt et de battage médiatique. On peut facilement voir cela du point de vue d’un mot à la mode. Le nombre de brevets délivrés ( https://www.uspto.gov ) a augmenté de façon exponentielle depuis 2010. Le nombre de recherches Google ( https://trends.google.com/trends/ ) et de publications papier évaluées par des pairs IEEE a atteint le genou de la courbe en 2013:

Figure 1: Analyse des recherches par mots clés pour l’IoT, les brevets et les publications techniques

1.2 Potentiel IoT

L’IoT affecte déjà tous les segments des produits industriels, d’entreprise, de santé et de consommation. Il est important de comprendre l’impact, ainsi que les raisons pour lesquelles ces industries insensées seront obligées de changer dans la façon dont elles fabriquent des produits et fournissent des services. Peut-être que votre rôle d’architecte vous oblige à vous concentrer sur un segment particulier ; Cependant, il est utile de comprendre le chevauchement avec d’autres cas d’utilisation.

Comme mentionné précédemment, il existe une opinion selon laquelle l’impact des industries, des services et du commerce liés à l’IoT affectera 3% (La route vers un billion d’appareils, ARM Ltd 2017) à 4% (L’Internet des objets : cartographier la valeur au-delà de la Hype, McKinsey and Company 2015) du PIB mondial d’ici 2020 (extrapolé). Le PIB mondial pour 2016 était de 75,64 billions de dollars, avec une estimation qu’en 2020, il s’élèvera à 81,5 billions de dollars. Cela fournit une gamme de valeur allant des solutions IoT de 2,4 billions de dollars à environ 4,9 billions de dollars.

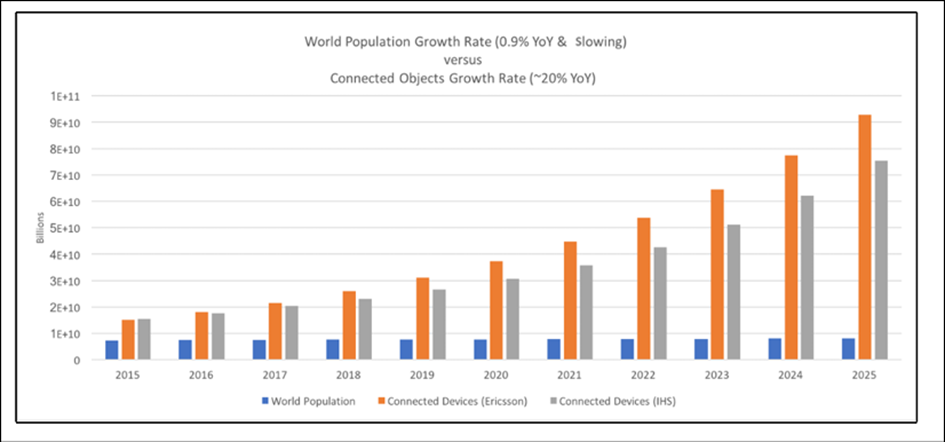

L’échelle des objets connectés est sans précédent. La spéculation sur la croissance de l’industrie est menacée par des risques. Pour aider à normaliser l’impact, nous examinons plusieurs sociétés de recherche et des rapports sur le nombre d’objets connectés. La plage est large, mais toujours dans le même ordre de grandeur. La moyenne de ces 10 prévisions d’analystes est d’environ 33,4 milliards d’objets connectés d’ici 2020-2021. ARM a récemment mené une étude et prévu que d’ici 2035, un billion d’appareils connectés seront opérationnels. Par tous les comptes, le taux de croissance du déploiement de l’IoT à court terme est d’environ 20% sur un an.

Figure 2 : Analystes et déclarations de l’industrie sur le nombre d’objets connectés

Ces chiffres devraient à première vue impressionner le lecteur. Par exemple, si nous adoptions une position très conservatrice et prévoyions que seuls 20 milliards de nouveaux appareils connectés seraient déployés (à l’exclusion des produits informatiques et mobiles traditionnels), nous dirions que 211 nouveaux objets connectés à Internet seront mis en ligne chaque seconde.

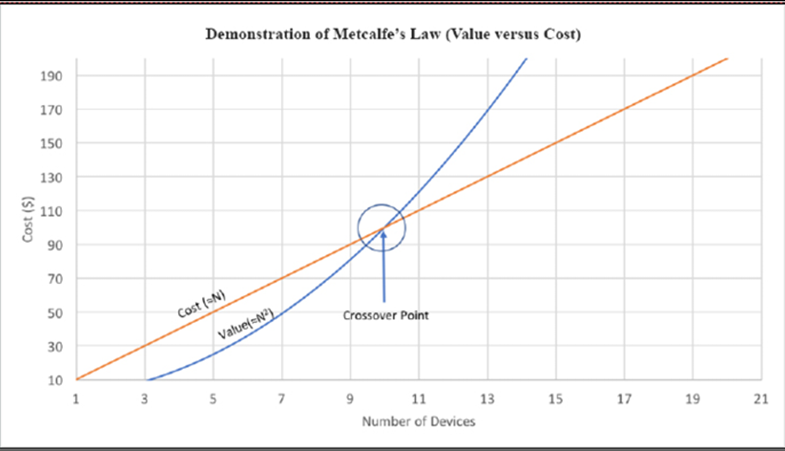

Pourquoi cela est important pour l’industrie technologique et le secteur informatique est le fait que la population mondiale a actuellement un taux de croissance d’environ 0,9% à 1,09% par an ( https://esa.un.org/unpd/wpp/ ). Le taux de croissance de la population mondiale a culminé en 1962 à 2,6 pour cent d’une année à l’autre et n’a cessé de diminuer en raison d’un certain nombre de facteurs. D’abord et avant tout, l’amélioration du PIB mondial et des économies a tendance à réduire les taux de natalité. D’autres facteurs incluent les guerres et la famine. Cette croissance implique que les objets connectés par l’homme atteindront un plateau et que la machine à machine ( M2M ) et les objets connectés représenteront la majorité des appareils connectés à Internet. Ceci est important car l’industrie informatique applique de la valeur à un réseau non pas nécessairement par la quantité de données consommées, mais par le nombre de connexions. C’est, d’une manière générale, la loi de Metcalfe, et nous en parlerons plus loin dans cet article. Il convient également de noter qu’après la mise en ligne du premier site Web public au CERN en 1990, il a fallu 15 années supplémentaires pour qu’un milliard de personnes soient des utilisateurs réguliers d’Internet. L’IoT cherche à ajouter 6 milliards d’appareils connectés par an. Bien sûr, cela influence l’industrie.

Figure 3 : La disparité entre la croissance de la population humaine et la croissance des objets connectés. La tendance a été une croissance de 20% des objets connectés contre une croissance humaine presque plate de 0,9%. Les humains ne dirigeront plus le réseau et la capacité informatique.

Il convient de noter que l’impact économique n’est pas uniquement la génération de revenus. L’impact de l’IoT ou de toute technologie se présente sous la forme de:

- De nouvelles sources de revenus (par exemple, des solutions d’énergie verte)

- Réduction des coûts (par exemple, soins de santé à domicile)

- Réduction du délai de mise sur le marché (par exemple, automatisation d’usine)

- Amélioration de la logistique de la chaîne d’approvisionnement (par exemple, suivi des actifs)

- Réduction des pertes de production (par exemple, vol ou détérioration de denrées périssables)

- Augmentation de la productivité (par exemple, apprentissage automatique et analyse des données)

- Cannibalisation (par exemple, Nest remplace les thermostats traditionnels)

Dans notre discussion tout au long de cet article, nous devrions nous préoccuper de la valeur d’une solution IoT. S’il s’agit simplement d’un nouveau gadget, le marché sera limité. Ce n’est que lorsque l’avantage prévisible l’emportera sur le coût qu’une industrie prospérera.

De manière générale, l’objectif utilisé devrait être une amélioration de 5 fois par rapport à une technologie traditionnelle. C’est mon objectif dans l’industrie informatique. Lorsque l’on considère le coût du changement, de la formation, de l’acquisition, du support, etc., un différentiel de 5x est une règle empirique équitable.

1.3 Définition de l’internet des objets

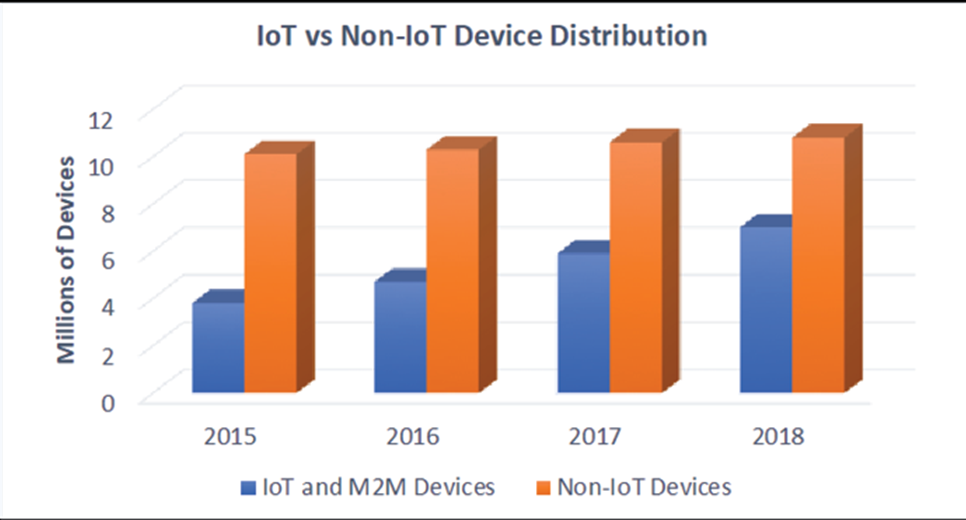

Il faut examiner certaines de ces affirmations avec un certain scepticisme. Il est presque impossible de quantifier le nombre exact d’appareils connectés à Internet. De plus, nous devons séparer les appareils qui sont naturellement connectés à Internet comme les smartphones, les PC, les serveurs, les routeurs de réseau et l’infrastructure informatique. Nous ne devrions pas non plus inclure dans le domaine de l’IoT les machines qui ont été présentes dans les bureaux, les maisons et les lieux de travail pendant des décennies et qui sont essentiellement connectées via une forme de mise en réseau. Nous n’incluons pas les imprimantes, copieurs ou scanners de bureau dans le spectre IoT.

Cet article examinera l’IoT du point de vue de la connexion d’appareils qui ne sont pas nécessairement connectés entre eux ou à Internet. Historiquement, ces appareils peuvent n’avoir que peu ou pas de capacités de calcul ou de communication. Par cela, nous supposons que les appareils ont historiquement eu des limites de coût, de puissance, d’espace, de poids, de taille ou thermiques.

Comme nous le voyons dans l’histoire des appareils IoT, la connexion d’objets traditionnellement non connectables comme les réfrigérateurs à Carnegie Mellon est possible depuis le début des années 1980, mais le coût était important. Il nécessitait la puissance de traitement d’un ordinateur central DEC PDP11. La loi de Moore démontre l’augmentation du nombre et de la densité des transistors dans les chipsets en silicium, tandis que la mise à l’échelle de Dennard améliore le profil de puissance des ordinateurs. Avec ces deux tendances, nous produisons maintenant des appareils qui utilisent des processeurs plus puissants et une capacité de mémoire accrue et exécutons des systèmes d’exploitation capables d’exécuter une pile réseau complète. Ce n’est qu’avec le respect de ces exigences que l’IoT est devenu une industrie à part entière.

Les exigences de base d’un appareil pour être considéré comme faisant partie de l’IoT :

- Capable par ordinateur d’héberger une pile logicielle de protocole Internet

- Matériel et alimentation capables d’utiliser un transport réseau tel que 802.3

- Pas un périphérique connecté à Internet traditionnel, tel qu’un PC, un ordinateur portable, un smartphone, un serveur, un appareil de centre de données, une machine de productivité de bureau ou une tablette

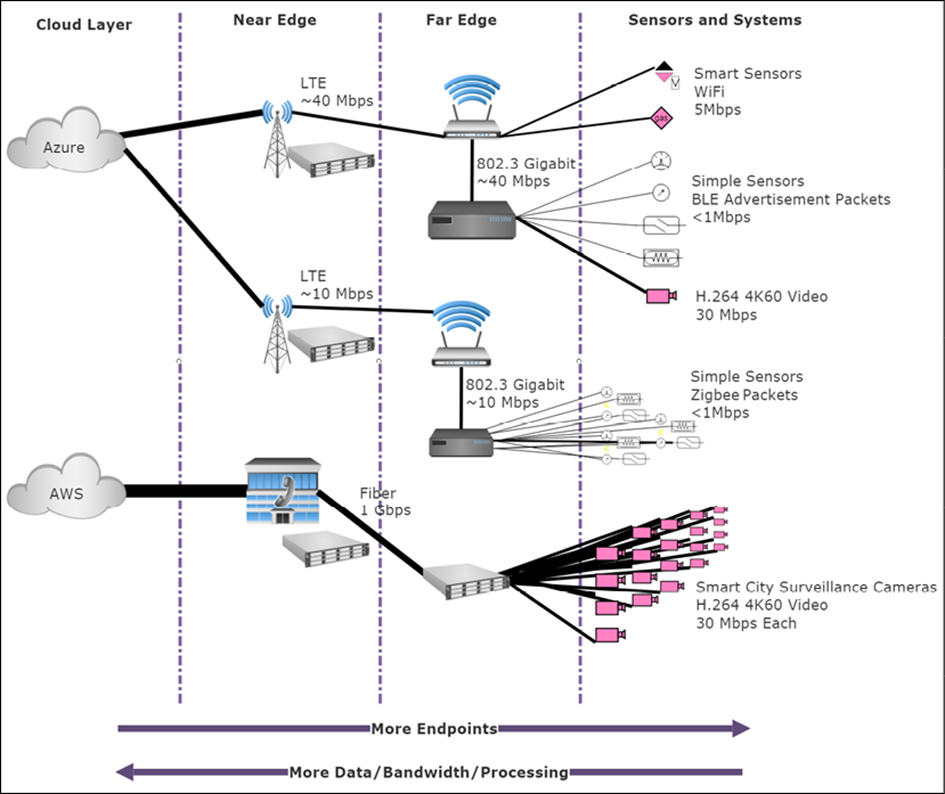

Nous incluons également des appareils « de pointe » dans cet article. Les appareils Edge eux-mêmes peuvent être des appareils IoT ou peuvent “héberger” des appareils IoT. Les périphériques Edge, comme détaillé plus loin dans cet article, seront généralement des nœuds informatiques gérés qui s’étendent plus près des sources de génération ou d’action des données. Ce ne sont peut-être pas des serveurs et des clusters typiques des centres de données, mais de l’espace, de l’alimentation et des appareils durcis pour l’environnement qui sont sur le terrain. Par exemple, une lame de centre de données serait constituée d’une électronique optimisée pour l’atmosphère à température contrôlée d’une batterie de serveurs avec des allées chaudes et froides, des échangeurs de chaleur et des alimentations sans coupure. Les dispositifs Edge peuvent être trouvés à l’extérieur et exposés à des éléments météorologiques et dans des zones où une alimentation constante et cohérente n’est pas une option. D’autres fois, ils peuvent inclure des nœuds de serveur traditionnels, mais en dehors des contraintes d’un centre de données.

Compte tenu de ces critères, la taille réelle du marché de l’IoT est inférieure aux prévisions des analystes. Lorsque nous séparons les appareils informatiques et connectés à Internet traditionnels des appareils IoT, nous constatons un taux de croissance différent, comme le montre la figure suivante.

Figure 4 : Séparation du volume des ventes d’appareils IoT par définition des appareils non IoT (par exemple, équipement informatique et informatique mobile)

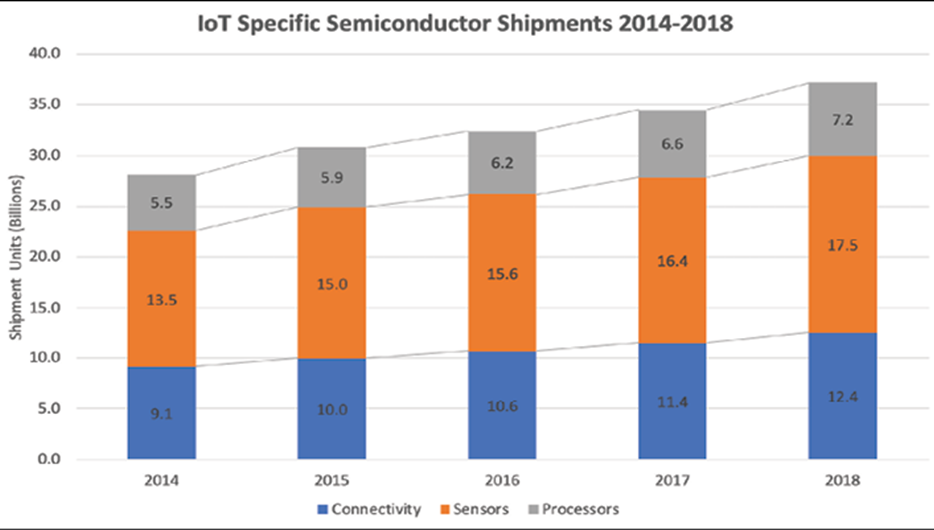

Une analyse plus approfondie des composants réels utilisés dans les appareils IoT révèle un autre modèle intéressant. Comme déjà mentionné, la plupart des appareils connectés à Internet nécessitent un certain niveau de performances et de matériel pour communiquer via des protocoles standard. Pourtant, le graphique suivant montre une différence entre le nombre de puces de communication et de processeurs par rapport au nombre de capteurs livrés. Cela renforce le concept selon lequel il existe un large éventail de capteurs vers les ordinateurs de bord et les appareils de communication.

Figure 5 : Tendance des ventes de capteurs, processeurs et circuits intégrés de communication dans les ventes IoT

Ce qui est remarquable, c’est que la plupart des installations IoT ne sont pas un seul appareil qui a la capacité d’exécuter une pile matérielle et logicielle Internet. La plupart des capteurs et appareils n’ont pas la capacité d’accéder directement à Internet. Ils n’ont pas les capacités de traitement, les ressources de mémoire et la distribution d’énergie requises pour une connectivité Internet complète. Au contraire, une grande partie de ce qui est vraiment l’IoT repose sur des passerelles et des ordinateurs de périphérie dans un modèle de hub et de rayons. Il existe un large éventail d’appareils qui se connectent aux ordinateurs périphériques via des réseaux locaux personnels, des réseaux non IP (Bluetooth), des protocoles industriels (ModBus), des protocoles de friches industrielles héritées (RS232) et des signaux matériels.

1.3.1 Industrie et fabrication

L’IoT industriel (IIoT) est l’un des segments les plus dynamiques et les plus importants de l’espace IoT global par le nombre de choses connectées et la valeur que ces services apportent à la fabrication et à l’automatisation des usines. Ce segment a traditionnellement été le monde de la technologie des opérations (OT). Cela implique des outils matériels et logiciels pour surveiller les appareils physiques en temps réel. Historiquement, ces systèmes étaient des ordinateurs et des serveurs sur site pour gérer les performances et les sorties de l’usine. Nous appelons ces systèmes le contrôle de supervision et l’acquisition de données (SCADA). Les rôles informatiques traditionnels ont été administrés différemment des rôles OT. OT sera concerné par les mesures de rendement, la disponibilité, la collecte et la réponse des données en temps réel et la sécurité des systèmes. Le rôle informatique se concentrera sur la sécurité, les regroupements, la livraison de données et les services. Alors que l’IoT devient répandu dans l’industrie et la fabrication, ces mondes se combineront en particulier avec la maintenance prédictive de milliers de machines d’usine et de production pour fournir une quantité sans précédent de données aux infrastructures de cloud privé et public.

Certaines des caractéristiques de ce segment incluent la nécessité de fournir des décisions en temps quasi réel ou en temps réel pour OT. Cela signifie que la latence est un problème majeur pour l’IoT en usine.

De plus, les temps d’arrêt et la sécurité sont les principales préoccupations. Cela implique la nécessité d’une redondance et éventuellement de réseaux cloud privés et d’un stockage des données. Le segment industriel est l’un des marchés à la croissance la plus rapide. Une nuance de cette industrie est la dépendance à l’égard de la technologie des friches industrielles, c’est-à-dire des interfaces matérielles et logicielles qui ne sont pas courantes. Il arrive souvent que des machines de production vieilles de 30 ans s’appuient sur des interfaces série RS485 plutôt que sur des mailles sans fil modernes.

1.3.2 Cas d’utilisation de l’IoT industriel et manufacturier

Voici les cas d’utilisation de l’IoT industriel et manufacturier et leur impact :

- Maintenance préventive sur les machines d’usine neuves et préexistantes

- Augmentation du débit grâce à la demande en temps réel

- Économies d’énergie

- Systèmes de sécurité tels que la détection thermique, la détection de pression et les fuites de gaz

- Systèmes experts de plancher d’usine

1.3.3 Consommateur

Les appareils grand public ont été l’un des premiers segments à adopter des objets connectés à Internet. L’IdO grand public a d’abord pris la forme d’une cafetière connectée dans une université dans les années 1990. Il a prospéré avec l’adoption de Bluetooth pour une utilisation grand public au début des années 2000.

Des millions de foyers disposent désormais de thermostats Nest, d’ampoules Hue, d’assistants Alexa et de décodeurs Roku. Les gens sont également connectés avec Fitbits et d’autres technologies portables. Le marché de la consommation est généralement le premier à adopter ces nouvelles technologies. Nous pouvons également les considérer comme des gadgets. Tous sont des appareils soigneusement emballés et emballés qui sont essentiellement plug and play.

L’une des contraintes du marché de la consommation est la bifurcation des normes. Nous voyons, par exemple, plusieurs protocoles WPAN ont un jogging comme Bluetooth, Zigbee et Z-wave (tous étant non interopérables).

Ce segment a également des traits communs avec le marché des soins de santé, qui a des appareils portables et des moniteurs de santé à domicile. Nous les séparons pour cette discussion, et les soins de santé vont se développer au-delà des simples appareils de santé connectés à domicile (par exemple, au-delà des fonctionnalités d’un Fitbit).

1.3.4 Cas d’utilisation IoT grand public

Voici quelques-uns des cas d’utilisation IoT grand public :

- Gadgets pour la maison intelligente : irrigation intelligente, portes de garage intelligentes, serrures intelligentes, lumières intelligentes, thermostats intelligents et sécurité intelligente

- Wearables : trackers de santé et de mouvement, vêtements intelligents / wearables

- Animaux de compagnie : systèmes de localisation pour animaux de compagnie, portes intelligentes pour chiens

1.3.5 Commerce de détail, finance et marketing

Cette catégorie fait référence à tout espace où le commerce axé sur le consommateur effectue des transactions. Cela peut être un magasin de brique et de mortier ou un kiosque pop-up. Il s’agit notamment des services bancaires traditionnels et des assureurs, mais également des services de loisirs et d’accueil. L’impact de l’IdO sur le commerce de détail est déjà en cours, dans le but de réduire les coûts de vente et d’améliorer l’expérience client. Cela se fait avec une myriade d’outils IoT. Pour plus de simplicité dans cet article, nous ajoutons également de la publicité et du marketing à cette catégorie.

Ce segment mesure la valeur des transactions financières immédiates. Si la solution IoT ne fournit pas cette réponse, son investissement doit être examiné de près. Cela crée des contraintes sur la recherche de nouvelles façons soit de réduire les coûts, soit de générer des revenus. Permettre aux clients d’être plus efficaces permet aux détaillants et aux industries de services d’offrir une meilleure expérience client tout en minimisant les frais généraux et les pertes de coûts de vente.

1.3.6 Cas d’utilisation de l’IoT pour la vente au détail, la finance et le marketing

Certains des cas d’utilisation de l’IoT sont les suivants :

- Publicité ciblée, comme la localisation de clients connus ou potentiels par proximité et la fourniture d’informations sur les ventes.

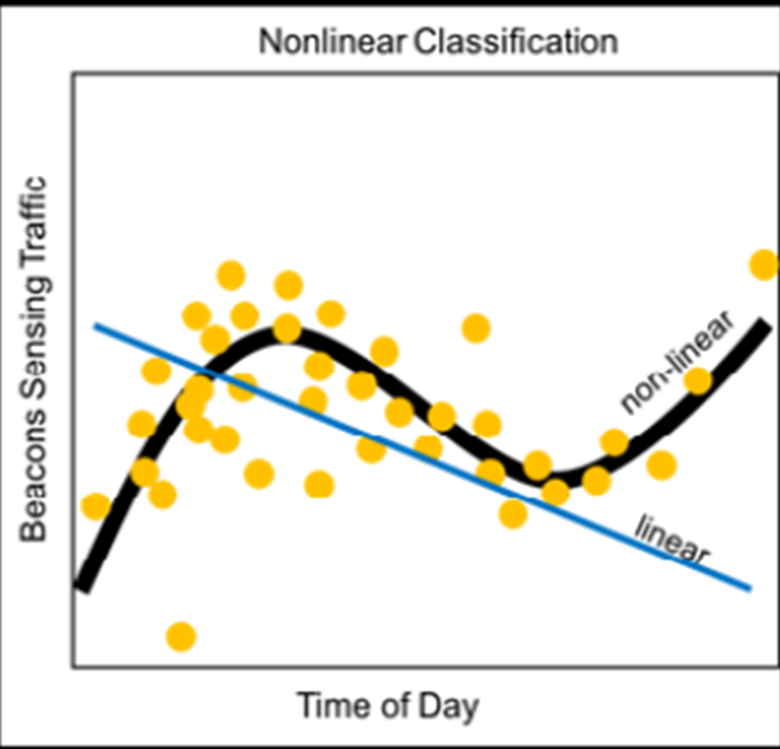

- Le balisage, comme la détection des clients à proximité, les modèles de trafic et les heures entre les arrivées comme analyses marketing.

- Suivi des actifs, comme le contrôle des stocks, le contrôle des pertes et les optimisations de la chaîne d’approvisionnement.

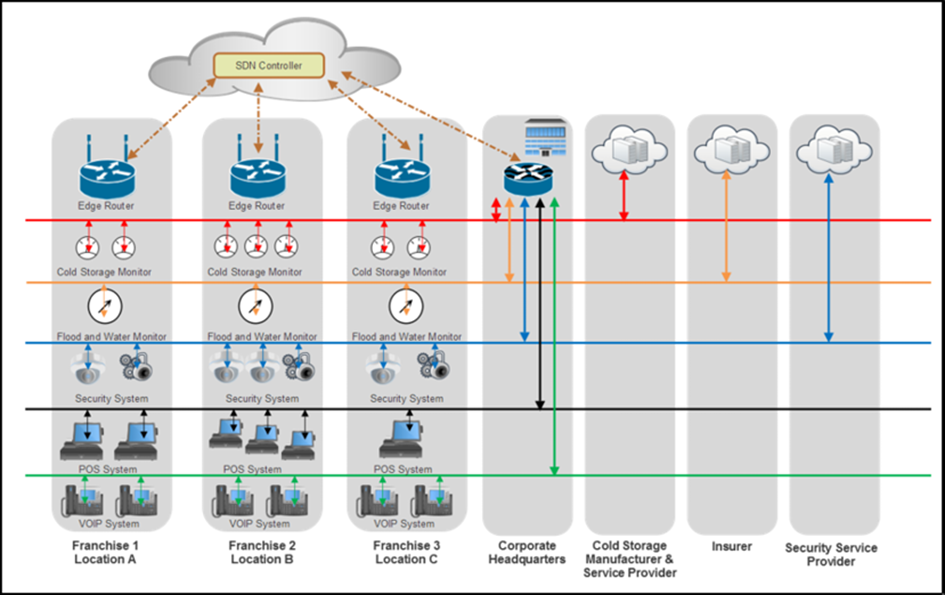

- Surveillance du stockage à froid, telle que l’analyse du stockage à froid des stocks périssables. Appliquer des analyses prédictives à l’approvisionnement alimentaire.

- Assurer le suivi des actifs.

- Mesure du risque d’assurance des conducteurs.

- Affichage numérique dans le commerce de détail, l’hôtellerie ou la ville.

- Systèmes de balisage dans les lieux de divertissement, les conférences, les concerts, les parcs d’attractions et les musées.

1.3.7 Santé

L’industrie des soins de santé affrontera la fabrication et la logistique pour la première place des revenus et de l’impact sur l’IoT. Tous les systèmes qui améliorent la qualité de vie et réduisent les coûts de santé sont une préoccupation majeure dans presque tous les pays développés. L’IoT est prêt à permettre une surveillance à distance et flexible des patients où qu’ils se trouvent.

Des outils d’analyse et d’apprentissage automatique avancés observeront les patients afin de diagnostiquer la maladie et de prescrire des traitements. Ces systèmes seront également les chiens de garde en cas de soins vitaux nécessaires. Actuellement, il existe environ 500 millions de moniteurs de santé portables, avec une croissance à deux chiffres dans les années à venir.

Les contraintes pesant sur les systèmes de santé sont importantes. De la conformité HIPAA à la sécurité des données, les systèmes IoT doivent agir comme des outils et équipements de qualité hospitalière. Les systèmes de terrain doivent communiquer avec les centres de santé 24h / 24 et 7j / 7, de manière fiable et sans interruption si le patient est surveillé à domicile. Les systèmes peuvent devoir être sur un réseau hospitalier tout en surveillant un patient dans un véhicule d’urgence.

1.3.8 Cas d’utilisation de l’IoT pour les soins de santé

Certains des cas d’utilisation de l’IoT dans le domaine de la santé sont les suivants :

- Soins aux patients à domicile

- Modèles d’apprentissage des soins de santé prédictifs et préventifs

- Démence et soins et suivi des personnes âgées

- Équipement hospitalier et suivi des actifs d’approvisionnement

- Suivi pharmaceutique et sécurité

- Médecine à distance

- Recherche sur les médicaments

- Indicateurs de chute du patient

1.3.9 Transport et logistique

Le transport et la logistique seront un moteur important, sinon le principal moteur de l’IoT. Les cas d’utilisation impliquent l’utilisation d’appareils pour suivre les actifs livrés, transportés ou expédiés, que ce soit sur un camion, un train, un avion ou un bateau. C’est aussi le domaine des véhicules connectés qui communiquent pour proposer une assistance au conducteur, ou une maintenance préventive pour le compte du conducteur. À l’heure actuelle, un véhicule moyen acheté neuf a environ 100 capteurs. Ce nombre doublera alors que la communication de véhicule à véhicule, la communication de véhicule à route et la conduite automatisée deviendront des caractéristiques incontournables pour la sécurité ou le confort. Cela a des rôles importants au-delà des véhicules de consommation et s’étend aux lignes ferroviaires et aux flottes de navigation qui ne peuvent se permettre aucun temps d’arrêt. Nous verrons également des camions de service qui peuvent suivre des actifs tels que les outils des travailleurs, l’équipement de construction et d’autres actifs précieux. Certains des cas d’utilisation peuvent être très simples, mais aussi très coûteux, comme la surveillance de l’emplacement des véhicules de service dans la livraison du stock.

Des systèmes sont nécessaires pour acheminer automatiquement les camions et le personnel de service vers des emplacements basés sur la demande par rapport à la routine.

Cette catégorie de type mobile nécessite une connaissance de la géolocalisation. Une grande partie de cela vient de la navigation GPS. Du point de vue IoT, les données analysées incluraient les actifs et le temps, mais également les coordonnées spatiales.

1.3.10 Cas d’utilisation de l’IoT pour le transport et la logistique

Voici quelques-uns des cas d’utilisation de l’IoT pour le transport et la logistique :

- Suivi de la flotte et connaissance de l’emplacement

- Planification, acheminement et surveillance des véhicules municipaux (déneigement, élimination des déchets)

- Transport en chambre froide et sécurité de livraison des aliments

- Identification et suivi des wagons

- Suivi des actifs et des colis au sein des flottes

- Entretien préventif des véhicules sur la route

1.3.11 Agriculture et environnement

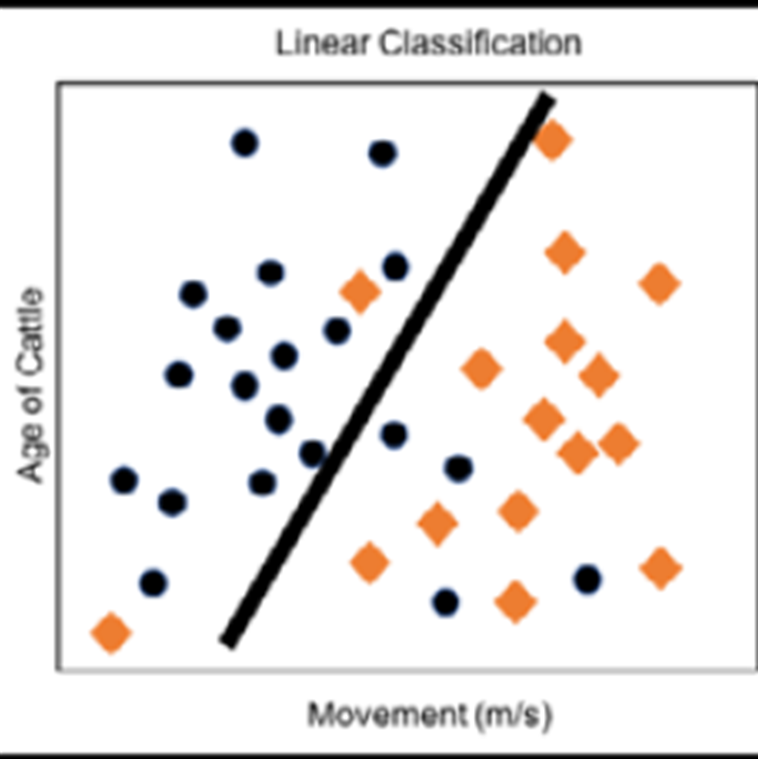

L’élevage et l’IdO environnemental comprennent des éléments de la santé du bétail, de l’analyse des terres et des sols, des prévisions micro-climatiques, une utilisation efficace de l’eau et même des prévisions de catastrophes dans le cas de catastrophes géologiques et météorologiques. Même si la croissance démographique mondiale ralentit, les économies mondiales deviennent plus riches. Même si les famines sont moins fréquentes qu’il y a 100 ans, la demande de production alimentaire devrait doubler d’ici 2035. Il est possible de réaliser d’importantes économies en agriculture grâce à l’IoT. L’utilisation d’un éclairage intelligent pour ajuster la fréquence du spectre en fonction de l’âge de la volaille peut augmenter les taux de croissance et diminuer les taux de mortalité en fonction du stress dans les élevages de poulets. De plus, les systèmes d’éclairage intelligents pourraient économiser 1 milliard de dollars par an en énergie par rapport à l’éclairage incandescent muet couramment utilisé. D’autres utilisations incluent la détection de la santé du bétail basée sur le mouvement et le positionnement des capteurs. Une ferme d’élevage pouvait trouver des animaux ayant la propension à la maladie avant qu’une infection bactérienne ou virale ne se propage. Les systèmes d’analyse de bord à distance pourraient trouver, localiser et isoler des têtes de bétail en temps réel, en utilisant des analyses de données ou des approches d’apprentissage automatique.

Ce segment a également la particularité d’être situé dans des zones reculées (volcans) ou dans des centres de population clairsemés (champs de maïs). Cela a des répercussions sur les systèmes de communication de données que nous devrons examiner plus loin dans le chapitre 5, WPAN non IP et le chapitre 7, Systèmes et protocoles de communication à longue portée (WAN).

1.3.12 Cas d’utilisation de l’IoT agricole et environnemental

Certains des cas d’utilisation de l’IoT agricole et environnemental sont les suivants :

- Techniques d’irrigation et de fertilisation intelligentes pour améliorer le rendement

- Éclairage intelligent en nidification ou en aviculture pour améliorer le rendement

- Santé du bétail et suivi des actifs

- Maintenance préventive des équipements agricoles à distance via le constructeur

- Relevés de terrain par drone

- Efficacité de la chaîne d’approvisionnement de la ferme au marché avec suivi des actifs

- Agriculture robotique

- Surveillance des volcans et des lignes de faille pour les catastrophes prédictives

1.3.13 Énergie

Le segment énergie comprend le suivi de la production d’énergie à la source de production pour le consommateur. Une quantité importante de recherche et développement s’est concentrée sur les moniteurs d’énergie grand public et commerciaux tels que les compteurs électriques intelligents qui communiquent via des protocoles à faible puissance et à longue portée pour révéler la consommation d’énergie en temps réel.

De nombreuses installations de production d’énergie se trouvent dans des environnements éloignés ou hostiles tels que les régions désertiques pour les panneaux solaires, les pentes abruptes pour les parcs éoliens et les installations dangereuses pour les réacteurs nucléaires. De plus, les données peuvent nécessiter une réponse en temps réel ou presque en temps réel pour les réponses critiques aux systèmes de contrôle de la production d’énergie (un peu comme les systèmes de fabrication). Cela peut avoir un impact sur le déploiement d’un système IoT dans cette catégorie. Nous parlerons des problèmes de réactivité en temps réel plus loin dans cet article.

1.3.14 Cas d’utilisation Energy IoT

Voici quelques cas d’utilisation de l’IoT énergétique :

- Analyse de plate-forme pétrolière de milliers de capteurs et de points de données pour des gains d’efficacité

- Surveillance et maintenance des panneaux solaires à distance

- Analyse dangereuse des installations nucléaires

- Compteurs électriques, de gaz et d’eau intelligents dans un déploiement à l’échelle de la ville pour surveiller l’utilisation et la demande

- Tarifs selon l’heure

- Réglages des pales en temps réel en fonction des conditions météorologiques sur les éoliennes à distance

1.3.15 Ville intelligente

«Ville intelligente» est une expression utilisée pour désigner une infrastructure connectée et intelligente, des citoyens et des véhicules. Les villes intelligentes sont l’un des segments à la croissance la plus rapide et affichent des ratios coûts / avantages substantiels, surtout si l’on considère les recettes fiscales. Les villes intelligentes touchent également la vie des citoyens par la sûreté, la sécurité et la facilité d’utilisation. Par exemple, plusieurs villes comme Barcelone ont adopté la connectivité IoT pour surveiller les conteneurs et les poubelles de collecte en fonction de la capacité actuelle, mais également du temps écoulé depuis la dernière collecte. Cela améliore l’efficacité de la collecte des ordures, permettant à la ville d’utiliser moins de ressources et de recettes fiscales pour le transport des déchets, mais élimine également les odeurs et les odeurs potentielles de matières organiques en décomposition.

L’une des caractéristiques du déploiement d’une ville intelligente peut être le nombre de capteurs utilisés. Par exemple, une installation de caméra intelligente à chaque coin de rue à New York nécessiterait plus de 3 000 caméras. Dans d’autres cas, une ville comme Barcelone déploiera près d’un million de capteurs environnementaux pour surveiller la consommation électrique, la température, les conditions ambiantes, la qualité de l’air, les niveaux de bruit et les espaces de stationnement. Ces Tous ont des besoins à faible bande passante par rapport à une caméra vidéo en continu, mais le montant total des données transmises seront les mêmes que les caméras de surveillance, près de New York. Ces caractéristiques de quantité et de bande passante doivent être prises en compte lors de la construction de l’architecture IoT correcte.

Les villes intelligentes sont également affectées par les mandats et les réglementations du gouvernement (comme nous l’explorerons plus loin) ; par conséquent, il existe des liens avec le segment gouvernemental.

1.3.16 Cas d’utilisation de l’IoT Smart City

Certains des cas d’utilisation de l’IoT Smart City sont les suivants :

- Contrôle de la pollution et analyse réglementaire par détection environnementale

- Prévisions météorologiques microclimatiques à l’aide de réseaux de capteurs à l’échelle de la ville

- Gains d’efficacité et amélioration des coûts grâce à un service de gestion des déchets sur demande

- Amélioration de la circulation et de l’économie de carburant grâce au contrôle et à la configuration intelligents des feux de circulation

- Efficacité énergétique de l’éclairage urbain sur demande

- Déneigement intelligent basé sur la demande routière en temps réel, les conditions météorologiques et les charrues à proximité

- Irrigation intelligente des parcs et des espaces publics, en fonction des conditions météorologiques et de l’utilisation actuelle

- Des caméras intelligentes pour détecter les délits et les alertes AMBER automatisées en temps réel

- Des parkings intelligents pour trouver automatiquement les meilleures places de parking sur demande

- Moniteurs d’usure et d’utilisation des ponts, des rues et des infrastructures pour améliorer la longévité et le service

1.3.17 Militaire et gouvernement

Les gouvernements municipaux, étatiques et fédéraux, ainsi que les militaires, s’intéressent vivement aux déploiements IoT. Prenez le décret exécutif de la Californie B-30-15 ( https://www.gov.ca.gov/news.php?id=18938 ), qui stipule que d’ici 2030, les émissions de gaz à effet de serre affectant le réchauffement climatique seront à des niveaux de 40% inférieurs à 1990 niveaux. Pour atteindre des objectifs agressifs comme celui-ci, les moniteurs environnementaux, les systèmes de détection d’énergie et l’intelligence artificielle devront intervenir pour modifier les schémas énergétiques à la demande, tout en maintenant la respiration de l’économie californienne. D’autres cas incluent des projets comme Internet Battlefield of Things, dans le but de fournir des efficacités pour les contre-attaques contre les ennemis. Ce segment s’inscrit également dans la catégorie des villes intelligentes lorsque l’on considère la surveillance des infrastructures gouvernementales comme les autoroutes et les ponts.

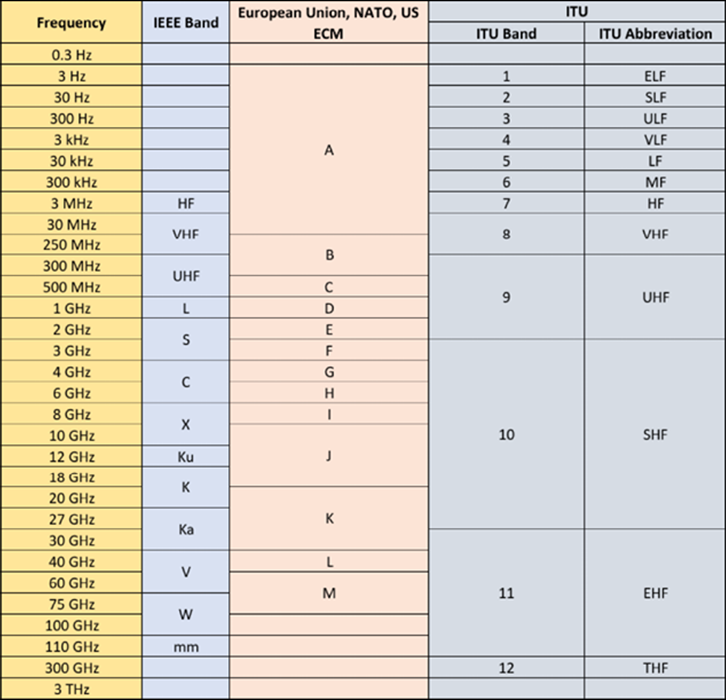

Le rôle du gouvernement dans l’IdO entre également en jeu sous la forme de normalisation, d’attribution du spectre de fréquences et de réglementations. Prenez, par exemple, la façon dont l’espace de fréquences est divisé, sécurisé et réparti entre différents fournisseurs. Nous verrons tout au long de ce texte comment certaines technologies ont vu le jour sous le contrôle fédéral.

1.3.18 Cas d’utilisation de l’IoT gouvernemental et militaire

Voici certains des cas d’utilisation de l’IoT gouvernemental et militaire :

- Analyse des menaces de terreur grâce à l’analyse des modèles d’appareils IoT et aux balises

- Des capteurs d’essaim à travers des drones

- Des bombes à capteurs déployées sur le champ de bataille pour former des réseaux de capteurs pour surveiller les menaces

- Systèmes de suivi des actifs du gouvernement

- Services de repérage et de localisation en temps réel du personnel militaire

- Capteurs synthétiques pour surveiller les environnements hostiles

- Surveillance du niveau d’eau pour mesurer le barrage et le confinement des inondations

1.4 Exemple de cas d’utilisation et de déploiement

La façon la plus efficace de comprendre un IoT et un système informatique de périphérie est de commencer par le cas d’utilisation d’un produit du monde réel. Ici, nous étudierons ce que la solution est censée offrir, puis nous nous concentrerons sur la technologie sous-jacente. Les utilisateurs et les clients ne détailleront pas les exigences système complètes, et les lacunes devront être dérivées des contraintes. Cet exemple illustrera également que les déploiements IoT sont une collaboration inter-domaines entre différentes disciplines et sciences de l’ingénierie. Souvent, il y aura des concepteurs numériques, des ingénieurs réseau, des ingénieurs de microprogrammes de bas niveau, des concepteurs industriels, des ingénieurs facteur humain, des ingénieurs électriciens en configuration de carte, ainsi que des développeurs cloud et SaaS. Cependant, la conception ne peut pas être architecturée dans divers silos. Souvent, un choix de conception dans un domaine peut entraîner des performances médiocres, une mauvaise durée de vie de la batterie, des charges de réseau exorbitantes ou une communication peu fiable avec les appareils distants.

1.4.1 Étude de cas – Télémédecine soins palliatifs

Un fournisseur de soins à domicile et de consultation pour les personnes âgées et les personnes âgées a l’intention de moderniser leur pratique actuelle des soins infirmiers à domicile et des soins d’assistance infirmière avec des solutions meilleures, plus exploitables et économiques pour faire face à la crise croissante des coûts et du nombre de patients. Actuellement, le service maintient des soins à domicile avec des visites de routine de 7 jours à plus de 500 patients dans un rayon de 100 miles d’une zone métropolitaine à Madison, Wisconsin. Les visites comprennent tout, de la livraison des médicaments et des services de soins spéciaux aux mesures de la vitale des patients. Les patients sont généralement âgés de plus de 70 ans et n’ont aucune capacité à administrer une infrastructure informatique apportée à domicile. De plus, les foyers pour patients peuvent ne pas avoir de connectivité Internet ou de connexion à large bande.

1.4.2 Exigences

Le fournisseur souhaite qu’un système fournisse ces fonctionnalités et services minimaux :

- Chaque patient se verra attribuer un appareil portable pour surveiller la fréquence cardiaque, l’oxygène sanguin, les mouvements, la température et les mesures prises.

- Un ou des dispositifs supplémentaires seront installés dans les maisons de patients pour surveiller les conditions spécifiques du patient et les signes vitaux tels que la pression artérielle, la glycémie, le poids, la température buccale, etc.

- Le système doit signaler les données sur les paramètres vitaux des patients à un tableau de bord central des opérations.

- Le système rappellera également aux patients des événements tels que quand prendre une certaine pilule ou quand administrer un test vital.

- Le système doit être en mesure de suivre l’état d’un patient en cas de panne de courant.

- Un système portable est fourni avec un bouton-poussoir facilement identifiable qui signalera une situation d’urgence (telle qu’une chute) au service opérateur en attente. L’appareil clignote pour indiquer qu’une urgence a été activée. L’appareil aura une communication audio bidirectionnelle avec l’opérateur. En cas de situation de patient malentendant, une autre méthode sera utilisée pour communiquer avec le patient.

- L’ensemble du réseau doit être capable de gérer 500 patients actuels et de croître à une échelle de 10% par an.

- Le système doit permettre une économie globale et un retour sur investissement de 33% dans les trois ans suivant sa mise en œuvre. Cet indicateur de performance clé ( ICP ) est mesuré en réduisant les soins infirmiers à domicile et les soins d’assistance infirmière de trois heures par jour à deux heures par jour tout en augmentant la qualité des soins de santé pour les patients du programme.

1.4.3 Mise en œuvre

L’IoT médical et la télémédecine sont l’un des domaines à plus forte croissance de l’IoT, de l’IA / ML et des systèmes de capteurs. Avec un taux de croissance d’une année sur l’autre (glissement annuel) de 19% et un marché de 534 milliards de dollars d’ici 2025, il a suscité beaucoup d’intérêt. Cependant, nous examinons cette étude de cas spécifique en raison des contraintes importantes qu’elle impose au concepteur de système. Plus précisément, dans les domaines des soins de santé, les exigences strictes et les réglementations HIPAA et FDA imposent des contraintes qui doivent être surmontées pour construire un système qui affecte le bien-être des patients. Par exemple, HIPAA exigera la sécurisation des données des patients, de sorte que le chiffrement et la sécurité des données devront être conçus et qualifiés pour l’ensemble du système. De plus, nous examinons ici les contraintes des personnes âgées, à savoir le manque de connectivité Internet robuste, tout en essayant de construire un système connecté à Internet.

Le système sera divisé en trois composantes principales :

- La couche du bord éloigné : elle sera constituée de deux appareils. Le premier sera un appareil portable pour le patient. Le second sera une myriade d’outils de mesure de qualité médicale différents. Le portable sera un appareil sans fil tandis que les autres appareils de mesure peuvent ou non être sans fil. Les deux établiront une communication sécurisée avec le composant de couche PAN-LAN décrit ci-après.

- La couche PAN-WAN proche du bord : Ce sera un dispositif sécurisé installé dans la localité du domicile du patient ou où il pourra être soigné. Il doit être portable mais une fois installé, il ne doit pas être utilisé et altéré par le patient. Il abritera l’équipement d’infrastructure de réseau PAN-LAN. Il contient également les systèmes informatiques de pointe pour gérer les appareils, contrôler la connaissance de la situation et stocker en toute sécurité les données des patients en cas de panne.

- Couche cloud : ce sera le point d’agrégation pour stocker, enregistrer et gérer les données des patients. Il présente également des tableaux de bord et des moteurs de règles de connaissance de la situation. Le clinicien gérera un parc de systèmes de soins à domicile installés par le biais d’un tableau de bord unique et d’un panneau de verre. Gérer 500 patients avec une croissance de 10% en glissement annuel présentera des défis pour gérer rapidement cette quantité de données, en particulier dans les situations d’urgence. Par conséquent, des moteurs de règles seront construits pour déterminer quand un événement ou une situation dépasse une limite.

Les trois couches de l’architecture composent le système du capteur au cloud. Les sections suivantes détaillent les aspects de chaque couche.

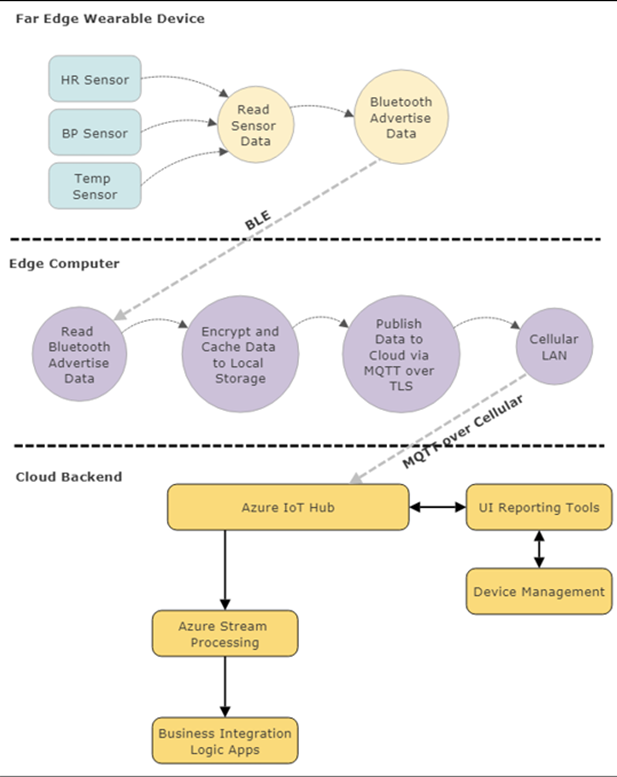

Le cas d’utilisation unique que nous avons choisi est simplement un événement IoT du portable qui doit se propager au cloud pour la visibilité du tableau de bord. Le flux de données s’étend sur les trois couches de ce cas d’utilisation IoT, comme illustré dans la figure suivante:

Figure 6 : flux de données de base et composants logiciels dans cet exemple de cas d’utilisation. Notez le rôle du périphérique informatique de périphérie assurant la traduction entre un périphérique Bluetooth et le cloud via un protocole de transport. Il remplit également les rôles de serveur de mise en cache et d’agent de chiffrement.

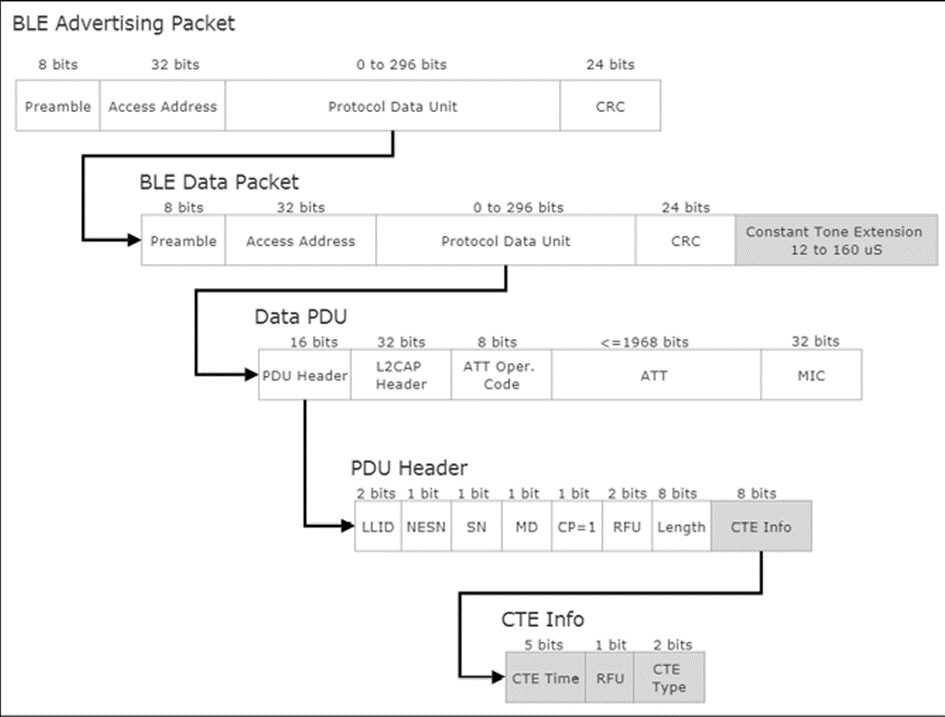

Ce cas d’utilisation lira à partir de capteurs intégrés et diffusera les données sous forme de paquets annoncés BLE en tant que périphérique BLE couplé à l’ordinateur de bord. Le système de périphérie gère la relation avec le PAN Bluetooth et récupère, crypte et stocke les données entrantes en cas de panne de courant ou de communication avec le cloud. Le système de périphérie a la responsabilité supplémentaire de convertir les données Bluetooth en paquets TCP / IP enveloppés dans un transport MQTT.

Il doit également configurer, gérer et contrôler une communication cellulaire avec un fournisseur d’abonnement. MQTT permet le transport fiable et robuste vers le système cloud en attente (Azure dans cet exemple). Ces données sont chiffrées via le câble via TLS, puis ingérées par le hub Azure IoT. À ce stade, les données seront authentifiées et rassemblées via le moteur Stream Analytics et vers les applications logiques où les services Web basés sur le cloud hébergeront un tableau de bord d’informations et d’événements sur les patients.

1.4.4 Architecture d’extrémité éloignée

Commençons par le bord éloigné et la conception portable. Pour ce projet, nous commençons par décomposer l’exigence utilisateur en exigences système exploitables :

| Cas d’utilisation | Choix | Description détaillée |

| Moniteur patient portable |

|

Dispositif portable pour le patient.

L’appareil doit maintenir l’intégrité sous plusieurs paramètres environnementaux tels que la submersion dans l’eau, le froid, la chaleur, l’humidité, etc. |

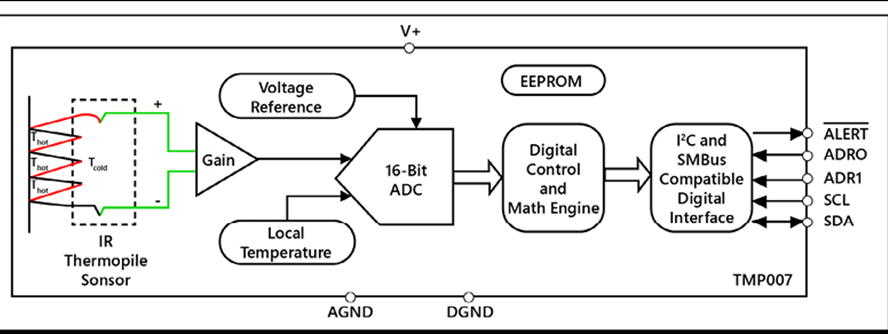

| Moniteurs vitaux portables | TI AFE4400 fréquence cardiaque et oxymètre de pouls | Moniteur de fréquence cardiaque et capteur d’oxygène sanguin de qualité médicale |

| Accéléromètre MEMS ST Micro MIS2DH de qualité médicale | Capteur de mouvement et podomètre | |

| Capteur de température corporelle Maxim MAX30205 | Capteur de température de qualité médicale | |

| Bouton d’appel d’urgence | Un seul bouton-poussoir visible avec une LED sur l’unité | Le bouton doit appuyer mais ne pas créer de faux événements positifs. De plus, une lumière doit clignoter lorsqu’une situation d’urgence est activée. De plus, une communication bidirectionnelle peut être initiée. |

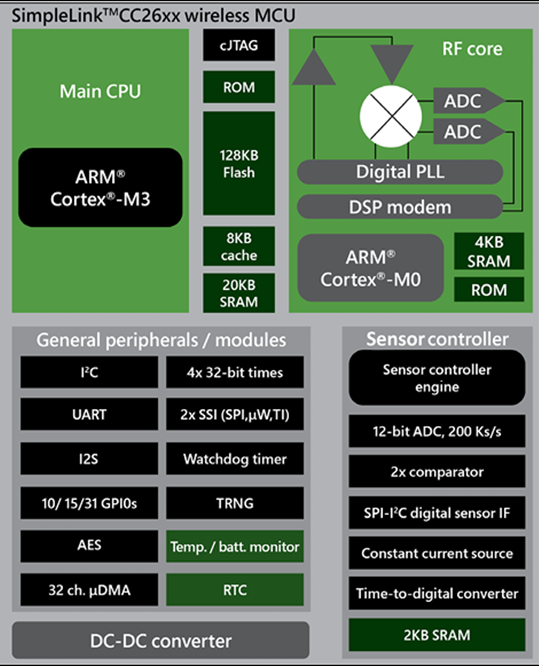

| Système de contrôle des bords | Microcontrôleur ST Micro STM32WB | Système pour interfacer les capteurs et fournir une communication PAN à la couche PAN-WAN. Le système Edge contient le matériel radio et les codecs audio nécessaires. |

| Microphone | Knowles SPU0410LR5 audio, microphone et amplificateur | Communication bidirectionnelle en cas d’urgence. |

| Système d’alimentation | Batterie Li-ion sous boîtier portable. | Le système doit avoir une durée de vie de la batterie rechargeable de plusieurs jours avec des avertissements pour le patient et le clinicien en cas de faible puissance. Le système d’alimentation doit être rechargeable ou remplaçable. |

| Jumelage | Bluetooth

Zigbee Wi-Fi |

Besoin d’une méthode pour associer et associer des attributs portables dans le concentrateur PAN-LAN domestique. |

L’intention du dispositif portable dans une situation de soins palliatifs est d’être fiable, robuste et durable. Nous avons choisi des composants de qualité médicale et des composants électroniques testés pour résister aux cas d’utilisation pouvant survenir dans les soins à domicile. L’appareil n’aura également aucune pièce réparable. Par exemple, pour ce cas d’utilisation, nous avons choisi de ne pas charger le patient de recharger le portable car cette procédure peut ne pas être suivie de manière fiable. Le projet nécessitant toujours des soins infirmiers à domicile et des soins d’assistance infirmière, une partie de la tâche de l’assistance infirmière sera de recharger et de surveiller la santé du portable.

Un système commence généralement par les contraintes de réalisation des composants. Dans ce cas, un système portable pour les soins de santé à domicile des personnes âgées pourrait se présenter sous la forme d’un bracelet, d’une sangle de cou, d’une sangle de bras, etc. Ce projet a choisi une dragonne semblable à une bande de nom de style hospitalier avec laquelle un patient aurait déjà une certaine familiarité. La dragonne permet un ajustement près de la peau et des artères pour permettre la collecte des caractéristiques de santé. D’autres formes d’objets portables n’ont pas réussi à fournir un contact plus robuste. La dragonne présente des contraintes de taille, de puissance et de forme importantes qui doivent contenir tous les composants électroniques, l’alimentation et les radios décrits ci-dessous.

Du point de vue du diagramme, le portable sera composé du moins de composants possible pour minimiser l’espace et le poids tout en économisant le plus d’énergie possible. Ici, nous choisissons d’utiliser un microcontrôleur très économe en énergie avec une radio Bluetooth 5 (Bluetooth Low Energy – BLE). La radio BLE servira de communication PAN au hub PAN-WAN. Le BLE 5 a une portée allant jusqu’à 100 mètres (ou plus lorsque le mode longue portée LE est activé).

Cela sera suffisant pour les situations de soins à domicile où le patient ne partira pas nécessairement.

Figure 7 : Dispositif informatique portable pour les soins palliatifs à domicile

1.4.5 Architecture de la couche Edge

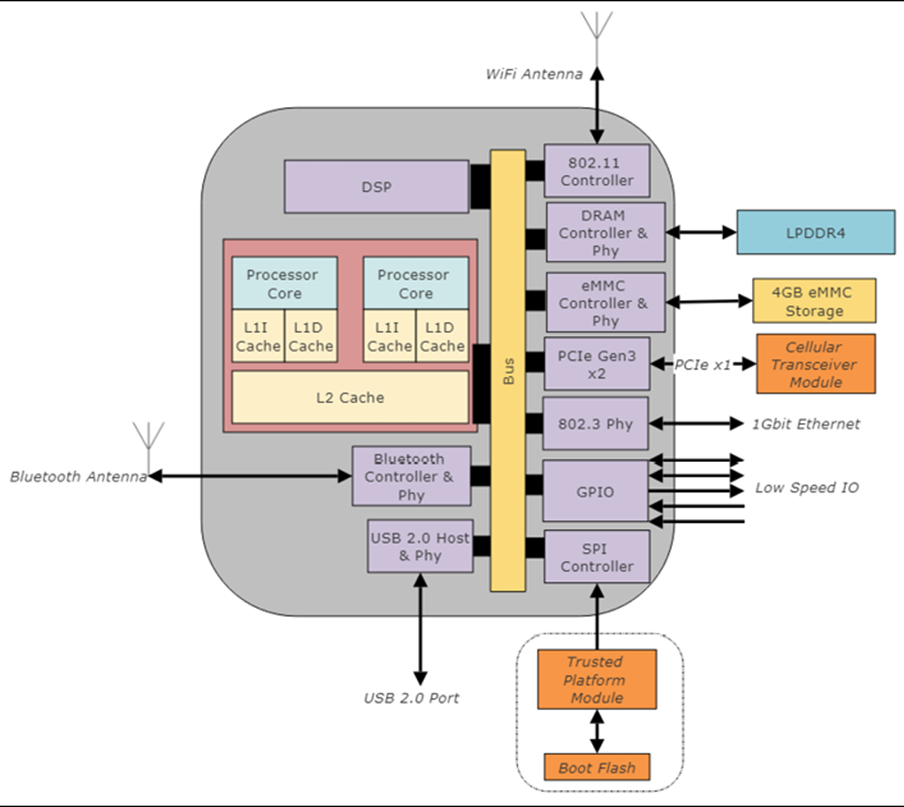

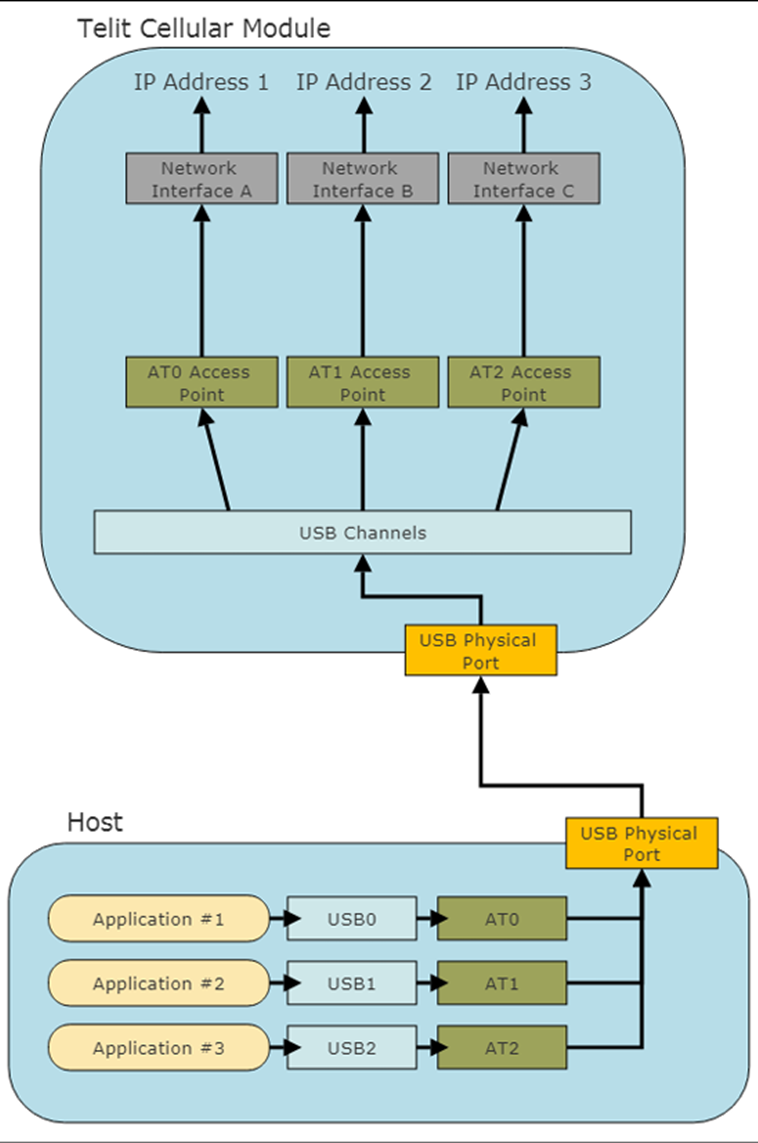

La couche périphérique PAN-WAN est l’ordinateur périphérique central, la passerelle et le routeur. Dans de nombreux cas, cette fonctionnalité est effectuée par un smartphone ; Cependant, dans cette mise en œuvre, nous devons construire un système utilisant un plan de service cellulaire différent et plus économique que ce qui est généralement proposé aux consommateurs de smartphones. Parce que notre échelle est de 500 utilisateurs et grandit, nous décidons de construire un hub en utilisant des composants matériels standard pour fournir la meilleure solution pour le client.

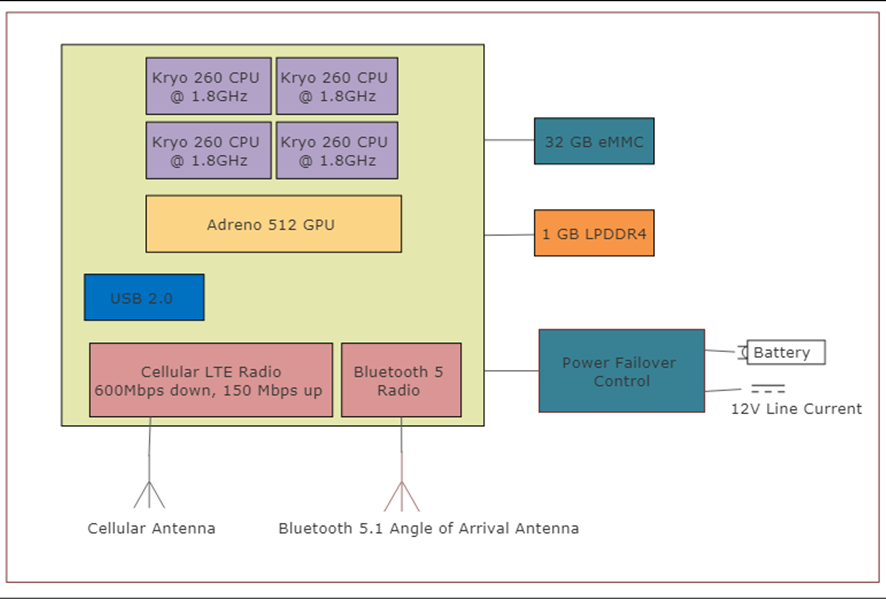

L’ordinateur de bord que nous avons choisi est un ordinateur monocarte de qualité industrielle capable d’exécuter une distribution d’entreprise de Linux. L’Inforce 6560 agit comme une passerelle entre le Bluetooth 5.0 PAN et un WAN cellulaire. Le système sur puce (SOC) intègre commodément le matériel suivant :

- Processeur Snapdragon 660 avec processeur Qualcomm Kryo 260

- 3 Go de DRAM LPDDR4 intégrée

- 32 Go de stockage eMMC

- Une interface pour carte microSD

- Radio Bluetooth 5.0

- Radio Wi-Fi 802.11n / ac 2,4 GHz et 5 GHz

Figure 8 : Schéma fonctionnel du matériel du système Edge

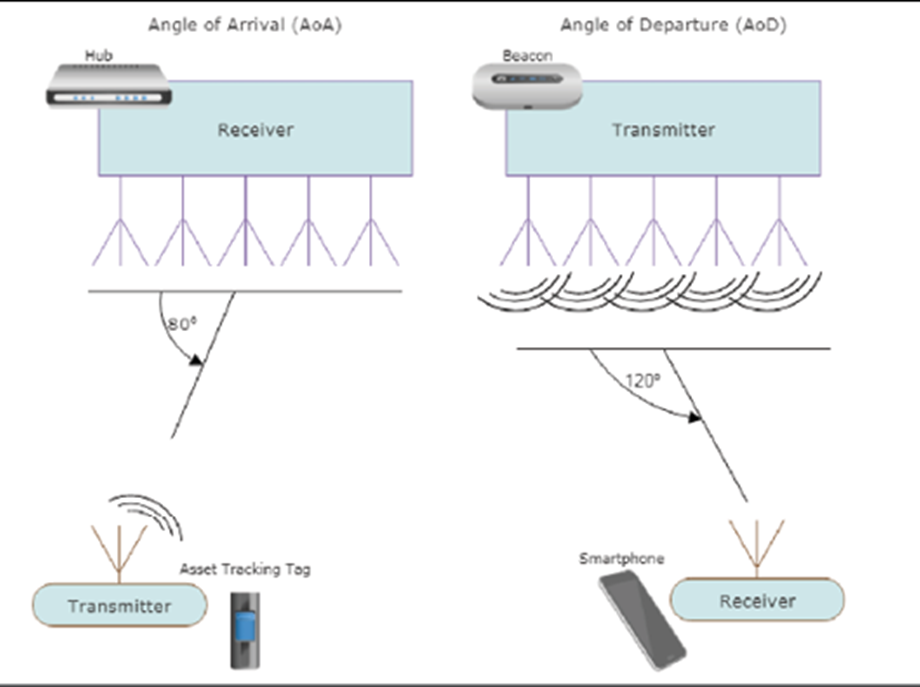

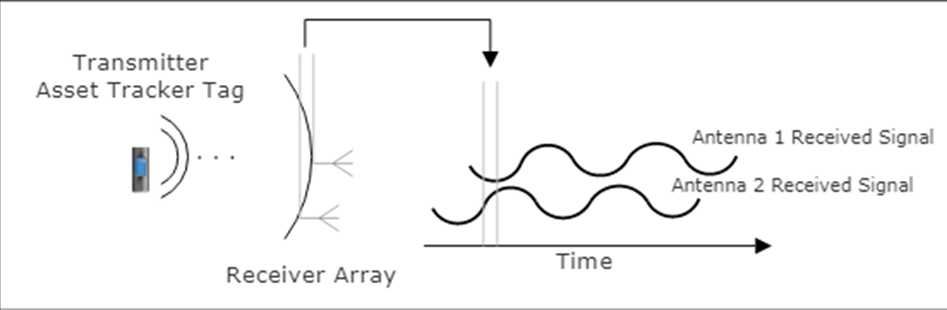

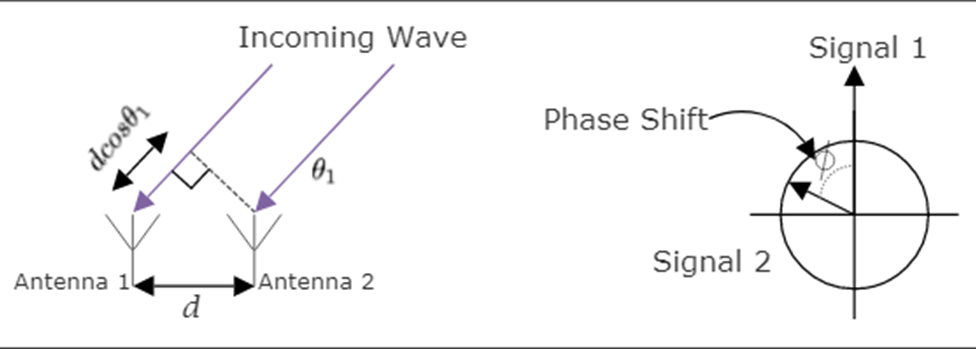

L’ordinateur de bord utilisera également un réseau d’antennes d’angle d’arrivée à suivi de localisation Bluetooth 5.1. Cette nouvelle norme permettra au système de bord d’obtenir une précision centimétrique sur l’emplacement du portable et du patient dans le champ Bluetooth. Cela permettra de suivre les mouvements du patient, l’exercice, les fonctions de la salle de bain et les situations d’urgence.

La périphérie repose sur un système d’alimentation de basculement ou une alimentation sans coupure (UPS). L’onduleur passera du courant de ligne à la batterie en cas de coupure de courant ou de panne de courant. Il signalera au système de périphérie qu’un événement d’alimentation s’est produit via un signal USB ou série UART. À ce stade, le système Edge communiquera à la gestion du cloud qu’un événement d’alimentation s’est produit et une action peut être nécessaire.

1.4.6 Architecture logicielle

Avec trois couches de protocoles de communication et de matériel, il existe trois modèles différents de logiciels dans ce système relativement simple. Plutôt que d’analyser cet exemple de cas d’utilisation avec toutes les nuances de la conception, y compris chaque récupération de panne, provisionnement des appareils, sécurité et état du système, nous examinerons l’utilisation la plus courante de la fourniture de données de santé des patients en temps réel.

La structure logicielle de l’appareil portable doit être compatible avec le matériel que nous avons choisi. Cela implique que nous avons choisi des outils, des systèmes d’exploitation, des pilotes de périphériques et des bibliothèques compatibles avec l’architecture et les périphériques que nous utilisons. Nous commencerons par le portable, qui a les exigences les plus strictes en termes de taille de code, d’autonomie et de performances. Étant donné que le microcontrôleur STM32WB est conçu comme un double cœur, nous avons essentiellement deux systèmes à gérer : le cœur ARM M4 plus performant qui exécutera notre micrologiciel portable spécifique et un cœur M0 de faible puissance qui gère les E / S via Bluetooth. Nous avons choisi un système d’exploitation commercial en temps réel tel que ThreadX par Express Logic pour permettre une expérience de développement moderne plutôt qu’une simple boucle de contrôle qui n’est pas appropriée pour ce produit. Nous voulons également pouvoir certifier le produit pour une utilisation de qualité médicale, ce qui est plus facile lors de l’utilisation de systèmes d’exploitation commerciaux standard.

La structure logicielle sur le portable est divisée en deux processus qui hébergent de nombreux threads pour gérer l’affichage portable, le matériel du haut-parleur et du microphone, les E / S vers les capteurs de rythme cardiaque et de mouvement et la pile Bluetooth. La pile Bluetooth communique avec le cœur M0 qui gère les couches matérielles de la radio Bluetooth.

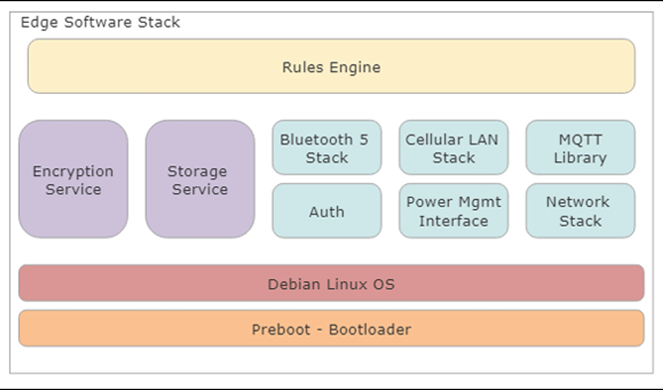

Figure 9 : pile logicielle du système portable divisée entre deux cœurs de traitement pour les services d’application et la communication IO

L’ordinateur périphérique dispose de plus de ressources de traitement car il doit fournir une pile TCP / IP complète, la communication et le routage PAN et WAN, des services de chiffrement, des services de stockage, le provisionnement des appareils et des mises à niveau de micrologiciel à sécurité intégrée. Pour le système Edge, nous avons choisi un système Linux Debian-variant car il fournit plus de fonctionnalités et de services qu’un RTOS étroitement intégré. La coordination avec le système cloud et tous les services sur l’ordinateur de bord ou sur le portable sont coordonnés via le « moteur de règles ». Le moteur de règles peut être un simple “système expert” utilisant une logique personnalisée pour ce client ou ce cas d’utilisation. Une conception plus robuste peut utiliser un cadre normalisé comme Drools. Étant donné que chaque patient peut avoir besoin d’un ensemble de règles différent, il est logique d’utiliser un moteur de règles dynamique et fongible qui peut être téléchargé avec différentes directives patient. Il s’agit d’un superviseur autonome de haut niveau qui capture périodiquement les données de santé, résout les problèmes de sécurité, publie de nouvelles mises à jour de micrologiciel de manière fiable, gère l’authentification et la sécurité et gère un nombre important de conditions d’erreur et d’échec. Le moteur de règles doit être autonome pour satisfaire l’exigence de produit du système fonctionnant sans contrôle direct via le cloud.

Figure 10 : pile logicielle informatique Edge composée d’un certain nombre de services gérés par un seul “moteur de règles” superviseur et autonome

La couche cloud fournit les services d’ingestion, de stockage de données à long terme, d’analyse de flux et de tableaux de bord de surveillance des patients. Il fournit l’interface aux fournisseurs de soins de santé pour gérer en toute sécurité des centaines de systèmes de périphérie via une interface commune. C’est également la méthode pour fournir rapidement des alertes sur les situations d’intégrité, les conditions d’erreur et les défaillances du système, et fournir des mises à niveau de périphérique en toute sécurité. Le partitionnement des services cloud par rapport aux services de périphérie est le suivant :

- Services cloud

- Ingestion et gestion des données pour les patients et les systèmes multi-périphériques

- Capacité de stockage presque illimitée

- Un déploiement logiciel contrôlé et des mises à jour vers Edge

- Services Edge

- Faible latence et réactions en temps réel aux événements

- Communication PAN aux capteurs

- Exigences minimales de connectivité

Les services cloud commerciaux s’accompagneront d’un contrat de service et d’un coût récurrent, tandis que les systèmes de périphérie n’entraîneront pour la plupart qu’un seul coût initial de matériel et de développement.

Lorsque nous considérons les composants du cloud, nous avons besoin d’un service pour ingérer les données de plusieurs périphériques périphériques en toute sécurité. Les données doivent être stockées pour analyse et surveillance. Les services cloud doivent également inclure une méthode de gestion et d’approvisionnement des installations de périphérie. Enfin, nous recherchons une méthode pour obtenir des données en temps réel des patients et les afficher au personnel qualifié.

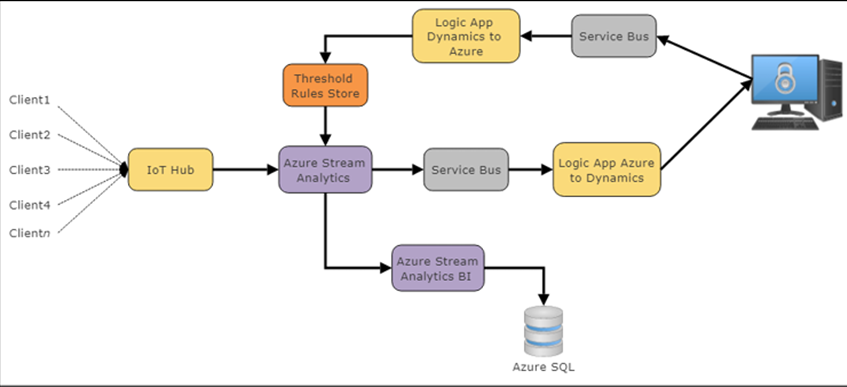

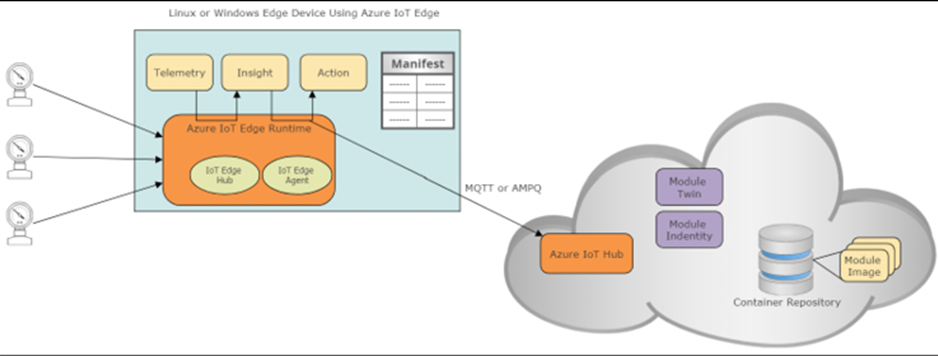

Pour ce projet, nous avons choisi d’utiliser Microsoft Azure IoT comme fournisseur de cloud pour gérer cette grande installation et permettre la croissance et l’évolutivité. Azure IoT fournit une architecture illustrée dans l’illustration suivante :

Figure 11 : pile logicielle Microsoft Azure IoT typique et architecture cloud

L’architecture logicielle Microsoft Azure IoT est généralement cohérente entre les conceptions au moins sur l’extrémité avant du hub IoT. Les données seront diffusées à partir de diverses sources authentifiées vers le hub Azure IoT. Il s’agit de la passerelle cloud et capable d’évoluer vers de très grandes installations IoT. Dans les coulisses, IoT Hub est une collection de processus et de services de centre de données qui écoutent et répondent aux événements entrants.

Le hub IoT achemine les flux qualifiés vers le moteur Stream Analytics. Ici, les données seront rapidement analysées en temps réel aussi vite que les données peuvent être ingérées. Les données peuvent être rassemblées vers des services de Business Intelligence et stockées pour une longue persistance dans une base de données Azure SQL et / ou déplacées vers un bus de service. Le bus de service répond aux événements et aux pannes sous forme de files d’attente pour permettre au système d’y répondre. Le dernier composant de notre architecture est les couches de « colle » du cloud qui acheminent les données vers l’appareil IoT (Logic App Dynamics vers Azure) ou répondent aux données entrantes (Logic App Azure vers Dynamics). Microsoft Dynamics 365 s’interface en tant qu’application logique et permet la visibilité des événements IoT, la création de tableaux de bord, de cadres Web et même des alertes mobiles et smartphone.

Ce cas d’utilisation n’est qu’une fraction des fonctionnalités réelles pour fabriquer un produit commercial d’expédition. Nous avons laissé de côté des domaines importants tels que l’approvisionnement, l’authentification, les conditions d’erreur, les mises à niveau résilientes du micrologiciel, la sécurité du système et la racine de confiance, les conditions de basculement, la communication audio, la gestion des clés, le travail d’affichage LCD et les systèmes de contrôle du tableau de bord eux-mêmes.

1.4.7 Rétrospective de cas d’utilisation

Ce que nous avons montré dans ce cas d’utilisation introductif très bref, c’est que les besoins en objets connectés et en informatique de bord pour les conceptions d’entreprise et commerciales impliquent de nombreuses disciplines, technologies et considérations. Tenter de banaliser la complexité de la transition de la connectivité Internet aux systèmes de périphérie avec les attentes modernes de performances, de fiabilité, de convivialité et de sécurité peut se solder par un échec.

Comme nous l’avons vu dans le cas d’utilisation portable abrégé médical, notre conception implique de nombreux composants interopérables qui composent un système. Il est essentiel qu’un architecte responsable d’un système IoT connaisse un certain niveau de ces composants du système :

- Conception matérielle

- Gestion de l’alimentation et conception de la batterie

- Conception et programmation de systèmes embarqués

- Systèmes de communication, signalisation radio, utilisation du protocole et économie de la communication

- Piles et protocoles réseau

- Sécurité, provisionnement, authentification et plateformes de confiance

- Analyse des performances et partitionnement du système

- Gestion du cloud, systèmes de streaming, systèmes de stockage dans le cloud et économie du cloud

- Analyse des données, gestion des données et science des données

- Gestion des middlewares et des appareils

Cet article est conçu pour aider l’architecte à naviguer à travers la myriade de détails et d’options pour chacun de ces niveaux.

1.5 Résumé

Bienvenue dans le monde de l’IoT. En tant qu’architectes dans ce nouveau domaine, nous devons comprendre ce que le client construit et ce que les cas d’utilisation exigent. Les systèmes IoT ne sont pas un type de conception qui consiste à tirer et à oublier. Un client attend plusieurs choses de sauter dans le train IoT.

Premièrement, il doit y avoir une récompense positive. Cela dépend de votre entreprise et de l’intention de votre client. D’après mon expérience, un gain 5x est la cible et a bien fonctionné pour l’introduction de nouvelles technologies dans les industries préexistantes. Deuxièmement, la conception de l’IoT est, par nature, une pluralité de dispositifs. La valeur de l’IoT n’est pas un seul appareil ou un seul emplacement diffusant des données vers un serveur. C’est un ensemble de choses diffusant des informations et comprenant la valeur que les informations globales essaient de vous dire. Tout ce qui est conçu doit évoluer ou être évolutif ; par conséquent, cela nécessite une attention lors de la conception initiale.

Nous avons découvert les segments de l’IoT et les taux de croissance prévus et réels de l’IoT. Nous avons également exploré un cas d’utilisation commerciale unique et constaté que l’IoT et l’informatique de périphérie couvrent plusieurs disciplines, technologies et fonctionnalités. Ces mécanismes de développement d’un IoT et d’un système informatique de bord commercialement viables nécessiteront que l’architecte comprenne ces différents segments et comment ils sont liés.

Nous commençons maintenant à explorer la topologie d’un IoT et d’un système informatique de périphérie dans son ensemble, puis nous décomposons les composants individuels dans le reste de l’article.

2 Architecture IoT et modules Core IoT

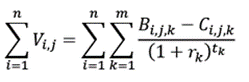

L’informatique de périphérie et l’écosphère de l’IoT commencent avec le plus simple des capteurs situés dans les coins les plus reculés de la terre et traduisent les effets physiques analogiques en signaux numériques (le langage d’Internet). Les données prennent ensuite un voyage complexe à travers des signaux filaires et sans fil, divers protocoles, des interférences naturelles et des collisions électromagnétiques, avant d’arriver dans l’éther d’Internet. À partir de là, les données en paquets traverseront divers canaux arrivant dans un cloud ou un grand centre de données. La force de l’IoT n’est pas seulement un signal provenant d’un capteur, mais l’ensemble de centaines, de milliers, potentiellement de millions de capteurs, d’événements et d’appareils.

Ce chapitre commence par une définition de l’IoT par rapport aux architectures machine à machine. Il aborde également le rôle de l’architecte dans la création d’une architecture IoT évolutive, sécurisée et d’entreprise. Pour ce faire, un architecte doit être capable de parler de la valeur que la conception apporte à un client. L’architecte doit également jouer plusieurs rôles d’ingénierie et de produit dans l’équilibre des différents choix de conception.